执行start-dfs.sh后,datenode没有启动的解决办法

执行start-dfs.sh后,datenode没有启动,很大一部分原因是因为在第一次格式化dfs后,启动并使用了hadoop,后来又重新执行了格式化命令(hdfs namenode -format),这时主节点namenode的clusterID会重新生成,而从节点datanode的clusterID 保持不变导致的。

解决办法如下:

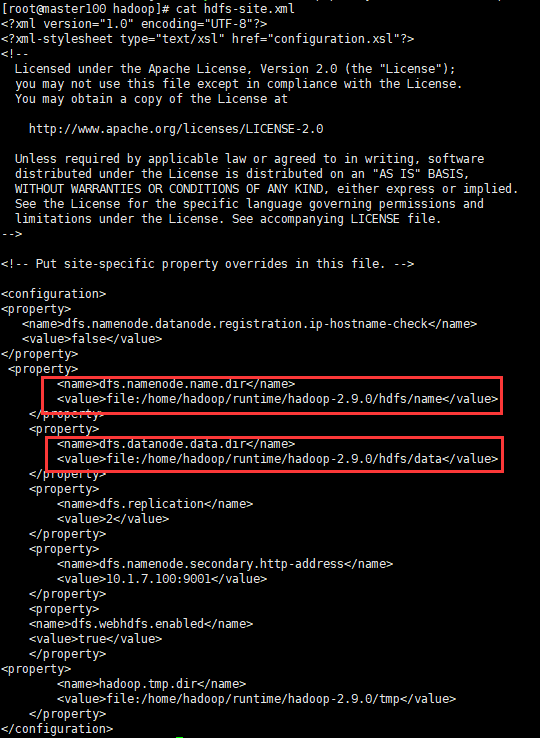

打开hdfs-site.xml找到如下节点

如上找到namenode和datanode(这个datanode是在从节点计算机中查看)的文件路径。分别进入这两个目录,分别打开VERSION查看clusterID是否一致。如果不一致,将namenode中的clusterID值赋值给datanode中VERSION中的clusterID。然后在重新运行脚本start-dfs.sh.

浙公网安备 33010602011771号

浙公网安备 33010602011771号