Hive_1

Sqoop实现Hbase和关系型数据库的数据互导

Zookeeper 配置的更新,文件的命名

Hive是建立在Hadoop之上为了减少MapReduce jobs编写工作的批处理系统,HBase是为了支持弥补Hadoop对实时操作的缺陷的项目。

Hive是Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供类似SQL的查询功能。可以将sql语句转化为MapReduce任务进行运行。Hive是以表为单位,表里面的数据存储在HDFS。所有如果你有数据仓库的需求并且你擅长写SQL并且不想写MapReduce jobs就可以用Hive代替。

Hive帮助熟悉SQL的人运行MapReduce任务。因为它是JDBC兼容的,同时,它也能够和现存的SQL工具整合在一起。运行Hive查询会花费很长时间,因为它会默认遍历表中所有的数据。不支持实时查询。虽然有这样的缺点,一次遍历的数据量可以通过Hive的分区机制来控制。分区允许在数据集上运行过滤查询,这些数据集存储在不同的文件夹内,查询的时候只遍历指定文件夹(分区)中的数据。这种机制可以用来,例如,只处理在某一个时间范围内的文件,只要这些文件名中包括了时间格式。

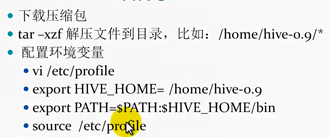

#Hive安装

JDK

Hadoop

Hive

配置文件生效,这里用的是命令行的方式

配置文件生效,这里用的是命令行的方式

Mysql

元数据存储使用mysql的优势是一个用户创建的表,另一个用户在任何位置都可以访问到该表。

Hive-site.xml里面修改,注释掉deby的

#Hive访问方式

(1)Cli (命令行的访问方式)

(2)Hwi (Hive自己提供的web UI的方式访问hive --service hwi ,不要关掉

然后去打开http://localhost:9999/hwi

(3)HiveServer 使用JDBC如何连接Hiveserver

hive –service hiveserver 大家就可以使用JDBC的方式访问元数据的信息。

新建类,定义驱动类,URL , NAME, PASSWORD

浙公网安备 33010602011771号

浙公网安备 33010602011771号