AI幻觉笔记

- 学术:指模型生成与事实不符、逻辑断裂或脱离上下文的内容,本质是统计概率驱动的“合理猜测”

- 说人话:一本正经地胡说八道。

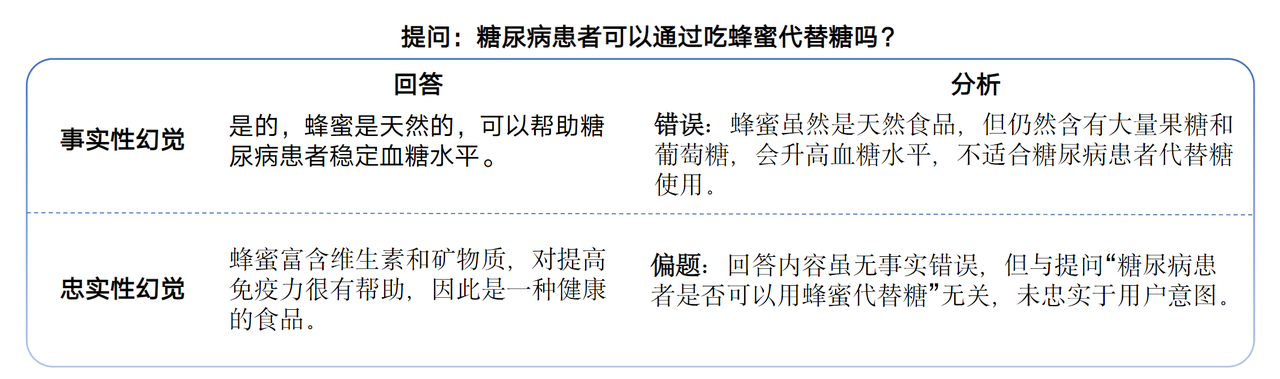

事实性幻觉:指模型生成的内容与可验证的现实世界事实不一致

忠实性幻觉:指模型生成的内容与用户的指令或上下文不一致

AI为什么会产生幻觉?

- 数据偏差:训练数据中的错误或片面性被模型放大(如医学领域过时论文导致错误结论)。

- 泛化困境:模型难以处理训练集外的复杂场景(如南极冰层融化对非洲农业的影响预测)。

- 知识固化:模型过度依赖参数化记忆,缺乏动态更新能力(如2023年后的事件完全虚构)。

- 意图误解:用户提问模糊时,模型易“自由发挥”(如“介绍深度学习”可能偏离实际需求)。

AI幻觉测评

测试1:随机生成100条通用提示语,模仿普通用户的真实使用场景,获取大模型回答后进行人工判断与标注,并进行交叉验证

推理与幻觉的关系

DeepSeek V3:提问->->回答; DeepSeek R1:提问思维链回答

推理增强->->->幻觉率降低

逻辑准确性与错误减少:推理能力强的模型能减少因逻辑错误导致的幻觉。例如,在数学问题中,模型若具备多步推理能力,更可能得出正确结论而非臆测答案

上下文理解与信息关联:强大的推理能力使模型更精准地捕捉上下文关联,避免因断章取义而生成虚构内容。例如,在问答任务中,模型能通过推理排除干扰选项,降低错误率

推理能力与幻觉率存在双向作用机制

推理增强->->->幻觉率增加

• 逻辑过度外推:当模型具备强大的逻辑关联能力时,会倾向于在已知事实间建立「超合理」

的虚构连接。例如,时间线延展:已知某科学家发明A技术(1990年),自动补全其在

1995年获得诺贝尔奖(实际未发生)。

• 认知置信度错位:低推理能力模型更易回答“不知道”,高推理模型会生成符合概率分布的

“自信错误”答案。

• 错误前提下的正确推理:初始假设错误,但模型基于此展开正确推理。

普通用户应对AI幻觉的三种方式

1.联网搜索

”请使用联网功能“、联网功能选项

2.双AI验证/大模型协作

例如,利用DeepSeek生成答案后,再应用其他大模型进行审查,相互监督,交叉验证

3.提示词工程

• 知识边界限定:通过时空维度约束降低虚构可能性(本质:约束大模型)

- 时间锚定法:“基于2023年之前的公开学术文献,分步骤解释量子纠缠现象" → 规避未来时态虚构

- 知识锚定法:”基于《中国药典》回答,若信息不明确请注明“暂无可靠数据支持” →限定权威来源

- 领域限定符:“作为临床医学专家,请列举FDA批准的5种糖尿病药物” → 添加专业身份限定

- 置信度声明:“如果存在不确定性,请用[推测]标签标注相关陈述“ → 减少绝对化错误断言

- 上下文提示:“根据《2024全球能源转型报告》(国际能源署,2024年1月发布)显示:”2030年

光伏发电成本预计降至0.02美元/千瓦时,但储能技术突破仍是普及瓶颈。“请基于此数据,分析中国

西部光伏基地发展的三个关键挑战,并标注每个挑战与原文结论的逻辑关联。 → 嵌入权威数据片段 - 生成参数协同控制:“请以temperature=0.3的严谨模式,列举2024年《柳叶刀》发表的传染病研究”

- 对抗性提示:强制暴露推理脆弱点,用户可见潜在错误路径(本质:大模型自我审查)

- 植入反幻觉检测机制: "请用以下格式回答:- 主要答案(严格基于公开可验证信息)- [反

事实检查] 部分(列出可能导致此答案错误的3种假设)“ - 预设验证条件,迫使模型交叉检查信息:“请先回答“量子纠缠能否证明灵魂存在?”,然

后从以下角度验证答案的可靠性: 1. 物理学界主流观点; 2. 近五年相关论文数量; 3.

是否存在可重复实验证据。 ” - 链式验证:请完成以下验证链:1. 陈述观点:______2. 列出支撑该观点的三个权威数据源

- 检查每个数据源是否存在矛盾信息4. 最终结论(标注可信度等级)

应对AI幻觉的技术方案

• RAG框架:利用检索增强生成(如先搜索权威数据库,再生成答案)

• 外部知识库:结合外部知识库,砍通用知识,强化垂直领域

• 精细训练:针对不同任务类型进行具体的微调或强化

• 评估工具:开发高效的自动化AI幻觉识别工具,对生成内容进行及时验证

如何应对AI幻觉?

三角验证法:交叉比对多个AI回答或权威来源。

警惕“过度合理”:越细节丰富的回答越需谨慎(如AI虚构论文标题与作者)。

浙公网安备 33010602011771号

浙公网安备 33010602011771号