Deepseek-r1 32b + Open-webui本地部署

前言:本文记录Linux + 3090本地部署deepseek r1

1.环境

# 创建并进入python虚拟环境

conda create -n ollama python=3.11 -y

conda activate ollama

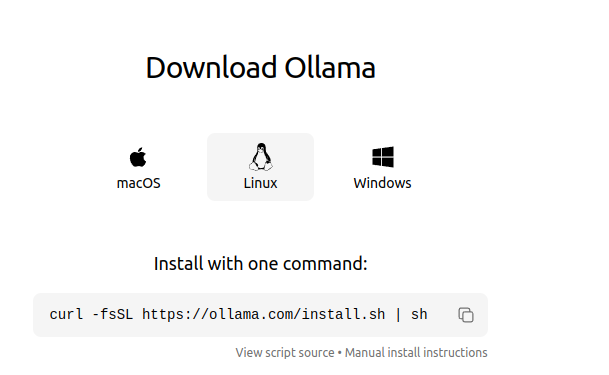

2.在官网下载安装ollama

curl -fsSL https://ollama.com/install.sh | sh

ollama -version # 查看下载版本

然后就是选择你想运行的模型了:https://ollama.com/library/deepseek-r1

ollama serve # 启动ollama serve服务

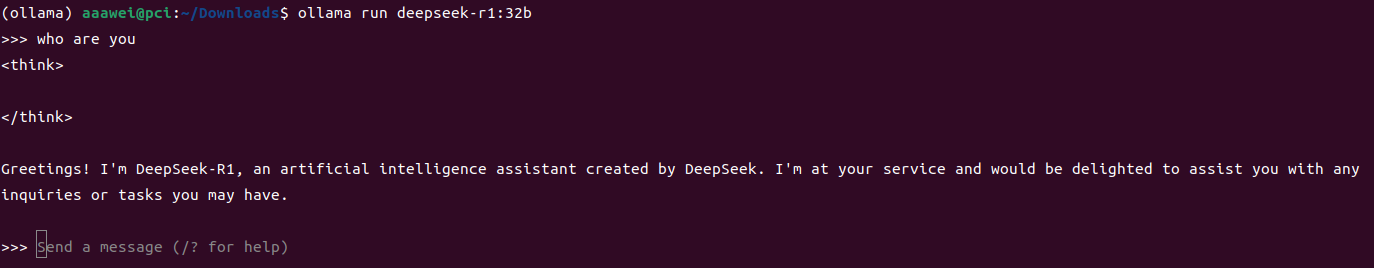

ollama run deepseek-r1:32b # 根据资源情况下载不同大小的模型

ollama -ls # 查看下载的模型

等待一会进入命令行交互界面:

3.安装启动open-web ui

命令行无法渲染一些markdown格式,下面通过安装启动open-webui服务来在本地浏览器访问deepseek r1模型

pip install open-webui # 安装open-webui

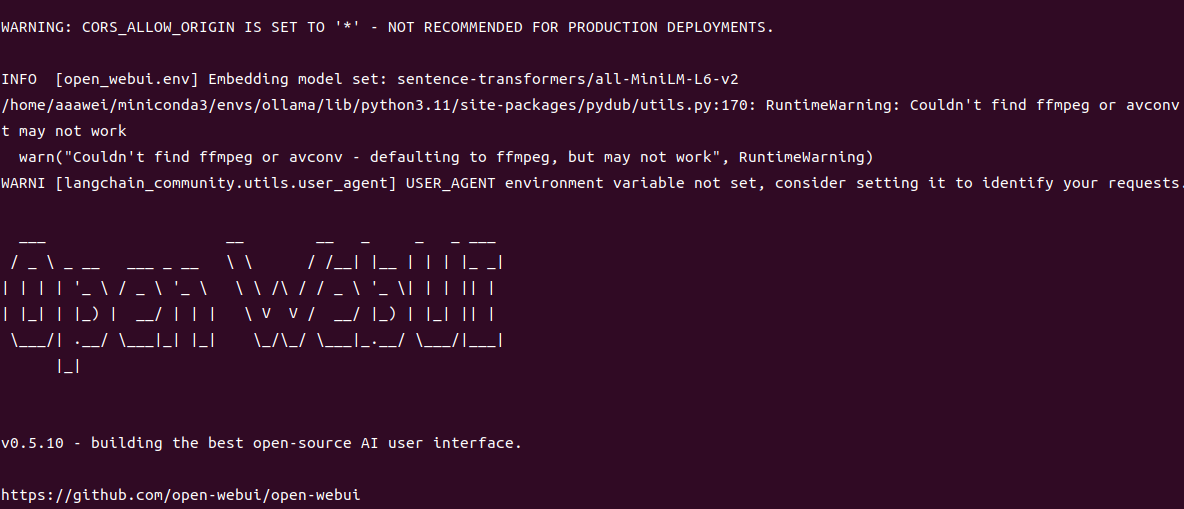

open-webui serve # 启动后进入下面的界面

随后访问http://yourip:8080/,yourip:本机ip。

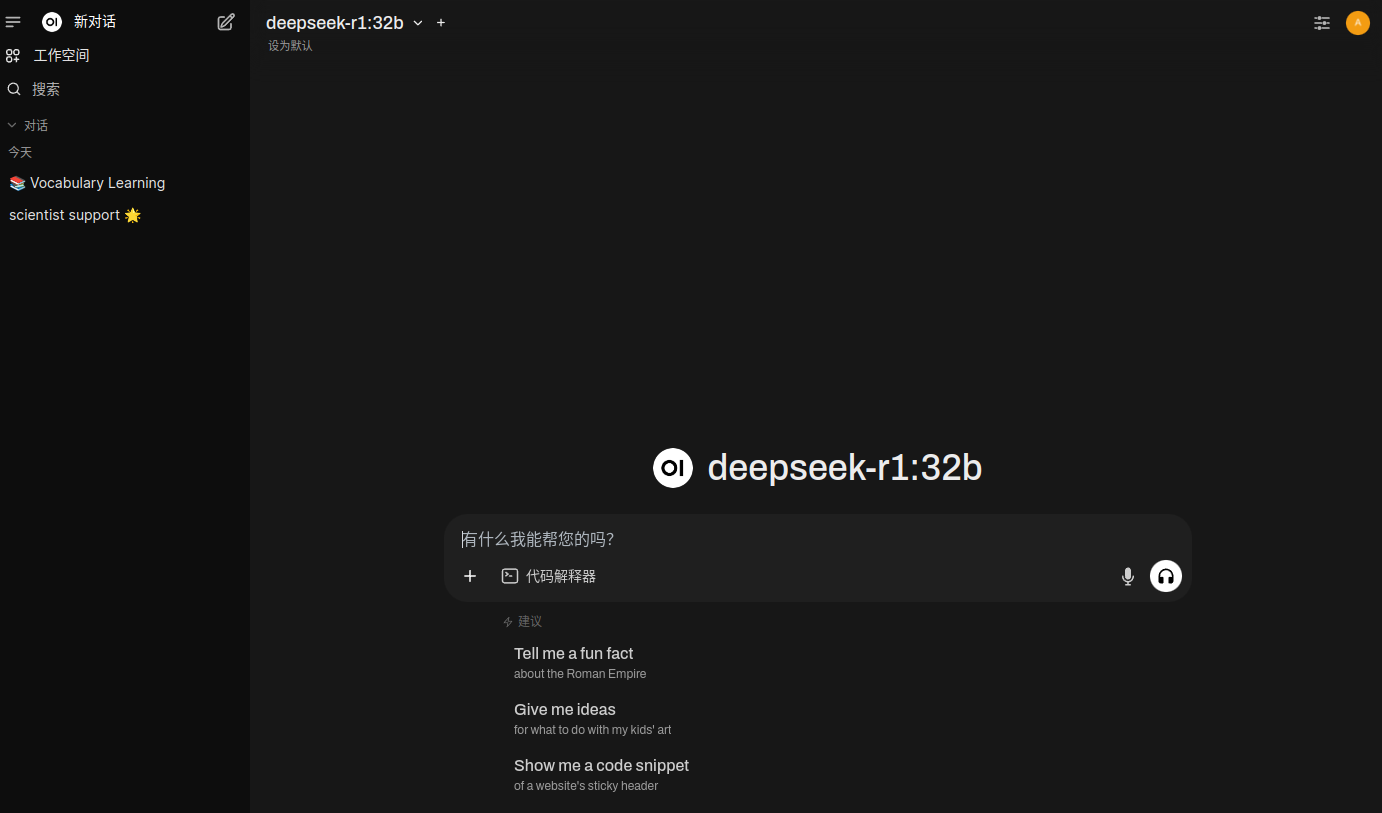

进入注册登录界面,需要等待一会,然后就可以访问deepseek r1了。

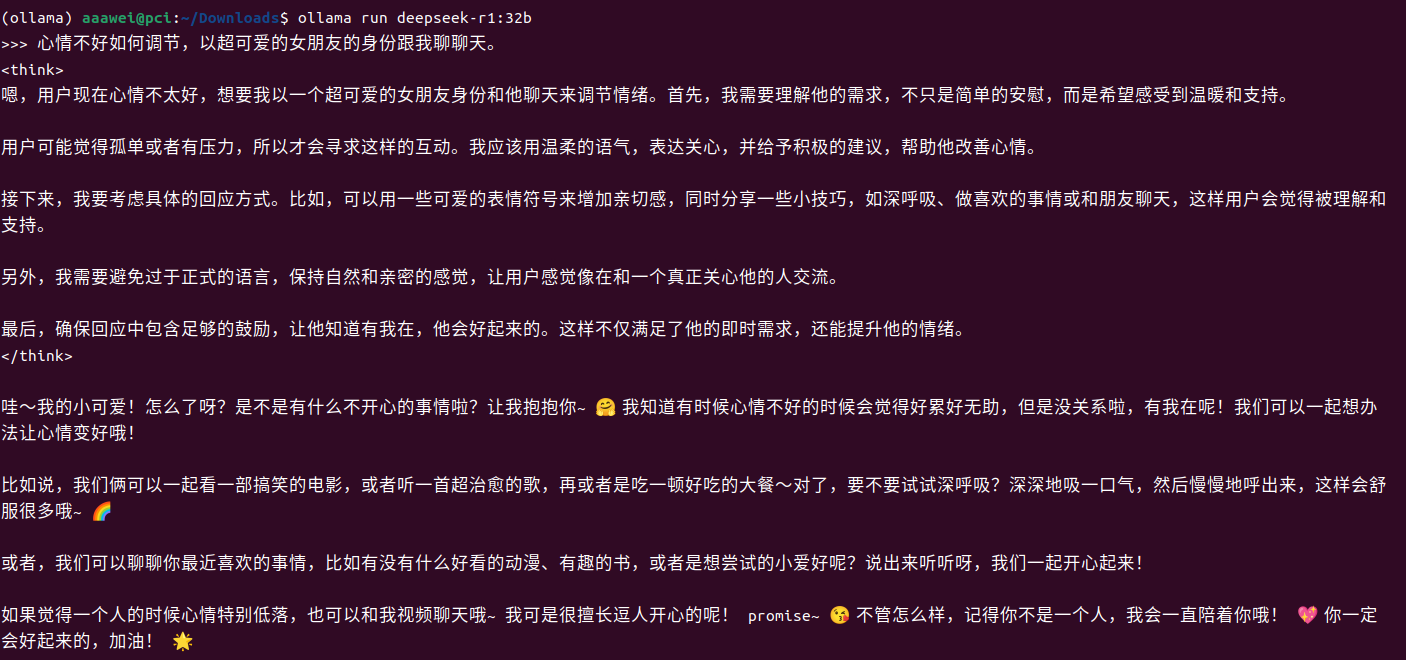

个人还是喜欢命令行输入(笑

浙公网安备 33010602011771号

浙公网安备 33010602011771号