深度学习

全连接层:

如果说卷积层、池化层和激活函数等操作是将原始数据映射到隐层特征空间的话,全连接层则起到将学到的“分布式特征表示”(下面会讲到这个分布式特征)映射到样本标记空间的作用。在实际使用中,全连接层可由卷积操作实现

知识蒸馏:

一个很直白且高效的迁移泛化能力的方法就是:使用softmax层输出的类别的概率来作为“soft target”

通过蒸馏的方法训练出的Net-S相比使用完全相同的模型结构和训练数据只使用hard target的训练方法得到的模型,拥有更好的泛化能力

softmax函数:

softmax函数解决了从一个原始的n维向量,向一个n维的概率分布映射的问题

残差网络:

计算资源的消耗

模型容易过拟合

梯度消失/梯度爆炸问题的产生

问题1可以通过GPU集群来解决,对于一个企业资源并不是很大的问题;

问题2的过拟合通过采集海量数据,并配合Dropout正则化等方法也可以有效避免;

问题3通过Batch Normalization也可以避免。貌似我们只要无脑的增加网络的层数,我们就能从此获益,但实验数据给了我们当头一棒。

作者发现,随着网络层数的增加,网络发生了退化(degradation)的现象:随着网络层数的增多,训练集loss逐渐下降,然后趋于饱和,当你再增加网络深度的话,训练集loss反而会增大。注意这并不是过拟合,因为在过拟合中训练loss是一直减小的。

当网络退化时,浅层网络能够达到比深层网络更好的训练效果,这时如果我们把低层的特征传到高层,那么效果应该至少不比浅层的网络效果差,或者说如果一个VGG-100网络在第98层使用的是和VGG-16第14层一模一样的特征,那么VGG-100的效果应该会和VGG-16的效果相同。所以,我们可以在VGG-100的98层和14层之间添加一条直接映射(Identity Mapping)来达到此效果

Cross-attention

- Transformer架构中混合两种不同嵌入序列的注意机制

- 两个序列必须具有相同的维度

- 两个序列可以是不同的模式形态(如:文本、声音、图像)

- 一个序列作为输入的Q,定义了输出的序列长度,另一个序列提供输入的K&V

Attention:

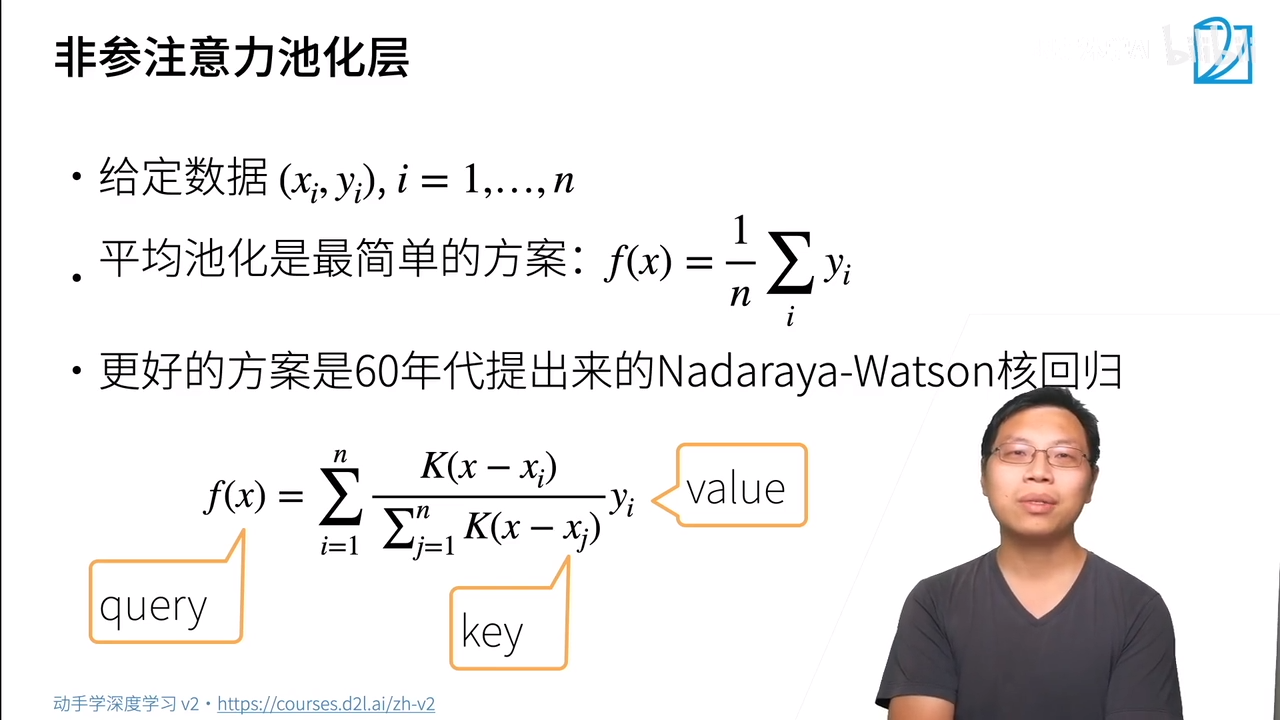

非参注意力池化层

K是衡量距离的一个函数(kernel),比如这个值越大距离就越近,越小就距离越远

非参的意思是不需要学任何东西。拿一个新值去求其近似值,有点像KNN

浙公网安备 33010602011771号

浙公网安备 33010602011771号