7.Spark SQL

1.请分析SparkSQL出现的原因,并简述SparkSQL的起源与发展。

Spark SQL是Spark用来处理结构化数据的一个模块,它提供了一个叫作Data Frame的编程抽象结构数据模型(即带有Schema信息的RDD),Spark SQL作为分布式SQL查询引擎,让用户可以通过SQL、DataFrame API和Dataset API三种方式实现对结构化数据的处理。但无论是哪种API或者是编程语言,都是基于同样的执行引擎,因此可以在不同的API之间随意切换。

Spark SQL的前身是 Shark,Shark最初是美国加州大学伯克利分校的实验室开发的Spark生态系统的组件之一,它运行在Spark系统之上,Shark重用了Hive的工作机制,并直接继承了Hive的各个组件, Shark将SQL语句的转换从MapReduce作业替换成了Spark作业,虽然这样提高了计算效率,但由于 Shark过于依赖Hive,因此在版本迭代时很难添加新的优化策略,从而限制了Spak的发展,在2014年,伯克利实验室停止了对Shark的维护,转向Spark SQL的开发。

2. 简述RDD 和DataFrame的联系与区别?

RDD:

分布式的java对象的集合

Spark框架本身不了解内部结构

转换操作

行动操作

面向对象的编程风格

DataFram能做的事情RDD都能做,RDD能做的事情DataFrame不一定能做

DataFrame:

分布式的Row对象的集合

DataFrame带有schema元信息.

Spark SQL清楚地知道该数据集中包含哪些列,每列的名称和类型。

新的操作数据的方法

SQL

提升执行效率、减少数据读取以及执行计划的优化

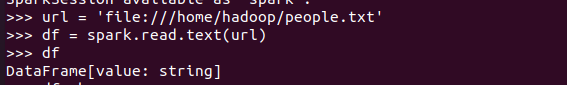

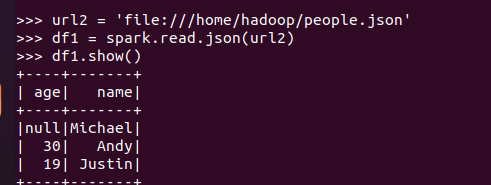

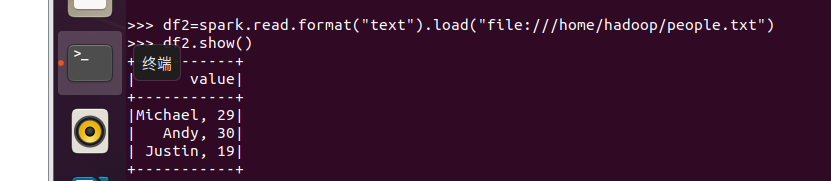

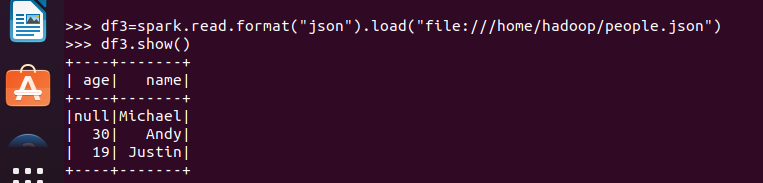

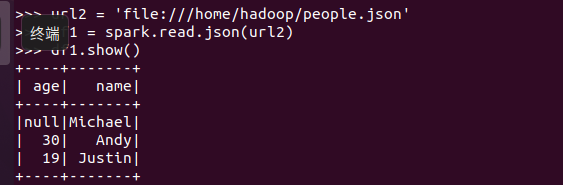

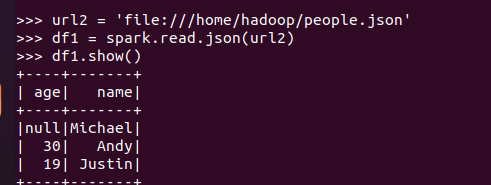

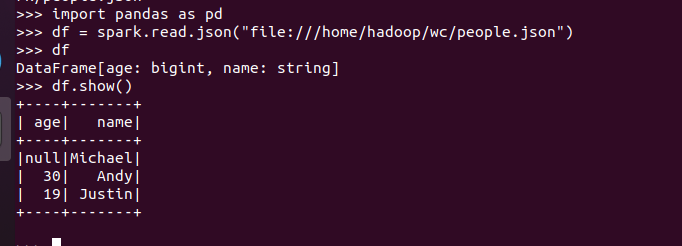

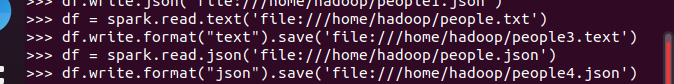

3.DataFrame的创建

spark.read.text(url)

spark.read.json(url) 注意从不同文件类型生成DataFrame的区别。

spark.read.format("text").load("people.txt")

spark.read.format("json").load("people.json")

4. PySpark-DataFrame各种常用操作

基于df的操作:

打印数据 df.show()默认打印前20条数据

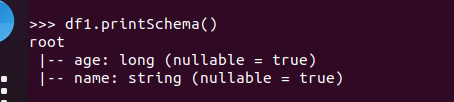

打印概要 df.printSchema()

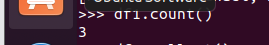

查询总行数 df.count()

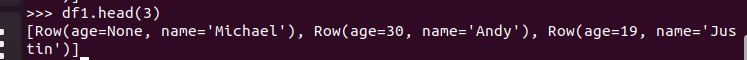

df.head(3) #list类型,list中每个元素是Row类

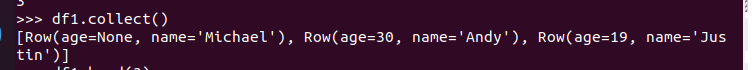

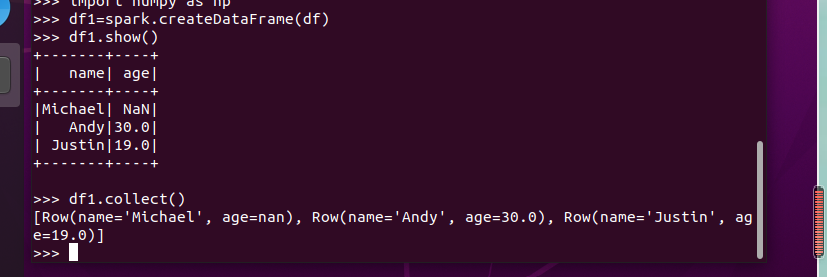

输出全部行 df.collect() #list类型,list中每个元素是Row类

查询概况 df.describe().show()

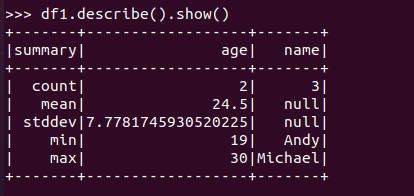

取列 df[‘name’], df.name, df[1]

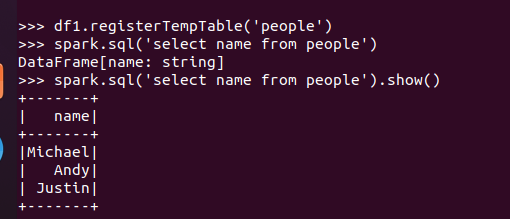

基于spark.sql的操作:

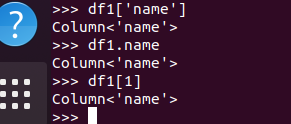

创建临时表虚拟表 df.registerTempTable('people')

spark.sql执行SQL语句 spark.sql('select name from people').show()

5. Pyspark中DataFrame与pandas中DataFrame

分别从文件创建DataFram

比较两者的异同

Pyspark的DataFrame 是基于 RDD 的一种数据类型,具有比 RDD 节省空间和更高运算效率的优点。pandas的DataFrame 是一种表格型数据结构,按照列结构存储,它含有一组有序的列,每列可以是不同的值,但每一列只能有一种数据类型。

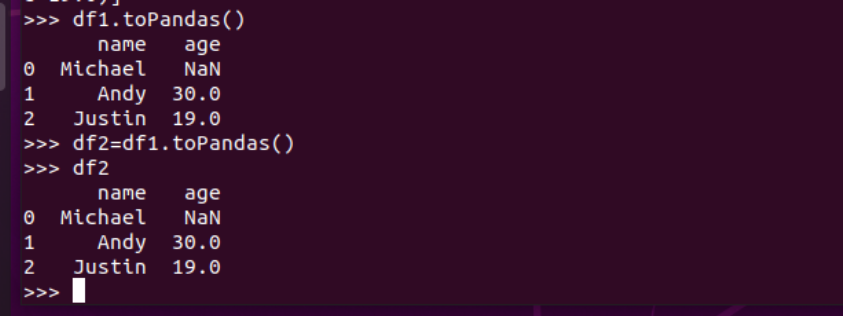

pandas中DataFrame 是可变的,pyspark中RDDs 是不可变的,因此 DataFrame 也是不可变的

pandas中所以是自动创建的,pyspark中没有 index 索引,若需要需要额外创建该列

pandas的是Series 结构,属于 Pandas DataFrame 结构,pyspark的是Row 结构,属于 Spark DataFrame 结构

pandas中DataFrame转换为Pyspark中DataFrame

Pyspark中DataFrame转换为pandas中DataFrame

6.从RDD转换得到DataFrame

6.1 利用反射机制推断RDD模式

创建RDD sc.textFile(url).map(),读文件,分割数据项

每个RDD元素转换成 Row

由Row-RDD转换到DataFrame

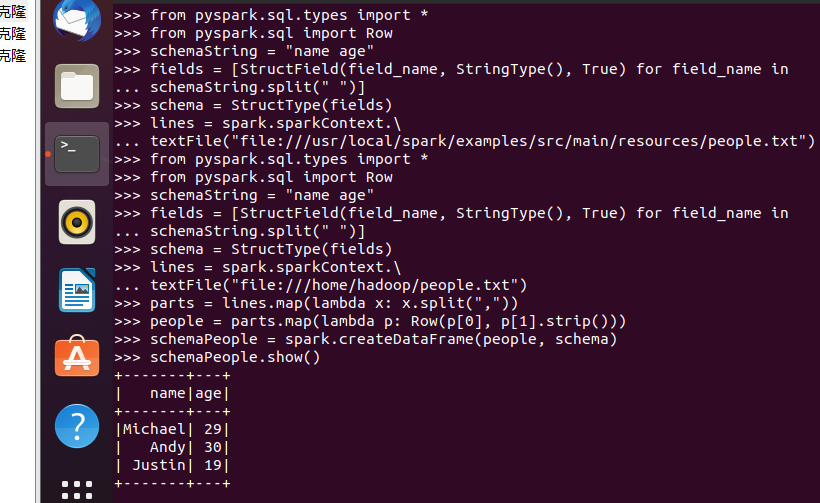

6.2 使用编程方式定义RDD模式

#下面生成“表头”

#下面生成“表中的记录”

#下面把“表头”和“表中的记录”拼装在一起

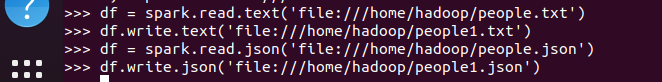

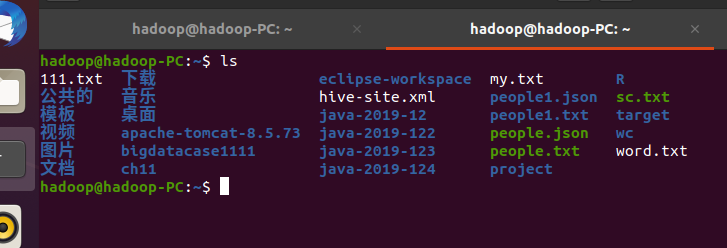

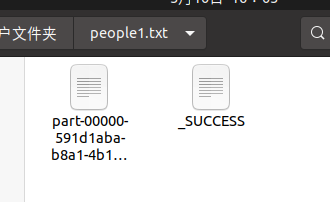

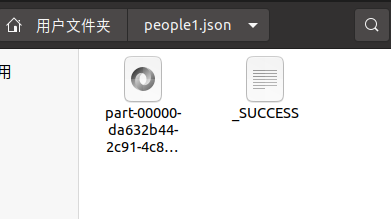

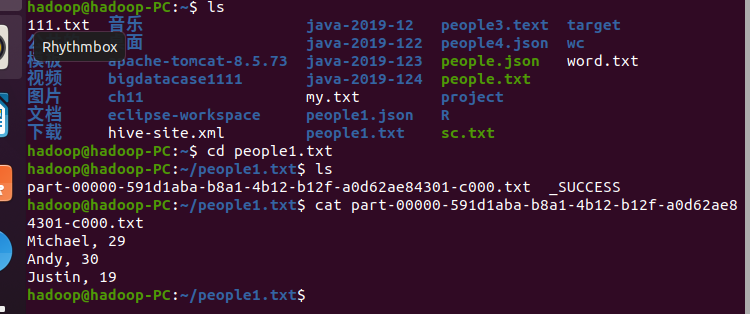

7. DataFrame的保存

df.write.text(dir)

df.write.json(dri)

df.write.format("text").save(dir)

df.write.format("json").save(dir)

浙公网安备 33010602011771号

浙公网安备 33010602011771号