零基础也能搞定!LoRA 低成本定制专属大模型,不用代码也能会

零基础也能搞定!LoRA 低成本定制专属大模型,不用代码也能会

引言:当万能大模型,遇上 “不懂代码” 的你

我们正处在一个大模型爆发的时代。从陪你聊天的智能助手,到帮你写代码的编程搭档,这些“全能型”AI展现出了惊人的通用能力。然而,当你兴奋地把它引入到自己的工作中时,可能会遇到这样的尴尬:

- 你是一个电商运营,想让AI根据你的商品库写文案,但它总用一些不接地气的网络用语。

- 你是客服负责人,希望 AI 能听懂行业黑话(比如 “工单闭环”“埋点曝光”),但它全程 “一脸茫然”;

- 你为公司内部开发了一个客服系统,但AI机器人总理解不了你们行业特有的缩写和业务流程。

问题出在哪?

根本原因在于,这些通用大模型就像一位博览群书的“通才”,它拥有海量知识,却并不专精于你的特定领域。它无法理解你业务中那些独特的“黑话”、数据格式和规则。

这时,我们就需要一种方法,能够高效、低成本地“教”会大模型你的专属知识,而不用从头训练一个模型(那需要天量的数据和算力)。这种方法就是 “微调”,而LoRA,正是当前最火热的微调“神器”。它能让你的大模型,从一个“通才”快速进化成你业务线上的“专家”。

技术原理:LoRA是如何“四两拨千斤”的?

一、核心比喻:“便利贴”学习法

想象一下,大模型的神经网络是由无数个权重矩阵(可以理解为复杂的公式)构成的。全参数微调是直接修改这些厚厚的“教科书”本身。而LoRA的做法是:把这些教科书冻结起来,原封不动。然后,在需要的关键页面上(比如注意力机制的关键层),贴上几张小小的“便利贴”(低秩矩阵)。

训练过程中,我们只修改“便利贴”上的内容。最终使用时,将“便利贴”上的内容叠加到原来的书页上,就得到了一个专为你的任务定制的新版本。因为只训练了“便利贴”(参数量极少),所以速度极快,消耗的资源也极少。

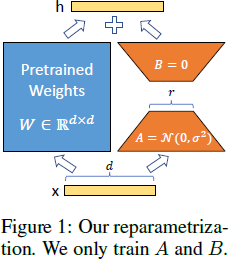

二、技术拆解:低秩矩阵的魔法

为什么叫“低秩”?这涉及到一点线性代数。简单理解,一个巨大的权重矩阵(比如1000x1000)所包含的核心变化信息,往往可以用两个更小、更“瘦长”的矩阵(比如1000x8和8x1000)相乘来近似表达。这个“8”就是秩(rank)。

冻结原权重W:保持大模型原有的核心能力不破坏。

引入低秩矩阵A和B:训练时,我们只更新这两个小矩阵。其中,B * A 的结果就是我们学到的“知识增量”ΔW。

合成新权重:在推理(使用)时,我们将学到的增量加回去:W_new = W + ΔW。这样,模型既保留了通用知识,又具备了你的专属技能。

三、LoRA的优劣一览

优势:

极致轻量:训练参数量可减少至原来的千分之一甚至万分之一,一块消费级显卡(如RTX 4090)就能跑。

训练飞快:只优化少量参数,迭代速度大幅提升。

存储友好:一个基础模型可以搭配无数个只有几MB到几百MB的LoRA“补丁”,灵活切换不同任务。

安全可靠:避免了全量微调可能导致的“灾难性遗忘”(学会了新知识,忘了旧本领)。

劣势:

性能天花板:在极其复杂的任务上,其极限性能可能略低于全参数微调。

依赖基座模型:如果基座模型本身在某方面能力很弱,LoRA也很难“无中生有”。

需要配置参数:需要选择在哪些层贴“便利贴”(target_modules),以及“便利贴”的尺寸多大(r值),这需要一些经验或实验。

实践步骤:两种方法,从代码到平台

了解了原理,我们该如何动手呢?主要有两种路径:一种是追求极致控制和理解的代码原生实现,另一种是追求效率和便捷的一站式平台。

方法一:原生代码实现(基于 Hugging Face PEFT)

这条路适合喜欢钻研的开发者。你需要在Python环境中安装transformers, peft, datasets等库。

关键步骤:

环境搭建与模型准备

首先安装必要的库,注意版本兼容性。

pip install --upgrade torch==2.1.0+cpu torchvision==0.16.0+cpu --index-url https://download.pytorch.org/whl/cpu

pip install -U transformers==4.38.2 peft==0.10.0 datasets==2.18.0 \

accelerate sentencepiece safetensors tqdm

然后选择一个合适的开源基座模型(如较小的Qwen-1.5B)并下载到本地。

准备数据

将业务数据整理成指令-响应格式。

{"instrucAon":"埋点时主要记录哪些事件?","response":"使⽤的是xx埋点框架,埋点有分为各种事件类型,主要的有曝光事件和点击事件,可以根据曝光和点击事件来统计数据,如点击率等"}

{"instrucAon":"xxxxxxxxxxxxxxxxxx?","response":"xxxxxxxxxxxxxxx"}

使用处理脚本加载和格式化数据。

import json

from datasets import Dataset

from transformers import AutoTokenizer

# 正确读取jsonl

with open("lora_seckill_qa.jsonl", "r", encoding="utf-8") as f:

raw_data = [json.loads(line) for line in f if line.strip()]

# 如果是单轮格式可直接用

# dataset = Dataset.from_list(raw_data)

# 若是conversation 格式(如 [{"conversation":[...]}]),需展开

def conversation_to_list(item):

out = [ ]

for turn in item["conversation"]:

instr = turn.get("system", "") + "\n" + turn["input"] if

turn.get("system") else turn["input"]

out.append({

"instruction": instr.strip(),

"response": turn["output"].strip()

})

return out

# 如果你的raw_data 已经是单轮格式就跳过这一段

all_samples = []

if "conversation" in raw_data[0]:

for d in raw_data:

all_samples.extend(conversation_to_list(d))

dataset = Dataset.from_list(all_samples)

else:

dataset = Dataset.from_list(raw_data)

# 保存分词器

tokenizer = AutoTokenizer.from_pretrained(

"/Users/shawn/Documents/AI-dev/models/deepseek/deepseek-ai/DeepSeek-R1-

Distill-Qwen-7B",

trust_remote_code=True,

local_files_only=True

)

tokenizer.save_pretrained("./tokenizer")

# 保存处理后的数据集

dataset.save_to_disk("./processed_dataset_ms")

print("预处理完成,已保存!")

配置LoRA与训练参数

这是核心步骤。配置LoRA的低秩矩阵、目标模块等。

import torch

from datasets import load_from_disk

from transformers import AutoTokenizer, AutoModelForCausalLM,

TrainingArguments, Trainer, default_data_collator

from peft import get_peft_model, LoraConfig

import random

# 1. 加载数据集

dataset = load_from_disk("./processed_dataset_ms")

# 2. 样本随机打乱

dataset = dataset.shuffle(seed=42)

# 3. 分词器

tokenizer = AutoTokenizer.from_pretrained("./tokenizer", local_files_only=True)

def generate_and_tokenize_prompt(batch):

texts = [

f"""<s>### Instruction:

{instruction}

### Response:

{response}

</s>"""

for instruction, response in zip(batch["instruction"],

batch["response"])

]out = tokenizer(

texts,

max_length=256,padding="max_length",

truncation=True,

add_special_tokens=False,

return_tensors=None,

)

# Loss 忽略paddingp.

out["labels"] = [

[tok if tok != tokenizer.pad_token_id else -100 for tok in label]

for label in out["input_ids"]

]

return out

tokenized_dataset =dataset.map(

generate_and_tokenize_prompt,

batched=True,

remove_columns=dataset.column_names,

desc="Tokenizing"

)

# 4. 加载基座模型(如设备有限可指定CPU/其他device)

model = AutoModelForCausalLM.from_pretrained(

"/Users/shawn/Documents/AI-dev/models/deepseek/deepseek-ai/DeepSeek-R1-

Distill-Qwen-7B",

torch_dtype=torch.bfloat16, # MPS、A100 等建议用bfloat16

local_files_only=True,

trust_remote_code=True

)

# 5. LoRA 配置

lora_config = LoraConfig(

r=8,lora_alpha=16,

target_modules=["q_proj", "v_proj", "k_proj", "o_proj"],

lora_dropout=0.05, # 或0, 稳定死记记忆;推荐小数据降dropout

bias="none",

task_type="CAUSAL_LM"

)

model = get_peft_model(model, lora_config)

model.print_trainable_parameters()

# 6. 训练参数

training_args = TrainingArguments(

output_dir="./results_ms",

per_device_train_batch_size=2,

gradient_accumulation_steps=1,

learning_rate=3e-4,

num_train_epochs=8,

logging_dir="./logs_ms",

save_steps=100,

save_total_limit=3,

logging_steps=10,

overwrite_output_dir=True,

report_to=None,

fp16=False

)

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_dataset,

data_collator=default_data_collator,

)

# 7. 训练与自动采样输出

trainer.train()

# 8. 保存模型与tokenizer

model.save_pretrained("./deepseek-7b-lora_ms")

tokenizer.save_pretrained("./deepseek-7b-lora_ms")

print("训练完成。")

开始训练与成本观察

启动训练脚本,观察损失值下降。使用1000条数据微调一个14B模型,单次成本可能在10元左右。

测试效果

训练完成后,使用测试脚本验证模型效果。

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer

from peft import PeftModel

# 路径设置

BASE_PATH = "/Users/shawn/Documents/AI-dev/models/deepseek/deepseekai/

DeepSeek-R1-Distill-Qwen-7B"

LORA_PATH = "./deepseek-7b-lora_ms"

# 加载分词器

tokenizer = AutoTokenizer.from_pretrained(

BASE_PATH,

local_files_only=True,

trust_remote_code=True

)

# === 严格分离模型实例 ===

# 原始模型

model_base = AutoModelForCausalLM.from_pretrained(

BASE_PATH,

device_map="mps",

torch_dtype=torch.bfloat16,

local_files_only=True,

trust_remote_code=True

)

# 微调后的模型(Base + LoRA 适配器)

model_base_for_lora = AutoModelForCausalLM.from_pretrained(

BASE_PATH,

device_map="mps",

torch_dtype=torch.bfloat16,

local_files_only=True,

trust_remote_code=True

)

model_lora = PeftModel.from_pretrained(

model_base_for_lora,

LORA_PATH

)

def format_prompt_one_round(user_input: str) -> str:

return f"<s>### Instruction:\n{user_input}\n### Response:\n"

def generate_single(model, prompt, tokenizer, max_new_tokens=200):

inputs = tokenizer(prompt, return_tensors="pt")

for k, v in inputs.items():

inputs[k] = v.to(model.device)

with torch.no_grad():

outputs = model.generate(

**inputs,

max_new_tokens=max_new_tokens,

temperature=0.7,

top_p=0.9,

do_sample=True,

eos_token_id=tokenizer.eos_token_id

)

full_output = tokenizer.decode(outputs[0], skip_special_tokens=True)

reply = full_output[len(prompt):]

# 截断下一个分隔符,保证只输出新生成内容

for sep in ["<s>", "</s>", "###"]:

if sep in reply:

reply = reply.split(sep)[0]

return reply.strip()

def main():

print("="*40)

print("DeepSeek 模型微调前/后 单轮对话对比(严格模型物理分离版)")

print("="*40)

print("输入exit 退出。\n")

while True:

user_input = input("你说:").strip()

if user_input.lower() in {"exit", "quit"}:

print("对话结束~ 再见!")

break

prompt = format_prompt_one_round(user_input)

# 原始模型推理

base_reply = generate_single(model_base, prompt, tokenizer)

# LoRA 微调后模型推理

lora_reply = generate_single(model_lora, prompt, tokenizer)

print("\n-------------------------------")

print("【原模型 输出】↓\n" + base_reply)

print("\n【微调后输出】↓\n" + lora_reply)

print("-------------------------------")

if __name__ == "__main__":

main()

可以看到,原模型对业务知识一无所知,而微调后的模型已经能有效回答相关问题(尽管小模型小数据下可能存在过拟合)。

方法二:无代码操作

我踩了很多坑后,发现 LLaMA-Factory Online 这个工具特别适合新手,把复杂的技术都封装好了,不用管代码、不用配环境,专注准备数据就行。

第一步:准备数据(最核心,10 分钟搞定)

不用懂数据格式,只要整理成 “问题 + 答案” 的形式就行

比如:

问题(指令):“写一款夏季棉麻连衣裙的文案,突出透气、显瘦”

答案(响应):“透气棉麻材质,高腰剪裁显瘦不挑身材,海边度假、日常通勤都适配,3 种温柔色系可选,久坐不闷汗”

支持 Excel、记事本等常见格式,几百条数据就够(最少 100 条,越多效果越好)。如果是多轮对话(比如客服场景的 “咨询 - 回复 - 追问 - 再回复”),也不用特意格式化,工具会自动识别。

第二步:选择工具 + 配置参数(鼠标点一点)

打开 LLaMA-Factory Online(不用下载,网页端直接用),注册后进入 “模型微调” 模块;

上传准备好的数据,工具会自动校验格式,有问题会提示修正(比如少了答案、格式错乱);

选基础模型:新手直接选推荐的 “Qwen-1.5B”,轻量又好用,不用自己下载;

参数不用管:工具会根据你的数据类型(文案、客服、问答等)自动推荐最优参数,比如 “循环次数”“学习率”,完全不用懂是什么意思。

第三步:启动训练 + 测试效果(坐等就行)

点击 “开始训练”,工具会显示实时进度(比如 “训练中 30%”“剩余 20 分钟”),不用管算力,工具自带免费额度(1000 条数据以内基本免费),超出后也才 0.03 元 / 千 Token,一次训练成本不到 10 元。

训练完成后,直接在工具里测试:输入问题,就能看到微调前后的对比。我之前用它训练电商文案模型,原模型写的文案千篇一律,微调后不仅贴合品牌风格,还能准确突出产品卖点,完全不用手动修改。

LoRA技术无疑为我们打开了一扇低成本、高效率定制AI能力的大门。它让“让大模型懂业务”从一个美好的愿景,变成了一个可执行、可落地的技术方案。无论是个人开发者还是中小企业团队,现在都有能力基于自身的数据资产,锻造出具有独特竞争力的AI应用。

展望未来,随着大模型生态的成熟,我们相信模型的“专业化”和“场景化”会是必然趋势。而像LLaMA-Factory Online这样的低门槛大模型微调平台,正在将这项技术的复杂度进一步降低。它们把繁琐的环境配置、资源调度和流程管理封装成开箱即用的服务,让开发者、产品经理甚至业务人员都能把重心完全放在“数据”和“业务逻辑”本身。你可以将它理解为AI时代的“应用工厂”,输入你的数据,配置你的需求,就能产出为你量身定制的模型能力,从而快速构建智能客服、内容生成、数据分析等各类AI应用,真正抓住大模型带来的生产力革命机遇。

未来,我们期待看到更多行业知识通过LoRA这样的技术注入到AI中,催生出无数个深度结合行业Know-how的智能体,让AI不仅“可用”,更能“好用”、“专用”,赋能千行百业。

浙公网安备 33010602011771号

浙公网安备 33010602011771号