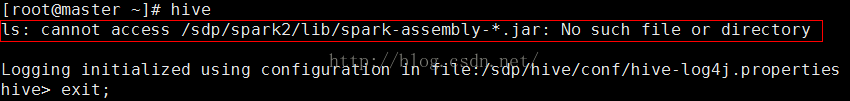

Hive on Spark 报错

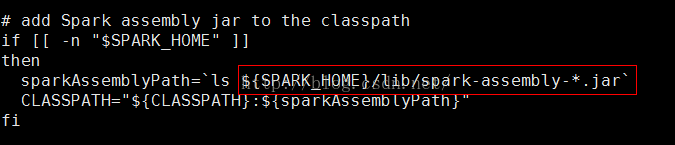

1.自从spark2.0.0发布没有assembly的包了,在jars里面,是很多小jar包

修改目录查找jar

2.异常HiveConf of name hive.enable.spark.execution.engine does not exist

在hive-site.xml中:

hive.enable.spark.execution.engine过时了,配置删除即可

3.异常

Failed to execute spark task, with exception 'org.apache.hadoop.hive.ql.metadata.HiveException(Failed to create spark client.)' FAILED: Execution Error, return code 1 from org.apache.hadoop.hive.ql.exec.spark.SparkTask

Spark与hive版本不对,spark的编译,在这里我使用的是hive稳定版本2.01,查看他的pom.xml需要的spark版本是1.5.0。hive与spark版本必须对应着

重新编译完报

Exception in thread "main" java.lang.NoClassDefFoundError: org/slf4j/impl/StaticLoggerBinder

在spark-env.sh里面添加

浙公网安备 33010602011771号

浙公网安备 33010602011771号