macbookpro m3本地部署DeepSeek模型

macbookpro m3有着十分强大的性能。在deepseek如火如荼的当下,可以尝试在本地部署并使用。还可以将自己的文档作为语料喂给deepseek,使其能成为自己专属的AI助手。

本文介绍使用ollama在本地部署deepseek模型,并使用chatbox优化访问的步骤。

下载ollama

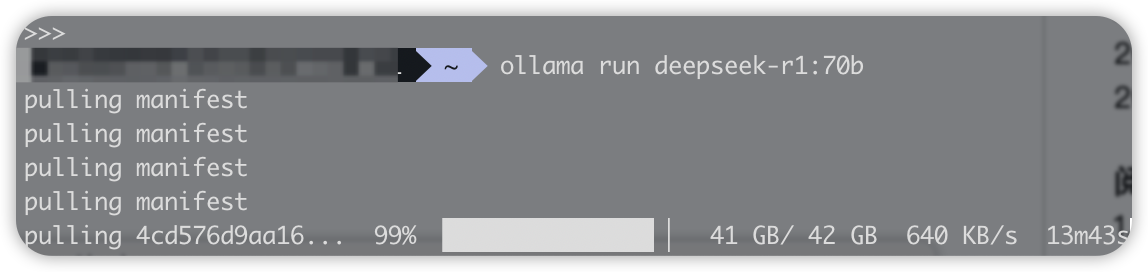

通过ollama下载deepseek r1模型

ollama run deepseek-r1:70b

ref: https://ollama.com/library/deepseek-r1:70b

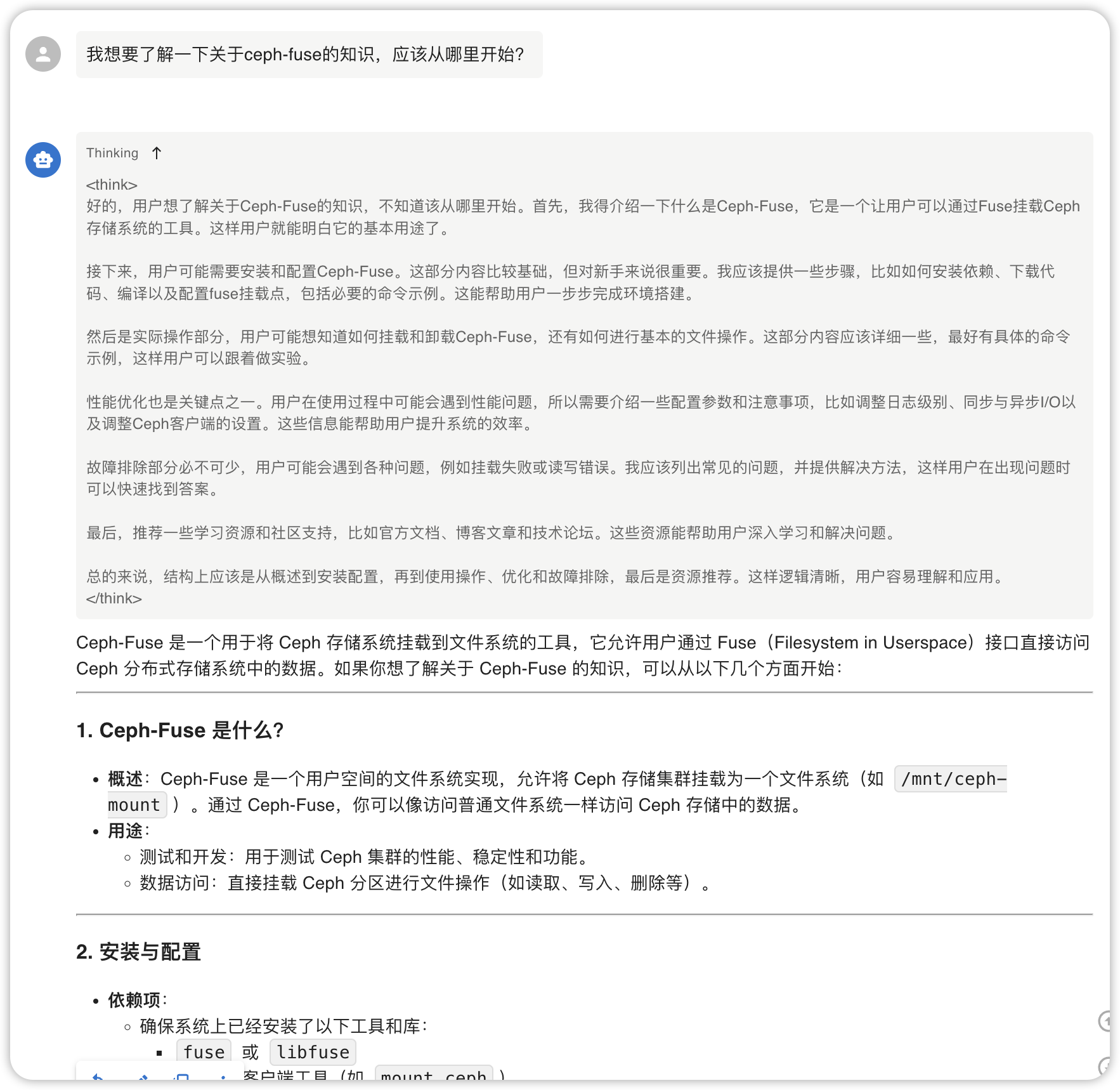

使用chatbox优化访问方式

在此处下载并安装:https://chatboxai.app/zh

使用示例

浙公网安备 33010602011771号

浙公网安备 33010602011771号