14.8.3 BERT:将ELMo与GPT结合起来

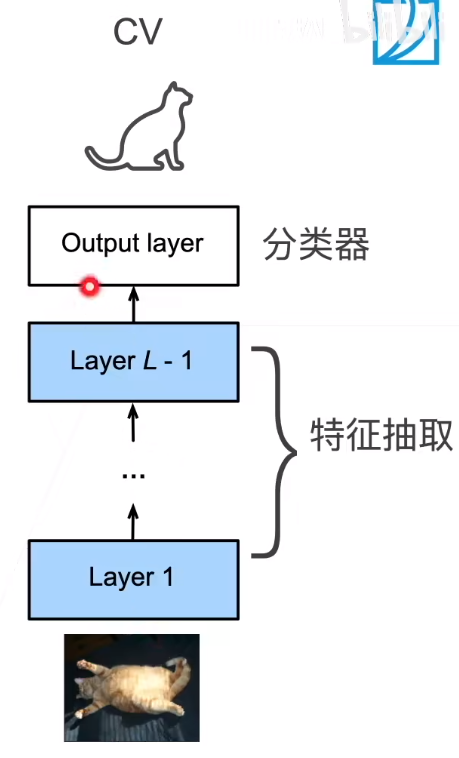

想想吴恩达讲的CV里面,复用其他网络的结构,只在最后一层加入一个全连接层,对这个全连接层进行微调,也就是如下过程

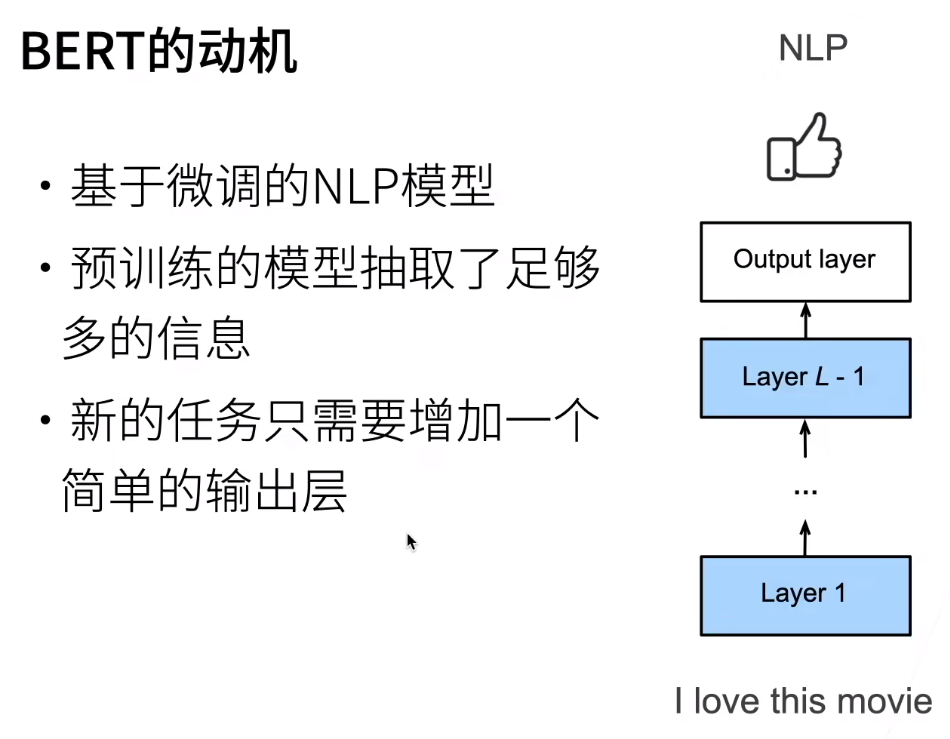

那么CV里面可以这么用,NLP里面当然也可以这么用,如下

我们只需要调整这个新增加的简单输出层即可

BERT说白了,就是只有编码器的Transformer

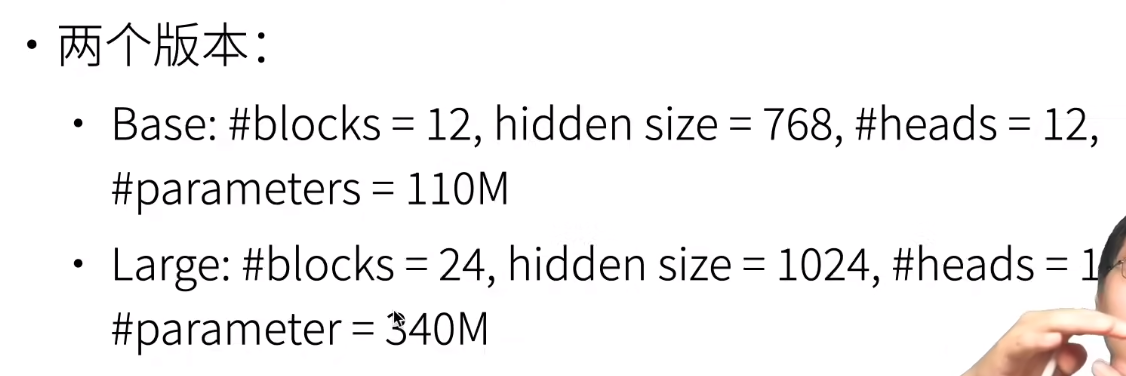

他有两个版本,见下

blocks就是Transformer的EncoderBlock

对于ELMo,冻结了LSTM的参数,所以很可能通过LSTM输出的词向量与下游任务很不相关,同时LSTM的表达能力有限,于是我们要为特定任务精心设计架构

对于GPT,我们提升了模型的表达能力同时没有冻结参数,但是此时我们只能处理一边的信息了

为了既提升模型的表达能力(从而设计一个任务通用的模型)又能处理双向,我们发明了BERT,但是此时就不能像前面两个一样直接将大量未处理文本仍给BERT了,因为现在不是普通的语言模型了,所以涉设计了MLM

浙公网安备 33010602011771号

浙公网安备 33010602011771号