暑假学习二 8.24 Hadoop的环境配置

今日学习内容:

主要为Hadoop的环境配置,相关配置所需文档可以留言(?)会给发送

1.hadoop介绍:

狭义:

核心组件,Hadoop

hdfs 分布存储

yarn 资源管理和任务调度框架

mapreduce 计算 (企业基本不再直接使用)

广义:

围绕Hadoop打造的大数据生态圈

Hadoop发行版本:

开源社区:http://hadoop.apache.org/

商业版本:cloudera和hortonworks

Hadoop架构变迁:

1.0-2.0框架优化

2.0-3.0性能优化

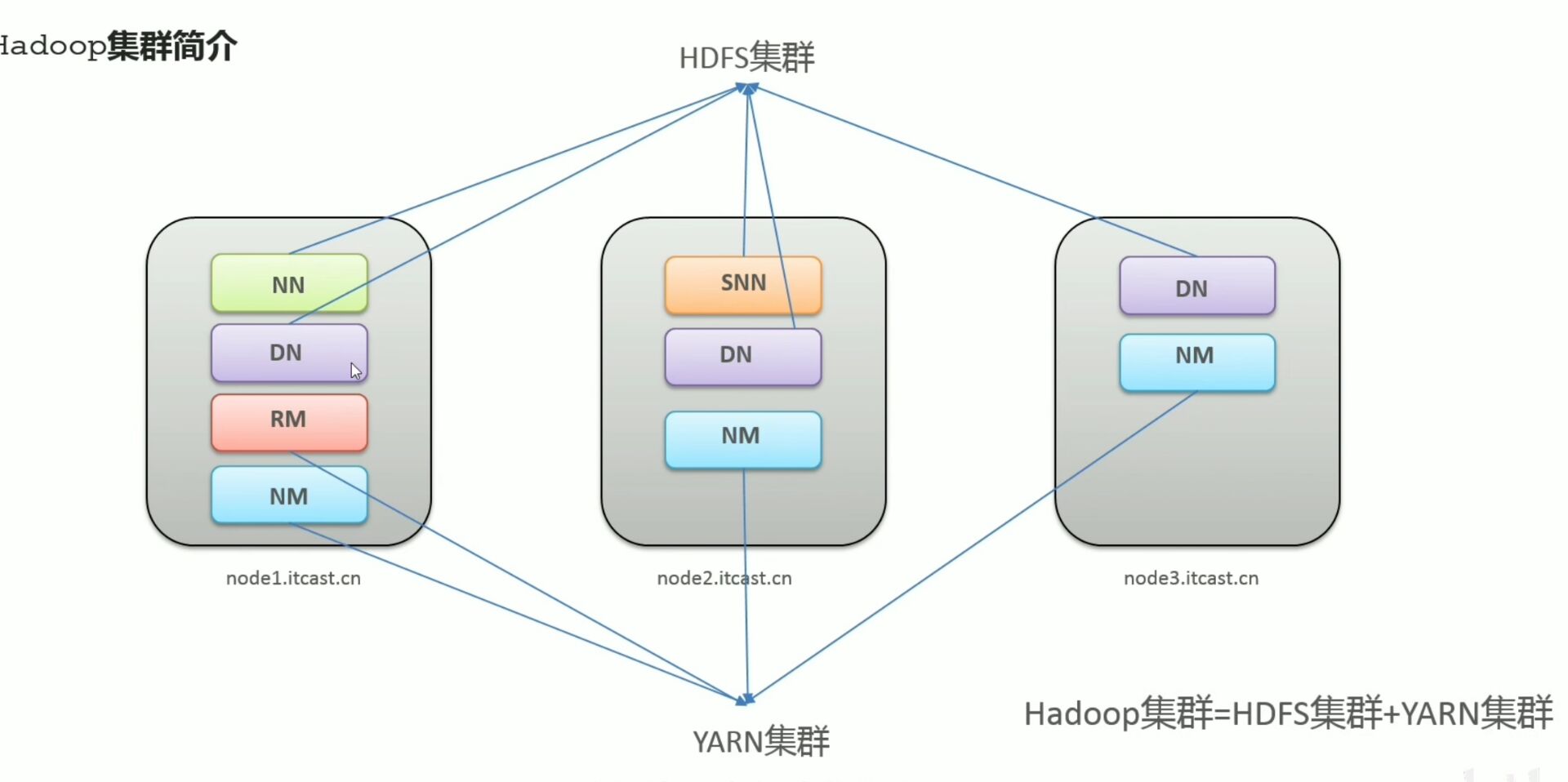

2.Hadoop集群概述:

包括,hdfs,yarn 逻辑上分离,物理上在一起,标准的主从架构集群

不存在mapreduce集群,mapreduce是计算框架,位于代码层面,不存在集群的说法

3.Hadoop集群的安装

下载网址;Index of /dist/hadoop/common/hadoop-3.3.0 (apache.org)

课程提供了安装包,有编译好的安装包。

3.1集群角色规划

3.2基础环境准备

部分提前配置过了,以下是验证:

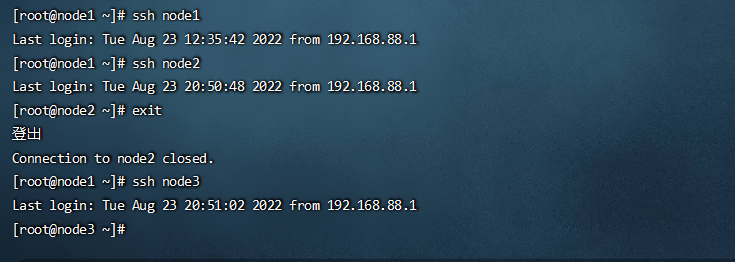

免密登录ssh:

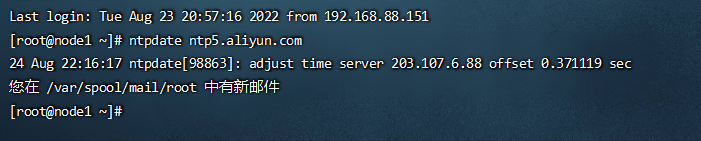

时间同步:

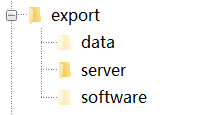

创建统一工作目录:

安装jdk在三台机器上:

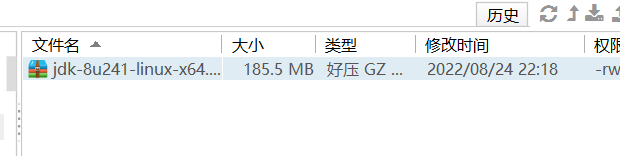

node1:先拖动导server目录下

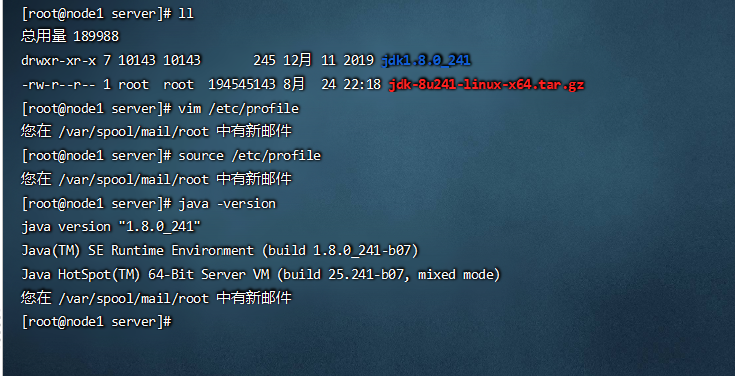

解压并且验证安装:

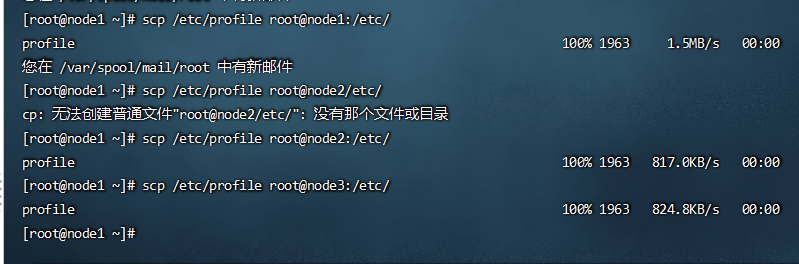

拷贝到node2下jdk:

node3:修改上面的node2为node3即可

拷贝环境变量:

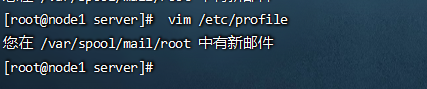

3.3 拷贝结束后同时重新加载环境变量

使用命令:

source /etc/profile

下面主要通过node1安装,node2,node3通过scp命名

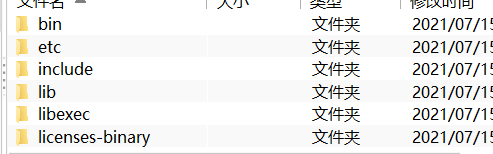

3.4 上传Hadoop资源并且解压:

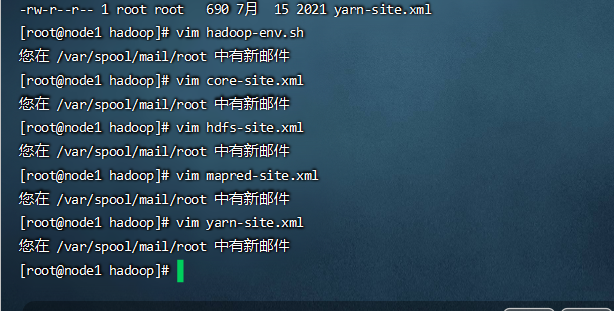

3.5Hadoop环境配置

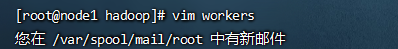

配置三类文件:

编辑环境变量

将配置完成后的文件夹以及profile都发送到另外两台机器

至此完成Hadoop的配置文件的修改,并且保证了三台机器都可以识别Hadoop命令

浙公网安备 33010602011771号

浙公网安备 33010602011771号