西瓜书读书笔记 task02

第三章 线性模型

3.1 基本形式

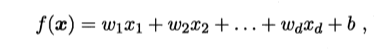

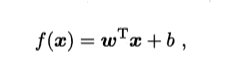

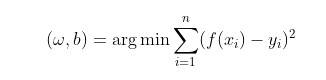

,线性模型(linear model)试图学得一个通过属性的线性组合来进行 预测的函数 xi为第i个属性上取值

一般形式为

3.2 线性回归

"线性回归" (linear regression)试图学得一个线性模 型以尽可能准确地预测实值输出标记.

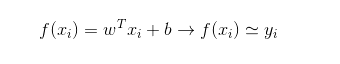

学习的最终目的是使得预测f(x)和实际值y尽量接近

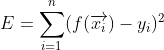

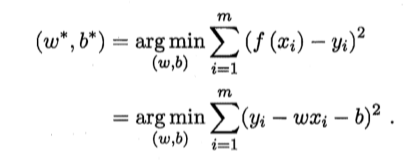

我们计算每个样本的预测值和实际值的差,然后求平方,然后在求和,要使得fx和y最近,所以

在线性回归中,最小二乘法就是试图 找到一条直线,使所有样本到直线上的欧氏距离之和最小.

求解w和b使得E(w,b)最小化的过程称为线性回归模型的最小二乘估计

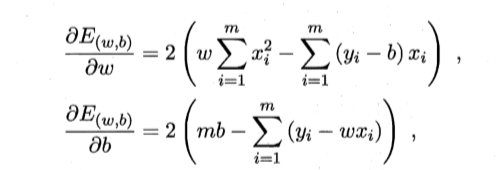

使这两个式子等于0,就得到一组二元一次方程组,然后解方程就能求出w和b

最后将x,y都带入式子就可以求出w,b

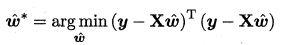

当x由d个属性描述时,试图学得:

此时称为多元线性回归。

、

、

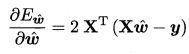

求导得

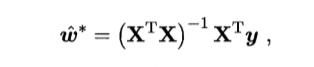

令上式得0即:

因为实际中xTx常不为满秩情况所以会有多个w他们都会使均方差误差最小化,所以还是学习算法的归纳偏好决定

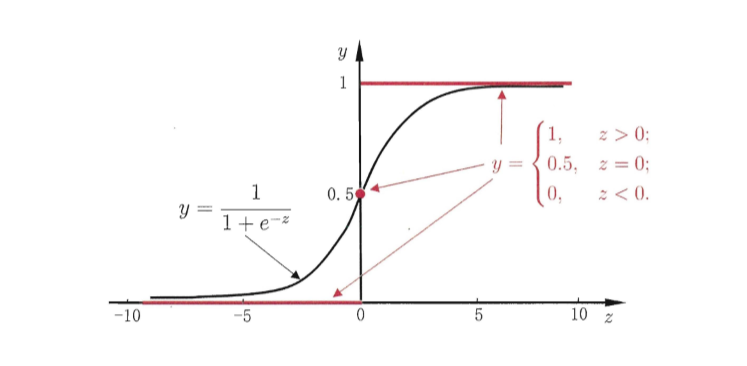

3.3 对数几率回归

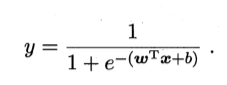

回归就是通过输入的属性值得到一个预测值,利用上述广义线性模型的特征,是否可以通过一个联系函数,将预测值转化为离散值从而进行分类呢?线性几率回归正是研究这样的问题。对数几率引入了一个对数几率函数(logistic function),将预测值投影到0-1之间,从而将线性回归问题转化为二分类问题。

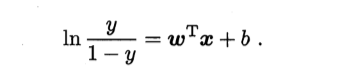

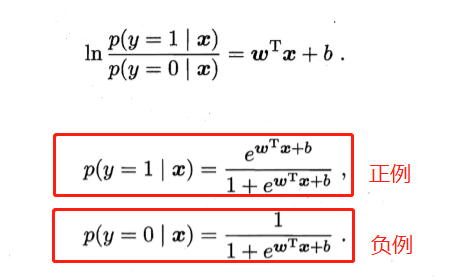

变化为

若将y看做样本为正例的概率,(1-y)看做样本为反例的概率,则上式实际上使用线性回归模型的预测结果器逼近真实标记的对数几率。因此这个模型称为“对数几率回归”(logistic regression),也有一些书籍称之为“逻辑回归”。

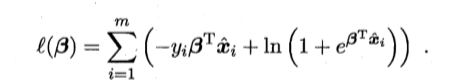

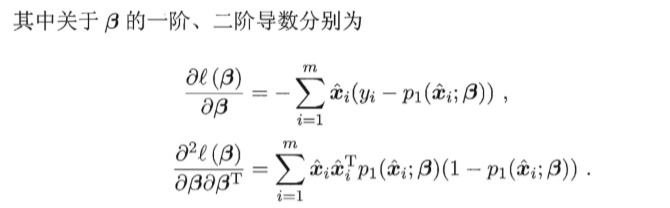

通过极大似然估计法来估计参数w,b

3.4 线性判别分析

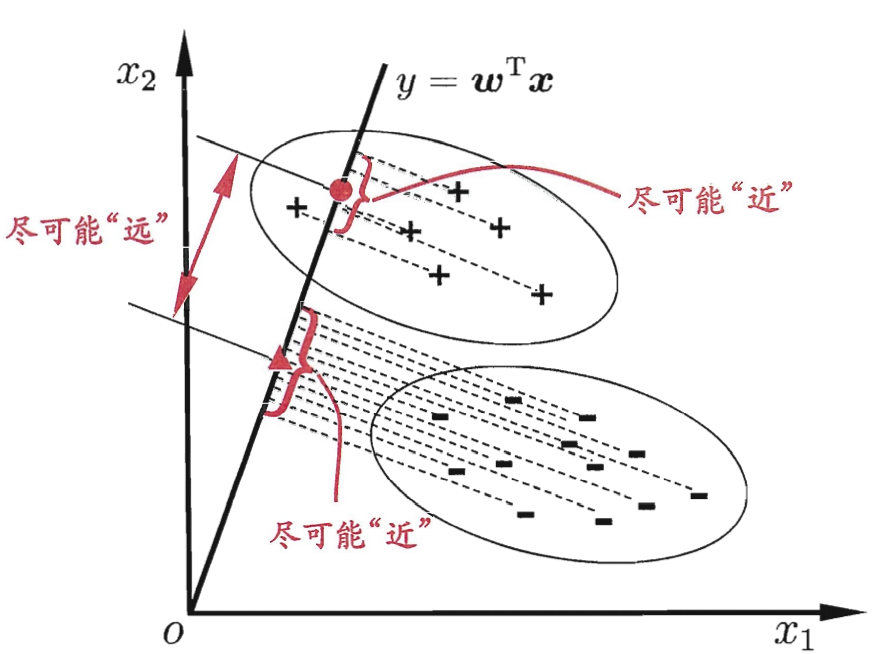

其朴素思想为: 给定训练集,将样例投影到一条直线上,是的同类的投影点尽可能近,不同类的投影点尽可能远;对新样本做分类时,同样将其投影到这条直线上,在根据投影点的位置来确定新样本的类别。

LDA 的二维示意图"+"、 " "分别代表正例和反例,椭圆表示数据簇的 外轮廓,虚线表示投影, 红色实心园和实心三角形分别表示两类样本投影后的中心点.

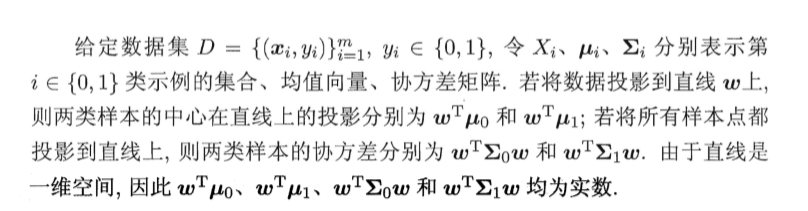

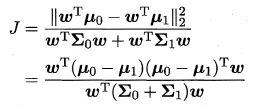

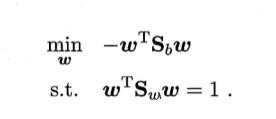

同类样例投影点的协方差尽可能小,异类样例投影点的距离尽可能大。最大化目标为:

这就是 LDA 欲最大化的目标,即 Sb 与 Sw的"广义瑞利商" (generalized Rayleigh quotie叫.

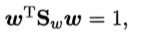

令

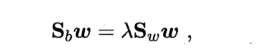

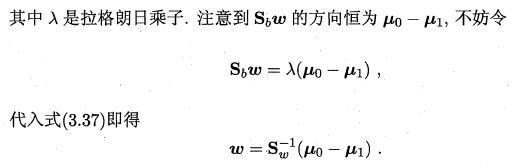

由拉格朗日乘子法,上式等价于

由贝叶斯决策理论:当两类数据同先验,满足高斯分布且协方差相等时,LDA可达到最优分类。

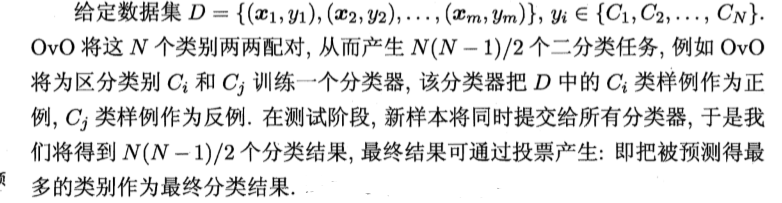

3.5 多分类学习

OvR 只需训练 N 个分类器, 而 OvO 需训练 N(N - 1)/2 个分 类器, 因此, OvO的存储开销和测试时间开销通常比 OvR 更大. 但在训练时, OvR 的每个分类器均使用全部训练样例,而 OvO 的每个分类器仅用到两个类 的样例,因此,在类别很多时, .OvO 的训练时间开销通常比 OvR 更小. 至于预 测性能, 则取决于具体的数据分布, 在多数情形下两者差不多.

MvM 是每次将若干个类作为正类,若干个其他类作为反类.显然, OvO 和 OvR 是 MvM 的特例. MvM 的正、反类构造必须有特殊的设计,不能随意选 取

3.6 类别不平衡问题

当分类的训练样例数据相差很多,达到一个数量级甚至以上时,我们通常需要通过再缩放(recalling)来平衡数据的分布,通常有几种手段:

欠采样:去掉数据量多的类别中的部分样本(简单的丢弃数据可能会导致重要信息缺失,可以将该类分割为几个集合供不同分类器训练,然后再将分类器集成)

过采样:增加数据量少的类别一部分样本(单纯通过复制样本来增加数据量可能使过拟合风险提高,可以通过一些插值算法来生成

调整阈值:将分类的阈值做相应调整

浙公网安备 33010602011771号

浙公网安备 33010602011771号