DeepSeek 开年王炸:mHC 架构用流形约束重构 ResNet 残差连接

大过节的qwen发布了image 2512,DeepSeek这边就偷摸的在arXiv 上挂出了这篇 mHC: Manifold-Constrained Hyper-Connections (arXiv:2512.24880),哪个正经公司在最后一天还发论文啊。

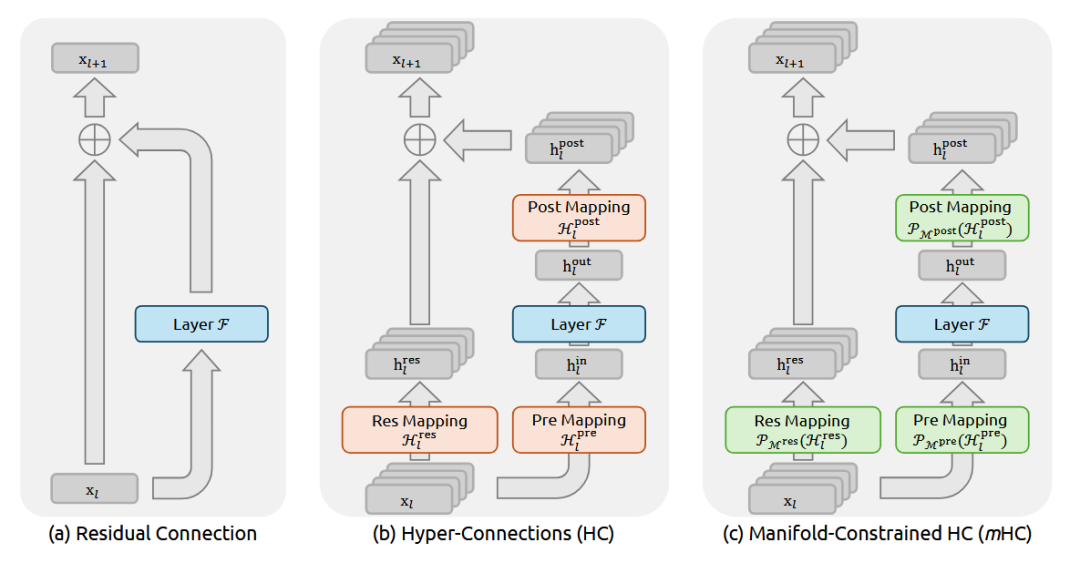

简单的看了一下,说说我的看法: 这回DeepSeek又要对 残差连接(Residual Connection)出手了。

现在我们模型的底层架构就是叠 Transformer Block,而过去这十年,对于每一层的堆叠,恺明大神的 ResNet 也就是那个 y=x+f(x),几乎行业的“公理”。它通过 Identity Mapping(恒等映射),可以让信号能无损传下去,梯度也能无损传上来,这就保证了咱们能把模型堆到几百上千层还不崩。

但 DeepSeek 团队之前(大概是去年 9 月那会儿)提了个 Hyper-Connections (好像看的人不多,我当时没太注意这个) 的概念,觉得简单的相加太浪费了就搞了个更复杂的连接方式来扩宽层间的信息通路。但是一旦你动了那个“相加”,Identity 的属性就没了,梯度传播就开始不稳定,这样训练起来特别容易炸他们管这叫 Seesaw Effect(跷跷板效应)。

这篇 mHC 就是来填这个坑的,咱们顺着逻辑拆解一下。

这就引出了 mHC 的核心:流形约束(Manifold Constraint)。

https://avoid.overfit.cn/post/51f0eb0654f744878511b56befd42a77

https://avoid.overfit.cn/post/51f0eb0654f744878511b56befd42a77

浙公网安备 33010602011771号

浙公网安备 33010602011771号