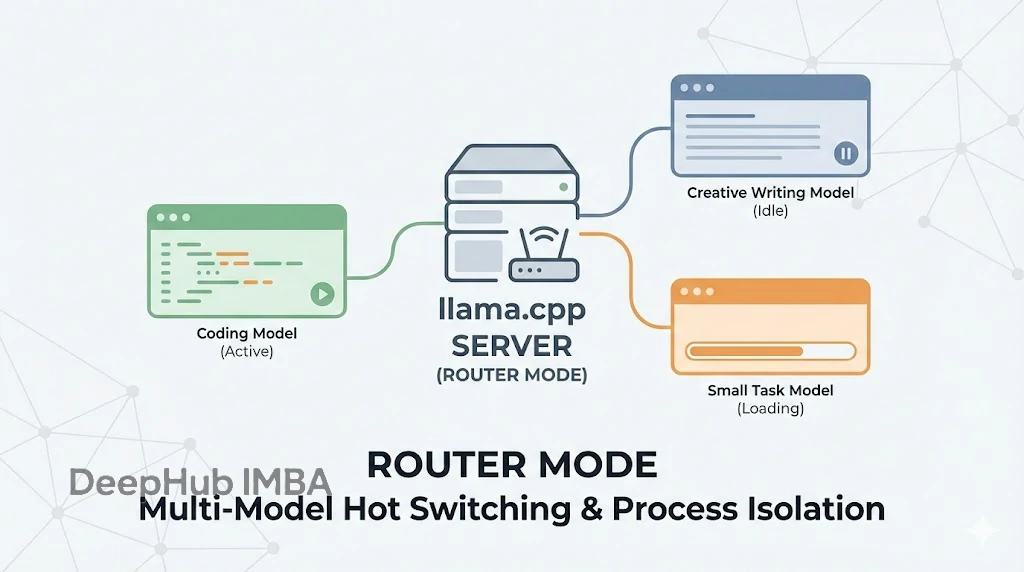

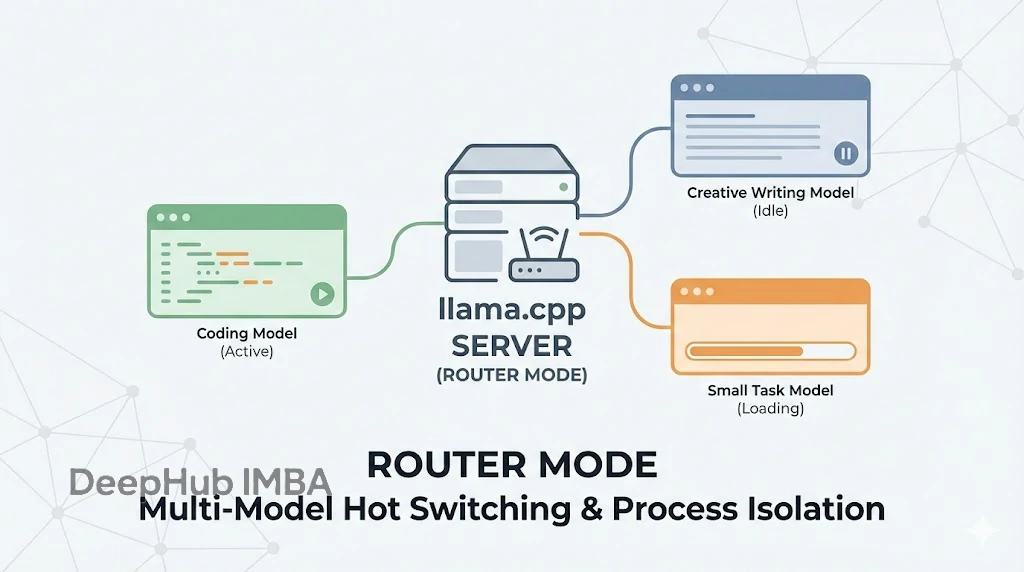

llama.cpp Server 引入路由模式:多模型热切换与进程隔离机制详解

llama.cpp server在 2025年12月11日发布的版本中正式引入了 router mode(路由模式),如果你习惯了 Ollama 那种处理多模型的方式,那这次 llama.cpp 的更新基本就是对标这个功能去的,而且它在架构上更进了一步。

https://avoid.overfit.cn/post/f604f19386df4d9ebb37aae55f899ec5

llama.cpp server在 2025年12月11日发布的版本中正式引入了 router mode(路由模式),如果你习惯了 Ollama 那种处理多模型的方式,那这次 llama.cpp 的更新基本就是对标这个功能去的,而且它在架构上更进了一步。

https://avoid.overfit.cn/post/f604f19386df4d9ebb37aae55f899ec5