MOIRAI-MOE: 基于混合专家系统的大规模时间序列预测模型

作为早期时间序列基础模型之一,Salesforce 开发的 MOIRAI 凭借其出色的基准测试性能以及开源的大规模预训练数据集 LOTSA 在业界获得了广泛关注。

本文在此前对 MOIRAI 架构原理的深入分析基础上,重点探讨其最新升级版本 MOIRAI-MOE。该版本通过引入混合专家模型(Mixture of Experts, MOE) 机制,在模型性能方面实现了显著提升。这一改进也与大语言模型模型采用的多专家机制形成了技术共鸣。

本文将系统性地分析以下核心内容:

- MOIRAI-MOE 的技术架构与实现机制

- MOIRAI 与 MOIRAI-MOE 的架构差异对比

- 混合专家模型在提升预测准确率方面的作用机理

- MOE 架构对解决时间序列建模中频率变化问题的技术贡献

MOIRAI 与 MOIRAI-MOE 的技术对比

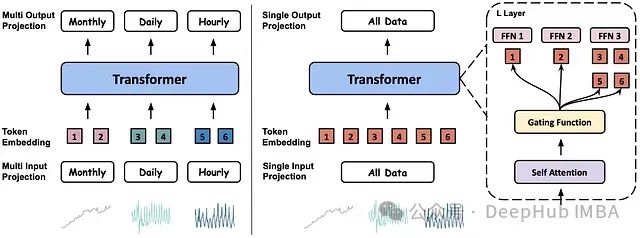

MOIRAI-MOE 采用纯解码器架构,通过混合专家模型实现了频率无关的通用预测能力,同时显著降低了模型参数规模。

图 1 展示了 MOIRAI 原始版本与 MOIRAI-MOE 的架构对比:

下面详细分析这些技术差异:

https://avoid.overfit.cn/post/e971572417b44af8b1f046cb471b6a21

浙公网安备 33010602011771号

浙公网安备 33010602011771号