spark学习进度12(RDD的Checkpoint)

1. Checkpoint

目标

-

Checkpoint 的作用

-

Checkpoint 的使用

- 、

1.1. Checkpoint 的作用

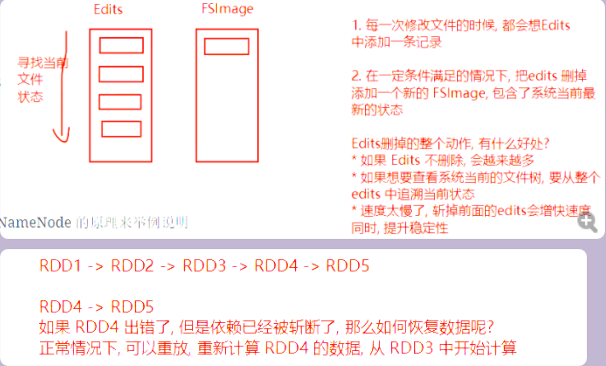

Checkpoint 的主要作用是斩断 RDD 的依赖链, 并且将数据存储在可靠的存储引擎中, 例如支持分布式存储和副本机制的 HDFS.

- Checkpoint 的方式

- 什么是斩断依赖链

- Checkpoint 和 Cache 的区别

1.2. 使用 Checkpoint

@Test def checkpoint(): Unit = { val conf = new SparkConf().setMaster("local[6]").setAppName("debug_string") val sc = new SparkContext(conf) sc.setCheckpointDir("checkpoint")//这里设置 var interimRDD = sc.textFile("dataset/access_log_sample.txt") .map(item => (item.split(" ")(0), 1)) .filter(item => StringUtils.isNotBlank(item._1)) .reduceByKey((curr, agg) => curr + agg) //下面打搭配才是最好的 interimRDD=interimRDD.cache() interimRDD.checkpoint()//这里(不准确的说他是一个action) interimRDD.collect().foreach(println(_)) sc.stop() }

浙公网安备 33010602011771号

浙公网安备 33010602011771号