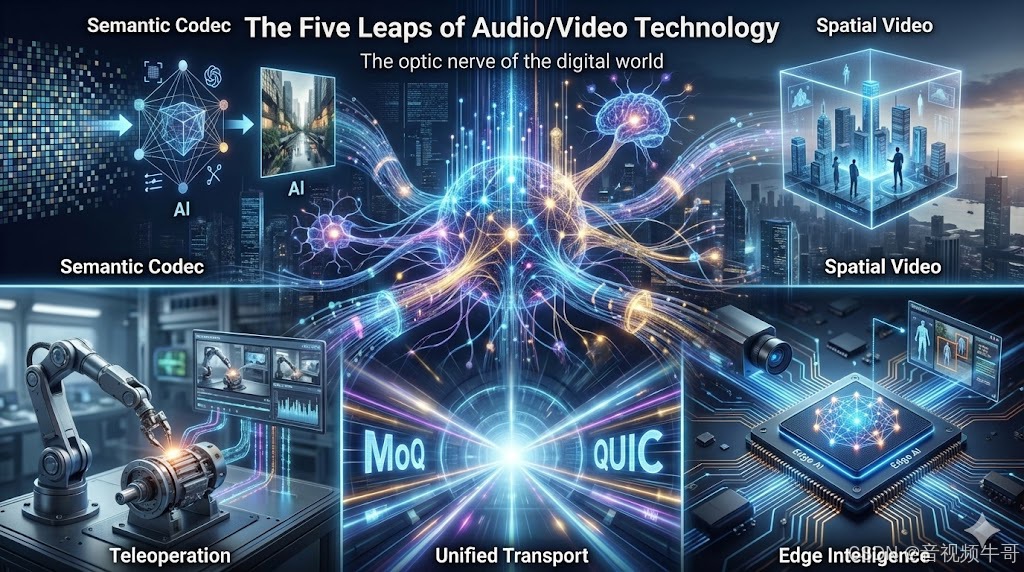

AI 重塑软件版图后,音视频的下一站在哪里?未来五年的五次关键进化

前言

过去十年,音视频技术的演进几乎都围绕同一个方向:

在有限资源下榨出更高画质、更低延迟和更强稳定性。

我们在带宽中挤空间、在协议中抠时延、在设备差异里寻求兼容性。

但到了 2025 年,这条传统进化路径正在显露疲态。

H.266 的压缩效率提升开始进入“边际衰减”,WebRTC 的交互延迟触碰物理极限,1080P 与 4K 成为默认配置,RTMP、SRT、WebRTC 各自的适用边界也愈发清晰。

“更清晰、更流畅、更低延时”不再是增量优势,而是行业的基础设施。

那么,当传统指标被卷到极限之后,音视频的下一步是什么?

基于 SmartMediakit 在安防、工业、车载、无人机等高要求场景的长期实践,我们看到的趋势是:音视频技术正从“展示”迈向“理解”,从“信号”迈向“数据”,从“人观看”迈向“机器使用”。

换句话说,它正在经历一场底层范式的转向:

-

从传像素 → 传语义

-

从二维视频 → 三维空间

-

从多协议割裂 → 统一传输层

-

从观看画面 → 远程操控

-

从 SDK 工具 → 边缘智能的操作系统

未来五年,音视频不会被替代,它会进化为数字世界的“视神经”。

以下,是音视频未来最值得提前理解的五次跃迁。

跃迁一:从“信号压缩”到“语义还原”——AI-Native Codec 的范式重构

过去二十年,视频编码的核心思想始终没变:

尽可能保留像素信号,在有限带宽中压缩出更高的保真度。

H.264、H.265 到 H.266 皆基于同一套数学框架——预测、变换、量化与熵编码。

但在 AI 时代,这条路径走到了尽头。

接下来真正的突破,不再来自更复杂的数学模型,而是来自 编码哲学的改变:

从“保存信号”转向“还原语义”。

1. 视频不再是像素,而是“语义信息流”

AI-Native Codec 的核心思想是:

摒弃逐像素保真,转而传输内容本身的语义结构。

未来的视频流可能只包含:

-

关键结构点(Keypoints)

-

姿态与运动轨迹

-

场景的几何特征

-

纹理抽象

-

Prompt + 模型参数(供生成器还原画面)

接收端不再“解码画面”,而是利用轻量模型进行 实时生成 / 重建,就像“推送画面草图,终端自行绘制高保真图像”。这是从“压缩信号”到“重建世界”的迁移。

2. 评价体系全面换轨:从 PSNR 到 LPIPS

在 AI-Native Codec 里:

-

画面是否逐像素一致不再重要

-

是否符合人眼与机器视觉的“感知一致性”才重要

LPIPS、FID 等感知指标将取代传统 PSNR/SSIM。这意味着“模糊但真实”会比“清晰但假”更可接受。

3. 带宽需求可能下降一个数量级

当推流只推“语义特征”,而非完整像素矩阵时:

-

数据量将变得更小

-

弱网表现更稳

-

移动端、无人机、车载等场景将迎来质变

音视频的传输能力,将从带宽限制中被释放出来。

4. 对 SDK 的真正启示:从封装库到轻推理框架

未来的 SmartMediakit 或同类 SDK,其核心能力将发生改变:

-

端侧推理能力(NCNN / MNN / TFLite)成为标配

-

编码链路中直接集成 AI 特征提取

-

视频流等于语义流,处理管线全面进化

推流逻辑也将从:

“推像素” → “推信息” → “推数据结构”

这对整个行业都是一次底层范式重构。

RTMP|RTSP播放器回调RGB数据进行算法分析和二次推流

跃迁二:从二维画面到三维场景——Spatial Video 的时代已悄然到来

当视频仍停留在“平面影像”阶段时,我们的交互方式就被平面束缚。

但随着 Vision Pro、Quest 3 等设备引爆空间计算浪潮,视频的载体不再是屏幕,而是现实空间本身。

未来的视频不再是“一张图”,而是“一处场景”。

1. 视频将从观看素材,变成重建空间

空间视频(Spatial Video)背后真正的价值在于:

-

它让内容具备 几何结构

-

让信息具备 空间维度

-

让观看者具备 沉浸视角

这意味着视频不再是“平面投影”,

而是 世界的轻量复刻。

3DGS(3D Gaussian Splatting)、NeRF、深度推理等技术会成为底层基石,但不需要普通开发者精通其数学本质,只需要知道:

视频从二维记录变成三维存在,这是下一代应用的基础形态。

2. 多摄同步将成为基础能力

未来的视频采集将逐渐从单路摄像头,转向:

-

多摄阵列

-

深度摄像

-

多角度融合

如何让多个画面在时间和空间上保持一致,不是某个“功能点”,而会成为空间视频时代的基本能力。

3. 传输也将从“画面压缩”变成“空间压缩”

当内容载体变成场景,传输压力自然成倍增加。

这时比拼的就不是帧率和清晰度,而是:

-

空间更新速度

-

数据重建效率

-

传输链路的连贯性

换句话说:

谁能把空间数据传得顺、渲得稳,谁就拥有了新一代终端的入口。

跃迁三:从协议割裂到统一传输——MoQ 的体系化重构

过去十年,实时音视频协议生态呈现出一种“被动多样性”:

-

RTMP:成熟稳健,但历史包袱大

-

HLS:通用性强,但偏向高延迟场景

-

WebRTC:实时性优秀,但体系庞大、实现复杂

-

SRT:抗抖动能力强,但更偏定制化场景

这些协议生于不同年代、服务于不同需求,因此整个行业被迫面对“多场景、多协议、多实现”的割裂状态。

这种碎片化本身不是问题,但不断增加的业务要求——移动性、多路协同、弱网环境、大规模分发——让这种割裂逐渐成为瓶颈。

MoQ(Media over QUIC)正是在这个历史节点出现的:

它不是为了替代某个协议,而是为了从底层统一整个流媒体体系。

1. MoQ 的意义不是“又一个协议”,而是“为现代互联网重写传输层”

MoQ 的价值不在于与 RTMP/WebRTC/SRT 竞争,而在于:

-

将 实时传输 与 内容分发 收敛到同一框架

-

把音频、视频、信令与元数据整合为统一语义层

-

简化现代音视频管线中冗余且重复的传输逻辑

-

提供一个真正面向“互联网原生”的媒体底座

换句话说,它让应用层不必再纠结于“该选 RTMP 还是 WebRTC”,

因为 流媒体的根问题被下沉到了传输层本身。

MoQ 不是新品,它是一次体系级重建。

2. MoQ 让“流”变成统一的数据结构,而非协议碎片

基于 QUIC,MoQ 天生具备:

-

多路复用

-

无队头阻塞

-

更稳定的弱网表现

-

更可控的延迟

-

更一致的资源管理方式

在 MoQ 中,多个媒体轨(音频、视频、字幕、控制指令)不再是“各自独立的协议实现”,

而是一个统一语义的数据结构。

这对实时音视频尤其关键:

不再因为某条子流拥塞而阻塞整个传输,不再需要为每条轨道单独实现策略。

本质上:

MoQ 不是在“传视频”,而是在“统一媒体数据”。

3. SmartMediakit 的工程经验:传统协议已经被挖到极限,但体系升级仍然必要

SmartMediakit 在多年安防、工业、车载、无人机等真实落地场景中已证明:

在 RTSP、RTMP 体系下,通过深度优化仍能稳定实现 100–200ms 的端到端延迟。

并且不是实验室数据,而是在:

-

公网

-

移动网络

-

弱网

-

复杂环境

-

多设备异构环境

下长期稳定运行的真实表现。

这是传统协议栈经过十多年工程经验、缓冲策略、调度机制、跨平台适配“打磨出来的极限能力”。

但同样需要看到:

传统协议之所以能达到这个水平,是靠工程堆栈做到“极致可用”,

而不是因为协议本身足够现代。

移动网络切换、车载高速移动、多路协同、媒体+控制的同步需求……

这些新场景都已经超出了传统协议诞生时的设计边界。

因此:

-

SmartMediakit 已经把 RTSP/RTMP 的潜力发挥到极致(100–200ms 稳定低延迟)

-

MoQ 则代表下一代协议的“正常形态”,减少对工程经验的过度依赖

它们的关系不是取代,而是 “现有极限” → “未来体系” 的自然演进。

总结:MoQ 让稳定性从“调优能力”变成“体系能力”

传统协议时代,秒开、弱网稳定、跨网络一致性,

都依赖 SDK 厂商的大量经验与调优。

MoQ 出现后,这些能力有机会下沉到传输层本身,

让实时体验从“工程技巧”变成“协议特性”。

对 SmartMediakit 而言,这不是威胁,而是机遇:

它意味着能在更现代、更干净的底层上,构建更强的实时链路能力。

Android平台Unity共享纹理模式RTMP播放延迟测试

跃迁四:从观看画面到操控世界——Teleoperation 才是真正的增量市场

视频的上半场是娱乐,下半场是生产力。

未来五年,音视频增长最快的赛道不会是直播,而是 实时操控类场景(Teleoperation):

-

无人机巡检

-

远程机械协作

-

工业臂示教

-

危险环境的可视化操作

-

车载辅助与远控应用

这些场景与传统视频最大的不同在于:

视频不是让人“看”的,而是让系统“行动”的。它从展示层变成了反馈层。

1. 在 Teleoperation 中,视频是一条“操作链路的一部分”,而不是单纯内容

真实的工程世界里,延迟不是越低越好,而是越 稳定 越重要。

对于绝大多数工业可视化、安防监控、车载探测、移动终端等场景,100–200ms 的端到端延迟已是成熟、可落地、可靠的行业标准。

SmartMediakit 的 RTSP/RTMP 播放器在多年的落地场景中已经证明:

即便在公网、弱网、移动网络等复杂环境下,

仍能将链路稳定保持在这一延迟区间,并同时保证:

-

画面连续

-

缓冲稳定

-

弱网可控

-

操控“手感”自然

这类“稳定低延迟”远比极端数值更关键。

对于特定的工业远控应用(如精密操控、机械臂示教),

进一步压缩延迟通常依靠:

-

专线/局域网

-

私有协议

-

深度定制的缓存策略

但这属于特定场景的工程定制,并不是实时音视频的普适门槛。

换句话说:

Teleoperation 的核心不是追求极限数字,而是让系统在真实世界里“可操作、可预期、不中断”。

2. 通用协议无法满足真实世界的操控需求

会议软件为了保证“看得顺”,往往增加缓冲、加大平滑策略。

但在操控链路中,这些策略反而适得其反。

工业级 Teleoperation 需要:

-

足够连贯(不跳变、不顿挫)

-

足够可控(延迟可预测)

-

足够稳态(网络波动不造成断链)

通用协议无法保证这些,因此垂直 SDK(如 SmartMediakit)才能在这里承担核心角色:

-

允许按场景重写缓存策略

-

按实时性要求调整丢包处理

-

在极端弱网中维持链路连续性

-

对视频与动作之间的协同进行微调

这类“场景级调优”是行业真正的壁垒。

3. Teleoperation 的规模化,将重塑“实时”的行业定义

过去我们定义实时:

“尽可能快。”

未来我们定义实时:

“快得足够自然,稳得足够可控。”

这是一种从“编码指标”向“系统体验”的迁移。

它意味着音视频不再是一个单独模块,而是整个操作链路的一部分。

安卓RTMP播放器同时播放4路RTMP流延迟测试

跃迁五:从 SDK 到边缘智能系统——未来是 Edge-Integrated Streaming

NPU 正在成为终端标配,如今的手机、工业相机、XR 设备、车载平台都具备端侧推理能力。

这使音视频的角色从简单的“通路层”,变成 “边缘智能的入口”。

1. SDK 的边界会持续外扩

未来的音视频 SDK(如 SmartMediakit)不只是:

-

采集

-

编码

-

传输

-

渲染

它还将承担:

-

轻量化模型推理

-

画面增强

-

隐私处理

-

实时检测与筛选

-

数据结构化(metadata pipeline)

它会更像一个 轻量操作系统(Edge OS),负责调度:

-

CPU

-

GPU

-

NPU

-

VPU

并确保设备在功耗、发热、算力之间取得平衡。

2. “算力在哪里,音视频就在哪里”

当终端具备智能能力:

-

视频不再只是被上传,而是被“处理后上传”

-

云不再承担全部分析,而是做最终决策

-

边缘端成为新的计算中心

这将彻底重构行业架构。

3. 未来的竞争不在于能否“跑视频”,而在于能否“调度设备本身”

这就是边缘智能时代音视频 SDK 的终极形态:

它是数据入口、计算调度器、链路管理者,也是未来智能系统的第一环。

结语:真正的进化,不在技术,而在视角

回看过去十几年,音视频行业的竞争,大多围绕清晰度、延迟、兼容性等传统指标展开。

但未来五年,这些将不再是核心战场。

它们会变成基础能力,像水、电、网络一样“理所当然”。

真正的竞争,将发生在更深层的地方:

谁能把视频从画面变成数据?

谁能让链路从传输变成理解?

谁能让端侧从渲染变成智能?

谁能让现实世界被数字世界真实地、稳定地复刻进去?

这意味着音视频不再是一个“技术模块”,

而是在 AI 时代承载 感知、行动、协作、空间重建 的基础设施。

在这条进化轨道上,通用能力会被 AI 迅速补齐,

但那些与物理世界深度绑定、与场景复杂性交织、与设备异构性紧密耦合的部分——

反而会变成新的稀缺资源。

这正是 SmartMediakit 的位置所在:

不是与 AI 竞争谁能写更多代码,而是负责把真实世界的每一帧、每一毫秒、每一次动态,

以最高的可靠性、最低的代价、最适合机器理解的方式,送入智能系统的入口。

当视频成为数据,当空间成为接口,当边缘成为算力中心,

音视频技术的角色也将彻底改写:

它将成为整个智能时代的“视神经”,

连接真实世界与数字世界的桥梁。

未来五年,音视频不会消失,更不会被替代——

它会变得更底层、更关键、更不可或缺。

我们正站在一个时代交汇点:

不是“视频如何做得更好”,

而是“如何让世界被机器看到得更准、更完整、更实时”。

这,就是下一代音视频技术的真正方向。

📎 CSDN官方博客:音视频牛哥-CSDN博客

浙公网安备 33010602011771号

浙公网安备 33010602011771号