spark之开发环境配置(windows)

特注:windows下开发spark不需要在本地安装hadoop,但是需要winutils.exe、hadoop.dll等文件,前提是你已经安装了eclipse、maven、jdk等软件。spark支持jdk版本建议是1.8及以上,如果开发spark建议将jdk编译版本设置为1.8。

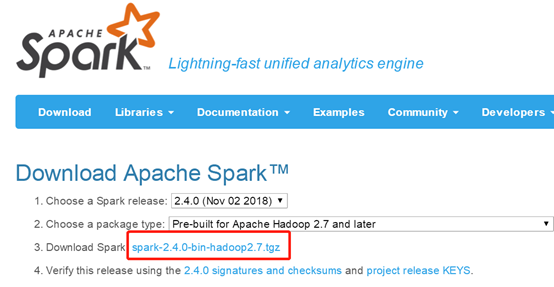

Spark

下载

网址:http://spark.apache.org/downloads.html

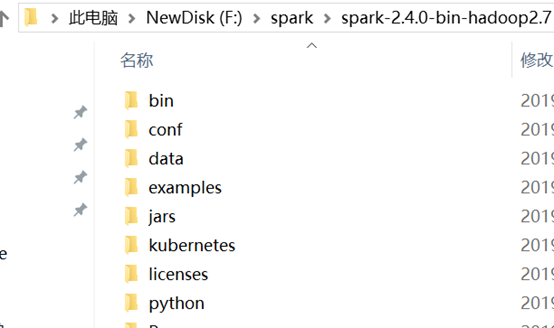

解压

环境变量配置

在cmd下输入以下命令:setx PATH “F:\spark\spark-2.4.0-bin-hadoop2.7\bin;%PATH%”

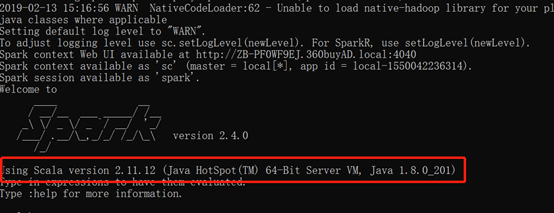

验证配置

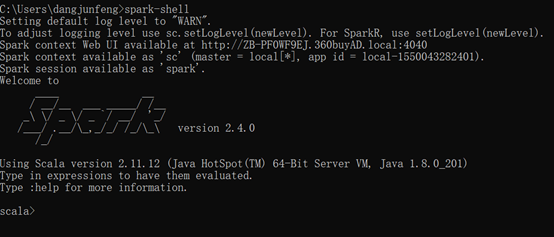

在cmd下输入spark-shell命令

如上,可以看到对应的spark、scala、java版本,同时也看到了异常信息,该异常信息是由于hadoop导致的,下面来配置hadoop。

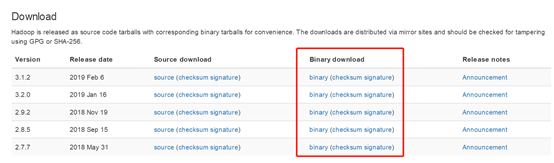

Hadoop

下载

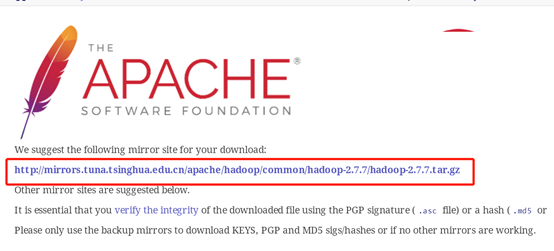

网址:http://hadoop.apache.org/releases.html

解压

环境变量配置

在cmd下依次输入以下两行命令:

- setx HADOOP_HOME F:\hadoop\hadoop-2.7.7

- setx PATH “%HADOOP_HOME%\bin;%PATH%”

winutils下载

网址:https://github.com/steveloughran/winutils

下载对应版本的bin目录直接替换本地bin目录即可。

验证配置

1、在cmd下输入spark-shell命令

此时即不会出现之前的异常提示。

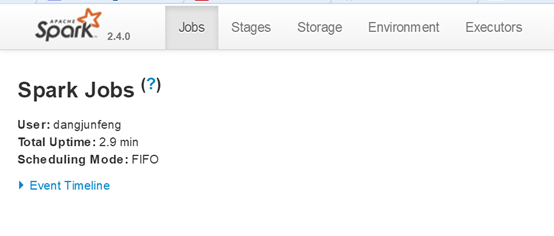

2、访问控制台中的webui如下:http://127.0.0.1:4040/jobs/

浙公网安备 33010602011771号

浙公网安备 33010602011771号