AI Ping双款新模型同步免费解锁:GLM-4.7与MiniMax M2.1实测

前言

本文聚焦国内领先大模型服务评测与聚合平台AI Ping最新上线的两款旗舰模型——GLM-4.7与MiniMax M2.1,深度解析二者核心定位与差异:GLM-4.7侧重复杂工程任务一次性交付与Agentic Coding场景;MiniMax M2.1专攻长链Agent执行,强化多语言工程能力与持续运行效率。

目录

一、旗舰模型详解:GLM-4.7 vs MiniMax M2.1

1.1 GLM-4.7:Agentic Coding先锋,复杂工程交付专家

1.1.1 GLM-4.7简介

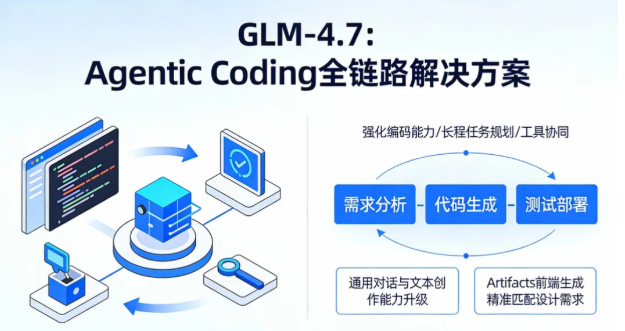

- GLM-4.7是智谱AI推出的最新旗舰模型,专为Agentic Coding场景量身打造,核心强化编码能力、长程任务规划与工具协同能力,依托可控推理机制,实现复杂工程任务的稳定、高效交付。

- GLM-4.7是智谱AI推出的新一代旗舰模型,核心定位为“Agentic Coding全链路解决方案”,专为复杂工程场景的一次性落地设计。

- 模型通过强化编码能力、长程任务规划与工具协同机制,搭配可控推理框架,可实现从需求分析到代码生成、测试部署的全流程自主完成。

- 在基础能力层面,GLM-4.7的通用对话与文本创作能力全面升级,回复逻辑更清晰、语言更自然;在专业场景中,其指令遵循度大幅提升,尤其在Artifacts前端生成领域,可精准匹配设计需求,生成的界面代码兼具美观度与可复用性。

1.1.2 与MiniMax M2.1的核心差异

- GLM-4.7:侧重一次性工程交付,适合复杂编码任务 + Artifacts前端生成;

- MiniMax M2.1:侧重长期稳定运行,适合长链Agent + 多语言后端工程。

- GLM-4.7:以“一次性交付”为核心,擅长复杂编码任务拆解与前端界面生成,适合项目初始化、核心架构落地等场景;

- MiniMax M2.1:以“长期稳定运行”为核心,强化多语言后端开发与长链任务执行,适合Agent工作流搭建、持续迭代优化等场景。

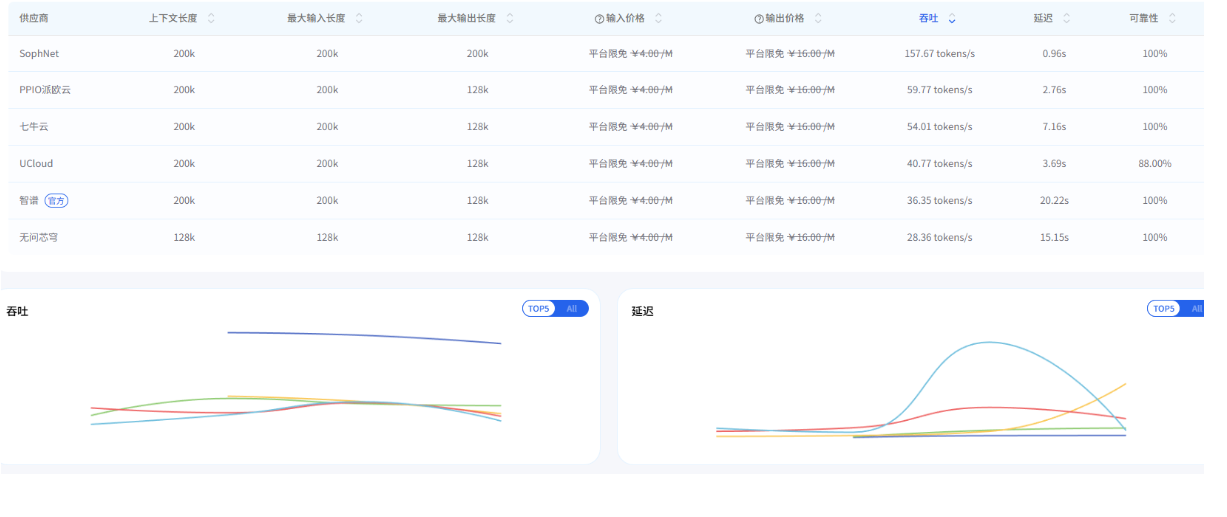

1.1.3 GLM-4.7实测数据

以下为AI Ping平台实测数据(数据截至2025年12月23日18:00),客观呈现模型真实性能:基于AI Ping标准化评测体系,我们对GLM-4.7进行了全场景实测(数据截至2025年12月23日18:00),核心性能表现如下,所有数据均可在平台实时查看验证:

1.1.4 GLM-4.7调用方式

AI Ping提供统一OpenAI兼容接口,调用流程简单便捷,具体代码如下:AI Ping为GLM-4.7提供统一的OpenAI兼容接口,无需额外适配开发,获取API Key后即可快速调用,具体流程与代码示例如下:

from openai import OpenAI

openai_client = OpenAI(

base_url="https://www.aiping.cn/api/v1",

api_key="***", # 替换为你的AI Ping API KEY

)

response = openai_client.chat.completions.create(

model="GLM-4.7",

stream=True,

extra_body={

"provider": {

"only": [],

"order": [],

"sort": None,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

},

messages=[

{"role": "user", "content": "Hello"}

]

)

for chunk in response:

if not getattr(chunk, "choices", None):

continue

reasoning_content = getattr(chunk.choices[0].delta, "reasoning_content", None)

if reasoning_content:

print(reasoning_content, end="", flush=True)

content = getattr(chunk.choices[0].delta, "content", None)

if content:

print(content, end="", flush=True)

1.2 MiniMax M2.1:长链Agent利器,多语言工程强者

1.2.1 MiniMax M2.1简介

- MiniMax M2.1是MiniMax推出的最新旗舰模型,聚焦长链Agent执行场景,核心强化多语言工程能力、持续运行效率与收敛推理路径。

- 依托高效MoE架构,实现吞吐与稳定性的出色平衡,为长期Agent工作流提供坚实支撑。MiniMax M2.1是MiniMax团队面向企业级Agent场景推出的旗舰模型,核心优势在于“长链任务执行效率”与“多语言工程适配性”。

- 模型采用高效MoE架构,在保障高吞吐的同时降低资源消耗,可稳定支撑长时间运行的Agent工作流。

- 模型强化了Rust/Go/Java/C++等8种生产级代码的支持能力,对Android/iOS原生开发与Web可视化开发适配更完善;在长时间Agent工作流执行中,推理路径更收敛、工具调用更高效,凭借低激活参数与200k长上下文优势,连续编码与持续运行吞吐进一步提升。

1.2.2 与GLM-4.7的核心差异

- GLM-4.7:侧重一次性工程交付,适合复杂编码任务 + Artifacts前端生成;

- MiniMax M2.1:侧重长期稳定运行,适合长链Agent + 多语言后端工程。

- GLM-4.7:聚焦“一次性复杂工程交付”,前端生成与架构设计能力突出;

- MiniMax M2.1:聚焦“长链Agent持续运行”,后端开发与多语言适配能力更强。

1.2.3 MiniMax M2.1实测数据

以下为AI Ping平台实测数据(数据截至2025年12月23日18:00),客观呈现模型真实性能:基于AI Ping标准化评测体系,我们对MiniMax M2.1进行了全场景实测(数据截至2025年12月23日18:00),核心性能表现如下,所有数据均可在平台实时查看验证:

1.2.4 MiniMax M2.1调用方式

同样支持统一OpenAI兼容接口,调用代码如下:MiniMax M2.1同样支持AI Ping统一的OpenAI兼容接口,调用流程与GLM-4.7一致,仅需修改模型名称参数,具体代码示例如下:

from openai import OpenAI

openai_client = OpenAI(

base_url="https://www.aiping.cn/api/v1",

api_key="***", # 替换为你的AI Ping API KEY

)

response = openai_client.chat.completions.create(

model="MiniMax-M2.1",

stream=True,

extra_body={

"provider": {

"only": [],

"order": [],

"sort": None,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

},

messages=[

{"role": "user", "content": "Hello"}

]

)

for chunk in response:

if not getattr(chunk, "choices", None):

continue

reasoning_content = getattr(chunk.choices[0].delta, "reasoning_content", None)

if reasoning_content:

print(reasoning_content, end="", flush=True)

content = getattr(chunk.choices[0].delta, "content", None)

if content:

print(content, end="", flush=True)

二、选型指南:如何精准匹配GLM-4.7与MiniMax M2.1?

GLM-4.7与MiniMax M2.1均为旗舰级模型,但定位和适用场景差异明显。结合AI Ping实测数据与场景适配性分析,为你整理了详细的选型指南:GLM-4.7与MiniMax M2.1虽同属旗舰级模型,但核心定位与场景适配性差异显著。结合AI Ping实测数据与大量项目落地经验,我们整理了清晰的选型指南,帮助开发者快速匹配最优模型:

2.1 核心差异对比

示此内容从核心能力、架构特性、场景适配、成本表现四大维度,对两款模型进行全面对比:

2.2 场景选型决策表

此内容针对不同业务场景,明确最优模型选择及核心依据:

2.3 快速决策流程图

是否需要生成前端/UI?

- 是 → GLM-4.7

- 否 → 是否涉及Rust/Go/Java/C++等后端语言?

- 是 → MiniMax M2.1

- 否 → 任务是否需要长时间持续运行?

- 是 → MiniMax M2.1

- 否 → 是否需要一次性完成复杂工程交付?

- 是 → GLM-4.7

- 否 → 两者均可,按个人偏好选择

- 是 → GLM-4.7

- 否 → 是否涉及Rust/Go/Java/C++等后端语言?

- 是 → MiniMax M2.1

- 否 → 任务是否需要长时间持续运行?

- 是 → MiniMax M2.1

- 否 → 是否需要一次性完成复杂工程交付?

- 是 → GLM-4.7

- 否 → 两者均可,按个人偏好选择

2.4 组合使用建议

对于大型复杂项目,推荐组合使用两款模型,实现优势互补:对于大型复杂项目,单一模型难以覆盖全流程需求,推荐组合使用GLM-4.7与MiniMax M2.1,实现优势互补,提升项目落地效率:

- GLM-4.7:负责项目初始化、核心架构设计、前端界面生成等一次性复杂工程交付任务;

- MiniMax M2.1:负责后端逻辑实现、长链业务流程搭建、持续迭代优化等长期运行任务。

- GLM-4.7:负责项目初始化阶段的需求分析、核心架构设计、前端界面生成,快速完成原型落地;

- MiniMax M2.1:负责项目迭代阶段的后端逻辑实现、长链业务流程搭建、Agent工具集成,保障长期稳定运行。

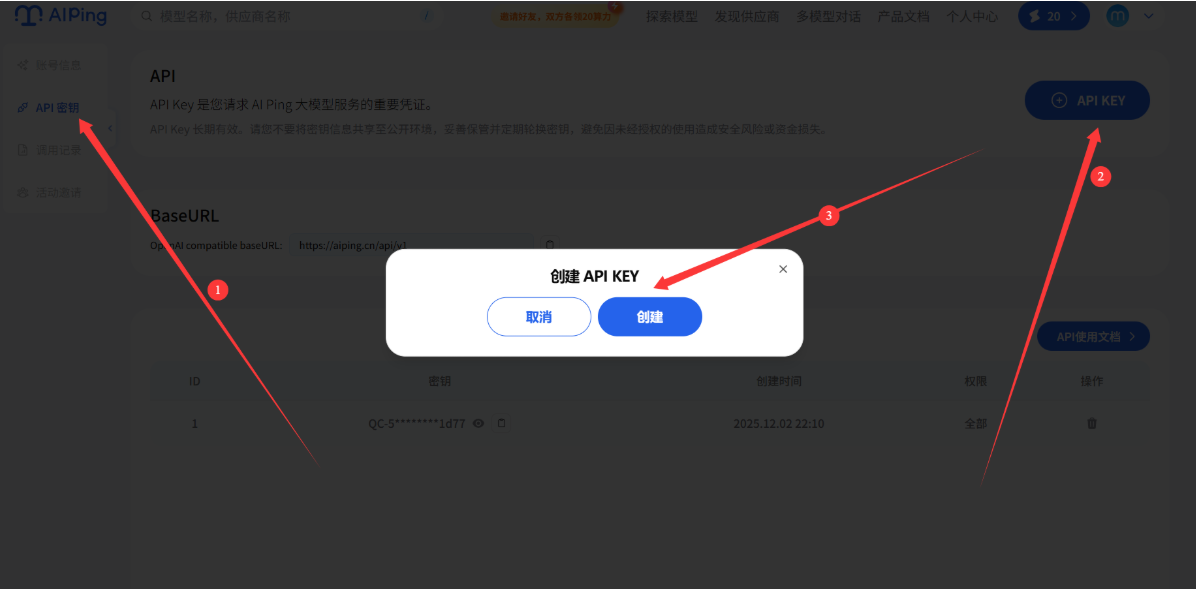

三、使用GLM-4.7实战演示:获取API KEY与平台使用指南

以GLM-4.7模型为例接入它的API进行测试模型为例,演示从选型到调用的步骤:

3.1 步骤1:创建API密钥

创建之后如图所示:

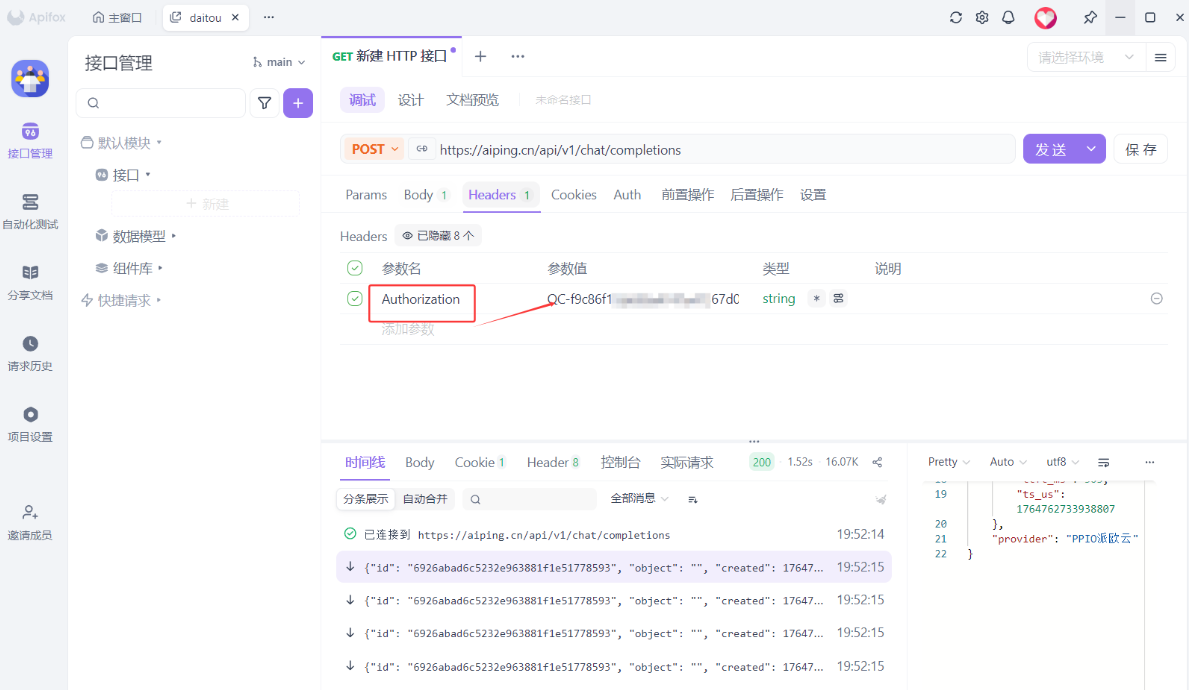

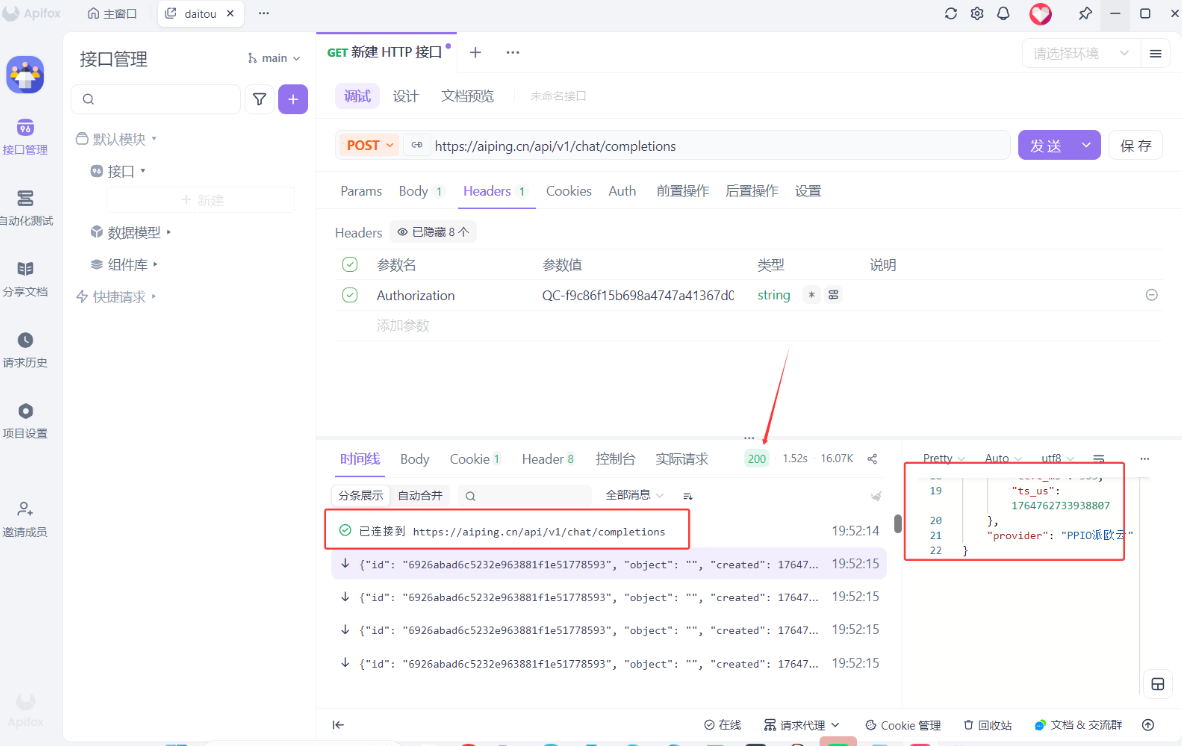

将其复制到ApifoxHeaders处,选择 Authorization

3.2 步骤2:使用Apifox进行调试

Apifox官网链接:https://app.apifox.com/main(注意这里需要下载)

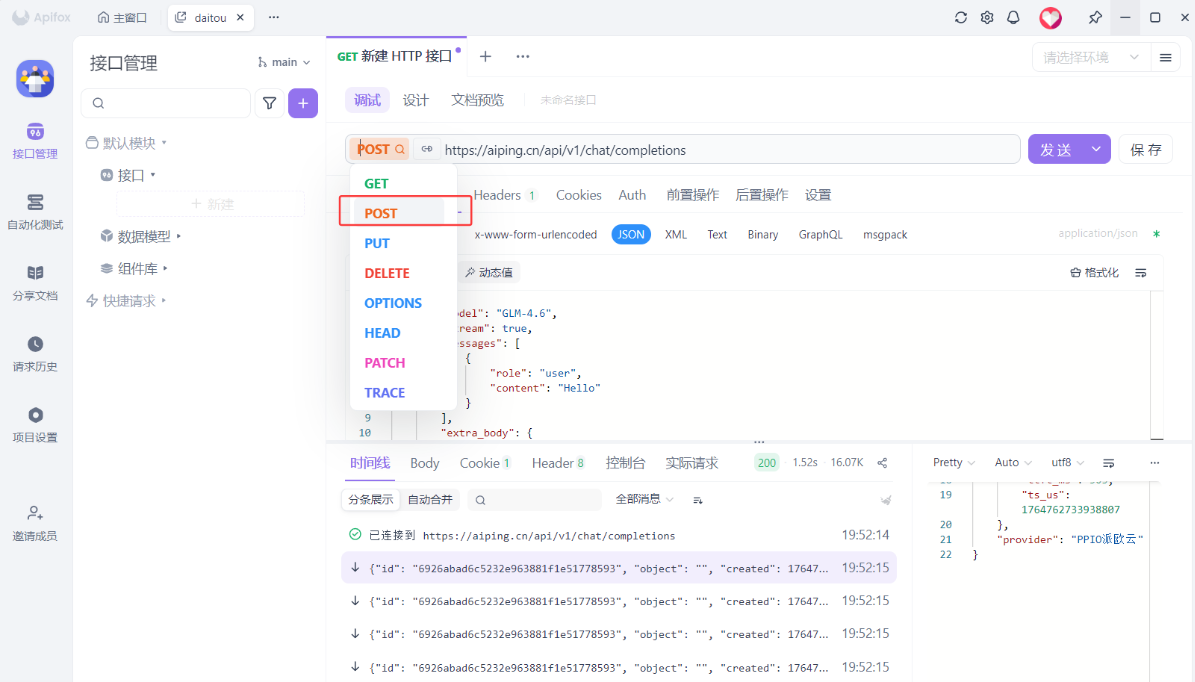

- 选择

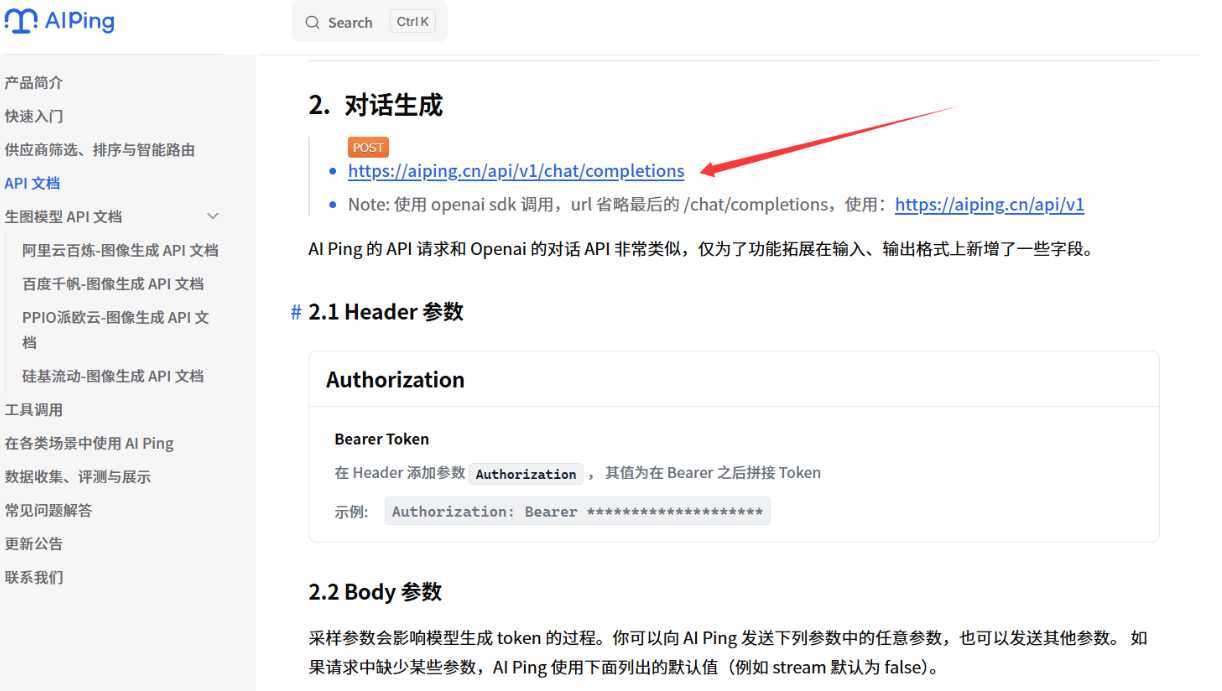

post,进入文档查看链接

- 进入官方复制链接

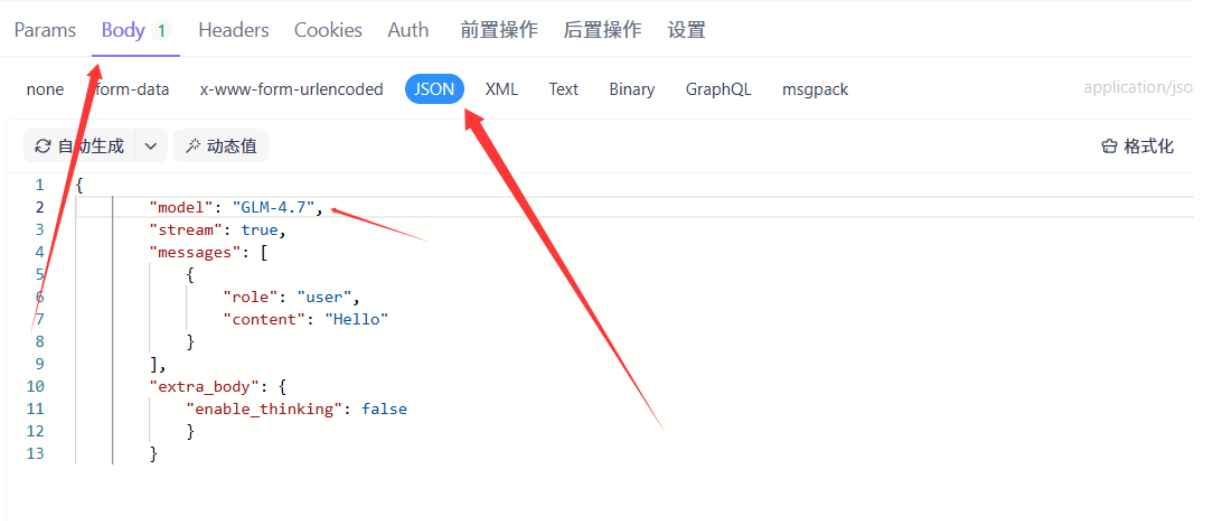

3.3 步骤3:编写调用代码

- 选择Body-JSON

modle处填写自己调用的大模型

{

"model": "GLM-4.7",

"stream": true,

"messages": [

{

"role": "user",

"content": "Hello"

}

],

"extra_body": {

"enable_thinking": false

}

}

3.4 结果果检查

说明我们已经打通自动化生产线!

四、总结:旗舰模型,AI开发更高效

- AI Ping作为国内领先的大模型聚合平台,本次上线的GLM-4.7与MiniMax M2.1两款旗舰模型,分别精准覆盖复杂工程一次性交付与长链Agent持续运行两大核心场景,为开发者提供了更丰富、更优质的选择。

- 作为国内领先的大模型评测与聚合平台,AI Ping此次上线的GLM-4.7与MiniMax M2.1,精准填补了“复杂工程落地”与“长链Agent运行”两大核心场景的需求空白,为开发者提供了高性价比的旗舰模型选择。

浙公网安备 33010602011771号

浙公网安备 33010602011771号