linux 安装 Hive 3.1.2

在安装完Hadoop(https://www.cnblogs.com/cz-xjw/p/16287905.html)之后,安装Hive

cd /opt/software #下载 wget https://dlcdn.apache.org/hive/hive-3.1.2/apache-hive-3.1.2-bin.tar.gz #解压 tar -xzvf apache-hive-3.1.2-bin.tar.gz -C /opt/module cd ../module mv apache-hive-3.1.2-bin apache-hive-3.1.2 cd apache-hive-3.1.2 vim /etc/profile #新增如下两行 export HIVE_HOME=/opt/module/apache-hive-3.1.2 PATH=$HIVE_HOME:$PATH #刷新配置 source /etc/profile

#创建hive-site.xml配置

cd config touch hive-site.xml

内容如下:

<?xml version="1.0" encoding="UTF-8" standalone="no"?> <?xml-stylesheet type="text/xsl" href="configuration.xsl"?> <configuration> <property> <name>javax.jdo.option.ConnectionURL</name> <value>jdbc:mysql://10.15.208.150:3306/hive?createDatabaseIfNotExist=true</value> <description>JDBC connect string for a JDBC metastore</description> </property> <property> <name>javax.jdo.option.ConnectionDriverName</name> <value>com.mysql.cj.jdbc.Driver</value> <description>Driver class name for a JDBC metastore</description> </property> <property> <name>javax.jdo.option.ConnectionUserName</name> <value>root</value> <description>username to use against metastore database</description> </property> <property> <name>javax.jdo.option.ConnectionPassword</name> <value>12345678</value> <description>password to use against metastore database</description> </property> </configuration>

创建临时目录

$HADOOP_HOME/bin/hadoop fs -mkdir /tmp $HADOOP_HOME/bin/hadoop fs -mkdir /user/hive/warehouse $HADOOP_HOME/bin/hadoop fs -chmod g+w /tmp $HADOOP_HOME/bin/hadoop fs -chmod g+w /user/hive/warehouse

下载mysql连接驱动包

cd /opt/module/apache-hive-3.1.2/lib wget https://repo1.maven.org/maven2/mysql/mysql-connector-java/8.0.19/mysql-connector-java-8.0.19.jar

复制hadoop的guava包到hive的lib目录

cp /opt/module/hadoop/share/hadoop/common/lib/guava-27.0-jre.jar /opt/module/apache-hive-3.1.2/lib/

初始化hive的Metastore架构

cd /opt/module/apache-hive-3.1.2/bin schematool -dbType mysql -initSchema

hive提供了jdbc的连接方式,就是在hive的某个计算节点开启hiveserver2启动方法如下

默认已启动hadoop

先启动hive元数据服务

hive --service metastore &

再启动hiveserver2服务

hive --service hiveserver2 &

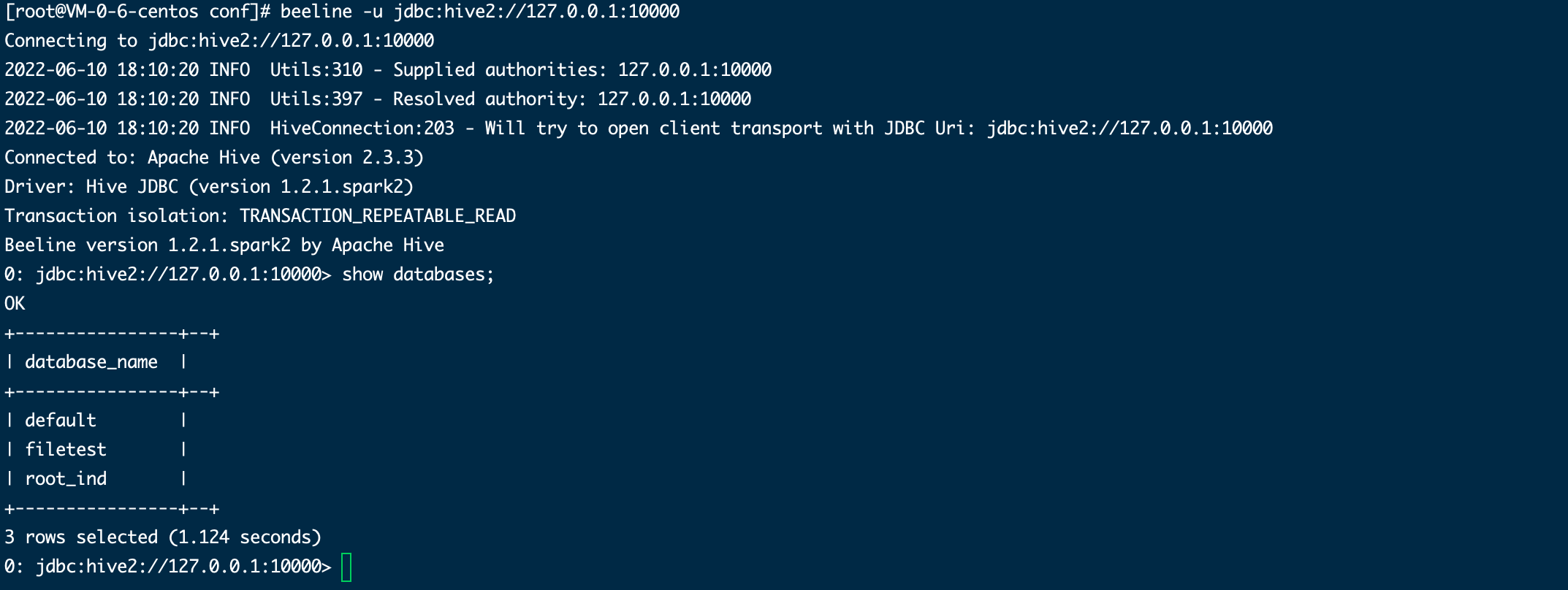

已通过beeline连接上hiveserver2,证明服务已开启

beeline -u jdbc:hive2://127.0.0.1:10000/hadoop

如下图则表示成功

如果上面的命令连接失败,则尝试修改一下hadoop的配置文件

vim $HADOOP_HOME/etc/hadoop/core-site.xml

添加如下配置,以下配置中的proxyuser后面的用户名为需要连接到hive的用户名,实际配置该替换成自己的用户名,例如连接的用户名为root,则配置如下:

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

浙公网安备 33010602011771号

浙公网安备 33010602011771号