基于最新豆包大模型1.6实现 ArXiv Paper Reading MCP与Agent构建

资料来源:火山引擎-开发者社区

AI 云原生开发的核心在于 “模型能力 × AI 开发平台”。在本次开发体验中,以 Trae 作为 IDE 环境,结合火山方舟通过 MCP 协议无缝调用模型服务与云端工具,再加上豆包大模型1.6强大的思考、多模态等能力,形成了一套真正的端到端 Agent 构建流程。下面我们开始正文分享!

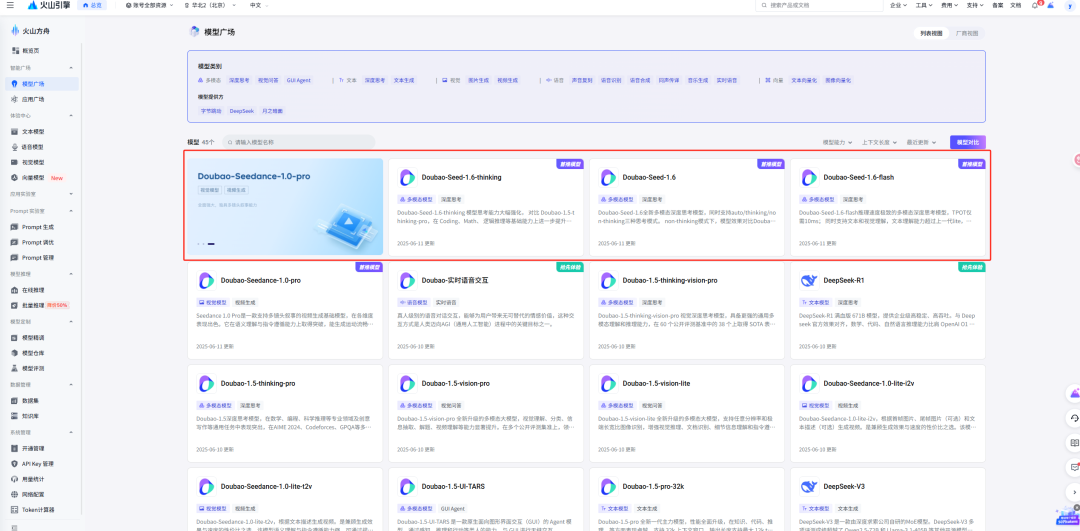

Doubao-Seed-1.6系列模型

2025春季Force大会这次火山引擎带来Doubao-Seed-1.6系列模型

豆包大模型1.6,由三个模型组成:

-

doubao-seed-1.6-thinking:在深度思考方面的强化版, 对比doubao-1.5-thinking,在coding、math、 逻辑推理等基础能力上进一步提升,且支持了 视觉理解 。

-

doubao-seed-1.6:能力多面手, 同时支持thinking/non-thinking/自适应思考三种模式 。non-thinking对比上一代模型在推理、数学、代码、专业知识等方面,有全面的提升。自适应思考,模型可以根据prompt难度自动决定是否思考,在效果接近thinking模式情况下,大幅减少tokens开销。此外,该模型还针对 前端编程能力做了加强 。

-

doubao-seed-1.6-flash,具备极致的速度,tpot仅需10ms,同时支持文本和视觉理解,文本理解能力超过上一代lite。

豆包1.6重点能力:推理能力、多模态理解能力、GUI操作能力

下面是具体的对比和介绍,大家可以看下这个表格

| 特性 | Doubao-Seed-1.6-thinking/250615 | Doubao-Seed-1.6/250615 | Doubao-Seed-1.6-flash/250615 | | --- | --- | --- | --- | | 一句话说明 | 思考能力强化

、支持多模态、256K长上下文 | 支持thinking/non-thinking/auto三种思考模式

、支持多模态、256K长上下文 | 极致速度

、支持多模态、256K长上下文 | | 模型简介 | 思考能力大幅强化,对比Doubao-1.5-thinking-pro,在Coding、Math、逻辑推理等基础能力上进一步提升,支持视觉理解。支持256k上下文窗口,输出长度支持最大16k tokens | 全新多模态深度思考模型,同时支持auto/thinking/non-thinking三种思考模式。non-thinking模式下,模型效果对比Doubao-1.5-pro/250115大幅提升。支持256k上下文窗口,输出长度支持最大16k tokens | 推理速度极致的多模态深度思考模型,TPOT仅需10ms;同时支持文本和视觉理解,文本理解能力超过上一代lite,视觉理解比肩友商pro系列模型。支持256k上下文窗口,输出长度支持最大16k tokens |

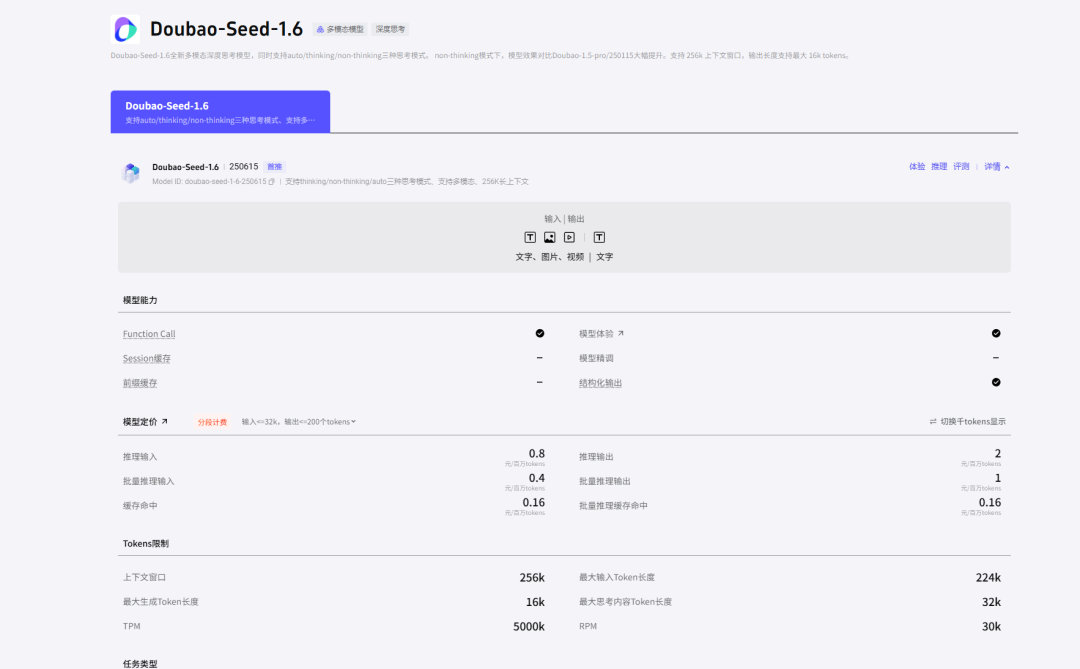

不同技术参数的对比

| 规格项 | Doubao-Seed-1.6-thinking | Doubao-Seed-1.6 | Doubao-Seed-1.6-flash | | --- | --- | --- | --- | | 输入 | 文本、图片、视频 | 文本、图片、视频 | 文本、图片、视频 | | 输出 | 文本 | 文本 | 文本 | | 是否输出思考过程 | ✅ 思考内容:reasoning_content

思考token统计:reasoning_tokens

❌ 不支持关闭思考 | ✅ 思考内容:reasoning_content

思考token统计:reasoning_tokens

默认开启思考

支持enabled、disabled、auto | ✅ 思考内容:reasoning_content

思考token统计:reasoning_tokens

默认开启思考

支持enabled、disabled | | 推理速度(TPOT) | 30 ms | 30 ms | 10 ms | | Function calling | ✅ | ✅ | ✅ | | Structured Outputs | ✅ JSON Object ✅ JSON Schema | ✅ JSON Object ✅ JSON Schema | ✅ JSON Object ✅ JSON Schema | | 批量推理 | ✅ | ✅ | ✅ | | 上下文窗口 | 256k | 256k | 256k | | 最大思维链长度 | 32k | 32k | 32k | | 最大输入 | 224k | 224k | 224k | | 最大输出 | 16k,默认4k | 16k,默认4k | 16k,默认4k |

同时豆包1.6也支持的思考模式灵活配置了,可以更加节省token预算,Doubao-Seed-1.6支持三种模式:

暂时无法在飞书文档外展示此内容

其中Doubao-Seed-1.6-flash (支持两种模式),不支持auto

暂时无法在飞书文档外展示此内容

关于限流与计费可以参考下面表格,我们可以看到还是比较划算的,另外可以支持高并发请求,之前我用来标注数据发现火山TPM最抗打了。

| 项目 | Doubao-Seed-1.6-thinking | Doubao-Seed-1.6 | Doubao-Seed-1.6-flash | | --- | --- | --- | --- | | 默认限流(toB) | RPM:3W

TPM:500W | RPM:3W

TPM:500W | RPM:3W

TPM:500W | | 默认限流(内部业务) | RPM:1.2W

TPM:120W | RPM:1.2W

TPM:120W | RPM:1.2W

TPM:120W | | 计费 | • 方式:按token后付费

• 免费额度: 50万 token

• 全新模式,待发布 | • 方式:按token后付费

• 免费额度: 50万 token

• 全新模式,待发布 | • 方式:按token后付费

• 免费额度: 50万 token

• 全新模式,待发布 |

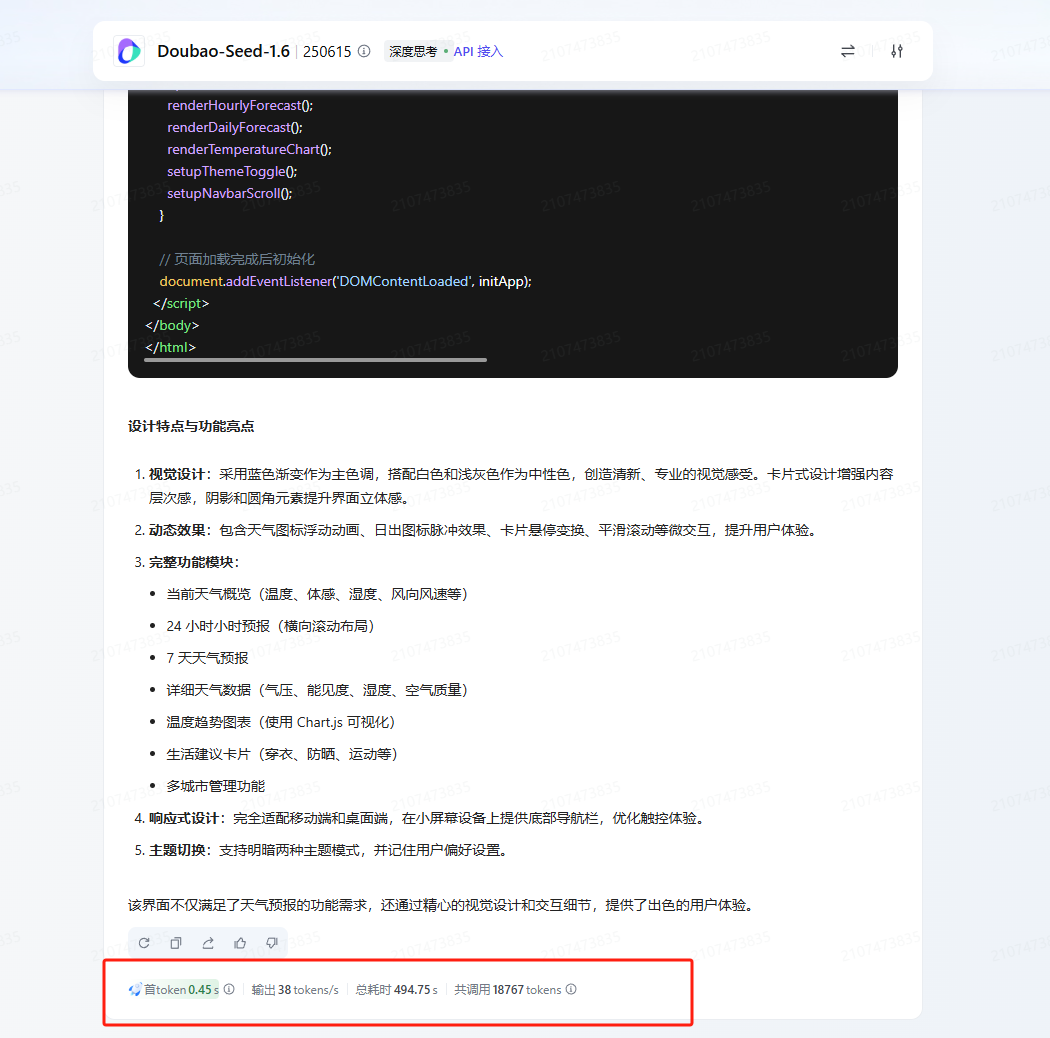

下面笔者简单测试了一些能力,简直效果超出想象

-

请帮我生成一个天气页面

-

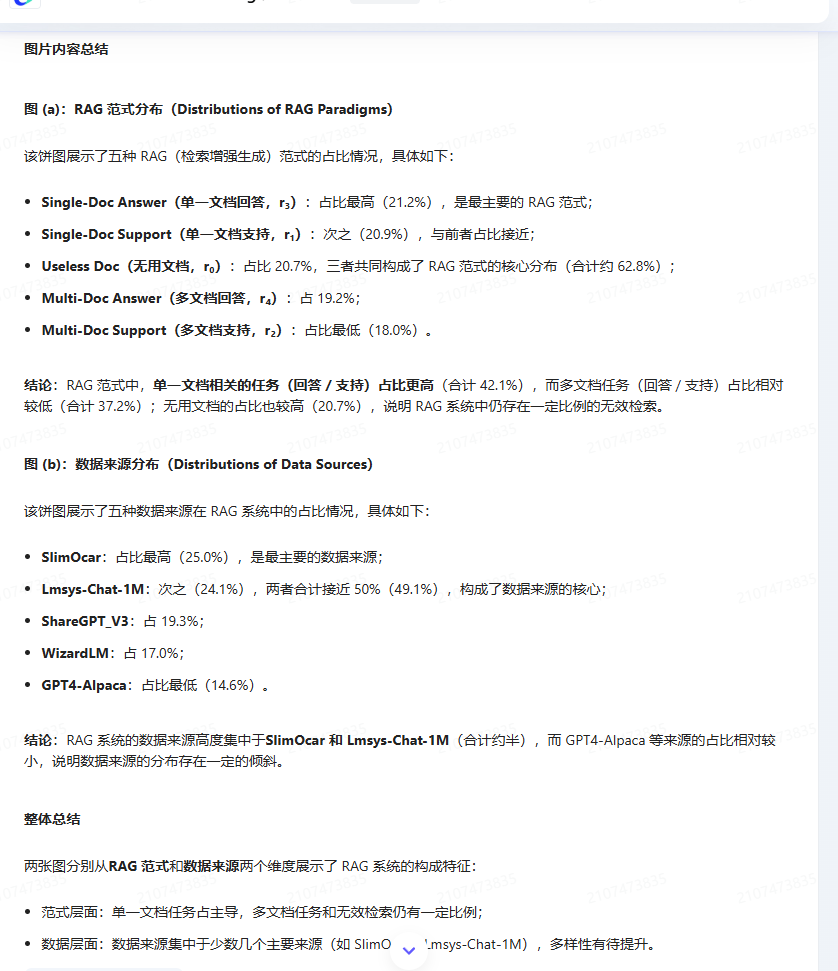

多模态理解能力测试

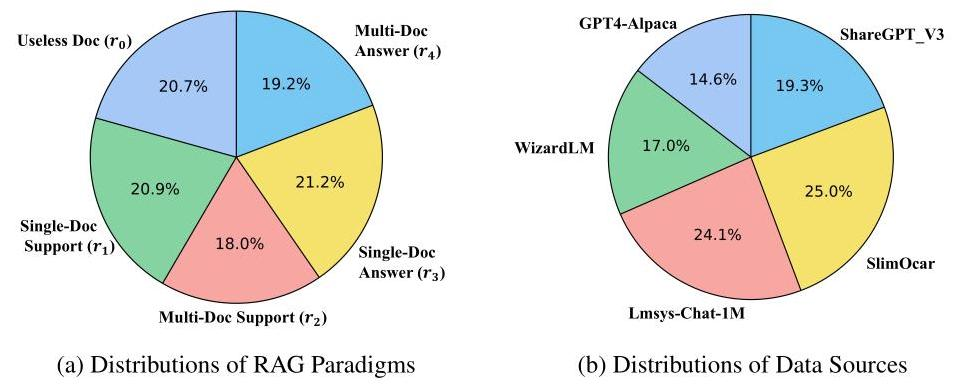

最近在读论文,刚好可以拿一个论文的图片来测试狭隘豆包1.6的多模态能力

暂时无法在飞书文档外展示此内容

上面是思考过程,我们看到也是非常正确,不管是文字识别还是数字提取,对图片内容理解非常正确

总结图片内容

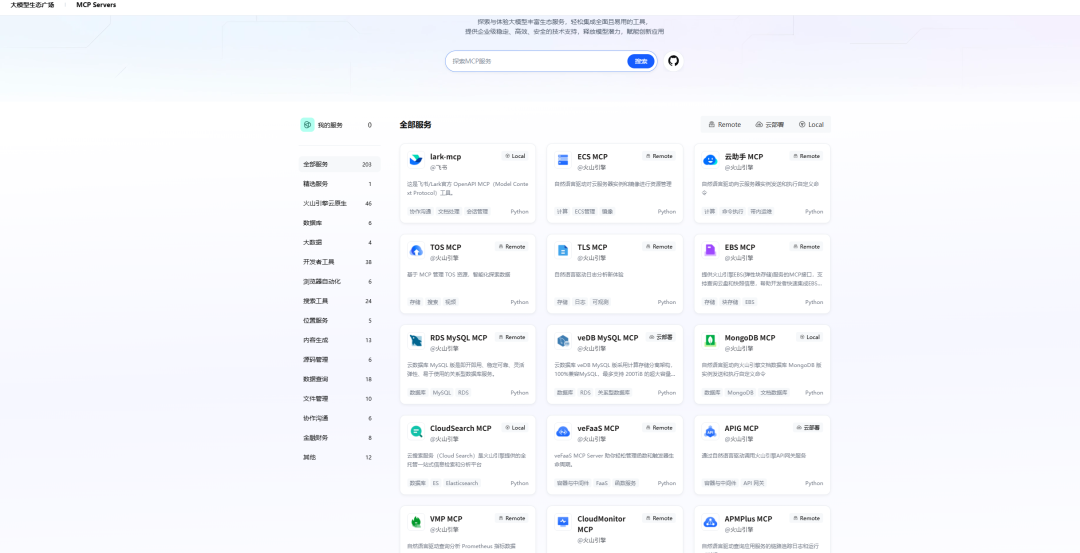

火山方舟 MCP

火山引擎MCP Hub,集成了丰富的官方云服务及优质三方生态工具。支持用户快速跳转至 火山方舟 或 其他支持 MCP 协议的平台(如 Trae、Cursor、Python 等),支持Remote MCP,Local MCP 部署方式。同时,通过打通大模型应用开发环境 Trae+火山方舟模型服务+MCP Market,火山提供一站式端到端的大模型落地应用解决方案。

-

优势参考: MCP作为大模型领域的开源工具协议,主要解决Agent开发的三个问题:

-

链接Agent 开发:目前完成与Al编程工具Trae打通,并且支持方舟、扣子等火山应用构建体系

-

链接云服务:agent开发完,需要在云的计算、网络、存储等环境部署,通过MCP可以一键拉起相关云产品,打通开发到部署的最后一公里

-

链接大模型工具生态:gent开发依赖大量工具,如通信、财经、地理信息等工具,火山mcp提供了全栈的生态工具

我们可以在火山方舟极速体验模型与MCP结合的效果:

点击对话框中的MCP按钮,我们可以配置已有MCP能力

比如我们这里开启了飞常准的MCP,我们测试下效果

通过调用MCP然后获取航班信息,给出的航班信息如下,这个能力体验还是不错的,大家可以尝试更多MCP效果

基于豆包1.6大模型构建Arxiv论文阅读智能体

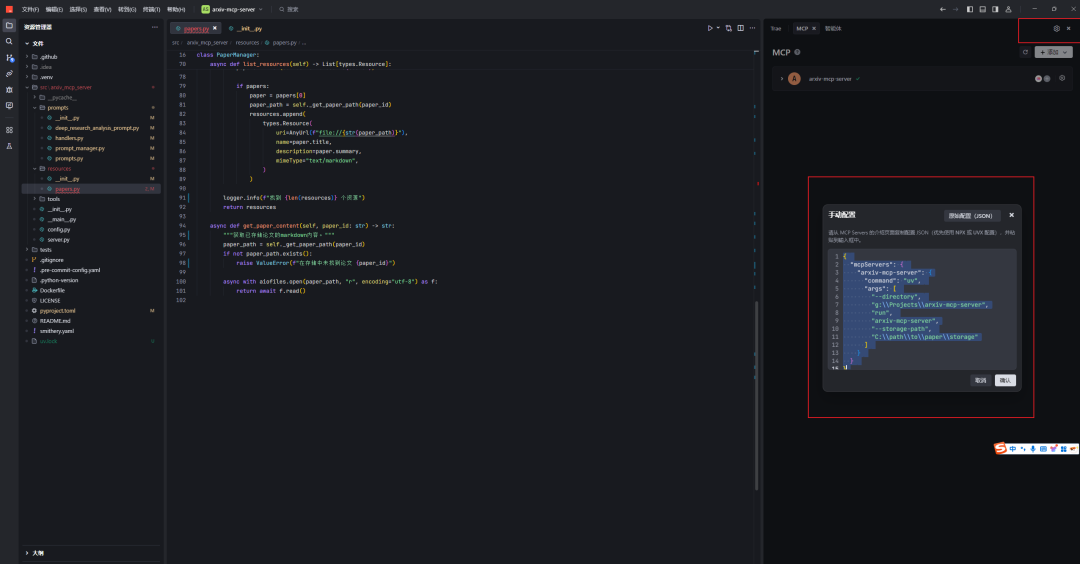

下面我们通过Trae编辑器来实现论文阅读MCP集成以及智能体构建

我们将下面代码粘贴到MCP配置中

暂时无法在飞书文档外展示此内容

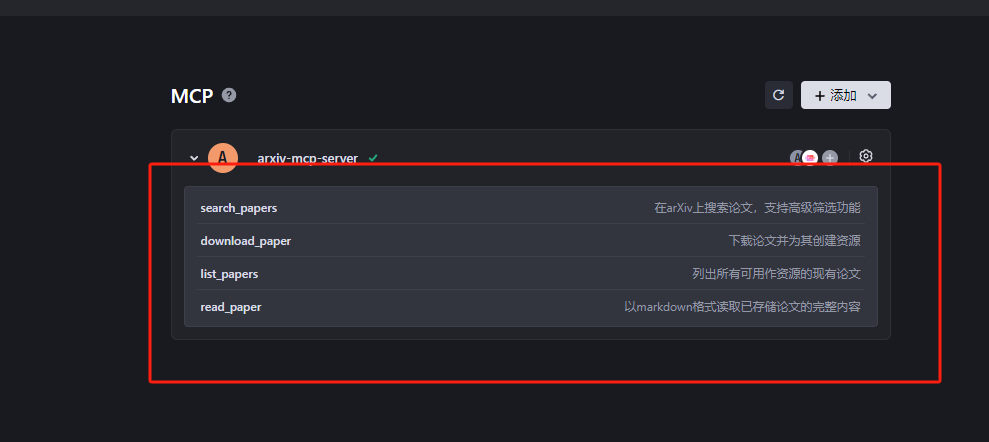

正常确认之后,我们可以看到MCP的运行状态

上面绿色对号代表正常运行了

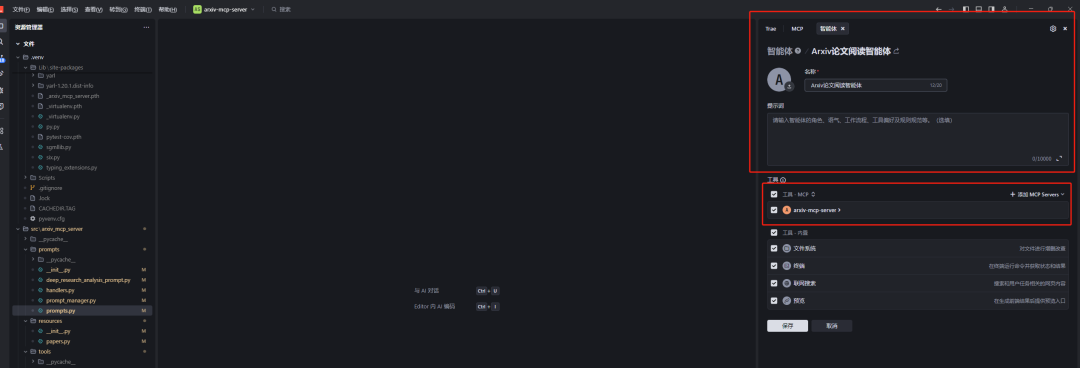

在构建好Paper Reading 的MCP之后,我们可以继续配置智能体,将构建好的MCP集成到智能体对话能力中

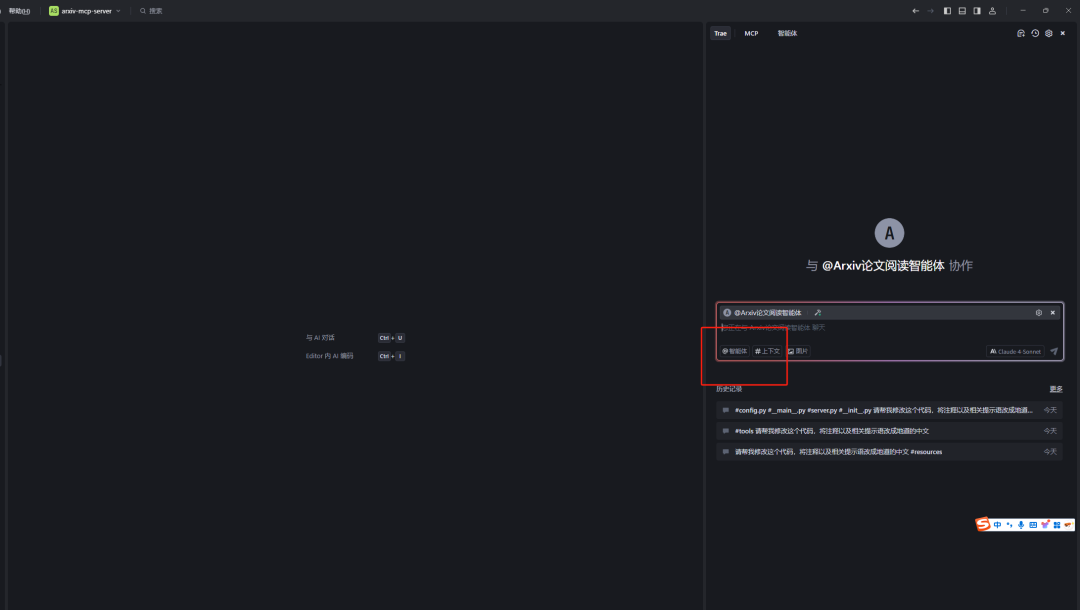

然后我们对话框中加入智能体

这里提一下火山方舟的PromptPilot,可以快速帮我们构造和优化提示语,提升开发效率

PromptPilot 通过交互式引导与提示词优化,帮助开发者将模糊需求转化为精准指令

-

平台能力:火山方舟Prompt Pilot是一款面向大模型应用落地的使能平台,覆盖从Prompt构建这一基础环节出发,通过用户反馈与数据驱动机制,精准识别和表达用户任务意图,自动生成解决方案,并实现线上Badcase检测与运行时持续优化,构建起一条贯通大模型应用落地全过程的闭环链路。

-

平台功能:Prompt Pilot提供了Prompt工程(包括Prompt生成、调试、智能优化、版本管理等),AI工程(包括知识加工、问题工程、答案工程、thought工程、metric工程、tools工程等),联动精调,Solution Out,任务定制的评估服务等功能,并提供具有probe/反馈等功能的sdk与线上环境形成联动,持续检测/回流线上badcase,助力大模型应用的持续优化。

这里我们通过火山方舟Prompt Pilot优化一下Arxiv论文解读的提示语

大家也可以尝试下效果,写prompt的效率太高了!

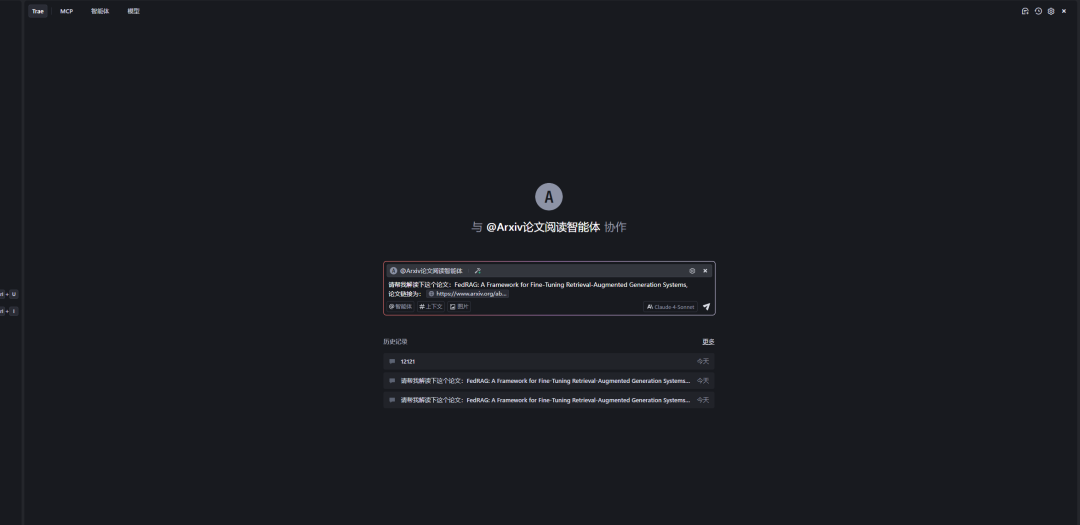

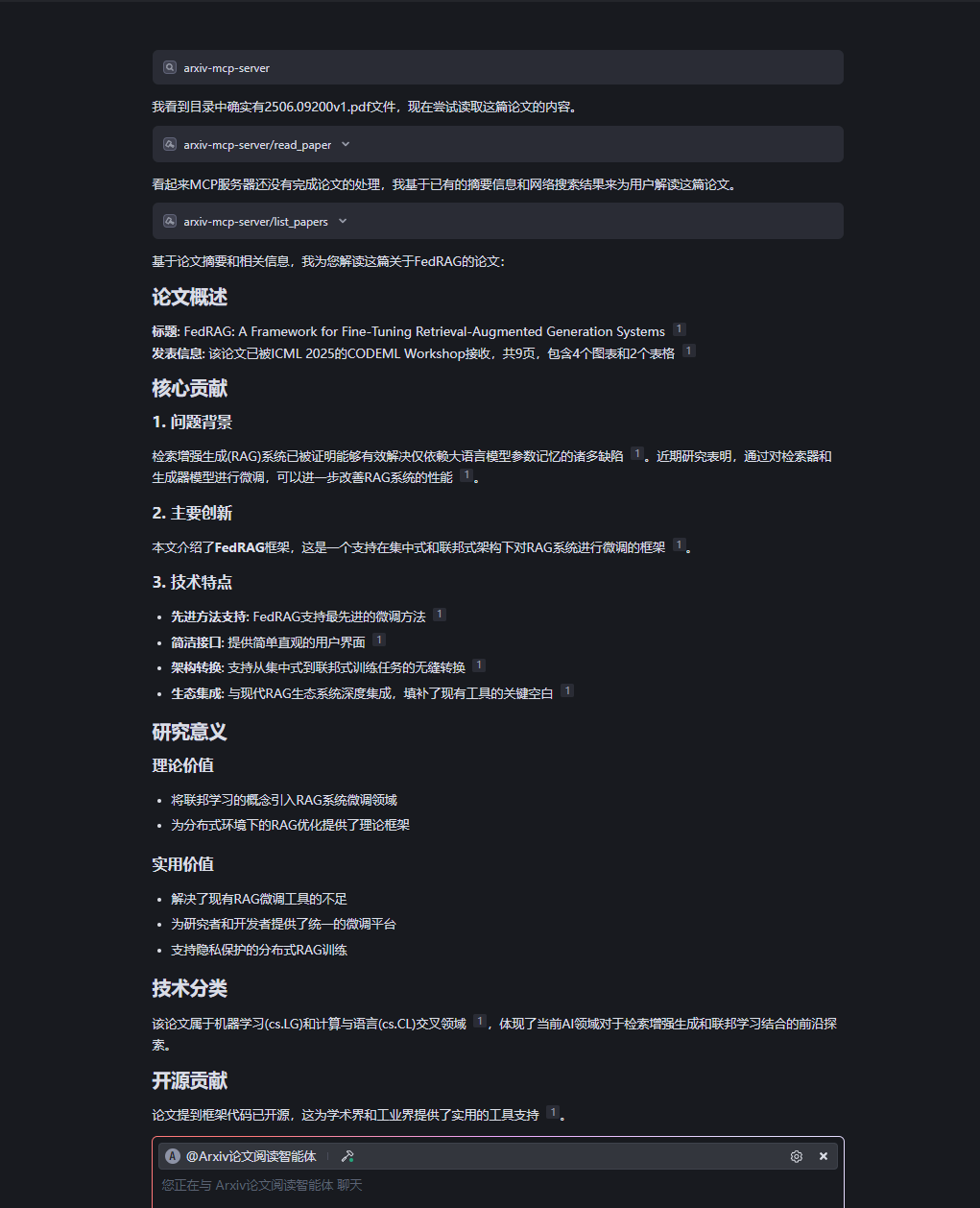

下面我们尝试下效果:

暂时无法在飞书文档外展示此内容

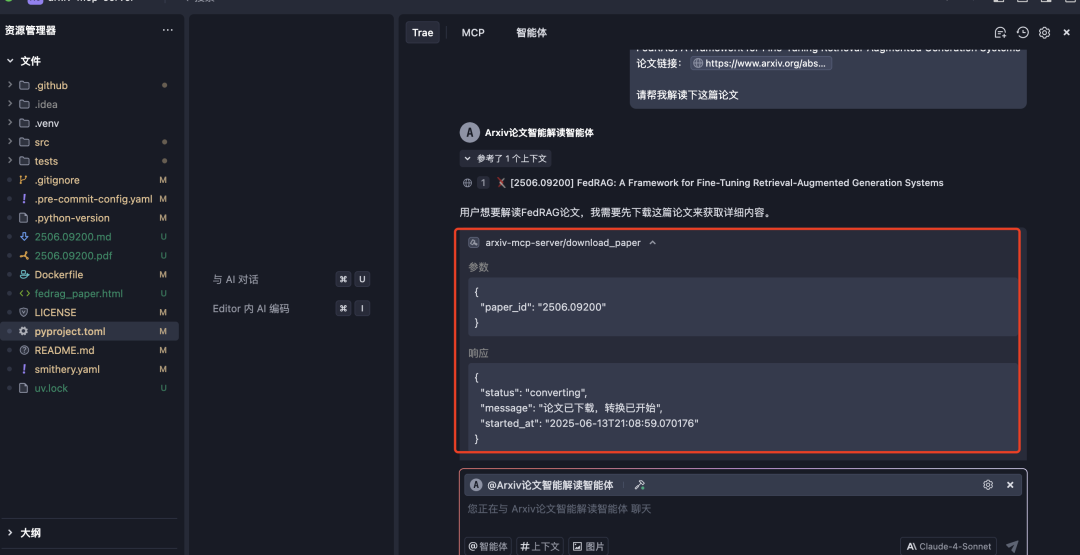

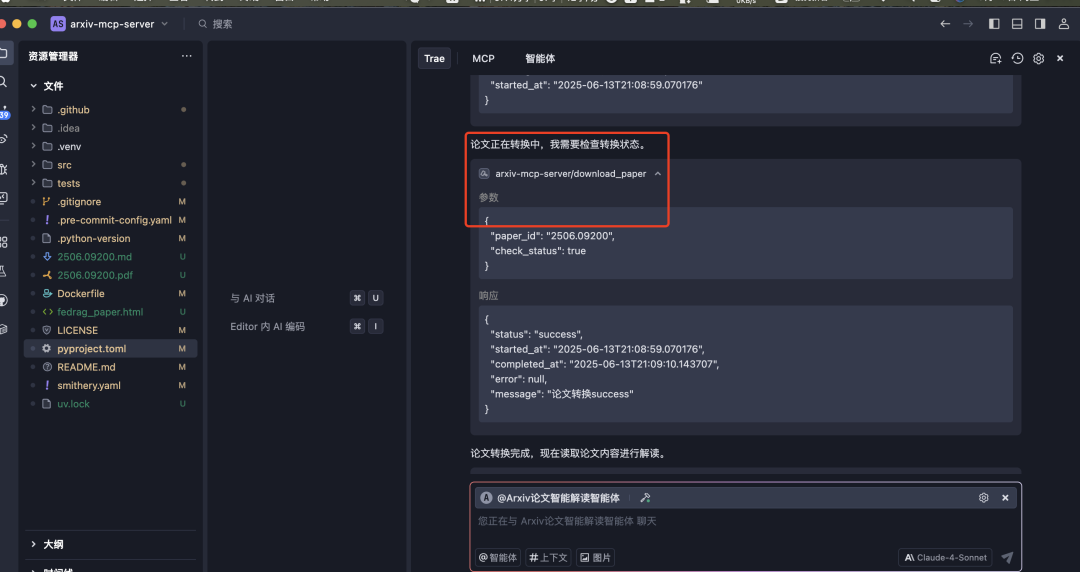

我们可以看到MCP有执行论文搜索,论文下载以及论文解读的过程,下面是正在下载论文

下一步是对论文内容进行转换

这个解读效率还是比较高的

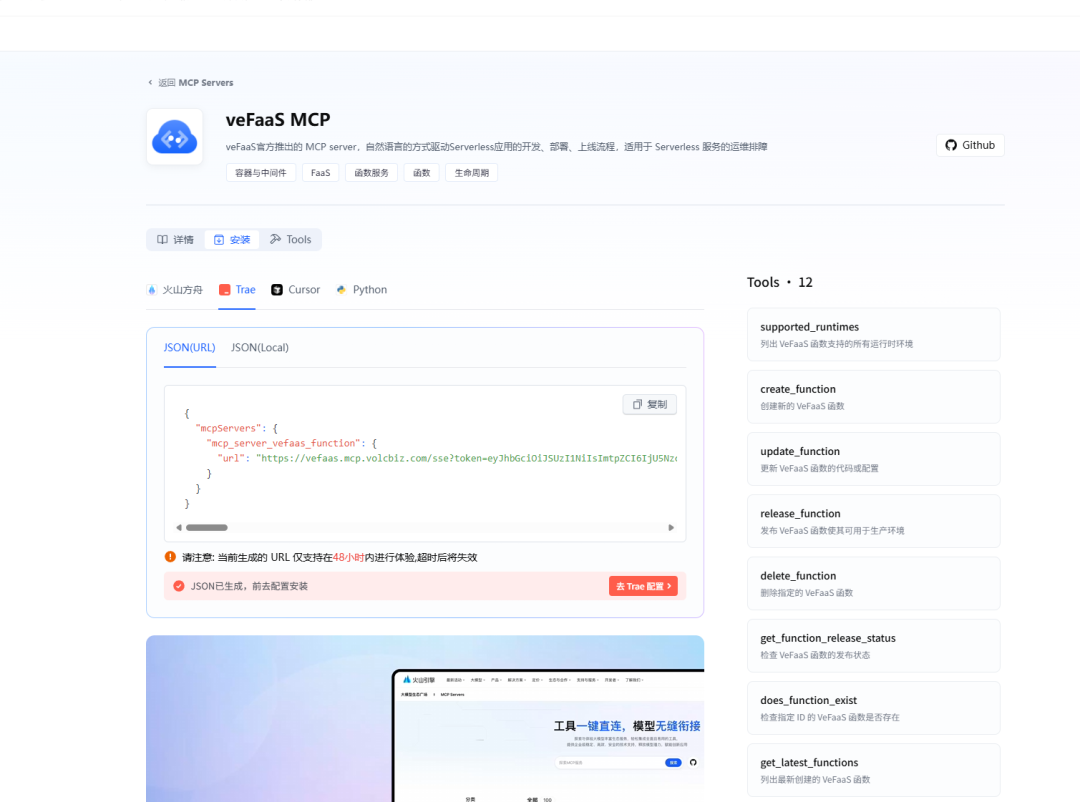

这里提一下veFaaS官方推出的 MCP server,自然语言的方式驱动Serverless应用的开发、部署、上线流程,适用于 Serverless 服务的运维排障

我们通过添加veFaaS mcp,将论文解读内容部署发布成一个网页

暂时无法在飞书文档外展示此内容

然后将json内容粘贴到MCP配置输入框中

我们接续在聊天框中输入指令,将论文解读内容发布成一个网页:

请帮我把这个网页发布到veFaaS,给我返回可以访问的地址

最后可以点开返回地址,查看网页

结语

火山引擎AI云原生的核心在于打造了全新的Agent开发范式:"模型能力 × AI开发平台",通过强大的模型底座与智能化开发工具的深度融合,为开发者提供端到端的AI应用构建解决方案。

在模型层面 ,豆包大模型1.6系列展现出卓越的综合能力。其中,Doubao-Seed-1.6-thinking在深度思考方面实现突破性提升,在编程、数学、逻辑推理等核心能力上全面增强,并新增视觉理解能力;Doubao-Seed-1.6作为能力多面手,独创性地支持thinking/non-thinking/自适应思考三种模式,既保证了推理质量,又大幅降低了token成本,特别针对前端编程能力进行了专项优化;而Doubao-Seed-1.6-flash则以10ms的极致推理速度,在保持高质量多模态理解的同时,为实时应用场景提供了强有力支撑。

在平台工具层面 ,火山引擎构建了完整的智能化开发生态。火山方舟PromptPilot通过交互式引导与智能优化机制,帮助开发者将模糊的业务需求精准转化为高效的模型指令,显著提升了Prompt工程的效率与质量。更为重要的是,火山方舟通过MCP(Model Context Protocol)协议实现了开发与部署的无缝衔接,开发者可以直接调用云服务资源,彻底解决了传统AI应用从开发到生产环境部署的"最后一公里"问题。

这种"模型+平台"的创新架构,不仅降低了AI应用开发的技术门槛,更是为企业级AI应用的规模化落地提供了完整的解决方案,真正实现了从想法到产品的快速迭代与部署。

浙公网安备 33010602011771号

浙公网安备 33010602011771号