Spark技术文档

Spark 源码解读

1. Spark调度模式-FIFO和FAIR

https://blog.csdn.net/dabokele/article/details/51526048

如果不加设置,jobs会提交到default调度池中。由于调度池的使用是Thread级别的,只能通过具体的SparkContext来设置local属性(即无法在配置文件中通过参数spark.scheduler.pool来设置,因为配置文件中的参数会被加载到SparkConf对象中)。所以需要使用指定调度池的话,需要在具体代码中通过SparkContext对象sc来按照如下方法进行设置:

sc.setLocalProperty("spark.scheduler.pool", "test")

设置该参数后,在该thread中提交的所有job都会提交到test Pool中。

如果接下来不再需要使用到该test调度池,

sc.setLocalProperty("spark.scheduler.pool", null)

http://spark.apache.org/docs/latest/job-scheduling.html#scheduling-within-an-application

Scheduling Within an Application

http://spark.apache.org/docs/latest/structured-streaming-kafka-integration.html

combineByKey函数需要传递三个函数做为参数,分别为createCombiner、mergeValue、mergeCombiner,需要理解这三个函数的意义

结合数据来讲的话,combineByKey默认按照key来进行元素的combine,这里三个参数都是对value的一些操作

1>第一个参数createCombiner,如代码中定义的是 : (v) => (v, 1)

这里是创建了一个combiner,作用是当遍历rdd的分区时,遇到第一次出现的key值,那么生成一个(v,1)的combiner,比如这里key为address,当遇到第一个

chaoyang,20 的时候,(v,1)中的v就是age的值20,1是address出现的次数

2>第2个参数是mergeValue,顾名思义就是合并value,如代码中定义的是:(accu: (Int, Int), v) => (accu._1 + v, accu._2 + 1)

这里的作用是当处理当前分区时,遇到已经出现过的key,那么合并combiner中的value,注意这里accu: (Int, Int)对应第一个参数中出现的combiner,即(v,1),注意类型要一致

那么(accu._1 + v, accu._2 + 1)就很好理解了,accu._1即使需要合并的age的值,而acc._2是需要合并的key值出现的次数,出现一次即加1

3>第三个参数是mergeCombiners,用来合并各个分区上的累加器,因为各个分区分别运行了前2个函数后需要最后合并分区结果.

ok,运行代码,结果如下,分别按照address来计算出age的平均值

tail -100 logs/spark-logs

https://stackoom.com/

2. Stream-Static Join

多数据源Join思路

多数据源Join大致有以下三种思路:

数据源端Join,如Android/IOS客户端在上报用户行为数据时就获取并带上用户基础信息。

计算引擎上Join,如用Spark Streaming、Flink做Join。

结果端Join,如用HBase/ES做Join,Join键做Rowkey/_id,各字段分别写入列簇、列或field。

三种思路各有优劣,使用时注意一下。这里总结在计算引擎Spark Streaming上做Join。

流与完全静态数据Join

流与完全静态数据Join。有两种方式,一种是RDD Join方式,另一种是Broadcast Join(也叫Map-Side Join)方式。

RDD Join 方式

思路:RDD Join RDD 。

Broadcast Join 方式

思路:RDD遍历每一条数据,去匹配广播变量中的值。

流与半静态数据Join

半静态数据指的是放在Redis等的数据,会被更新。

思路:RDD 每个Partition连接一次Redis,遍历Partition中每条数据,根据k,去Redis中查找v。

Stream-Stream Join

流与流Join。

思路:DStream Join DStream。

getOrElse()主要就是防范措施,如果有值,那就可以得到这个值,如果没有就会得到一个默认值,个人认为早开发过程中用getOrElse()方法要比用get()方法安全得多。

1、广播变量在Driver端定义

2、广播变量在Execoutor只能读取不能修改

3、广播变量的值只能在Driver端修改

4、不能将RDD广播出去,RDD不存数据,可以将RDD的结果广播出去,rdd.collect()

https://blog.csdn.net/wangpei1949/article/details/83892162

https://blog.csdn.net/u013013024/article/details/77877570

foreachPartition应该属于action运算操作,而mapPartitions是在Transformation中,所以是转化操作,此外在应用场景上区别是mapPartitions可以获取返回值,继续在返回RDD上做其他的操作,而foreachPartition因为没有返回值并且是action操作,所以使用它一般都是在程序末尾比如说要落地数据到存储系统中如mysql,es,或者hbase中,可以用它。

https://blog.csdn.net/u010454030/article/details/78897150

最后,需要注意一点,如果操作是iterator类型,我们是不能在循环外打印这个iterator的size,一旦执行size方法,相当于iterato就会被执行,所以后续的foreach你会发现是空值的,切记iterator迭代器只能被执行一次。

rdd.toDebugString

可以根据查看RDD的依赖:

但是执行的时候相当于走了两次流程,sum的时候前面计算了一遍,然后checkpoint又会计算一次,所以一般我们先进行cache然后做checkpoint就会只走一次流程,checkpoint的时候就会从刚cache到内存中取数据写入hdfs中,如下:

其中作者也说明了,在checkpoint的时候强烈建议先进行cache,并且当你checkpoint执行成功了,那么前面所有的RDD依赖都会被销毁,如下:

rdd.cache()

rdd.checkpoint()

rdd.collect

SparkContext的初始化(仲篇)——SparkUI、环境变量及调度

https://blog.csdn.net/beliefer/article/details/50720582

https://www.cnblogs.com/small-k/p/8909942.html

SparkStreaming在处理kafka中的数据时,存在一个kafka offset的管理问题:

官方的解决方案是checkpoint:

checkpoint是对sparkstreaming运行过程中的元数据和

每次rdds的数据状态保存到一个持久化系统中,当然这里面也包含了offset,一般是HDFS,S3,如果程序挂了,或者集群挂了,下次启动仍然能够从checkpoint中恢复,从而做到生产环境的7*24高可用。如果checkpoint存储做hdfs中,会带来小文件的问题。

但是checkpoint的最大的弊端在于,一旦你的流式程序代码或配置改变了,或者更新迭代新功能了,这个时候,你先停旧的sparkstreaming程序,然后新的程序打包编译后执行运行,会出现两种情况:

(1)启动报错,反序列化异常

(2)启动正常,但是运行的代码仍然是上一次的程序的代码。

https://spark.apache.org/docs/2.1.0/streaming-programming-guide.html#upgrading-application-code

Kafka带有提交偏移量的API,可将偏移量存储在一个特殊的Kafka主题中。

但这个容错语义是at least one,且Kafka不是事务性的,故障出现后会数据可能会重复。

如要实现at least one,要求SparkStreaming输出形式是幂等的。

幂等(idempotent、idempotence):

在编程中一个幂等操作的特点是其任意多次执行所产生的影响均与一次执行的影响相同。

幂等函数:可以使用相同参数重复执行,并能获得相同结果的函数。

例如setTrue()就是一个幂等函数。

SparkStreaming有哪些输出是幂等的?

println不是幂等性的,因为我们看到了重复打印

数据按Key写Redis是幂等性的,重复写结果相同

数据按RowKey写HBase是幂等性的,重复写结果相同

————————————————

版权声明:本文为CSDN博主「小基基o_O」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/Yellow_python/article/details/119864718

ds.foreachRDD { rdd =>

// 1、获取偏移量(如果有)

val offsetRanges = rdd.asInstanceOf[HasOffsetRanges].offsetRanges

// 2、处理数据并输出结果

// 3、输出结果成功后,异步提交偏移量

ds.asInstanceOf[CanCommitOffsets].commitAsync(offsetRanges)

}

3. flink

<properties>

<flink.version>1.10.0</flink.version>

<scala.binary.version>2.11</scala.binary.version>

<kafka.version>2.2.0</kafka.version>

</properties>

4.分析

方差是衡量源数据和期望值相差的度量值。

标准差是方差的算术平方根。标准差能反映一个数据集的离散程度。平均数相同的两组数据,标准差未必相同

标准差、方差越大,离散程度越大

Pearson相关系数(Pearson Correlation Coefficient)是用来衡量两个数据集合是否在一条线上面,它用来衡量定距变量间的线性关系。

偏度(skewness),是统计数据分布偏斜方向和程度的度量,是统计数据分布非对称程度的数字特征。偏度(Skewness)亦称偏态、偏态系数。

峰度(Kurtosis)与偏度类似,是描述总体中所有取值分布形态陡缓程度的统计量。这个统计量需要与正态分布相比较,峰度为0表示该总体数据分布与正态分布的陡缓程度相同;峰度大于0表示该总体数据分布与正态分布相比较为陡峭,为尖顶峰;峰度小于0表示该总体数据分布与正态分布相比较为平坦,为平顶峰。峰度的绝对值数值越大表示其分布形态的陡缓程度与正态分布的差异程度越大。

例如上图中,左图是标准正太分布,峰度=3,右图的峰度=4,可以看到右图比左图更高尖。

通常我们将峰度值减去3,也被称为超值峰度(Excess Kurtosis),这样正态分布的峰度值等于0,当峰度值>0,则表示该数据分布与正态分布相比较为高尖,当峰度值<0,则表示该数据分布与正态分布相比较为矮胖。

Phoenix的二级索引主要有两种,即全局索引和本地索引。全局索引适合那些读多写少的场景。如果使用全局索引,读数据基本不损耗性能,所有的性能损耗都来源于写数据。本地索引适合那些写多读少,或者存储空间有限的场景。

索引定义完之后,一般来说,Phoenix会判定使用哪个索引更加有效。但是,全局索引必须是查询语句中所有列都包含在全局索引中,它才会生效。

5. 快捷键

ctrl+shift+A: 使用IDEA, 你需要记住的是action,而不是快捷键. 例如我想要打开设置界面,那么 ctrl+shift+A,然后输入setting,第一个候选action就是settings(同时你可以看到打开settings的快捷键是ctrl+alt+S); 如果你想要复制当前行,那么ctrl+shift+A,输入dupl就可以看到duplicate line. 下次你就知道复制行是ctrl+D, 当然,这对英语和编程短语要求有些高,实际上,你也可以搜索 edit code actions, 回车, 这时会弹出你可以对当前行操作的action,第三个就是duplicate line. 这时你懂了吧, 只要搜索你的意图,大概清楚你想要的操作是属于哪个类型,然后搜索这个类型单词即可. 或者你可以直接搜索actions, 熟悉这些actions的分类,这样你就可以慢慢熟悉自己最常用的快捷键了.

alt+Home/ ctrl+E: 初学者会习惯用鼠标在project窗口选择文件,这样效率很低. IDEA提供了很好的文件导航,就在工具栏下方,alt+Home即可激活导航,然后你可以用方向键移动浏览每个文件夹的文件,回车进入某个文件夹,然后alt+Ins,即可新建文件(包括class,package). 当然你也可以用ctrl+E 打开最近操作的文件,包括terminal.

上一个位置: 这个是我在eclipse中常用的快捷键. 在IDEA中是: ctrl+alt+ 方向键. 注意,这个是上一次光标的位置,不是编辑的位置,所以可能需要你习惯. 此外, alt+左右方向是编辑窗口tab切换.

search everywhere vs find in path: 如果你想要搜索一个类或者接口, 双击shift,激活 search everywhere, 但是不会搜索普通文本的, 如果你使用mybatis, 想要搜索xml的sql,那么你需要使用ctrl+shift+F,叫find in path, 当然搜索的范围越大,结果就越多, 所以只有在search everywhere不行的时候才使用find in path.

zen mode: ctrl+shift+F12, 就是editor窗口最大化的意思啦,全心开始码吧...

refactor this: ctrl+shift+alt+T, 重构,可以这么说,新手使用这个快捷键频率体现了你代码的水平, 只用重构越多,代码水平才可能提高,如果你从来没用过,你不是在写代码,只是. 记不住这个快捷键没关系, ctrl+shift+A ,然后输入refactor就出来了.

有一个很好的gif教程:

你需要学会使用以下功能

方法执行: Alt + F8;

条件断点: 断点上右键即可;

日志断点: 不要再傻傻的用sysout或者http://log.info去记录一些调试日志啦.调试完你还要删除代码. 请用日志断点.当然, idea 专业版提供而来很好的热更新功能,修改代码后可以直接更新web容器的代码.

方法断点: 如果你只对某个方法的入参和返回值感兴趣, 那么不要浪费时间在单步调试一步步走完这个方法, 只要在方法名那一行断点. 方法断点是一个红色里面四个黑点的标识.

异常断点: 如果你想在异常抛出时停下来,那么使用 Run -> View BreakPoints -> add breakPoint

变量断点: 在并发程序中你不知道那个线程或者方法修改了某个变量,这时你可以对变量声明处断点,并右键设置.例如,变量修改时停下来.

还有更多debug技能需要你去发现,都在Run -> View Breakpoint里.

F9:恢复程序

Alt+F10:显示执行断点

F8: 跳到下一步

F7:进入到代码

Alt+shift+F7:强制进入代码

Shift+F8:跳到下一个断点

Atl+F9:运行到光标处

ctrl+shift+F9:debug运行java类

ctrl+shift+F10:正常运行java类

Alt+F8:debug时选中查看值

Alt + Ctrl + S 打开Settings

Alt + Ctrl + Shift + S 打开Project Structrue

Alt + Enter 快速修复

Alt + / 单词自动补全

Alt + Insert 代码自动生成,比如setter、getter、toString等等

Alt + Shift + V 把类中成员移动到另一个类

Ctrl + Shift + F 格式化代码

Ctrl + Shift + U 大小写切换

Ctrl + Shift + I 根据当前上下文显示代码定义,比如:光标停在方法上就会以popupview方式显示该方法的定义

Ctrl + click 跳到源码

Shift + Shift 搜索所有文件

Ctrl + E 打开最近访问文件列表

实际开发中我会结合IDEA的postfix completion和aiXcoder配置使用,IDEA本身就已经提供了许多快速补全的快捷方式,不过我发现组内很多人并没有真正用起来。

Restfultoolkit一套RESTful服务开发辅助工具集,维护项目通常会涉及到查找一个请求所对应的类,一般用ctrl + shift + f进行全局搜索,但是如果项目文件太多,这种查找方式的效率就很低。

Restfultoolkit管理项目中全部的请求链接,可以快速查找。

快捷键:ctrl+ alt + n

可以复制当前请求的全路径和JSON格式的参数,开发测试中非常的实用。

6. 缓存

如何释放cache缓存:unpersist,它是立即执行的。persist是lazy级别的(没有计算),unpersist是eager级别的。RDD cache的生命周期是application级别的,也就是如果不显示unpersist释放缓存,RDD会一直存在(虽然当内存不够时按LRU算法进行清除),如果不正确地进行unpersist,让无用的RDD占用executor内存,会导致资源的浪费,影响任务的效率。

https://blog.csdn.net/qq_27639777/article/details/82319560

7.模块列表

源码阅读

Spark至今只经历过1.x、2.x和3.x三个大版本的变化,在核心实现上,我们在Github能看到的最早的实现是0.5版本,这个版本只有1万多行代码,就把Spark的核心功能实现了。

当然我们不可能从这么古老的版本看,假如你接触过Spark,现在准备看源码,那么我建议从2.x版本中选取一个,最好是2.3或者2.4。但是经过如此多的迭代,Spark的代码量已经暴增了几倍。关于Spark3.x中的新增功能和优化例如动态资源分配,可以针对性的进行补充即可。

我把最重要的模块列表如下:

Spark的初始化

SparkContext SparkEnv SparkConf RpcEnv SparkStatusTracker SecurityManager SparkUI MetricsSystem TaskScheduler

Spark的存储体系

SerializerManager BroadcastManager ShuffleManager MemoryManager NettyBlockTransferService BlockManagerMaster BlockManager CacheManager

Spark的内存管理

MemoryManager MemoryPool ExecutionMemoryPool StorageMemoryPool MemoryStore UnifiedMemoryManager

Spark的运算体系

LiveListenerBus MapOutputTracker DAGScheduler TaskScheduler ExecutorAllocationManager OutputCommitCoordinator ContextClearner

Spark的部署模式

LocalSparkCluster Standalone Mater/Executor/Worker的容错

Spark Streaming

StreamingContext Receiver Dstream 窗口操作

Spark SQL

Catalog TreeNode 词法解析器Parser RuleExecutor Analyzer与Optimizer HiveSQL相关

其他

假如你对图计算Spark GraphX和机器学习Spark MLlib感兴趣,可以单独看看。

一些可以直接入门的项目

我曾经发过一些可以直接入门的项目,大家可以参考:

这里就不得不说B站了,你可以在B站找到非常丰富的学习资源,甚至我自己也曾经上传过关于Spark的项目。

我这里找了一个不错的入门视频:https://www.bilibili.com/video/BV1tp4y1B7qd

另外下面这篇文章也是一个完整的入门案例:

《Spark Streaming + Canal + Kafka打造Mysql增量数据实时进行监测分析》

8.Kafka

创建了AdminClient的实例对象后,我们就可以通过它提供的方法操作Kafka,常用的方法如下:

方法名称

作用

createTopics 创建一个或多个Topic

listTopics 查询Topic列表

deleteTopics 删除一个或多个Topic

describeTopics 查询Topic的描述信息

describeConfigs 查询Topic、Broker等的所有配置项信息

alterConfigs 用于修改Topic、Broker等的配置项信息(该方法在新版本中被标记为已过期)

incrementalAlterConfigs 同样也是用于修改Topic、Broker等的配置项信息,但功能更多、更灵活,用于代替alterConfigs

createPartitions 用于调整Topic的Partition数量,只能增加不能减少或删除,也就是说新设置的Partition数量必须大于等于之前的Partition数量

Tips:

describeTopics和describeConfigs的意义主要是在监控上,很多用于监控Kafka的组件都会使用到这两个API,因为通过这两个API可以获取到Topic自身和周边的详细信息

https://blog.51cto.com/zero01/2495884

InterfaceAudience 类包含有三个注解类型,用来说明被他们注解的类型的潜在使用范围,即audience

1.如果标注的是Public,说明被注解的类型对多有工程和应用可用。

2.如果标注的是LimitedPrivate,说明被注解的类型只能用于某些特定的工程或应用,如Common,HDFS,MapReduce,ZooKeeper,HBase等。

3.如果标注的是Private,说明被注解的类型只能用于Hadoop。

InterfaceStability 类包含三个注解,用于说明被他们注解的类型的稳定性。

@InterfaceStability.Evolving

1.如果标注的是Stable,说明主版本是稳定的,不同主版本之间可能不兼容。

2.如果标注的是Evolving,说明是不停在变化的,不同小版本之间也可能不兼容。

3.如果标注的是Unstable,说明稳定性没有任何保证。

Partition的索引从0开始,所以第一个partition=0,第二个partition=1

在创建Topic时我们需要设定Partition的数量,但如果觉得初始设置的Partition数量太少了,那么就可以使用createPartitions方法来调整Topic的Partition数量,但是需要注意在Kafka中Partition只能增加不能减少。

https://www.jianshu.com/p/5bdd9a0d7d02

Kafka-Eagle 安装到使用全教程

https://www.jianshu.com/p/2ebfad402fa0

https://www.cnblogs.com/zeling/p/8494851.html

https://ke.smartloli.org/

https://blog.csdn.net/Locky_LLL/article/details/104840827

http://node1:8048/ke 初始用户名:admin 密码:123456

https://blog.csdn.net/hell_oword/article/details/120111230

http://192.168.3.66:8048/ke/account/signin?/ke/

初始用户名:admin 密码:123456

select * from "ke_topic" where "partition" in (0,1,2) limit 10;

select * from "hs_spin" where "partition" in (0,1,2) limit 10;

前几天为了省事,在申请group的时候,就使用了原来的group,本来以为group从属于某一个topic,topic不同,group之间相互不会影响,但实际情况不是这样的。

kafka不同topic的consumer如果用的groupid名字一样的情况下,其中任意一个topic的consumer重新上下线都会造成剩余所有的consumer产生reblance行为,

即使大家不是同一个topic,这主要是由于kafka官方支持一个consumer同时消费多个topic的情况,所以在zk上一个consumer出问题后zk是直接把group下面所有的consumer都通知一遍

earliest:当各分区下有已提交的offset时,从提交的offset开始消费;无提交的offset时,从头开始消费

latest:当各分区下有已提交的offset时,从提交的offset开始消费;无提交的offset时,消费新产生的该分区下的数据

none:topic各分区都存在已提交的offset时,从offset后开始消费;只要有一个分区不存在已提交的offset,则抛出异常

最近也是有人问我kafka的auto.offset.reset设置为earliest后怎么结果和自己想象的不一样呢,相信很多人都对这个参数心存疑惑,今天来详细讲解一下:

kafka-0.10.1.X版本之前: auto.offset.reset 的值为smallest,和,largest.(offest保存在zk中)

kafka-0.10.1.X版本之后: auto.offset.reset 的值更改为:earliest,latest,和none (offest保存在kafka的一个特殊的topic名为:__consumer_offsets里面)

顾名思义,earliest就是从最开始消费数据,latest即为从最新的数据开始消费,但我们在使用的时候发现并不是这样的.下面就来详细测试一下.

先看一下官网对auto.offset.reset的解释吧(测试版本为0.10.2.1)

如果存在已经提交的offest时,不管设置为earliest 或者latest 都会从已经提交的offest处开始消费

如果不存在已经提交的offest时,earliest 表示从头开始消费,latest 表示从最新的数据消费,也就是新产生的数据.

none topic各分区都存在已提交的offset时,从提交的offest处开始消费;只要有一个分区不存在已提交的offset,则抛出异常

show processlist 命令非常实用,有时候mysql经常跑到50%以上或更多,就需要用这个命令看哪个sql语句占用资源比较多,就知道哪个网站的程序问题了。

show processlist 命令的输出结果显示了有哪些线程在运行,可以帮助识别出有问题的查询语句;如果有SUPER权限,则可以看到全部的线程,否则,只能看到自己发起的线程(这是指当前对应的MySQL帐户运行的线程)。

先简单说一下各列的含义和用途

第一列,id,不用说了吧,一个标识,你要kill一个语句的时候很有用

user列,显示单前用户,如果不是root,这个命令就只显示你权限范围内的sql语句。

host列,显示这个语句是从哪个ip的哪个端口上发出的。呵呵,可以用来追踪出问题语句的用户。

db列,显示这个进程目前连接的是哪个数据库。

command列,显示当前连接的执行的命令,一般就是休眠(sleep),查询(query),连接(connect)。

time列,此这个状态持续的时间,单位是秒。

state列,显示使用当前连接的sql语句的状态,很重要的列,后续会有所有的状态的描述,请注意,state只是语句执行中的某一个状态,一个sql语句,已查询为例,可能需要经过copying to tmp table,Sorting result,Sending data等状态才可以完成

info列,显示这个sql语句,因为长度有限,所以长的sql语句就显示不全,但是这是一个判断问题语句的重要依据。

————————————————

这个命令中最关键的就是state列,mysql列出的状态主要有以下几种:

Checking table

正在检查数据表(这是自动的)。

Closing tables

正在将表中修改的数据刷新到磁盘中,同时正在关闭已经用完的表。这是一个很快的操作,如果不是这样的话,就应该确认磁盘空间是否已经满了或者磁盘是否正处于重负中。

Connect Out

复制从服务器正在连接主服务器。

Copying to tmp table on disk

由于临时结果集大于tmp_table_size,正在将临时表从内存存储转为磁盘存储以此节省内存。

Creating tmp table

正在创建临时表以存放部分查询结果。

deleting from main table

服务器正在执行多表删除中的第一部分,刚删除第一个表。

deleting from reference tables

服务器正在执行多表删除中的第二部分,正在删除其他表的记录。

Flushing tables

正在执行FLUSH TABLES,等待其他线程关闭数据表。

Killed

发送了一个kill请求给某线程,那么这个线程将会检查kill标志位,同时会放弃下一个kill请求。MySQL会在每次的主循环中检查kill标志位,不过有些情况下该线程可能会过一小段才能死掉。如果该线程程被其他线程锁住了,那么kill请求会在锁释放时马上生效。

Locked

被其他查询锁住了。

Sending data

正在处理Select查询的记录,同时正在把结果发送给客户端。

Sorting for group

正在为GROUP BY做排序。

Sorting for order

正在为ORDER BY做排序。

Opening tables

这个过程应该会很快,除非受到其他因素的干扰。例如,在执Alter TABLE或LOCK TABLE语句行完以前,数据表无法被其他线程打开。正尝试打开一个表。

Removing duplicates

正在执行一个Select DISTINCT方式的查询,但是MySQL无法在前一个阶段优化掉那些重复的记录。因此,MySQL需要再次去掉重复的记录,然后再把结果发送给客户端。

Reopen table

获得了对一个表的锁,但是必须在表结构修改之后才能获得这个锁。已经释放锁,关闭数据表,正尝试重新打开数据表。

Repair by sorting

修复指令正在排序以创建索引。

Repair with keycache

修复指令正在利用索引缓存一个一个地创建新索引。它会比Repair by sorting慢些。

Searching rows for update

正在讲符合条件的记录找出来以备更新。它必须在Update要修改相关的记录之前就完成了。

Sleeping

正在等待客户端发送新请求.

System lock

正在等待取得一个外部的系统锁。如果当前没有运行多个mysqld服务器同时请求同一个表,那么可以通过增加--skip-external-locking参数来禁止外部系统锁。

Upgrading lock

Insert DELAYED正在尝试取得一个锁表以插入新记录。

Updating

正在搜索匹配的记录,并且修改它们。

User Lock

正在等待GET_LOCK()。

Waiting for tables

该线程得到通知,数据表结构已经被修改了,需要重新打开数据表以取得新的结构。然后,为了能的重新打开数据表,必须等到所有其他线程关闭这个表。以下几种情况下会产生这个通知:FLUSH TABLES tbl_name, Alter TABLE, RENAME TABLE, REPAIR TABLE, ANALYZE TABLE,或OPTIMIZE TABLE。

waiting for handler insert

Insert DELAYED已经处理完了所有待处理的插入操作,正在等待新的请求。

大部分状态对应很快的操作,只要有一个线程保持同一个状态好几秒钟,那么可能是有问题发生了,需要检查一下。还有其他的状态没在上面中列出来,不过它们大部分只是在查看服务器是否有存在错误是才用得着。

常用计数器

————————————————

版权声明:本文为CSDN博主「盛艺小豆丁」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/weixin_33814090/article/details/113207648

show 后面的参数可以更改用来查看不同的数据,通过show profiles来觉得自己需要查看那个语句。

参数 功能

all 显示所有的开销信息

block io 显示块IO相关开销

cpu 显示CPU相关开销信息

ipc 显示发送和接收相关开销信息

memory 显示内存相关开销信息

page faults 显示页面错误相关开销信息

————————————————

版权声明:本文为CSDN博主「夕麻」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/weixin_45735361/article/details/104115116

参数注意

converting HEAP to MyISAM查询结果太大,内存都不够用了往磁盘上搬

Creating tmp table 创建临时表

Copying to tmp table on disk 把内存中临时表复制到磁盘,危险

locked

show profile cpu,block_io for query 3

测试环境可以开启:

全局查询日志

开启命令

set global general_log = 1;

1

将SQL语句写到表中

set global log_output = 'TABLE';

1

我们所编写的SQL语句,会记录到MySQL库里的genral_log表,我们可通过下述语句来查看

select * from mysql.general_log;

9. log4j 日志输出级别

log4j定义了8个级别的log(除去OFF和ALL 可以说分为6个级别),

* 优先级从高到低依次为:OFF FATAL ERROR WARN INFO DEBUG TRACE ALL

*

* ALL 最低等级的 用于打开所有日志记录

* TRACE 很低的日志级别 一般不会使用

* DEBUG 指出细粒度信息事件对调试应用程序是非常有帮助的 主要用于开发过程中打印一些运行信息

* INFO 消息在粗粒度级别上突出强调应用程序的运行过程

* 打印一些你感兴趣的或者重要的信息 这个可以用于生产环境中输出程序运行的一些重要信息

* 但是不能滥用 避免打印过多的日志

* WARN 表明会出现潜在错误的情形 有些信息不是错误信息 但是也要给程序员的一些提示

* ERROR 指出虽然发生错误事件 但仍然不影响系统的继续运行

* 打印错误和异常信息 如果不想输出太多的日志 可以使用这个级别

* FATAL 指出每个严重的错误事件将会导致应用程序的退出

* 这个级别比较高了 重大错误 这种级别你可以直接停止程序了

* OFF 最高等级的,用于关闭所有日志记录

*

* 如果将log level设置在某一个级别上 那么比此级别优先级高的log都能打印出来

* 例如 如果设置优先级为WARN 那么OFF FATAL ERROR WARN 4个级别的log能正常输出

* 而INFO DEBUG TRACE ALL级别的log则会被忽略

10.dbeaver常用快捷键

hot key

ctrl + enter 执行sql

ctrl + \ 执行sql,保留之前窗口结果

ctrl + shift + ↑ 向上复制一行

ctrl + shift + ↓ 向下复制一行

ctrl + alt + F 对sql语句进行格式化,对于很长的sql语句很有用

ctrl + d 删除当前行

alt + ↑ 向上选定一条sql语句

alt + ↓ 向下选定一条sql语句

ctrl + / 行注释

ctrl + shift+ / 块注释

ctrl + f 查找、替换

ctrl + space sql提示(如果写了from table后也会自动提示field)

ctrl + shift + E 执行计划

ctrl + shift + U 将选定的sql转换成大写字母

ctrl + shift + L 将选定的sql转换成小写字母

————————————————

版权声明:本文为CSDN博主「ronaldo2018」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/sinat_17697111/article/details/88800616

【hive】求日期是星期几

在Hive原生版本中,目前并没有返回星期几的函数。

除了利用java自己编写udf外,也可以利用现有hive函数实现。

方法格式:

pmod(datediff('#date#', '任意年任意一个星期日的日期'), 7)

1、datediff 是两个日期相减的函数,hive日期函数可以见附录:

日期相减函数:datediff

语法:datediff(string enddate, string startdate)

返回值: int

说明: 返回两个时间参数的相差天数。

2、 pmod 是正取余函数:

正取余函数 : pmod

语法: pmod(int a, int b),pmod(double a, double b)

返回值: int double

说明: 返回正的a除以b的余数

如:2012-01-01刚好是星期日。

pmod(datediff('#date#', '2012-01-01'), 7)

返回值:int,“0-6”(“0-6”分别表示“星期日-星期六”)

注意:这里的日期必须是'string'类型的格式为'yyyy-MM-dd',因为datediff()函数对参数的要求

补充:当后边的日期不是周日的时候,我们可以对datediff结果进行加减到周日即可

例如:2018-01-01是周一,我们可以在datediff基础上+1/-6.

为什么是周一要+1呢,因为对于一整周的时间是少了一天.

变通一下,一样可以达到相同的目的:

select pmod(datediff('2018-06-04', '2018-01-01') - 6, 7);

select pmod(datediff('2018-06-04', '2018-01-01') + 1, 7);

附赠:bigint类型的日期转换成string(yyyy-MM-DD)类型的日期

from_unixtime(unix_timestamp(cast(20180707 as string),'yyyymmdd'),'yyyy-mm-dd')

20180707 -> '2018-07-07'

-- hive 求某一天是星期几

select htime,

(case when pmod(datediff(htime,'2018-01-01') + 1,7) = 1 then 'Monday'

when pmod(datediff(htime,'2018-01-01') + 1,7) = 2 then 'Tuesday'

when pmod(datediff(htime,'2018-01-01') + 1,7) = 3 then 'Wednesday'

when pmod(datediff(htime,'2018-01-01') + 1,7) = 4 then 'Thursday'

when pmod(datediff(htime,'2018-01-01') + 1,7) = 5 then 'Friday'

when pmod(datediff(htime,'2018-01-01') + 1,7) = 6 then 'Saturday'

else 'Weekend'

end) time_interval

from

hs_spin.ods_wide_host_external limit 6;

count(...) over(partition by ... order by ...)--求分组后的总数。

sum(...) over(partition by ... order by ...)--求分组后的和。

max(...) over(partition by ... order by ...)--求分组后的最大值。

min(...) over(partition by ... order by ...)--求分组后的最小值。

avg(...) over(partition by ... order by ...)--求分组后的平均值。

rank() over(partition by ... order by ...)--rank值可能是不连续的。

dense_rank() over(partition by ... order by ...)--rank值是连续的。

first_value(...) over(partition by ... order by ...)--求分组内的第一个值。

last_value(...) over(partition by ... order by ...)--求分组内的最后一个值。

lag() over(partition by ... order by ...)--取出前n行数据。

lead() over(partition by ... order by ...)--取出后n行数据。

ratio_to_report() over(partition by ... order by ...)--Ratio_to_report() 括号中就是分子,over() 括号中就是分母。

percent_rank() over(partition by ... order by ...)-- 计算当前行所在前百分位

[ERROR] Failed to execute goal org.apache.maven.plugins:maven-enforcer-plugin:3.0.0-M1:enforce (enforce-versions) on project apache-atlas: Some Enforcer rules have failed. Look above for specific messages explaining why the rule failed. -> [Help 1]

[ERROR]

[ERROR] To see the full stack trace of the errors, re-run Maven with the -e switch.

[ERROR] Re-run Maven using the -X switch to enable full debug logging.

[ERROR]

[ERROR] For more information about the errors and possible solutions, please read the following articles:

[ERROR] [Help 1] http://cwiki.apache.org/confluence/display/MAVEN/MojoExecutionException

[ERROR]

[ERROR] After correcting the problems, you can resume the build with the command

[ERROR] mvn <goals> -rf :apache-atlas

可能会角色里面的message信息有点奇怪,这是我改之后的结果,原本的情况是:

requireJavaVersion 要求jdk8-151 以上才行

requireMavenVersion 要求在3.5.0 以上

因此,我们编译的maven版本和jdk版本要在其要求范围内,这样就不会报这个插件错误了(事实上,我这里修改是有点画蛇添足,但是直接指定也行)。

下载安装JDK。(不要用Linux自带的jdk,且atlas2.0要求,jdk版本最好1.8.0_151以上)。

下载安装Maven(atlas2.0版本最低要求3.6.0)。

安装Python环境(Linux下自带Python环境,可忽略)

下载Apache Atlas

官网链接:http://atlas.apache.org/#/Downloads

我这里下载的是2.0.0

————————————————

版权声明:本文为CSDN博主「Y_尘」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/Y_anger/article/details/105514126

浏览器访问localhost:21000。等几分钟可出现登录界面。

用户名:admin

密码:admin

11.spark 任务添加外部依赖包

依赖包放这个目录下 spark on yarn:

/opt/spark/spark-2.1.1-bin-hadoop2.6/jars

mkdir -p /opt/external_jars

ln -s /opt/external_jars /opt/spark/spark-2.1.1-bin-hadoop2.6/jars/external_jars

具体操作如下:

(1)新建目录

mkdir -p /opt/external_jars

(2)上传依赖包

XXX

(3)建立软链接

ln -s /opt/external_jars /opt/spark/spark-2.1.1-bin-hadoop2.6/jars/external_jars

ln -s /opt/external_jars $SPARK_HOME/jars/external_jars

(4)执行任务即可

xxx

注意:$SPARK_HOME 为spark安装目录

--jars

ln -s /home/gamestat /gamestat

rm -rf b 注意不是rm -rf b/

mkdir -p /opt/external_jars

ln -s /opt/external_jars /usr/lib/hadoop-hdfs/lib/external_jars

ln -s /opt/external_jars /usr/lib/hadoop-yarn/lib/external_jars

SPARK_CLASSPATH=$SPARK_CLASSPATH:/opt/external_jars/*

SPARK_CLASSPATH=$SPARK_CLASSPATH:/opt/external_jars/*

spark-submit --class ezviz.bigdata.spark.OfflineJob --master yarn --deploy-mode cluster --queue azkaban --name antarmy_XP_one_day_data --driver-memory 2G --executor-memory 10G --executor-cores 3 --num-executors 10 --conf spark.driver.extraJavaOptions=" -Dfile.encoding=utf-8 " --conf spark.executor.extraJavaOptions=" -Dfile.encoding=utf-8 " --conf spark.yarn.jars=local:/opt/cloudera/parcels/CDH/lib/spark/jars/*,local:/opt/cloudera/parcels/CDH/lib/spark/hive/*:/opt/cloudera/parcels/CDH/lib/hive/lib/* --conf spark.sql.parquet.compression.codec=gzip --conf spark.shuffle.consolidateFiles=true EzBigdataFramework-1.0-SNAPSHOT-shaded.jar "/user/antarmy/antarmy_xp_one_day_data.conf"

--conf spark.yarn.jars=local:/opt/external_jars/* --conf spark.sql.parquet.compression.codec=gzip --conf spark.shuffle.consolidateFiles=true EzBigdataFramework-1.0-SNAPSHOT-shaded.jar

spark.driver.extraClassPath /opt/external_jars/*

git add 添加了多余文件

git add . 表示当前目录所有文件,不小心就会提交其他文件

git add 如果添加了错误的文件的话

撤销操作

git status 先看一下add 中的文件

git reset HEAD 如果后面什么都不跟的话 就是上一次add 里面的全部撤销了

git reset HEAD XXX.py 就是对某个py文件进行撤销了

git reset HEAD file 即使对file文件夹进行撤销

12.Hbase

truncate_preserve 'hs_spin:ods_ext_item_origin'

describe 'hs_spin:ods_ext_item_origin'

count 'hs_spin:ods_ext_item_origin'

--disable 'tablename'

--drop 'tablename'

--

--

--DROP TABLE "hs_spin"."wh_wide_t1";

A>B and A>C

B>A and B>C

C

1,2,3

-- ELECT b.column_name column_name --字段名

--,b.data_type data_type --字段类型

--,b.data_length --字段长度

--,a.comments comments --字段注释

--FROM user_col_comments a

--,all_tab_columns b

--WHERE a.table_name = b.table_name and

--a.table_name = 'table_name';

select * from "hs_spin"."hive_hbase_test";

select * from "test"."hive_hbase_test";

--use "test"

create table "test"."hive_hbase_test" (

"ROW" VARCHAR PRIMARY KEY,

"f"."id" VARCHAR,

"f"."name" VARCHAR,

"f"."age" VARCHAR);

CREATE SCHEMA IF NOT EXISTS "ns_hs_flink";

/*

CREATE VIEW IF NOT EXISTS "ns_hs_flink"."content" (

"ROW" VARCHAR NOT NULL PRIMARY KEY,

"info"."content" VARCHAR

);

CREATE TABLE IF NOT EXISTS "ns_hs_flink"."content" (

"ROW" VARCHAR NOT NULL PRIMARY KEY,

"info"."content" VARCHAR

) column_encoded_bytes=0;--禁用列映射

*/

0000074d93654e3e836c4be4a9b34712

SELECT min(a."crt"),max(a."crt") from "hs_spin"."ods_min_yield_val" a;

CREATE TABLE "hs_spin"."pictures"(

"ROW" VARCHAR PRIMARY KEY,

"f1"."content" VARCHAR,

"f1"."filename" VARCHAR,

"f1"."filesize" VARCHAR,

"f1"."filesplits" VARCHAR);

/*

desc "hs_spin:ods_min_yield_val"

scan "hs_spin:ods_min_yield_val" ,{LIMIT=>6}

scan "hs_spin:ods_min_yield_val" ,{LIMIT=>2}

scan "hs_spin:ods_min_yield_val", {COLUMNS => 'f',LIMIT=>3}

scan "hs_spin:ods_yeid_data" ,{LIMIT=>2}

import org.apache.hadoop.hbase.filter.CompareFilter

import org.apache.hadoop.hbase.filter.SubstringComparator

import org.apache.hadoop.hbase.filter.RowFilter

scan 'hs_spin:dwd_min_yield_val','1435183125@2404213781392523265@20210716170001', {LIMIT=>1}

scan 'hs_spin:dwd_min_yield_val', {LIMIT=>1}

get 'hs_spin:dwd_min_yield_val','1435183125@2404213781392523265@20210716170001'

get 'hs_spin:ods_wide_host','6440379923955687632@2021-07-27 08:00:00'

get 'hs_spin:ods_wide_host','4478282144964194612@2021-07-27 04:00:00'

get 'hs_spin:ods_wide_host','8290000109709697632@20210727080000'

count 'hs_spin:ods_wide_host'

import org.apache.hadoop.hbase.filter.CompareFilter

import org.apache.hadoop.hbase.filter.SubstringComparator

import org.apache.hadoop.hbase.filter.RowFilter

import org.apache.hadoop.hbase.filter.RegexStringComparator

scan 'hs_spin:dwd_min_yield_val',{FILTER => RowFilter.new(CompareFilter::CompareOp.valueOf('EQUAL'), SubstringComparator.new('20210716170001')),LIMIT=>1}

scan 'hs_spin:data_item_val',{FILTER => RowFilter.new(CompareFilter::CompareOp.valueOf('EQUAL'), SubstringComparator.new('1441341441')),LIMIT=>1}

scan 'hs_spin:data_item_val',{FILTER => RowFilter.new(CompareFilter::CompareOp.valueOf('EQUAL'), RegexStringComparator.new(".*1441341441.*")),LIMIT=>1}

scan 'hs_spin:data_item_val',{STARTROW=>'1441341441',STOPROW=>'1441341441z',LIMIT=>10}

scan 'hs_spin:data_item_val_cp',{STARTROW=>'1441341441',STOPROW=>'1441341441z',LIMIT=>10}

scan 'hs_spin:data_item_val',{STARTROW=>'1444390914',STOPROW=>'1444390914z',LIMIT=>10}

scan 'hs_spin:data_item_val',{STARTROW=>'1441598501',STOPROW=>'1441598501z',LIMIT=>10}

scan 'hs_spin:data_item_val',{STARTROW=>'1444390914@YLXS030',STOPROW=>'1444390914z',LIMIT=>10}

scan 'hs_spin:data_item_val',{STARTROW=>'1444390914@YLXS030',STOPROW=>'1444390914z',LIMIT=>10}

scan 'hs_spin:data_item_val',{STARTROW=>'1444390914@YLXS030@202108090759',STOPROW=>'1444390914z',LIMIT=>10}

YLXS030

1444390914

202108090759

scan 'test1', {FILTER => RowFilter.new(CompareFilter::CompareOp.valueOf('EQUAL'), SubstringComparator.new('ts3'))}

ROW COLUMN+CELL

user1|ts3 column=sf:s1, timestamp=1409122354954, value=sku123

scan "hs_spin:ods_spin_host" ,{LIMIT=>1}

scan "hs_spin:ods_wide_host" ,{LIMIT=>1}

put 'hs_spin:ods_wide_host', '0005670556180797632@2020-09-25', 'f_data:htime', '时间'

get 'hs_spin:ods_wide_host', '0005670556180797632@2020-09-25'

get 'hs_spin:ods_wide_host', '0005670556180797632@2020-09-25'

deleteall 'tableName','rowkey' —— 根据rowkey删除表

deleteall 'hs_spin:ods_wide_host', '0005670556180797632@2020-09-25'

deleteall 'hs_spin:ods_wide_host', '2021-07-17'

put 'hs_spin:ods_wide_host', 'r1', 'c1', 'value'

> alter 'Rumenz','depart'

alter 'hs_spin:ods_wide_host','f_data'

> alter 'Rumenz','delete'=>'depart'

// 表名 rowkey 列族:字段名 值

> put 'Rumenz','001','user:name','入门小站'

> put 'Rumenz','001','user:type','1'

//Hbase中表没有rename操作

//1.禁止表插入

> disable 'Rumenz'

//2.制作快照

> snapshot 'Rumenz','RumenzShot'

//3.克隆快照为新名字

> clone_snapshot 'RumenzShot','RumenzNew'

//4.删除快照

> delete_snapshot 'RumenzShot'

//5.删除原表

> drop 'Rumenz'

> desc 'RumenzNew'

scan 'test_table', FILTER=>"ValueFilter(=,'binary:侠梦的开发笔记')"

scan 'hs_spin:data_item_val_cp',{COLUMNS => ['f:devid','f:val'],FILTER=>"ValueFilter(=,'binary:YLXS030')",LIMIT=>3}

scan 'hs_spin:data_item_val_cp',{COLUMNS => ['f:devid','f:val'],FILTER=>"ValueFilter(=,'binary:YLXS030')",LIMIT=>3}

scan 'emp', {FILTER => "RowFilter(=,'binary:5555')"}

import org.apache.hadoop.hbase.filter.CompareFilter

import org.apache.hadoop.hbase.filter.SingleColumnValueFilter

import org.apache.hadoop.hbase.util.Bytes

scan 'ld_login_2',{STARTROW=>'1395590400',LIMIT=>1,FILTER=>SingleColumnValueFilter.new(Bytes.toBytes('cf'),Bytes.toBytes('uid'),CompareFilter::CompareOp.valueOf('EQUAL'),Bytes.toBytes('48159865'))}

scan "hs_spin:ods_yeid_data" ,{LIMIT=>1}

scan "hs_spin:dwd_min_yield_val", {COLUMNS => 'f',LIMIT=>3}

scan "hs_spin:dwd_min_yield_val", {COLUMNS => 'f',LIMIT=>1}

scan "hs_spin:dwd_min_yield_val", {COLUMNS => 'f:producer_id',LIMIT=>3}

scan "hs_spin:dwd_min_yield_val",{FILTER=>"PrifixFilter('100')",LIMIT=>3}

scan 'hs_spin:dwd_min_yield_val', {COLUMNS => ['key' , 'id' , 'name' , 'host_id' , 'model_id' , 'dev_group' , 'path_id' , 'staff_id' , 'staff_name' , 'class_type' , 'variety' , 'yarn_count' , 'class_order' , 'class_order_alias' , 'producer_id' , 'efficiency' , 'factor' , 'output_m' , 'output_kg' , 'output_add_m' , 'output_add_kg' , 'htime' , 'crt' , 'online'], LIMIT => 3, STARTROW => '100'};

scan 'hs_spin:dwd_min_yield_val', {COLUMNS => ['f:producer_id' , 'f:class_order' , 'f:crt' , 'f:host_id' ], LIMIT => 3, STARTROW => '100'}

scan 'hs_spin:dwd_min_yield_val', {COLUMNS => ['f:class_order', 'f:class_order_alias', 'f:crt', 'f:dev_group', 'f:efficiency', 'f:factor', 'f:host_id', 'f:htime', 'f:model_id', 'f:name', 'f:online', 'f:output_add_kg', 'f:output_add_m', 'f:output_kg', 'f:output_m', 'f:path_id', 'f:producer_id', 'f:staff_name'], LIMIT => 3, STARTROW => '100'}

scan 'hs_spin:dwd_min_yield_val', {COLUMNS => ['f:class_order', 'f:class_order_alias', 'f:crt', 'f:dev_group', 'f:efficiency', 'f:factor', 'f:host_id', 'f:htime', 'f:model_id', 'f:name', 'f:online', 'f:output_add_kg', 'f:output_add_m', 'f:output_kg', 'f:output_m', 'f:path_id', 'f:producer_id', 'f:staff_name'], LIMIT => 1, STARTROW => '100'}

scan 'hs_spin:dwd_min_yield_val', {COLUMNS => ['f:producer_id' , 'f:class_order' , 'f:crt' , 'f:host_id' ],TIMERANGE => [1621750981904, 1621750981924], LIMIT => 3, STARTROW => '100'}

-- 查询最后一条数据

scan 'hs_spin:dwd_min_yield_val', {REVERSED => true,LIMIT => 1}

scan 'hs_spin:dwd_min_yield_val', {ALL_METRICS => true}

scan 'hs_spin:dwd_min_yield_val', {ALL_METRICS => true,LIMIT => 1}

scan 'hs_spin:dwd_min_yield_val', {METRICS => ['RPC_RETRIES', 'ROWS_FILTERED'],LIMIT => 1}

scan 'hs_spin:dwd_min_yield_val', {ROWPREFIXFILTER => '100', FILTER => "(QualifierFilter (>=, 'binary:100')) AND (TimestampsFilter ( 123, 456))"}

get 'hs_spin:ods_fault_tolerant_coefficient','6925670556180797632'

get "hs_spin:ods_fault_tolerant_coefficient", '7478282144964194612'

put 'hs_spin:ods_fault_tolerant_coefficient','7478282144964194612','f:ratio','0.03'

get 'hs_spin:ods_fault_tolerant_coefficient','6925670556180797632',{COLUMN=>'f:ratio'}

get 'hs_spin:ods_fault_tolerant_coefficient','6925670556180797632',{COLUMN=>['f:ratio','f:host_id']}

put 'hs_spin:ods_fault_tolerant_coefficient','6925670556180797632','f:ratio','10.35098650746265'

put 'hs_spin:ods_fault_tolerant_coefficient','6925670556180797632','f:ratio','10.35098650746264'

--truncate table "hs_spin"."ods_wide_host";

--truncate "hs_spin"."ods_wide_host";

--

--truncate 'hs_spin:ods_wide_host'

--truncate 'hs_spin:ods_wide_host'

10.35098650746264

hbase> scan 'ns1:hs_spin:dwd_min_yield_val', {COLUMNS => ['c1', 'c2'], LIMIT => 10, STARTROW => 'xyz'}

hbase> scan 'hs_spin:dwd_min_yield_val', {COLUMNS => ['c1', 'c2'], LIMIT => 10, STARTROW => 'xyz'}

hbase> scan 'hs_spin:dwd_min_yield_val', {COLUMNS => 'c1', TIMERANGE => [1303668804, 1303668904]}

hbase> scan 'hs_spin:dwd_min_yield_val', {REVERSED => true,LIMIT => 1}

hbase> scan 'hs_spin:dwd_min_yield_val', {ALL_METRICS => true,LIMIT => 1}

hbase> scan 'hs_spin:dwd_min_yield_val', {METRICS => ['RPC_RETRIES', 'ROWS_FILTERED']}

hbase> scan 'hs_spin:dwd_min_yield_val', {ROWPREFIXFILTER => 'row2', FILTER => "

(QualifierFilter (>=, 'binary:xyz')) AND (TimestampsFilter ( 123, 456))"}

scan "hs_spin:ods_min_yield_val", {COLUMNS => 'f',RAW => true,LIMIT=>3}

get "hs_spin:ods_min_yield_val", '1434475522@null@20210609220301'

1700000100@2633282539095064594@20210606200101

scan '表名', {LIMIT => 2}

scan 'user', {COLUMNS => 'info'}

scan 'user', {COLUMNS => 'info', RAW => true, VERSIONS => 5}

scan 'user', {COLUMNS => 'info', RAW => true, VERSIONS => 3}

scan 'user', {COLUMNS => 'info', RAW => true, VERSIONS => 5}

scan 'user', {COLUMNS => 'info', RAW => true, VERSIONS => 3}

describe 't1' / desc 't1'

scan "hs_spin:ods_min_yield_val" ,{COLUMNS=>['name','id’],LIMIT=>10}

describe "hs_spin:ods_min_yield_val" / desc 't1'

scan "test:hive_hbase_test"

get "test:hive_hbase_test",'0001'

select * from "hs_spin"."hive_hbase_test";

enable "hs_spin"."hive_hbase_test";

hbase shell

use test;

list_namespace

drop_namespace TEST

drop_namespace "TEST"

create_namespace "test", {"author"=>"CC11001100", "create_time"=>"2022-11-4 17:51:53"}

create_namespace "test", {"author"=>"CC11001100", "create_time"=>"2022-11-4 17:51:53"}

use "test"

describe_namespace 'test'

disable "test:hive_hbase_test"

drop "test:hive_hbase_test"

drop_namespace "test"

list_namespace_tables 'test'

-- hbase

create_namespace 'ns_weibo'

create 'ns_weibo:content','info'

put 'ns_weibo:content','1002_1597824006872','info:content','哦,我的上帝,f1'

put 'ns_weibo:content','1002_1597824007229','info:content',',我的上帝,f2'

put 'ns_weibo:content','1002_1597824007311','info:content','哦,我的上帝,f3'

put 'ns_weibo:content','1003_1597824007386','info:content','哦,我的上帝,f5'

create_namespace 'ns_hs_flink'

create 'ns_hs_flink:content','info'

put 'ns_hs_flink:content','1002_1597824006872','info:content','哦,我的上帝,f1'

put 'ns_hs_flink:content','1002_1597824007229','info:content',',我的上帝,f2'

put 'ns_hs_flink:content','1002_1597824007311','info:content','哦,我的上帝,f3'

put 'ns_hs_flink:content','1003_1597824007386','info:content','哦,我的上帝,f5'

scan 'ns_hs_flink:content'

-- phoenix

CREATE SCHEMA IF NOT EXISTS "ns_hs_flink";

CREATE VIEW IF NOT EXISTS "ns_hs_flink"."content" (

"ROW" VARCHAR NOT NULL PRIMARY KEY,

"info"."content" VARCHAR

);

CREATE TABLE IF NOT EXISTS "ns_hs_flink"."content" (

"ROW" VARCHAR NOT NULL PRIMARY KEY,

"info"."content" VARCHAR

) column_encoded_bytes=0;--禁用列映射

scan 'ns_weibo:content'

-- phoenix

CREATE SCHEMA IF NOT EXISTS "ns_weibo";

CREATE VIEW IF NOT EXISTS "ns_weibo"."content" (

"ROW" VARCHAR NOT NULL PRIMARY KEY,

"info"."content" VARCHAR

);

CREATE TABLE IF NOT EXISTS "ns_weibo"."content" (

"ROW" VARCHAR NOT NULL PRIMARY KEY,

"info"."content" VARCHAR

) column_encoded_bytes=0;--禁用列映射

column_encoded_bytes=0;如果hbase表存在加上这个,否则hbase的数据不会映射过来

SPLIT ON ('133','158','159') phoenix的预分区,比hbase更直观明了

SPLIT ON和column_encoded_bytes不能同时存在

COMPRESSION='snappy''?选择压缩方式

SALT_BUCKETS=16 加盐预分区,会?峙渲贫ㄊ康脑し智?,会根据rowkey的hash将数据分配到指定分区,但是不可控会造成数据热点问题

*/

SELECT r."htime" htime,r."dev_group" dev_group,r."batch" batch,r."variety_num" varietyNum,

r."class_order" class_order,r."class_type" class_type,

round(to_number(r."prods"),2) prods,ROUND(to_number(r."rate"), 2) rate,r."host_name" host_name

FROM "hs_spin"."mk_machine_platforms" r

ORDER BY r."htime" DESC ,r."class_order",reverse(substr(r."ROW",1,19));

SELECT *

FROM "hs_spin"."mk_machine_platforms" r

ORDER BY r."htime" DESC ,r."class_order",reverse(substr(r."ROW",1,19)) limit 10;

CREATE TABLE "hs_spin"."wh_wide_all"(

"ROW" VARCHAR PRIMARY KEY ,

"f"."id" VARCHAR ,

"f"."serial_no" VARCHAR ,

"f"."name" VARCHAR ,

"f"."dev_group" VARCHAR ,

"f"."model_id" VARCHAR ,

"f"."variety_id" VARCHAR ,

"f"."batch_id" VARCHAR ,

"f"."emp_name" VARCHAR ,

"f"."class_order" VARCHAR ,

"f"."class_type" VARCHAR ,

"f"."ratea" VARCHAR ,

"f"."rateb" VARCHAR ,

"f"."ratec" VARCHAR ,

"f"."proda1" VARCHAR ,

"f"."add_proda1" VARCHAR ,

"f"."proda" VARCHAR ,

"f"."add_proda" VARCHAR ,

"f"."prodb1" VARCHAR ,

"f"."add_prodb1" VARCHAR ,

"f"."prodb" VARCHAR ,

"f"."add_prodb" VARCHAR ,

"f"."prodc1" VARCHAR ,

"f"."add_prodc1" VARCHAR ,

"f"."prodc" VARCHAR ,

"f"."add_prodc" VARCHAR ,

"f"."prodnow1" VARCHAR ,

"f"."add_prodnow1" VARCHAR ,

"f"."prodnow" VARCHAR ,

"f"."add_prodnow" VARCHAR ,

"f"."ratenow" VARCHAR ,

"f"."open_status" VARCHAR ,

"f"."active_power" VARCHAR ,

"f"."add_active_power" VARCHAR ,

"f"."reverse_active_power" VARCHAR ,

"f"."perceptual_active_power" VARCHAR ,

"f"."capacitive_reactive_power" VARCHAR ,

"f"."a_phase_voltage" VARCHAR ,

"f"."b_phase_voltage" VARCHAR ,

"f"."c_phase_voltage" VARCHAR ,

"f"."ab_line_voltage" VARCHAR ,

"f"."bc_line_voltage" VARCHAR ,

"f"."ca_line_voltage" VARCHAR ,

"f"."a_phase_current" VARCHAR ,

"f"."b_phase_current" VARCHAR ,

"f"."c_phase_current" VARCHAR ,

"f"."a_phase_active_power" VARCHAR ,

"f"."b_phase_active_power" VARCHAR ,

"f"."c_phase_active_power" VARCHAR ,

"f"."a_phase_reactive_power" VARCHAR ,

"f"."total_work" VARCHAR ,

"f"."b_phase_reactive_power" VARCHAR ,

"f"."c_phase_reactive_power" VARCHAR ,

"f"."total_reactive_power" VARCHAR ,

"f"."a_phase_apparent_power" VARCHAR ,

"f"."b_phase_apparent_power" VARCHAR ,

"f"."c_phase_apparent_power" VARCHAR ,

"f"."total_apparent_power" VARCHAR ,

"f"."a_phase_power_factor" VARCHAR ,

"f"."b_phase_power_factor" VARCHAR ,

"f"."c_phase_power_factor" VARCHAR ,

"f"."power_factor" VARCHAR ,

"f"."frequency" VARCHAR ,

"f"."htime" VARCHAR ,

"f"."owner_id" VARCHAR ,

"f"."mf_id" VARCHAR ,

"f"."online" VARCHAR ,

"f"."crt" VARCHAR );

SELECT * FROM "hs_spin"."data_item_val" limit 10;

SELECT * FROM "hs_spin"."ods_wide_host" limit 10;

SELECT count(1) FROM "hs_spin"."ods_wide_host"; --799432 800943

delete from "hs_spin"."ods_wide_host" where 1=1;

SELECT COUNT(1) from "hs_spin"."ods_wide_host";

[root@cdh1 ~]# hbase org.apache.hadoop.hbase.mapreduce.RowCounter 'sda_crm_calls20180102'

[root@cdh1 ~]# hbase org.apache.hadoop.hbase.mapreduce.RowCounter 'hs_spin:ods_spin_host'

select * from hs_spin:ods_max_yeid_data limit 10;

SELECT COUNT(1) from "hs_spin"."pictures";

SELECT * from "hs_spin"."pictures";

select * from "hs_spin"."data_item_val" a where a."key" like '%2367874700551389189' LIMIT 10;

select * from "hs_spin"."data_item_val" a where a."key" like '%9189' LIMIT 10;

SELECT COUNT(1) from "hs_spin"."ods_wide_host"; --408875

SELECT * from "hs_spin"."ods_wide_host" order by "start_time" desc;

SELECT COUNT(1) from "hs_spin"."spindle_speed_avg_his";

SELECT * from "hs_spin"."spindle_speed_avg_his";

SELECT max("crt"),"t_start_date","t_end_date" FROM "hs_spin"."spindle_speed_avg_his";

SELECT max("crt"),min("crt") FROM "hs_spin"."spindle_speed_avg_his";

--CREATE TABLE "hs_spin"."spindle_speed_avg_his" (

-- "ROW" VARCHAR PRIMARY KEY,

-- "f"."host_id" VARCHAR,

-- "f"."producer_id" VARCHAR,

-- "f"."hostname" VARCHAR,

-- "f"."variety" VARCHAR,

-- "f"."spindle_speed_avg" VARCHAR,

-- "f"."crt" VARCHAR,

-- "f"."t_start_date" VARCHAR,

-- "f"."t_end_date" VARCHAR

--);

SELECT

ROW,

host_id,

producer_id,

hostname,

variety,

spindle_speed_avg,

crt,

t_start_date,

t_end_date

FROM "hs_spin"."spindle_speed_avg_his"

;

SELECT count(1) FROM "hs_spin"."spindle_speed_avg_his"; --99840

SELECT * FROM "hs_spin"."spindle_speed_avg_his" limit 10;

SELECT * FROM "hs_spin"."spindle_speed_avg_his" limit 10;

SELECT MYKEY,MYCOLUMN FROM "ns_hs_flink"."test_phoenix_api";

SELECT MYKEY,MYCOLUMN FROM "ns_hs_flink"."test_phoenix_api";

SELECT * FROM "hs_spin"."spindle_speed_avg_his" where "ROW"='2367900818650169344@202106300001';

SELECT * FROM "hs_spin"."spindle_speed_avg_his" where "t_start_date"='2021-07-12';

SELECT * FROM "hs_spin"."spindle_speed_avg" where "ROW"='2367900818650169344@202106251748';

"ns_hs_flink:airTest"

--create table test_phoenix_api(mykey integer not null primary key ,mycolumn varchar )

--create table "ns_hs_flink"."test_phoenix_api"(mykey integer not null primary key ,mycolumn varchar )

create table IF NOT EXISTS "ns_hs_flink"."test_phoenix_api3"(mykey integer not null primary key ,mycolumn varchar )

/*

squirrel sql客户端里面 有没有快捷键可以让自己写的代码格式化

快捷键盘 : ctrl+alt+f 组合键盘 不过不是很好看

sf SELECT * FROM

智能提示 ctrl+t

scan "ns_hs_flink:airTest"

*/

--CREATE TABLE "hs_spin"."spindle_speed_avg" (

-- "ROW" VARCHAR PRIMARY KEY,

-- "f"."host_id" VARCHAR,

-- "f"."producer_id" VARCHAR,

-- "f"."hostname" VARCHAR,

-- "f"."variety" VARCHAR,

-- "f"."spindle_speed_avg" VARCHAR,

-- "f"."crt" VARCHAR

--);

--DROP TABLE "ns_hs_flink"."content";

--drop table if exists "ns_hs_flink"."content";

--drop table if exists "ns_hs_flink"."hive_hbase_test";

--upsert into "ns_hs_flink".test01_20200413 (COL1, COL6) values(1, 321334);

SELECT COL1,COL2,COL3,COL4,COL5 FROM "ns_hs_flink"."TEST01_20200413";

SELECT ROW,serial_no,producer_id,dev_group,htime,host_name,add_proda,batch_id,batch,add_prodb,add_prodc,prods,variety_num,class_order,class_type,variety_id,rate,model_id,code,open_num,emp_name FROM "hs_spin"."mk_machine_platforms";

SELECT * FROM "hs_spin"."mk_machine_platforms" a limit 3;

SELECT * FROM "hs_spin"."mk_machine_platforms" a where a."producer_id"='2162304858206502921' and a."class_order_alias"='ну░Я' and a."htime"='2021-06-06';

SELECT * FROM "hs_spin"."mk_machine_platforms" a where a."producer_id"='2162304858206502921' and a."class_type"='A' and a."htime"='2021-06-06';

SELECT * FROM "hs_spin"."mk_machine_platforms" a where a."producer_id"='2162304858206502921' and a."class_order"='1' and a."htime"='2021-06-06';

SELECT * FROM "hs_spin"."mk_machine_platforms" a where a."producer_id"='2162304858206502921' and a."class_order"='2' and a."htime"='2021-06-06' and a."add_proda" is not null;

/*

CREATE TABLE "ns_hs_flink"."hive_hbase_test"(

"ROW" VARCHAR PRIMARY KEY,

"cf"."id" VARCHAR,

"cf"."name" VARCHAR,

"cf"."age" VARCHAR

);

*/

select * from "ns_hs_flink"."hive_hbase_test";

13.hive中标准偏差函数stddev()详细讲解

1.标准偏差概念

标准偏差(Std Dev,Standard Deviation) -统计学名词。一种度量数据分布的分散程度之标准,用以衡量数据值偏离算术平均值的程度。标准偏差越小,这些值偏离平均值就越少,反之亦然。标准偏差的大小可通过标准偏差与平均值的倍率关系来衡量。

例如,A、B两组各有6位学生参加同一次语文测验,A组的分数为95、85、75、65、55、45,B组的分数为73、72、71、69、68、67。这两组的平均数都是70,但A组的标准差应该是17.078分,B组的标准差应该是2.160分,说明A组学生之间的差距要比B组学生之间的差距大得多。

标准偏差又分为总体标准偏差与样本标准偏差

总体标准偏差:针对总体数据的偏差,所以要平均,

样本标准偏差,也称实验标准偏差:针对从总体抽样,利用样本来计算总体偏差,为了使算出的值与总体水平更接近,就必须将算出的标准偏差的值适度放大,即,

2.标准偏差计算公式:

样本标准偏差

,

代表所采用的样本X1,X2,...,Xn的均值。

总体标准偏差

,

代表总体X的均值。

例:有一组数字分别是200、50、100、200,求它们的样本标准偏差。

= (200+50+100+200)/4 = 550/4 = 137.5

= [(200-137.5)^2+(50-137.5)^2+(100-137.5)^2+(200-137.5)^2]/(4-1)

样本标准偏差 S = Sqrt(S^2)=75, 注:八年级(下册)上海科学技术出版 21.2数据的离散程度中的标准差是总体标准差

3.hive中的标准偏差函数 stddev_pop(),stddev_samp(),stddev()

stddev_pop() 总体标准方差,stddev_samp() 样本标准方差

(1) hive引擎计算标准偏差

select col, stddev_pop(num),stddev_samp(num),stddev(num) as stddev_col

from (

select 'A' as col, '1' as num

union all

select 'A' as col, '2' as num

union all

select 'A' as col, '3' as num

union all

select 'B' as col, '1' as num

union all

select 'B' as col, '2' as num

) as a

group by col

;

查询结果:

(2)spark引擎查询标准偏差

select col, stddev_pop(num),stddev_samp(num),stddev(num) as stddev_col

from (

select 'A' as col, '1' as num

union all

select 'A' as col, '2' as num

union all

select 'A' as col, '3' as num

union all

select 'B' as col, '1' as num

union all

select 'B' as col, '2' as num

) as a

group by col

查询结果

由上可看出,hive中stddev()函数默认计算总体标准偏差,spark 中stddev()函数默认计算样本标准偏差

4.stddev()也可用于窗口函数

select col, stddev(num) over(partition by col) as stddev_col

from (

select 'A' as col, '1' as num

union all

select 'A' as col, '2' as num

union all

select 'A' as col, '3' as num

union all

select 'B' as col, '1' as num

union all

select 'B' as col, '2' as num

) as a

查询结果:

5. 当计算的输入数据只有一行时 ,hive和spark计算标准方差的结果

(1)hive

select col, stddev_pop(num),stddev_samp(num),stddev(num) as stddev_col

from (

select 'A' as col, '1' as num

union all

select 'B' as col, '2' as num

) as a

group by col

;

查询结果:

(2)spark

select col, stddev_pop(num),stddev_samp(num),stddev(num) as stddev_col

from (

select 'A' as col, '1' as num

union all

select 'B' as col, '2' as num

) as a

group by col

;

hive删除数据

按分区删除:

ALTER TABLE test1 DROP PARTITION (dt='2016-04-29');

删除符合条件的数据:

insert overwrite table t_table1 select * from t_table1 where XXXX;

其中xxx是你需要保留的数据的查询条件。

insert overwrite table tlog_bigtable PARTITION (dt='2017-12-20',game_id = 'id')

select * from tlog_bigtable t

where t.dt = '2017-12-20'

and t.event_time < '2017-12-20 20:00:00'

and t.game_id = 'id'

清空表:

insert overwrite table t_table1 select * from t_table1 where 1=0;

DROP TABLE [IF EXISTS] table_name ;

TRUNCATE TABLE table_name

Method

ttl(String)

Found usages (10 usages found)

Delegate to another instance method (1 usage found)

Maven: redis.clients:jedis:2.9.0 (1 usage found)

redis.clients.jedis (1 usage found)

ShardedJedis (1 usage found)

ttl(String) (1 usage found)

100 return j.ttl(key);

Unclassified usage (1 usage found)

Maven: redis.clients:jedis:2.9.0 (1 usage found)

redis.clients.jedis (1 usage found)

JedisCluster (1 usage found)

ttl(String) (1 usage found)

212 return connection.ttl(key);

Value read (8 usages found)

ods_flink (8 usages found)

com.hangshu.sink (8 usages found)

RedisCustomSink.scala (8 usages found)

48 println("sadd之前"+this.redisCon.ttl(value.key))

50 println("sadd之后"+this.redisCon.ttl(value.key))

51 if (this.redisCon.ttl(value.key) == -1) {

54 println("设置过期之后/每次更新后"+this.redisCon.ttl(value.key))

79 println("sadd之前"+this.redisCon.ttl(value.key))

81 println("sadd之后"+this.redisCon.ttl(value.key))

82 if (this.redisCon.ttl(value.key) == -1) {

85 println("设置过期之后/每次更新后"+this.redisCon.ttl(value.key))

当 key 不存在时,返回 -2 。 当 key 存在但没有设置剩余生存时间时,返回 -1 。 否则,以秒为单位,返回 key 的剩余生存时间。

注意:在 Redis 2.8 以前,当 key 不存在,或者 key 没有设置剩余生存时间时,命令都返回 -1 。

14.mysql

对mysql中日期范围搜索的大致有三种方式:

1、between and语句;

2、datediff函数;

3、timestampdiff函数;

下面就具体说明下这三种方式:

第一种: between and语句

select * from dat_document where commit_date between '2018-07-01' and '2018-07-04'

结果是1号到3号的数据,这是因为时间范围显示的实际上只是‘2018-07-01 00:00:00’到'2018-07-04 00:00:00'之间的数据,而'2018-07-04'的数据就无法显示出来,between and对边界还需要进行额外的处理.

第二种: datediff函数

datediff函数返回两个日期之间的天数

语法:DATEDIFF(date1,date2)

SELECT DATEDIFF('2018-07-01','2018-07-04');

运行结果:-3

所以,datediff函数对时间差值的计算方式为date1-date2的差值。

————————————————

第三种: timestampdiff函数

timestampdiff函数日期或日期时间表达式之间的整数差。

语法:TIMESTAMPDIFF(interval,datetime1,datetime2),比较的单位interval可以为以下数值

FRAC_SECOND。表示间隔是毫秒

SECOND。秒

MINUTE。分钟

HOUR。小时

DAY。天

WEEK。星期

MONTH。月

QUARTER。季度

YEAR。年

select TIMESTAMPDIFF(DAY,'2018-07-01 09:00:00','2018-07-04 12:00:00');

运行结果:3

所以,timestampdiff函数对日期差值的计算方式为datetime2-datetime1的差值。

请注意:DATEDIFF,TIMESTAMPDIFF对日期差值的计算方式刚好是相反的。

————————————————

版权声明:本文为CSDN博主「斌小哥」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/weixin_38319645/article/details/81050962

另外,如果是在xml文件中对计算的值进行比较的话,有可能会用到<、>、<=、>=等,xml会报错,这里需要对这些符号进行替换。

| 原符号 | < | <= | > | >= | & | ' | " |

|---|---|---|---|---|---|---|---|

| 替换符号 | < | <= | > | >= | & | ' | " |

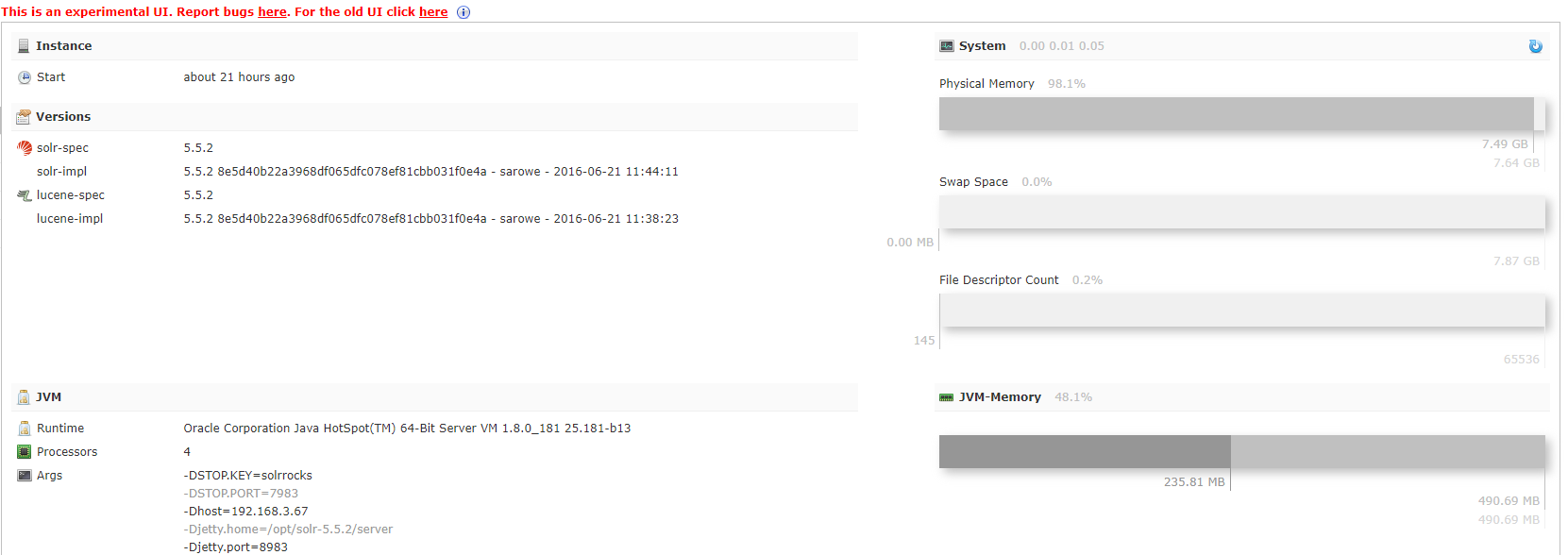

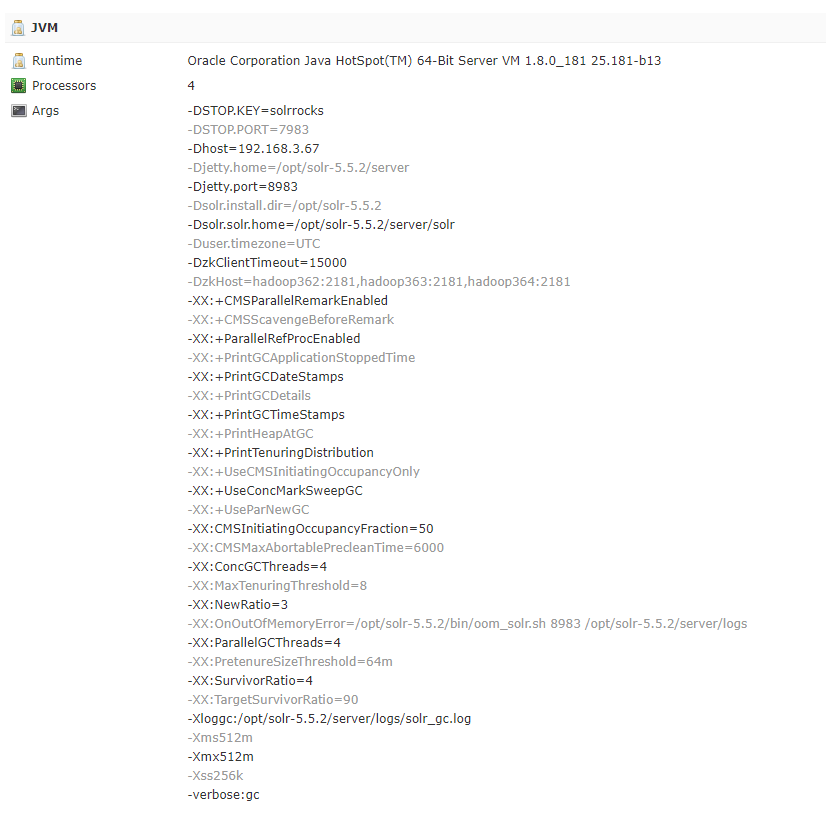

Oracle Corporation Java HotSpot(TM) 64-Bit Server VM (1.8.0_181 25.181-b13)

Processors

4

Args

-DSTOP.KEY=solrrocks-DSTOP.PORT=7983-Dhost=192.168.3.67-Djetty.home=/opt/solr-5.5.2/server-Djetty.port=8983-Dsolr.install.dir=/opt/solr-5.5.2-Dsolr.solr.home=/opt/solr-5.5.2/server/solr-Duser.timezone=UTC-DzkClientTimeout=15000-DzkHost=hadoop362:2181,hadoop363:2181,hadoop364:2181-XX:+CMSParallelRemarkEnabled-XX:+CMSScavengeBeforeRemark-XX:+ParallelRefProcEnabled-XX:+PrintGCApplicationStoppedTime-XX:+PrintGCDateStamps-XX:+PrintGCDetails-XX:+PrintGCTimeStamps-XX:+PrintHeapAtGC-XX:+PrintTenuringDistribution-XX:+UseCMSInitiatingOccupancyOnly-XX:+UseConcMarkSweepGC-XX:+UseParNewGC-XX:CMSInitiatingOccupancyFraction=50-XX:CMSMaxAbortablePrecleanTime=6000-XX:ConcGCThreads=4-XX:MaxTenuringThreshold=8-XX:NewRatio=3-XX:OnOutOfMemoryError=/opt/solr-5.5.2/bin/oom_solr.sh 8983 /opt/solr-5.5.2/server/logs-XX:ParallelGCThreads=4-XX:PretenureSizeThreshold=64m-XX:SurvivorRatio=4-XX:TargetSurvivorRatio=90-Xloggc:/opt/solr-5.5.2/server/logs/solr_gc.log-Xms512m-Xmx512m-Xss256k-verbose:gc

-DzkHost=hadoop362:2181,hadoop363:2181,hadoop364:2181

https://solr.apache.org/

https://cwiki.apache.org/confluence/display/solr/SolrQuerySyntax

## 计算时间差

FRAC_SECOND 表示间隔是毫秒

SECOND 秒

MINUTE 分钟

HOUR 小时

DAY 天

WEEK 星期

MONTH 月

QUARTER 季度

YEAR 年

SELECT DATEDIFF('2021-10-11 07:45:00','2021-10-12 15:45:00');

select timestampdiff(MINUTE,'2021-10-11 07:45:00','2021-10-12 15:45:00');

select timestampdiff(HOUR,'2021-10-11 07:45:00','2021-10-12 15:45:00');

SELECT UNIX_TIMESTAMP('2021-10-12 15:45:00');

SELECT UNIX_TIMESTAMP('2021-10-11 15:45:00');

SELECT (UNIX_TIMESTAMP('2021-10-12 15:45:00') - UNIX_TIMESTAMP('2021-10-11 07:45:00'));

SELECT 1634024700-1633938300;

SELECT SEC_TO_TIME(UNIX_TIMESTAMP(end_time) - UNIX_TIMESTAMP(start_time));

SELECT SEC_TO_TIME(UNIX_TIMESTAMP('2021-10-12 15:45:00') - UNIX_TIMESTAMP('2021-10-11 07:45:00'));

-- mysql中查询某一个字段名属于哪一个库中的哪一张表

select table_schema,table_name from information_schema.columns where column_name = '字段名'

改变世界的是这样一群人,他们寻找梦想中的乐园,当他们找不到时,他们亲手创造了它

https://zhuanlan.zhihu.com/p/144027891

https://www.cnblogs.com/listenfwind/p/12886205.html

https://cloud.tencent.com/developer/article/1005925

https://www.jianshu.com/p/edf503a2a1e7

http://www.ptbird.cn/optimization-of-relational-algebraic-expression.html

org.apache.spark.internal.Logging

蟹六跪而二螯,非蛇鳝之,无可寄托者,用心躁也

《antlr4权威指南》

sqlBase.g4

这里antlr4和grun都已经存储成bat文件,所以可以直接调用,实际命令在《antlr4权威指南》说得很详细了就不介绍了。调用完后就会生成这样的语法树

Spark 2.4.3

其中Catalyst可以说是Spark内部专门用来解析SQL的一个框架,在Hive中类似的框架是Calcite(将SQL解析成MapReduce任务)。Catalyst将SQL解析任务分成好几个阶段,这个在对应的论文中讲述得比较清楚,本系列很多内容也会参考论文,有兴趣阅读原论文的可以到这里看:Spark SQL: Relational Data Processing in Spark。

Catalyst在论文中被叫做优化器(Optimizer),这部分是论文里面较为核心的内容,不过其实流程还是蛮好理解的

主要流程大概可以分为以下几步:

1.Sql语句经过Antlr4解析,生成Unresolved Logical Plan(有使用过Antlr4的童鞋肯定对这一过程不陌生)

2.analyzer与catalog进行绑定(catlog存储元数据),生成Logical Plan;

3.optimizer对Logical Plan优化,生成Optimized LogicalPlan;

4.SparkPlan将Optimized LogicalPlan转换成 Physical Plan;

5.prepareForExecution()将 Physical Plan 转换成 executed Physical Plan;

6.execute()执行可执行物理计划,得到RDD;

//lazy已经缓存的表达式的内容,所以不会再运行表达式里面的东西,也就是表达式内容只运行一次

懒加载就是让表达式里面的计算延迟,并且只计算一次,然后就会缓存结果。

值得一提的是,懒加载只对表达式和函数生效,如果直接定义变量,那是没什么用的。因为懒加载就是让延迟计算,你直接定义变量那计算啥啊

lazy的一个作用,是将推迟复杂的计算,直到需要计算的时候才计算,而如果不使用,则完全不会进行计算。这无疑会提高效率。

而在大量数据的情况下,如果一个计算过程相互依赖,就算后面的计算依赖前面的结果,那么懒加载也可以和缓存计算结合起来,进一步提高计算效率。嗯,有点类似于spark中缓存计算的思想。

除了延迟计算,懒加载也可以用于构建相互依赖或循环的数据结构。我这边再举个从stackOverFlow看到的例子:

这种情况会出现栈溢出,因为无限递归,最终会导致堆栈溢出。

//每个Stream有两个元素,一个head表示当前元素,tail表示除当前元素后面的其他元素,也可能为空

//就跟链表一样

《scala函数式编程》

Functional programming in Scala

这同样都是filter和take,代码跟代码的差距咋就这么大呢?

答案就是:因为Stream利用了惰性求值(lazy evaluation),或者也可以称之为延迟执行(deferred execution)。

就在于List是先把数据构造出来,然后在一堆数据中挑选我们心仪的数据。

而Stream是先把算法构造出来,挑选心仪的算法,最后只执行一大堆算法中我们需要的那一部分。

这样,自然就不会执行多余的运算了。

总而言之,懒加载主要是为了能够在一定程度上提升函数式编程的效率,无论是空间效率还是时间效率。这一点看Stream的各个例子就明白了,Stream这种数据结构天然就是懒的。

同时懒加载更重要的一点是通过分离表达式和值,提升了模块化。这句话听起来比较抽象,还是得看回1.2 懒加载的好处这一节的例子。所谓值和表达式分离,在这个例子中,就是当调用Fee().foo的时候,不会立刻要求得它的值,而只是获得了一个表达式,表达式的值暂时并不关心。这样就将表达式和值分离开来,并且模块化特性更加明显!从这个角度来看,这一点和Scala函数式编程(五) 函数式的错误处理介绍的Try()错误处理有些类似,都是关注表达式而不关注具体的值,其核心归根结底就是为了提升模块化。

Option呢,其实就是薛定谔的值,里面可能有值,也可能没有值。只有到要看的时候,才会知道Option里面到底有没有值。

Option全程叫Option[A],表示Option里面存的是A类型的值,这个A可以是Int,String,等等。我们可以通过get这个api来获取Option[A]里面的值,当不存在时,get会返回None。

可以通过isEmpty,来确认Option里面到底是不是有值。也可以通过getOrElse来指定没有值的时候要返回什么值。

Try[A]和Option类似,都是表示一个可能有也可能没有的东西。实际对应过来, Try[A]就表示一个可能成功也可以失败的计算,如果成功,则返回A类型,如果失败,则返回Throwable。

这种做法会忽略掉原本应该抛出的错误,你需要明确知道自己确实是要忽略掉这个错误才能这样用。

Try("asd".toInt).getOrElse(-1)

一个好的程序员,不应当满足于学习到了什么新的技术或者学习了什么新的算法模型。真正有价值的东西,往往是那些人们不乐意去学的底层的,枯燥的内容。

我们应该认识到,单单只会上层应用开发或只会调包调模型而不懂底层原理,那这种开发人员的知识体系便如空中阁楼。看起来华丽壮观,但实际上却地基不稳。一旦出现一点问题这座阁楼便会顷刻崩塌,并且无计可施,只能到处“祈祷”。

对未知的事务保持好奇,不断学习,探究事物的本质,原理。在我看来,这才是程序员之道。

https://www.cnblogs.com/listenfwind/p/9963489.html

RpcEndpoint => Actor

RpcEndpointRef => ActorRef

RpcEnv => ActorSystem

https://cuipengfei.me/blog/2014/10/23/scala-stream-application-scenario-and-how-its-implemented/

Spark RPC 服务端逻辑小结:我们说明了 Spark RPC 服务端启动的逻辑流程,分为两个部分,第一个是 Spark RPC env ,即 NettyRpcEnv 的创建过程,第二个则是 RpcEndpoint 注册到 dispatcher 的流程。

1. NettyRpcEnvFactory 创建 NettyRpcEnv

根据地址创建 NettyRpcEnv。

NettyRpcEnv 开始启动服务,包括 TransportContext 根据地址开启监听服务,向 Dispacther 注册一个 RpcEndpointVerifier 等待。

2. Dispatcher 注册 RpcEndpoint

Dispatcher 初始化时便创建一个线程池并阻塞等待 receivers 队列中加入新的 EndpointData

一旦新加入 EndpointData 便会调用该 EndpointData 的 inbox 去处理消息。比如 OnStart 消息,或是 RPCMessage 等等。

客户端逻辑小结:客户端和服务端比较类似,都是需要创建一个 NettyRpcEnv 。不同的是接下来客户端创建的是 RpcEndpointRef ,并用之向服务端对应的 RpcEndpoint 发送消息。

1. NettyRpcEnvFactory 创建 NettyRpcEnv

根据地址创建 NettyRpcEnv。 根据地址开启监听服务,向 Dispacther 注册一个 RpcEndpointVerifier 等待。

2. 创建 RpcEndpointRef

创建一个新的 RpcEndpointRef

创建对应的 verifier ,使用 verifier 向服务端发送请求,判断对应的 RpcEndpoint 是否存在。若存在,返回该 RpcEndpointRef ,否则抛出异常。

3. RpcEndpointRef 使用同步或者异步的方式发送请求。

https://gitee.com/dromara

为往圣继绝学,一个人或许能走的更快,但一群人会走的更远。

https://dromara.org/

https://dromara.org/projects/

https://www.oschina.net/

select total_read_bytes_rate_across_disks, total_write_bytes_rate_across_disks where category = CLUSTER

https://ci.apache.org/projects/flink/flink-docs-release-1.7/

https://ci.apache.org/projects/flink/flink-docs-release-1.13/zh/docs/libs/cep/

import org.apache.flink.api.scala._

15.文献下载

http://www.ccgp.gov.cn/cggg/dfgg/cjgg/202108/t20210831_16804338.htm

https://zhuanlan.zhihu.com/p/44149623

https://www.scidown.cn/

www.sciencedirect.com

ieeexplore.ieee.org

pubmed.ncbi.nlm.nih.gov

https://www.sciencedirect.com/science/article/abs/pii/S0951832021002076

FD装备故障诊断专家知识管理系统

https://www.sciencedirect.com/search?qs=Fault%20tree&years=2022%2C2021&lastSelectedFacet=years

Fault tree

Aircraft fault diagnosis

https://www.scidown.cn/scixue.php?doi=10.1016/j.ast.2021.107031

https://www.sciencedirect.com/search?qs=Aircraft%20fault%20diagnosis&years=2020%2C2021%2C2022&lastSelectedFacet=years

http://www.miaotranslation.com/

https://www.hightopo.com/demo/flight-monitor/

https://www.onlinedoctranslator.com/zh-CN/translationform

https://fanyi.sogou.com/user/document/preview?fileId=897afba463b2409e95d33ea6f912ee23

https://www.dogetranslator.com/translation

16.Spark Streaming

流式处理发生中断出错的现象是常有的情况,可能是发生在网络部分、某个节点宕机或程序异常等。,当发生错误导致任务中断后,应该能够恢复到之前成功的状态重新消费。

Storm是利用记录确认机制(Record ACKs)来提供容错功能。

Spark Streaming则采用了基于RDD Checkpoint的方式进行容错。

1.4 性能

延时时间:storm > spark

吞吐量 :spark > storm

1.5. Structed Streaming(结构化)简述

不同点:

Spark Streaming是以RDD构成的DStream为处理结构.

Structed Streaming是一种基于Spark SQL引擎的可扩展且容错的流处理引擎

Structed 提供了更加低延迟的处理模式

相同点:

都是微批的实时处理,内部并不是逐条处理数据记录,而是按照一个个小batch来处理,从而实现低延迟的端到端延迟和一次性容错保证。

原文链接:https://blog.csdn.net/Mrerlou/article/details/113410060

https://www.cnblogs.com/yangxusun9/p/13137592.html

16.1 广播变量、累加器

通常,如下操作rdd.transformation(func),func所需要的外部变量都会以副本的形式从Driver端被发送到每个Executor的每个Task,当Task数目有成百上千个时,这种方式就非常低效;同时每个Task中变量的更新是在本地,也不会被传回Driver端。为此,Spark提供了两种类型的共享变量:广播变量、累加器。

广播变量

广播变量,Execoutor中的只读变量。在Driver端定义,在Exector中只读。

在Execoutor的Task中只读。可用来缓存全局只读变量到Exector中,减少网络通信和存储开销。

————————————————

版权声明:本文为CSDN博主「wangpei1949」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/wangpei1949/article/details/83335273

累加器

累计器,Execoutor中的只增变量。在Exector的Task中只增,在Driver端可读。可用来分布式全局计数和分布式全局聚合。

注意:从Spark 2.x开始,之前的Accumulator被废除,用AccumulatorV2代替。

累加器使用

分布式计数

异常数据收集

UDF、UDAF、UDTF

UDF:用户自定义函数(User Defined Function)。一行输入一行输出。

UDAF: 用户自定义聚合函数(User Defined Aggregate Function)。多行输入一行输出。

UDTF: 用户自定义表函数(User Defined Table Generating Function)。一行输入多行输出。如hive/spark中的explode、json_tuple函数。

UDTF不常用,这里只总结UDF和UDAF。

————————————————

版权声明:本文为CSDN博主「wangpei1949」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/wangpei1949/article/details/83850208

此时注册的方法 只能在sql()中可见,对DataFrame API不可见

用法:sqlContext.udf.register("makeDt", makeDT(_:String,_:String,_:String))

此时注册的方法 只能在sql()中可见,对DataFrame API不可见

用法:sqlContext.udf.register("makeDt", makeDT(_:String,_:String,_:String))

def makeDT(date: String, time: String, tz: String) = s"$date $time $tz"

sqlContext.udf.register("makeDt", makeDT(_:String,_:String,_:String))

// Now we can use our function directly in SparkSQL.

sqlContext.sql("SELECT amount, makeDt(date, time, tz) from df").take(2)

// but not outside

df.select($"customer_id", makeDt($"date", $"time", $"tz"), $"amount").take(2) // fails

2)调用spark.sql.function.udf()方法

此时注册的方法,对外部可见

用法:valmakeDt = udf(makeDT(_:String,_:String,_:String))

示例:

import org.apache.spark.sql.functions.udf

val makeDt = udf(makeDT(_:String,_:String,_:String))

// now this works

df.select($"customer_id", makeDt($"date", $"time", $"tz"), $"amount").take(2)

UDF函数有两种注册方式:

- spark.udf.register() // spark是SparkSession对象

- udf() // 需要import org.apache.spark.sql.functions._

SparkSQL中可以创建自定义函数UDF对dataframe进行操作,UDF是一对一的关系,用于给dataframe增加一列数据的场景。 每次传入一行数据,该行数据可以是一列,也可以是多列,进行一顿操作后,最终只能输出该新增列的一个值。

从Spark 2.0.0开始,Spark Sql包内置和Spark Streaming类似的Time Window,方便我们通过时间来理解数据。

Spark Sql包中的Window API

Tumbling Window

window(timeColumn: Column, windowDuration: String): Column

Slide Window

window(timeColumn: Column, windowDuration: String, slideDuration: String): Column

window(timeColumn: Column,windowDuration: String,slideDuration: String,startTime: String): Column

注意

timeColumn 时间列的schema必须是timestamp类型。

窗口间隔(windowDuration、slideDuration)是字符串类型。如 0 years、0 months 、1 week、0 days、 0 hours、0 minute、 0 seconds、 1 milliseconds、 0 microseconds。

startTime 开始的位置。如从每小时第15分钟开始,startTime为15 minutes。

————————————————

版权声明:本文为CSDN博主「wangpei1949」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/wangpei1949/article/details/83855223

Spark 推测执行是一种优化技术。

在Spark中,可以通过推测执行,即Speculative Execution,来识别并在其他节点的Executor上重启某些运行缓慢的Task,并行处理同样的数据,谁先完成就用谁的结果,并将另一个未完成的Task Kill掉,从而加快Task处理速度。适用于某些Spark任务中部分Task被hang住或运行缓慢,从而拖慢了整个任务运行速度的场景。

注意:

不是所有运行缓慢的Spark任务,都可以用推测执行来解决。

使用推测执行时应谨慎。需要合适的场景、合适的参数,参数不合理可能会导致大量推测执行Task占用资源。

如Spark Streaming写Kafka缓慢,若启用推测执行,可能会导致数据重复。

被推测的Task不会再次被推测。

Spark推测执行参数

spark.speculation :默认false。是否开启推测执行。

spark.speculation.interval :默认100ms。多久检查一次要推测执行的Task。

spark.speculation.multiplier :默认1.5。一个Stage中,运行时间比成功完成的Task的运行时间的中位数还慢1.5倍的Task才可能会被推测执行。

spark.speculation.quantile: 默认0.75。推测的分位数。即一个Stage中,至少要完成75%的Task才开始推测。

————————————————

版权声明:本文为CSDN博主「wangpei1949」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/wangpei1949/article/details/88927332

org.apache.spark.scheduler.TaskSetManager#checkSpeculatableTasks

Spark Streaming是一种面向微批(micro-batch)处理的流计算引擎。Spark Streaming中有3个关于时间间隔的参数,这里做以下总结。

Duration含义

batchDuration: 批次时间。多久一个批次。

windowDuration: 窗口时间。要统计多长时间内的数据。必须是batchDuration整数倍。

slideDuration: 滑动时间。窗口多久滑动一次。必须是batchDuration整数倍。

————————————————

版权声明:本文为CSDN博主「wangpei1949」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/wangpei1949/article/details/89062157

Duration与DStream中RDD数量关系

一个DStream中有且仅有一个RDD。不论是普通DStream还是窗口DStream。

所有DStream都可以看做是WindowedDStream。当只设置了batchDuration,可理解为batchDuration=windowDuration=slideDuration。

DStream.foreachRDD遍历的是间隔slideDuration时间生成的那个RDD。该RDD包含的是windowDuration中的数据。

————————————————

Exactly-Once不是指对输入的数据只处理一次,指的是, 在流计算引擎中, 算子给下游的结果是Exactly-Once的(即:给下游的结果有且仅有一个,且不重复、不少算)。

如在Spark Streaming处理过程中,从一个算子(Operator)到另一个算子(Operator),可能会因为各种不可抗力如机器挂掉等原因,导致某些Task处理失败,Spark内部会基于Lineage或Checkpoint启动重试Task去重新处理同样的数据。因不可抗力的存在,流处理引擎内部不可能做到一条数据仅被处理一次。所以,当流处理引擎声称提供Exactly-Once语义时,指的是从一个Operator到另一个Operator,同样的数据,无论重复处理多少次,最终的结果状态是Exactly-Once。

————————————————

版权声明:本文为CSDN博主「wangpei1949」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/wangpei1949/article/details/89277490

Micro-Batch

典型流处理引擎:Apache Spark(Spark Streaming)。

Spark Streaming将输入的流周期性的划分成一个一个的Batch,然后用Spark批处理的方式,处理每个Batch,一个Batch要么成功,要么失败,失败后重新Replay,Recompute。偶尔可用Checkpoint快照每个RDD状态,恢复时,找到最近的Checkpoint,确定依赖,然后Recompute。

Distributed Snapshot

Distributed Snapshot(分布式快照),简单来说,就是为了保存分布式系统的Global State,当系统Failure Recovery时,从最近一次成功保存的全局快照中恢复每个节点的状态。

典型流处理引擎:Apache Spark(Spark Structured Streaming)、Apache Flink。

Flnk分布式快照是通过Asynchronous Barrier Snapshots算法实现的,该算法借鉴了Chandy-Lamport算法的主要思想,同时也做了一些改进。

Spark Structured Streaming 的Continuous Processing Mode的容错处理使用了基于Chandy-Lamport的分布式快照(Distributed Snapshot)算法。

————————————————

Spark Streaming保证Exactly-Once语义

一个Spark Streaming流处理程序,从广义上讲,包含三个步骤。

接收数据:从Source中接收数据。

转换数据:用DStream和RDD算子转换。

储存数据:将结果保存至外部系统。

如果流处理程序需要实现Exactly-Once语义,那么每一个步骤都要保证Exactly-Once。

接收数据

不同的数据源提供不同的保证。

如HDFS中的数据源,直接支持Exactly-Once语义。如使用基于Kafka Direct API从Kafka获取数据,也能保证Exactly-Once。

转换数据

Spark Streaming内部是天然支持Exactly-once语义。任务失败,不论重试多少次,一个算子给另一个算子的结果有且仅有一个,不重不丢。

储存数据

Spark Streaming中的输出操作foreachRDD默认具有At-Least Once语义,因此当任务失败时会重试多次输出,这样就会重复多次写入外部存储。 如果储存数据想实现Exactly-once,有两种途径。

幂等输出

幂等输出,即同样的数据输出多次,结果一样。一般需要借助外部存储中的唯一键实现。具体步骤:

将kafka参数enable.auto.commit设置为false。

幂等写入后手动提交offset。这里用checkpoint,不需要手动提交,生产中可用Kafka、Zookeeper、HBase等保存offset。

————————————————

Kafka在0.8和0.10之间引入了一种新的消费者API,因此,Spark Streaming与Kafka集成,有两种包可以选择: spark-streaming-kafka-0-8与spark-streaming-kafka-0-10。在使用时应注意以下几点:

spark-streaming-kafka-0-8兼容Kafka 0.8.2.1及以后的版本, 从Spark 2.3.0开始,对Kafka 0.8支持已被标记为过时。

spark-streaming-kafka-0-10兼容Kafka 0.10.0及以后的版本, 从Spark 2.3.0开始, 此API是稳定版。

如果Kafka版本大于等于0.10.0,且Spark版本大于等于Spark 2.3.0,应使用spark-streaming-kafka-0-10。

本文总结spark-streaming-kafka-0-8中两种读取Kafka数据的方式:createStream、createDirectStream。

————————————————

版权声明:本文为CSDN博主「wangpei1949」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/wangpei1949/article/details/89419691

在Spark Streaming中,DStream的转换分为有状态和无状态两种。无状态的操作,即当前批次的处理不依赖于先前批次的数据,如map()、flatMap()、filter()、reduceByKey()、groupByKey()等等;而有状态的操作,即当前批次的处理需要依赖先前批次的数据,这样的话,就需要跨批次维护状态。

总结spark streaming中的状态操作:updateStateByKey、mapWithState、和基于window的状态操作。

————————————————

版权声明:本文为CSDN博主「wangpei1949」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/wangpei1949/article/details/90199002

反压(Back Pressure)机制主要用来解决流处理系统中,处理速度比摄入速度慢的情况。是控制流处理中批次流量过载的有效手段。

反压机制原理

Spark Streaming中的反压机制是Spark 1.5.0推出的新特性,可以根据处理效率动态调整摄入速率。

当批处理时间(Batch Processing Time)大于批次间隔(Batch Interval,即 BatchDuration)时,说明处理数据的速度小于数据摄入的速度,持续时间过长或源头数据暴增,容易造成数据在内存中堆积,最终导致Executor OOM或任务奔溃。

在这种情况下,若是基于Receiver的数据源,可以通过设置spark.streaming.receiver.maxRate来控制最大输入速率;若是基于Direct的数据源(如Kafka Direct Stream),则可以通过设置spark.streaming.kafka.maxRatePerPartition来控制最大输入速率。当然,在事先经过压测,且流量高峰不会超过预期的情况下,设置这些参数一般没什么问题。但最大值,不代表是最优值,最好还能根据每个批次处理情况来动态预估下个批次最优速率。在Spark 1.5.0以上,就可通过背压机制来实现。开启反压机制,即设置spark.streaming.backpressure.enabled为true,Spark Streaming会自动根据处理能力来调整输入速率,从而在流量高峰时仍能保证最大的吞吐和性能。

Spark Streaming的反压机制主要是通过RateController组件来实现。RateController继承自接口StreamingListener,并实现了onBatchCompleted方法。每一个Batch处理完成后都会调用此方法

————————————————

版权声明:本文为CSDN博主「wangpei1949」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/wangpei1949/article/details/90727805

反压机制相关参数

spark.streaming.backpressure.enabled

默认值false,是否启用反压机制。

spark.streaming.backpressure.initialRate

默认值无,初始最大接收速率。只适用于Receiver Stream,不适用于Direct Stream。

spark.streaming.backpressure.rateEstimator

默认值pid,速率控制器,Spark 默认只支持此控制器,可自定义。

spark.streaming.backpressure.pid.proportional

默认值1.0,只能为非负值。当前速率与最后一批速率之间的差值对总控制信号贡献的权重。用默认值即可。

spark.streaming.backpressure.pid.integral

默认值0.2,只能为非负值。比例误差累积对总控制信号贡献的权重。用默认值即可。

spark.streaming.backpressure.pid.derived

默认值0.0,只能为非负值。比例误差变化对总控制信号贡献的权重。用默认值即可。

spark.streaming.backpressure.pid.minRate

默认值100,只能为正数,最小速率。

————————————————

注意:

A. 反压机制真正起作用时需要至少处理一个批

由于反压机制需要根据当前批的速率,预估新批的速率,所以反压机制真正起作用前,应至少保证处理一个批。

B. 如何保证反压机制真正起作用前应用不会崩溃

要保证反压机制真正起作用前应用不会崩溃,需要控制每个批次最大摄入速率。若为Direct Stream,如Kafka Direct Stream,则可以通过spark.streaming.kafka.maxRatePerPartition参数来控制。此参数代表了 每秒每个分区最大摄入的数据条数。假设BatchDuration为10秒,spark.streaming.kafka.maxRatePerPartition为12条,kafka topic 分区数为3个,则一个批(Batch)最大读取的数据条数为360条(3*12*10=360)。同时,需要注意,该参数也代表了整个应用生命周期中的最大速率,即使是背压调整的最大值也不会超过该参数。

查看日志

————————————————

同反压机制一样,Spark Streaming动态资源分配(即DRA,Dynamic Resource Allocation)也可以用来应对流处理中批次流量过载的场景。

Spark Streaming动态资源分配,允许为应用动态分配资源。当任务积压时,申请更多资源;当任务空闲时,使用最少资源。

在生产中,可将动态资源分配和背压机制一起使用,通过背压机制来细粒度确保系统稳定;通过动态资源分配机制来粗粒度根据应用负载,动态增减Executors。共同保证Spark Streaming流处理应用的稳定高效。

动态资源分配的原理

入口类是org.apache.spark.streaming.scheduler.ExecutorAllocationManager。ExecutorAllocationManager中的定时器,每隔spark.streaming.dynamicAllocation.scalingInterval时间,调用一次manageAllocation方法来管理Executor。manageAllocation方法计算规则如下:

必须完成至少一个Batch处理,即batchProcTimeCount > 0。

计算Batch平均处理时间(Batch平均处理时间=Batch总处理时间/Batch总处理次数)。

若Batch平均处理时间大于阈值spark.streaming.dynamicAllocation.scalingUpRatio,则请求新的Executor。

若Batch平均处理时间小于阈值spark.streaming.dynamicAllocation.scalingDownRatio,则移除没有任务的Executor。

动态资源分配重要参数

spark.dynamicAllocation.enabled: 默认false,是否启用Spark批处理动态资源分配。

spark.streaming.dynamicAllocation.enabled: 默认false,是否启用Spark Streaming流处理动态资源分配。

spark.streaming.dynamicAllocation.scalingInterval: 默认60秒,多久检查一次。

spark.streaming.dynamicAllocation.scalingUpRatio: 默认0.9,增加Executor的阈值。

spark.streaming.dynamicAllocation.scalingDownRatio: 默认0.3,减少Executor的阈值。

spark.streaming.dynamicAllocation.minExecutors: 默认无,最小Executor个数

spark.streaming.dynamicAllocation.maxExecutors: 默认无,最大Executor个数。

Spark Streaming动态资源分配注意事项

Spark Streaming动态资源分配和Spark Core动态资源分配互斥

Spark Core动态资源分配适合于批处理,如Spark Sql Cli,可以根据Task数量动态分配Executor数量;如Spark ThriftServer On Yarn,空闲时不占用资源,只有在用户提交Sql任务时才会根据Task数动态分配Executor数。

当开启Spark Streaming动态资源分配时,需要关闭Spark Core动态资源分配。

Spark Streaming动态资源分配起作用前,需要至少完成一个Batch处理

由于Spark Streaming动态资源分配需要根据Batch总处理时间和Batch总处理次数来计算Batch平均处理时间,因此需要至少完成一个Batch处理。这就需要我们保证在Spark Streaming动态资源分配起作用前,应用程序不会崩溃。

Spark Streaming动态资源分配应当和Spark Streaming背压机制同时使用

————————————————

版权声明:本文为CSDN博主「wangpei1949」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/wangpei1949/article/details/90734304

sparkCommLib=/data/apps/sparkCommLib

/usr/hdp/2.6.4.0-91/spark2/bin/spark-submit \

--master yarn \

--deploy-mode cluster \

--queue default \

--name spark_streaming_dra \

--driver-cores 1 \

--driver-memory 1G \

--executor-memory 1G \

--conf spark.dynamicAllocation.enabled=false \

--conf spark.streaming.dynamicAllocation.enabled=true \

--conf spark.streaming.dynamicAllocation.minExecutors=1 \

--conf spark.streaming.dynamicAllocation.maxExecutors=15 \

--jars ${sparkCommLib}/kafka_2.11-0.10.1.0.jar,${sparkCommLib}/kafka-clients-0.10.1.0.jar,${sparkCommLib}/spark-streaming-kafka-0-10_2.11-2.1.1.jar,${sparkCommLib}/fastjson-1.2.5.jar \

--class com.bigData.spark.SparkStreamingDRA \

spark-1.0-SNAPSHOT.jar

在Yarn上可以看到,随着Spark Streaming任务队列中Queued的Batch越来越多,Executors数量在逐渐增加。

https://blog.csdn.net/chenjieit619/article/details/53421080

我们使用spark-submit提交一个Spark作业之后,这个作业就会启动一个对应的Driver进程。根据你使用的部署模式(deploy-mode)不同,Driver进程可能在本地启动,也可能在集群中某个工作节点上启动。Driver进程本身会根据我们设置的参数,占有一定数量的内存和CPU core。而Driver进程要做的第一件事情,就是向集群管理器(可以是Spark Standalone集群,也可以是其他的资源管理集群,美团•大众点评使用的是YARN作为资源管理集群)申请运行Spark作业需要使用的资源,这里的资源指的就是Executor进程。YARN集群管理器会根据我们为Spark作业设置的资源参数,在各个工作节点上,启动一定数量的Executor进程,每个Executor进程都占有一定数量的内存和CPU core。

在申请到了作业执行所需的资源之后,Driver进程就会开始调度和执行我们编写的作业代码了。Driver进程会将我们编写的Spark作业代码分拆为多个stage,每个stage执行一部分代码片段,并为每个stage创建一批task,然后将这些task分配到各个Executor进程中执行。task是最小的计算单元,负责执行一模一样的计算逻辑(也就是我们自己编写的某个代码片段),只是每个task处理的数据不同而已。一个stage的所有task都执行完毕之后,会在各个节点本地的磁盘文件中写入计算中间结果,然后Driver就会调度运行下一个stage。下一个stage的task的输入数据就是上一个stage输出的中间结果。如此循环往复,直到将我们自己编写的代码逻辑全部执行完,并且计算完所有的数据,得到我们想要的结果为止。

Spark是根据shuffle类算子来进行stage的划分。如果我们的代码中执行了某个shuffle类算子(比如reduceByKey、join等),那么就会在该算子处,划分出一个stage界限来。可以大致理解为,shuffle算子执行之前的代码会被划分为一个stage,shuffle算子执行以及之后的代码会被划分为下一个stage。因此一个stage刚开始执行的时候,它的每个task可能都会从上一个stage的task所在的节点,去通过网络传输拉取需要自己处理的所有key,然后对拉取到的所有相同的key使用我们自己编写的算子函数执行聚合操作(比如reduceByKey()算子接收的函数)。这个过程就是shuffle。

当我们在代码中执行了cache/persist等持久化操作时,根据我们选择的持久化级别的不同,每个task计算出来的数据也会保存到Executor进程的内存或者所在节点的磁盘文件中。

因此Executor的内存主要分为三块:第一块是让task执行我们自己编写的代码时使用,默认是占Executor总内存的20%;第二块是让task通过shuffle过程拉取了上一个stage的task的输出后,进行聚合等操作时使用,默认也是占Executor总内存的20%;第三块是让RDD持久化时使用,默认占Executor总内存的60%。

task的执行速度是跟每个Executor进程的CPU core数量有直接关系的。一个CPU core同一时间只能执行一个线程。而每个Executor进程上分配到的多个task,都是以每个task一条线程的方式,多线程并发运行的。如果CPU core数量比较充足,而且分配到的task数量比较合理,那么通常来说,可以比较快速和高效地执行完这些task线程。

以上就是Spark作业的基本运行原理的说明,大家可以结合上图来理解。理解作业基本原理,是我们进行资源参数调优的基本前提。

资源参数调优

了解完了Spark作业运行的基本原理之后,对资源相关的参数就容易理解了。所谓的Spark资源参数调优,其实主要就是对Spark运行过程中各个使用资源的地方,通过调节各种参数,来优化资源使用的效率,从而提升Spark作业的执行性能。以下参数就是Spark中主要的资源参数,每个参数都对应着作业运行原理中的某个部分,我们同时也给出了一个调优的参考值。

内容

1.num-executors

参数说明:该参数用于设置Spark作业总共要用多少个Executor进程来执行。Driver在向YARN集群管理器申请资源时,YARN集群管理器会尽可能按照你的设置来在集群的各个工作节点上,启动相应数量的Executor进程。这个参数非常之重要,如果不设置的话,默认只会给你启动少量的Executor进程,此时你的Spark作业的运行速度是非常慢的。

参数调优建议:每个Spark作业的运行一般设置50~100个左右的Executor进程比较合适,设置太少或太多的Executor进程都不好。设置的太少,无法充分利用集群资源;设置的太多的话,大部分队列可能无法给予充分的资源。

2.executor-memory

参数说明:该参数用于设置每个Executor进程的内存。Executor内存的大小,很多时候直接决定了Spark作业的性能,而且跟常见的JVM OOM异常,也有直接的关联。

参数调优建议:每个Executor进程的内存设置4G~8G较为合适。但是这只是一个参考值,具体的设置还是得根据不同部门的资源队列来定。可以看看自己团队的资源队列的最大内存限制是多少,num-executors乘以executor-memory,是不能超过队列的最大内存量的。此外,如果你是跟团队里其他人共享这个资源队列,那么申请的内存量最好不要超过资源队列最大总内存的1/3~1/2,避免你自己的Spark作业占用了队列所有的资源,导致别的同学的作业无法运行。

3.executor-cores

参数说明:该参数用于设置每个Executor进程的CPU core数量。这个参数决定了每个Executor进程并行执行task线程的能力。因为每个CPU core同一时间只能执行一个task线程,因此每个Executor进程的CPU core数量越多,越能够快速地执行完分配给自己的所有task线程。

参数调优建议:Executor的CPU core数量设置为2~4个较为合适。同样得根据不同部门的资源队列来定,可以看看自己的资源队列的最大CPU core限制是多少,再依据设置的Executor数量,来决定每个Executor进程可以分配到几个CPU core。同样建议,如果是跟他人共享这个队列,那么num-executors * executor-cores不要超过队列总CPU core的1/3~1/2左右比较合适,也是避免影响其他同学的作业运行。

4.driver-memory

参数说明:该参数用于设置Driver进程的内存。

参数调优建议:Driver的内存通常来说不设置,或者设置1G左右应该就够了。唯一需要注意的一点是,如果需要使用collect算子将RDD的数据全部拉取到Driver上进行处理,那么必须确保Driver的内存足够大,否则会出现OOM内存溢出的问题。

5.spark.default.parallelism

参数说明:该参数用于设置每个stage的默认task数量。这个参数极为重要,如果不设置可能会直接影响你的Spark作业性能。

参数调优建议:Spark作业的默认task数量为500~1000个较为合适。很多同学常犯的一个错误就是不去设置这个参数,那么此时就会导致Spark自己根据底层HDFS的block数量来设置task的数量,默认是一个HDFS block对应一个task。通常来说,Spark默认设置的数量是偏少的(比如就几十个task),如果task数量偏少的话,就会导致你前面设置好的Executor的参数都前功尽弃。试想一下,无论你的Executor进程有多少个,内存和CPU有多大,但是task只有1个或者10个,那么90%的Executor进程可能根本就没有task执行,也就是白白浪费了资源!因此Spark官网建议的设置原则是,设置该参数为num-executors * executor-cores的2~3倍较为合适,比如Executor的总CPU core数量为300个,那么设置1000个task是可以的,此时可以充分地利用Spark集群的资源。

6.spark.storage.memoryFraction

参数说明:该参数用于设置RDD持久化数据在Executor内存中能占的比例,默认是0.6。也就是说,默认Executor 60%的内存,可以用来保存持久化的RDD数据。根据你选择的不同的持久化策略,如果内存不够时,可能数据就不会持久化,或者数据会写入磁盘。

参数调优建议:如果Spark作业中,有较多的RDD持久化操作,该参数的值可以适当提高一些,保证持久化的数据能够容纳在内存中。避免内存不够缓存所有的数据,导致数据只能写入磁盘中,降低了性能。但是如果Spark作业中的shuffle类操作比较多,而持久化操作比较少,那么这个参数的值适当降低一些比较合适。此外,如果发现作业由于频繁的gc导致运行缓慢(通过spark web ui可以观察到作业的gc耗时),意味着task执行用户代码的内存不够用,那么同样建议调低这个参数的值。

7.spark.shuffle.memoryFraction

参数说明:该参数用于设置shuffle过程中一个task拉取到上个stage的task的输出后,进行聚合操作时能够使用的Executor内存的比例,默认是0.2。也就是说,Executor默认只有20%的内存用来进行该操作。shuffle操作在进行聚合时,如果发现使用的内存超出了这个20%的限制,那么多余的数据就会溢写到磁盘文件中去,此时就会极大地降低性能。

参数调优建议:如果Spark作业中的RDD持久化操作较少,shuffle操作较多时,建议降低持久化操作的内存占比,提高shuffle操作的内存占比比例,避免shuffle过程中数据过多时内存不够用,必须溢写到磁盘上,降低了性能。此外,如果发现作业由于频繁的gc导致运行缓慢,意味着task执行用户代码的内存不够用,那么同样建议调低这个参数的值。

8.total-executor-cores

参数说明:Total cores for all executors.

9.资源参数参考示例

以下是一份spark-submit命令的示例:

--master spark://192.168.1.1:7077 \

--master yarn-cluster \

--master yarn-client \

./bin/spark-submit \

--master spark://192.168.1.1:7077 \

--num-executors 100 \

--executor-memory 6G \

--executor-cores 4 \

--total-executor-cores 400 \ ##standalone default all cores

--driver-memory 1G \

--conf spark.default.parallelism=1000 \

--conf spark.storage.memoryFraction=0.5 \

--conf spark.shuffle.memoryFraction=0.3 \

————————————————

版权声明:本文为CSDN博主「chenjieit619」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/chenjieit619/article/details/53421080

查看正常CPU

SELECT cpu_nice_rate WHERE category= HOST

2. 查看使用物理内存

SELECT physical_memory_used WHERE category= HOST

1.10 Hbase迁移

1.10.1 copytable方式

bin/hbaseorg.apache.hadoop.hbase.mapreduce.CopyTable--peer.adr=zookeeper1,zookeeper2,zookeeper3:/hbase 'testtable'

这个操作需要添加hbase目录里的conf/mapred-site.xml,可以复制hadoop的过来。

1.10.2 Export/Import

bin/hbaseorg.apache.hadoop.hbase.mapreduce.Export testtable /user/testtable[versions] [starttime] [stoptime]

bin/hbaseorg.apache.hadoop.hbase.mapreduce.Import testtable /user/testtable

1.10.3 直接拷贝hdfs对应的文件

首先拷贝hdfs文件,如bin/hadoop distcp hdfs://srcnamenode:9000/hbase/testtable/hdfs://distnamenode:9000/hbase/testtable/

然后在目的hbase上执行bin/hbase org.jruby.Main bin/add_table.rb /hbase/testtable

生成meta信息后,重启hbase

http://www.saoniuhuo.com/question/detail-1914490.html?sort=new

在YARN的原生任务监控界面中,我们经常能看到Aggregate Resource Allocation这个指标(图中高亮选中部分),这个指标表示该任务拥有的所有container每秒所消耗的资源(内存、CPU)总和

GMV (Gross Merchandise Volume) 一般只有平台类的电商网站才喜欢这么说法,比如淘宝,TMALL在电商网站定义里面是网站成交金额这个实际指的是拍下订单金额, 包含付款和未付款的部分而销售额一般对应的是b2c自营网站,那个就是实际流水了以前一些活动销售额的新闻报道,网站喜欢给的是GMV金额, 无他, 数字大,好看!实际付款金额要略低一些,因为有时候是隔天付款,但是订单成交是在当天当然,实际订单可能不支付,所以GMV肯定大于实际销售额

作者:皓子

链接:https://www.zhihu.com/question/20146641/answer/24469879

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

如上图,这里面的Aggregate Resource Allocation : 38819 MB-seconds, 104 vcore-seconds是什么意思呢?