为什么 Java 中只有值传递?

开始之前,我们先来搞懂下面这两个概念:

- 形参&实参

- 值传递&引用传递

形参&实参

方法的定义可能会用到 参数(有参的方法),参数在程序语言中分为:

- 实参(实际参数) :用于传递给函数/方法的参数,必须有确定的值。

- 形参(形式参数) :用于定义函数/方法,接收实参,不需要有确定的值。

String hello = "Hello!";

// hello 为实参

sayHello(hello);

// str 为形参

void sayHello(String str) {

System.out.println(str);

}

值传递&引用传递

程序设计语言将实参传递给方法(或函数)的方式分为两种:

- 值传递 :方法接收的是实参值的拷贝,会创建副本。

- 引用传递 :方法接收的直接是实参所引用的对象在堆中的地址,不会创建副本,对形参的修改将影响到实参。

很多程序设计语言(比如 C++、 Pascal )提供了两种参数传递的方式,不过,在 Java 中只有值传递。

为什么 Java 只有值传递?

为什么说 Java 只有值传递呢? 不需要太多废话,我通过 3 个例子来给大家证明。

案例1:传递基本类型参数

代码:

public static void main(String[] args) {

int num1 = 10;

int num2 = 20;

swap(num1, num2);

System.out.println("num1 = " + num1);

System.out.println("num2 = " + num2);

}

public static void swap(int a, int b) {

int temp = a;

a = b;

b = temp;

System.out.println("a = " + a);

System.out.println("b = " + b);

}

输出:

a = 20

b = 10

num1 = 10

num2 = 20

解析:

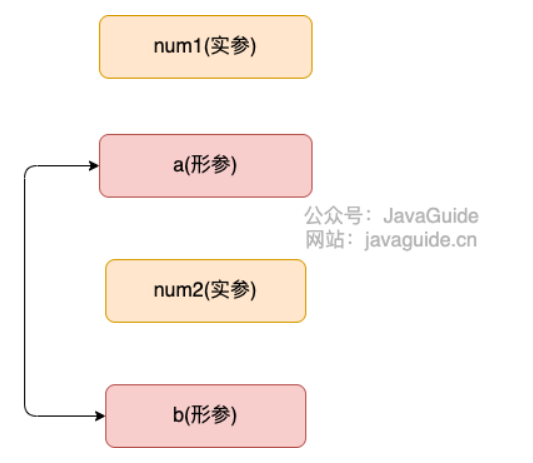

在 swap() 方法中,a、b 的值进行交换,并不会影响到 num1、num2。因为,a、b 的值,只是从 num1、num2 的复制过来的。也就是说,a、b 相当于 num1、num2 的副本,副本的内容无论怎么修改,都不会影响到原件本身。

通过上面例子,我们已经知道了一个方法不能修改一个基本数据类型的参数,而对象引用作为参数就不一样,请看案例2。

案例2:传递引用类型参数1

代码:

public static void main(String[] args) {

int[] arr = { 1, 2, 3, 4, 5 };

System.out.println(arr[0]);

change(arr);

System.out.println(arr[0]);

}

public static void change(int[] array) {

// 将数组的第一个元素变为0

array[0] = 0;

}

输出:

1

0

解析:

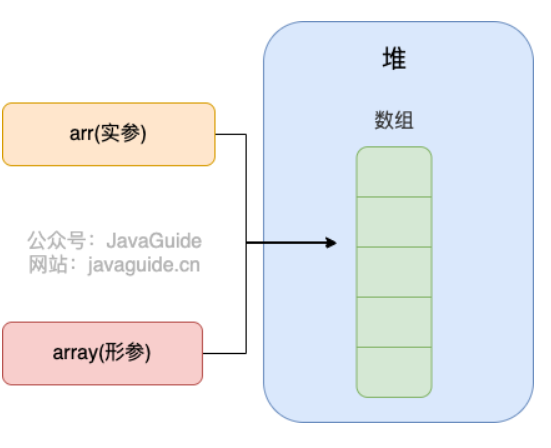

看了这个案例很多人肯定觉得 Java 对引用类型的参数采用的是引用传递。

实际上,并不是的,这里传递的还是值,不过,这个值是实参的地址罢了!

也就是说 change 方法的参数拷贝的是 arr (实参)的地址,因此,它和 arr 指向的是同一个数组对象。这也就说明了为什么方法内部对形参的修改会影响到实参。

为了更强有力地反驳 Java 对引用类型的参数采用的不是引用传递,我们再来看下面这个案例!

案例3 :传递引用类型参数2

public class Person {

private String name;

// 省略构造函数、Getter&Setter方法

}

public static void main(String[] args) {

Person xiaoZhang = new Person("小张");

Person xiaoLi = new Person("小李");

swap(xiaoZhang, xiaoLi);

System.out.println("xiaoZhang:" + xiaoZhang.getName());

System.out.println("xiaoLi:" + xiaoLi.getName());

}

public static void swap(Person person1, Person person2) {

Person temp = person1;

person1 = person2;

person2 = temp;

System.out.println("person1:" + person1.getName());

System.out.println("person2:" + person2.getName());

}

输出:

person1:小李

person2:小张

xiaoZhang:小张

xiaoLi:小李

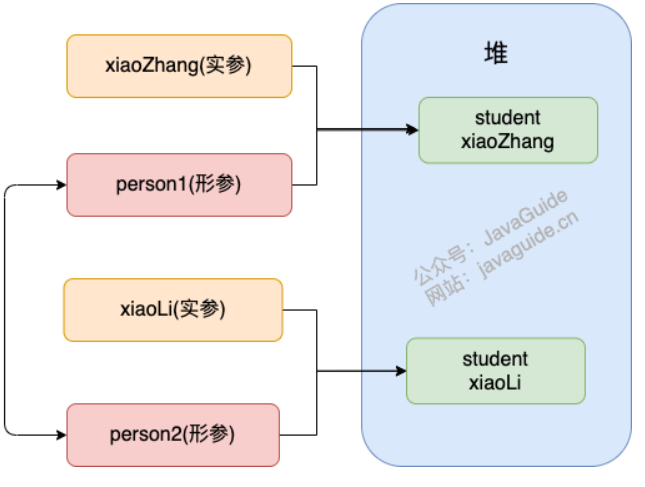

怎么回事???两个引用类型的形参互换并没有影响实参啊!

swap 方法的参数 person1 和 person2 只是拷贝的实参 xiaoZhang 和 xiaoLi 的地址。因此, person1 和 person2 的互换只是拷贝的两个地址的互换罢了,并不会影响到实参 xiaoZhang 和 xiaoLi 。

那如果调用对象的方法进行改变的话,就会发生改变,比如将swap改成:

public static void swap(Person person1, Person person2) {

String name1 = person1.getName();

String name2 = person2.getName();

person1.setName(name2);

person2.setName(name1);

}

主程序中:

@Test

void Test3(){

Person xiaoZhang = new Person("小张");

Person xiaoLi = new Person("小李");

System.out.println("修改前");

System.out.println("person1:" + xiaoZhang.getName());

System.out.println("person2:" + xiaoLi.getName());

swap(xiaoZhang,xiaoLi);

System.out.println("修改后");

System.out.println("person1:" + xiaoZhang.getName());

System.out.println("person2:" + xiaoLi.getName());

}

结果为

修改前

person1:小张

person2:小李

修改后

person1:小李

person2:小张

可以发现里面的属性被修改了。

总结

Java 中将实参传递给方法(或函数)的方式是 值传递 :

- 如果参数是基本类型的话,很简单,传递的就是基本类型的字面量值的拷贝,会创建副本。

- 如果参数是引用类型,传递的就是实参所引用的对象在堆中地址值的拷贝,同样也会创建副本。

Java序列化详解

什么是序列化?什么是反序列化?

如果我们需要持久化 Java 对象比如将 Java 对象保存在文件中,或者在网络传输 Java 对象,这些场景都需要用到序列化。

简单来说:

- 序列化: 将数据结构或对象转换成二进制字节流的过程

- 反序列化:将在序列化过程中所生成的二进制字节流的过程转换成数据结构或者对象的过程

对于 Java 这种面向对象编程语言来说,我们序列化的都是对象(Object)也就是实例化后的类(Class),但是在 C++这种半面向对象的语言中,struct(结构体)定义的是数据结构类型,而 class 对应的是对象类型。

维基百科是如是介绍序列化的:

序列化(serialization)在计算机科学的数据处理中,是指将数据结构或对象状态转换成可取用格式(例如存成文件,存于缓冲,或经由网络中发送),以留待后续在相同或另一台计算机环境中,能恢复原先状态的过程。依照序列化格式重新获取字节的结果时,可以利用它来产生与原始对象相同语义的副本。对于许多对象,像是使用大量引用的复杂对象,这种序列化重建的过程并不容易。面向对象中的对象序列化,并不概括之前原始对象所关系的函数。这种过程也称为对象编组(marshalling)。从一系列字节提取数据结构的反向操作,是反序列化(也称为解编组、deserialization、unmarshalling)。

综上:序列化的主要目的是通过网络传输对象或者说是将对象存储到文件系统、数据库、内存中。

实际开发中有哪些用到序列化和反序列化的场景?

- 对象在进行网络传输(比如远程方法调用 RPC 的时候)(啥是远程方法调用RPC?)之前需要先被序列化,接收到序列化的对象之后需要再进行反序列化;

- 将对象存储到文件中的时候需要进行序列化,将对象从文件中读取出来需要进行反序列化。

- 将对象存储到缓存数据库(如 Redis)时需要用到序列化,将对象从缓存数据库中读取出来需要反序列化。

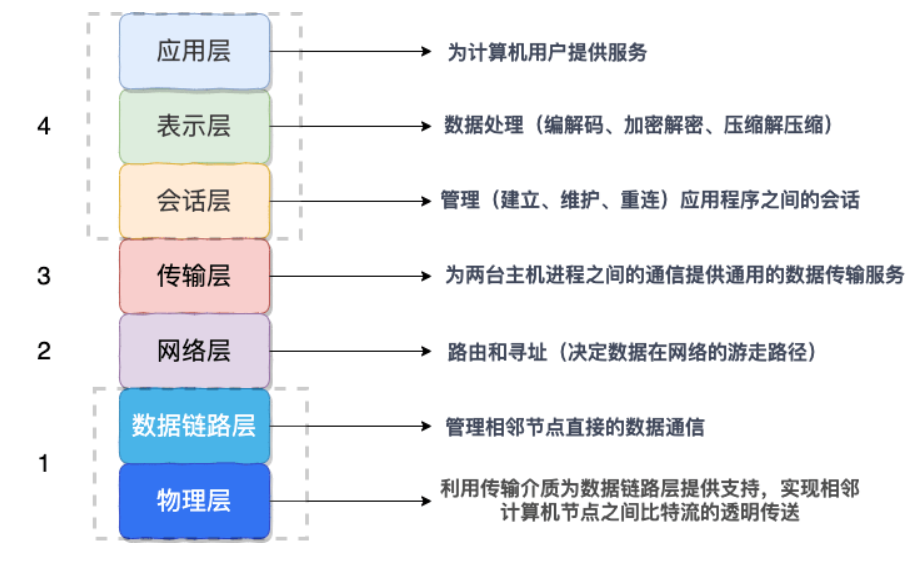

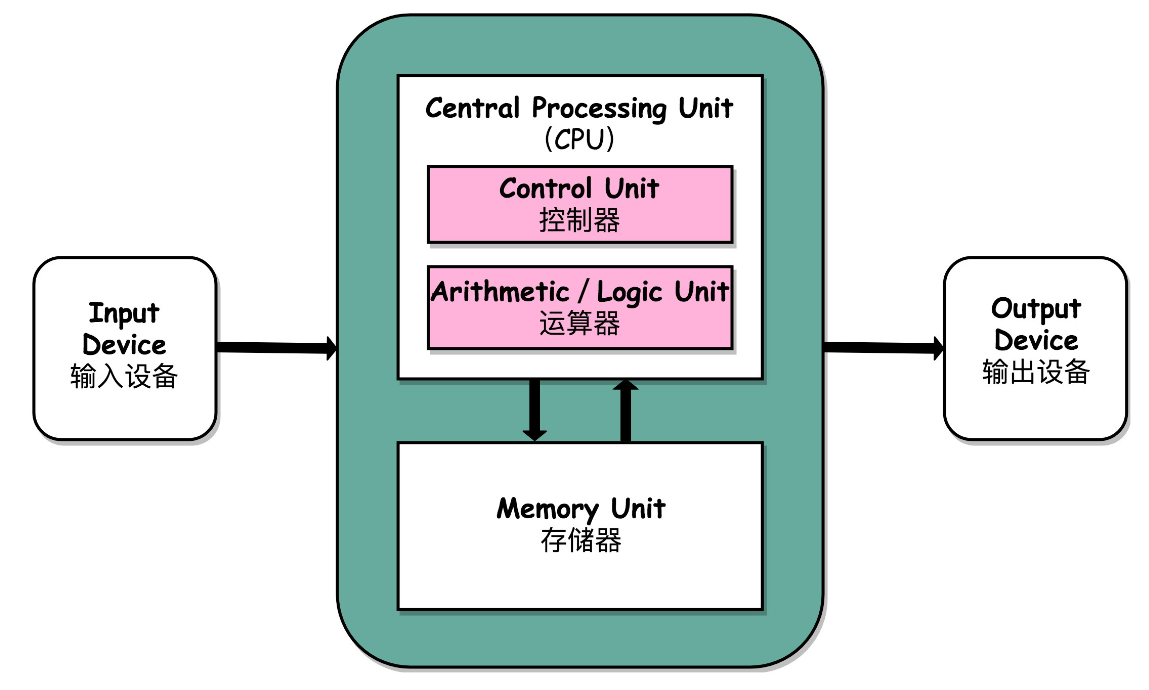

序列化协议对应于 TCP/IP 4 层模型的哪一层?

我们知道网络通信的双方必须要采用和遵守相同的协议。TCP/IP 四层模型是下面这样的,序列化协议属于哪一层呢?

- 应用层

- 传输层

- 网络层

- 网络接口层

如上图所示,OSI 七层协议模型中,表示层做的事情主要就是对应用层的用户数据进行处理转换为二进制流。反过来的话,就是将二进制流转换成应用层的用户数据。这不就对应的是序列化和反序列化么?

因为,OSI 七层协议模型中的应用层、表示层和会话层对应的都是 TCP/IP 四层模型中的应用层,所以序列化协议属于 TCP/IP 协议应用层的一部分。

常见序列化协议对比

JDK 自带的序列化方式一般不会用 ,因为序列化效率低并且部分版本有安全漏洞。(为啥效率低?安全漏洞又是啥?)比较常用的序列化协议有 hessian、kyro、protostuff。

下面提到的都是基于二进制的序列化协议,像 JSON 和 XML 这种属于文本类序列化方式。虽然 JSON 和 XML 可读性比较好,但是性能较差,一般不会选择。

JDK 自带的序列化方式

JDK 自带的序列化,只需实现 java.io.Serializable接口即可。比如下面的Student类

@NoArgsConstructor

@AllArgsConstructor

@Getter

@Builder

@ToString

public class Student implements Serializable {

private static final long serialVersionUID = 1905122041950251207L;

private String name;

private transient Integer age;

private String address;

}

private transient Integer age中的transient表示不会序列化该属性,当对象被序列化时该属性age不会被序列化,反序列化时,该属性是以默认值赋值。比如下面反序列化时,age的值为空。

public class SerializeOperation {

/**

* 序列化对象,并使用了try-with-resources

* @param student

* @param path

* @throws IOException

*/

public static void serializeToFile(Student student, String path) throws IOException {

Student s = new Student("小明",16,"翻斗花园");

try(FileOutputStream fileOut = new FileOutputStream(path);

ObjectOutputStream out = new ObjectOutputStream(fileOut);) {

out.writeObject(s);

}catch (Exception e){

e.printStackTrace();

}

}

/**

* 反序列化对象

* @param path

*/

public static void deserializationFromFile(String path){

try(FileInputStream fileIn = new FileInputStream(path);

ObjectInputStream in = new ObjectInputStream(fileIn);){

Student s = (Student) in.readObject();

System.out.println(s.getAddress());

System.out.println(s.getAge());

System.out.println(s.getName());

}catch (Exception e){

e.printStackTrace();

}

}

}

上面使用了try-with-resources可以自动关闭任何实现 java.lang.AutoCloseable或者 java.io.Closeable 的对象。这样我们就不用在finally再关闭了。

主程序:

public class mainPractice {

public static void main(String[] args) throws IOException {

Student toBeSerializedObject = new Student("小明",16,"翻斗花园!");

StringBuffer path = new StringBuffer("E:");

path.append(File.separator).append("test").append(File.separator).append("student.ser");

SerializeOperation.serializeToFile(toBeSerializedObject, path.toString());

SerializeOperation.deserializationFromFile(path.toString());

}

}

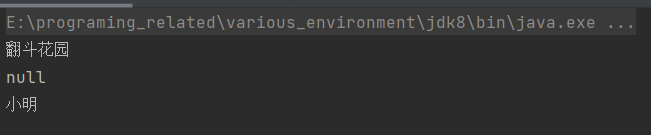

打印的结果:

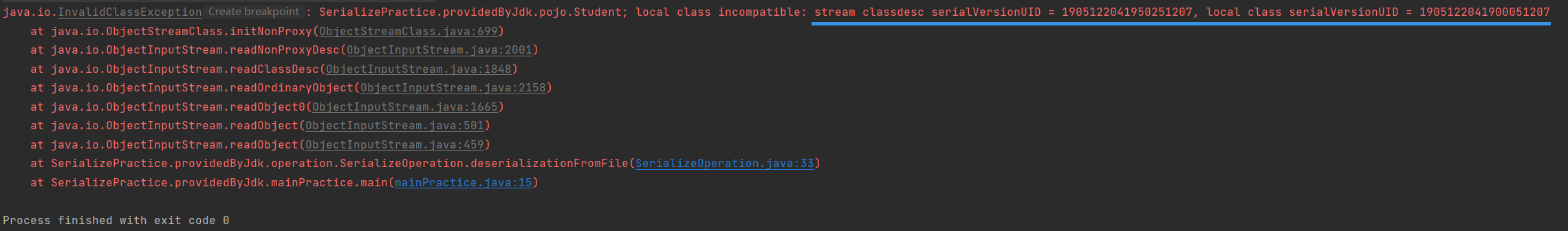

如果初始化的序列化id和反序列化的id不一致,就会报错:

JDK序列化的缺陷

我们在用过的RPC(远程方法调用)通信框架中,很少会发现使用JDK提供的序列化,主要是因为JDK默认的序列化存在着如下一些缺陷:

1. 无法跨语言

现在很多系统的复杂度很高,采用多种语言来编码,而Java序列化目前只支持Java语言实现的框架,其它语言大部分都没有使用Java的序列化框架,也没有实现Java序列化这套协议,因此,如果两个基于不同语言编写的应用程序之间通信,使用Java序列化,则无法实现两个应用服务之间传输对象的序列化和反序列化。 像JSON序列化的话就可以跨语言,因为JSON这种数据格式是通用的。

2. 易被攻击

Java官网安全编码指导方针里有说明,“对于不信任数据的反序列化,从本质上来说是危险的,应该避免“。可见Java序列化并不是安全的。

我们知道对象是通过在 ObjectInputStream 上调用 readObject() 方法进行反序列化的,这个方法其实是一个神奇的构造器,它可以将类路径上几乎所有实现了 Serializable 接口的对象都实例化。这也就意味着,在反序列化字节流的过程中,该方法可以执行任意类型的代码,这是非常危险的。

对于需要长时间进行反序列化的对象,不需要执行任何代码,也可以发起一次攻击。攻击者可以创建循环对象链,然后将序列化后的对象传输到程序中反序列化,这种情况会导致 hashCode 方法被调用次数呈次方爆发式增长, 从而引发栈溢出异常。例如下面这个案例就可以很好地说明。

Set root = new HashSet();

Set s1 = root;

Set s2 = new HashSet();

for (int i = 0; i < 100; i++) {

Set t1 = new HashSet();

Set t2 = new HashSet();

t1.add("test"); //使t2不等于t1

s1.add(t1);

s1.add(t2);

s2.add(t1);

s2.add(t2);

s1 = t1;

s2 = t2;

}

如何解决这个漏洞?

很多序列化协议都制定了一套数据结构来保存和获取对象。例如,JSON 序列化、ProtocolBuf 等,它们只支持一些基本类型和数组数据类型,这样可以避免反序列化创建一些不确定的实例。虽然它们的设计简单,但足以满足当前大部分系统的数据传输需求。我们也可以通过反序列化对象白名单来控制反序列化对象,可以重写 resolveClass 方法,并在该方法中校验对象名字。代码如下所示:

@Override

protected Class resolveClass(ObjectStreamClass desc) throws IOException,ClassNotFoundException {

if (!desc.getName().equals(Bicycle.class.getName())) {

throw new InvalidClassException(

"Unauthorized deserialization attempt", desc.getName());

}

return super.resolveClass(desc);

}

3. 序列化后的流太大

序列化后的二进制流大小能体现序列化的性能。序列化后的二进制数组越大,占用的存储空间就越多,存储硬件的成本就越高。如果我们是进行网络传输,则占用的带宽就更多,这时就会影响到系统的吞吐量。

Java 序列化中使用了 ObjectOutputStream 来实现对象转二进制编码,那么这种序列化机制实现的二进制编码完成的二进制数组大小,相比于 NIO 中的 ByteBuffer 实现的二进制编码完成的数组大小,要大上几倍。

4. 序列化性能太差

Java 序列化中的编码耗时要比 ByteBuffer 长很多。

Kryo

Kryo 是一个高性能的序列化/反序列化工具,由于其变长存储特性并使用了字节码生成机制,拥有较高的运行速度和较小的字节码体积。

另外,Kryo 已经是一种非常成熟的序列化实现了,已经在 Twitter、Groupon、Yahoo 以及多个著名开源项目(如 Hive、Storm)中广泛的使用。刚刚序列化和反序列化Student的案例在Kryo上使用如下:

public class KryoSerializerOperation {

public static void serializeToFile(Object toBeSerializedObject, String path){

Kryo kryo = new Kryo();

kryo.register(toBeSerializedObject.getClass());

try (Output output = new Output(new FileOutputStream(path));){

kryo.writeObject(output, toBeSerializedObject);

}catch (Exception e){

e.printStackTrace();

}

}

public static void deSerializeFromFile(Class toBeSerializedObject, String path){

Kryo kryo = new Kryo();

kryo.register(toBeSerializedObject);

try (Input input = new Input(new FileInputStream(path));){

Student s = (Student) kryo.readObject(input, toBeSerializedObject);

System.out.println(s);

}catch (Exception e){

e.printStackTrace();

}

}

}

主程序:

public class mainPractice {

public static void main(String[] args) {

KryoSerializerOperation.serializeToFile(ConstantUsedBySerialization.student

,ConstantUsedBySerialization.path);

KryoSerializerOperation.deSerializeFromFile(ConstantUsedBySerialization.student.getClass()

,ConstantUsedBySerialization.path);

}

}

其中的常量类为:

public class ConstantUsedBySerialization {

public static Student student = new Student("小明",16,"翻斗花园");

public static String path = "E:"+ File.separator+"test"+File.separator+"student.ser";

}

Protobuf

Protobuf 出自于 Google,性能还比较优秀,也支持多种语言,同时还是跨平台的。就是在使用中过于繁琐,因为你需要自己定义 IDL 文件和生成对应的序列化代码。这样虽然不然灵活,但是,另一方面导致 protobuf 没有序列化漏洞的风险。

Protobuf 包含序列化格式的定义、各种语言的库以及一个 IDL 编译器。正常情况下你需要定义 proto 文件,然后使用 IDL 编译器编译成你需要的语言

一个简单的 proto 文件如下:

// protobuf的版本

syntax = "proto3";

// SearchRequest会被编译成不同的编程语言的相应对象,比如Java中的class、Go中的struct

message Person {

//string类型字段

string name = 1;

// int 类型字段

int32 age = 2;

}

总结

Kryo 是专门针对 Java 语言序列化方式并且性能非常好,如果你的应用是专门针对 Java 语言的话可以考虑使用,并且 Dubbo 官网的一篇文章中提到说推荐使用 Kryo 作为生产环境的序列化方式。(文章地址:[rest 协议 | Apache Dubbo](https://dubbo.apache.org/zh/docs/v2.7/user/references/protocol/rest/))

Java 反射机制详解

何为反射?

如果说大家研究过框架的底层原理或者咱们自己写过框架的话,一定对反射这个概念不陌生。

反射之所以被称为框架的灵魂,主要是因为它赋予了我们在运行时分析类以及执行类中方法的能力。通过反射你可以获取任意一个类的所有属性和方法,你还可以调用这些方法和属性。

反射的应用场景了解么?

像咱们平时大部分时候都是在写业务代码,很少会接触到直接使用反射机制的场景。

但是,这并不代表反射没有用。相反,正是因为反射,你才能这么轻松地使用各种框架。像 Spring/Spring Boot、MyBatis 等等框架中都大量使用了反射机制。

这些框架中也大量使用了动态代理,而动态代理的实现也依赖反射。

比如下面是通过 JDK 实现动态代理的示例代码,其中就使用了反射类 Method 来调用指定的方法。

public class DebugInvocationHandler implements InvocationHandler {

/**

* 代理类中的真实对象

*/

private final Object target;

public DebugInvocationHandler(Object target) {

this.target = target;

}

public Object invoke(Object proxy, Method method, Object[] args) throws InvocationTargetException, IllegalAccessException {

System.out.println("before method " + method.getName());

Object result = method.invoke(target, args);

System.out.println("after method " + method.getName());

return result;

}

}

另外,像 Java 中的一大利器 注解 的实现也用到了反射。

为什么你使用 Spring 的时候 ,一个@Component注解就声明了一个类为 Spring Bean 呢?为什么你通过一个 @Value注解就读取到配置文件中的值呢?究竟是怎么起作用的呢?

这些都是因为你可以基于反射分析类,然后获取到类/属性/方法/方法的参数上的注解。你获取到注解之后,就可以做进一步的处理。

谈谈反射机制的优缺点

优点 : 可以让咱们的代码更加灵活、为各种框架提供开箱即用的功能提供了便利

缺点 :让我们在运行时有了分析操作类的能力,这同样也增加了安全问题。比如可以无视泛型参数的安全检查(泛型参数的安全检查发生在编译时)(如何无视?)。另外,反射的性能也要稍差点,不过,对于框架来说实际是影响不大的。

反射实战

获取 Class 对象的四种方式

如果我们动态获取到这些信息,我们需要依靠 Class 对象。Class 类对象将一个类的方法、变量等信息告诉运行的程序。Java 提供了四种方式获取 Class 对象:

1. 知道具体类的情况下可以使用:

Class alunbarClass = TargetObject.class;

但是我们一般是不知道具体类的,基本都是通过遍历包下面的类来获取 Class 对象,通过此方式获取 Class 对象不会进行初始化

2. 通过 Class.forName()传入类的全路径获取:

Class alunbarClass1 = Class.forName("cn.javaguide.TargetObject");

3. 通过对象实例instance.getClass()获取:

TargetObject o = new TargetObject();

Class alunbarClass2 = o.getClass();

4.通过类加载器xxxClassLoader.loadClass()传入类路径获取:

ClassLoader.getSystemClassLoader().loadClass("cn.javaguide.TargetObject");

通过类加载器获取 Class 对象不会进行初始化,意味着不进行包括初始化等一系列步骤,静态代码块和静态对象不会得到执行

反射的一些基本操作

- 创建一个我们要使用反射操作的类

TargetObject。

package reflect;

public class TargetObject {

private String value;

public TargetObject() {

value = "JavaGuide";

}

public void publicMethod(String s) {

System.out.println("I love " + s);

}

private void privateMethod() {

System.out.println("value is " + value);

}

}

2.使用反射操作这个类的方法以及参数

public class mainPractice {

public static void main(String[] args) throws ClassNotFoundException, InstantiationException, IllegalAccessException, NoSuchMethodException, InvocationTargetException {

/**

* 获取 TargetObject 类的 Class 对象并且创建 TargetObject 类实例

*/

Class<?> targetClass = Class.forName("reflect.TargetObject");

TargetObject targetObject = (TargetObject) targetClass.newInstance();

/**

* 获取 TargetObject 类中定义的所有方法

*/

Method[] declaredMethods = targetClass.getDeclaredMethods();

for (Method method : declaredMethods) {

System.out.println("方法名字:"+method.getName());

System.out.println("返回值类型:"+method.getReturnType());

System.out.println("该方法的参数个数"+method.getParameterCount());

System.out.println("方法的参数的类型依次为:");

for (Class<?> parameterType : method.getParameterTypes()) {

System.out.println(parameterType.getName());

}

}

/**

* 获取指定方法publicMethod并调用,传入参数JavaGuide

*/

Method publicMethod = targetClass.getDeclaredMethod("publicMethod",String.class);

publicMethod.invoke(targetObject, "JavaGuide");

/**

* 调用 private 方法

*/

Method privateMethod = targetClass.getDeclaredMethod("privateMethod");

//为了调用private方法我们取消安全检查

privateMethod.setAccessible(true);

privateMethod.invoke(targetObject);

}

}

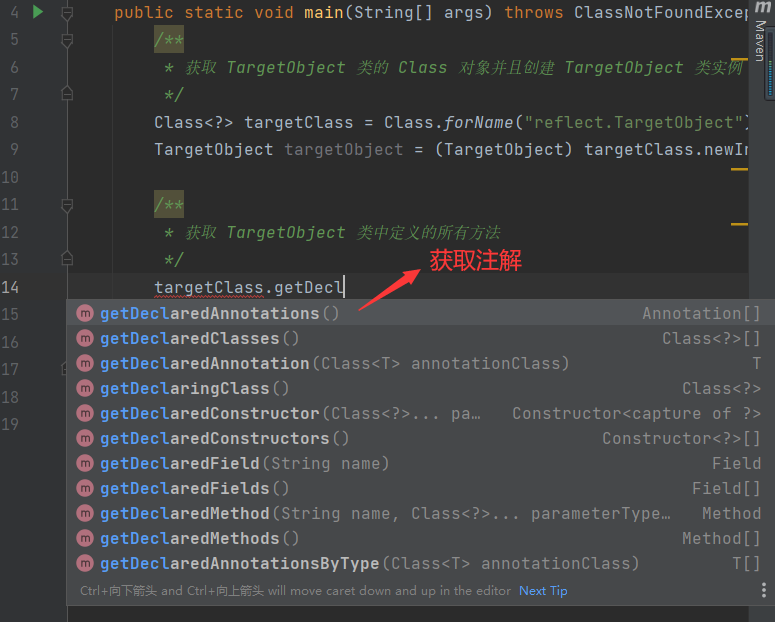

可以看到Class类的对象有很多get方法,可以获取类似于注解,方法,构造器之类的。

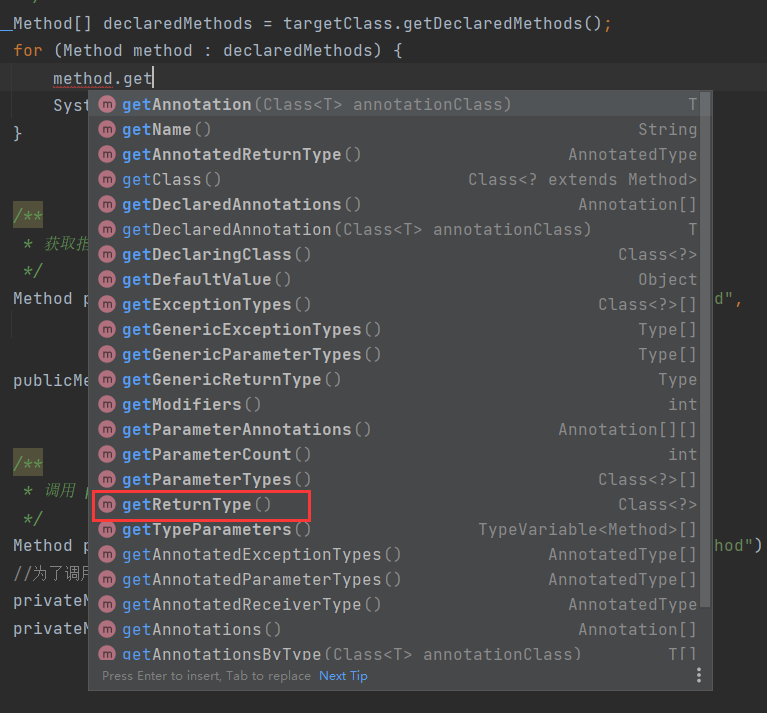

获得方法之后,还可以获得方法的返回值、参数等等...

输出为:可以看到当privateMethod没有参数时,参数类型输出就位空。

方法名字:publicMethod

返回值类型:void

该方法的参数个数1

方法的参数的类型依次为:

java.lang.String

方法名字:privateMethod

返回值类型:void

该方法的参数个数0

方法的参数的类型依次为:

I love JavaGuide

value is JavaGuide

Java Socket详解

Java 代理模式详解

1. 代理模式

代理模式是一种比较好理解的设计模式。简单来说就是 我们使用代理对象来代替对真实对象(real object)的访问,这样就可以在不修改原目标对象的前提下,提供额外的功能操作,扩展目标对象的功能。

代理模式的主要作用是扩展目标对象的功能,比如说在目标对象的某个方法执行前后你可以增加一些自定义的操作。

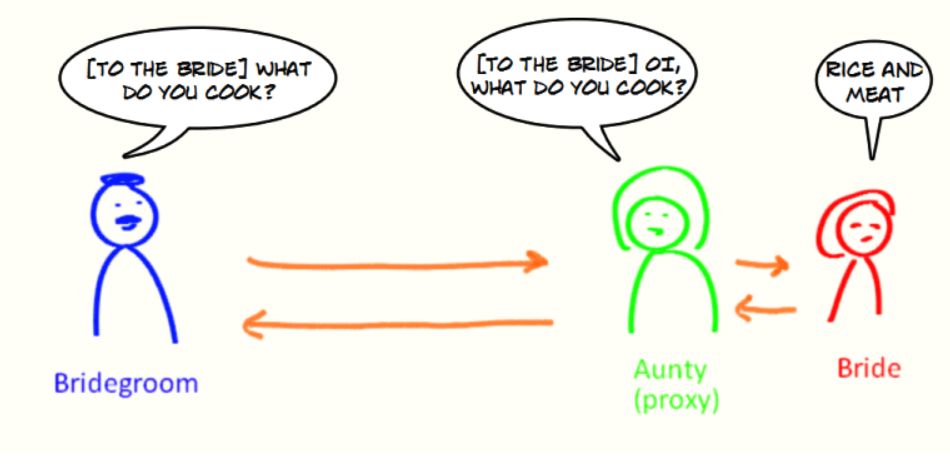

举个例子:新娘找来了自己的姨妈来代替自己处理新郎的提问,新娘收到的提问都是经过姨妈处理过滤之后的。姨妈在这里就可以看作是代理你的代理对象,代理的行为(方法)是接收和回复新郎的提问。

代理模式有静态代理和动态代理两种实现方式,我们 先来看一下静态代理模式的实现。

2. 静态代理

静态代理中,我们对目标对象的每个方法的增强都是手动完成的(*后面会具体演示代码*),非常不灵活(*比如接口一旦新增加方法,目标对象和代理对象都要进行修改*)且麻烦(*需要对每个目标类都单独写一个代理类*)。 实际应用场景非常非常少,日常开发几乎看不到使用静态代理的场景。

上面我们是从实现和应用角度来说的静态代理,从 JVM 层面来说, 静态代理在编译时就将接口、实现类、代理类这些都变成了一个个实际的 class 文件。

静态代理实现步骤:

- 定义一个接口及其实现类;

- 创建一个代理类同样实现这个接口

- 将目标对象注入进代理类,然后在代理类的对应方法调用目标类中的对应方法。这样的话,我们就可以通过代理类屏蔽对目标对象的访问,并且可以在目标方法执行前后做一些自己想做的事情。

下面通过代码展示!

1.定义发送短信的接口

public interface SmsService {

String send(String message);

}

2.实现发送短信的接口

public class SmsServiceImpl implements SmsService {

public String send(String message) {

System.out.println("send message:" + message);

return message;

}

}

3.创建代理类并同样实现发送短信的接口

public class SmsProxy implements SmsService {

private final SmsService smsService;

public SmsProxy(SmsService smsService) {

this.smsService = smsService;

}

@Override

public String send(String message) {

//调用方法之前,我们可以添加自己的操作

System.out.println("before method send()");

smsService.send(message);

//调用方法之后,我们同样可以添加自己的操作

System.out.println("after method send()");

return null;

}

}

4.实际使用

public class Main {

public static void main(String[] args) {

SmsService smsService = new SmsServiceImpl();

SmsProxy smsProxy = new SmsProxy(smsService);

smsProxy.send("java");

}

}

运行上述代码之后,控制台打印出:

before method send()

send message:java

after method send()

可以输出结果看出,我们已经增加了 SmsServiceImpl 的send()方法。因为本来的SmsServiceImpl 的send()方法就只输出send message:java,现在加上了两行分别是:before method send()和after method send(),这就代表着我们可以在调用方法之前做一些操作,调用之后也做一些操作。

3. 动态代理

相比于静态代理来说,动态代理更加灵活。我们不需要针对每个目标类都单独创建一个代理类,并且也不需要我们必须实现接口,我们可以直接代理实现类( CGLIB 动态代理机制)。

从 JVM 角度来说,动态代理是在运行时动态生成类字节码,并加载到 JVM 中的。

说到动态代理,Spring AOP、RPC 框架应该是两个不得不提的,它们的实现都依赖了动态代理。

动态代理在我们日常开发中使用的相对较少,但是在框架中的几乎是必用的一门技术。学会了动态代理之后,对于我们理解和学习各种框架的原理也非常有帮助。

就 Java 来说,动态代理的实现方式有很多种,比如 JDK 动态代理、CGLIB 动态代理等等。

3.1. JDK 动态代理机制

3.1.1. 介绍

在 Java 动态代理机制中 InvocationHandler 接口和 Proxy 类是核心。Proxy 类中使用频率最高的方法是:newProxyInstance() ,这个方法主要用来生成一个代理对象。

<?>代表任意java类型,只有在不关心数据的具体类型下才使用通配符表示

public static Object newProxyInstance(ClassLoader loader,Class<?>[] interfaces,InvocationHandler h)throws IllegalArgumentException

{

......

}

这个方法一共有 3 个参数:

- loader :类加载器,用于加载代理对象。

- interfaces : 被代理类实现的一些接口;

- h : 实现了

InvocationHandler接口的对象;

要实现动态代理的话,还必须需要实现InvocationHandler 来自定义处理逻辑。 当我们的动态代理对象调用一个方法时,这个方法的调用就会被转发到实现InvocationHandler 接口类的 invoke 方法来调用。

public interface InvocationHandler {

/**

* 当你使用代理对象调用方法的时候实际会调用到这个方法

*/

public Object invoke(Object proxy, Method method, Object[] args)

throws Throwable;

}

invoke() 方法有下面三个参数:

- proxy :动态生成的代理类

- method : 与代理类对象调用的方法相对应

- args : 当前 method 方法的参数

也就是说:你通过Proxy 类的 newProxyInstance() 创建的代理对象在调用方法的时候,实际会调用到实现InvocationHandler 接口的类的 invoke()方法。 你可以在 invoke() 方法中自定义处理逻辑,比如在方法执行前后做什么事情。

3.1.2. JDK 动态代理类使用步骤

- 定义一个接口及其实现类;

- 自定义

InvocationHandler并重写invoke方法,在invoke方法中我们会调用原生方法(被代理类的方法)并自定义一些处理逻辑; - 通过

Proxy.newProxyInstance(ClassLoader loader,Class<?>[] interfaces,InvocationHandler h)方法创建代理对象;

3.1.3. 代码示例

1.定义发送短信的接口

public interface SmsService {

String send(String message);

}

2.实现发送短信的接口

public class SmsServiceImpl implements SmsService {

@Override

public String send(String message) {

System.out.println("real Object sends message:" + message);

return message;

}

}

3.定义一个 JDK 动态代理类

import java.lang.reflect.InvocationHandler;

import java.lang.reflect.InvocationTargetException;

import java.lang.reflect.Method;

public class DebugInvocationHandler implements InvocationHandler {

/**

* 代理类中的真实对象

*/

private final Object target;

public DebugInvocationHandler(Object target) {

this.target = target;

}

@Override

public Object invoke(Object proxy, Method method, Object[] args) throws Throwable {

//调用方法之前,我们可以添加自己的操作

System.out.println("before method " + method.getName());

Object result = method.invoke(target, args);//method表示是哪个方法进行调用,target表示对哪个对象调用,args表示调用时传入的参数

//调用方法之后,我们同样可以添加自己的操作

System.out.println("after method " + method.getName());

return result;

}

}

invoke() 方法: 当我们的动态代理对象调用原生方法的时候,最终实际上调用到的是 invoke() 方法,然后 invoke() 方法代替我们去调用了被代理对象的原生方法。

4.获取代理对象的工厂类

public class JdkProxyFactory {

public static Object getProxy(Object target) {

return Proxy.newProxyInstance(

target.getClass().getClassLoader(), // 目标类的类加载

target.getClass().getInterfaces(), // 代理需要实现的接口,可指定多个,这里也是和CGLIB不同的地方,需要通过接口来

new DebugInvocationHandler(target) // 代理对象对应的自定义 InvocationHandler,

// 通过传入不同的实现了InvocationHandler的handler对象,可以实现对不同的代理对象进行不同的处理

);

}

}

getProxy() :主要通过Proxy.newProxyInstance()方法获取某个类的代理对象

5.实际使用

SmsService smsService = (SmsService) JdkProxyFactory.getProxy(new SmsServiceImpl());

smsService.send("java");

运行上述代码之后,控制台打印出:

before method send

real Object sends message:javajava

after method send

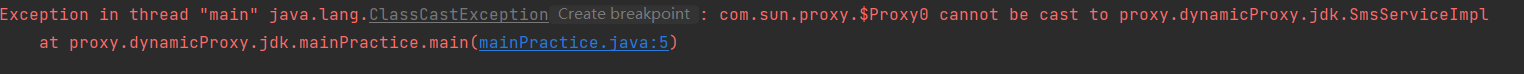

注意点:实际使用时,只能用接口来接受经过代理的类,比如下面这种写法就会报错,即用实现类来接受Object:

public static void main(String[] args) {

SmsServiceImpl smsService = (SmsServiceImpl) JdkProxyFactory.getProxy(new SmsServiceImpl());

smsService.send("javajava");

}

所以JDK的代理实现中Proxy.newProxyInstance( target.getClass().getClassLoader(),target.getClass().getInterfaces(), new DebugInvocationHandler(target))的getInterfaces就是关键,JDK动态代理只能增强接口里的方法,因为需要从接口中获得有哪些方法。

3.2CGLIB 动态代理机制

3.2.1. 介绍

JDK 动态代理有一个最致命的问题是其只能代理实现了接口的类。为了解决这个问题,我们可以用 CGLIB 动态代理机制来避免。

CGLIB(Code Generation Library)是一个基于ASM的字节码生成库,它允许我们在运行时对字节码进行修改和动态生成。CGLIB 通过继承方式实现代理。很多知名的开源框架都使用到了CGLIB, 例如 Spring 中的 AOP 模块中:如果目标对象实现了接口,则默认采用 JDK 动态代理,否则采用 CGLIB 动态代理。

在 CGLIB 动态代理机制中 MethodInterceptor 接口和 Enhancer 类是核心。

你需要自定义 MethodInterceptor 并重写 intercept 方法,intercept 用于拦截增强被代理类的方法。

public interface MethodInterceptor

extends Callback{

// 拦截被代理类中的方法

public Object intercept(Object obj, java.lang.reflect.Method method, Object[] args,MethodProxy proxy) throws Throwable;

}

- obj : 动态生成的代理对象

- method : 被拦截的方法(需要增强的方法)

- args : 方法入参

- proxy : 用于调用原始方法

你可以通过 Enhancer类来动态获取被代理类,当代理类调用方法的时候,实际调用的是 MethodInterceptor 中的 intercept 方法。

3.2.2. CGLIB 动态代理类使用步骤

- 定义一个类;

- 自定义

MethodInterceptor并重写intercept方法,intercept用于拦截增强被代理类的方法,和 JDK 动态代理中的invoke方法类似; - 通过

Enhancer类的create()创建代理类

3.2.3. 代码示例

不同于 JDK 动态代理不需要额外的依赖。CGLIB(Code Generation Library) 实际是属于一个开源项目,如果你要使用它的话,需要手动添加相关依赖。

<dependency>

<groupId>cglib</groupId>

<artifactId>cglib</artifactId>

<version>3.3.0</version>

</dependency>

1.实现一个使用阿里云发送短信的类

public class AliSmsService {

public String send(String message) {

System.out.println("REAL send message:" + message);

return message;

}

}

2.自定义 MethodInterceptor(方法拦截器)

import net.sf.cglib.proxy.MethodInterceptor;

import net.sf.cglib.proxy.MethodProxy;

import java.lang.reflect.Method;

public class DebugMethodInterceptor implements MethodInterceptor {

/**

* @param o 代理对象(增强的对象)

* @param method 被拦截的方法(需要增强的方法)

* @param args 方法入参

* @param methodProxy 用于调用原始方法

*/

@Override

public Object intercept(Object o, Method method, Object[] args, MethodProxy methodProxy) throws Throwable {

//调用方法之前,我们可以添加自己的操作

System.out.println("before method " + method.getName());

Object object = methodProxy.invokeSuper(o, args);

//调用方法之后,我们同样可以添加自己的操作

System.out.println("after method " + method.getName());

return object;

}

}

3.获取代理类

public class CglibProxyFactory {

public static Object getProxy(Class<?> clazz) {

Enhancer enhancer = new Enhancer();// 创建动态代理增强类

enhancer.setClassLoader(clazz.getClassLoader());// 设置类加载器

enhancer.setSuperclass(clazz);// 设置被代理类

enhancer.setCallback(new DebugMethodInterceptor());// 设置方法拦截器,可以自定义传入

return enhancer.create();// 创建代理类

}

}

4.实际使用

AliSmsService aliSmsService = (AliSmsService) CglibProxyFactory.getProxy(AliSmsService.class);

aliSmsService.send("javajava");

输出为:

before method send

REAL send message:javajava

after method send

如果想用在另一个类上,那么直接如法炮制即可:

public class OtherService {

public String callPhone(String phoneNumber){

System.out.println("正在拨打电话,号码为"+phoneNumber);

return phoneNumber;

}

}

接着用同样的方法动态代理OtherService类

OtherService otherService = (OtherService) CglibProxyFactory.getProxy(OtherService.class);

otherService.callPhone("12344");

输出为:

before method callPhone

正在拨打电话,号码为12344

after method callPhone

3.3. JDK 动态代理和 CGLIB 动态代理对比

- JDK 动态代理只能代理实现了接口的类或者直接代理接口,而 CGLIB 可以代理未实现任何接口的类。 另外, CGLIB 动态代理是通过生成一个被代理类的子类来拦截被代理类的方法调用,因此不能代理声明为 final 类型的类和方法。

- 就二者的效率来说,大部分情况都是 JDK 动态代理更优秀,随着 JDK 版本的升级,这个优势更加明显。

4. 静态代理和动态代理的对比

- 灵活性 :动态代理更加灵活,不需要必须实现接口,可以直接代理实现类,并且可以不需要针对每个目标类都创建一个代理类。另外,静态代理中,接口一旦新增加方法,目标对象和代理对象都要进行修改,这是非常麻烦的!

- JVM 层面 :静态代理在编译时就将接口、实现类、代理类这些都变成了一个个实际的 class 文件。而动态代理是在运行时动态生成类字节码,并加载到 JVM 中的。

5. 总结

这篇文章中主要介绍了代理模式的两种实现:静态代理以及动态代理。涵盖了静态代理和动态代理实战、静态代理和动态代理的区别、JDK 动态代理和 Cglib 动态代理区别等内容。

泛型和通配符

参考了Java 泛型中的通配符 - 雨点的名字 - 博客园 (cnblogs.com),感谢雨点的名字!转自公众号: 后端元宇宙

泛型

Java泛型是JDK5中引入的一个新特性,泛型提供了编译时类型安全检测机制,该机制允许程序员在编译时检测到非法的类型。泛型的本质是参数化类型,也就是说所操作的数据类型被指定为一个参数。

泛型擦除

Java的泛型基本上都是在编译器这个层次上实现的,在生成的字节码中是不包含泛型中的类型信息的,使用泛型的时候加上类型参数,在编译器编译的时候会去掉,这个过程成为类型擦除。看下面代码

public class GenericErase {

public static void main(String[] args) {

ArrayList<String> list1 = new ArrayList<>();

ArrayList<Integer> list2 = new ArrayList<>();

System.out.println(list1.getClass() == list2.getClass());//true

}

}

可以看到ArrayList<Integer>和ArrayList<String>的原始类型是相同,在编译成字节码文件后都会变成List,JVM看到的只有List,看不到泛型信息,这就是泛型的类型擦除。所以我们可以利用反射机制,跳过泛型检测添加不同类型的元素。

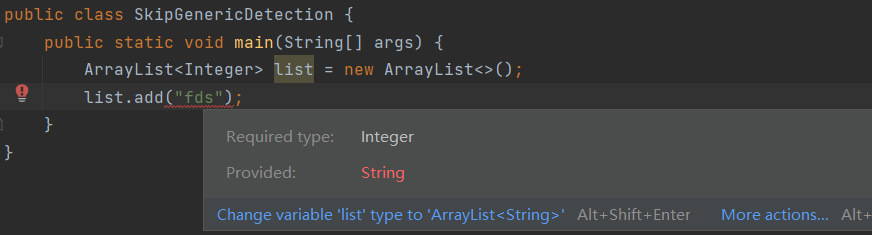

如果我们在运行之前给指定了泛型(Integer)的list添加String类型的元素,不仅IDE会报错,而且编译器检查代码的时候也会报错。

跳过泛型检测

在看下面这段代码,使用反射机制跳过泛型检测:

public class SkipGenericDetection {

public static void main(String[] args) throws NoSuchMethodException, InvocationTargetException, IllegalAccessException {

ArrayList<Integer> list = new ArrayList<>();

list.add(1);

list.getClass().getMethod("add",Object.class).invoke(list,"haha");

System.out.println(list.get(0));

System.out.println(list.get(1));

}

}

输出:

1

haha

可以看到通过反射进行add操作,ArrayList<Integer>竟然可以存储字符串,这是因为在反射就是在运行期调用的add方法,在运行期泛型信息已经被擦除。

既然存在类型擦除,那么Java是如何保证在ArrayList<Integer>添加字符串会报错呢?Java编译器是通过先检查代码中泛型的类型,然后再进行类型擦除,再进行编译。

通配符

- ? 用于在泛型的使用,即为通配符。

- 通配符是用来解决泛型无法协变的问题的,协变指的就是如果 Student 是 Person 的子类,那么List 也应该是 List 的子类。但是泛型是不支持。

我们在泛型中使用通配符经常看到T、F、U、E,K,V其实这些并没有啥区别,我们可以选 A-Z 之间的任何一个字母都可以,并不会影响程序的正常运行。

只不过大家心照不宣的在命名上有些约定:

- T (Type) 具体的Java类

- E (Element)在集合中使用,因为集合中存放的是元素

- K V (key value) 分别代表java键值中的Key Value

- N (Number)数值类型

- ? 表示不确定的 Java 类型

上界通配符 < ? extends E>

语法:<? extends E>

举例:<? extends Animal> 可以传入的实参类型是Animal或者Animal的子类。主要用于接收的时候用。

两大原则

add:除了null之外,不允许加入任何元素!get:可以获取元素,可以通过E或者Object接受元素!因为不管存入什么数据类型都是E的子类型

代码:

public static void method(List<? extends Animal> lists){

Animal animal = lists.get(0);//正确 因为传入的一定是Animal的子类

Object object = lists.get(1);//正确 当然也可以用Object类接收,因为Object是顶层父类

? t = lists.get(2);//错误 不能用?接收

lists.add(new Animal());// 错误

lists.add(new Dog());//错误

lists.add(object);//错误

lists.add(null);//正确 除了null之外,不允许加入任何元素!

}

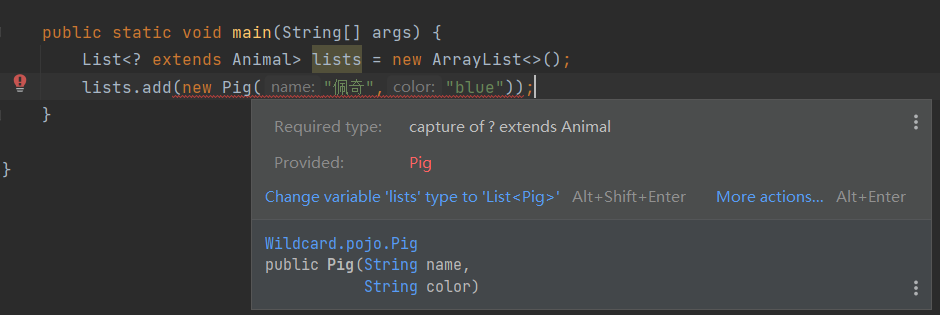

add加入子类对象也会报错:

但是上界通配符作为接受时的参数时,会很有用,只要list中的泛型是Animal的子类的时候,就可以作为参数传入。

public class mainPractice {

public static void getList(List<? extends Animal> lists){

Animal animal = lists.get(0);

System.out.println(animal.getName());

}

public static void main(String[] args) {

List<Pig> lists = new ArrayList<>();

lists.add(new Pig("佩奇","blue"));

mainPractice.getList(lists);//打印出 佩奇

List<Dog> list2 = new ArrayList<>();

list2.add(new Dog("汪汪队","red"));

mainPractice.getList(list2);//打印出 汪汪队

}

}

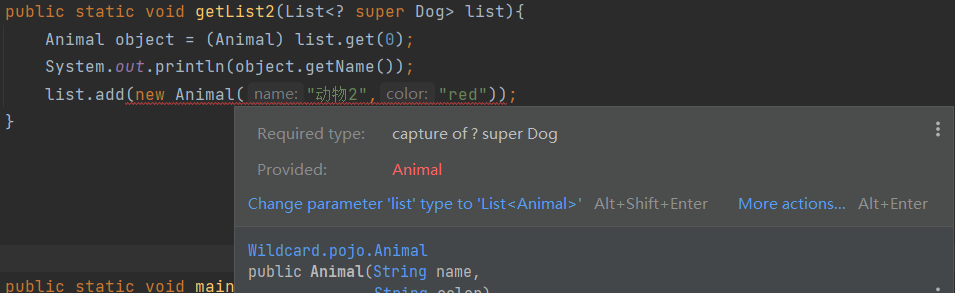

下界通配符 < ? super E>

语法: <? super E>

举例 :<? super Dog> 可以传入的实参的类型是Dog或者Dog的父类类型

两大原则

-

add:允许添加E和E的子类元素! -

get:可以获取元素,但传入的类型可能是E到Object之间的任何类型,也就无法确定接收到数据类型,所以返回只能使用Object引用来接受!如果需要自己的类型则需要强制类型转换。

add的时候只能允许添加E和E的子类元素,是因为,万一泛型是E的某个父类A,E的子类也是A的子类,所以添加E和E的子类肯定不会报错。但是如果泛型就是E,这个时候E的父类A的其他子类B不一定是E的子类(肯定不是),所以会报错。比如下面的,虽然泛型是Dog的父类,但是传入Animal会超出Dog这个下界,如果这个Animal是一个Pig,而泛型是Dog,那么就会报错了。

这样添加时肯定没错的,Hashiqi是Dog的子类,添加Dog和Hashiqi肯定没问题。

public static void main(String[] args) {

List<Animal> list = new ArrayList<>();//Animal是Dog的父类类型

list.add(new Pig("佩奇","blue"));

mainPractice.getList2(list);

}

什么是PECS原则?

PECS原则:生产者(Producer)使用extends,消费者(Consumer)使用super。

原则

-

如果想要获取,而不需要写值则使用" ? extends T "作为数据结构泛型。

-

如果想要写值,而不需要取值则使用" ? super T "作为数据结构泛型。

实例程序:

public class PESC {

ArrayList<? extends Animal> exdentAnimal;

ArrayList<? super Animal> superAnimal;

Dog dog = new Dog("小黑", "黑色");

private void test() {

Animal a1 = exdentAnimal.get(0);//正确,因为exdentAnimal里面的元素最大不会超过Animal

Animal a2 = superAnimal.get(0);//错误,需要用强制类型转换。

exdentAnimal.add(dog);//错误

superAnimal.add(dog);//正确

}

}

实例程序二:

Collections集合工具类有个copy方法,我们可以看下源码,就是PECS原则。因为只需要从源list中读元素,所以用上界通配符,只需要对dest写元素,所以用下界通配符。

public static <T> void copy(List<? super T> dest, List<? extends T> src) {

int srcSize = src.size();

if (srcSize > dest.size())

throw new IndexOutOfBoundsException("Source does not fit in dest");

if (srcSize < COPY_THRESHOLD ||

(src instanceof RandomAccess && dest instanceof RandomAccess)) {

for (int i=0; i<srcSize; i++)

dest.set(i, src.get(i));

} else {

ListIterator<? super T> di=dest.listIterator();

ListIterator<? extends T> si=src.listIterator();

for (int i=0; i<srcSize; i++) {

di.next();

di.set(si.next());

}

}

}

我们按照这个源码简单改造下

public class CollectionsTest {

/**

* 将源集合数据拷贝到目标集合

*

* @param dest 目标集合

* @param src 源集合

* @return 目标集合

*/

public static <T> void copy(List<? super T> dest, List<? extends T> src) {

int srcSize = src.size();

for (int i = 0; i < srcSize; i++) {

dest.add(src.get(i));

}

}

public static void main(String[] args) {

ArrayList<Animal> animals = new ArrayList();

ArrayList<Pig> pigs = new ArrayList();

pigs.add(new Pig("黑猪", "黑色"));

pigs.add(new Pig("花猪", "花色"));

CollectionsTest.copy(animals, pigs);

System.out.println("dest = " + animals);

}

}

输出结果:

dest = [Animal(name=黑猪, color=黑色), Animal(name=花猪, color=花色)]

通过一个案例来理解 ?和 T 和 Object 的区别

1、实体转换

我们在实际开发中,经常进行实体转换,比如SO转DTO,DTO转DO等等,所以需要一个转换工具类。

如下示例

/**

* 实体转换工具类

* TODO 说明该工具类不能直接用于生产,因为为了代码看去清爽点,我少了一些必要检验,所以如果直接拿来使用可以会在某些场景下会报错。

*/

public class EntityUtil {

/**

* 集合实体转换

* @param target 目标实体类

* @param list 源集合

* @return 装有目标实体的集合

*/

public static <T> List<T> changeEntityList(Class<T> target, List<?> list) throws Exception {

if (list == null || list.size() == 0) {

return null;

}

List<T> resultList = new ArrayList<T>();

for (Object obj : list) {//用Object接收

resultList.add(changeEntityNew(target, obj));

}

return resultList;

}

/**

* 实体转换

* @param target 目标实体class对象

* @param baseTO 源实体

* @return 目标实体

*/

public static <T> T changeEntity(Class<T> target, Object baseTO) throws Exception{

T obj = target.newInstance();

if (baseTO == null) {

return null;

}

BeanUtils.copyProperties(baseTO, obj);

return obj;

}

}

使用工具类示例

private void changeTest() throws Exception {

ArrayList<Pig> pigs = new ArrayList();

pigs.add(new Pig("黑猪", "黑色"));

pigs.add(new Pig("花猪", "花色"));

//实体转换

List<Animal> animals = EntityUtil.changeEntityList(Animal.class, pigs);

}

这是一个很好的例子,从这个例子中我们可以去理解 ?和 T 和 Object的使用场景。

我们先以集合转换来说

public static <T> List<T> changeEntityListNew(Class<T> target, List<?> list);

首先其实我们并不关心传进来的集合内是什么对象,我们只关心我们需要转换的集合内是什么对象,所以我们传进来的集合就可以用List<?>表示任何对象的集合都可以。返回呢,这里指定的是ClassList<T>集合。

再以实体转换方法为例

public static <T> T changeEntityNew(Class<T> target, Object baseTO)

同样的,我们并不关心源对象是什么,我们只关心需要转换的对象,只需关心需要转换的对象为T。

那为什么这里用Object上面用?呢,其实上面也可以改成List<Object> list,效果是一样的,上面List<?> list在遍历的时候最终不就是用Object接收的吗?

?和Object的区别

?类型不确定和Object作用差不多,好多场景下可以通用,但?可以缩小泛型的范围,如:List<? extends Animal>,指定了范围只能是Animal的子类,但是用List<Object>,没法做到缩小范围。

方法前的泛型是啥意思?

参考(111条消息) Java的方法前面有一个<T>是什么?_soralink的博客-CSDN博客,感谢soralink!

我们在看java源码的时候会发现有的方法前面会用。我管这个方法叫做范型方法,英文是Generic Methods。

代码样例:

<R> Stream<R> map(Function<? super T, ? extends R> mapper);

这个抽象方法在返回类型的前面有一个。其实这个声明类似于泛型声明,但是这个方法前面的声名只能作用在方法中。

这个范型可以用于静态和非静态方法但是用<>包裹的泛型必须放在返回类型的前面。在<>里面我们可以放多个范型。

代码举例:

public class Util {

public static <K, V> boolean compare(Pair<K, V> p1, Pair<K, V> p2) {

return p1.getKey().equals(p2.getKey()) &&

p1.getValue().equals(p2.getValue());

}

}

public class Pair<K, V> {

private K key;

private V value;

public Pair(K key, V value) {

this.key = key;

this.value = value;

}

public void setKey(K key) { this.key = key; }

public void setValue(V value) { this.value = value; }

public K getKey() { return key; }

public V getValue() { return value; }

}

这段代码是从官网抄过来的。可以看到在静态方法compare前面放了一个<K, V>。因为我们提前不知道放进来的Pair里面放的是什么类型的,但是我们希望任何类型的Pair都可以放进来。所以我们就用了这种写法。 之后看一下怎么调用这个方法

//完整调用方法

Pair<Integer, String> p1 = new Pair<>(1, "apple");

Pair<Integer, String> p2 = new Pair<>(2, "pear");

boolean same = Util.<Integer, String>compare(p1, p2);

//类型推断调用

Pair<Integer, String> p1 = new Pair<>(1, "apple");

Pair<Integer, String> p2 = new Pair<>(2, "pear");

boolean same = Util.compare(p1, p2);

其实在调用的时候我们可以指定要传入的类型就像第一种调用用法。如果我们省略的话,编译器会推断出什么类型是要被传入的。

总结

- 只用于读功能时,泛型结构使用<? extends T>

- 只用于写功能时,泛型结构使用<? super T>

- 如果既用于写,又用于读操作,那么直接使用

- 如果操作与泛型类型无关,那么使用<?>

Java SPI 机制详解

本文来自 Kingshion 投稿。欢迎更多朋友参与到 JavaGuide 的维护工作,这是一件非常有意义的事情。详细信息请看:JavaGuide 贡献指南 。

在面向对象的设计原则中,一般推荐模块之间基于接口编程,通常情况下调用方模块是不会感知到被调用方模块的内部具体实现。一旦代码里面涉及具体实现类,就违反了开闭原则。如果需要替换一种实现,就需要修改代码。

为了实现在模块装配的时候不用在程序里面动态指明,这就需要一种服务发现机制。Java SPI 就是提供了这样一个机制:为某个接口寻找服务实现的机制。这有点类似 IoC 的思想,将装配的控制权移交到了程序之外。

SPI 介绍

何谓 SPI?

SPI 即 Service Provider Interface ,字面意思就是:“服务提供者的接口”,我的理解是:专门提供给服务提供者或者扩展框架功能的开发者去使用的一个接口。

SPI 将服务接口和具体的服务实现分离开来,将服务调用方和服务实现者解耦,能够提升程序的扩展性、可维护性。修改或者替换服务实现并不需要修改调用方。很多框架都使用了 Java 的 SPI 机制,比如:Spring 框架、数据库加载驱动、日志接口、以及 Dubbo 的扩展实现等等。

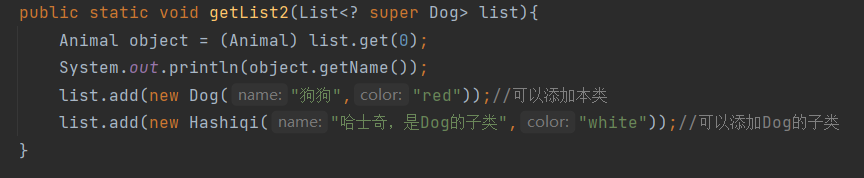

SPI 和 API 有什么区别?

那 SPI 和 API 有啥区别?

说到 SPI 就不得不说一下 API 了,从广义上来说它们都属于接口,而且很容易混淆。下面先用一张图说明一下:

一般模块之间都是通过通过接口进行通讯,那我们在服务调用方和服务实现方(也称服务提供者)之间引入一个“接口”。

当实现方提供了接口和实现,我们可以通过调用实现方的接口从而拥有实现方给我们提供的能力,这就是 API ,这种接口和实现都是放在实现方的。

当接口存在于调用方这边时,就是 SPI ,由接口调用方确定接口规则,然后由不同的厂商去根据这个规则对这个接口进行实现,从而提供服务。

举个通俗易懂的例子:公司 H 是一家科技公司,新设计了一款芯片,然后现在需要量产了,而市面上有好几家芯片制造业公司,这个时候,只要 H 公司指定好了这芯片生产的标准(定义好了接口标准),那么这些合作的芯片公司(服务提供者)就按照标准交付自家特色的芯片(提供不同方案的实现,但是给出来的结果是一样的)。

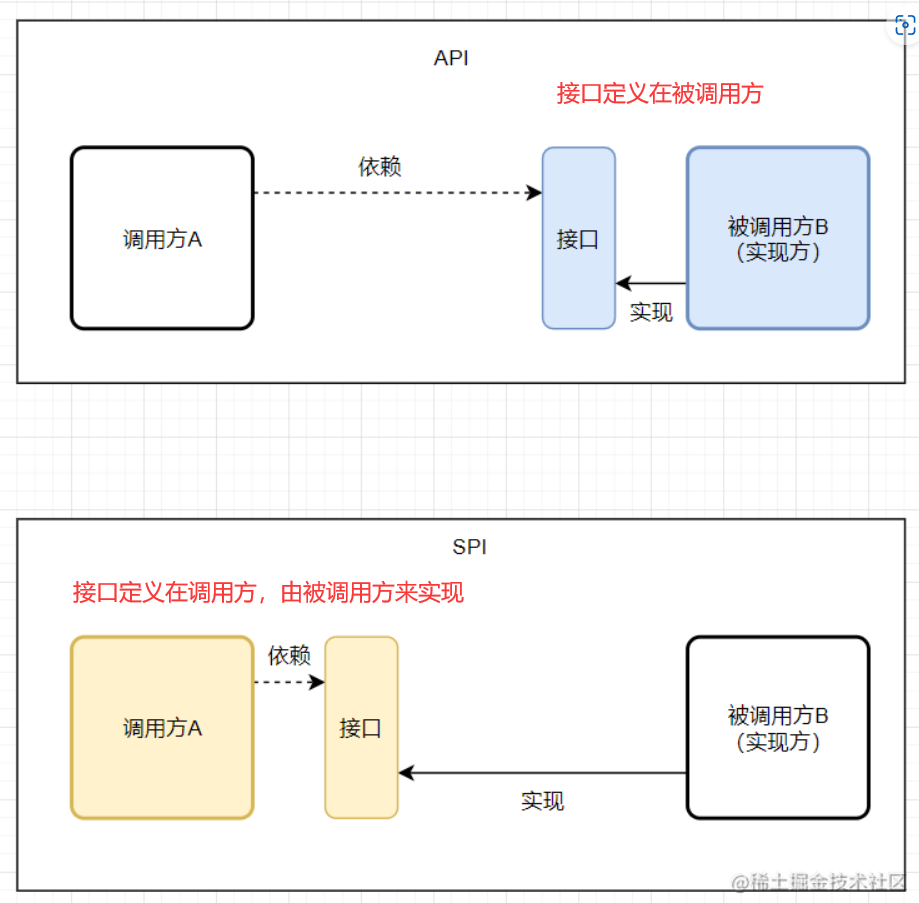

实战演示

Spring 框架提供的日志服务 SLF4J 其实只是一个日志门面(接口),但是 SLF4J 的具体实现可以有几种,比如:Logback、Log4j、Log4j2 等等,而且还可以切换,在切换日志具体实现的时候我们是不需要更改项目代码的,只需要在 Maven 依赖里面修改一些 pom 依赖就好了。

这就是依赖 SPI 机制实现的,那我们接下来就实现一个简易版本的日志框架。

Service Provider Interface

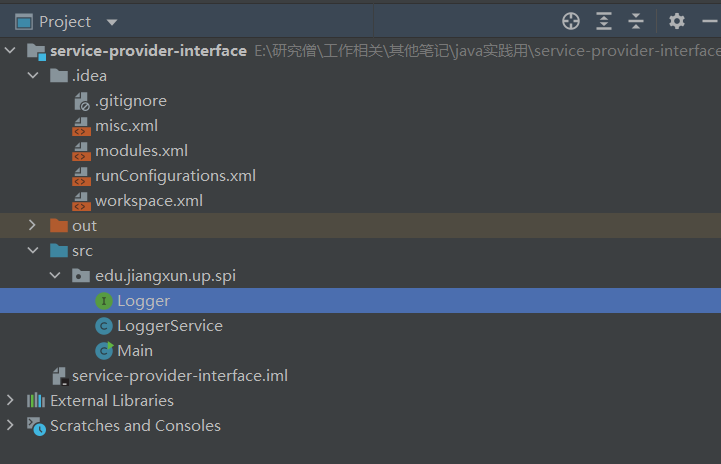

新建一个 Java 项目 service-provider-interface 目录结构如下:(注意直接新建 Java 项目就好了,不用新建 Maven 项目,Maven 项目会涉及到一些编译配置,如果有私服的话,直接 deploy 会比较方便,但是没有的话,在过程中可能会遇到一些奇怪的问题。)

项目目录结构:

新建 Logger 接口,这个就是 SPI , 服务提供者接口,后面的服务提供者就要针对这个接口进行实现。

package edu.jiangxuan.up.spi;

/**

* 这个就是 SPI , 服务提供者接口,后面的服务提供者就要针对这个接口进行实现。

*/

public interface Logger {

void info(String msg);

void debug(String msg);

}

接下来就是 LoggerService 类,这个主要是为服务使用者(调用方)提供特定功能的。这个类也是实现 Java SPI 机制的关键所在,如果存在疑惑的话可以先往后面继续看。

package edu.jiangxuan.up.spi;

import java.util.ArrayList;

import java.util.List;

import java.util.ServiceLoader;

/**

* 这个主要是为服务使用者(调用方)提供特定功能的。这个类也是实现 Java SPI 机制的关键所在.

*/

public class LoggerService {

private static final LoggerService SERVICE = new LoggerService();

private final Logger logger;

private final List<Logger> loggerList;

private LoggerService() {

ServiceLoader<Logger> loader = ServiceLoader.load(Logger.class);

List<Logger> list = new ArrayList<>();

for (Logger log : loader) {

list.add(log);

}

// LoggerList 是所有 ServiceProvider

loggerList = list;

if (!list.isEmpty()) {

logger = list.get(0);// Logger 只取一个

} else {

logger = null;

}

}

public static LoggerService getService() {

return SERVICE;

}

public void info(String msg) {

if (logger == null) {

System.out.println("info 中没有发现 Logger 服务提供者");

} else {

logger.info(msg);//只用第一个实现类的info方法

}

}

public void debug(String msg) {

if (loggerList.isEmpty()) {

System.out.println("debug 中没有发现 Logger 服务提供者");

}

loggerList.forEach(log -> log.debug(msg));//会遍历所有的实现类的debug方法

}

}

新建 Main 类(服务使用者,调用方),启动程序查看结果。

package edu.jiangxuan.up.spi;

public class Main {

public static void main(String[] args) {

LoggerService service = LoggerService.getService();

service.info("Hello SPI");

service.debug("Hello SPI");

}

}

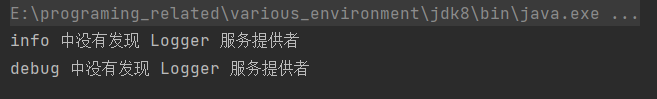

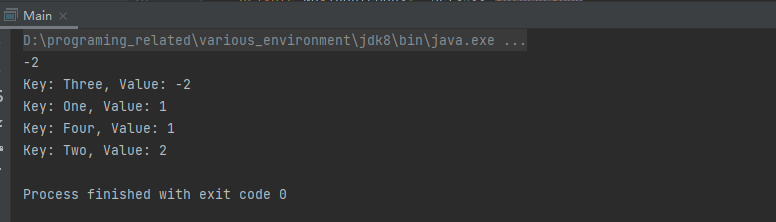

程序结果:

此时我们只是空有接口,并没有为 Logger 接口提供任何的实现,所以输出结果中没有按照预期打印相应的结果。

接着,你可以使用命令或者直接使用 IDEA 将整个程序直接打包成 jar 包。IDEA打包的步骤可以参考:(111条消息) idea中java程序打jar包的两种方式(超详细)_sunny潘先生的博客-CSDN博客_idea打jar包方式

Service Provider

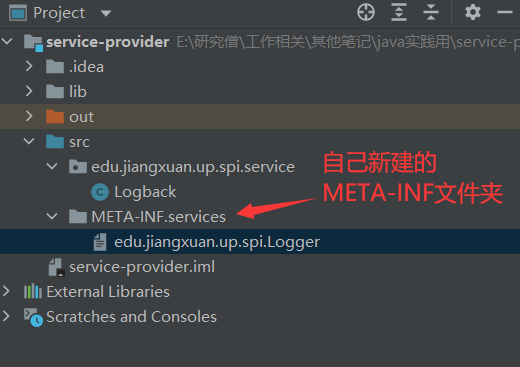

接下来新建一个项目用来实现 Logger 接口。新建项目 service-provider 目录结构如下:

新建 Logback 类.

package edu.jiangxuan.up.spi.service;

import edu.jiangxuan.up.spi.Logger;

public class Logback implements Logger {

@Override

public void info(String s) {System.out.println("Logback info 打印日志:" + s);}

@Override

public void debug(String s) {System.out.println("Logback debug 打印日志:" + s);}

}

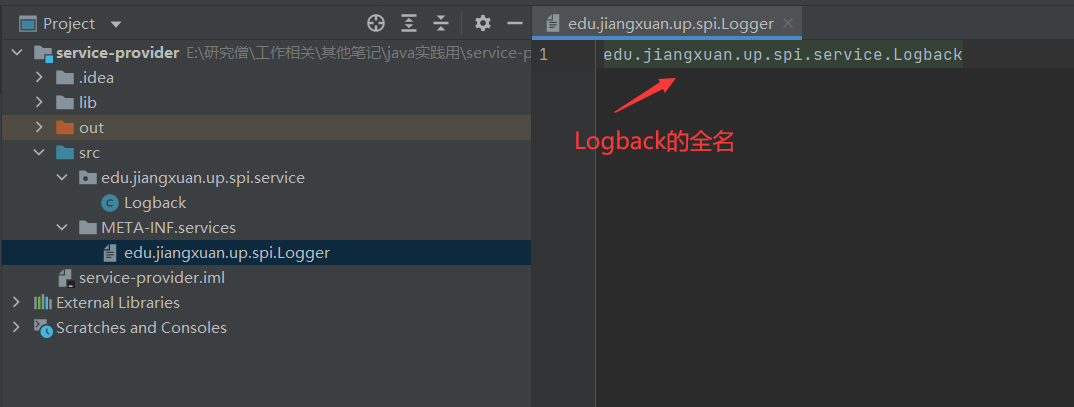

实现 Logger 接口,在 src 目录下新建 META-INF/services 文件夹,然后新建文件 edu.jiangxuan.up.spi.Logger (SPI 的全类名),文件里面的内容是:edu.jiangxuan.up.spi.service.Logback (Logback 的全类名,即 SPI 的实现类的包名 + 类名)。这是 JDK SPI 机制 ServiceLoader 约定好的标准。

这里先大概解释一下:Java 中的 SPI 机制就是在每次类加载的时候会先去找到 class 相对目录下的 META-INF 文件夹下的 services 文件夹下的文件,将这个文件夹下面的所有文件先加载到内存中,然后根据这些文件的文件名和里面的文件内容找到相应接口的具体实现类,找到实现类后就可以通过反射去生成对应的对象,保存在一个 list 列表里面,所以可以通过迭代或者遍历的方式拿到对应的实例对象,生成不同的实现。

META-INF文件夹用来干嘛的?

如果META-INF文件夹存在的话,是用来存储包和扩展的配置数据,包含安全,版本,扩展和服务。META-INF下支持四种类型,会被java自动识别并解析,用于配置应用,扩展,类加载器,服务。

1.MANIFEST.MF。MANIFEST文件用来定义扩展和包相关的数据,

2.INDEX.LIST。如果使用了jar工具的 "-i"选项,这个文件就会自动生成.文件包含了路径信息和应用或扩展的包定义.它是部分jar索引的实现方式,可用来提高类加载器的加载速度

3.x.SF。jar包的签名文件,包含清单信息,SF表示signature file, "x" 是文件名

4.x.DSA。. DSA是一种非对称的数字签名算法.可简单理解为"私钥加密生成数字签名,公钥验证数据及签名", x.DSA是"x.SF"文件关联的同名的"签名块文件",里面存着x.SF的数字签名. SF签名文件和DSA签名块文件可用"jarsigner"命令生成.其实还支持RSA算法,对应的是.RSA的 后缀名

5.services/ 目录文件,存放 服务提供者 的配置文件

所以会提出一些规范要求:文件名一定要是接口的全类名,然后里面的内容一定要是实现类的全类名,实现类可以有多个,直接换行就好了,多个实现类的时候,会一个一个的迭代加载。

接下来同样将 service-provider 项目打包成 jar 包,这个 jar 包就是服务提供方的实现。通常我们导入 maven 的 pom 依赖就有点类似这种,只不过我们现在没有将这个 jar 包发布到 maven 公共仓库中,所以在需要使用的地方只能手动的添加到项目中。

效果展示

为了更直观的展示效果,我这里再新建一个专门用来测试的工程项目:java-spi-test

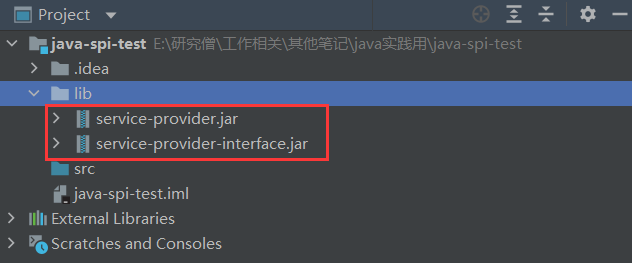

然后先导入 Logger 的接口 jar 包,再导入具体的实现类的 jar 包。

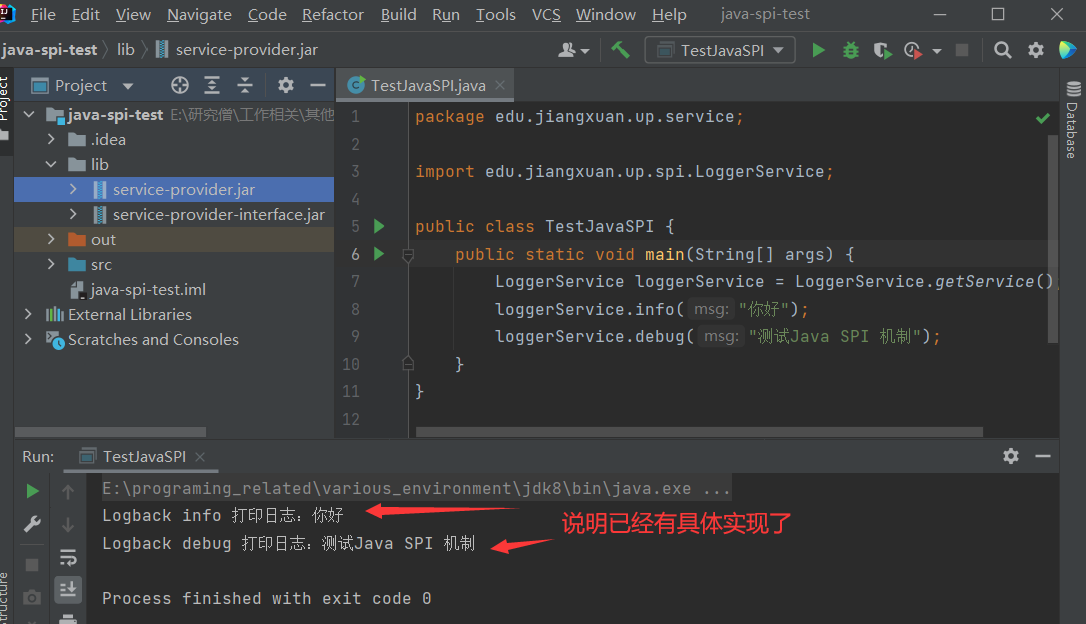

新建 Main 方法测试:

package edu.jiangxuan.up.service;

import edu.jiangxuan.up.spi.LoggerService;

public class TestJavaSPI {

public static void main(String[] args) {

LoggerService loggerService = LoggerService.getService();

loggerService.info("你好");

loggerService.debug("测试Java SPI 机制");

}

}

运行结果如下:

Logback info 打印日志:你好 Logback debug 打印日志:测试 Java SPI 机制

说明导入 jar 包中的实现类生效了。如果我们不导入具体的实现类的 jar 包,那么此时程序运行的结果就会是:

info 中没有发现 Logger 服务提供者 debug 中没有发现 Logger 服务提供者

通过使用 SPI 机制,可以看出服务(LoggerService)和 服务提供者两者之间的耦合度非常低,如果说我们想要换一种实现,那么其实只需要修改 service-provider 项目中针对 Logger 接口的具体实现就可以了,只需要换一个 jar 包即可,也可以有在一个项目里面有多个实现,这不就是 SLF4J 原理吗?

如果某一天需求变更了,此时需要将日志输出到消息队列,或者做一些别的操作,这个时候完全不需要更改 Logback 的实现,只需要新增一个服务实现(service-provider)可以通过在本项目里面新增实现也可以从外部引入新的服务实现 jar 包。我们可以在服务(LoggerService)中选择一个具体的 服务实现(service-provider) 来完成我们需要的操作。

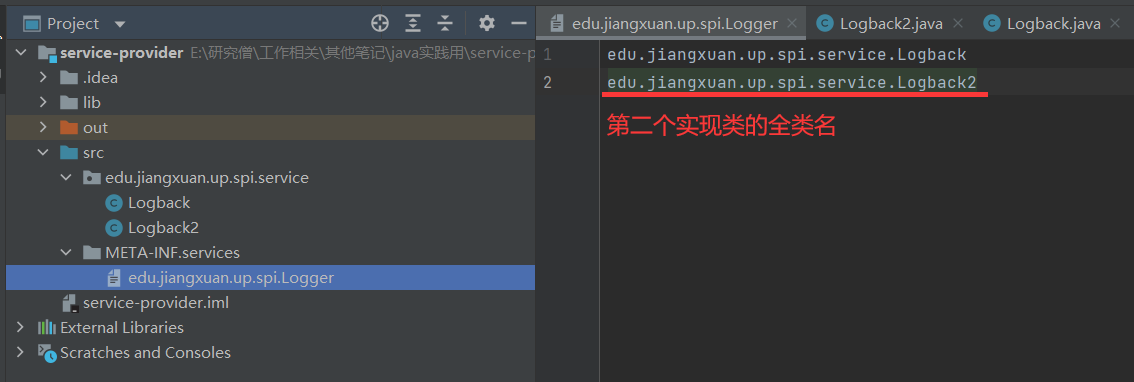

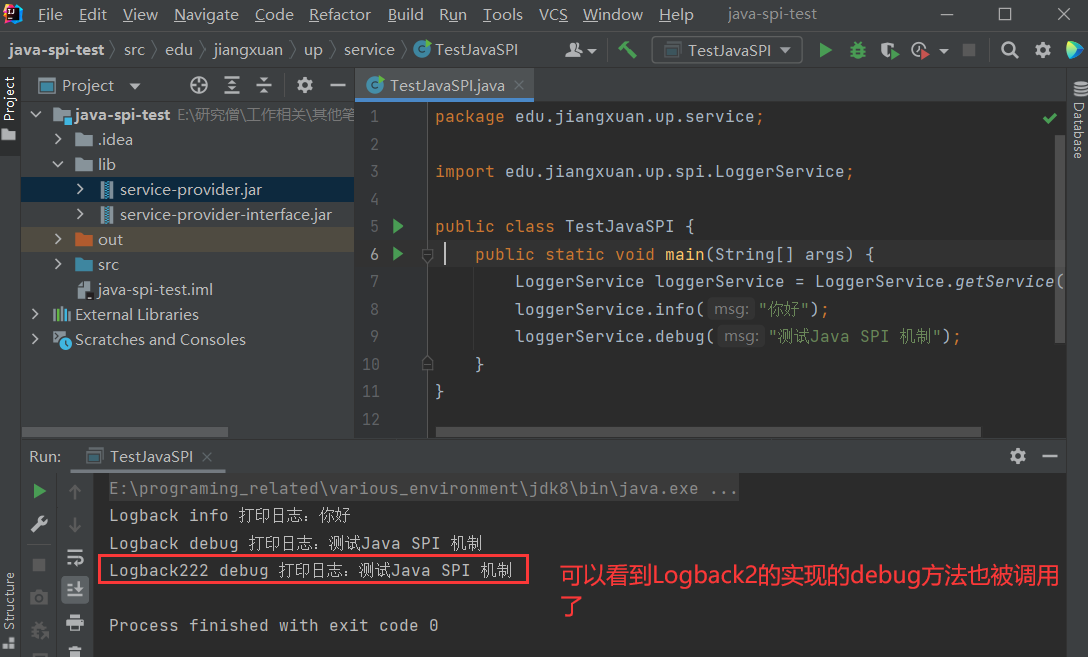

假如我有多个实现类(比如多个厂商实现了这个接口),那么我的debug方法会遍历所有的实现类的debug方法,但是info只取第一个。比如service-provider中又有一个实现了Logger接口的Logback2。

package edu.jiangxuan.up.spi.service;

import edu.jiangxuan.up.spi.Logger;

public class Logback2 implements Logger {

@Override

public void info(String s) {System.out.println("Logback222 info 打印日志:" + s);}

@Override

public void debug(String s) {System.out.println("Logback222 debug 打印日志:" + s);}

}

并且把他的全类名配置进去

打成jar包后再运行java-spi-test,得到如下结果:

那么接下来我们具体来说说 Java SPI 工作的重点原理—— ServiceLoader 。

ServiceLoader

ServiceLoader 具体实现

想要使用 Java 的 SPI 机制是需要依赖 ServiceLoader 来实现的,那么我们接下来看看 ServiceLoader 具体是怎么做的:

ServiceLoader 是 JDK 提供的一个工具类, 位于package java.util;包下。

A facility to load implementations of a service.

这是 JDK 官方给的注释:一种加载服务实现的工具。

再往下看,我们发现这个类是一个 final 类型的,所以是不可被继承修改,同时它实现了 Iterable 接口。之所以实现了迭代器,是为了方便后续我们能够通过迭代的方式得到对应的服务实现。

public final class ServiceLoader<S> implements Iterable<S>{ xxx...}

可以看到一个熟悉的常量定义:private static final String PREFIX = "META-INF/services/";

下面是 load 方法:可以发现 load 方法支持两种重载后的入参;

public static <S> ServiceLoader<S> load(Class<S> service) {

ClassLoader cl = Thread.currentThread().getContextClassLoader();

return ServiceLoader.load(service, cl);

}

public static <S> ServiceLoader<S> load(Class<S> service,ClassLoader loader) {

return new ServiceLoader<>(service, loader);

}

private ServiceLoader(Class<S> svc, ClassLoader cl) {

service = Objects.requireNonNull(svc, "Service interface cannot be null");

loader = (cl == null) ? ClassLoader.getSystemClassLoader() : cl;

acc = (System.getSecurityManager() != null) ? AccessController.getContext() : null;

reload();

}

public void reload() {

providers.clear();

lookupIterator = new LazyIterator(service, loader);

}

根据代码的调用顺序,在 reload() 方法中是通过一个内部类 LazyIterator 实现的。先继续往下面看。

ServiceLoader 实现了 Iterable 接口的方法后,具有了迭代的能力,在这个 iterator 方法被调用时,首先会在 ServiceLoader 的 Provider 缓存中进行查找,如果缓存中没有命中那么则在 LazyIterator 中进行查找。

public Iterator<S> iterator() {

return new Iterator<S>() {

Iterator<Map.Entry<String, S>> knownProviders= providers.entrySet().iterator();

public boolean hasNext() {

if (knownProviders.hasNext())

return true;

return lookupIterator.hasNext(); // 调用 LazyIterator

}

public S next() {

if (knownProviders.hasNext())

return knownProviders.next().getValue();

return lookupIterator.next(); // 调用 LazyIterator

}

public void remove() {throw new UnsupportedOperationException();}

};

}

在调用 LazyIterator 时,具体实现如下:

public boolean hasNext() {

if (acc == null) {

return hasNextService();

} else {

PrivilegedAction<Boolean> action = new PrivilegedAction<Boolean>() {

public Boolean run() {

return hasNextService();

}

};

return AccessController.doPrivileged(action, acc);

}

}

private boolean hasNextService() {

if (nextName != null) {

return true;

}

if (configs == null) {

try {

//通过PREFIX(META-INF/services/)和类名 获取对应的配置文件,得到具体的实现类

String fullName = PREFIX + service.getName();

if (loader == null)

configs = ClassLoader.getSystemResources(fullName);

else

configs = loader.getResources(fullName);

} catch (IOException x) {

fail(service, "Error locating configuration files", x);

}

}

while ((pending == null) || !pending.hasNext()) {

if (!configs.hasMoreElements()) {

return false;

}

pending = parse(service, configs.nextElement());

}

nextName = pending.next();

return true;

}

public S next() {

if (acc == null) {

return nextService();

} else {

PrivilegedAction<S> action = new PrivilegedAction<S>() {

public S run() {

return nextService();

}

};

return AccessController.doPrivileged(action, acc);

}

}

private S nextService() {

if (!hasNextService())

throw new NoSuchElementException();

String cn = nextName;

nextName = null;

Class<?> c = null;

try {

c = Class.forName(cn, false, loader);

} catch (ClassNotFoundException x) {

fail(service,"Provider " + cn + " not found");

}

if (!service.isAssignableFrom(c)) {

fail(service,"Provider " + cn + " not a subtype");

}

try {

S p = service.cast(c.newInstance());

providers.put(cn, p);

return p;

} catch (Throwable x) {

fail(service,"Provider " + cn + " could not be instantiated",x);

}

throw new Error(); // This cannot happen

}

自己实现一个 ServiceLoader

package edu.jiangxuan.up.service;

import java.io.BufferedReader;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.lang.reflect.Constructor;

import java.net.URL;

import java.net.URLConnection;

import java.util.ArrayList;

import java.util.Enumeration;

import java.util.List;

public class MyServiceLoader<S> {

// 对应的接口 Class 模板

private final Class<S> service;

// 对应实现类的 可以有多个,用 List 进行封装

private final List<S> providers = new ArrayList<>();

// 类加载器

private final ClassLoader classLoader;

// 暴露给外部使用的方法,通过调用这个方法可以开始加载自己定制的实现流程。

public static <S> MyServiceLoader<S> load(Class<S> service) {

return new MyServiceLoader<>(service);

}

// 构造方法私有化

private MyServiceLoader(Class<S> service) {

this.service = service;

this.classLoader = Thread.currentThread().getContextClassLoader();

doLoad();

}

// 关键方法,加载具体实现类的逻辑

private void doLoad() {

try {

// 读取所有 jar 包里面 META-INF/services 包下面的文件,这个文件名就是接口名,然后文件里面的内容就是具体的实现类的路径加全类名

Enumeration<URL> urls = classLoader.getResources("META-INF/services/" + service.getName());

// 挨个遍历取到的文件

while (urls.hasMoreElements()) {

// 取出当前的文件

URL url = urls.nextElement();

System.out.println("File = " + url.getPath());

// 建立链接

URLConnection urlConnection = url.openConnection();

urlConnection.setUseCaches(false);

// 获取文件输入流

InputStream inputStream = urlConnection.getInputStream();

// 从文件输入流获取缓存

BufferedReader bufferedReader = new BufferedReader(new InputStreamReader(inputStream));

// 从文件内容里面得到实现类的全类名

String className = bufferedReader.readLine();

while (className != null) {

// 通过反射拿到实现类的实例

Class<?> clazz = Class.forName(className, false, classLoader);

// 如果声明的接口跟这个具体的实现类是属于同一类型,(可以理解为Java的一种多态,接口跟实现类、父类和子类等等这种关系。)则构造实例

if (service.isAssignableFrom(clazz)) {

Constructor<? extends S> constructor = (Constructor<? extends S>) clazz.getConstructor();

S instance = constructor.newInstance();

// 把当前构造的实例对象添加到 Provider的列表里面

providers.add(instance);

}

// 继续读取下一行的实现类,可以有多个实现类,只需要换行就可以了。

className = bufferedReader.readLine();

}

}

} catch (Exception e) {

System.out.println("读取文件异常。。。");

}

}

// 返回spi接口对应的具体实现类列表

public List<S> getProviders() {

return providers;

}

}

主要的流程就是:

- 通过 URL 工具类从 jar 包的

/META-INF/services目录下面找到对应的文件, - 读取这个文件的名称找到对应的 spi 接口,

- 通过

InputStream流将文件里面的具体实现类的全类名读取出来, - 根据获取到的全类名,先判断跟 spi 接口是否为同一类型,如果是的,那么就通过反射的机制构造对应的实例对象,

- 将构造出来的实例对象添加到

Providers的列表中。

总结

其实不难发现,SPI 机制的具体实现本质上还是通过反射完成的。即:我们按照规定将要暴露对外使用的具体实现类在 META-INF/services/ 文件下声明。

另外,SPI 机制在很多框架中都有应用:Spring 框架的基本原理也是类似的反射。还有 Dubbo 框架提供同样的 SPI 扩展机制,只不过 Dubbo 和 spring 框架中的 SPI 机制具体实现方式跟咱们今天学得这个有些细微的区别,不过整体的原理都是一致的,相信大家通过对 JDK 中 SPI 机制的学习,能够一通百通,加深对其他高深框的理解。

通过 SPI 机制能够大大地提高接口设计的灵活性,但是 SPI 机制也存在一些缺点,比如:

- 遍历加载所有的实现类,这样效率还是相对较低的;

- 当多个

ServiceLoader同时load时,会有并发问题。

Java语法糖详解

作者:Hollis

语法糖是大厂 Java 面试常问的一个知识点。

本文从 Java 编译原理角度,深入字节码及 class 文件,抽丝剥茧,了解 Java 中的语法糖原理及用法,帮助大家在学会如何使用 Java 语法糖的同时,了解这些语法糖背后的原理。

什么是语法糖?

语法糖(Syntactic Sugar) 也称糖衣语法,是英国计算机学家 Peter.J.Landin 发明的一个术语,指在计算机语言中添加的某种语法,这种语法对语言的功能并没有影响,但是更方便程序员使用。简而言之,语法糖让程序更加简洁,有更高的可读性。

我们所熟知的编程语言中几乎都有语法糖。作者认为,语法糖的多少是评判一个语言够不够牛逼的标准之一。很多人说 Java 是一个“低糖语言”,其实从 Java 7 开始 Java 语言层面上一直在添加各种糖,主要是在“Project Coin”项目下研发。尽管现在 Java 有人还是认为现在的 Java 是低糖,未来还会持续向着“高糖”的方向发展。

Java 中有哪些常见的语法糖?

前面提到过,语法糖的存在主要是方便开发人员使用。但其实, Java 虚拟机并不支持这些语法糖。这些语法糖在编译阶段就会被还原成简单的基础语法结构,这个过程就是解语法糖。

说到编译,大家肯定都知道,Java 语言中,javac命令可以将后缀名为.java的源文件编译为后缀名为.class的可以运行于 Java 虚拟机的字节码。如果你去看com.sun.tools.javac.main.JavaCompiler的源码,你会发现在compile()中有一个步骤就是调用desugar(),这个方法就是负责解语法糖的实现的。

Java 中最常用的语法糖主要有泛型、变长参数、条件编译、自动拆装箱、内部类等。本文主要来分析下这些语法糖背后的原理。一步一步剥去糖衣,看看其本质。

switch 支持 String 与枚举

前面提到过,从 Java 7 开始,Java 语言中的语法糖在逐渐丰富,其中一个比较重要的就是 Java 7 中switch开始支持String。

在开始之前先科普下,Java 中的switch自身原本就支持基本类型。比如int、char等。对于int类型,直接进行数值的比较。对于char类型则是比较其 ascii 码。所以,对于编译器来说,switch中其实只能使用整型,任何类型的比较都要转换成整型。比如byte。short,char(ackii 码是整型)以及int。

那么接下来看下switch对String的支持,有以下代码:

public class switchDemoString {

public static void main(String[] args) {

String str = "world";

switch (str) {

case "hello":

System.out.println("hello");

break;

case "world":

System.out.println("world");

break;

default:

break;

}

}

}

反编译后内容如下:

public class switchDemoString

{

public switchDemoString()

{

}

public static void main(String args[])

{

String str = "world";

String s;

switch((s = str).hashCode())

{

default:

break;

case 99162322:

if(s.equals("hello"))

System.out.println("hello");

break;

case 113318802:

if(s.equals("world"))

System.out.println("world");

break;

}

}

}

看到这个代码,你知道原来 字符串的 switch 是通过equals()和hashCode()方法来实现的。 还好hashCode()方法返回的是int,而不是long。

仔细看下可以发现,进行switch的实际是哈希值,然后通过使用equals方法比较进行安全检查,这个检查是必要的,因为哈希可能会发生碰撞。因此它的性能是不如使用枚举进行 switch 或者使用纯整数常量,但这也不是很差。

泛型

我们都知道,很多语言都是支持泛型的,但是很多人不知道的是,不同的编译器对于泛型的处理方式是不同的,通常情况下,一个编译器处理泛型有两种方式:Code specialization和Code sharing。C++和 C#是使用Code specialization的处理机制,而 Java 使用的是Code sharing的机制。

Code sharing 方式为每个泛型类型创建唯一的字节码表示,并且将该泛型类型的实例都映射到这个唯一的字节码表示上。将多种泛型类形实例映射到唯一的字节码表示是通过类型擦除(

type erasue)实现的。

也就是说,对于 Java 虚拟机来说,他根本不认识Map<String, String> map这样的语法。需要在编译阶段通过类型擦除的方式进行解语法糖。

类型擦除的主要过程如下: 1.将所有的泛型参数用其最左边界(最顶级的父类型)类型替换。 2.移除所有的类型参数。

以下代码:

Map<String, String> map = new HashMap<String, String>();

map.put("name", "hollis");

map.put("wechat", "Hollis");

map.put("blog", "www.hollischuang.com");

解语法糖之后会变成:

Map map = new HashMap();

map.put("name", "hollis");

map.put("wechat", "Hollis");

map.put("blog", "www.hollischuang.com");

以下代码:

public static <A extends Comparable<A>> A max(Collection<A> xs) {

Iterator<A> xi = xs.iterator();

A w = xi.next();

while (xi.hasNext()) {

A x = xi.next();

if (w.compareTo(x) < 0)

w = x;

}

return w;

}

类型擦除后会变成:

public static Comparable max(Collection xs){

Iterator xi = xs.iterator();

Comparable w = (Comparable)xi.next();

while(xi.hasNext())

{

Comparable x = (Comparable)xi.next();

if(w.compareTo(x) < 0)

w = x;

}

return w;

}

虚拟机中没有泛型,只有普通类和普通方法,所有泛型类的类型参数在编译时都会被擦除,泛型类并没有自己独有的Class类对象。比如并不存在List<String>.class或是List<Integer>.class,而只有List.class。

自动装箱与拆箱

自动装箱就是 Java 自动将原始类型值转换成对应的包装类的对象,比如将 int 的变量转换成 Integer 对象,这个过程叫做装箱,反之将 Integer 对象转换成 int 类型值,这个过程叫做拆箱。因为这里的装箱和拆箱是自动进行的非人为转换,所以就称作为自动装箱和拆箱。原始类型 byte, short, char, int, long, float, double 和 boolean 对应的封装类为 Byte, Short, Character, Integer, Long, Float, Double, Boolean。

先来看个自动装箱的代码:

public static void main(String[] args) {

int i = 10;

Integer n = i;

}

反编译后代码如下:

public static void main(String args[]){

int i = 10;

Integer n = Integer.valueOf(i);

}

再来看个自动拆箱的代码:

public static void main(String[] args) {

Integer i = 10;

int n = i;

}

反编译后代码如下:

public static void main(String args[]){

Integer i = Integer.valueOf(10);

int n = i.intValue();

}

从反编译得到内容可以看出,在装箱的时候自动调用的是Integer的valueOf(int)方法。而在拆箱的时候自动调用的是Integer的intValue方法。

所以,装箱过程是通过调用包装器的 valueOf 方法实现的,而拆箱过程是通过调用包装器的 xxxValue 方法实现的。

如何避免自动拆箱?

比如我有一个ArrayList<Intger>,现在调用remove(Object c)方法时,放进去一个Integer对象,它却给我调用成了remove(int index)的方法了。这种坑可以用list.remove((Integer) c);或者list.remove((Object) c);来显式的调用。

可变长参数

可变参数(variable arguments)是在 Java 1.5 中引入的一个特性。它允许一个方法把任意数量的值作为参数。

看下以下可变参数代码,其中 print 方法接收可变参数:

public static void main(String[] args){

print("Holis", "公众号:Hollis", "博客:www.hollischuang.com", "QQ:907607222");

}

public static void print(String... strs){

for (int i = 0; i < strs.length; i++){

System.out.println(strs[i]);

}

}

反编译后代码:

public static void main(String args[]){

print(new String[] {

"Holis", "\u516C\u4F17\u53F7:Hollis", "\u535A\u5BA2\uFF1Awww.hollischuang.com", "QQ\uFF1A907607222"

});

}

public static transient void print(String strs[]){

for(int i = 0; i < strs.length; i++)

System.out.println(strs[i]);

}

从反编译后代码可以看出,可变参数在被使用的时候,他首先会创建一个数组,数组的长度就是调用该方法是传递的实参的个数,然后再把参数值全部放到这个数组当中,然后再把这个数组作为参数传递到被调用的方法中。

枚举

Java SE5 提供了一种新的类型-Java 的枚举类型,关键字enum可以将一组具名的值的有限集合创建为一种新的类型,而这些具名的值可以作为常规的程序组件使用,这是一种非常有用的功能。

要想看源码,首先得有一个类吧,那么枚举类型到底是什么类呢?是enum吗?答案很明显不是,enum就和class一样,只是一个关键字,他并不是一个类,那么枚举是由什么类维护的呢,我们简单的写一个枚举:

public enum t {

SPRING,SUMMER;

}

然后我们使用反编译,看看这段代码到底是怎么实现的,反编译后代码内容如下:

public final class T extends Enum

{

private T(String s, int i)

{

super(s, i);

}

public static T[] values()

{

T at[];

int i;

T at1[];

System.arraycopy(at = ENUM$VALUES, 0, at1 = new T[i = at.length], 0, i);

return at1;

}

public static T valueOf(String s)

{

return (T)Enum.valueOf(demo/T, s);

}

public static final T SPRING;

public static final T SUMMER;

private static final T ENUM$VALUES[];

static

{

SPRING = new T("SPRING", 0);

SUMMER = new T("SUMMER", 1);

ENUM$VALUES = (new T[] {

SPRING, SUMMER

});

}

}

通过反编译后代码我们可以看到,public final class T extends Enum,说明,该类是继承了Enum类的,同时final关键字告诉我们,这个类也是不能被继承的。

当我们使用enum来定义一个枚举类型的时候,编译器会自动帮我们创建一个final类型的类继承Enum类,所以枚举类型不能被继承。

内部类

内部类又称为嵌套类,可以把内部类理解为外部类的一个普通成员。

内部类之所以也是语法糖,是因为它仅仅是一个编译时的概念,outer.java里面定义了一个内部类inner,一旦编译成功,就会生成两个完全不同的.class文件了,分别是outer.class和outer$inner.class。所以内部类的名字完全可以和它的外部类名字相同。

public class OutterClass {

private String userName;

public String getUserName() {

return userName;

}

public void setUserName(String userName) {

this.userName = userName;

}

public static void main(String[] args) {

}

class InnerClass{

private String name;

public String getName() {

return name;

}

public void setName(String name) {

this.name = name;

}

}

}

以上代码编译后会生成两个 class 文件:OutterClass$InnerClass.class 、OutterClass.class 。当我们尝试对OutterClass.class文件进行反编译的时候,命令行会打印以下内容:Parsing OutterClass.class...Parsing inner class OutterClass$InnerClass.class... Generating OutterClass.jad 。他会把两个文件全部进行反编译,然后一起生成一个OutterClass.jad文件。文件内容如下:

public class OutterClass

{

class InnerClass

{

public String getName()

{

return name;

}

public void setName(String name)

{

this.name = name;

}

private String name;

final OutterClass this$0;

InnerClass()

{

this.this$0 = OutterClass.this;

super();

}

}

public OutterClass()

{

}

public String getUserName()

{

return userName;

}

public void setUserName(String userName){

this.userName = userName;

}

public static void main(String args1[])

{

}

private String userName;

}

条件编译

—般情况下,程序中的每一行代码都要参加编译。但有时候出于对程序代码优化的考虑,希望只对其中一部分内容进行编译,此时就需要在程序中加上条件,让编译器只对满足条件的代码进行编译,将不满足条件的代码舍弃,这就是条件编译。

如在 C 或 CPP 中,可以通过预处理语句来实现条件编译。其实在 Java 中也可实现条件编译。我们先来看一段代码:

ublic class ConditionalCompilation {

public static void main(String[] args) {

final boolean DEBUG = true;

if(DEBUG) {

System.out.println("Hello, DEBUG!");

}

final boolean ONLINE = false;

if(ONLINE){

System.out.println("Hello, ONLINE!");

}

}

}

反编译后代码如下:

public class ConditionalCompilation

{

public ConditionalCompilation()

{

}

public static void main(String args[])

{

boolean DEBUG = true;

System.out.println("Hello, DEBUG!");

boolean ONLINE = false;

}

}

首先,我们发现,在反编译后的代码中没有System.out.println("Hello, ONLINE!");,这其实就是条件编译。当if(ONLINE)为 false 的时候,编译器就没有对其内的代码进行编译。

所以,Java 语法的条件编译,是通过判断条件为常量的 if 语句实现的。其原理也是 Java 语言的语法糖。根据 if 判断条件的真假,编译器直接把分支为 false 的代码块消除。通过该方式实现的条件编译,必须在方法体内实现,而无法在整个 Java 类的结构或者类的属性上进行条件编译,这与 C/C++的条件编译相比,确实更有局限性。在 Java 语言设计之初并没有引入条件编译的功能,虽有局限,但是总比没有更强。

断言

在 Java 中,assert关键字是从 JAVA SE 1.4 引入的,为了避免和老版本的 Java 代码中使用了assert关键字导致错误,Java 在执行的时候默认是不启动断言检查的(这个时候,所有的断言语句都将忽略!),如果要开启断言检查,则需要用开关-enableassertions或-ea来开启。

看一段包含断言的代码:

public class AssertTest {

public static void main(String args[]) {

int a = 1;

int b = 1;

assert a == b;

System.out.println("公众号:Hollis");

assert a != b : "Hollis";

System.out.println("博客:www.hollischuang.com");

}

}

反编译后代码如下:

public class AssertTest {

public AssertTest()

{

}

public static void main(String args[])

{

int a = 1;

int b = 1;

if(!$assertionsDisabled && a != b)

throw new AssertionError();

System.out.println("\u516C\u4F17\u53F7\uFF1AHollis");

if(!$assertionsDisabled && a == b)

{

throw new AssertionError("Hollis");

} else

{

System.out.println("\u535A\u5BA2\uFF1Awww.hollischuang.com");

return;

}

}

static final boolean $assertionsDisabled = !com/hollis/suguar/AssertTest.desiredAssertionStatus();

}

很明显,反编译之后的代码要比我们自己的代码复杂的多。所以,使用了 assert 这个语法糖我们节省了很多代码。其实断言的底层实现就是 if 语言,如果断言结果为 true,则什么都不做,程序继续执行,如果断言结果为 false,则程序抛出 AssertError 来打断程序的执行。-enableassertions会设置$assertionsDisabled 字段的值。

数值字面量

在 java 7 中,数值字面量,不管是整数还是浮点数,都允许在数字之间插入任意多个下划线。这些下划线不会对字面量的数值产生影响,目的就是方便阅读。

比如:

public class Test {

public static void main(String... args) {

int i = 10_000;

System.out.println(i);

}

}

反编译后:

public class Test

{

public static void main(String[] args)

{

int i = 10000;

System.out.println(i);

}

}

反编译后就是把_删除了。也就是说 编译器并不认识在数字字面量中的_,需要在编译阶段把他去掉。

for-each

增强 for 循环(for-each)相信大家都不陌生,日常开发经常会用到的,他会比 for 循环要少写很多代码,那么这个语法糖背后是如何实现的呢?

public static void main(String... args) {

String[] strs = {"Hollis", "公众号:Hollis", "博客:www.hollischuang.com"};

for (String s : strs) {

System.out.println(s);

}

List<String> strList = ImmutableList.of("Hollis", "公众号:Hollis", "博客:www.hollischuang.com");

for (String s : strList) {

System.out.println(s);

}

}

反编译后代码如下:

public static transient void main(String args[])

{

String strs[] = {

"Hollis", "\u516C\u4F17\u53F7\uFF1AHollis", "\u535A\u5BA2\uFF1Awww.hollischuang.com"

};

String args1[] = strs;

int i = args1.length;

for(int j = 0; j < i; j++)

{

String s = args1[j];

System.out.println(s);

}

List strList = ImmutableList.of("Hollis", "\u516C\u4F17\u53F7\uFF1AHollis", "\u535A\u5BA2\uFF1Awww.hollischuang.com");

String s;

for(Iterator iterator = strList.iterator(); iterator.hasNext(); System.out.println(s))

s = (String)iterator.next();

}

代码很简单,for-each 的实现原理其实就是使用了普通的 for 循环和迭代器。

try-with-resource

Java 里,对于文件操作 IO 流、数据库连接等开销非常昂贵的资源,用完之后必须及时通过 close 方法将其关闭,否则资源会一直处于打开状态,可能会导致内存泄露等问题。

关闭资源的常用方式就是在finally块里是释放,即调用close方法。比如,我们经常会写这样的代码:

public static void main(String[] args) {

BufferedReader br = null;

try {

String line;

br = new BufferedReader(new FileReader("d:\\hollischuang.xml"));

while ((line = br.readLine()) != null) {

System.out.println(line);

}

} catch (IOException e) {

// handle exception

} finally {

try {

if (br != null) {

br.close();

}

} catch (IOException ex) {

// handle exception

}

}

}

从 Java 7 开始,jdk 提供了一种更好的方式关闭资源,使用try-with-resources语句,改写一下上面的代码,效果如下:

public static void main(String... args) {

try (BufferedReader br = new BufferedReader(new FileReader("d:\\ hollischuang.xml"))) {

String line;

while ((line = br.readLine()) != null) {

System.out.println(line);

}

} catch (IOException e) {

// handle exception

}

}

看,这简直是一大福音啊,虽然我之前一般使用IOUtils去关闭流,并不会使用在finally中写很多代码的方式,但是这种新的语法糖看上去好像优雅很多呢。看下他的背后:

public static transient void main(String args[])

{

BufferedReader br;

Throwable throwable;

br = new BufferedReader(new FileReader("d:\\ hollischuang.xml"));

throwable = null;

String line;

try

{

while((line = br.readLine()) != null)

System.out.println(line);

}

catch(Throwable throwable2)

{

throwable = throwable2;

throw throwable2;

}

if(br != null)

if(throwable != null)

try

{

br.close();

}

catch(Throwable throwable1)

{

throwable.addSuppressed(throwable1);

}

else

br.close();

break MISSING_BLOCK_LABEL_113;

Exception exception;

exception;

if(br != null)

if(throwable != null)

try

{

br.close();

}

catch(Throwable throwable3)

{

throwable.addSuppressed(throwable3);

}

else

br.close();

throw exception;

IOException ioexception;

ioexception;

}

}

其实背后的原理也很简单,那些我们没有做的关闭资源的操作,编译器都帮我们做了。所以,再次印证了,语法糖的作用就是方便程序员的使用,但最终还是要转成编译器认识的语言。

Lambda 表达式

关于 lambda 表达式,有人可能会有质疑,因为网上有人说他并不是语法糖。其实我想纠正下这个说法。Labmda 表达式不是匿名内部类的语法糖,但是他也是一个语法糖。实现方式其实是依赖了几个 JVM 底层提供的 lambda 相关 api。

先来看一个简单的 lambda 表达式。遍历一个 list:

public static void main(String... args) {

List<String> strList = ImmutableList.of("Hollis", "公众号:Hollis", "博客:www.hollischuang.com");

strList.forEach( s -> { System.out.println(s); } );

}

为啥说他并不是内部类的语法糖呢,前面讲内部类我们说过,内部类在编译之后会有两个 class 文件,但是,包含 lambda 表达式的类编译后只有一个文件。

反编译后代码如下:

public static /* varargs */ void main(String ... args) {

ImmutableList strList = ImmutableList.of((Object)"Hollis", (Object)"\u516c\u4f17\u53f7\uff1aHollis", (Object)"\u535a\u5ba2\uff1awww.hollischuang.com");

strList.forEach((Consumer<String>)LambdaMetafactory.metafactory(null, null, null, (Ljava/lang/Object;)V, lambda$main$0(java.lang.String ), (Ljava/lang/String;)V)());

}

private static /* synthetic */ void lambda$main$0(String s) {

System.out.println(s);

}

可以看到,在forEach方法中,其实是调用了java.lang.invoke.LambdaMetafactory#metafactory方法,该方法的第四个参数 implMethod 指定了方法实现。可以看到这里其实是调用了一个lambda$main$0方法进行了输出。

再来看一个稍微复杂一点的,先对 List 进行过滤,然后再输出:

public static void main(String... args) {

List<String> strList = ImmutableList.of("Hollis", "公众号:Hollis", "博客:www.hollischuang.com");

List HollisList = strList.stream().filter(string -> string.contains("Hollis")).collect(Collectors.toList());

HollisList.forEach( s -> { System.out.println(s); } );

}

反编译后代码如下:

public static /* varargs */ void main(String ... args) {

ImmutableList strList = ImmutableList.of((Object)"Hollis", (Object)"\u516c\u4f17\u53f7\uff1aHollis", (Object)"\u535a\u5ba2\uff1awww.hollischuang.com");

List<Object> HollisList = strList.stream().filter((Predicate<String>)LambdaMetafactory.metafactory(null, null, null, (Ljava/lang/Object;)Z, lambda$main$0(java.lang.String ), (Ljava/lang/String;)Z)()).collect(Collectors.toList());

HollisList.forEach((Consumer<Object>)LambdaMetafactory.metafactory(null, null, null, (Ljava/lang/Object;)V, lambda$main$1(java.lang.Object ), (Ljava/lang/Object;)V)());

}

private static /* synthetic */ void lambda$main$1(Object s) {

System.out.println(s);

}

private static /* synthetic */ boolean lambda$main$0(String string) {

return string.contains("Hollis");

}

两个 lambda 表达式分别调用了lambda$main$1和lambda$main$0两个方法。

所以,lambda 表达式的实现其实是依赖了一些底层的 api,在编译阶段,编译器会把 lambda 表达式进行解糖,转换成调用内部 api 的方式。

可能遇到的坑

泛型

一、当泛型遇到重载

public class GenericTypes {

public static void method(List<String> list) {

System.out.println("invoke method(List<String> list)");

}

public static void method(List<Integer> list) {

System.out.println("invoke method(List<Integer> list)");

}

}

上面这段代码,有两个重载的函数,因为他们的参数类型不同,一个是List<String>另一个是List<Integer> ,但是,这段代码是编译通不过的。因为我们前面讲过,参数List<Integer>和List<String>编译之后都被擦除了,变成了一样的原生类型 List,擦除动作导致这两个方法的特征签名变得一模一样。

二、当泛型遇到 catch

泛型的类型参数不能用在 Java 异常处理的 catch 语句中。因为异常处理是由 JVM 在运行时刻来进行的。由于类型信息被擦除,JVM 是无法区分两个异常类型MyException<String>和MyException<Integer>的

三、当泛型内包含静态变量

public class StaticTest{

public static void main(String[] args){

GT<Integer> gti = new GT<Integer>();

gti.var=1;

GT<String> gts = new GT<String>();

gts.var=2;

System.out.println(gti.var);

}

}

class GT<T>{

public static int var=0;

public void nothing(T x){}

}

以上代码输出结果为:2!

由于经过类型擦除,所有的泛型类实例都关联到同一份字节码上,泛型类的所有静态变量是共享的。

自动装箱与拆箱

对象相等比较

public static void main(String[] args) {

Integer a = 1000;

Integer b = 1000;

Integer c = 100;

Integer d = 100;

System.out.println("a == b is " + (a == b));

System.out.println(("c == d is " + (c == d)));

}

输出结果:

a == b is false

c == d is true

在 Java 5 中,在 Integer 的操作上引入了一个新功能来节省内存和提高性能。整型对象通过使用相同的对象引用实现了缓存和重用。

适用于整数值区间-128 至 +127。

只适用于自动装箱。使用构造函数创建对象不适用。

增强 for 循环(经常遇到!)

for (Student stu : students) {

if (stu.getId() == 2)

students.remove(stu);

}

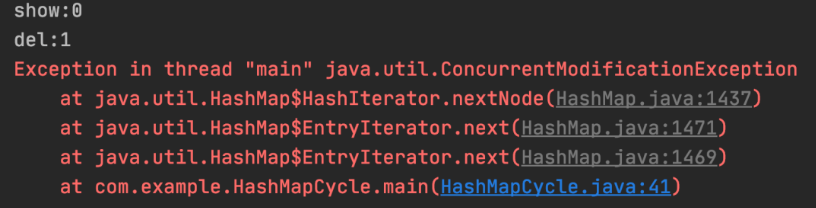

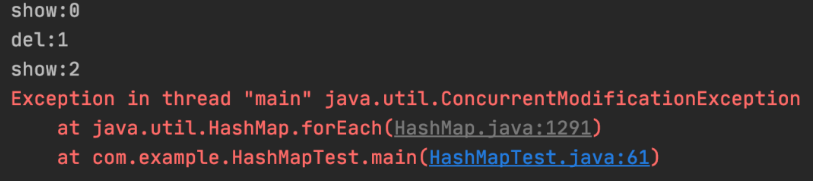

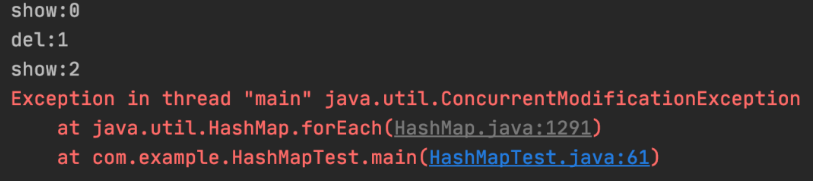

会抛出ConcurrentModificationException异常。

Iterator 是工作在一个独立的线程中,并且拥有一个 mutex 锁。 Iterator 被创建之后会建立一个指向原来对象的单链索引表,当原来的对象数量发生变化时,这个索引表的内容不会同步改变,所以当索引指针往后移动的时候就找不到要迭代的对象,所以按照 fail-fast 原则 Iterator 会马上抛出java.util.ConcurrentModificationException异常。

所以 Iterator 在工作的时候是不允许被迭代的对象被改变的。但你可以使用 Iterator 本身的方法remove()来删除对象,Iterator.remove() 方法会在删除当前迭代对象的同时维护索引的一致性。

集合

集合概述

Java 集合概览

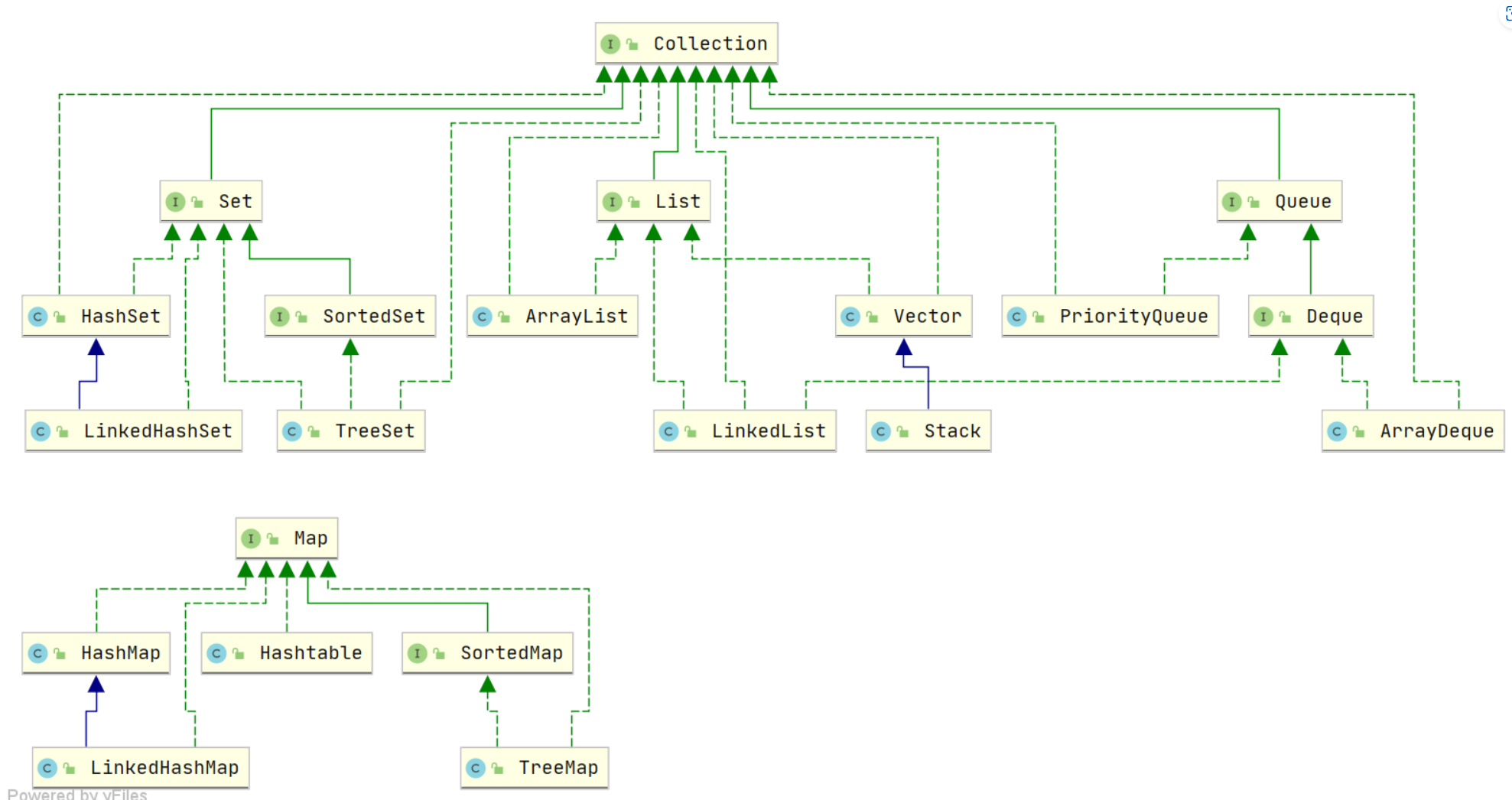

Java 集合, 也叫作容器,主要是由两大接口派生而来:一个是 Collection接口,主要用于存放单一元素;另一个是 Map 接口,主要用于存放键值对。对于Collection 接口,下面又有三个主要的子接口:List、Set 和 Queue。

Java 集合框架如下图所示:

注:图中只列举了主要的继承派生关系,并没有列举所有关系。比方省略了AbstractList, NavigableSet等抽象类以及其他的一些辅助类,如想深入了解,可自行查看源码。

说说 List, Set, Queue, Map 四者的区别?

List(对付顺序的好帮手): 存储的元素是有序的、可重复的。Set(注重独一无二的性质): 存储的元素是无序的、不可重复的。Queue(实现排队功能的叫号机): 按特定的排队规则来确定先后顺序,存储的元素是有序的、可重复的。Map(用 key 来搜索的专家): 使用键值对(key-value)存储,类似于数学上的函数 y=f(x),"x" 代表 key,"y" 代表 value,key 是无序的、不可重复的,value 是无序的、可重复的,每个键最多映射到一个值

集合框架底层数据结构总结

先来看一下 Collection 接口下面的集合List。

List

ArrayList:Object[]数组Vector:Object[]数组LinkedList: 双向链表(JDK1.6 之前为循环链表,JDK1.7 取消了循环)

Set

HashSet(无序,唯一): 基于HashMap实现的,底层采用HashMap来保存元素LinkedHashSet:LinkedHashSet是HashSet的子类,并且其内部是通过LinkedHashMap来实现的。有点类似于我们之前说的LinkedHashMap其内部是基于HashMap实现一样,不过还是有一点点区别的TreeSet(有序,唯一): 红黑树(自平衡的排序二叉树)

Queue

PriorityQueue:Object[]数组来实现二叉堆ArrayQueue:Object[]数组 + 双指针

再来看看 Map 接口下面的集合。

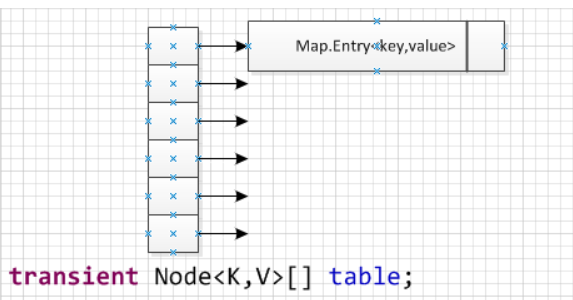

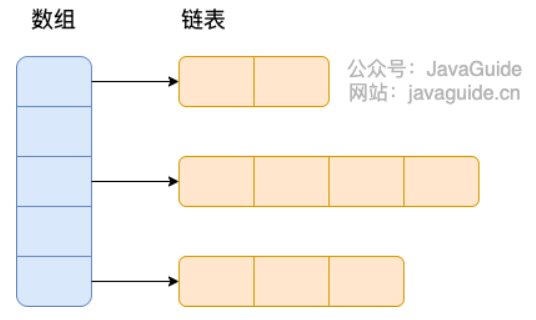

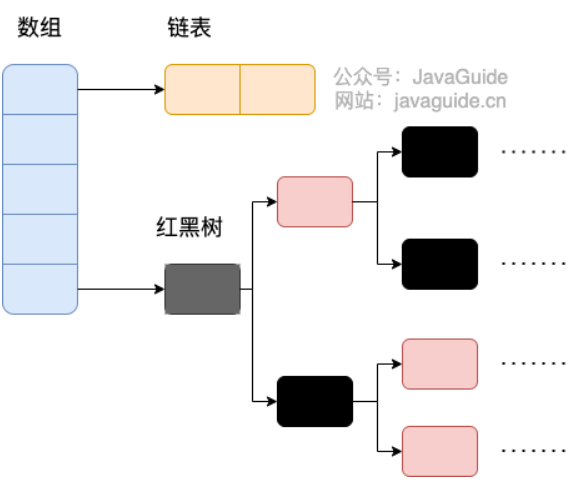

Map

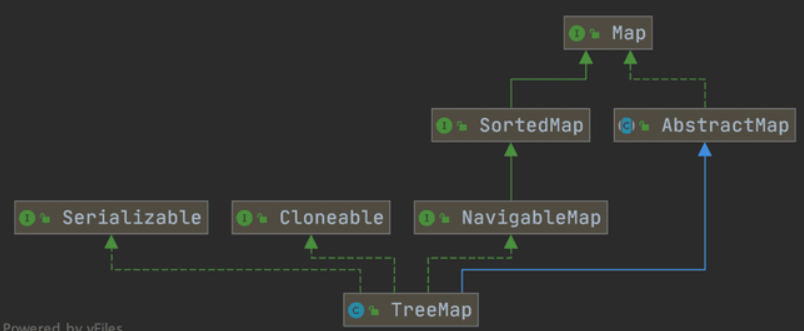

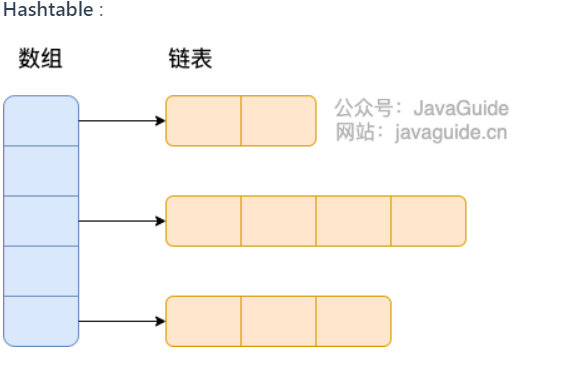

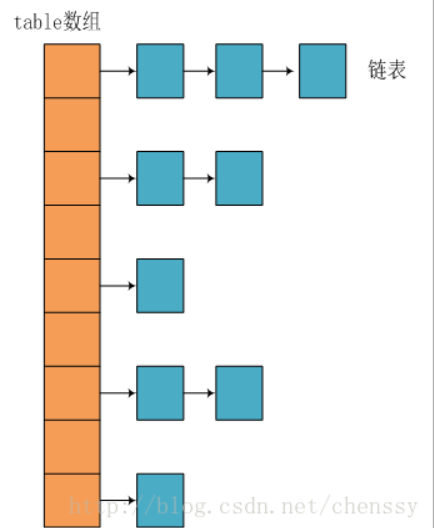

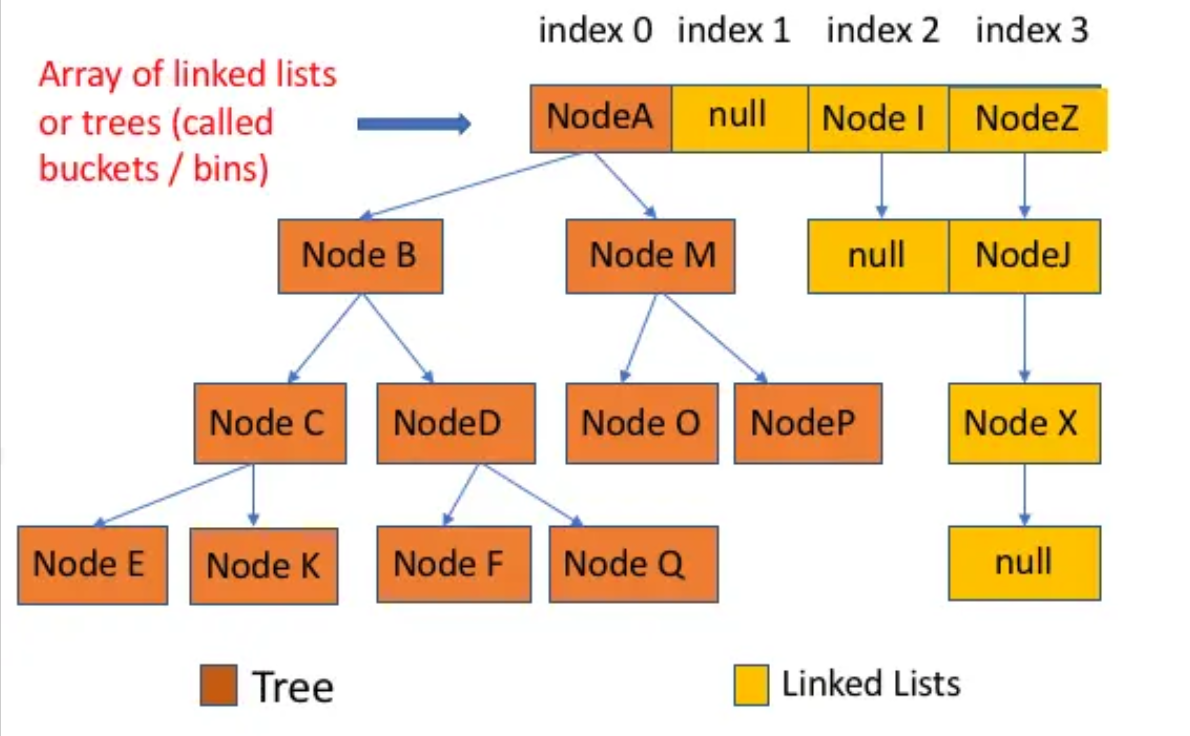

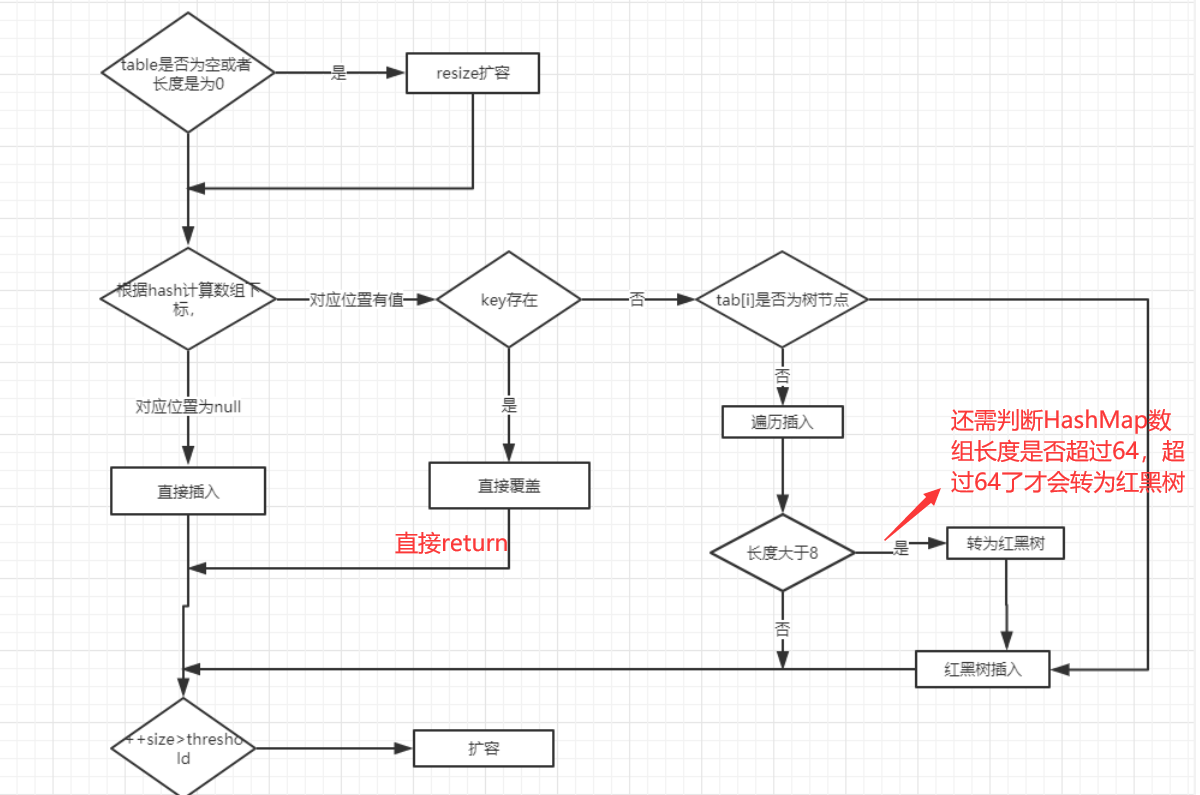

HashMap: JDK1.8 之前HashMap由数组+链表组成的,数组是HashMap的主体,链表则是主要为了解决哈希冲突而存在的(“拉链法”解决冲突)。JDK1.8 以后在解决哈希冲突时有了较大的变化,当链表长度大于阈值(默认为 8)(将链表转换成红黑树前会判断,如果当前数组的长度小于 64,那么会选择先进行数组扩容,而不是转换为红黑树)时,将链表转化为红黑树,以减少搜索时间。LinkedHashMap:LinkedHashMap继承自HashMap,所以它的底层仍然是基于拉链式散列结构即由数组和链表或红黑树组成。另外,LinkedHashMap在上面结构的基础上,增加了一条双向链表,使得上面的结构可以保持键值对的插入顺序。同时通过对链表进行相应的操作,实现了访问顺序相关逻辑。详细可以查看:《LinkedHashMap 源码详细分析(JDK1.8)》Hashtable: 数组+链表组成的,数组是Hashtable的主体,链表则是主要为了解决哈希冲突而存在的TreeMap: 红黑树(自平衡的排序二叉树)

如何选用集合?

主要根据集合的特点来选用,比如我们需要根据键值获取到元素值时就选用 Map 接口下的集合,需要排序时选择 TreeMap,不需要排序时就选择 HashMap,需要保证线程安全就选用 ConcurrentHashMap。

当我们只需要存放元素值时,就选择实现Collection 接口的集合,需要保证元素唯一时选择实现 Set 接口的集合比如 TreeSet 或 HashSet,不需要就选择实现 List 接口的比如 ArrayList 或 LinkedList,然后再根据实现这些接口的集合的特点来选用。

为什么要使用集合?

当我们需要保存一组类型相同的数据的时候,我们应该是用一个容器来保存,这个容器就是数组,但是,使用数组存储对象具有一定的弊端, 因为我们在实际开发中,存储的数据的类型是多种多样的,于是,就出现了“集合”,集合同样也是用来存储多个数据的。

数组的缺点是一旦声明之后,长度就不可变了;同时,声明数组时的数据类型也决定了该数组存储的数据的类型;而且,数组存储的数据是有序的、可重复的,特点单一。 但是集合提高了数据存储的灵活性,Java 集合不仅可以用来存储不同类型不同数量的对象,还可以保存具有映射关系的数据。

Collection 子接口之 List

ArrayList 和 Vector 的区别?

ArrayList是List的主要实现类,底层使用Object[ ]存储,适用于频繁的查找工作,线程不安全 ;Vector是List的古老实现类,底层使用Object[ ]存储,线程安全的。

ArrayList 与 LinkedList 区别?

- 是否保证线程安全:

ArrayList和LinkedList都是不同步的,也就是不保证线程安全; - 底层数据结构:

ArrayList底层使用的是Object数组;LinkedList底层使用的是 双向链表 数据结构(JDK1.6 之前为循环链表,JDK1.7 取消了循环。注意双向链表和双向循环链表的区别,下面有介绍到!) - 插入和删除是否受元素位置的影响:

ArrayList采用数组存储,所以插入和删除元素的时间复杂度受元素位置的影响。 比如:执行add(E e)方法的时候,ArrayList会默认在将指定的元素追加到此列表的末尾,这种情况时间复杂度就是 O(1)。但是如果要在指定位置 i 插入和删除元素的话(add(int index, E element))时间复杂度就为 O(n-i)。因为在进行上述操作的时候集合中第 i 和第 i 个元素之后的(n-i)个元素都要执行向后位/向前移一位的操作。LinkedList采用链表存储,所以,如果是在头尾插入或者删除元素不受元素位置的影响(add(E e)、addFirst(E e)、addLast(E e)、removeFirst()、removeLast()),时间复杂度为 O(1),如果是要在指定位置i插入和删除元素的话(add(int index, E element),remove(Object o)), 时间复杂度为 O(n) ,因为需要先移动到指定位置再插入。

- 是否支持快速随机访问:

LinkedList不支持高效的随机元素访问,而ArrayList支持。快速随机访问就是通过元素的序号快速获取元素对象(对应于get(int index)方法)。 - 内存空间占用:

ArrayList的空间浪费主要体现在在 list 列表的结尾会预留一定的容量空间,而 LinkedList 的空间花费则体现在它的每一个元素都需要消耗比 ArrayList 更多的空间(因为要存放直接后继和直接前驱以及数据)。

我们在项目中一般是不会使用到 LinkedList 的,需要用到 LinkedList 的场景几乎都可以使用 ArrayList 来代替,并且,性能通常会更好!就连 LinkedList 的作者约书亚 · 布洛克(Josh Bloch)自己都说从来不会使用 LinkedList 。

另外,不要下意识地认为 LinkedList 作为链表就最适合元素增删的场景。我在上面也说了,LinkedList 仅仅在头尾插入或者删除元素的时候时间复杂度近似 O(1),其他情况增删元素的时间复杂度都是 O(n) 。

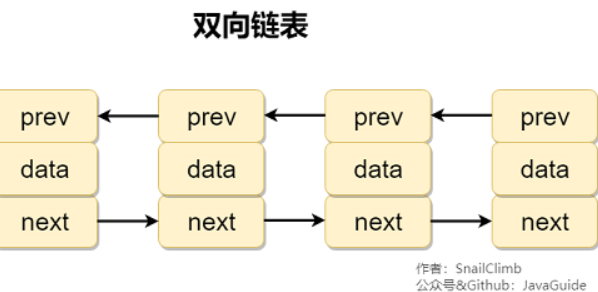

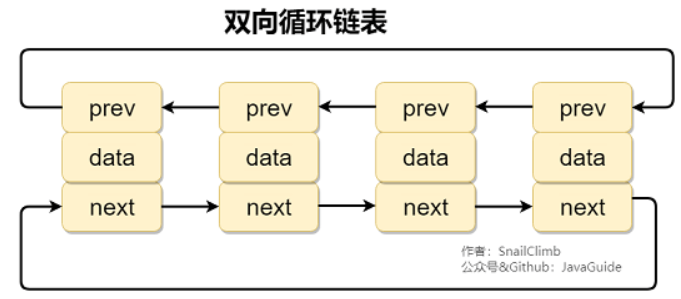

补充内容:双向链表和双向循环链表

双向链表: 包含两个指针,一个 prev 指向前一个节点,一个 next 指向后一个节点。

双向循环链表: 最后一个节点的 next 指向 head,而 head 的 prev 指向最后一个节点,构成一个环。

补充内容:RandomAccess 接口

public interface RandomAccess {

}

查看源码我们发现实际上 RandomAccess 接口中什么都没有定义。所以,在我看来 RandomAccess 接口不过是一个标识罢了。标识什么? 标识实现这个接口的类具有随机访问功能。

在 binarySearch() 方法中,它要判断传入的 list 是否 RandomAccess 的实例,如果是,调用indexedBinarySearch()方法,如果不是并且list的大小大雨了5000(private static final int BINARYSEARCH_THRESHOLD = 5000;),那么调用iteratorBinarySearch()方法

public static <T> int binarySearch(List<? extends Comparable<? super T>> list, T key) {

if (list instanceof RandomAccess || list.size()<BINARYSEARCH_THRESHOLD)

return Collections.indexedBinarySearch(list, key);

else

return Collections.iteratorBinarySearch(list, key);

}

ArrayList 实现了 RandomAccess 接口, 而 LinkedList 没有实现。为什么呢?我觉得还是和底层数据结构有关!ArrayList 底层是数组,而 LinkedList 底层是链表。数组天然支持随机访问,时间复杂度为 O(1),所以称为快速随机访问。链表需要遍历到特定位置才能访问特定位置的元素,时间复杂度为 O(n),所以不支持快速随机访问。,ArrayList 实现了 RandomAccess 接口,就表明了他具有快速随机访问功能。 RandomAccess 接口只是标识,并不是说 ArrayList 实现 RandomAccess 接口才具有快速随机访问功能的!

ArrayList扩容机制详情见之后的源码阅读

Collection 子接口之 Set

comparable 和 Comparator 的区别

comparable接口实际上是出自java.lang包 它有一个compareTo(Object obj)方法用来排序,一般用于在类声明时继承接口后重写compareTo(Object obj)方法,实现了comparable接口后,传入像TreeMap这种带有排序性质的集合后就会自动排好序的。comparator接口实际上是出自 java.util 包它有一个compare(Object obj1, Object obj2)方法用来排序,一般用于Collection.sort(List,new Comparator...{ 其中重写compare方法})。

一般我们需要对一个集合使用自定义排序时,我们就要重写compareTo()方法或compare()方法,当我们需要对某一个集合实现两种排序方式,比如一个 song 对象中的歌名和歌手名分别采用一种排序方法的话,我们可以重写compareTo()方法和使用自制的Comparator方法或者以两个 Comparator 来实现歌名排序和歌星名排序,第二种代表我们只能使用两个参数版的 Collections.sort().

Comparator 定制排序

ArrayList<Integer> arrayList = new ArrayList<Integer>();

arrayList.add(-1);

arrayList.add(3);

arrayList.add(3);

arrayList.add(-5);

arrayList.add(7);

arrayList.add(4);

arrayList.add(-9);

arrayList.add(-7);

System.out.println("原始数组:");

System.out.println(arrayList);

// void reverse(List list):反转

Collections.reverse(arrayList);

System.out.println("Collections.reverse(arrayList):");

System.out.println(arrayList);

// void sort(List list),按自然排序的升序排序

Collections.sort(arrayList);

System.out.println("Collections.sort(arrayList):");

System.out.println(arrayList);

// 定制排序的用法

Collections.sort(arrayList, new Comparator<Integer>() {

@Override

public int compare(Integer o1, Integer o2) {

return o2.compareTo(o1);

}

});

System.out.println("定制排序后:");

System.out.println(arrayList);

Output:

原始数组:

[-1, 3, 3, -5, 7, 4, -9, -7]

Collections.reverse(arrayList):

[-7, -9, 4, 7, -5, 3, 3, -1]

Collections.sort(arrayList):

[-9, -7, -5, -1, 3, 3, 4, 7]

定制排序后:

[7, 4, 3, 3, -1, -5, -7, -9]

重写 compareTo 方法实现按年龄来排序

// person对象没有实现Comparable接口,所以必须实现,这样才不会出错,才可以使treemap中的数据按顺序排列

// 前面一个例子的String类已经默认实现了Comparable接口,详细可以查看String类的API文档,另外其他

// 像Integer类等都已经实现了Comparable接口,所以不需要另外实现了

public class Person implements Comparable<Person> {

private String name;

private int age;

public Person(String name, int age) {

super();

this.name = name;

this.age = age;

}

public String getName() {

return name;

}

public void setName(String name) {

this.name = name;

}

public int getAge() {

return age;

}

public void setAge(int age) {

this.age = age;

}

/**

* T重写compareTo方法实现按年龄来排序

*/

@Override

public int compareTo(Person o) {

if (this.age > o.getAge()) {//年龄大的排到后面去

return 1;

}

if (this.age < o.getAge()) {

return -1;

}

return 0;

}

}

TreeMap根据其键的自然顺序进行排序,或者根据创建映射时提供的 Comparator 进行排序。

public static void main(String[] args) {

TreeMap<Person, String> pdata = new TreeMap<Person, String>();

pdata.put(new Person("张三", 30), "zhangsan");

pdata.put(new Person("李四", 20), "lisi");

pdata.put(new Person("王五", 10), "wangwu");

pdata.put(new Person("小红", 5), "xiaohong");

// 得到key的值的同时得到key所对应的值

Set<Person> keys = pdata.keySet();

for (Person key : keys) {

System.out.println(key.getAge() + "-" + key.getName());

}

}

Output:

5-小红

10-王五

20-李四

30-张三

无序性和不可重复性的含义是什么

- 无序性不等于随机性 ,无序性是指存储的数据在底层数组中并非按照数组索引的顺序添加 ,而是根据数据的哈希值决定的。

- 不可重复性是指添加的元素按照

equals()判断时 ,返回 false,需要同时重写equals()方法和hashCode()方法

比较 HashSet、LinkedHashSet 和 TreeSet 三者的异同

HashSet、LinkedHashSet和TreeSet都是Set接口的实现类,都能保证元素唯一,并且都不是线程安全的。HashSet、LinkedHashSet和TreeSet的主要区别在于底层数据结构不同。HashSet的底层数据结构是哈希表(基于HashMap实现)。LinkedHashSet的底层数据结构是链表和哈希表,元素的插入和取出顺序满足 FIFO。TreeSet底层数据结构是红黑树,元素是有序的,排序的方式有自然排序和定制排序。- 底层数据结构不同又导致这三者的应用场景不同。

HashSet用于不需要保证元素插入和取出顺序的场景,LinkedHashSet用于保证元素的插入和取出顺序满足 FIFO 的场景,TreeSet用于支持对元素自定义排序规则的场景。

Collection 子接口之 Queue

Queue 与 Deque 的区别

Queue 是单端队列,只能从一端插入元素,另一端删除元素,实现上一般遵循 先进先出(FIFO) 规则。

Queue 扩展了 Collection 的接口,根据 因为容量问题而导致操作失败后处理方式的不同 可以分为两类方法: 一种在操作失败后会抛出异常,另一种则会返回特殊值。

Queue 接口 |

抛出异常 | 返回特殊值 |

|---|---|---|

| 插入队尾 | add(E e) | offer(E e) |

| 删除队首 | remove() | poll() |

| 查询队首元素 | element() | peek() |

Deque 是双端队列,在队列的两端均可以插入或删除元素。Deque 扩展了 Queue 的接口, 增加了在队首和队尾进行插入和删除的方法,同样根据失败后处理方式的不同分为两类:

Deque 接口 |

抛出异常 | 返回特殊值 |

|---|---|---|

| 插入队首 | addFirst(E e) | offerFirst(E e) |

| 插入队尾 | addLast(E e) | offerLast(E e) |

| 删除队首 | removeFirst() | pollFirst() |

| 删除队尾 | removeLast() | pollLast() |

| 查询队首元素 | getFirst() | peekFirst() |

| 查询队尾元素 | getLast() | peekLast() |

事实上,Deque 还提供有 push() 和 pop() 等其他方法,可用于模拟栈。

ArrayDeque 与 LinkedList 的区别

ArrayDeque 和 LinkedList 都实现了 Deque 接口,两者都具有队列的功能,但两者有什么区别呢?

ArrayDeque是基于可变长的数组和双指针来实现,而LinkedList则通过链表来实现。ArrayDeque不支持存储NULL数据,但LinkedList支持。ArrayDeque是在 JDK1.6 才被引入的,而LinkedList早在 JDK1.2 时就已经存在。ArrayDeque插入时可能存在扩容过程, 不过均摊后的插入操作依然为 O(1)。虽然LinkedList不需要扩容,但是每次插入数据时均需要申请新的堆空间,均摊性能相比更慢。

从性能的角度上,选用 ArrayDeque 来实现队列要比 LinkedList 更好。此外,ArrayDeque 也可以用于实现栈。

说一说 PriorityQueue

PriorityQueue 是在 JDK1.5 中被引入的, 其与 Queue 的区别在于元素出队顺序是与优先级相关的,即总是优先级最高的元素先出队。

这里列举其相关的一些要点:

PriorityQueue利用了二叉堆的数据结构来实现的,底层使用可变长的数组来存储数据PriorityQueue通过堆元素的上浮和下沉,实现了在 O(logn) 的时间复杂度内插入元素和删除堆顶元素。PriorityQueue是非线程安全的,且不支持存储NULL和non-comparable的对象。PriorityQueue默认是小顶堆,但可以接收一个Comparator作为构造参数,从而来自定义元素优先级的先后。