绪论-1.2.1浅层神经网络

1.2神经网络发展史

我们将神经网络的发展历程大致分为浅层神经网络阶段和深度学习阶段,以2006年为分割点。2006年以前,深度学弟以神经网络连接主义名义发展,经历了两次兴盛和两次寒冬;2006年,Groffrey Hinton首次将深层神经网络命名为深度学习,自此开启了深度学习的第三次复兴之路。

1.2.1浅层神经网络

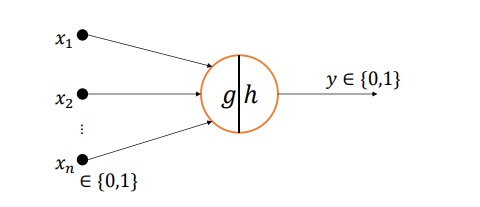

1943 年,心理学家 Warren McCulloch 和逻辑学家 Walter Pitts 根据生物神经元(Neuron) 结构,提出了最早的神经元数学模型,称为 MP 神经元模型。该模型的输出𝑓(𝒙) = ℎ(𝑔(𝒙)),其中𝑔(𝒙) = ∑𝑖 𝑥𝑖 , 𝑥𝑖 ∈ {0,1},模型通过𝑔(𝒙)的值来完成输出值的预测,如图 所示。如果𝑔(𝒙) ≥ 0,输出为 1;如果𝑔(𝒙) < 0,输出为 0。可以看到,MP 神经元模型并 没有学习能力,只能完成固定逻辑的判定。

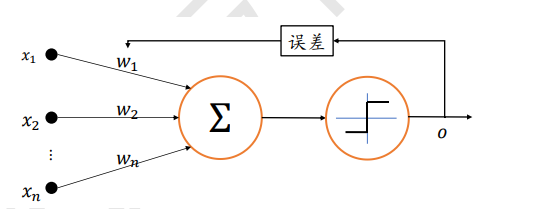

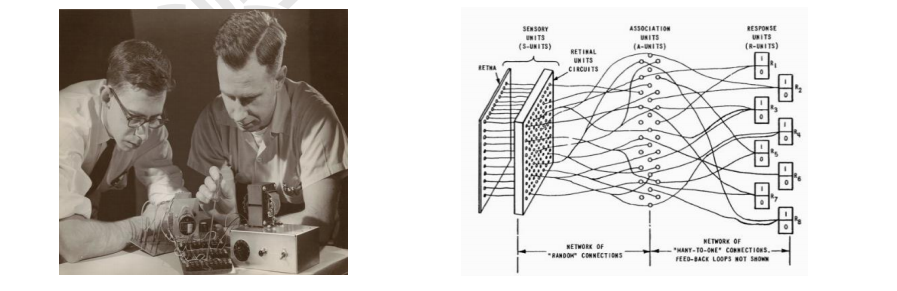

1958 年,美国心理学家 Frank Rosenblatt 提出了第一个可以自动学习权重的神经元模 型,称为感知机(Perceptron),如图 所示,输出值𝑜与真实值 之间的误差用于调整神经 元的权重参数{𝑤 , 𝑤 , … , 𝑤 }。Frank Rosenblatt 随后基于“Mark 1 感知机”硬件实现感知 机模型,如图 1.6、图 1.7 所示,输入为 400 个单元的图像传感器,输出为 8 个节点端 子,可以成功识别一些英文字母。一般认为 1943 年~1969 年为人工智能发展的第一次兴盛 期。

尽管处于 AI 发展的低谷期,仍然有很多意义重大的研究相继发表,这其中最重要的 成果就是误差反向传播算法(Back Propagation,简称 BP 算法)的提出,它依旧是现代深度学 习的核心理论基础。实际上,反向传播的数学思想早在 1960 年代就已经被推导出了,但是 并没有应用在神经网络上。1974 年,美国科学家 Paul Werbos 在他的博士论文中第一次提 出可以将 BP 算法应用到神经网络上,遗憾的是,这一成果并没有获得足够重视。直至 1986 年,David Rumelhart 等人在 Nature 上发表了通过 BP 算法来进行表征学习的论文, BP 算法才获得了广泛的关注。

浙公网安备 33010602011771号

浙公网安备 33010602011771号