神经网络梯度消失原因&解决方案

个人学习使用,内容来源于网络,侵权删

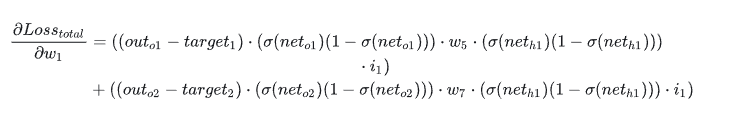

主要原因就是反向传播链式求导某项小于1(如使用sigmoid激活函数,其求导之后值\(\leq0.25\)),越深层次网络导数连乘越多,从而导致梯度消失,反之某项大于1会导致梯度爆炸,因此初始\(W\)过大会导致梯度爆炸。

如图所示,当\(\sigma\)激活函数求导后的值太小,经过多层传播后会导致梯度消失;当\(w\)或者其他隐藏层计算的值太大,则导致梯度爆炸。

解决方案如下:

参考链接

个人学习使用,内容来源于网络,侵权删

主要原因就是反向传播链式求导某项小于1(如使用sigmoid激活函数,其求导之后值\(\leq0.25\)),越深层次网络导数连乘越多,从而导致梯度消失,反之某项大于1会导致梯度爆炸,因此初始\(W\)过大会导致梯度爆炸。

如图所示,当\(\sigma\)激活函数求导后的值太小,经过多层传播后会导致梯度消失;当\(w\)或者其他隐藏层计算的值太大,则导致梯度爆炸。

解决方案如下:

参考链接