2020最新最全Python面试题整理(六)

1 说说什么是爬虫协议?

Robots协议(也称为爬虫协议、爬虫规则、机器人协议等)也就是robots.txt,网站通过robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取。

Robots协议是网站国际互联网界通行的道德规范,其目的是保护网站数据和敏感信息、确保用户个人信息和隐私不被侵犯。因其不是命令,故需要搜索引擎自觉遵守。

2 如果对方网站反爬取,封IP了怎么办?

放慢抓取熟速度,减小对目标网站造成的压力,但是这样会减少单位时间内的数据抓取量

使用代理IP(免费的可能不稳定,收费的可能不划算)

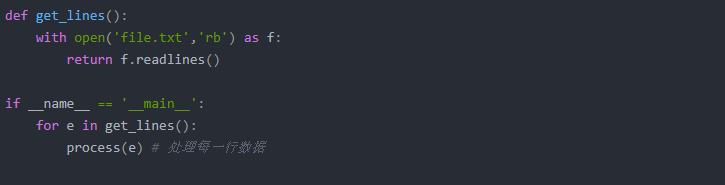

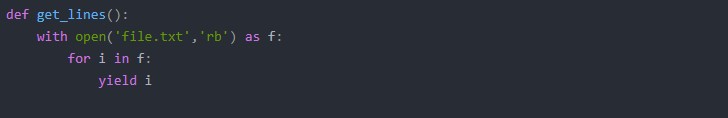

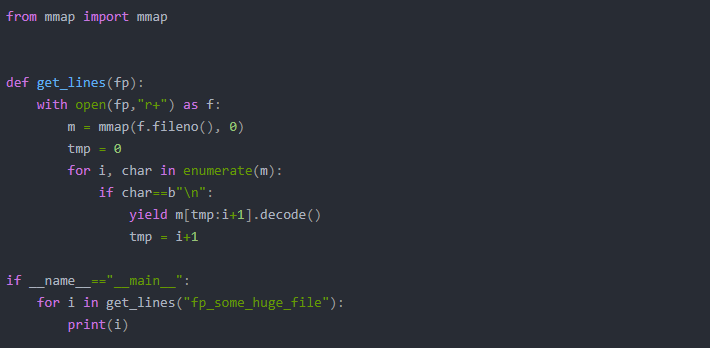

3 有一个jsonline格式的文件file

现在要处理一个大小为10G的文件,但是内存只有4G,如果在只修改get_lines 函数而其他代码保持不变的情况下,应该如何实现?需要考虑的问题都有那些?

方法

要考虑的问题有:内存只有4G无法一次性读入10G文件,需要分批读入分批读入数据要记录每次读入数据的位置。分批每次读取数据的大小,太小会在读取操作花费过多时间。

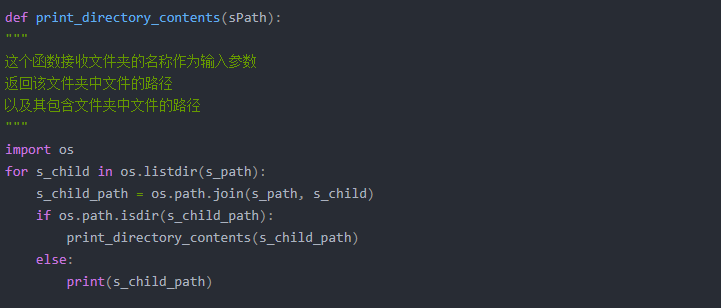

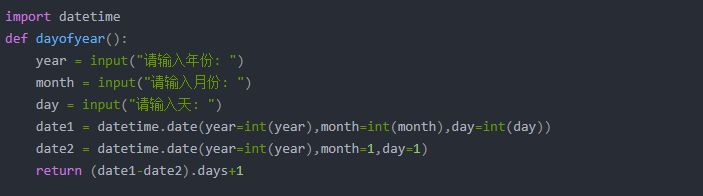

4 补充缺失的代码

5 输入日期, 判断这一天是这一年的第几天?

浙公网安备 33010602011771号

浙公网安备 33010602011771号