基于深度学习的遥感地面物体检测系统演示与介绍(YOLOv12/v11/v8/v5模型+Pyqt5界面+训练代码+数据集)

视频演示

1. 前言

遥感地面物体检测在城市规划、交通监控、环境监测及农业管理等领域具有重要应用价值。传统基于人工解译或经典图像处理的方法,面对高分辨率遥感影像中目标尺度多变、背景复杂、分布密集等挑战,往往存在效率低、漏检率高、定位精度受限等问题。近年来,以 YOLO 系列为代表的单阶段目标检测算法,凭借端到端推理、较高检测速度与优良的多尺度特征学习能力,在遥感影像目标检测任务中得到广泛关注,并逐步由通用场景向交通设施、港口、运动场、道路交叉口等细粒度地面物体检测延伸。

现有研究多侧重于模型结构的改进,如引入注意力机制、特征金字塔增强或轻量化设计,以提升特定场景下的检测性能。然而,面向实际工程应用仍需在多模型横向对比、交互可视化、批量与实时检测支持、用户管理及训练流程自动化等方面形成完整解决方案,以满足从实验验证到业务落地的闭环需求。此外,不同目标类别在遥感影像中的出现频率与形态特征差异显著,数据集的规模、质量与标注一致性直接影响模型的泛化与稳定性,因此需建立标准化的数据组织、训练评估与结果分析体系。

本文实现并评估了一套基于 YOLO 的遥感地面物体检测系统,覆盖从数据准备、模型训练到推理部署的全流程:系统集成 YOLOv5、YOLOv8、YOLOv11、YOLOv12 四种模型,支持同一界面下快速切换与性能对比;采用 PyQt5 构建桌面应用,提供图片、视频、文件夹批量及摄像头实时检测功能,具备置信度与 IoU 阈值调节、检测耗时与目标统计、检测结果列表与类别过滤、目标详细信息展示等交互特性;基于 SQLite 实现用户注册、登录与个人中心管理,支持资料与头像更新;配套独立脚本工具,可实现命令行模式的图片、视频及摄像头快速检测。训练方面,代码支持对四个模型依次训练,数据集按训练/验证/测试划分,训练结果保存在 runs目录,包含最佳权重(best.pt)、F1 曲线、混淆矩阵、样本预测与数据增强效果图等,便于复现与横向分析。

本研究面向遥感影像智能解译、交通设施监测、港口与场地管理等应用场景,兼顾检测精度、推理速度与系统易用性,为地面物体检测技术的科研实验与工程落地提供了一体化参考方案。

2. 项目演示

2.1 用户登录界面

登录界面布局简洁清晰,左侧展示系统主题,用户需输入用户名、密码及验证码完成身份验证后登录系统。

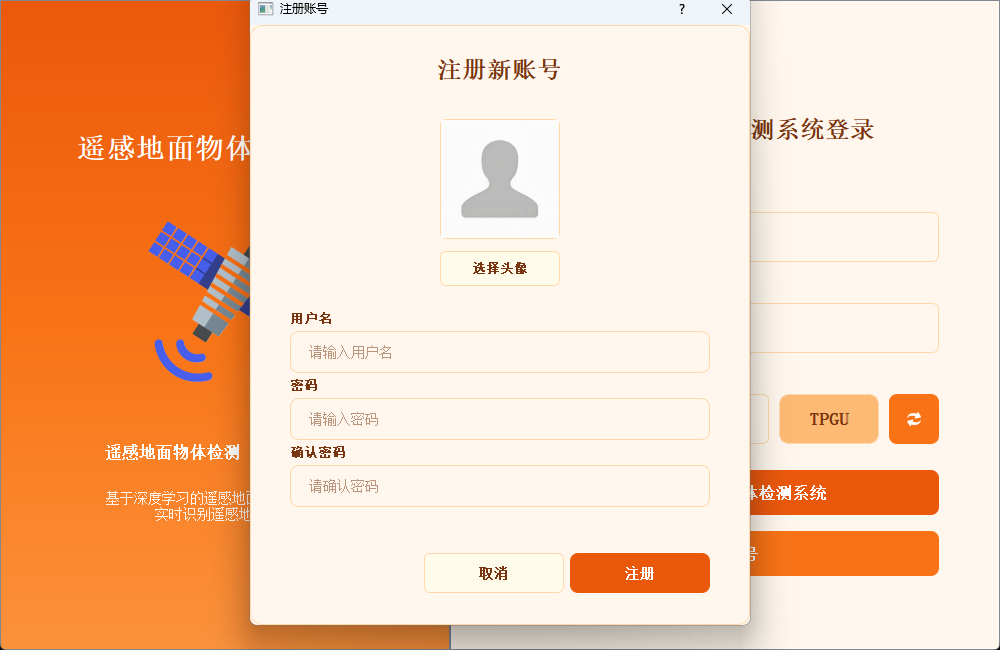

2.2 新用户注册

注册时可自定义用户名与密码,支持上传个人头像;如未上传,系统将自动使用默认头像完成账号创建。

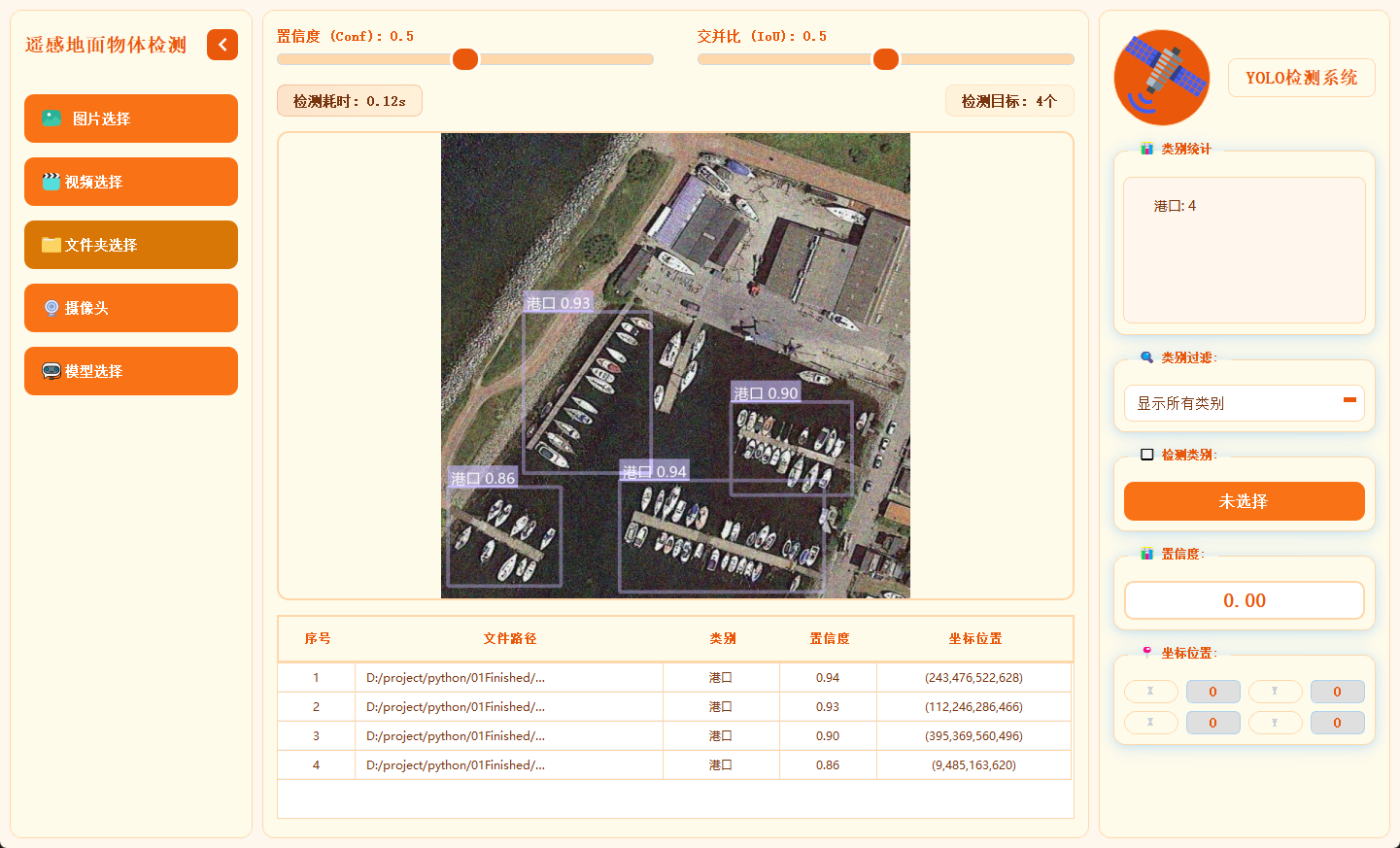

2.3 主界面布局

主界面采用三栏结构,左侧为功能操作区,中间用于展示检测画面,右侧呈现目标详细信息,布局合理,交互流畅。

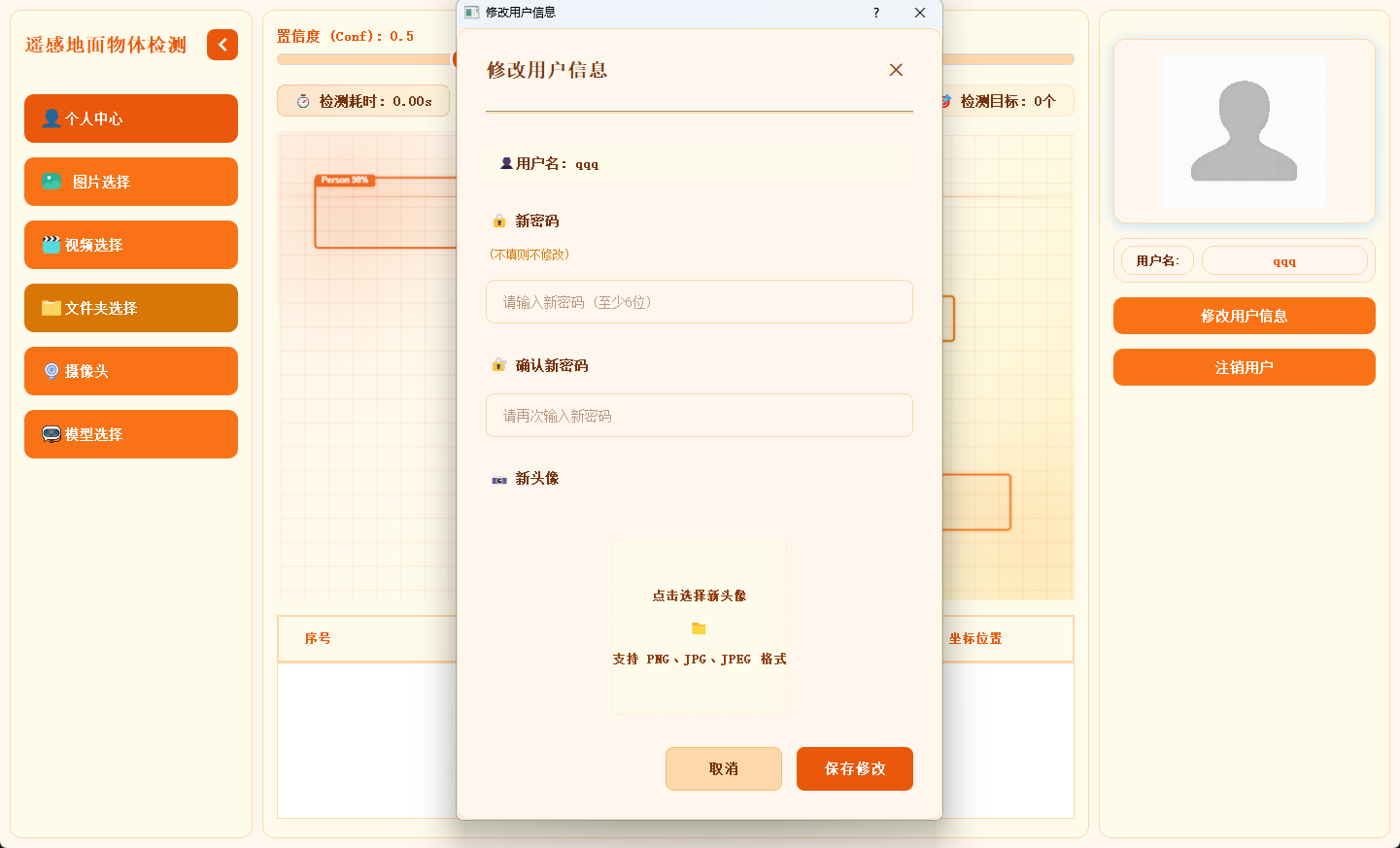

2.4 个人信息管理

用户可在此模块中修改密码或更换头像,个人信息支持随时更新与保存。

2.5 多模态检测展示

系统支持图片、视频及摄像头实时画面的目标检测。识别结果将在画面中标注显示,并在下方列表中逐项列出。点击具体目标可查看其类别、置信度及位置坐标等详细信息。

2.6 多模型切换

系统内置多种已训练模型,用户可根据实际需求灵活切换,以适应不同检测场景或对比识别效果。

3.模型训练核心代码

本脚本是YOLO模型批量训练工具,可自动修正数据集路径为绝对路径,从pretrained文件夹加载预训练模型,按设定参数(100轮/640尺寸/批次8)一键批量训练YOLOv5nu/v8n/v11n/v12n模型。

4. 技术栈

-

语言:Python 3.10

-

前端界面:PyQt5

-

数据库:SQLite(存储用户信息)

-

模型:YOLOv5、YOLOv8、YOLOv11、YOLOv12

5. YOLO模型对比与识别效果解析

5.1 YOLOv5/YOLOv8/YOLOv11/YOLOv12模型对比

基于Ultralytics官方COCO数据集训练结果:

|

模型 |

尺寸(像素) |

mAPval 50-95 |

速度(CPU ONNX/毫秒) |

参数(M) |

FLOPs(B) |

|---|---|---|---|---|---|

|

YOLO12n |

640 |

40.6 |

- |

2.6 |

6.5 |

|

YOLO11n |

640 |

39.5 |

56.1 ± 0.8 |

2.6 |

6.5 |

|

YOLOv8n |

640 |

37.3 |

80.4 |

3.2 |

8.7 |

|

YOLOv5nu |

640 |

34.3 |

73.6 |

2.6 |

7.7 |

关键结论:

-

精度最高:YOLO12n(mAP 40.6%),显著领先其他模型(较YOLOv5nu高约6.3个百分点);

-

速度最优:YOLO11n(CPU推理56.1ms),比YOLOv8n快42%,适合实时轻量部署;

-

效率均衡:YOLO12n/YOLO11n/YOLOv8n/YOLOv5nu参数量均为2.6M,FLOPs较低(YOLO12n/11n仅6.5B);YOLOv8n参数量(3.2M)与计算量(8.7B)最高,但精度优势不明显。

综合推荐:

-

追求高精度:优先选YOLO12n(精度与效率兼顾);

-

需高速低耗:选YOLO11n(速度最快且精度接近YOLO12n);

-

YOLOv5nu/YOLOv8n因性能劣势,无特殊需求时不建议首选。

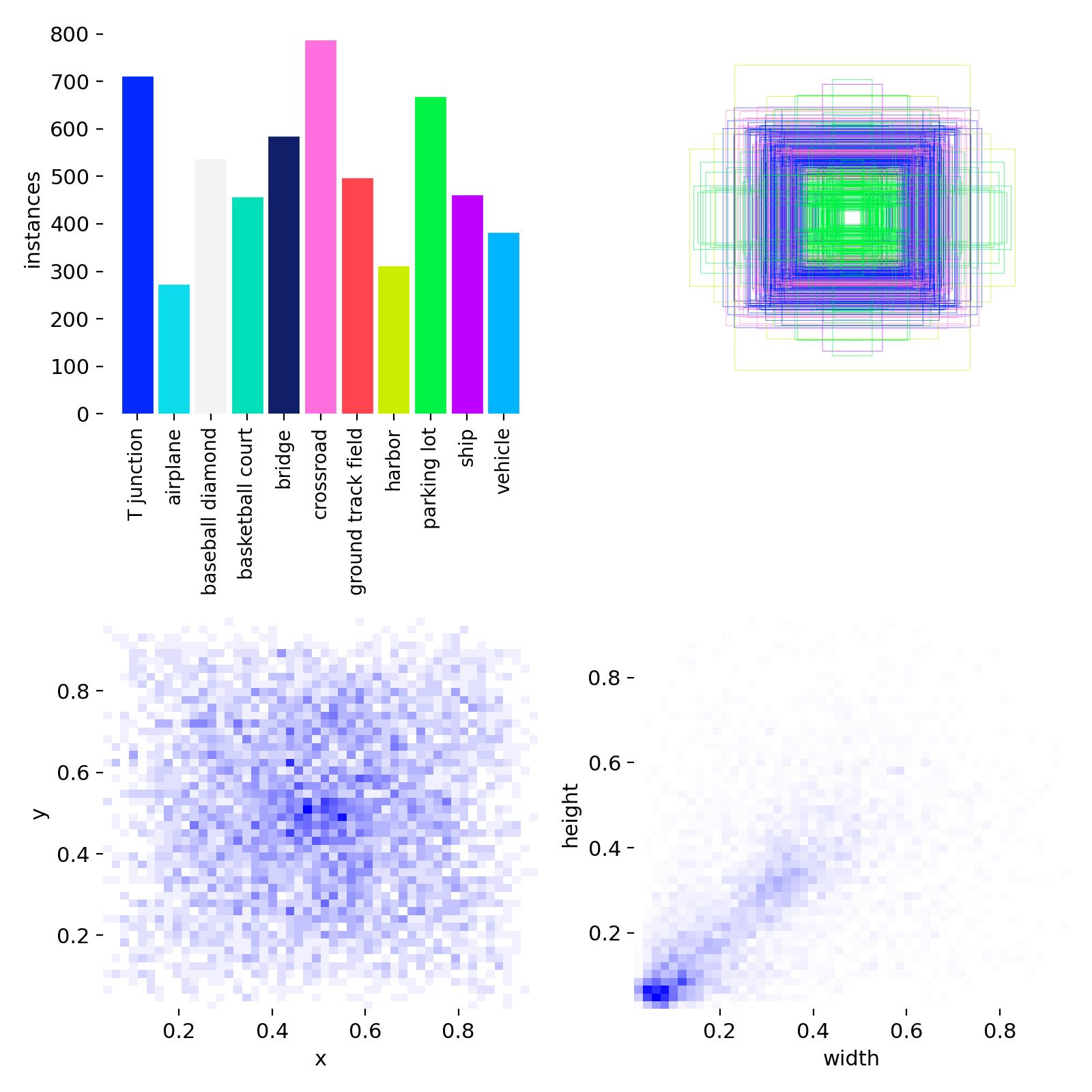

5.2 数据集分析

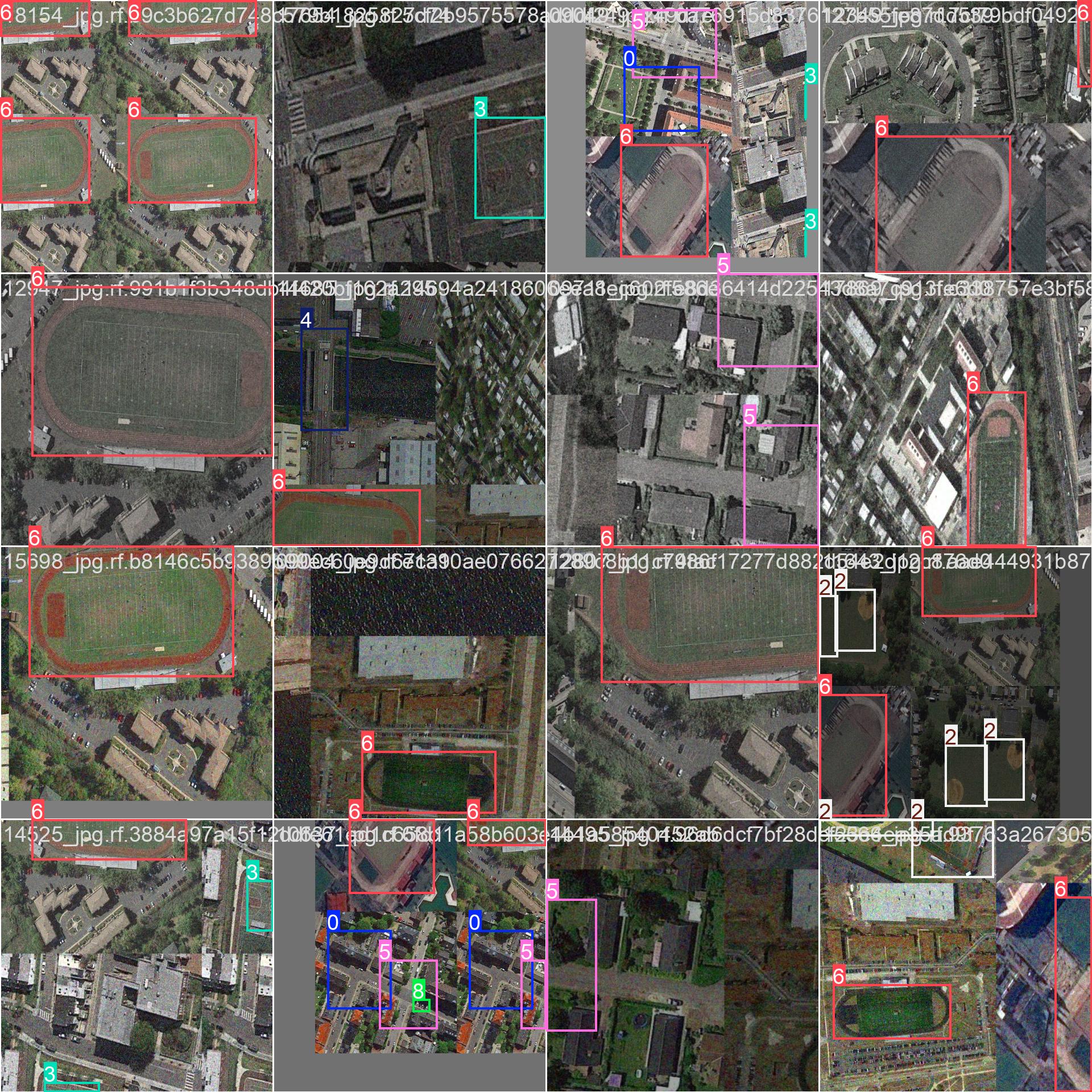

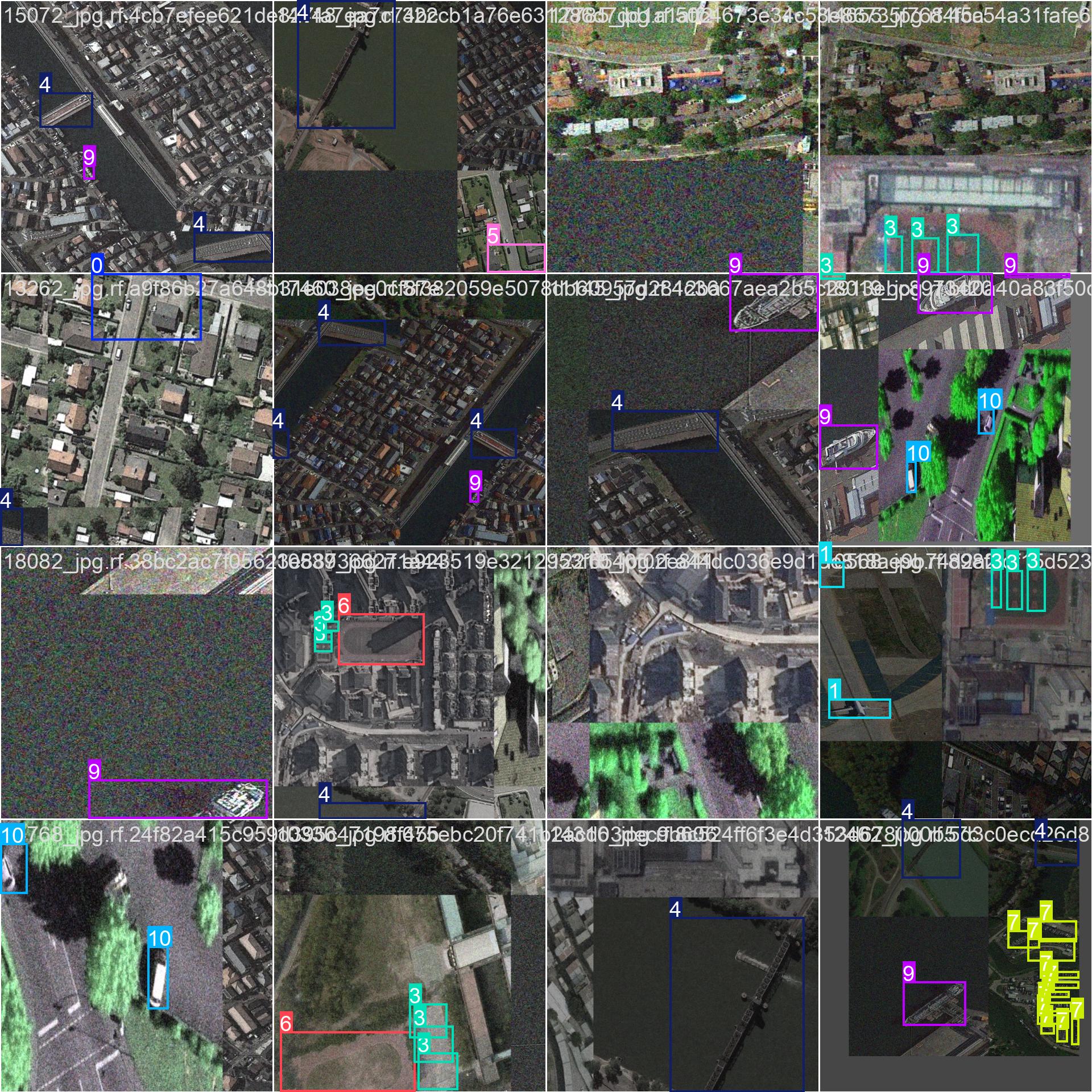

数据集中训练集和验证集一共4000多张图片,数据集目标类别11种:T型路口,飞机,棒球场,篮球场,桥梁,十字路口,田径运动场,港口,停车场,船只,车辆,数据集配置代码如下:

上面的图片就是部分样本集训练中经过数据增强后的效果标注。

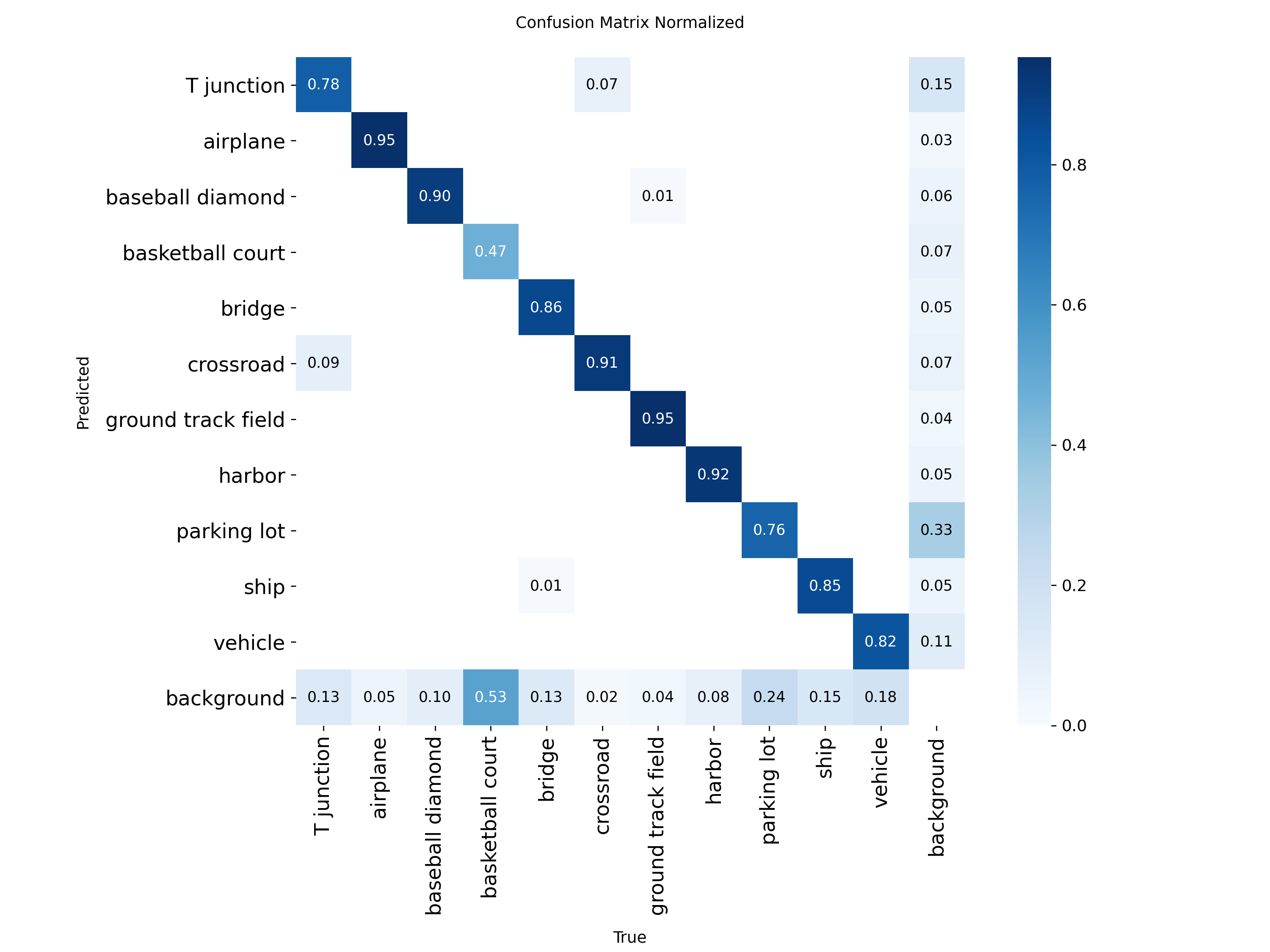

5.3 训练结果

混淆矩阵显示中识别精准度显示是一条对角线,方块颜色越深代表对应的类别识别的精准度越高了,图像显示识别精准度非常高。

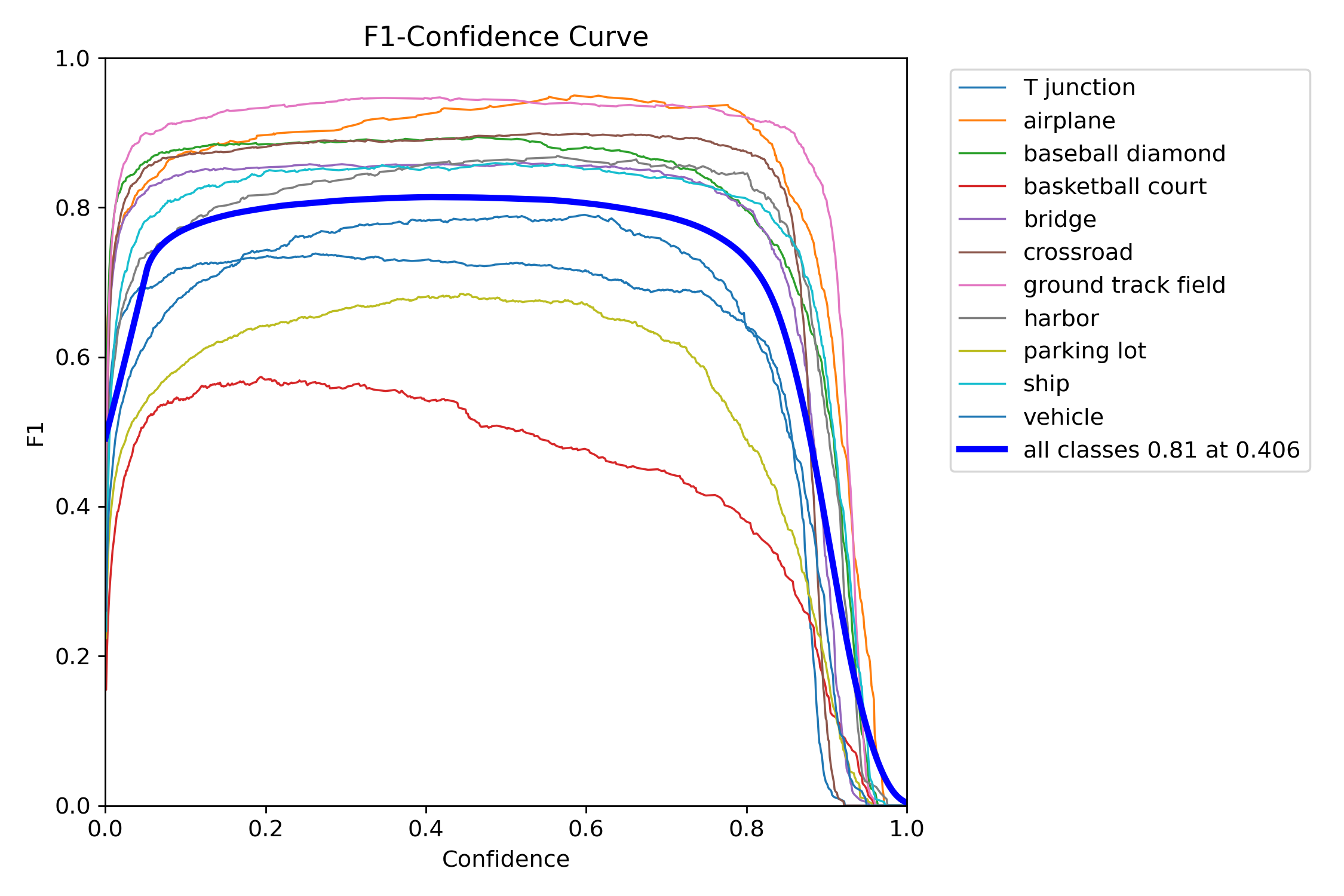

F1指数(F1 Score)是统计学和机器学习中用于评估分类模型性能的核心指标,综合了模型的精确率(Precision)和召回率(Recall),通过调和平均数平衡两者的表现。

当置信度为0406时,所有类别的综合F1值达到了0.81(蓝色曲线)。

mAP@0.5:是目标检测任务中常用的评估指标,表示在交并比(IoU)阈值为0.5时计算的平均精度均值(mAP)。其核心含义是:只有当预测框与真实框的重叠面积(IoU)≥50%时,才认为检测结果正确。

图中可以看到综合mAP@0.5达到了0.849(84.9%),准确率非常高。

6. 源码获取方式

源码获取方式:https://www.bilibili.com/video/BV1AjUsBbEHX

本文实现了一套基于YOLO系列的遥感地面物体检测系统,集成YOLOv5/v8/v11/v12四种模型,支持多模型横向对比与快速切换。系统采用PyQt5构建桌面应用,具备图片/视频/实时摄像头检测功能,提供交互式参数调节和结果分析。通过SQLite实现用户管理,配套训练脚本支持批量自动化训练。实验表明,YOLO12n在精度(mAP40.6%)和效率(6.5B FLOPs)上表现最优,YOLO11n推理速度最快(56.1ms)。系统在11类遥感目标检测任务中取得mAP@0.5达84.9%的优异性能,为遥感智能解译提供了一体化解决方案。

本文实现了一套基于YOLO系列的遥感地面物体检测系统,集成YOLOv5/v8/v11/v12四种模型,支持多模型横向对比与快速切换。系统采用PyQt5构建桌面应用,具备图片/视频/实时摄像头检测功能,提供交互式参数调节和结果分析。通过SQLite实现用户管理,配套训练脚本支持批量自动化训练。实验表明,YOLO12n在精度(mAP40.6%)和效率(6.5B FLOPs)上表现最优,YOLO11n推理速度最快(56.1ms)。系统在11类遥感目标检测任务中取得mAP@0.5达84.9%的优异性能,为遥感智能解译提供了一体化解决方案。

浙公网安备 33010602011771号

浙公网安备 33010602011771号