基于深度学习的35种鸟类检测系统演示与介绍(YOLOv12/v11/v8/v5模型+Pyqt5界面+训练代码+数据集)

视频演示

1. 前言

在自然与科技深度交织的时代,我们对周遭生命的观察与认知,正被算法悄然拓展边界。鸟类作为生态系统中灵动的注脚,其多样性与分布状态不仅是自然研究的课题,更牵动着无数观鸟爱好者、生态保护者的目光。然而,传统的人工观测与识别方式,常受限于经验门槛、效率瓶颈,难以应对复杂场景下的精准捕捉——当镜头掠过林梢、水面或城市绿地,那些转瞬即逝的身影,如何被清晰记录并准确命名?

技术的演进给出了新的可能。计算机视觉领域的目标检测算法,正以“让机器看懂世界”的能力,为生物识别注入新的活力。其中,YOLO系列算法凭借高效的实时性与精准的定位能力,成为连接图像像素与语义信息的关键桥梁。将这一技术落地于鸟类检测场景,不仅能突破人眼观察的局限,更能为生态监测、物种保护乃至科普教育提供可量化的工具支撑。

我们聚焦的这套系统,正是围绕“35种鸟类检测识别”展开的具象实践。它不止于简单的“看见”,更试图构建从图像/视频输入、多源数据处理到结果可视化与交互的全流程能力——无论是单张照片里的驻足身影,还是视频流中的振翅轨迹,抑或是摄像头实时捕捉的动态画面,系统都能快速框定目标、判别种类,并以直观的界面反馈关键信息;而模型切换、参数调节、类别统计与过滤等功能的设计,则让技术更贴近实际使用需求,兼顾灵活性与易用性。此外,从用户登录管理到模型训练支持,从脚本化批量检测到个性化信息维护,系统的功能延伸亦指向更完整的应用闭环,试图让技术真正“可用”“好用”。

接下来,我们将通过功能拆解与实操演示,呈现这套系统如何将YOLO算法的潜力转化为具体的鸟类识别能力,也期待它能为探索自然与科技融合的更多可能,提供一个可触摸的样本。

2. 项目演示

2.1 用户登录界面

登录界面布局简洁清晰,左侧展示系统主题,用户需输入用户名、密码及验证码完成身份验证后登录系统。

2.2 新用户注册

注册时可自定义用户名与密码,支持上传个人头像;如未上传,系统将自动使用默认头像完成账号创建。

2.3 主界面布局

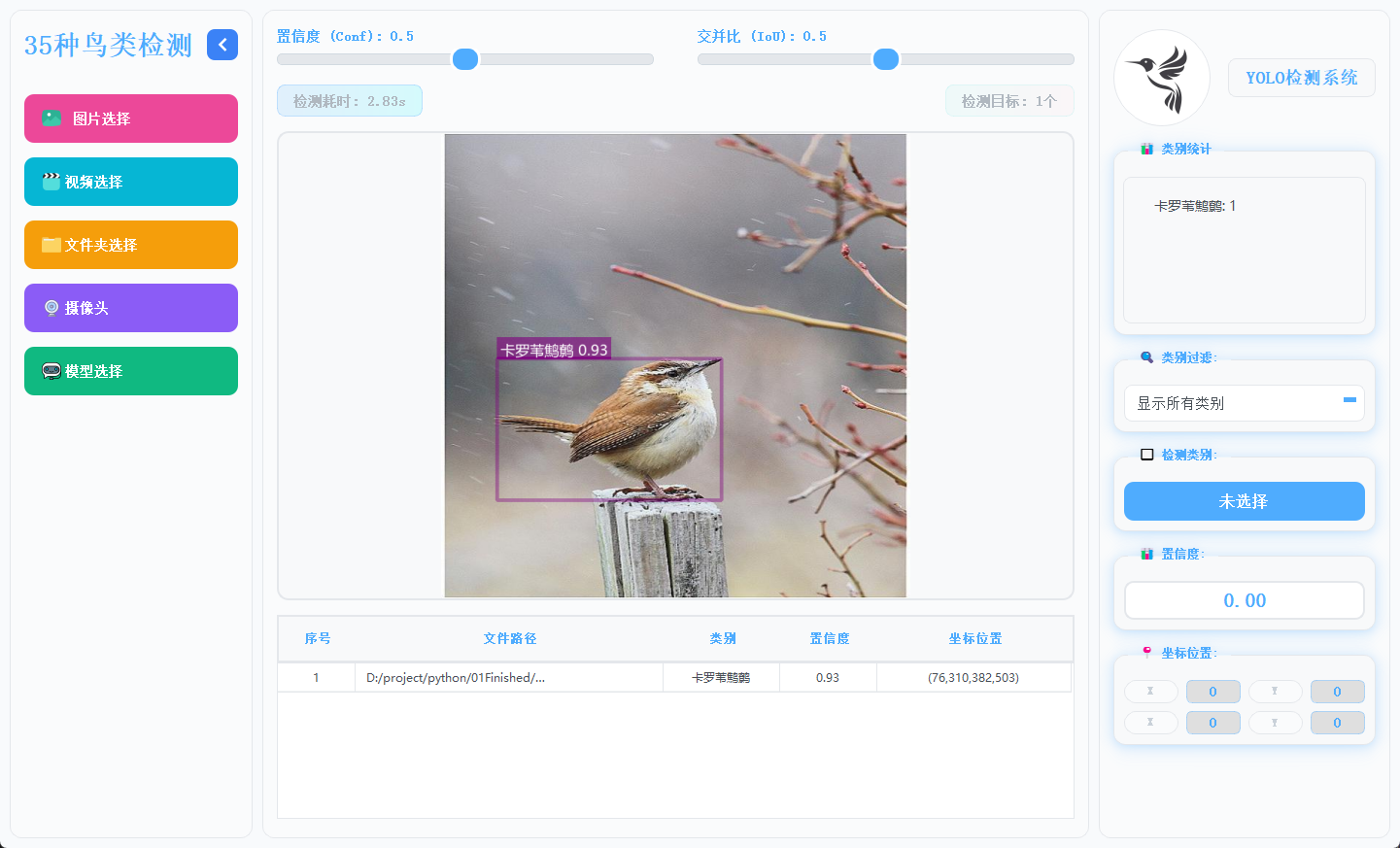

主界面采用三栏结构,左侧为功能操作区,中间用于展示检测画面,右侧呈现目标详细信息,布局合理,交互流畅。

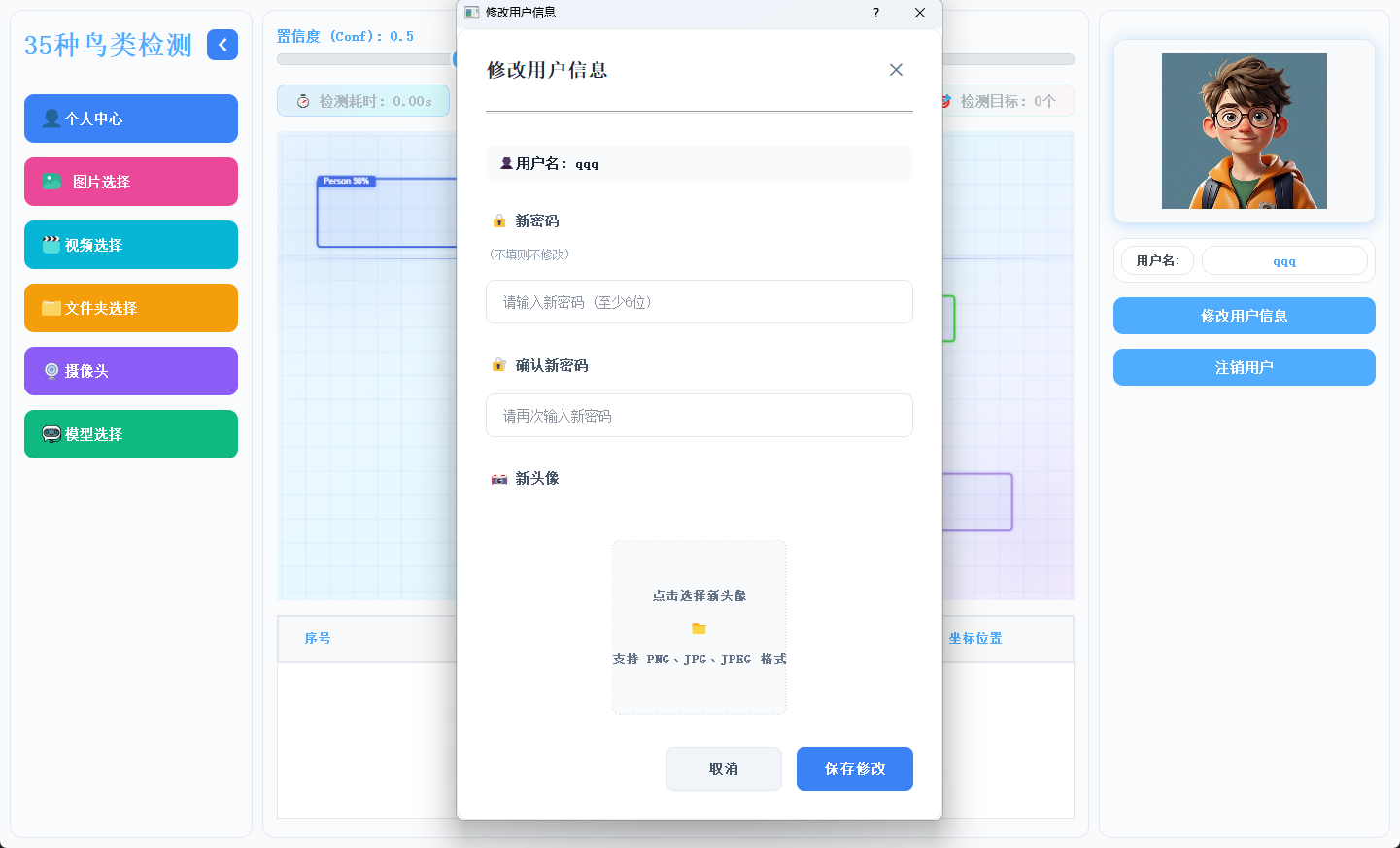

2.4 个人信息管理

用户可在此模块中修改密码或更换头像,个人信息支持随时更新与保存。

2.5 多模态检测展示

系统支持图片、视频及摄像头实时画面的目标检测。识别结果将在画面中标注显示,并在下方列表中逐项列出。点击具体目标可查看其类别、置信度及位置坐标等详细信息。

2.6 多模型切换

系统内置多种已训练模型,用户可根据实际需求灵活切换,以适应不同检测场景或对比识别效果。

3.模型训练核心代码

本脚本是YOLO模型批量训练工具,可自动修正数据集路径为绝对路径,从pretrained文件夹加载预训练模型,按设定参数(100轮/640尺寸/批次8)一键批量训练YOLOv5nu/v8n/v11n/v12n模型。

4. 技术栈

-

语言:Python 3.10

-

前端界面:PyQt5

-

数据库:SQLite(存储用户信息)

-

模型:YOLOv5、YOLOv8、YOLOv11、YOLOv12

5. YOLO模型对比与识别效果解析

5.1 YOLOv5/YOLOv8/YOLOv11/YOLOv12模型对比

基于Ultralytics官方COCO数据集训练结果:

|

模型 |

尺寸(像素) |

mAPval 50-95 |

速度(CPU ONNX/毫秒) |

参数(M) |

FLOPs(B) |

|---|---|---|---|---|---|

|

YOLO12n |

640 |

40.6 |

- |

2.6 |

6.5 |

|

YOLO11n |

640 |

39.5 |

56.1 ± 0.8 |

2.6 |

6.5 |

|

YOLOv8n |

640 |

37.3 |

80.4 |

3.2 |

8.7 |

|

YOLOv5nu |

640 |

34.3 |

73.6 |

2.6 |

7.7 |

关键结论:

-

精度最高:YOLO12n(mAP 40.6%),显著领先其他模型(较YOLOv5nu高约6.3个百分点);

-

速度最优:YOLO11n(CPU推理56.1ms),比YOLOv8n快42%,适合实时轻量部署;

-

效率均衡:YOLO12n/YOLO11n/YOLOv8n/YOLOv5nu参数量均为2.6M,FLOPs较低(YOLO12n/11n仅6.5B);YOLOv8n参数量(3.2M)与计算量(8.7B)最高,但精度优势不明显。

综合推荐:

-

追求高精度:优先选YOLO12n(精度与效率兼顾);

-

需高速低耗:选YOLO11n(速度最快且精度接近YOLO12n);

-

YOLOv5nu/YOLOv8n因性能劣势,无特殊需求时不建议首选。

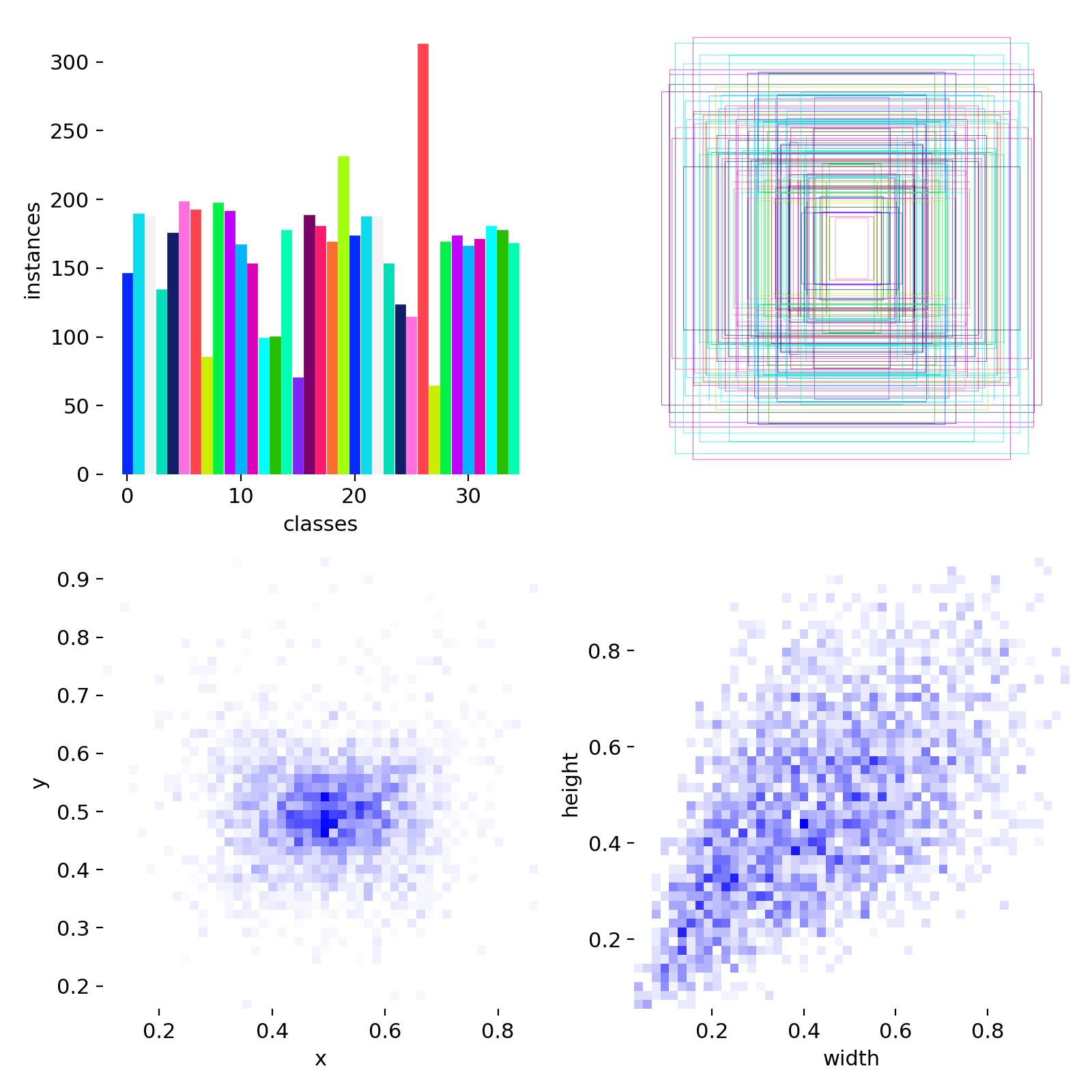

5.2 数据集分析

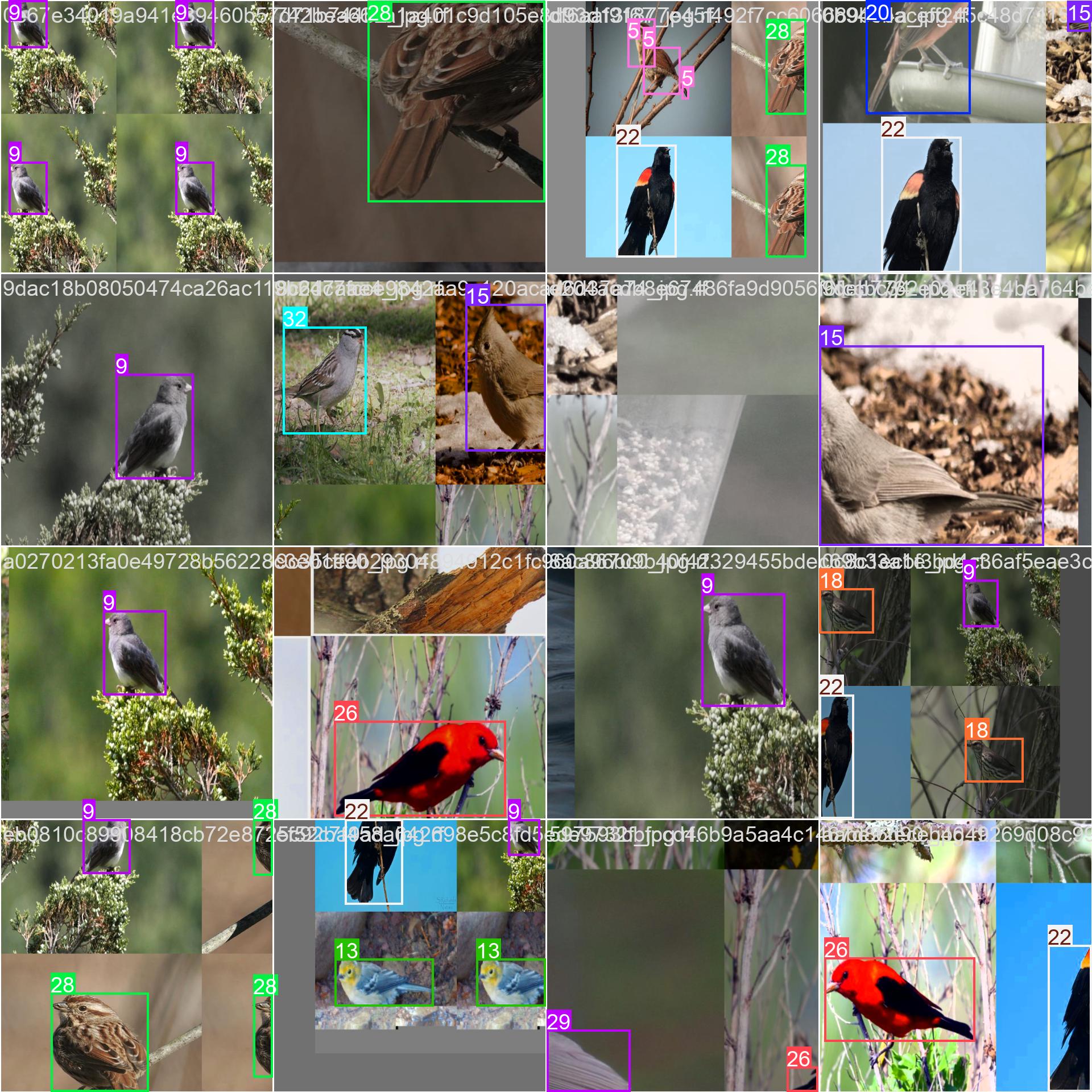

数据集中训练集和验证集一共大概将近4000张图片,数据集目标类别35种鸟类,数据集配置代码如下:

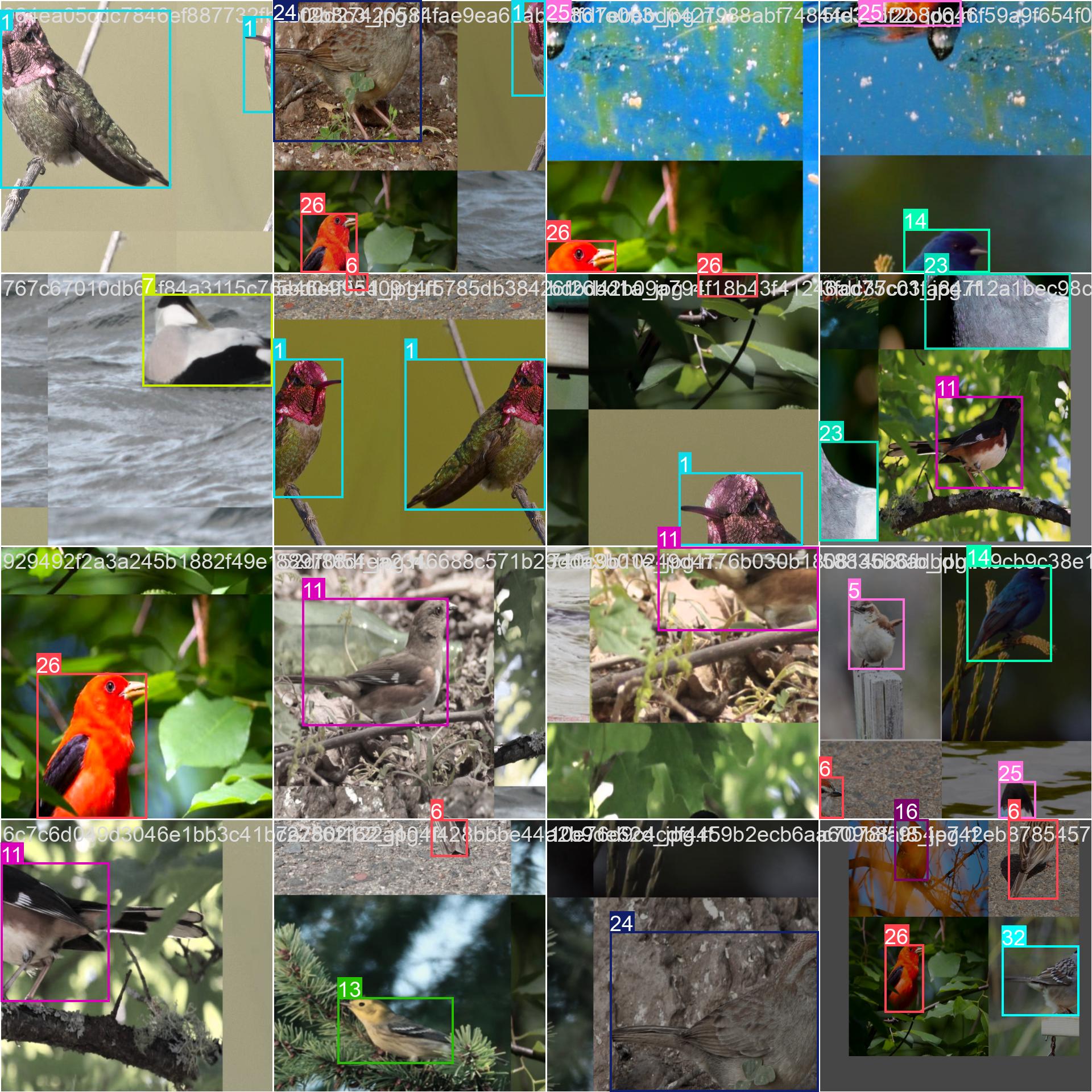

上面的图片就是部分样本集训练中经过数据增强后的效果标注。

5.3 训练结果

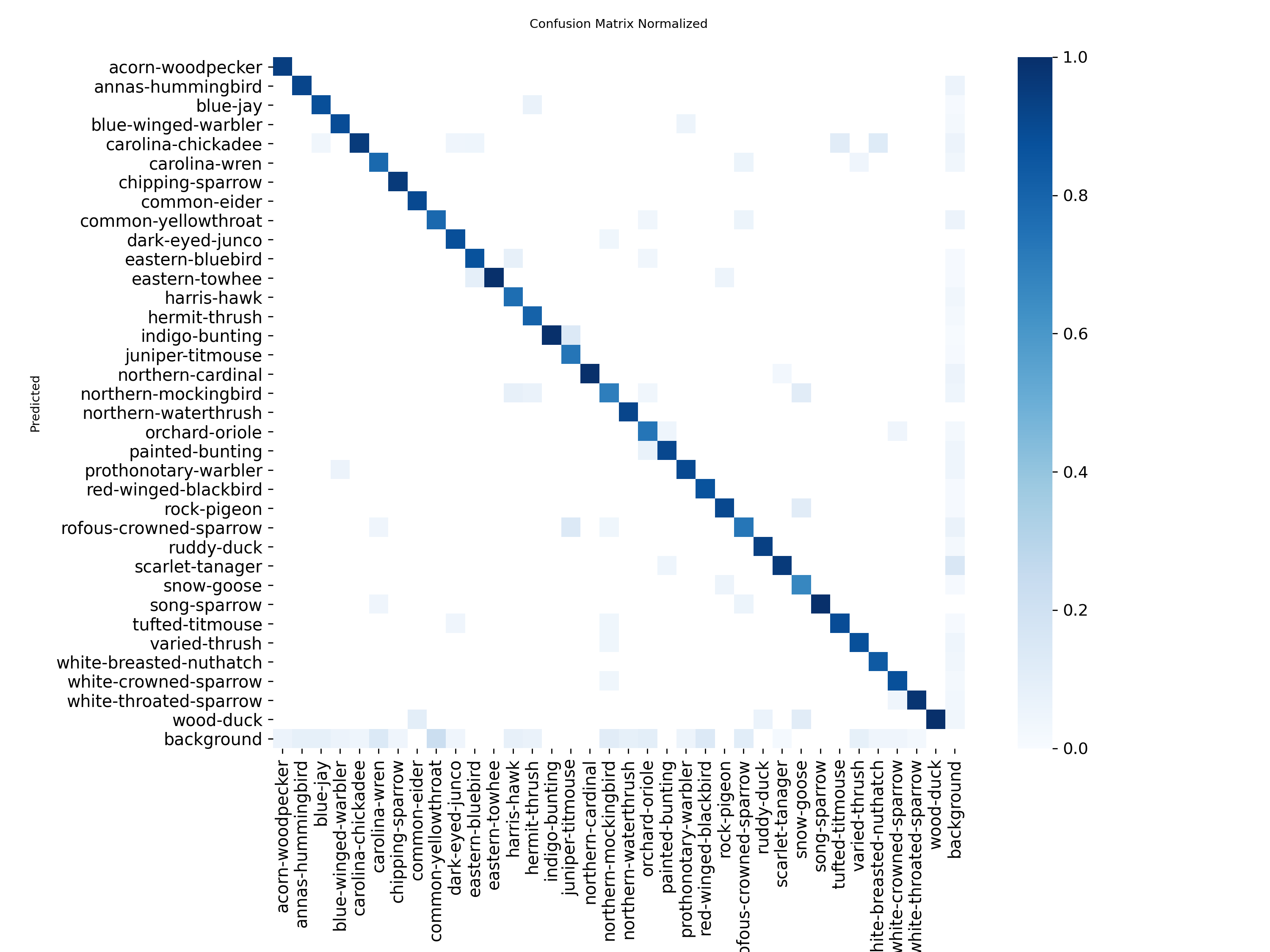

混淆矩阵显示中识别精准度显示是一条对角线,方块颜色越深代表对应的类别识别的精准度越高了,图像显示识别精准度非常高。

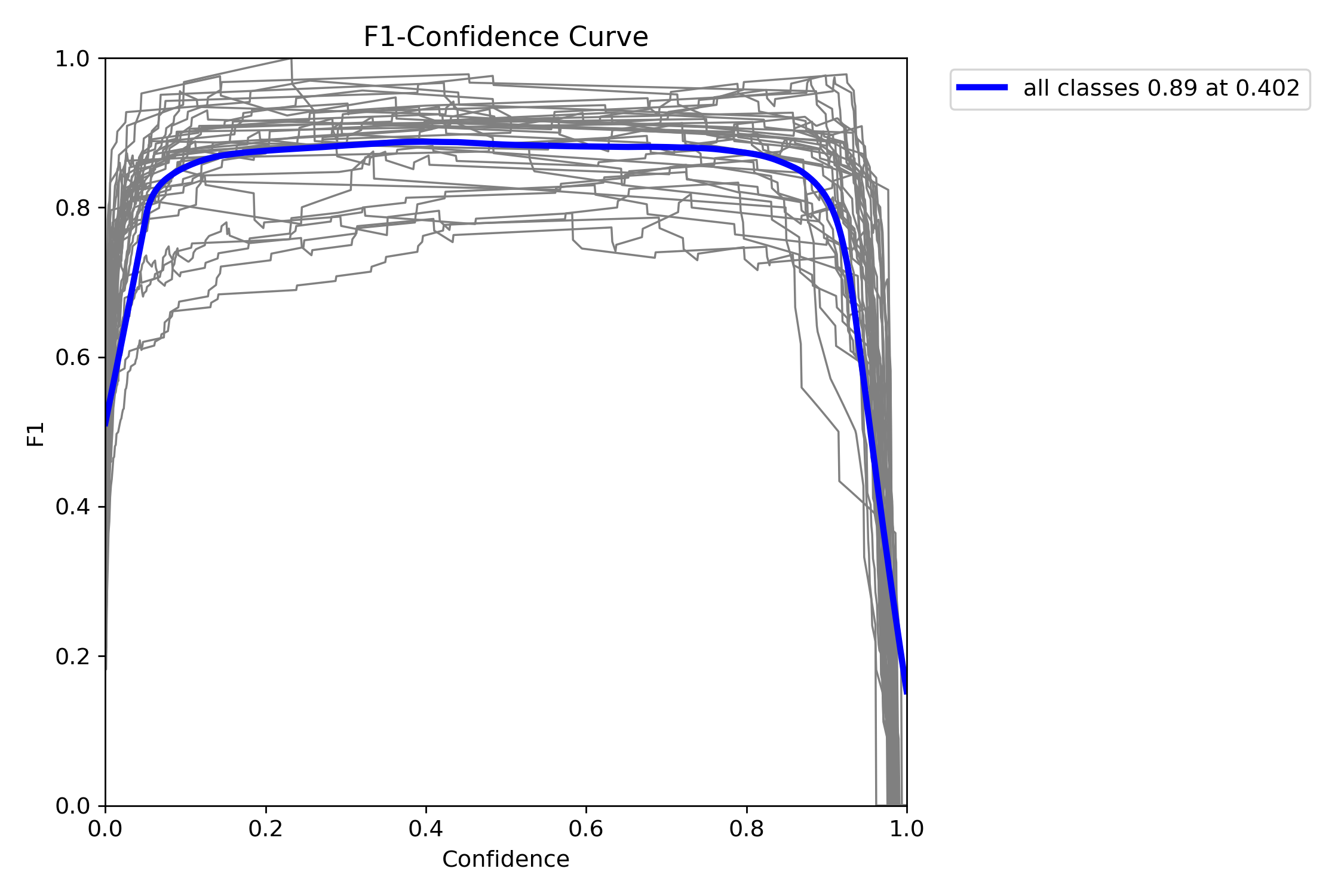

F1指数(F1 Score)是统计学和机器学习中用于评估分类模型性能的核心指标,综合了模型的精确率(Precision)和召回率(Recall),通过调和平均数平衡两者的表现。

当置信度为0.402时,所有类别的综合F1值达到了0.89(蓝色曲线)。

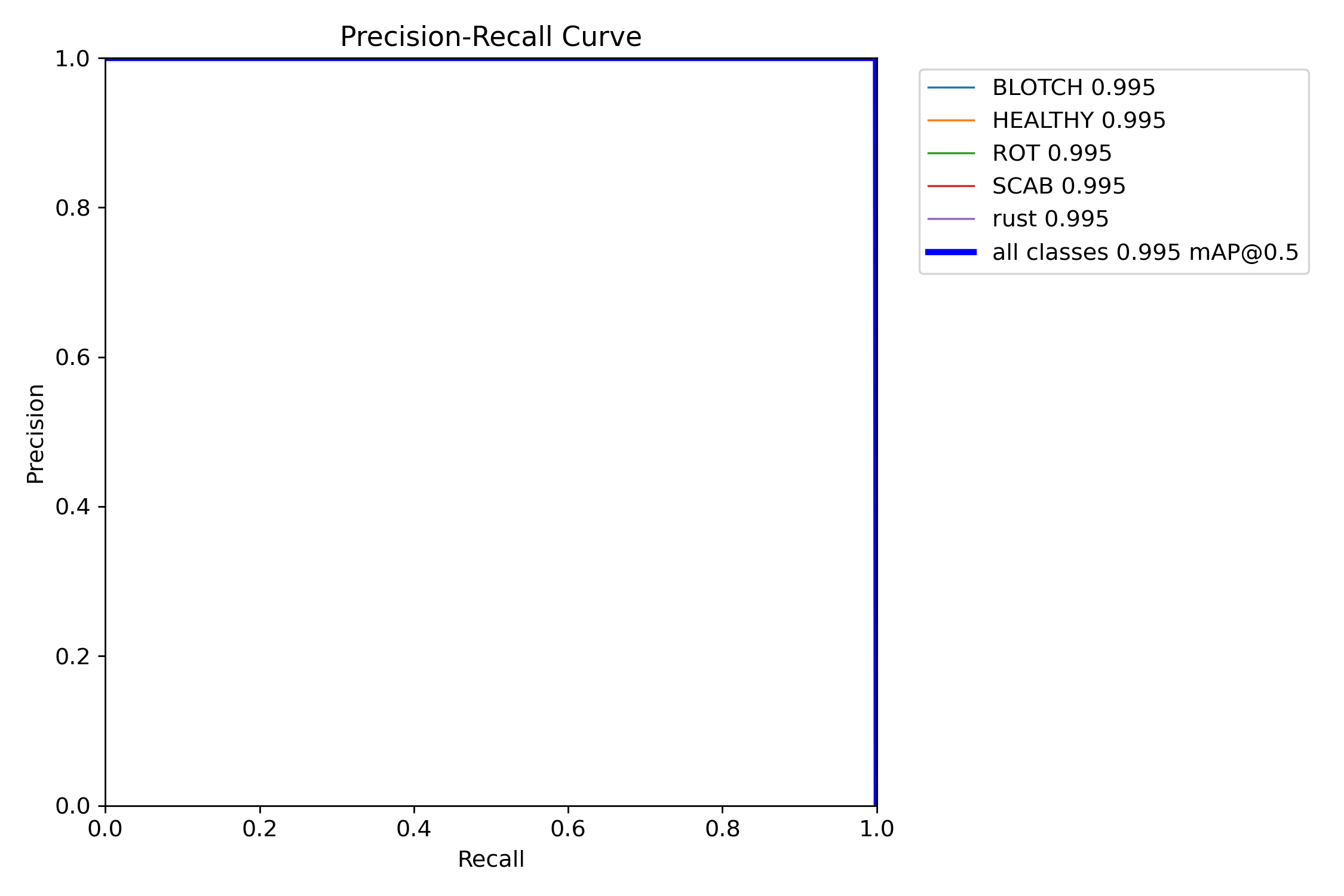

mAP@0.5:是目标检测任务中常用的评估指标,表示在交并比(IoU)阈值为0.5时计算的平均精度均值(mAP)。其核心含义是:只有当预测框与真实框的重叠面积(IoU)≥50%时,才认为检测结果正确。

图中可以看到综合mAP@0.5达到了0.995(99.5%),准确率非常高。

源码获取方式:https://www.bilibili.com/video/BV1EACiBgEi7

本文介绍了一个基于YOLO系列算法的鸟类识别系统,支持35种鸟类的实时检测。系统采用Python3.10开发,前端界面使用PyQt5,数据库为SQLite。通过对比YOLOv5/v8/v11/v12模型性能,发现YOLO12n精度最高(mAP40.6%),YOLO11n速度最优(56.1ms)。系统功能包括多模态检测(图片/视频/摄像头)、模型切换、用户管理等,在4000张图片的数据集上训练后,mAP@0.5达到99.5%。该技术为生态监测和科普教育提供了高效工具。

本文介绍了一个基于YOLO系列算法的鸟类识别系统,支持35种鸟类的实时检测。系统采用Python3.10开发,前端界面使用PyQt5,数据库为SQLite。通过对比YOLOv5/v8/v11/v12模型性能,发现YOLO12n精度最高(mAP40.6%),YOLO11n速度最优(56.1ms)。系统功能包括多模态检测(图片/视频/摄像头)、模型切换、用户管理等,在4000张图片的数据集上训练后,mAP@0.5达到99.5%。该技术为生态监测和科普教育提供了高效工具。

浙公网安备 33010602011771号

浙公网安备 33010602011771号