Pytorch

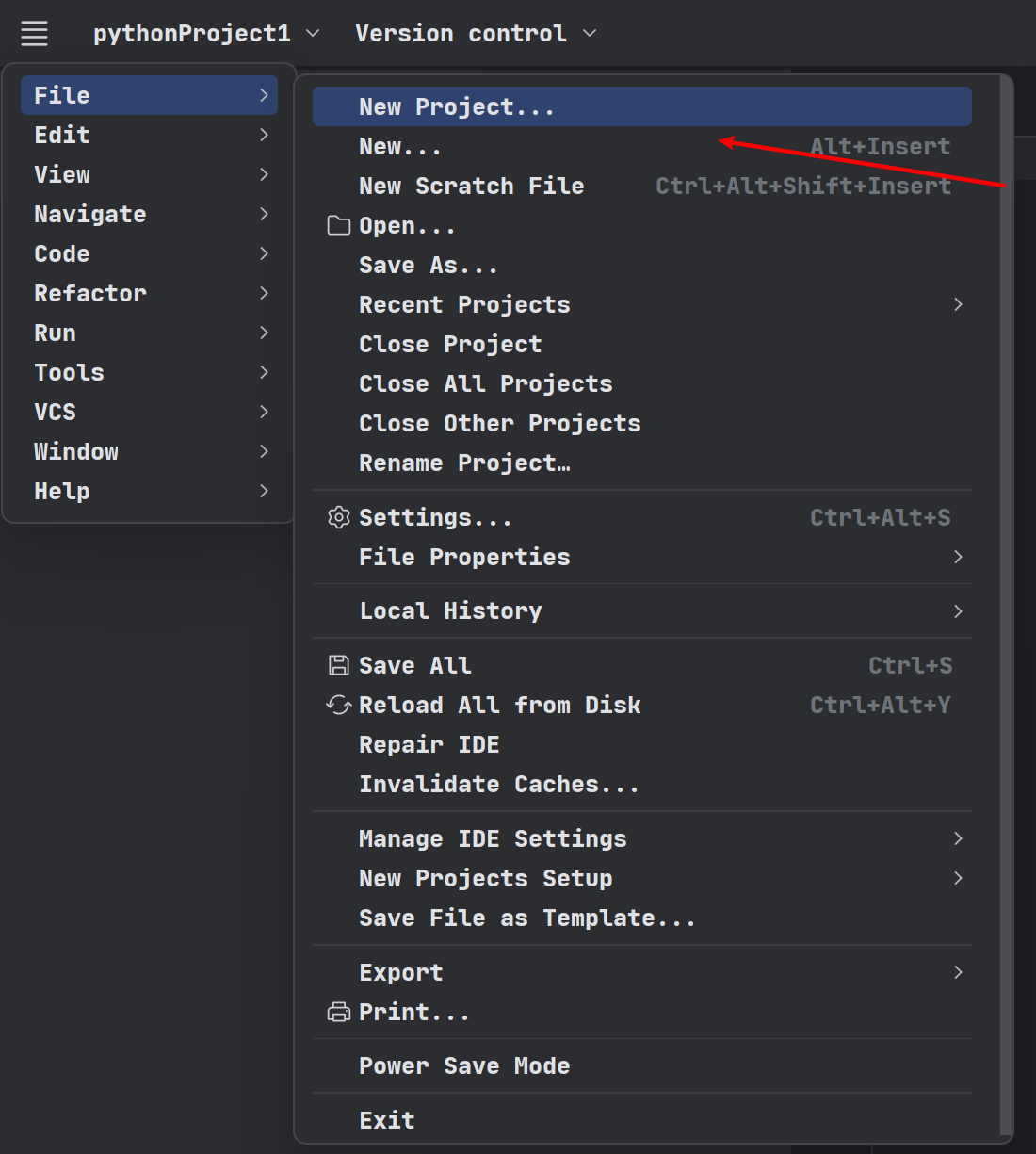

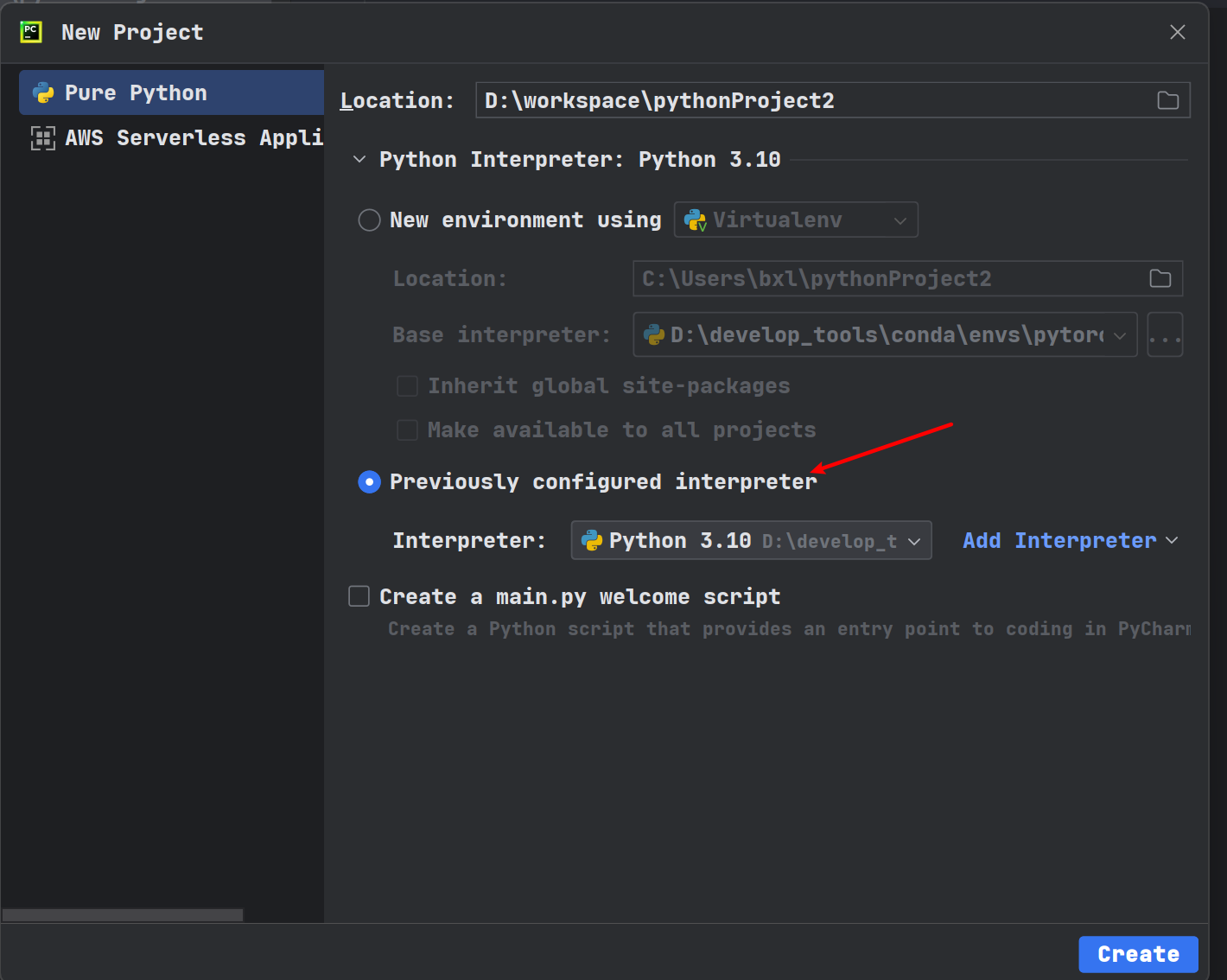

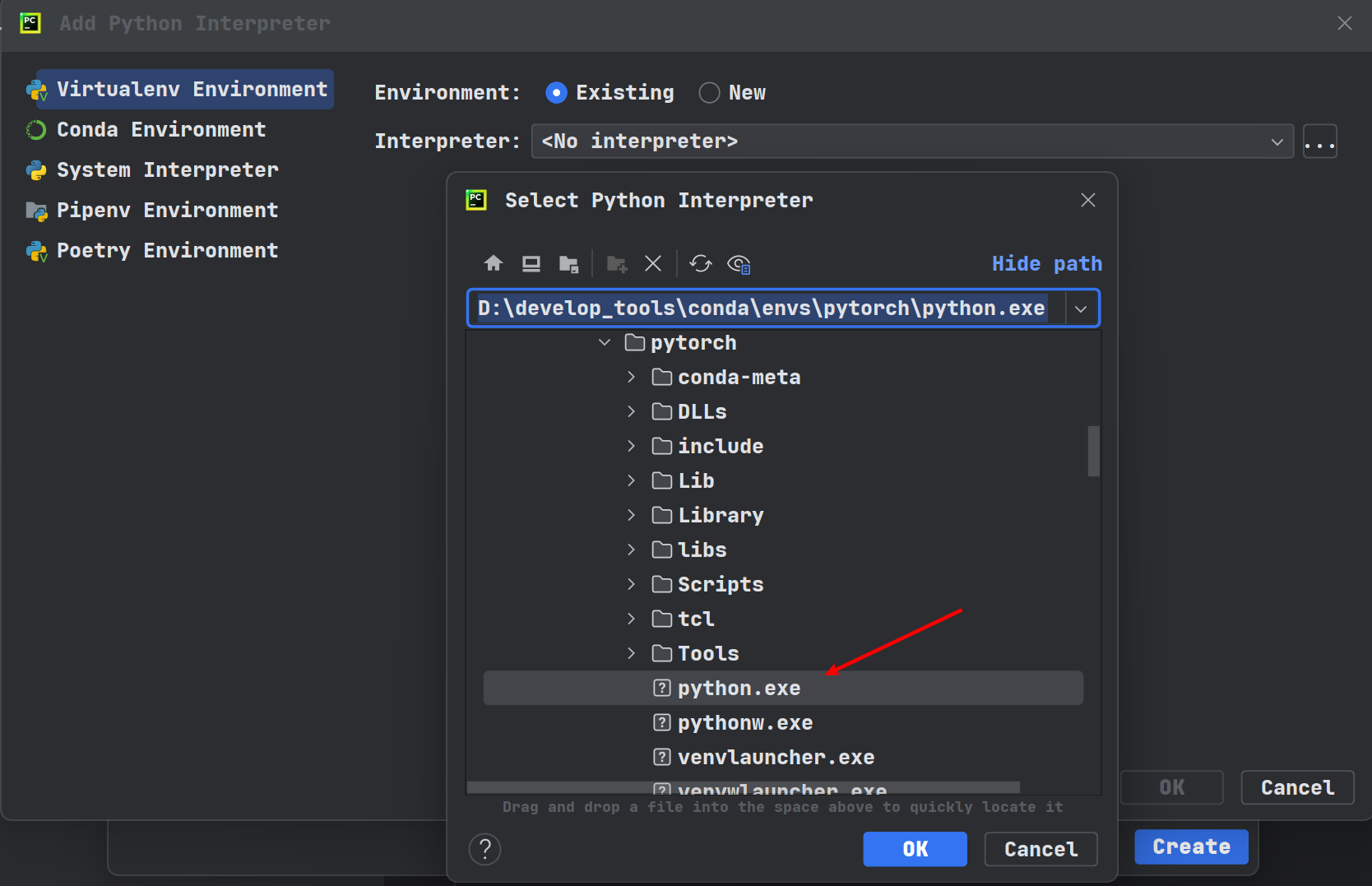

损失函数(Loss Function)创建项目的方式

conda create -n 环境名称 python版本

DataSet类代码实战

read_data.py

from torch.utils.data import Dataset

from PIL import Image

import os

class MyData(Dataset):

def __init__(self, root_dir, label_dir):

self.root_dir = root_dir

self.label_dir = label_dir

# 将两个路径进行拼接

self.path = os.path.join(self.root_dir, self.label_dir)

# 将文件夹下的内容变成列表

self.img_path = os.listdir(self.path)

# 在python中__getitem__(self, key):方法被称为魔法方法,这个方法返回所给键对应的值。

# 1 当对象是序列时,键是整数。当对象是映射时(字典),键是任意值

# 2 在定义类时,如果希望能按照键取类的值,则需要定义__getitem__方法

# 3 如果给类定义了__getitem__方法,则当按照键取值时,可以直接返回__getitem__方法执行的结果

def __getitem__(self, idx):

img_name = self.img_path[idx]

# 相对于这个程序的相对路径

img_item_path = os.path.join(self.root_dir, self.label_dir, img_name)

img = Image.open(img_item_path)

label = self.label_dir

return img, label

def __len__(self):

# 返回列表长度

return len(self.img_path)

root_dir = "dataset/train"

ants_label_dir = "ants"

bees_label_dir = "bees"

ants_dataset = MyData(root_dir, ants_label_dir)

bees_dataset = MyData(root_dir, bees_label_dir)

train_dataset = ants_dataset + bees_dataset

rename_dataset.py

import os

root_dir = "dataset/train"

target_dir = "ants_image"

img_path = os.listdir("D:\\workspace\\learn_pytorch\\" + os.path.join(root_dir, target_dir))

print(img_path)

label = target_dir.split('_')[0]

print(label)

out_dir = "ants_label"

for i in img_path:

file_name = i.split('.jpg')[0]

# with open("D:\\workspace\\learn_pytorch\\" + os.path.join(root_dir, out_dir, "{}.txt").format(file_name), 'w') as f:

with open("D:\\workspace\\learn_pytorch\\" + os.path.join(root_dir, out_dir+f'{file_name}.txt'), 'w') as f:

f.write(label)

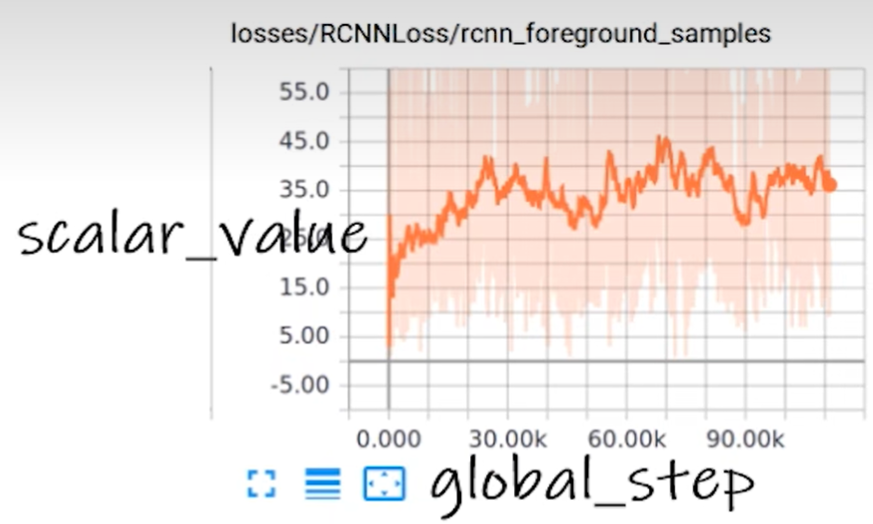

TensorBoard的使用

tensorboard的用途

tensorboard可以用来查看loss是否能够按照我们预想的变化,或者查看训练到某一步输出的图像是什么样子的。

tensorboard写日志

from tensorboardX import SummaryWriter

writer = SummaryWriter("logs") # 创建一个logs文件夹,writer写的文件都在该文件夹下

#writer.add_image()

for i in range(100):

writer.add_scalar("y=2x",2*i,i)

writer.close()

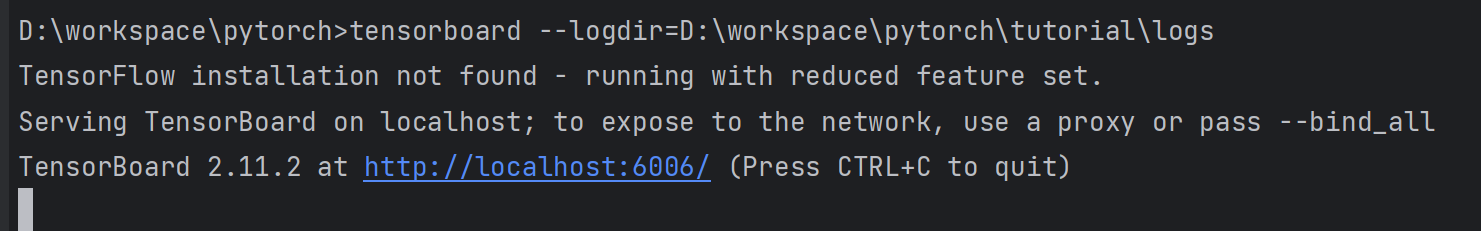

tensorboard读日志

① 在 Anaconda 终端里面,激活py环境(conda activate pytorch),再输入 tensorboard --logdir=D:/workspace/pytorch/transform/logs 命令,将网址赋值浏览器的网址栏,回车,即可查看tensorboard显示日志情况。

② 为避免多人使用端口导致冲突,也可以在后面加上后缀,使得端口独立,tensorboard --logdir=D:\workspace\pytorch\transform\logs --port=6007

③ 输入网址可得Tensorboard界面。

tensorboard读取图片

from torch.utils.tensorboard import SummaryWriter

from PIL import Image

import numpy as np

img_path1 = "Data/FirstTypeData/train/ants/0013035.jpg"

img_PIL1 = Image.open(img_path1)

img_array1 = np.array(img_PIL1)

img_path2 = "Data/SecondTypeData/train/bees_image/17209602_fe5a5a746f.jpg"

img_PIL2 = Image.open(img_path2)

img_array2 = np.array(img_PIL2)

writer = SummaryWriter("logs")

writer.add_image("test",img_array1,1,dataformats="HWC") # 1 表示该图片在第1步

writer.add_image("test",img_array2,2,dataformats="HWC") # 2 表示该图片在第2步

writer.close()

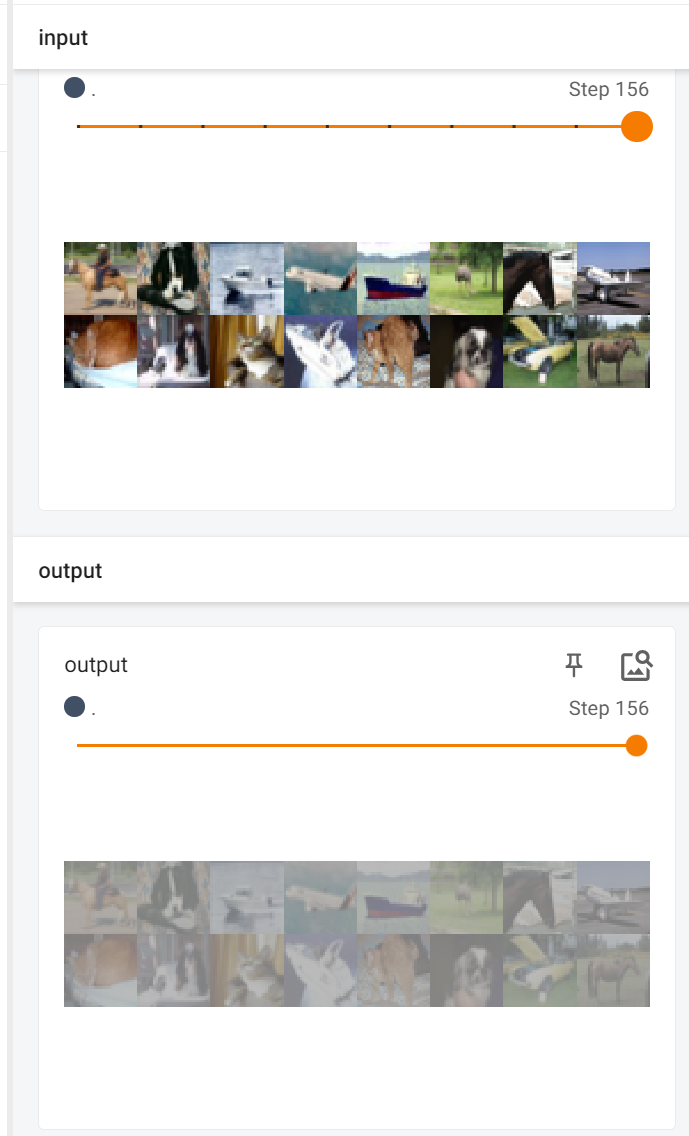

在terminal中输入tensorboard --logdir=D:\workspace\pytorch\transboard\logs --port=6007后运行效果如下:

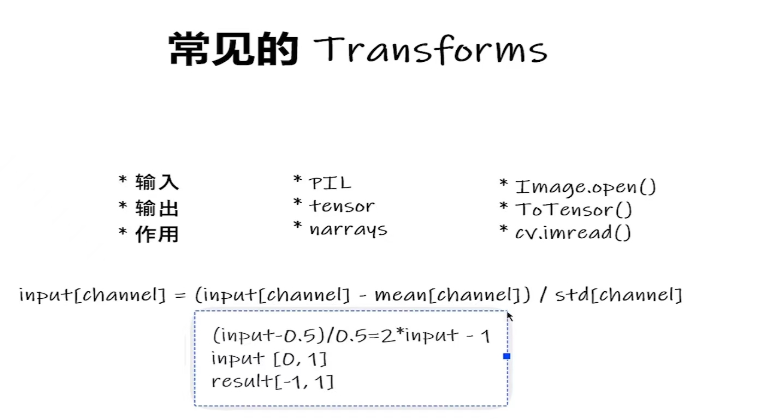

torchvision中的transforms

transforms的用途

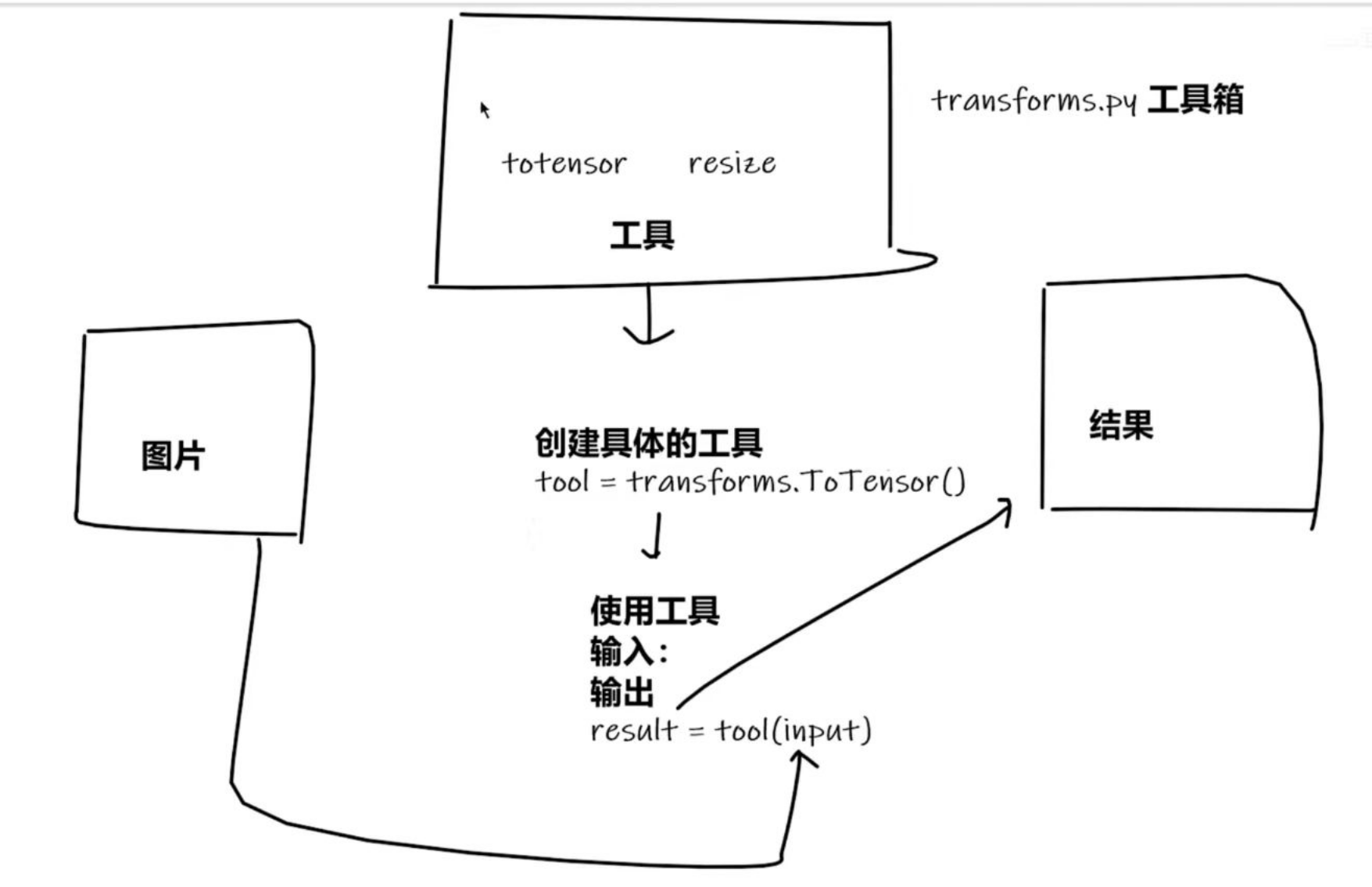

①transforms当成工具箱的话,里面的class就是不同的工具。例如像tensor、resize这些工具。

②transforms拿一些特定格式的图片,经过transforms里面的工具,获得我们想要的结果。

transforms结构及用法

transform的图示

from PIL import Image

from torchvision import transforms

# from torch.utils.tensorboard import SummaryWriter

from tensorboardX import SummaryWriter

# python的用法->tensor数据类型

img_path = "D:/workspace/pytorch-learn/dataset/train/bees_image/16838648_415acd9e3f.jpg"

img = Image.open(img_path)

writer = SummaryWriter("logs")

# 1、transforms该如何使用(python)

# 2、为什么我们需要tensor数据类型

tensor_trans = transforms.ToTensor() # 创建transforms.ToTensor类的实例化对象

tensor_img = tensor_trans(img) # 调用transforms.ToTensor类的__call__的魔术方法

print(tensor_img)

writer.add_image("Tensor_img", tensor_img)

writer.close()

运行效果如下:

tensor([[[0.0980, 0.0863, 0.0902, ..., 0.0314, 0.0314, 0.0431],

[0.0784, 0.0863, 0.0863, ..., 0.0235, 0.0196, 0.0196],

[0.0510, 0.0784, 0.0863, ..., 0.0431, 0.0353, 0.0392],

...,

[0.7765, 0.7804, 0.6941, ..., 0.7529, 0.7333, 0.7804],

[0.6784, 0.8000, 0.7529, ..., 0.7490, 0.7098, 0.7961],

[0.7882, 0.7176, 0.6431, ..., 0.7373, 0.6824, 0.7529]],

[[0.0863, 0.0667, 0.0667, ..., 0.0706, 0.0706, 0.0667],

[0.0824, 0.0863, 0.0824, ..., 0.0510, 0.0471, 0.0392],

[0.0863, 0.1020, 0.0941, ..., 0.0510, 0.0431, 0.0392],

...,

[0.8980, 0.9137, 0.8392, ..., 0.8941, 0.8510, 0.8745],

[0.7882, 0.9020, 0.8510, ..., 0.8627, 0.8118, 0.8902],

[0.8980, 0.8196, 0.7412, ..., 0.8510, 0.7843, 0.8471]],

[[0.1216, 0.0902, 0.0667, ..., 0.0392, 0.0392, 0.0510],

[0.0980, 0.0941, 0.0745, ..., 0.0235, 0.0196, 0.0235],

[0.0667, 0.0863, 0.0745, ..., 0.0314, 0.0235, 0.0314],

...,

[0.9176, 0.9529, 0.9098, ..., 0.9490, 0.8941, 0.9137],

[0.8353, 0.9608, 0.9294, ..., 0.9255, 0.8627, 0.9294],

[0.9451, 0.8784, 0.8196, ..., 0.9137, 0.8353, 0.8863]]])

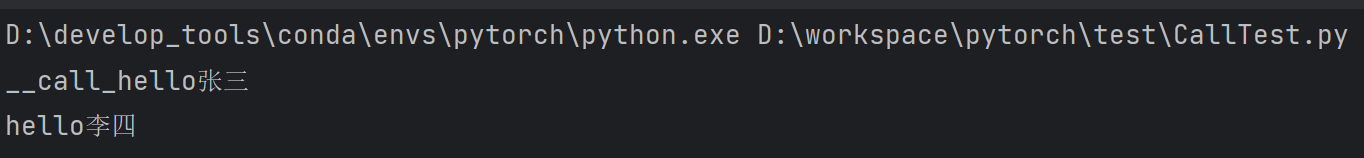

扩展:python中_call_()的使用

class Person:

def __call__(self, name):

print("__call_" + "hello" + name)

def hello(self, name):

print("hello" + name)

person = Person()

person("张三") # 内置call不用.,可直接通过对象进行调用

person.hello("李四") # 通过对象.方法进行调用

运行效果如下:

transforms.Tensor的使用

from PIL import Image

from tensorboardX import SummaryWriter

from torchvision import transforms

writer = SummaryWriter("logs")

# 读取图片

img = Image.open("../images/pytorch.jpg")

print(img)

# ToTensor的使用

# """Convert a ``PIL Image`` or ``numpy.ndarray`` to tensor.

trans_totensor = transforms.ToTensor()

img_tensor = trans_totensor(img)

writer.add_image("ToTensor", img_tensor)

writer.close()

测试环境如下,在terminal下输入tensorboard --logdir=D:/workspace/pytorch/transform/logs,即可在TensorBoard中显示图片的形状,运行效果如下

Normalize的使用(归一化)

# Normalize的使用(归一化)

# """Normalize a tensor image with mean and standard deviation.

print(img_tensor[0][0][0])

trans_norm = transforms.Normalize([5, 2, 6], [6, 3, 4])

img_norm = trans_norm(img_tensor)

print(img_norm[0][0][0])

writer.add_image("Normalize", img_norm, 2)

writer.close()

Resize()的使用

# Resize

print(img.size)

trans_resize = transforms.Resize((512, 512))

# img PTL -> resize -> img_resize PIL

img_resize = trans_resize(img)

# img_resize PIL -> totensor ->img_resize tensor

img_resize = trans_totensor(img_resize)

writer.add_image("Resize", img_resize, 0)

print(img_resize) # <PIL.Image.Image image mode=RGB size=512x512 at 0x226457A8708>

测试环境如下,在terminal下输入tensorboard --logdir=D:\workspace\pytorch\transform\logs,即可在TensorBoard中显示图片的形状,运行效果如下

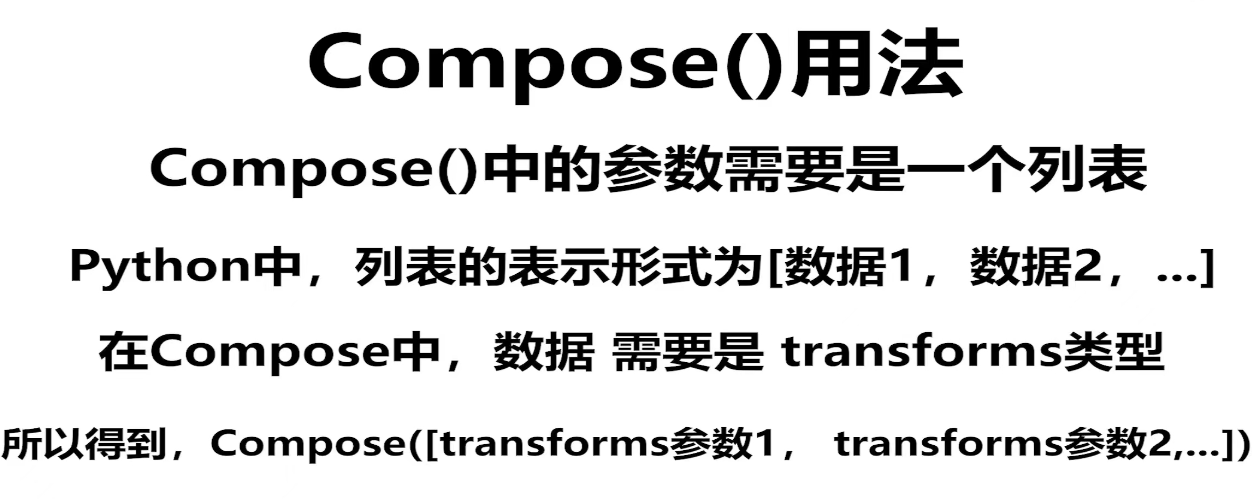

Compose()的使用

# compose - resize - 2 等比缩放

trans_resize_2 = transforms.Resize(512)

# PIL->PIL->tensor

trans_compose = transforms.Compose([trans_resize_2, trans_totensor])

img_resize_2 = trans_compose(img)

writer.add_image("Resize", img_resize_2, 1)

测试环境如下,在terminal下输入tensorboard --logdir=D:\workspace\pytorch\transform\logs,即可在TensorBoard中显示图片的形状,运行效果如下

# RandomCrop

trans_random = transforms.RandomCrop(120)

print(type(trans_random))

trans_compose_2 = transforms.Compose([trans_random, trans_totensor])

for i in range(10):

img_crop = trans_compose_2(img)

writer.add_image("RandomCrop", img_crop, i)

测试环境如下,在terminal下输入tensorboard --logdir=D:\workspace\pytorch\transform\logs,即可在TensorBoard中显示图片的形状,运行效果如下

总结使用方法

- 关注输入和输出类型

- 多看官网文档

- 关注方法需要什么参数

不知道返回值的时候

- print(type)

- debug

torchvision中数据集的使用

torchvision数据集介绍

①torchvision中有很多数据集,当我们写代码是指定相应的数据集指定一些参数,它就可以自行下载。

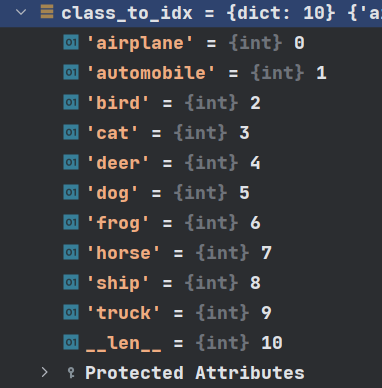

②CIFAR-10数据集包含60000张32x32的彩色图片,一共10个类别,其中50000张训练图片,10000张测试图片。

import torchvision

train_set = torchvision.datasets.CIFAR10(root="./dataset", train=True, download=True)

test_set = torchvision.datasets.CIFAR10(root="./dataset", train=False, download=True)

print(test_set[0])

print(test_set.classes)

img, target = test_set[0]

print(img)

print(target)

print(test_set.classes[target])

img.show()

输出结果如下:

(<PIL.Image.Image image mode=RGB size=32x32 at 0x1DC5F0EE7C8>, 3)

['airplane', 'automobile', 'bird', 'cat', 'deer', 'dog', 'frog', 'horse', 'ship', 'truck']

<PIL.Image.Image image mode=RGB size=32x32 at 0x1DC5F101CC8>

3

cat

tensorboard查看内容

import torchvision

from tensorboardX import SummaryWriter

dataset_transform = torchvision.transforms.Compose([torchvision.transforms.ToTensor()])

train_set = torchvision.datasets.CIFAR10(root="./dataset", train=True, transform=dataset_transform, download=True) # 将ToTensor应用到数据集中的每一张图片,每一张图片转为Tensor数据类型

test_set = torchvision.datasets.CIFAR10(root="./dataset", train=False, transform=dataset_transform, download=True)

writer = SummaryWriter("logs")

for i in range(10):

img, target = test_set[i]

writer.add_image("test_set", img, i)

print(img.size())

writer.close() # 一定要把读写关闭,否则显示不出来图片

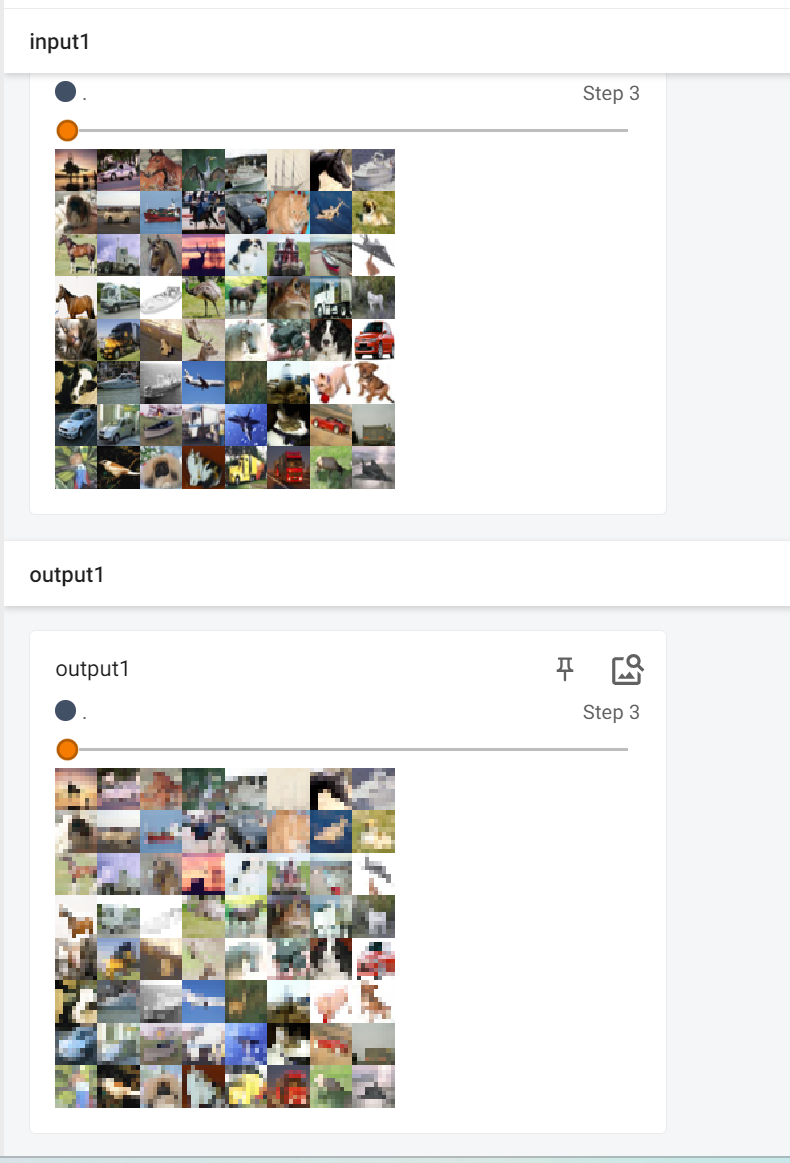

运行效果如下:

Files already downloaded and verified

Files already downloaded and verified

torch.Size([3, 32, 32])

torch.Size([3, 32, 32])

torch.Size([3, 32, 32])

torch.Size([3, 32, 32])

torch.Size([3, 32, 32])

torch.Size([3, 32, 32])

torch.Size([3, 32, 32])

torch.Size([3, 32, 32])

torch.Size([3, 32, 32])

torch.Size([3, 32, 32])

DataLoader的使用

DataLoad的用途

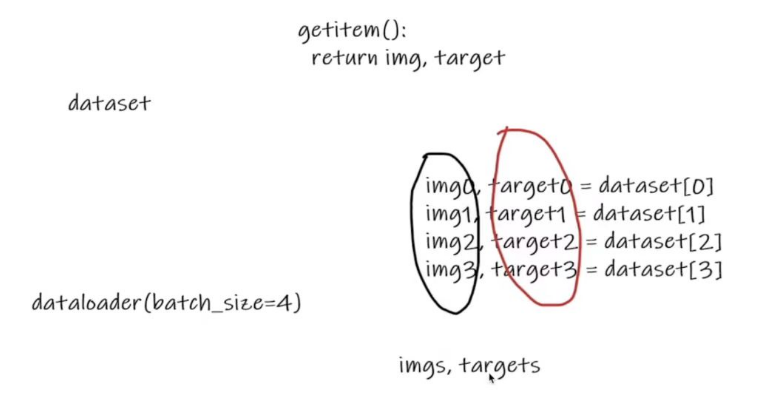

①DataSet只是去告诉程序,数据集的位置在哪里,数据集第一个数据给它一个索引0,它对应的是第一个数据。

②DataLoader就是把数据加载到神经网络当中,DataLoader所做的事就是每次从DataSet中取出数据,至于怎么取数据,是由DataLoader中的参数决定的。

import torchvision.datasets

from torch.utils.data import DataLoader

from tensorboardX import SummaryWriter

# 准备的测试数据集

test_data = torchvision.datasets.CIFAR10("../torchvision_with_DataSet/dataset", train=False, transform=torchvision.transforms.ToTensor())

# batch_size=4使得img0,target0=dataset[0]、img1, target1 = dataset[1]、img2, target2 = dataset[2]、img3, target3 = dataset[3],然后这四个数据作为Dataloader的一个返回

# drop_last:设置为True,当最后一次设置的数据集不满足batch_size的时候,这时候这些数据就会被舍弃;设置为False,就不会被舍弃

# shuffle:设置为True,tensorboard显示相同的step不会被打乱,设置为False,tensorboard显示相同的step会被打乱

test_loader = DataLoader(dataset=test_data, batch_size=64, shuffle=True, num_workers=0, drop_last=True)

# 测试数据集中第一张图片及target

img, target = test_data[0]

print(img.shape) # torch.Size([3, 32, 32])

print(target) # 3

writer = SummaryWriter("dataloader")

for epoch in range(2):

step = 0

for data in test_loader:

imgs, targets = data # 每个data都是由4张图片组成,imgs.size 为 [4,3,32,32],四张32×32图片三通道,targets由四个标签组成

writer.add_images("epoch:{}".format(epoch), imgs, step)

step += 1

# print(imgs.shape)

# print(targets)

writer.close()

小tips:将图片的路径放置到

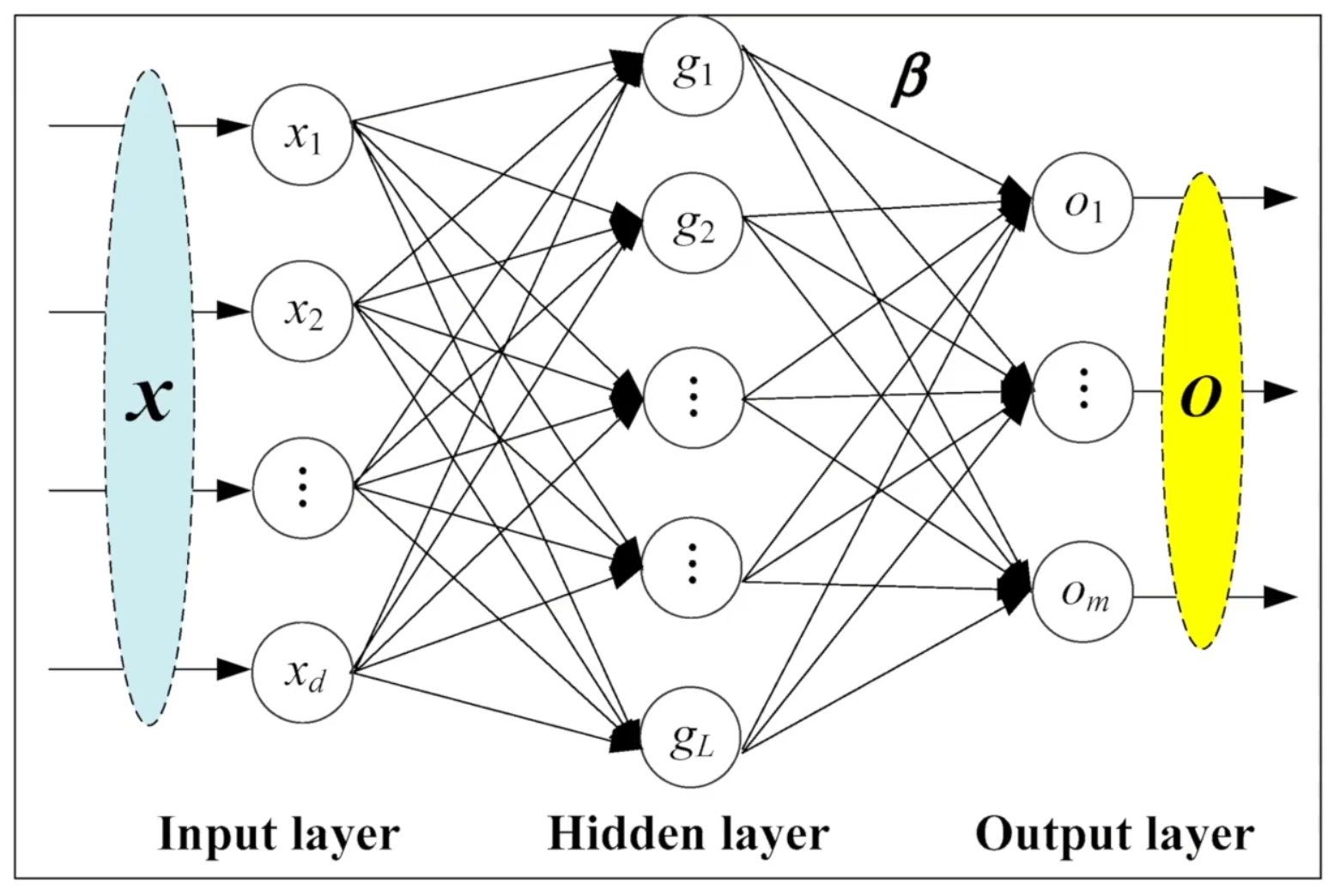

神经网络的基本骨架

nn.Module模块使用

①nn.Module是对所有神经网络提供的一个基本的类

②我们的神经网络是继承nn.Module这个类,即nn.Module为父类,nn.Module为所有神经网络提供一个模板,对其中一些我们不满意的部分进行修改。

import torch

from torch import nn

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__() # 继承父类的初始化

def forward(self, input): # 将forward函数进行重写

output = input + 1

return output

tudui = Tudui()

x = torch.tensor(1.0) # 创建一个值为 1.0 的tensor

output = tudui(x)

print(output)

super(Myclass, self)._init_()

①简单理解就是子类把父类的_init_()放到自己的_init_()中,这样子类就有了父类的_init_()的那些东西

②myclass类继承nn.Module,super(Myclass, self).init()就是对继承自父类nn.Module的属性进行初始化。而且是用nn.Module的初始化方法来初始化继承的属性。

③super()._init_()来通过初始化父类属性以初始化自身继承了父类的那部分属性,这样一来,作为nn.Module的子类就无序再初始化那一部分属性了,只需要初始化新加的元素。

④子类继承了父类的所有属性和方法,父类属性自然会用父类方法来进行初始化。

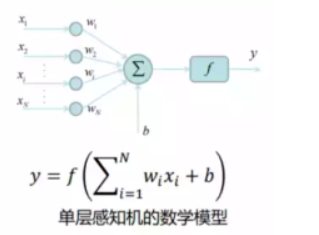

forward函数

①使用pytorch的时候,不需要手动调用forward函数,只要在实例化一个对象中传入对应的参数就可以自动调用forward函数。

②因为pytorch中的大部分方法都继承自torch.nn.Module,而torch.nn.Module的_call_(self)函数中会返回forward()函数的结果,因此pytorch中的forward()函数等于是被嵌套在了call(self)函数中;因此forward()函数可以直接通过类名被调用,而不用实例化对象

卷积操作

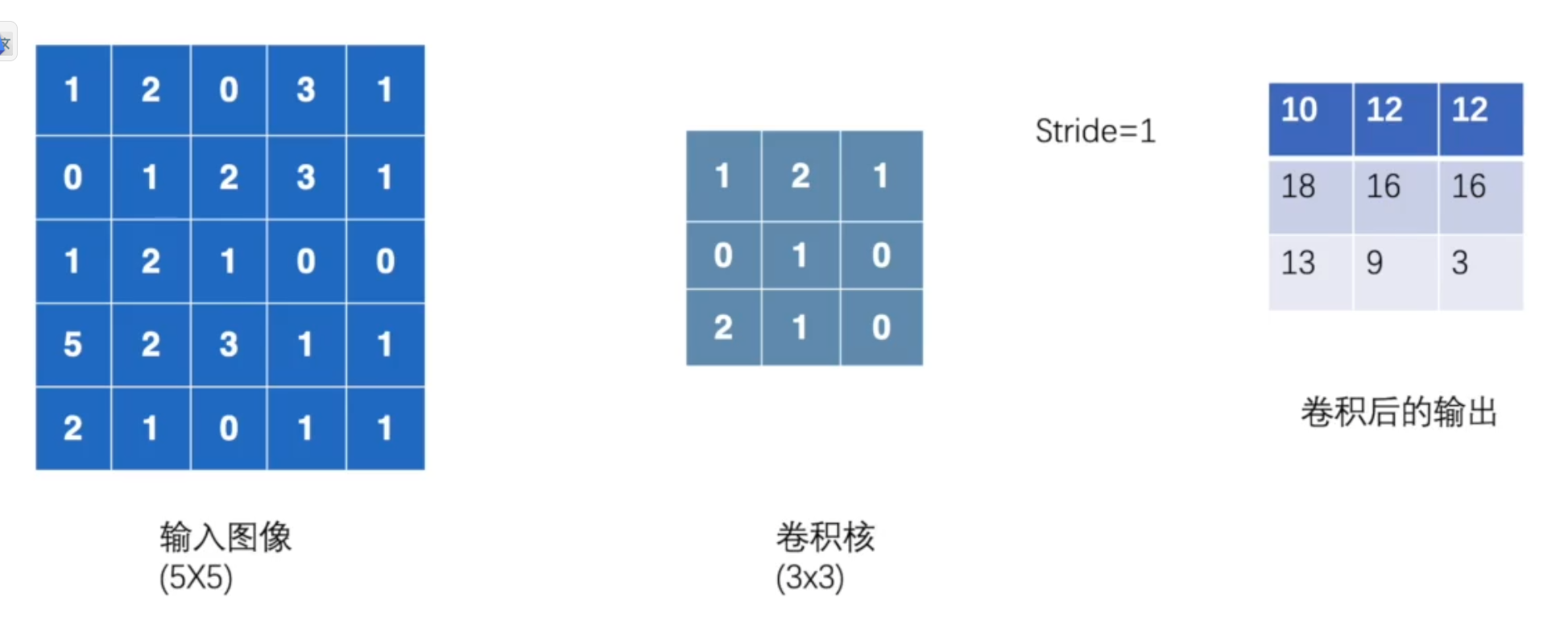

卷积原理

①卷积核不停地在原图上进行滑动,对应元素相乘再相加。

②下图为每次滑动移动1格,然后再利用原图与卷积核上的数值进行计算得到缩略图矩阵的数据,如下图所示。

import torch

import torch.nn.functional as F

input = torch.tensor([[1, 2, 0, 3, 1],

[0, 1, 2, 3, 1],

[1, 2, 1, 0, 0],

[5, 2, 3, 1, 1],

[2, 1, 0, 1, 1]])

kernel = torch.tensor([[1, 2, 1],

[0, 1, 0],

[2, 1, 0]])

print(input.shape)

print(kernel.shape)

# 灰度图用2为矩阵表示,所以通道数channel设置为1.彩色图用3为矩阵表示,通道数为2

input = torch.reshape(input, (1, 1, 5, 5))

kernel = torch.reshape(kernel, (1, 1, 3, 3))

print(input.shape)

print(kernel.shape)

output = F.conv2d(input, kernel, stride=1)

print(output)

运行结果如下:

torch.Size([5, 5])

torch.Size([3, 3])

torch.Size([1, 1, 5, 5])

torch.Size([1, 1, 3, 3])

tensor([[[[10, 12, 12],

[18, 16, 16],

[13, 9, 3]]]])

import torch

import torch.nn.functional as F

input = torch.tensor([[1, 2, 0, 3, 1],

[0, 1, 2, 3, 1],

[1, 2, 1, 0, 0],

[5, 2, 3, 1, 1],

[2, 1, 0, 1, 1]])

kernel = torch.tensor([[1, 2, 1],

[0, 1, 0],

[2, 1, 0]])

print(input.shape)

print(kernel.shape)

input = torch.reshape(input, (1,1,5,5))

kernel = torch.reshape(kernel, (1,1,3,3))

print(input.shape)

print(kernel.shape)

output2 = F.conv2d(input, kernel, stride=2) # 步伐为2

print(output2)

运行结果如下:

torch.Size([5, 5])

torch.Size([3, 3])

torch.Size([1, 1, 5, 5])

torch.Size([1, 1, 3, 3])

tensor([[[[10, 12],

[13, 3]]]])

import torch

import torch.nn.functional as F

input = torch.tensor([[1, 2, 0, 3, 1],

[0, 1, 2, 3, 1],

[1, 2, 1, 0, 0],

[5, 2, 3, 1, 1],

[2, 1, 0, 1, 1]])

kernel = torch.tensor([[1, 2, 1],

[0, 1, 0],

[2, 1, 0]])

print(input.shape)

print(kernel.shape)

input = torch.reshape(input, (1,1,5,5))

kernel = torch.reshape(kernel, (1,1,3,3))

print(input.shape)

print(kernel.shape)

# padding填充的值为0

output3 = F.conv2d(input, kernel, stride=1, padding=1) # 周围只填充一层

print(output3)

运行结果如下:

torch.Size([5, 5])

torch.Size([3, 3])

torch.Size([1, 1, 5, 5])

torch.Size([1, 1, 3, 3])

tensor([[[[ 1, 3, 4, 10, 8],

[ 5, 10, 12, 12, 6],

[ 7, 18, 16, 16, 8],

[11, 13, 9, 3, 4],

[14, 13, 9, 7, 4]]]])

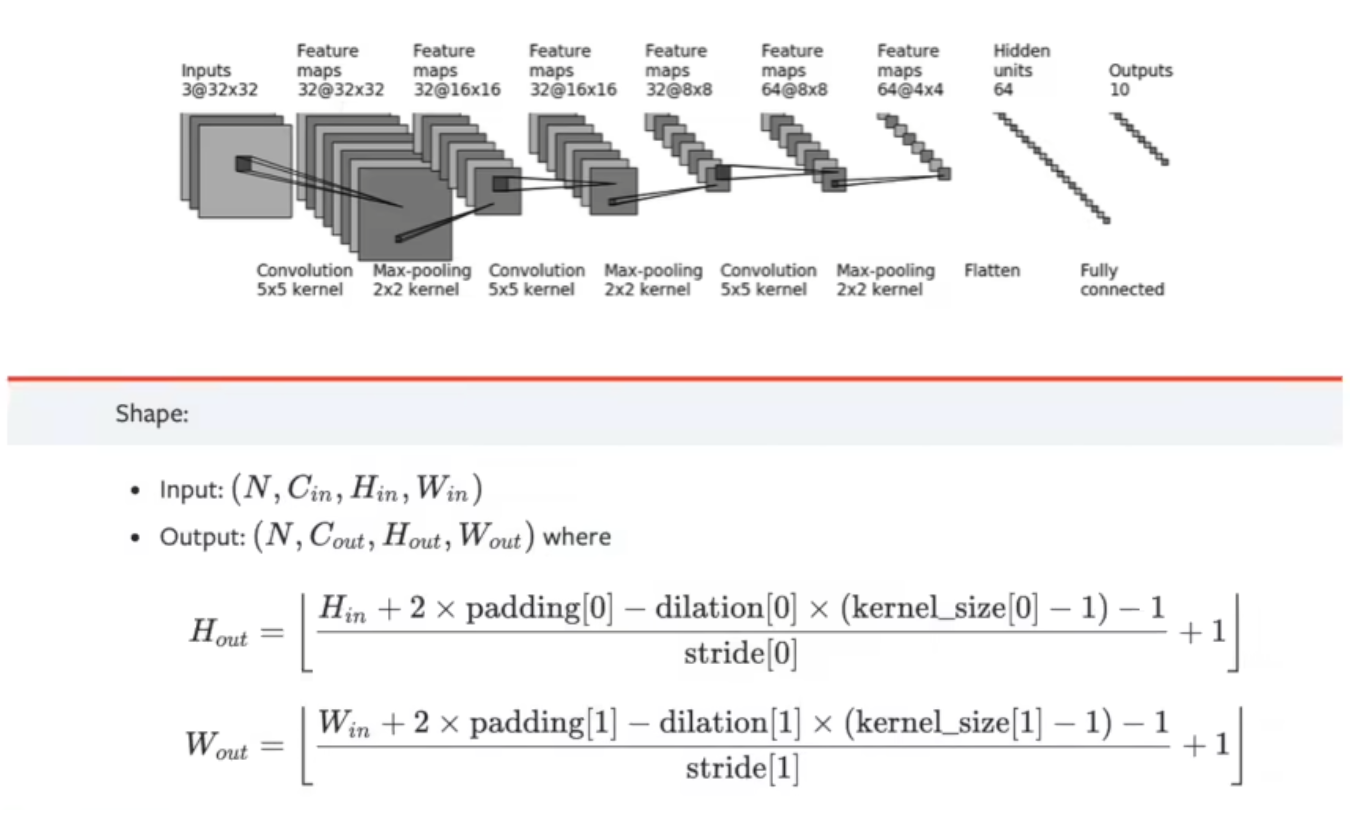

卷积层

①Conv1d代表一维卷积,Conv2d代表二维卷积,Conv3d代表三维卷积

②kernel_size在训练过程中不断调整,定义为3就是3x3的卷积核,实际我们在训练神经网络的过程就是对kernel_size不断调整

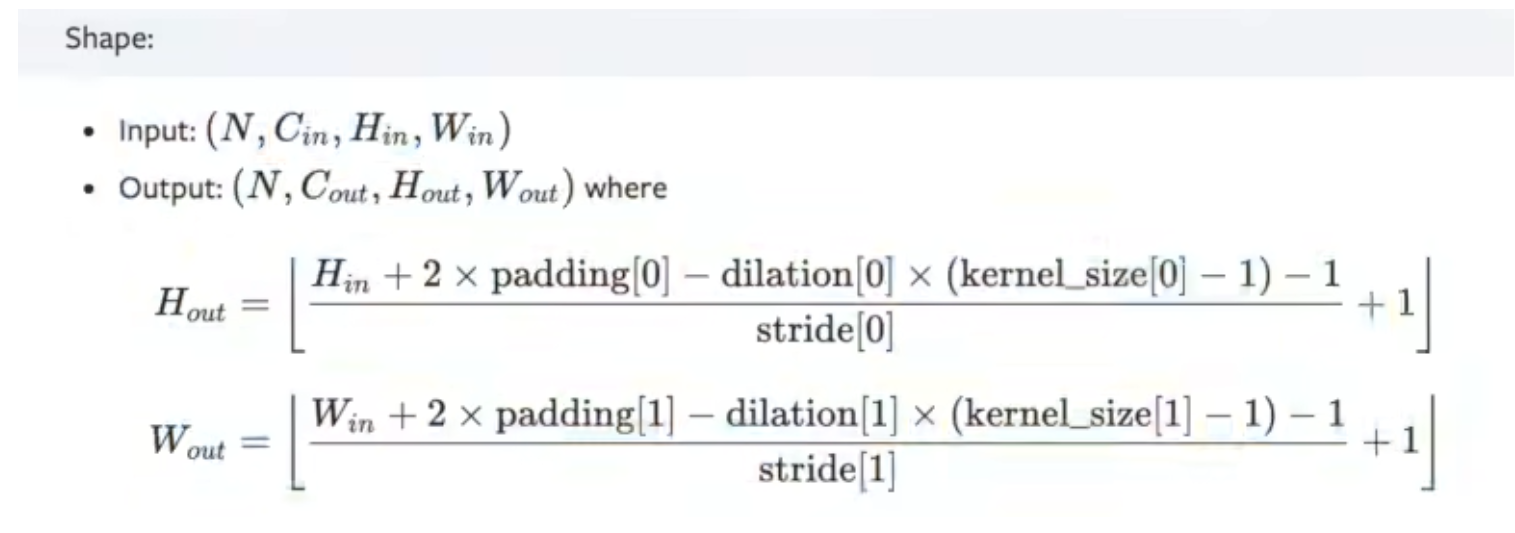

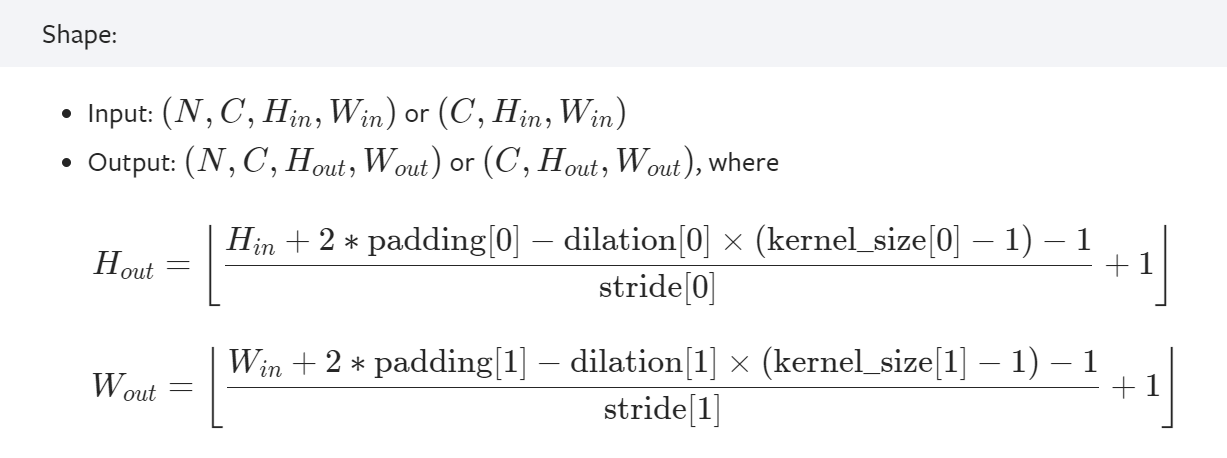

③可以根据输入的参数获得输出的情况,如下图所示。

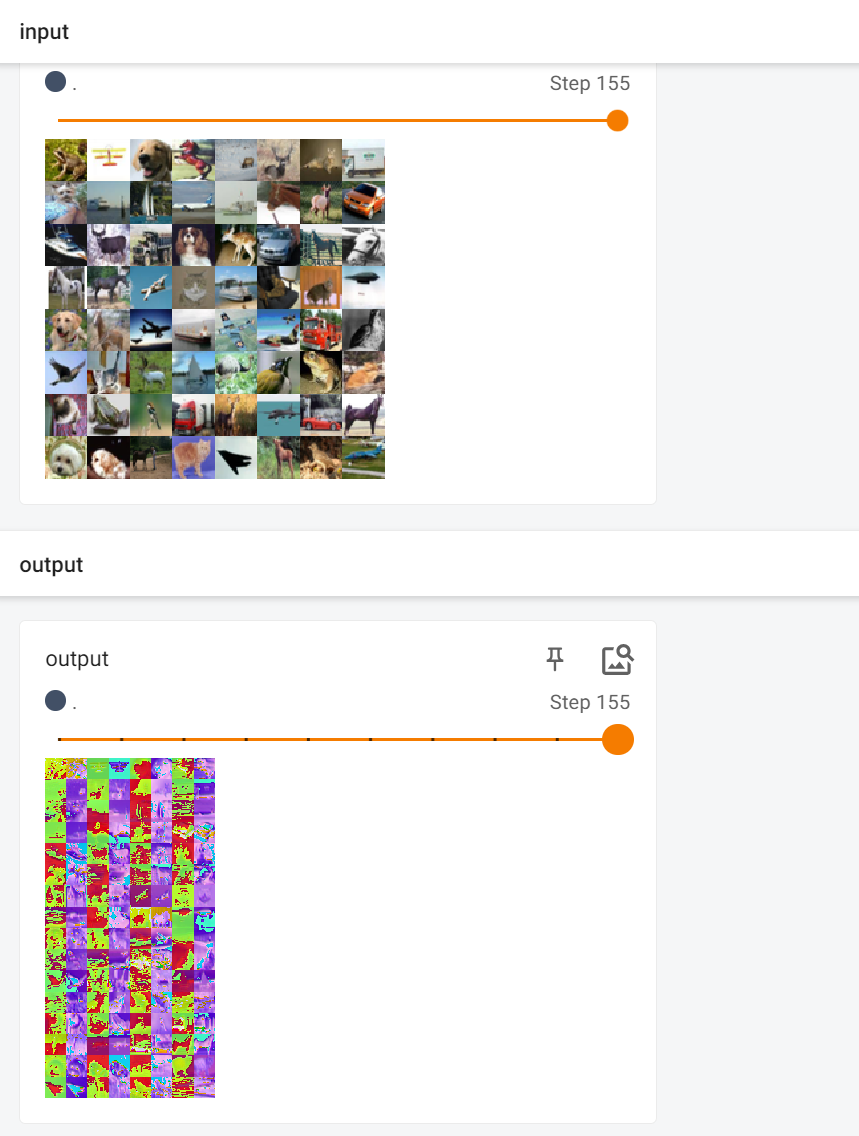

搭建卷积层代码如下:

import torch

import torchvision

from torch.nn import Conv2d

from torch.utils.data import DataLoader

from torch import nn

from tensorboardX import SummaryWriter

dataset = torchvision.datasets.CIFAR10('../torchvision_with_DataSet/dataset', train=False, transform=torchvision.transforms.ToTensor(), download=True)

dataloader = DataLoader(dataset, batch_size=64, drop_last=True)

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

self.conv1 = Conv2d(in_channels=3, out_channels=6, kernel_size=3, stride=1,

padding=0) # 彩色图像输入为3层,我们想让它的输出为6层,选3 * 3 的卷积

def forward(self, x):

x = self.conv1(x)

return x

tudui = Tudui()

print(tudui)

# tensorboard显示

writer = SummaryWriter("logs")

step = 0

# 卷积层处理图片

for data in dataloader:

imgs, target = data

output = tudui(imgs)

# print(imgs.shape) # 输入为3通道32×32的64张图片

# print(output.shape) # 输出为6通道30×30的64张图片

writer.add_images("input", imgs, step)

output = torch.reshape(output, (-1, 3, 30, 30)) # 把原来6个通道拉为3个通道,为了保证所有维度总数不变,其余的分量分到第一个维度中

writer.add_images("output", output, step)

step += 1

writer.close()

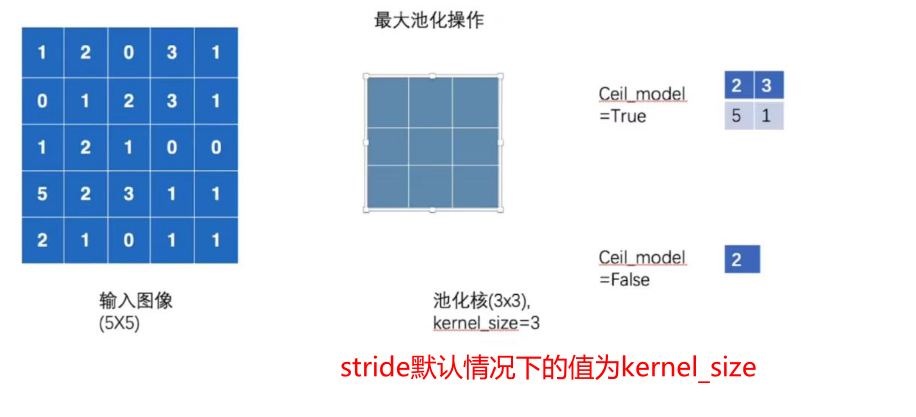

最大池化层

池化层原理

①最大池化层有时也被称为下采样

②dilation为空洞卷积

③Ceil_model为当超出区域时,只取最左上角的值

④池化使得数据由5x5变为3x3,甚至1x1的,这样导致计算的参数会大大减小。例如1080P的电影经过池化的转为720P的电影、或360P的电影后,同样的网速下,视频更为不卡。

池化层处理数据

import torch

import torchvision.datasets

from tensorboardX import SummaryWriter

from torch import nn

from torch.nn import MaxPool2d

from torch.utils.data import DataLoader

dataset = torchvision.datasets.CIFAR10("../torchvision_with_DataSet/dataset", train=False,

transform=torchvision.transforms.ToTensor())

dataloader = DataLoader(dataset, batch_size=64)

input = torch.tensor([[1, 2, 0, 3, 1],

[0, 1, 2, 3, 1],

[1, 2, 1, 0, 0],

[5, 2, 3, 1, 1],

[2, 1, 0, 1, 1]], dtype=torch.float32)

# -1表示根据其他设置,自动计算,把input的参数补全,加上channel数

# input = torch.reshape(input, (-1, 1, 5, 5))

# print(input.shape)

step = 0

# 为什么需要最大池化?

# 保留数据的输入特征,减少数据量,训练的更快

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

self.maxpoll1 = MaxPool2d(kernel_size=3, ceil_mode=False)

def forward(self, input):

output = self.maxpoll1(input)

return output

tudui = Tudui()

# output = tudui(input)

# print(output)

writer = SummaryWriter("logs_maxpool")

step = 0

for data in dataloader:

imgs, targets = data

writer.add_images("input1", imgs, step)

output = tudui(imgs)

writer.add_images("output1", output, step)

step += 1

writer.close()

运行效果如下:

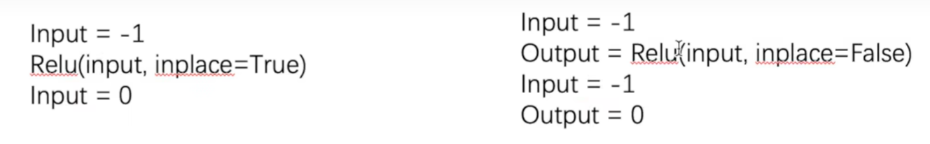

非线性激活

非线性变换的目的是给网络中加入一些非线性特征,非线性越多才能训练出符合各种特征的模型。

import torch

import torchvision

from tensorboardX import SummaryWriter

from torch import nn

from torch.nn import ReLU, Sigmoid

from torch.utils.data import DataLoader

input = torch.tensor([[1, -0.5],

[-1, 3]])

output = torch.reshape(input, (-1, 1, 2, 2))

print(output.shape)

dataset = torchvision.datasets.CIFAR10("../torchvision_with_DataSet/dataset", train=False, download=True,

transform=torchvision.transforms.ToTensor())

dataloader = DataLoader(dataset, batch_size=64)

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

self.relu1 = ReLU()

self.sigmoid1 = Sigmoid()

def forward(self, input):

# output = self.relu1(input)

output = self.sigmoid1(input)

return output

tudui = Tudui()

# print(tudui(input))

writer = SummaryWriter("log_relu")

step = 0

for data in dataloader:

imgs, tragets = data

writer.add_images("input", imgs, global_step=step)

output = tudui(imgs)

writer.add_images("output", output, global_step=step)

step += 1

writer.close()

运行效果如下:

线性层以及其它层

torch.nn.Linear(in_features, out_features, bias=True, device=None, dtype=None)

参数分析:

- in_features (int) – size of each input sample

- out_features (int) – size of each output sample

- bias (bool) – If set to

False, the layer will not learn an additive bias. Default:True(偏差(布尔值)– 如果设置为False,则层将不会学习加b。默认:True)

import torch

import torchvision.datasets

from torch import nn

from torch.nn import Linear

from torch.utils.data import DataLoader

dataset = torchvision.datasets.CIFAR10("../torchvision_with_DataSet/dataset", train=False, transform=torchvision.transforms.ToTensor(), download=True)

dataloader = DataLoader(dataset, batch_size=64, drop_last=True)

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

self.linear1 = Linear(196608, 10)

def forward(self, input):

output = self.linear1(input)

return output

tudui = Tudui()

for data in dataloader:

imgs, target = data

print(imgs.shape)

# output = torch.reshape(imgs, (1, 1, 1, -1))

output = torch.flatten(imgs)

print(output.shape)

output = tudui(output)

print(output.shape)

运行效果如下:

torch.Size([64, 3, 32, 32])

torch.Size([196608])

torch.Size([10])

torch.Size([64, 3, 32, 32])

torch.Size([196608])

torch.Size([10])

torch.Size([64, 3, 32, 32])

torch.Size([196608])

torch.Size([10])

...

补充:

torch.flatten(input, start_dim=0, end_dim=- 1) →张量

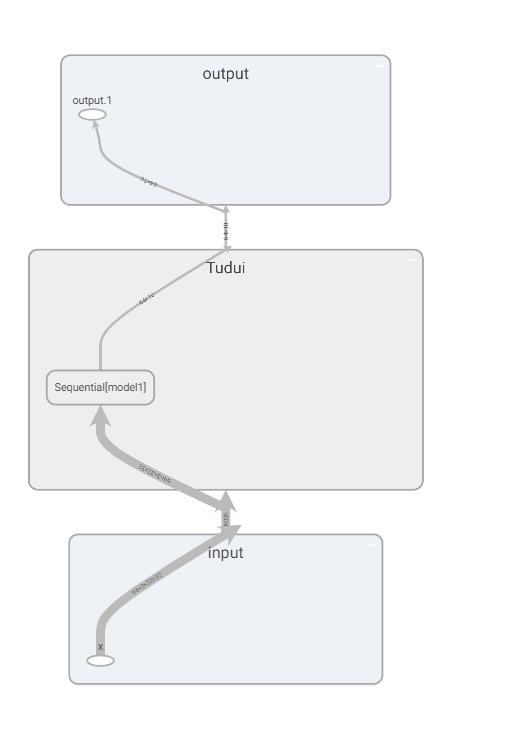

搭建小实战和Sequential使用

好处如下

①把网络结构放在Sequential里面,好处就是代码写起来比较简洁、易懂。

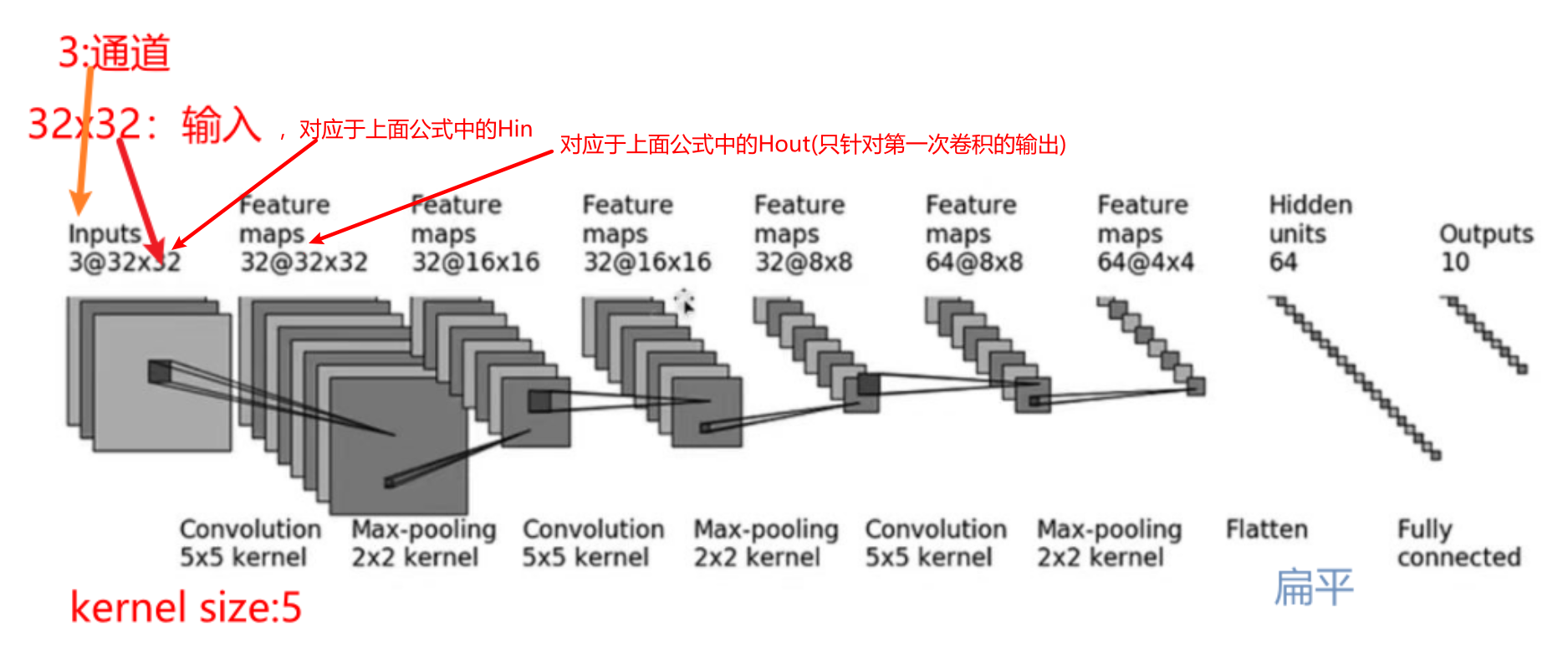

②可以根据神经网络每层的尺寸,根据下图的公式计算出神经网络中的参数。

参数分析:

Hin:输入的高

dilation:未采用空洞卷积,默认为1

未知参数:padding、stride

Hout:输出的高

搭建神经网络模型

根据CRFAR10搭建网络模型

import torch

from torch import nn

from torch.nn import Conv2d, MaxPool2d, Flatten, Linear

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

# 新建第一层卷积层

self.conv1 = Conv2d(3, 32, 5, padding=2)

self.maxpool1 = MaxPool2d(2)

self.conv2 = Conv2d(32, 32, 5, padding=2)

self.maxpool2 = MaxPool2d(2)

self.conv3 = Conv2d(32, 64, 5, padding=2)

self.maxpool3 = MaxPool2d(2)

self.flatten = Flatten()

self.linear1 = Linear(1024, 64)

self.linear2 = Linear(64, 10)

def forward(self, x):

x = self.conv1(x)

x = self.maxpool1(x)

x = self.conv2(x)

x = self.maxpool2(x)

x = self.conv3(x)

x = self.maxpool3(x)

x = self.flatten(x)

x = self.linear1(x)

x = self.linear2(x)

return x

tudui = Tudui()

print(tudui)

input = torch.ones((64, 3, 32, 32))

output = tudui(input)

print(output.shape)

简化后的写法:

import torch

from torch import nn

from torch.nn import Conv2d, MaxPool2d, Flatten, Linear, Sequential

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

# 新建第一层卷积层

self.model1 = Sequential(

Conv2d(3, 32, 5, padding=2),

MaxPool2d(2),

Conv2d(32, 32, 5, padding=2),

MaxPool2d(2),

Conv2d(32, 64, 5, padding=2),

MaxPool2d(2),

Flatten(),

Linear(1024, 64),

Linear(64, 10)

)

def forward(self, x):

x = self.model1(x)

return x

tudui = Tudui()

print(tudui)

input = torch.ones((64, 3, 32, 32))

output = tudui(input)

print(output.shape)

输出结果如下:

Tudui(

(model1): Sequential(

(0): Conv2d(3, 32, kernel_size=(5, 5), stride=(1, 1), padding=(2, 2))

(1): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(2): Conv2d(32, 32, kernel_size=(5, 5), stride=(1, 1), padding=(2, 2))

(3): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(4): Conv2d(32, 64, kernel_size=(5, 5), stride=(1, 1), padding=(2, 2))

(5): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(6): Flatten(start_dim=1, end_dim=-1)

(7): Linear(in_features=1024, out_features=64, bias=True)

(8): Linear(in_features=64, out_features=10, bias=True)

)

)

torch.Size([64, 10])

运行效果如下:

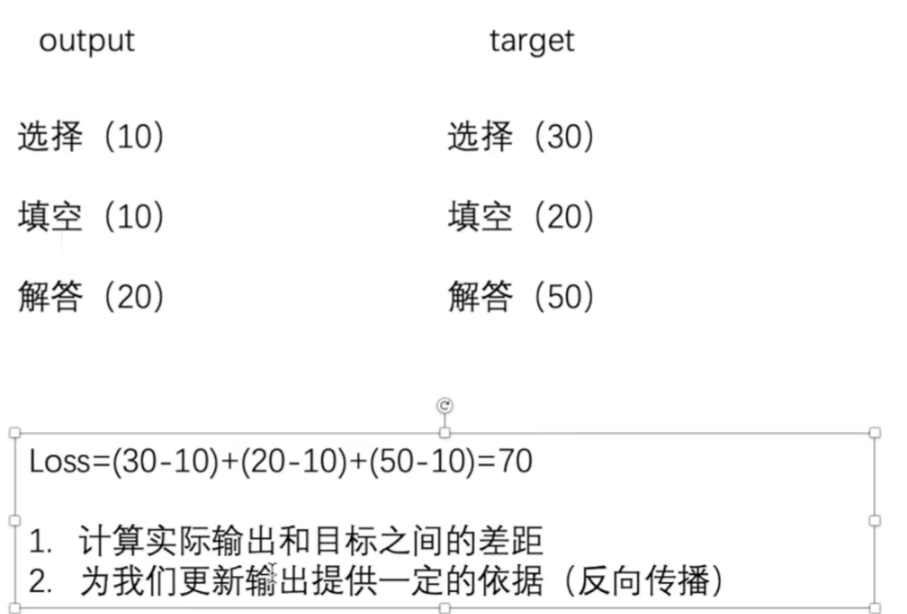

损失函数与反向传播

损失函数

①Loss损失函数一方面计算实际输出和目标之间的差距。

②Loss损失函数另一方面为我们更新输出提供一定的依据。

注意:loss function的值是越小越好

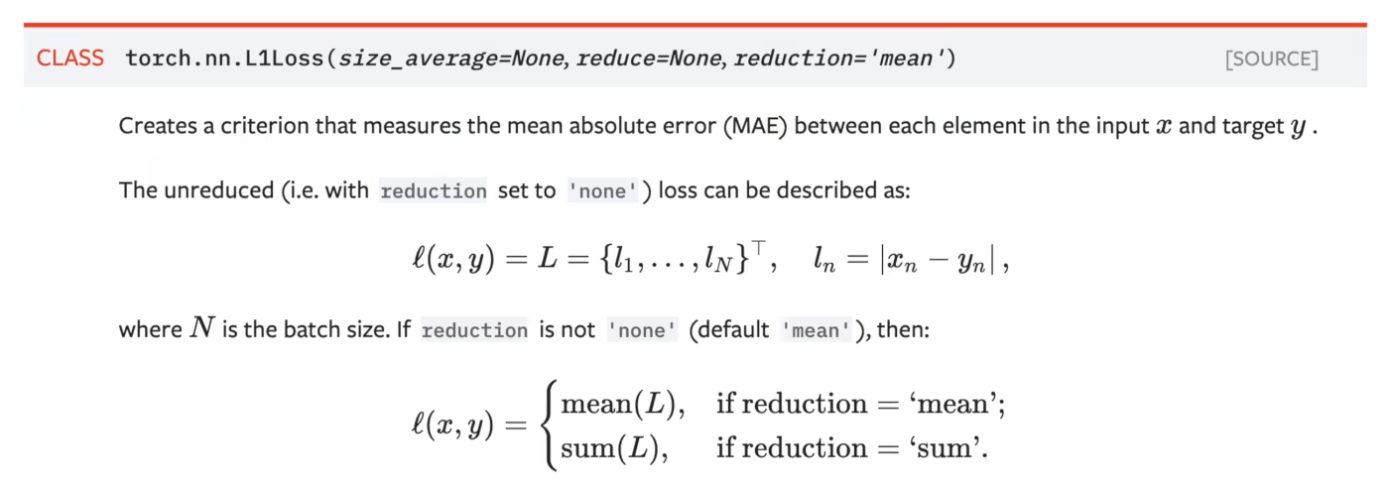

L1loss损失函数

① L1loss数学公式如下图所示,例子如下图所示。

import torch

from torch.nn import L1Loss

inputs = torch.tensor([1, 2, 3], dtype=torch.float32)

targets = torch.tensor([1, 2, 5], dtype=torch.float32)

inputs = torch.reshape(inputs, (1, 1, 1, 3))

outputs = torch.reshape(targets, (1, 1, 1, 3))

print(inputs)

print(targets)

# 默认是mean,计算平均值[(1-1)+(2-2)+(5-3)]/3=0.667

# loss = L1Loss()

loss = L1Loss(reduction="sum")

result = loss(inputs, targets)

print(result) # tensor(2.)

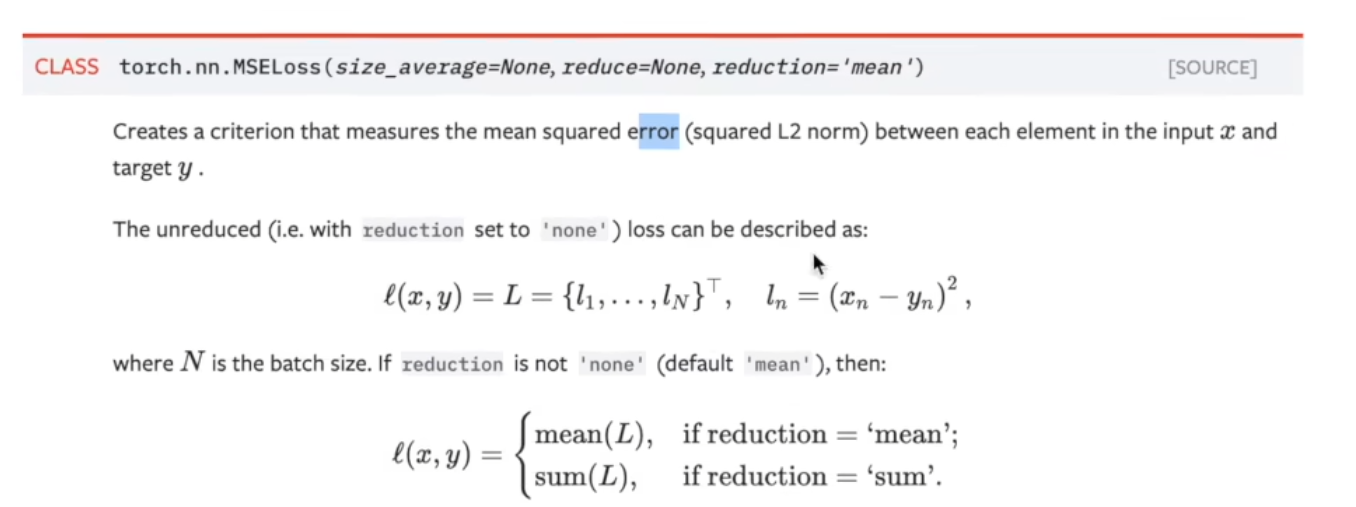

MSE损失函数

import torch

from torch.nn import L1Loss, MSELoss

from torch import nn

inputs = torch.tensor([1, 2, 3], dtype=torch.float32)

targets = torch.tensor([1, 2, 5], dtype=torch.float32)

# batchsize:1(batchsize是输入图片的数量) channel:1(C是通道数) weight:1(W是宽) height:3(H是高)

inputs = torch.reshape(inputs, (1, 1, 1, 3))

outputs = torch.reshape(targets, (1, 1, 1, 3))

loss_mse = nn.MSELoss()

result_mse = loss_mse(inputs, targets)

print(result_mse) # 1.333【2^2/3】

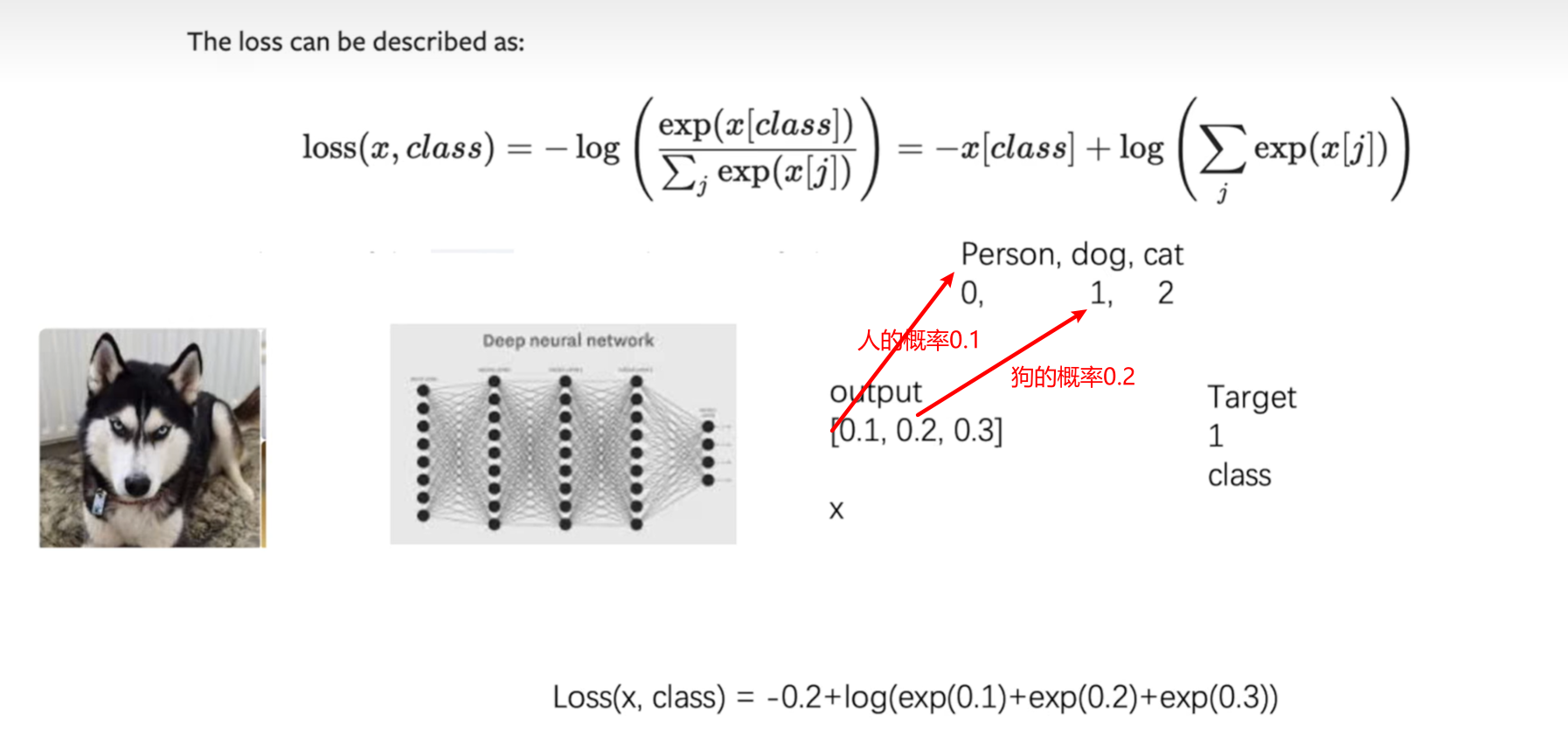

交叉熵损失函数

常用于分类的损失函数

import torch

import torch.nn.functional as F

from torch import nn

input = torch.tensor([[1, 2, 0, 3, 1],

[0, 1, 2, 3, 1],

[1, 2, 1, 0, 0],

[5, 2, 3, 1, 1],

[2, 1, 0, 1, 1]])

# 卷积核

kernel = torch.tensor([[1, 2, 1],

[0, 1, 0],

[2, 1, 0]])

# 重新变换:通道数为1,batch为1,数据维度5x5

input = torch.reshape(input, (1, 1, 5, 5))

kernel = torch.reshape(kernel, (1, 1, 3, 3))

print(input.shape)

print(kernel.shape)

output1 = F.conv2d(input, kernel, stride=1)

print(output1)

output2 = F.conv2d(input, kernel, stride=2)

print(output2)

output3 = F.conv2d(input, kernel, stride=1, padding=1)

print(output3)

x = torch.tensor([0.1, 0.2, 0.3])

y = torch.tensor([1])

x = torch.reshape(x, (1, 3))

loss_cross = nn.CrossEntropyLoss()

result_cross = loss_cross(x, y)

print(result_cross) # tensor(1.1019)x

搭建神经网络

import torch

import torchvision.datasets

from torch import nn

from torch.nn import Conv2d, MaxPool2d, Flatten, Linear

from torch.utils.data import DataLoader

dataset = torchvision.datasets.CIFAR10('../torchvision_with_DataSet/dataset', train=False, transform=torchvision.transforms.ToTensor(), download=True)

dataloader = DataLoader(dataset, batch_size=1)

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

self.model1 = nn.Sequential(

Conv2d(3, 32, 5, padding=2),

MaxPool2d(2),

Conv2d(32, 32, 5, padding=2),

MaxPool2d(2),

Conv2d(32, 64, 5, padding=2),

MaxPool2d(2),

Flatten(),

Linear(1024, 64),

Linear(64, 10)

)

def forward(self, x):

x = self.model1(x)

return x

loss = nn.CrossEntropyLoss()

tudui = Tudui()

for data in dataloader:

imgs, targets = data

outputs = tudui(imgs)

print(outputs)

print(targets)

result_loss = loss(outputs, targets)

print(result_loss)

输出结果如下:

tensor([[-0.0482, 0.1419, -0.0266, 0.0194, 0.0727, 0.0062, 0.0675, -0.0183,

-0.0773, -0.0356]], grad_fn=<AddmmBackward0>)

tensor([3])

tensor(2.2954, grad_fn=<NllLossBackward0>)

tensor([[-0.0826, 0.1348, -0.0375, 0.0342, 0.0927, -0.0335, 0.0841, -0.0071,

-0.0592, -0.0782]], grad_fn=<AddmmBackward0>)

tensor([8])

tensor(2.3692, grad_fn=<NllLossBackward0>)

tensor([[-0.0640, 0.1211, -0.0672, 0.0288, 0.0787, -0.0088, 0.0804, -0.0183,

-0.0726, -0.0555]], grad_fn=<AddmmBackward0>)

tensor([8])

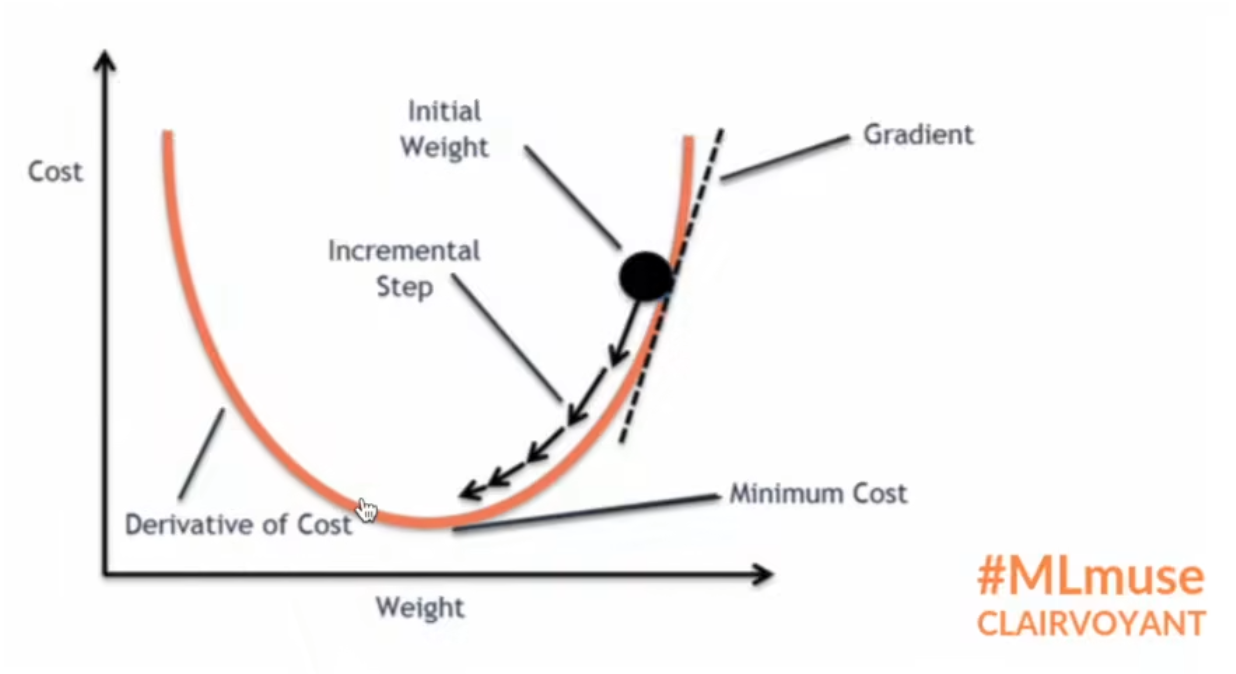

反向传播

什么是神经网络的反向传播机制?

定义:反向传播是"误差反向传播"的简称,是一种与最优化方法(如梯度下降法)结合使用的,用来训练人工神经网络的常见方法。该方法对网络中所有权重计算损失函数的梯度。这个梯度会反馈给最优化方法,用来更新权值以最小化损失函数。(误差的反向传播)

import torch

import torchvision.datasets

from torch import nn

from torch.nn import Conv2d, MaxPool2d, Flatten, Linear

from torch.utils.data import DataLoader

dataset = torchvision.datasets.CIFAR10('../torchvision_with_DataSet/dataset', train=False, transform=torchvision.transforms.ToTensor(), download=True)

dataloader = DataLoader(dataset, batch_size=1)

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

self.model1 = nn.Sequential(

Conv2d(3, 32, 5, padding=2),

MaxPool2d(2),

Conv2d(32, 32, 5, padding=2),

MaxPool2d(2),

Conv2d(32, 64, 5, padding=2),

MaxPool2d(2),

Flatten(),

Linear(1024, 64),

Linear(64, 10)

)

def forward(self, x):

x = self.model1(x)

return x

loss = nn.CrossEntropyLoss()

tudui = Tudui()

for data in dataloader:

imgs, targets = data

outputs = tudui(imgs)

# print(outputs)

# print(targets)

result_loss = loss(outputs, targets)

# 反向传播

result_loss.backward()

print("ok")

# print(result_loss)

优化器

①损失函数调用backward方法,就可以调用损失函数的反向传播方法,就可以求出我们需要调节的梯度,我们就可以利用我们的优化器就可以根据梯度对参数进行调整,达到整体误差降低的目的。

②梯度要清零,如果梯度不清零会导致梯度累加

神经网络优化一轮

import torch

import torchvision

from torch import nn

from torch.nn import Conv2d, MaxPool2d, Flatten, Linear, Sequential

from torch.utils.data import DataLoader

from torch.utils.tensorboard import SummaryWriter

dataset = torchvision.datasets.CIFAR10("./dataset",train=False,transform=torchvision.transforms.ToTensor(),download=True)

dataloader = DataLoader(dataset, batch_size=64,drop_last=True)

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

self.model1 = Sequential(

Conv2d(3,32,5,padding=2),

MaxPool2d(2),

Conv2d(32,32,5,padding=2),

MaxPool2d(2),

Conv2d(32,64,5,padding=2),

MaxPool2d(2),

Flatten(),

Linear(1024,64),

Linear(64,10)

)

def forward(self, x):

x = self.model1(x)

return x

loss = nn.CrossEntropyLoss() # 交叉熵

tudui = Tudui()

optim = torch.optim.SGD(tudui.parameters(),lr=0.01) # 随机梯度下降优化器

for data in dataloader:

imgs, targets = data

outputs = tudui(imgs)

result_loss = loss(outputs, targets) # 计算实际输出与目标输出的差距

optim.zero_grad() # 梯度清零

result_loss.backward() # 反向传播,计算损失函数的梯度

optim.step() # 根据梯度,对网络的参数进行调优

print(result_loss) # 对数据只看了一遍,只看了一轮,所以loss下降不大

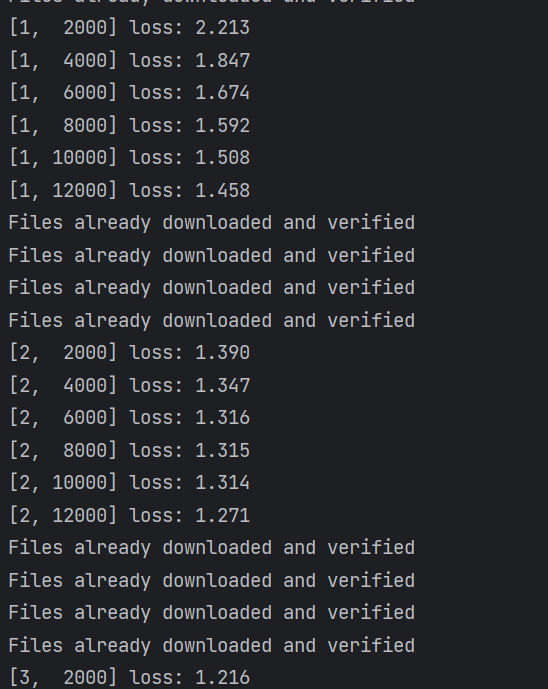

神经网络优化多轮

import torch

import torchvision.datasets

from torch import nn

from torch.nn import Conv2d, MaxPool2d, Flatten, Linear

from torch.utils.data import DataLoader

dataset = torchvision.datasets.CIFAR10("../torchvision_with_DataSet/dataset", train=False, transform=torchvision.transforms.ToTensor(), download=True)

dataloader = DataLoader(dataset, batch_size=1)

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

self.model1 = nn.Sequential(

Conv2d(3, 32, 5, padding=2),

MaxPool2d(2),

Conv2d(32, 32, 5, padding=2),

MaxPool2d(2),

Conv2d(32, 64, 5, padding=2),

MaxPool2d(2),

Flatten(),

Linear(1024, 64),

Linear(64, 10)

)

def forward(self, x):

x = self.model1(x)

return x

tudui = Tudui()

loss = nn.CrossEntropyLoss()

# 设置优化器

optim = torch.optim.SGD(tudui.parameters(), lr=0.01)

for epoch in range(20):

running_loss = 0.0

for data in dataloader:

imgs, targets = data

outputs = tudui(imgs)

result_loss = loss(outputs, targets)

optim.zero_grad() # 将网络模型中每一个可以调节参数的梯度设置为0

result_loss.backward() # 反向传播求出每一个可以调节节点的梯度

optim.step() # 对每个参数的每个参数进行调优

running_loss += result_loss

print(running_loss)

运行结果如下:

Files already downloaded and verified

tensor(18572.7617, grad_fn=<AddBackward0>)

tensor(16135.2334, grad_fn=<AddBackward0>)

tensor(15418.3721, grad_fn=<AddBackward0>)

tensor(16082.0986, grad_fn=<AddBackward0>)

tensor(17837.6621, grad_fn=<AddBackward0>)

tensor(19959.7852, grad_fn=<AddBackward0>)

现有网络模型的使用及修改

下载网络模型

import torchvision

#trauin_data = torchvision.datasets.ImageNet("./dataset",split="train",download=True,transform=torchvision.transforms.ToTensor()) # 这个数据集没有办法再公开的访问了

vgg16_true = torchvision.models.vgg16(pretrained=True) # 下载卷积层对应的参数是多少、池化层对应的参数时多少,这些参数时ImageNet训练好了的

vgg16_false = torchvision.models.vgg16(pretrained=False) # 没有预训练的参数

print("ok")

print(vgg16_true)

ok

VGG(

(features): Sequential(

(0): Conv2d(3, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(1): ReLU(inplace=True)

(2): Conv2d(64, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(3): ReLU(inplace=True)

(4): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(5): Conv2d(64, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(6): ReLU(inplace=True)

(7): Conv2d(128, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(8): ReLU(inplace=True)

(9): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(10): Conv2d(128, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(11): ReLU(inplace=True)

(12): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(13): ReLU(inplace=True)

(14): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(15): ReLU(inplace=True)

(16): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(17): Conv2d(256, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(18): ReLU(inplace=True)

(19): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(20): ReLU(inplace=True)

(21): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(22): ReLU(inplace=True)

(23): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(24): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(25): ReLU(inplace=True)

(26): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(27): ReLU(inplace=True)

(28): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(29): ReLU(inplace=True)

(30): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

)

(avgpool): AdaptiveAvgPool2d(output_size=(7, 7))

(classifier): Sequential(

(0): Linear(in_features=25088, out_features=4096, bias=True)

(1): ReLU(inplace=True)

(2): Dropout(p=0.5, inplace=False)

(3): Linear(in_features=4096, out_features=4096, bias=True)

(4): ReLU(inplace=True)

(5): Dropout(p=0.5, inplace=False)

(6): Linear(in_features=4096, out_features=1000, bias=True)

)

)

查看函数用法

import torchvision

help(torchvision.models.vgg16)

Help on function vgg16 in module torchvision.models.vgg:

vgg16(pretrained:bool=False, progress:bool=True, **kwargs:Any) -> torchvision.models.vgg.VGG

VGG 16-layer model (configuration "D")

`"Very Deep Convolutional Networks For Large-Scale Image Recognition" <https://arxiv.org/pdf/1409.1556.pdf>`_.

The required minimum input size of the model is 32x32.

Args:

pretrained (bool): If True, returns a model pre-trained on ImageNet

progress (bool): If True, displays a progress bar of the download to stderr

网络模型添加

import torchvision

from torch import nn

dataset = torchvision.datasets.CIFAR10("./dataset",train=True,transform=torchvision.transforms.ToTensor(),download=True)

vgg16_true = torchvision.models.vgg16(pretrained=True) # 下载卷积层对应的参数是多少、池化层对应的参数时多少,这些参数时ImageNet训练好了的

vgg16_true.add_module('add_linear',nn.Linear(1000,10)) # 在VGG16后面添加一个线性层,使得输出为适应CIFAR10的输出,CIFAR10需要输出10个种类

print(vgg16_true)

Files already downloaded and verified

VGG(

(features): Sequential(

(0): Conv2d(3, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(1): ReLU(inplace=True)

(2): Conv2d(64, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(3): ReLU(inplace=True)

(4): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(5): Conv2d(64, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(6): ReLU(inplace=True)

(7): Conv2d(128, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(8): ReLU(inplace=True)

(9): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(10): Conv2d(128, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(11): ReLU(inplace=True)

(12): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(13): ReLU(inplace=True)

(14): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(15): ReLU(inplace=True)

(16): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(17): Conv2d(256, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(18): ReLU(inplace=True)

(19): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(20): ReLU(inplace=True)

(21): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(22): ReLU(inplace=True)

(23): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(24): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(25): ReLU(inplace=True)

(26): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(27): ReLU(inplace=True)

(28): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(29): ReLU(inplace=True)

(30): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

)

(avgpool): AdaptiveAvgPool2d(output_size=(7, 7))

(classifier): Sequential(

(0): Linear(in_features=25088, out_features=4096, bias=True)

(1): ReLU(inplace=True)

(2): Dropout(p=0.5, inplace=False)

(3): Linear(in_features=4096, out_features=4096, bias=True)

(4): ReLU(inplace=True)

(5): Dropout(p=0.5, inplace=False)

(6): Linear(in_features=4096, out_features=1000, bias=True)

)

(add_linear): Linear(in_features=1000, out_features=10, bias=True)

)

网络模型修改

import torchvision

from torch import nn

vgg16_false = torchvision.models.vgg16(pretrained=False) # 没有预训练的参数

print(vgg16_false)

vgg16_false.classifier[6] = nn.Linear(4096,10)

print(vgg16_false)

VGG(

(features): Sequential(

(0): Conv2d(3, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(1): ReLU(inplace=True)

(2): Conv2d(64, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(3): ReLU(inplace=True)

(4): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(5): Conv2d(64, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(6): ReLU(inplace=True)

(7): Conv2d(128, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(8): ReLU(inplace=True)

(9): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(10): Conv2d(128, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(11): ReLU(inplace=True)

(12): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(13): ReLU(inplace=True)

(14): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(15): ReLU(inplace=True)

(16): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(17): Conv2d(256, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(18): ReLU(inplace=True)

(19): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(20): ReLU(inplace=True)

(21): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(22): ReLU(inplace=True)

(23): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(24): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(25): ReLU(inplace=True)

(26): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(27): ReLU(inplace=True)

(28): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(29): ReLU(inplace=True)

(30): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

)

(avgpool): AdaptiveAvgPool2d(output_size=(7, 7))

(classifier): Sequential(

(0): Linear(in_features=25088, out_features=4096, bias=True)

(1): ReLU(inplace=True)

(2): Dropout(p=0.5, inplace=False)

(3): Linear(in_features=4096, out_features=4096, bias=True)

(4): ReLU(inplace=True)

(5): Dropout(p=0.5, inplace=False)

(6): Linear(in_features=4096, out_features=1000, bias=True)

)

)

VGG(

(features): Sequential(

(0): Conv2d(3, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(1): ReLU(inplace=True)

(2): Conv2d(64, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(3): ReLU(inplace=True)

(4): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(5): Conv2d(64, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(6): ReLU(inplace=True)

(7): Conv2d(128, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(8): ReLU(inplace=True)

(9): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(10): Conv2d(128, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(11): ReLU(inplace=True)

(12): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(13): ReLU(inplace=True)

(14): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(15): ReLU(inplace=True)

(16): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(17): Conv2d(256, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(18): ReLU(inplace=True)

(19): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(20): ReLU(inplace=True)

(21): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(22): ReLU(inplace=True)

(23): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(24): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(25): ReLU(inplace=True)

(26): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(27): ReLU(inplace=True)

(28): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(29): ReLU(inplace=True)

(30): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

)

(avgpool): AdaptiveAvgPool2d(output_size=(7, 7))

(classifier): Sequential(

(0): Linear(in_features=25088, out_features=4096, bias=True)

(1): ReLU(inplace=True)

(2): Dropout(p=0.5, inplace=False)

(3): Linear(in_features=4096, out_features=4096, bias=True)

(4): ReLU(inplace=True)

(5): Dropout(p=0.5, inplace=False)

(6): Linear(in_features=4096, out_features=10, bias=True)

)

)

网络模型的保存与读取

网络模型保存(方式一)

import torchvision

import torch

vgg16 = torchvision.models.vgg16(pretrained=False) # 模型中的参数是未经过训练的

torch.save(vgg16,"./model/vgg16_method1.pth") # 保存方式一:模型结构 + 模型参数

print(vgg16)

运行结果如下:

VGG(

(features): Sequential(

(0): Conv2d(3, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(1): ReLU(inplace=True)

(2): Conv2d(64, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(3): ReLU(inplace=True)

(4): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(5): Conv2d(64, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(6): ReLU(inplace=True)

(7): Conv2d(128, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(8): ReLU(inplace=True)

(9): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(10): Conv2d(128, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(11): ReLU(inplace=True)

(12): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(13): ReLU(inplace=True)

(14): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(15): ReLU(inplace=True)

(16): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(17): Conv2d(256, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(18): ReLU(inplace=True)

(19): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(20): ReLU(inplace=True)

(21): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(22): ReLU(inplace=True)

(23): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(24): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(25): ReLU(inplace=True)

(26): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(27): ReLU(inplace=True)

(28): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(29): ReLU(inplace=True)

(30): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

)

(avgpool): AdaptiveAvgPool2d(output_size=(7, 7))

(classifier): Sequential(

(0): Linear(in_features=25088, out_features=4096, bias=True)

(1): ReLU(inplace=True)

(2): Dropout(p=0.5, inplace=False)

(3): Linear(in_features=4096, out_features=4096, bias=True)

(4): ReLU(inplace=True)

(5): Dropout(p=0.5, inplace=False)

(6): Linear(in_features=4096, out_features=1000, bias=True)

)

)

网络模型导入(方式一)

import torch

model = torch.load("./model/vgg16_method1.pth") # 保存方式一对应的加载模型

print(model)

运行结果如下:

VGG(

(features): Sequential(

(0): Conv2d(3, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(1): ReLU(inplace=True)

(2): Conv2d(64, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(3): ReLU(inplace=True)

(4): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(5): Conv2d(64, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(6): ReLU(inplace=True)

(7): Conv2d(128, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(8): ReLU(inplace=True)

(9): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(10): Conv2d(128, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(11): ReLU(inplace=True)

(12): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(13): ReLU(inplace=True)

(14): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(15): ReLU(inplace=True)

(16): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(17): Conv2d(256, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(18): ReLU(inplace=True)

(19): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(20): ReLU(inplace=True)

(21): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(22): ReLU(inplace=True)

(23): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(24): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(25): ReLU(inplace=True)

(26): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(27): ReLU(inplace=True)

(28): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(29): ReLU(inplace=True)

(30): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

)

(avgpool): AdaptiveAvgPool2d(output_size=(7, 7))

(classifier): Sequential(

(0): Linear(in_features=25088, out_features=4096, bias=True)

(1): ReLU(inplace=True)

(2): Dropout(p=0.5, inplace=False)

(3): Linear(in_features=4096, out_features=4096, bias=True)

(4): ReLU(inplace=True)

(5): Dropout(p=0.5, inplace=False)

(6): Linear(in_features=4096, out_features=1000, bias=True)

)

)

网络模型保存(方式二)-推荐

import torchvision

import torch

vgg16 = torchvision.models.vgg16(weights=None)

torch.save(vgg16.state_dict(),"./model/vgg16_method2.pth") # 保存方式二:模型参数(官方推荐),不再保存网络模型结构

print(vgg16)

运行结果如下:

VGG(

(features): Sequential(

(0): Conv2d(3, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(1): ReLU(inplace=True)

(2): Conv2d(64, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(3): ReLU(inplace=True)

(4): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(5): Conv2d(64, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(6): ReLU(inplace=True)

(7): Conv2d(128, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(8): ReLU(inplace=True)

(9): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(10): Conv2d(128, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(11): ReLU(inplace=True)

(12): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(13): ReLU(inplace=True)

(14): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(15): ReLU(inplace=True)

(16): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(17): Conv2d(256, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(18): ReLU(inplace=True)

(19): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(20): ReLU(inplace=True)

(21): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(22): ReLU(inplace=True)

(23): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(24): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(25): ReLU(inplace=True)

(26): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(27): ReLU(inplace=True)

(28): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(29): ReLU(inplace=True)

(30): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

)

(avgpool): AdaptiveAvgPool2d(output_size=(7, 7))

(classifier): Sequential(

(0): Linear(in_features=25088, out_features=4096, bias=True)

(1): ReLU(inplace=True)

(2): Dropout(p=0.5, inplace=False)

(3): Linear(in_features=4096, out_features=4096, bias=True)

(4): ReLU(inplace=True)

(5): Dropout(p=0.5, inplace=False)

(6): Linear(in_features=4096, out_features=1000, bias=True)

)

)

网络模型导入(方式二)

import torch

import torchvision

vgg16 = torchvision.models.vgg16(weights=None)

print(vgg16)

vgg16.load_state_dict(torch.load("./model/vgg16_method2.pth")) # 将模型参数导入到模型结构中

print(vgg16)

运行效果如下:

VGG(

(features): Sequential(

(0): Conv2d(3, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(1): ReLU(inplace=True)

(2): Conv2d(64, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(3): ReLU(inplace=True)

(4): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(5): Conv2d(64, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(6): ReLU(inplace=True)

(7): Conv2d(128, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(8): ReLU(inplace=True)

(9): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(10): Conv2d(128, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(11): ReLU(inplace=True)

(12): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(13): ReLU(inplace=True)

(14): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(15): ReLU(inplace=True)

(16): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(17): Conv2d(256, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(18): ReLU(inplace=True)

(19): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(20): ReLU(inplace=True)

(21): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(22): ReLU(inplace=True)

(23): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(24): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(25): ReLU(inplace=True)

(26): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(27): ReLU(inplace=True)

(28): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(29): ReLU(inplace=True)

(30): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

)

(avgpool): AdaptiveAvgPool2d(output_size=(7, 7))

(classifier): Sequential(

(0): Linear(in_features=25088, out_features=4096, bias=True)

(1): ReLU(inplace=True)

(2): Dropout(p=0.5, inplace=False)

(3): Linear(in_features=4096, out_features=4096, bias=True)

(4): ReLU(inplace=True)

(5): Dropout(p=0.5, inplace=False)

(6): Linear(in_features=4096, out_features=1000, bias=True)

)

)

VGG(

(features): Sequential(

(0): Conv2d(3, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(1): ReLU(inplace=True)

(2): Conv2d(64, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(3): ReLU(inplace=True)

(4): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(5): Conv2d(64, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(6): ReLU(inplace=True)

(7): Conv2d(128, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(8): ReLU(inplace=True)

(9): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(10): Conv2d(128, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(11): ReLU(inplace=True)

(12): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(13): ReLU(inplace=True)

(14): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(15): ReLU(inplace=True)

(16): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(17): Conv2d(256, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(18): ReLU(inplace=True)

(19): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(20): ReLU(inplace=True)

(21): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(22): ReLU(inplace=True)

(23): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

(24): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(25): ReLU(inplace=True)

(26): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(27): ReLU(inplace=True)

(28): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(29): ReLU(inplace=True)

(30): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False)

)

(avgpool): AdaptiveAvgPool2d(output_size=(7, 7))

(classifier): Sequential(

(0): Linear(in_features=25088, out_features=4096, bias=True)

(1): ReLU(inplace=True)

(2): Dropout(p=0.5, inplace=False)

(3): Linear(in_features=4096, out_features=4096, bias=True)

(4): ReLU(inplace=True)

(5): Dropout(p=0.5, inplace=False)

(6): Linear(in_features=4096, out_features=1000, bias=True)

)

)

网络陷阱-创建模型

import torch

from torch import nn

class Tudui(nn.Module):

def __init__(self):

super(Tudui,self).__init__()

self.conv1 = nn.Conv2d(3,64,kernel_size=3)

def forward(self,x):

x = self.conv1(x)

return x

tudui = Tudui()

torch.save(tudui, "./model/tudui_method1.pth")

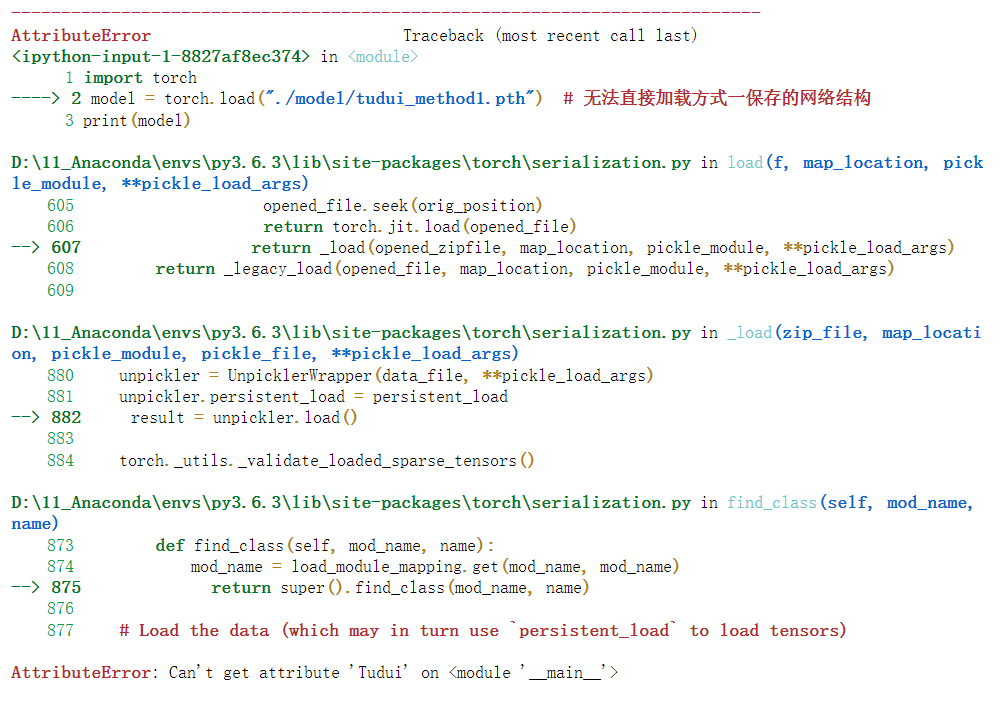

网路陷阱-失败加载模型

①保存网络模型

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

self.conv1 = nn.Conv2d(3, 64, kernel_size=3)

def forward(self, x):

x = self.conv1(x)

return x

tudui = Tudui()

torch.save(tudui, "tudui_method1.pth")

②在运行下面的代码过程中,即下面为第一个代码块运行,无法直接导入网络模型。原因是没有导入自定义的网络模型

import torch

model = torch.load("./model/tudui_method1.pth") # 无法直接加载方式一保存的网络结构

print(model)

网络陷阱-成功加载模型(方式一)

import torch

from torch import nn

# 确保网络模型是我们想要的网络模型,需要在加载前还写明网络模型

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

self.conv1 = nn.Conv2d(3, 64, kernel_size=3)

def forward(self, x):

x = self.conv1(x)

return x

# tudui=Tudui # 不需要写这一步,不需要创建网络模型

model = torch.load('./model/tudui_mothod1.pth') # 无法直接加载方式一保存的网络结构

print(model)

运行结果如下:

Tudui(

(conv1): Conv2d(3, 64, kernel_size=(3, 3), stride=(1, 1))

)

网络陷阱-成功加载模型(方式二)

import torch

import model_save import * # 它就相当于把 model_save.py 里的网络模型定义写到这里了

#tudui = Tudui # 不需要写这一步,不需要创建网络模型

model = torch.load("tudui_method1.pth")

print(model)

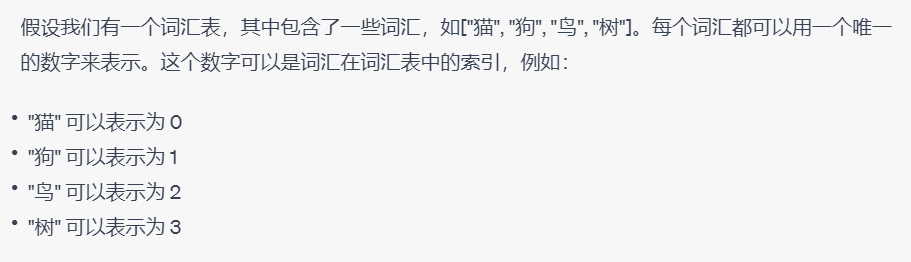

完整模型训练套路

简单总结一下下面提到的代码的训练模型的基本步骤:

- 准备数据集

- dataloader加载数据集

- 搭建网络模型

- 创建网络模型实例

- 定义损失函数

- 定义优化器

- 设置网络训练的参数

- 开始训练

- 验证模型

- 保存模型

- 将训练结果展示

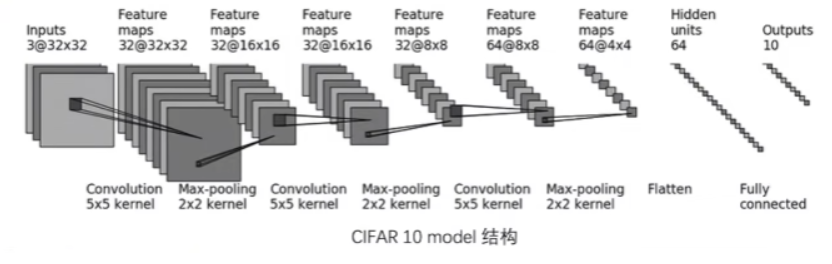

CIFAR10 model网络模型

下面是用CIFAR10 model网络来完成分类问题,网络模型如下图所示。

DataLoader加载数据集

import torchvision

from torch import nn

from torch.utils.data import DataLoader

# 准备数据集

train_data = torchvision.datasets.CIFAR10("./dataset",train=True,transform=torchvision.transforms.ToTensor(),download=True)

test_data = torchvision.datasets.CIFAR10("./dataset",train=False,transform=torchvision.transforms.ToTensor(),download=True)

# length 长度

train_data_size = len(train_data)

test_data_size = len(test_data)

# 如果train_data_size=10,则打印:训练数据集的长度为:10

print("训练数据集的长度:{}".format(train_data_size))

print("测试数据集的长度:{}".format(test_data_size))

# 利用 Dataloader 来加载数据集

train_dataloader = DataLoader(train_data_size, batch_size=64)

test_dataloader = DataLoader(test_data_size, batch_size=64)

运行结果如下:

Files already downloaded and verified

Files already downloaded and verified

训练数据集的长度:50000

测试数据集的长度:10000

测试网络是否正确

import torch

from torch import nn

# 搭建神经网络

class Tudui(nn.Module):

def __init__(self):

super.model1 = nn.Sequential(

nn.Conv2d(3, 32, 5, 1, 2), # 输入通道3,输出通道32,卷积核尺寸5x5,步长1,填充2

nn.MaxPool2d(2),

nn.Conv2d(32, 32, 5, 1, 2),

nn.MaxPool2d(2),

nn.Conv2d(32, 64, 5, 1, 2),

nn.MaxPool2d(2),

nn.Flatten(), #展平后变成了64x4x4

nn.Linear(64*4*4, 64),

nn.Linear(64, 10)

)

def forward(self, x):

x = self.model1(x)

return x

if __name__ == '__main__':

tudui = Tudui()

input = torch.ones((64, 3, 32, 32))

output = tudui(input)

print(output.shape) # 测试输出的尺寸是不是我们想要的

torch.Size([64, 10])

网络训练数据

import torchvision

from torch import nn

from torch.utils.data import DataLoader

# from model import * 相当于把 model中的所有内容写到这里,这里直接把 model 写在这里

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

self.model1 = nn.Sequential(

nn.Conv2d(3,32,5,1,2), # 输入通道3,输出通道32,卷积核尺寸5×5,步长1,填充2

nn.MaxPool2d(2),

nn.Conv2d(32,32,5,1,2),

nn.MaxPool2d(2),

nn.Conv2d(32,64,5,1,2),

nn.MaxPool2d(2),

nn.Flatten(), # 展平后变成 64*4*4 了

nn.Linear(64*4*4,64),

nn.Linear(64,10)

)

def forward(self, x):

x = self.model1(x)

return x

# 准备数据集

train_data = torchvision.datasets.CIFAR10("./dataset",train=True,transform=torchvision.transforms.ToTensor(),download=True)

test_data = torchvision.datasets.CIFAR10("./dataset",train=False,transform=torchvision.transforms.ToTensor(),download=True)

# length 长度

train_data_size = len(train_data)

test_data_size = len(test_data)

# 如果train_data_size=10,则打印:训练数据集的长度为:10

print("训练数据集的长度:{}".format(train_data_size))

print("测试数据集的长度:{}".format(test_data_size))

# 利用 Dataloader 来加载数据集

train_dataloader = DataLoader(train_data, batch_size=64)

test_dataloader = DataLoader(test_data, batch_size=64)

# 创建网络模型

tudui = Tudui()

# 损失函数

loss_fn = nn.CrossEntropyLoss() # 交叉熵,fn 是 fuction 的缩写

# 优化器

learning = 0.01 # 1e-2 就是 0.01 的意思

optimizer = torch.optim.SGD(tudui.parameters(),learning) # 随机梯度下降优化器

# 设置网络的一些参数

# 记录训练的次数

total_train_step = 0

# 训练的轮次

epoch = 10

for i in range(epoch):

print("-----第 {} 轮训练开始-----".format(i+1))

# 训练步骤开始

for data in train_dataloader:

imgs, targets = data

outputs = tudui(imgs)

loss = loss_fn(outputs, targets) # 计算实际输出与目标输出的差距

# 优化器对模型调优

optimizer.zero_grad() # 梯度清零

loss.backward() # 反向传播,计算损失函数的梯度

optimizer.step() # 根据梯度,对网络的参数进行调优

total_train_step = total_train_step + 1

#print("训练次数:{},Loss:{}".format(total_train_step,loss)) # 方式一:获得loss值

print("训练次数:{},Loss:{}".format(total_train_step,loss.item())) # 方式二:获得loss值

item作用

import torch

a = torch.tensor(5)

print(a)

print(a.item())

tensor(5)

5

查看训练损失

①在pytorch中,tensor有一个require_grad参数,如果设置为True,则反向传播时,该tensor就会自动求导

②tensor的requires_grad的属性默认为False,若一个节点(叶子变量:自己创建的tensor)requires_grad被设置为True,那么所有依赖它的节点requires_grad都为True(即使其它相依赖的tensor的requires_grad = Fasle)

③当requires_grad设置为False,反向传播时就不会自动求导了,因此大大节约了显存或者内存

④with torch.no_grad的作用在该模块下,所有计算得出的tensor的requires_grad=False

⑤即使一个tensor(命名为x)的requires_grad=True,在with torch.no_grad计算,由x得到的新tensor(命名为w-标量)requires_grad也为False,且grad_fn也为None,即不会对w求导

⑥torch.no_grad():停止计算梯度,不能进行反向传播

import torchvision

import torch

from torch import nn

from torch.utils.data import DataLoader

from torch.utils.tensorboard import SummaryWriter

# from model import * 相当于把 model中的所有内容写到这里,这里直接把 model 写在这里

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

self.model1 = nn.Sequential(

nn.Conv2d(3,32,5,1,2), # 输入通道3,输出通道32,卷积核尺寸5×5,步长1,填充2

nn.MaxPool2d(2),

nn.Conv2d(32,32,5,1,2),

nn.MaxPool2d(2),

nn.Conv2d(32,64,5,1,2),

nn.MaxPool2d(2),

nn.Flatten(), # 展平后变成 64*4*4 了

nn.Linear(64*4*4,64),

nn.Linear(64,10)

)

def forward(self, x):

x = self.model1(x)

return x

# 准备数据集

train_data = torchvision.datasets.CIFAR10("./dataset",train=True,transform=torchvision.transforms.ToTensor(),download=True)

test_data = torchvision.datasets.CIFAR10("./dataset",train=False,transform=torchvision.transforms.ToTensor(),download=True)

# length 长度

train_data_size = len(train_data)

test_data_size = len(test_data)

# 如果train_data_size=10,则打印:训练数据集的长度为:10

print("训练数据集的长度:{}".format(train_data_size))

print("测试数据集的长度:{}".format(test_data_size))

# 利用 Dataloader 来加载数据集

train_dataloader = DataLoader(train_data, batch_size=64)

test_dataloader = DataLoader(test_data, batch_size=64)

# 创建网络模型

tudui = Tudui()

# 损失函数

loss_fn = nn.CrossEntropyLoss() # 交叉熵,fn 是 fuction 的缩写

# 优化器

learning = 0.01 # 1e-2 就是 0.01 的意思

optimizer = torch.optim.SGD(tudui.parameters(),learning) # 随机梯度下降优化器

# 设置网络的一些参数

# 记录训练的次数

total_train_step = 0

# 记录测试的次数

total_test_step = 0

# 训练的轮次

epoch = 10

# 添加 tensorboard

writer = SummaryWriter("logs")

for i in range(epoch):

print("-----第 {} 轮训练开始-----".format(i+1))

# 训练步骤开始

for data in train_dataloader:

imgs, targets = data

outputs = tudui(imgs)

loss = loss_fn(outputs, targets) # 计算实际输出与目标输出的差距

# 优化器对模型调优

optimizer.zero_grad() # 梯度清零

loss.backward() # 反向传播,计算损失函数的梯度

optimizer.step() # 根据梯度,对网络的参数进行调优

total_train_step = total_train_step + 1

if total_train_step % 100 == 0:

print("训练次数:{},Loss:{}".format(total_train_step,loss.item())) # 方式二:获得loss值

writer.add_scalar("train_loss",loss.item(),total_train_step)

# 测试步骤开始(每一轮训练后都查看在测试数据集上的loss情况)

total_test_loss = 0

with torch.no_grad(): # 没有梯度计算,节约内存

for data in test_dataloader: # 测试数据集提取数据

imgs, targets = data

outputs = tudui(imgs)

loss = loss_fn(outputs, targets) # 仅data数据在网络模型上的损失

total_test_loss = total_test_loss + loss.item() # 所有loss

print("整体测试集上的Loss:{}".format(total_test_loss))

writer.add_scalar("test_loss",total_test_loss,total_test_step)

total_test_step = total_test_step + 1

writer.close()

运行结果如下:

Files already downloaded and verified

Files already downloaded and verified

训练数据集的长度:50000

测试数据集的长度:10000

-----第 1 轮训练开始-----

训练次数:100,Loss:2.2818071842193604

训练次数:200,Loss:2.267061471939087

训练次数:300,Loss:2.2060177326202393

训练次数:400,Loss:2.1160497665405273

训练次数:500,Loss:2.03908371925354

训练次数:600,Loss:2.0013811588287354

训练次数:700,Loss:1.971280574798584

整体测试集上的Loss:311.444508433342

-----第 2 轮训练开始-----

训练次数:800,Loss:1.8406707048416138

训练次数:900,Loss:1.835253357887268

训练次数:1000,Loss:1.9193772077560425

训练次数:1100,Loss:1.9817758798599243

训练次数:1200,Loss:1.6866414546966553

训练次数:1300,Loss:1.6833062171936035

训练次数:1400,Loss:1.7423250675201416

训练次数:1500,Loss:1.7910836935043335

整体测试集上的Loss:295.83529579639435

-----第 3 轮训练开始-----

训练次数:1600,Loss:1.7340000867843628

训练次数:1700,Loss:1.6623749732971191

训练次数:1800,Loss:1.9103188514709473

训练次数:1900,Loss:1.722930908203125

训练次数:2000,Loss:1.8943604230880737

训练次数:2100,Loss:1.4975690841674805

训练次数:2200,Loss:1.464676856994629

训练次数:2300,Loss:1.7708508968353271

整体测试集上的Loss:273.4990575313568

-----第 4 轮训练开始-----

训练次数:2400,Loss:1.7362182140350342

训练次数:2500,Loss:1.3517616987228394

训练次数:2600,Loss:1.5586233139038086

训练次数:2700,Loss:1.6879914999008179

训练次数:2800,Loss:1.469564437866211

训练次数:2900,Loss:1.5893890857696533

训练次数:3000,Loss:1.352890968322754

训练次数:3100,Loss:1.4961837530136108

整体测试集上的Loss:270.01156997680664

-----第 5 轮训练开始-----

训练次数:3200,Loss:1.3372247219085693

训练次数:3300,Loss:1.4689146280288696

训练次数:3400,Loss:1.4240412712097168

训练次数:3500,Loss:1.5419731140136719

训练次数:3600,Loss:1.5850610733032227

训练次数:3700,Loss:1.343977451324463

训练次数:3800,Loss:1.3023576736450195

训练次数:3900,Loss:1.4324713945388794

整体测试集上的Loss:257.1781986951828

-----第 6 轮训练开始-----

训练次数:4000,Loss:1.3752213716506958

训练次数:4100,Loss:1.4291632175445557

训练次数:4200,Loss:1.5042070150375366

训练次数:4300,Loss:1.1800527572631836

训练次数:4400,Loss:1.1353368759155273

训练次数:4500,Loss:1.3278626203536987

训练次数:4600,Loss:1.385879397392273

整体测试集上的Loss:243.80352401733398

-----第 7 轮训练开始-----

训练次数:4700,Loss:1.3193678855895996

训练次数:4800,Loss:1.5091830492019653

训练次数:4900,Loss:1.390406608581543

训练次数:5000,Loss:1.377677083015442

训练次数:5100,Loss:0.9832243919372559

训练次数:5200,Loss:1.306634545326233

训练次数:5300,Loss:1.2060096263885498

训练次数:5400,Loss:1.3645224571228027

整体测试集上的Loss:227.03500604629517

-----第 8 轮训练开始-----

训练次数:5500,Loss:1.2007256746292114

训练次数:5600,Loss:1.2000162601470947

训练次数:5700,Loss:1.217725157737732

训练次数:5800,Loss:1.2193546295166016

训练次数:5900,Loss:1.344832420349121

训练次数:6000,Loss:1.5032548904418945

训练次数:6100,Loss:0.9945251941680908

训练次数:6200,Loss:1.0842390060424805

整体测试集上的Loss:210.75880527496338

-----第 9 轮训练开始-----

训练次数:6300,Loss:1.3924059867858887

训练次数:6400,Loss:1.08247971534729

训练次数:6500,Loss:1.6116385459899902

训练次数:6600,Loss:1.0441133975982666

训练次数:6700,Loss:1.0808278322219849

训练次数:6800,Loss:1.1203839778900146

训练次数:6900,Loss:1.065340518951416

训练次数:7000,Loss:0.8646073341369629

整体测试集上的Loss:200.43587028980255

-----第 10 轮训练开始-----

训练次数:7100,Loss:1.2311145067214966

训练次数:7200,Loss:0.9793491363525391

训练次数:7300,Loss:1.1264833211898804

训练次数:7400,Loss:0.8558132648468018

训练次数:7500,Loss:1.1851539611816406

训练次数:7600,Loss:1.2427409887313843

训练次数:7700,Loss:0.8233367204666138

训练次数:7800,Loss:1.2412829399108887

整体测试集上的Loss:194.5557427406311

在 Anaconda 终端里面,激活pytorch环境,再输入 tensorboard --logdir=ogs 命令,将网址赋值浏览器的网址栏,回车,即可查看tensorboard显示日志情况

保留每一轮后参数

import torchvision

import torch

from torch import nn

from torch.utils.data import DataLoader

from torch.utils.tensorboard import SummaryWriter

# from model import * 相当于把 model中的所有内容写到这里,这里直接把 model 写在这里

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

self.model1 = nn.Sequential(

nn.Conv2d(3,32,5,1,2), # 输入通道3,输出通道32,卷积核尺寸5×5,步长1,填充2

nn.MaxPool2d(2),

nn.Conv2d(32,32,5,1,2),

nn.MaxPool2d(2),

nn.Conv2d(32,64,5,1,2),

nn.MaxPool2d(2),

nn.Flatten(), # 展平后变成 64*4*4 了

nn.Linear(64*4*4,64),

nn.Linear(64,10)

)

def forward(self, x):

x = self.model1(x)

return x

# 准备数据集

train_data = torchvision.datasets.CIFAR10("./dataset",train=True,transform=torchvision.transforms.ToTensor(),download=True)

test_data = torchvision.datasets.CIFAR10("./dataset",train=False,transform=torchvision.transforms.ToTensor(),download=True)

# length 长度

train_data_size = len(train_data)

test_data_size = len(test_data)

# 如果train_data_size=10,则打印:训练数据集的长度为:10

print("训练数据集的长度:{}".format(train_data_size))

print("测试数据集的长度:{}".format(test_data_size))

# 利用 Dataloader 来加载数据集

train_dataloader = DataLoader(train_data, batch_size=64)

test_dataloader = DataLoader(test_data, batch_size=64)

# 创建网络模型

tudui = Tudui()

# 损失函数

loss_fn = nn.CrossEntropyLoss() # 交叉熵,fn 是 fuction 的缩写

# 优化器

learning = 0.01 # 1e-2 就是 0.01 的意思

optimizer = torch.optim.SGD(tudui.parameters(),learning) # 随机梯度下降优化器

# 设置网络的一些参数

# 记录训练的次数

total_train_step = 0

# 记录测试的次数

total_test_step = 0

# 训练的轮次

epoch = 10

# 添加 tensorboard

writer = SummaryWriter("logs")

for i in range(epoch):

print("-----第 {} 轮训练开始-----".format(i+1))

# 训练步骤开始

for data in train_dataloader:

imgs, targets = data

outputs = tudui(imgs)

loss = loss_fn(outputs, targets) # 计算实际输出与目标输出的差距

# 优化器对模型调优

optimizer.zero_grad() # 梯度清零

loss.backward() # 反向传播,计算损失函数的梯度

optimizer.step() # 根据梯度,对网络的参数进行调优

total_train_step = total_train_step + 1

if total_train_step % 100 == 0:

print("训练次数:{},Loss:{}".format(total_train_step,loss.item())) # 方式二:获得loss值

writer.add_scalar("train_loss",loss.item(),total_train_step)

# 测试步骤开始(每一轮训练后都查看在测试数据集上的loss情况)

total_test_loss = 0

with torch.no_grad(): # 没有梯度了

for data in test_dataloader: # 测试数据集提取数据

imgs, targets = data

outputs = tudui(imgs)

loss = loss_fn(outputs, targets) # 仅data数据在网络模型上的损失

total_test_loss = total_test_loss + loss.item() # 所有loss

print("整体测试集上的Loss:{}".format(total_test_loss))

writer.add_scalar("test_loss",total_test_loss,total_test_step)

total_test_step = total_test_step + 1

torch.save(tudui, "./model/tudui_{}.pth".format(i)) # 保存每一轮训练后的结果

print("模型已保存")

writer.close()

argmax作用

import torch

outputs = torch.tensor([[0.1,0.2],

[0.05,0.4]])

print(outputs.argmax(0)) # 竖着看,最大值的索引

print(outputs.argmax(1)) # 横着看,最大值的索引

preds = outputs.argmax(0)

targets = torch.tensor([0,1])

print((preds == targets).sum()) # 对应位置相等的个数

tensor([0, 1])

tensor([1, 1])

tensor(2)

打印正确率

import torchvision

import torch

from torch import nn

from torch.utils.data import DataLoader

from torch.utils.tensorboard import SummaryWriter

# from model import * 相当于把 model中的所有内容写到这里,这里直接把 model 写在这里

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

self.model1 = nn.Sequential(

nn.Conv2d(3,32,5,1,2), # 输入通道3,输出通道32,卷积核尺寸5×5,步长1,填充2

nn.MaxPool2d(2),

nn.Conv2d(32,32,5,1,2),

nn.MaxPool2d(2),

nn.Conv2d(32,64,5,1,2),

nn.MaxPool2d(2),

nn.Flatten(), # 展平后变成 64*4*4 了

nn.Linear(64*4*4,64),

nn.Linear(64,10)

)

def forward(self, x):

x = self.model1(x)

return x

# 准备数据集

train_data = torchvision.datasets.CIFAR10("./dataset",train=True,transform=torchvision.transforms.ToTensor(),download=True)

test_data = torchvision.datasets.CIFAR10("./dataset",train=False,transform=torchvision.transforms.ToTensor(),download=True)

# length 长度

train_data_size = len(train_data)

test_data_size = len(test_data)

# 如果train_data_size=10,则打印:训练数据集的长度为:10

print("训练数据集的长度:{}".format(train_data_size))

print("测试数据集的长度:{}".format(test_data_size))

# 利用 Dataloader 来加载数据集

train_dataloader = DataLoader(train_data, batch_size=64)

test_dataloader = DataLoader(test_data, batch_size=64)

# 创建网络模型

tudui = Tudui()

# 损失函数

loss_fn = nn.CrossEntropyLoss() # 交叉熵,fn 是 fuction 的缩写

# 优化器

learning = 0.01 # 1e-2 就是 0.01 的意思

optimizer = torch.optim.SGD(tudui.parameters(),learning) # 随机梯度下降优化器

# 设置网络的一些参数

# 记录训练的次数

total_train_step = 0

# 记录测试的次数

total_test_step = 0

# 训练的轮次

epoch = 10

# 添加 tensorboard

writer = SummaryWriter("logs")

for i in range(epoch):

print("-----第 {} 轮训练开始-----".format(i+1))

# 训练步骤开始

for data in train_dataloader:

imgs, targets = data

outputs = tudui(imgs)

loss = loss_fn(outputs, targets) # 计算实际输出与目标输出的差距

# 优化器对模型调优

optimizer.zero_grad() # 梯度清零

loss.backward() # 反向传播,计算损失函数的梯度

optimizer.step() # 根据梯度,对网络的参数进行调优

total_train_step = total_train_step + 1

if total_train_step % 100 == 0:

print("训练次数:{},Loss:{}".format(total_train_step,loss.item())) # 方式二:获得loss值

writer.add_scalar("train_loss",loss.item(),total_train_step)

# 测试步骤开始(每一轮训练后都查看在测试数据集上的loss情况)

total_test_loss = 0

total_accuracy = 0

with torch.no_grad(): # 没有梯度了

for data in test_dataloader: # 测试数据集提取数据

imgs, targets = data

outputs = tudui(imgs)

loss = loss_fn(outputs, targets) # 仅data数据在网络模型上的损失

total_test_loss = total_test_loss + loss.item() # 所有loss

accuracy = (outputs.argmax(1) == targets).sum()

total_accuracy = total_accuracy + accuracy

print("整体测试集上的Loss:{}".format(total_test_loss))

print("整体测试集上的正确率:{}".format(total_accuracy/test_data_size))

writer.add_scalar("test_loss",total_test_loss,total_test_step)

writer.add_scalar("test_accuracy",total_accuracy/test_data_size,total_test_step)

total_test_step = total_test_step + 1

torch.save(tudui, "./model/tudui_{}.pth".format(i)) # 保存每一轮训练后的结果

print("模型已保存")

writer.close()

运行效果如下:

Files already downloaded and verified

Files already downloaded and verified

训练数据集的长度为:50000

测试数据集的长度为:10000

--------------------第1轮训练开始--------------------

训练次数:100,loss:2.290602684020996

训练次数:200,loss:2.287285327911377

训练次数:300,loss:2.2444310188293457

训练次数:400,loss:2.169663429260254

训练次数:500,loss:2.1361947059631348

训练次数:600,loss:2.075166702270508

训练次数:700,loss:1.9815199375152588

整体测试集上的loss为:312.1001933813095

整体测试集上的正确率为:0.29269999265670776

模型已保存

--------------------第2轮训练开始--------------------

训练次数:800,loss:1.8577196598052979

训练次数:900,loss:1.850684642791748

训练次数:1000,loss:1.9485677480697632

训练次数:1100,loss:1.9768987894058228

训练次数:1200,loss:1.6851532459259033

训练次数:1300,loss:1.6394447088241577

训练次数:1400,loss:1.726165771484375

训练次数:1500,loss:1.813376545906067

整体测试集上的loss为:292.74943912029266

整体测试集上的正确率为:0.33219999074935913

模型已保存

--------------------第3轮训练开始--------------------

训练次数:1600,loss:1.7275582551956177

训练次数:1700,loss:1.6258721351623535

训练次数:1800,loss:1.9269616603851318

训练次数:1900,loss:1.6683919429779053

训练次数:2000,loss:1.945574164390564

训练次数:2100,loss:1.5271880626678467

训练次数:2200,loss:1.458802342414856

训练次数:2300,loss:1.7970935106277466

整体测试集上的loss为:258.29104018211365

整体测试集上的正确率为:0.4025999903678894

模型已保存

--------------------第4轮训练开始--------------------

训练次数:2400,loss:1.7016180753707886

训练次数:2500,loss:1.3566914796829224

训练次数:2600,loss:1.5722663402557373

训练次数:2700,loss:1.6519713401794434

训练次数:2800,loss:1.4794732332229614

训练次数:2900,loss:1.5956920385360718

训练次数:3000,loss:1.3555442094802856

训练次数:3100,loss:1.5187991857528687

整体测试集上的loss为:251.28711569309235

整体测试集上的正确率为:0.41530001163482666

模型已保存

--------------------第5轮训练开始--------------------

训练次数:3200,loss:1.3214302062988281

训练次数:3300,loss:1.4614449739456177

训练次数:3400,loss:1.454591989517212

训练次数:3500,loss:1.5601571798324585

训练次数:3600,loss:1.5753967761993408

训练次数:3700,loss:1.3145686388015747

训练次数:3800,loss:1.289497971534729

训练次数:3900,loss:1.450293779373169

整体测试集上的loss为:245.25754117965698

整体测试集上的正确率为:0.42750000953674316

模型已保存

--------------------第6轮训练开始--------------------

训练次数:4000,loss:1.4143743515014648

训练次数:4100,loss:1.4589511156082153

训练次数:4200,loss:1.5510549545288086

训练次数:4300,loss:1.2015137672424316

训练次数:4400,loss:1.1165118217468262

训练次数:4500,loss:1.3256618976593018

训练次数:4600,loss:1.4347445964813232

整体测试集上的loss为:237.9616264104843

整体测试集上的正确率为:0.4487000107765198

模型已保存

--------------------第7轮训练开始--------------------

训练次数:4700,loss:1.2991517782211304

训练次数:4800,loss:1.5193597078323364

训练次数:4900,loss:1.4198514223098755

训练次数:5000,loss:1.4244966506958008

训练次数:5100,loss:0.9594044089317322

训练次数:5200,loss:1.2893214225769043

训练次数:5300,loss:1.2365928888320923

训练次数:5400,loss:1.4055867195129395

整体测试集上的loss为:227.9086148738861