专栏学习-CPU性能篇(一)

1.理解平均负载

1.1查看平均负载

root@srv1:~# uptime

05:48:41 up 43 days, 6:54, 1 user, load average: 0.22, 0.14, 0.10

0.22, 0.14, 0.10 分别是 前1分钟 , 5分钟, 15 分钟的 平均负载.

1.2官方解释

$man uptime

System load averages is the average number of processes that are either in a runnable or uninterruptable state. A process in a runnable state is either using the CPU or waiting to use the CPU. A process in uninterruptable state is waiting for some I/O access, eg waiting for disk. The averages are taken over the three time intervals. Load averages are not normalized for the number of CPUs in a system, so a load average of 1 means a single CPU system is loaded all the time while on a 4 CPU system it means it was idle 75% of the time.

翻译过来: 系统负载平均值是处于可运行或不可中断状态的平均进程数。 处于可运行状态的进程要么使用CPU 或等待使用 CPU。 处于不可中断状态的进程正在等待某些 I/O 访问,例如等待磁盘。 取三个时间的平均值间隔。 负载平均值并未针对系统中的 CPU 数量进行标准化,因此负载平均值为 1 意味着单个 CPU 系统在运行时始终处于加载状态。4 CPU 系统这意味着它有 75% 的时间处于空闲状态。

可运行状态 : 正在使用 CPU 或者正在等待 CPU 的进程,也就是我们常用 ps 命令看到的,处于 R 状态(Running 或 Runnable)的进程.

不可运行状态: 正处于内核态关键流程中的进程,并且这些流程是不可打断的,比如最常见的是等待硬件设备的 I/O 响应,也就是我们在 ps 命令中看到的 D 状态(Uninterruptible Sleep,也称为 Disk Sleep)的进程。例如 当一个进程向磁盘读写数据时,为了保证数据的一致性,在得到磁盘回复前,它是不能被其他进程或者中断打断的,这个时候的进程就处于不可中断状态。如果此时的进程被打断了,就容易出现磁盘数据与进程数据不一致的问题。

理解 平均负载是一定时间内的平均活跃的进程数, 他代表了对 CPU资源的需求但是值并不受 cpu 数量的影响, 但是要依据 cpu 数量判断负载是高还是低, 大于CPU 表示不足以服务线程, 有些线程在等待. 平均负载小于 CPU 数量, 代表还有一些余量.

cpu 个数查询: grep 'model name' /proc/cpuinfo | wc -l

例子: 平均负载为 2

- 在只有 2 个 CPU 的系统上,意味着所有的 CPU 都刚好被完全占用。

- 在 4 个 CPU 的系统上,意味着 CPU 有 50% 的空闲。

- 而在只有 1 个 CPU 的系统中,则意味着有一半的进程竞争不到 CPU。

1.3 平均负载多少为合理,应该参考哪一个

合理的状态应 结合 cpu的数量来看.

三个平均值的变化反应了 系统负载的趋势, 能帮我们更全面,更立体地了解情况.

- 如果 1 分钟、5 分钟、15 分钟的三个值基本相同,或者相差不大,那就说明系统负载很平稳。

- 如果 1 分钟的值远小于 15 分钟的值,就说明系统最近 1 分钟的负载在减少,而过去 15 分钟内却有很大的负载。

- 如果 1 分钟的值远大于 15 分钟的值,就说明最近 1 分钟的负载在增加,这种增加有可能只是临时性的,也有可能还会持续增加下去,所以就需要持续观察。一旦 1 分钟的平均负载接近或超过了 CPU 的个数,就意味着系统正在发生过载的问题,这时就得分析调查是哪里导致的问题,并要想办法优化了。

1.3.1 例子

我们在一个单 CPU 系统上看到平均负载为 1.73,0.60,7.98,那么说明在过去 1 分钟内,系统有 73% 的超载,而在 15 分钟内,有 698% 的超载,从整体趋势来看,系统的负载在降低。

实际生产环境中,平均负载多高时,需要重点关注?

当平均负载高于 CPU 数量 70% 的时候,你就应该分析排查负载高的问题了。一旦负载过高,就可能导致进程响应变慢,进而影响服务的正常功能。

但 70% 这个数字并不是绝对的,最推荐的方法,还是把系统的平均负载监控起来,然后根据更多的历史数据,判断负载的变化趋势。当发现负载有明显升高趋势时,比如说负载翻倍了,你再去做分析和调查。

1.4 平均负载和CPU使用率

由于是因为两个包含的进程分类不同.CPU 使用率和平均负载有关联, 但是没有完全对应.

平均负载它不仅包括了正在使用 CPU 的进程,还包括等待 CPU 和等待 I/O 的进程。

CPU 使用率是单位时间内 CPU 繁忙情况的统计

例如

- CPU 密集型进程,使用大量 CPU 会导致平均负载升高,此时这两者是一致的;

- I/O 密集型进程,等待 I/O 也会导致平均负载升高,但 CPU 使用率不一定很高;

- 大量等待 CPU 的进程调度也会导致平均负载升高(进程竞争),此时的 CPU 使用率也会比较高。

1.5 工具推荐

查找 平均负载过高的 工具推荐

- iostat 查看进程IO请求下发的数量、系统处理IO请求的耗时,进而分析进程与操作系统的交互过程中IO方面是否存在瓶颈。

- mpstat 是一个常用的多核 CPU 性能分析工具,用来实时查看每个 CPU 的性能指标,以及所有 CPU 的平均指标。

- pidstat 是一个常用的进程性能分析工具,用来实时查看进程的 CPU、内存、I/O 以及上下文切换等性能指标。

2.理解CPU上下文切换

进程在竞争 CPU 的时候并没有真正运行,为什么还会导致系统的负载升高呢?

因为 CPU 上下文切换

Linux 是一个多任务操作系统,它支持远大于 CPU 数量的任务同时运行。当然,这些任务实际上并不是真的在同时运行,而是因为系统在很短的时间内,将 CPU 轮流分配给它们,造成多任务同时运行的错觉。

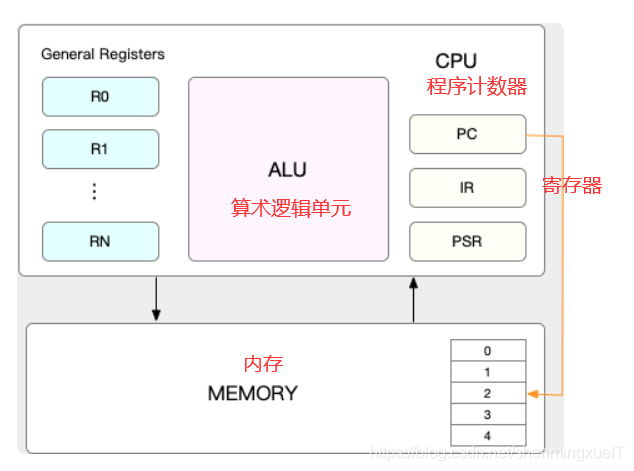

而在每个任务运行前,CPU 都需要知道任务从哪里加载、又从哪里开始运行,也就是说,需要系统事先帮它设置好 CPU 寄存器和程序计数器(Program Counter,PC)。

CPU 寄存器,是 CPU 内置的容量小、但速度极快的内存。

程序计数器,则是用来存储 CPU 正在执行的指令位置、或者即将执行的下一条指令位置。

它们都是 CPU 在运行任何任务前,必须的依赖环境,因此也被叫做 CPU 上下文。

2.1 概念

CPU 上下文切换,就是先把前一个任务的 CPU 上下文(也就是 CPU 寄存器和程序计数器)保存起来,然后加载新任务的上下文到这些寄存器和程序计数器,最后再跳转到程序计数器所指的新位置,运行新任务。而这些保存下来的上下文,会存储在系统内核中,并在任务重新调度执行时再次加载进来。这样就能保证任务原来的状态不受影响,让任务看起来还是连续运行。

操作系统管理的任务是什么? 包含 进程, 线程, 中断处理程序的调用

根据任务的不同,CPU 的上下文切换就可以分为几个不同的场景,也就是

- 进程上下文切换,

- 线程上下文切换,

- 中断上下文切换.

2.2 进程上下文切换

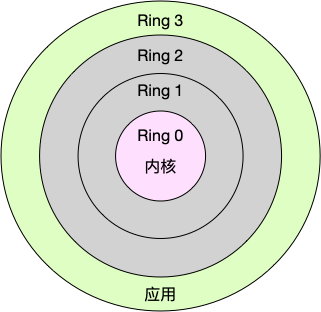

Linux 按照特权等级,把进程的运行空间分为内核空间和用户空间,分别对应着下图中, CPU 特权等级的 Ring 0 和 Ring 3。

- 内核空间(Ring 0)具有最高权限,可以直接访问所有资源;

- 用户空间(Ring 3)只能访问受限资源,不能直接访问内存等硬件设备,必须通过系统调用陷入到内核中,才能访问这些特权资源。

进程既可以在用户空间运行,又可以在内核空间中运行。

进程在用户空间运行时,被称为进程的用户态,而陷入内核空间的时候,被称为进程的内核态。

从用户态到内核态的转变,需要通过系统调用来完成.

系统调用过程例子:

当我们查看文件内容时,就需要多次系统调用来完成:首先调用 open() 打开文件,然后调用 read() 读取文件内容,并调用 write() 将内容写到标准输出,最后再调用 close() 关闭文件。

调用过程中的上下文切换: CPU 寄存器里原来用户态的指令位置,需要先保存起来。接着,为了执行内核态代码,CPU 寄存器需要更新为内核态指令的新位置。最后才是跳转到内核态运行内核任务。

而系统调用结束后,CPU 寄存器需要恢复原来保存的用户态,然后再切换到用户空间,继续运行进程。所以,一次系统调用的过程,其实是发生了两次 CPU 上下文切换。

需要注意的是,系统调用过程中,并不会涉及到虚拟内存等进程用户态的资源,也不会切换进程。这跟我们通常所说的进程上下文切换是不一样的:

- 进程上下文切换,是指从一个进程切换到另一个进程运行。

- 而系统调用过程中一直是同一个进程在运行。

系统调用过程通常称为特权模式切换,而不是上下文切换。但实际上,系统调用过程中,CPU 的上下文切换还是无法避免的。

2.2.1进程上下文切换跟系统调用又有什么区别呢?

进程是由内核来管理和调度的,进程的切换只能发生在内核态。所以,进程的上下文不仅包括了虚拟内存、栈、全局变量等用户空间的资源,还包括了内核堆栈、寄存器等内核空间的状态。

进程的上下文切换就比系统调用时多了一步:在保存当前进程的内核状态和 CPU 寄存器之前,需要先把该进程的虚拟内存、栈等保存下来;而加载了下一进程的内核态后,还需要刷新进程的虚拟内存和用户栈。

注意: Linux 通过 TLB(Translation Lookaside Buffer)来管理虚拟内存到物理内存的映射关系。当虚拟内存更新后,TLB 也需要刷新,内存的访问也会随之变慢。特别是在多处理器系统上,缓存是被多个处理器共享的,刷新缓存不仅会影响当前处理器的进程,还会影响共享缓存的其他处理器的进程。

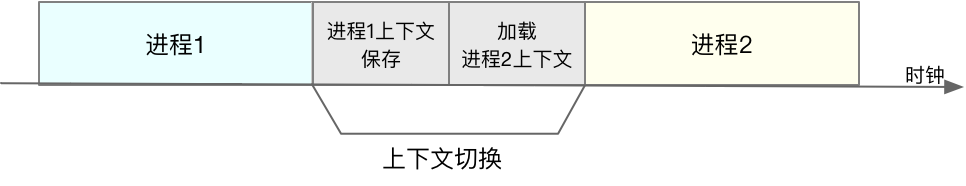

什么时候会切换进程上下文?

进程切换时才需要切换上下文

如2.2.1图

2.2.2 进程上下文切换(一个进程到另一个进程)过程

- 接受切换信号,挂起进程,记录当前的进程的虚拟内存、栈等资源存储

- 存储进程在 CPU 的上下文状态

- 检索下一个进程 CPU 的上下文

- 加载到 CPU 的寄存器中进行进程恢复

- 刷新进程保存的虚拟内存和用户栈

- 跳转到程序计数器指向的位置,恢复进程运行

很多进程切换时,会消耗大量时间去保存恢复 cpu 上下文和用户空间状态,而 cpu 分配给进程的时间片是有限的。这就导致 cpu 实际运行进程时间(cpu 利用率)大大降低。而当时间片用完,进程又必须挂起,就导致了 cpu 负载急剧升高。

2.2.2 进程在什么时候会被调度到 CPU 上?

- 进程执行完终止了,它之前使用的 CPU 会释放出来,这个时候再从就绪队列里,拿一个新的进程过来运行。

- 为了保证所有进程可以得到公平调度,CPU 时间被划分为一段段的时间片,这些时间片再被轮流分配给各个进程。这样,当某个进程的时间片耗尽了,就会被系统挂起,切换到其它正在等待 CPU 的进程运行。

- 进程在系统资源不足(比如内存不足)时,要等到资源满足后才可以运行,这个时候进程也会被挂起,并由系统调度其他进程运行。

- 进程通过睡眠函数 sleep 这样的方法将自己主动挂起时,自然也会重新调度。

- 有优先级更高的进程运行时,为了保证高优先级进程的运行,当前进程会被挂起,由高优先级进程来运行。

- 发生硬件中断时,CPU 上的进程会被中断挂起,转而执行内核中的中断服务程序。

2.3线程上下文切换

2.3.1 线程和进程的区别

线程是调度的基本单位,而进程则是资源拥有的基本单位.

所谓内核中的任务调度,实际上的调度对象是线程;而进程只是给线程提供了虚拟内存、全局变量等资源。所以,对于线程和进程,我们可以这么理解:

当进程只有一个线程时,可以认为进程就等于线程。

当进程拥有多个线程时,这些线程会共享相同的虚拟内存和全局变量等资源。这些资源在上下文切换时是不需要修改的。

另外,线程也有自己的私有数据,比如栈和寄存器等,这些在上下文切换时也是需要保存的。

2.3.2线程上下文切换的两种情况

- 前后两个线程属于不同进程。此时,因为资源不共享,所以切换过程就跟进程上下文切换是一样。

- 前后两个线程属于同一个进程。此时,因为虚拟内存是共享的,所以在切换时,虚拟内存这些资源就保持不动,只需要切换线程的私有数据、寄存器等不共享的数据。

2.4 中断上下文切换

为了快速响应硬件的事件,中断处理会打断进程的正常调度和执行,转而调用中断处理程序,响应设备事件。而在打断其他进程时,就需要将进程当前的状态保存下来,这样在中断结束后,进程仍然可以从原来的状态恢复运行。

中断上下文切换不涉及到进程的用户态。所以,即便中断过程打断了一个正处在用户态的进程,也不需要保存和恢复这个进程的虚拟内存、全局变量等用户态资源。中断上下文,其实只包括内核态中断服务程序执行所必需的状态,包括 CPU 寄存器、内核堆栈、硬件中断参数等。

对同一个 CPU 来说,中断处理比进程拥有更高的优先级,所以中断上下文切换并不会与进程上下文切换同时发生。同样道理,由于中断会打断正常进程的调度和执行,所以大部分中断处理程序都短小精悍,以便尽可能快的执行结束。

另外,跟进程上下文切换一样,中断上下文切换也需要消耗 CPU,切换次数过多也会耗费大量的 CPU,甚至严重降低系统的整体性能。所以,当你发现中断次数过多时,就需要注意去排查它是否会给你的系统带来严重的性能问题。

2.5 基本小结

对同一个 CPU 来说,中断处理比进程拥有更高的优先级,所以中断上下文切换并不会与进程上下文切换同时发生。同样道理,由于中断会打断正常进程的调度和执行,所以大部分中断处理程序都短小精悍,以便尽可能快的执行结束。

另外,跟进程上下文切换一样,中断上下文切换也需要消耗 CPU,切换次数过多也会耗费大量的 CPU,甚至严重降低系统的整体性能。所以,当你发现中断次数过多时,就需要注意去排查它是否会给你的系统带来严重的性能问题。

2.6工具推荐

vmstat 是一个常用的系统性能分析工具,主要用来分析系统的内存使用情况,也常用来分析 CPU 上下文切换和中断的次数。

root@srv1:~# vmstat -w

procs -----------------------memory---------------------- ---swap-- -----io---- -system-- --------cpu--------

r b swpd free buff cache si so bi bo in cs us sy id wa st

0 0 33024 183676 1241436 1520160 0 0 4 44 0 5 3 1 95 0 0

- cs(context switch)是每秒上下文切换的次数。

- in(interrupt)则是每秒中断的次数。

- r(Running or Runnable)是就绪队列的长度,也就是正在运行和等待 CPU 的进程数。

- b(Blocked)则是处于不可中断睡眠状态的进程数。

pidstat

root@srv1:~# pidstat -w **显示上下文切换, 主动切换, 被动切换**

Linux 4.15.0-143-generic (srv1) 07/05/2021 _x86_64_ (2 CPU)

10:57:55 AM UID PID cswch/s nvcswch/s Command

10:57:55 AM 0 1 0.03 0.00 systemd

10:57:55 AM 0 2 0.00 0.00 kthreadd

10:57:55 AM 0 4 0.00 0.00 kworker/0:0H

10:57:55 AM 0 6 0.00 0.00 mm_percpu_wq

10:57:55 AM 0 7 4.61 0.01 ksoftirqd/0

10:57:55 AM 0 8 70.51 0.00 rcu_sched

- cswch ,表示每秒主动上下文切换(voluntary context switches)的次数

- nvcswch ,表示每秒被动上下文切换(non voluntary context switches)的次数。

主动上下文切换,是指进程无法获取所需资源,导致的上下文切换。比如说, I/O、内存等系统资源不足时,就会发生主动上下文切换。

被动上下文切换,则是指进程由于时间片已到等原因,被系统强制调度,进而发生的上下文切换。比如说,大量进程都在争抢 CPU 时,就容易发生被动上下文切换

root@srv1:~# dstat -y **显示系统中断和上下文切换的整体信息**

---system--

int csw

2320 5443

1955 5006

1809 4440

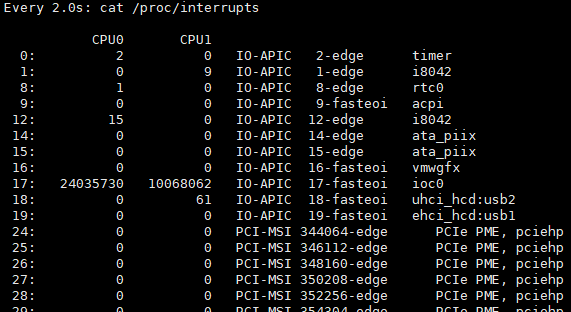

watch -d cat /proc/interrupts 分析软件终端的类别

2.7 上下文切换频率是多少次才算正常呢?

这个数值其实取决于系统本身的 CPU 性能。,如果系统的上下文切换次数比较稳定,那么从数百到一万以内,都应该算是正常的。但当上下文切换次数超过一万次,或者切换次数出现数量级的增长时,就很可能已经出现了性能问题。

还需要根据上下文切换的类型,再做具体分析。比方说:

- 自愿上下文切换变多了,说明进程都在等待资源,有可能发生了 I/O 等其他问题;

- 非自愿上下文切换变多了,说明进程都在被强制调度,也就是都在争抢 CPU,说明 CPU 的确成了瓶颈;

- 中断次数变多了,说明 CPU 被中断处理程序占用,还需要通过查看 /proc/interrupts 文件来分析具体的中断类型

3. 总结

3.1 导致cpu负载升高的原因

导致 cpu 平均负载升高的原因

1:CPU 密集型

2:I/O 密集型

3:大量进程竞争 cpu

3.2 常用工具

vmstat, uptime, top, dstat, pidstat

参考 Linux性能优化实战

浙公网安备 33010602011771号

浙公网安备 33010602011771号