完整教程:LLM - 从 GPU 到智能应用:构建 AI 系统的五层技术栈不完全指北

文章目录

概述

许多团队在做 AI 应用时都有类似体验:模型参数越来越大、能力越来越强,但真正落地时,却频频遭遇“跑不动、接不进业务、用户不用”的尴尬局面。

背后原因往往不是“模型不够强”,而是缺少从硬件到应用的全栈视角,忽略了基础设施、数据、编排和产品形态之间的系统性关系。

本文面向开发者、架构师和工艺决策者,从一个真实的场景出发,系统拆解 AI 技术栈的五个关键层次,并给出选型思路、实践建议与成本权衡。

一、场景出发

1.1 需求场景:如何高效读论文

假设你要为一个XX团队构建 AI 框架,目标是帮助科学家高效理解和分析最新论文。

这些科研人员每月要面对成百上千篇文献,既要筛选,又要做交叉对比和趋势分析,人工成本极高。

典型挑战包括:

- 领域高度专业,需要专业背景才能读懂

- 最新论文往往在模型训练时间之后发布,LLM“天然不知道”

- 需求不是简单“生成摘要”,而是要做交叉引用、趋势分析、假设验证等复杂任务

如果只“选一个据说擅长科学任务的大模型”,挑战远远解决不了。还必须回答:

- 放在哪里跑:本地 GPU、云端 GPU,还是终端设备?

- 最新论文如何喂给模型、如何高效检索?

- “分析论文”这个复杂任务怎么拆解、如何自检结果?

- 科学家在什么界面、以什么方式使用该系统?

这就引出了一个完整的五层 AI 技术栈。

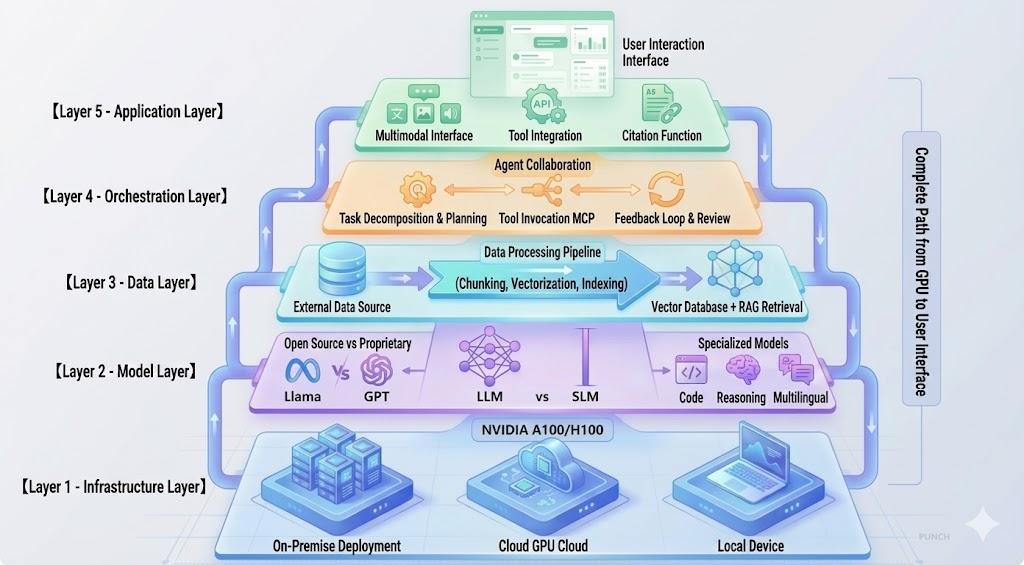

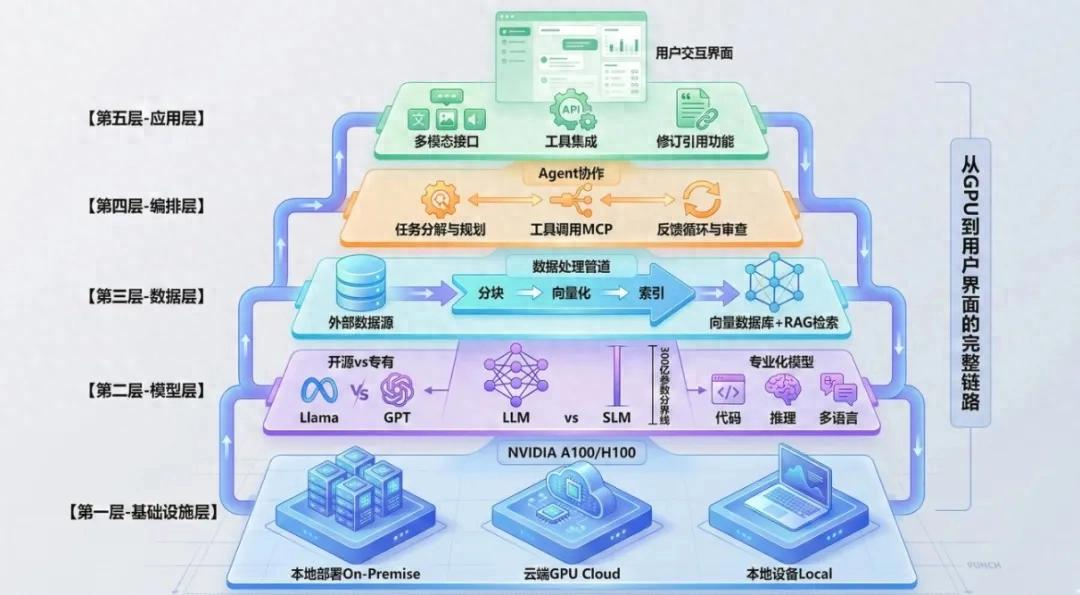

二、AI 五层技术栈总览

2.1 自底向上的五层结构

一个可落地的 AI 系统,可以抽象为自底向上的五层:

- 基础设施层(Infrastructure)

- 模型层(Model)

- 数据层(Data)

- 编排层(Orchestration)

- 应用层(Application)

这五层分别解决:算力、能力、知识、任务流程和用户体验的问题,每层都直接影响性能、成本和可靠性。

2.2 每一层在平台中的角色

- 基础设施层:决定“能不能跑起来”“跑得快不快”“素材放哪儿”

- 模型层:决定“能听懂人话”“能不能推理”“是否适配领域”

- 数据层:决定“知不知道最新事实”“能否利用私有知识”

- 编排层:决定“复杂任务能否拆解并可靠执行”

- 应用层:决定“用户愿不愿意用、用得爽不爽”

接下来从下到上逐层展开。

三、第一层:基础设施——GPU 在哪儿,AI 就在哪儿跑

LLM 不再是普通软件,它天然依赖 GPU 等专用算力。常见的部署方式主要有三种:本地部署、云端 GPU、本地设备。

3.1 三种部署模式概览

| 维度 | 本地部署(On-Premise) | 云端 GPU(Cloud) | 本地设备(Laptop/Edge) |

|---|---|---|---|

| 控制力 | 完全自控 | 受云厂商约束 | 完全自控 |

| 初始投入 | 极高 | 极低 | 已 sunk cost |

| 运维复杂度 | 高 | 低 | 低 |

| 数据安全 | 最好 | 取决于云与策略 | 最好 |

| 可扩展性 | 硬件级扩容 | 弹性极佳 | 差 |

| 典型场景 | 金融、医疗、政府 | 初创、弹性业务 | 个人、边缘、隐私 |

模式一:本地部署(On-Premise)

- 适用:金融、医疗、政府等强合规/高敏感数据场景

- 优点:

- 完全掌控硬件与拓扑,可深度优化性能

- 素材不出机房,更易满足 GDPR、HIPAA 等合规要求

- 性能稳定,不受云上邻居影响

- 成本:

- A100/H100 级别服务器单价约在数万美元量级

- 需持续投入电力、制冷、机房与运维人力

模式二:云端 GPU(Cloud)

- 适用:初创公司、迅速原型、负载波动明显的业务

- 优点:

- 零硬件前置投入,按小时租用 GPU

- 几分钟内从 1 张扩到几十上百张

- 可就近选择数据中心降低延迟

- 成本示例(2025 年量级):

- A100:约 4–5 美元/小时

- H100:约 8–10 美元/小时

- 若 24×7 跑一台 A100,月成本约 3,000 美元以上

很多团队会结合云上 GPU + 自部署开源模型,规避高额专有模型 API 成本

模式三:本地设备(Laptop / Edge)

- 适用:个人实验、离线场景、边缘计算或强隐私需求的小规模任务

- 优点:

- 无云资源费,可离线运行

- 数据完全留在本机

- 限制:

- 对内存与显存要求较高

- 通常只能跑 70 亿参数以下的小模型(量化版)

例如在一台 32GB 内存的 MacBook Pro M2 Max 上运行 Llama 3 8B 量化模型,推理速度可以达到每秒二三十 token,足够做原型和本地助手。

四、第二层:模型——从“多大”到“多适合”

“用什么模型以及用几个模型”。截至 2025 年,模型数量呈指数增长,合理选型比轻松追新更重要。就是在具备算力之后,第二个关键决策

4.1 三个关键维度:开源/专有、大/小、通用/专业

维度一:开源 vs 专有

- 开源模型(Llama 3、Mistral、Qwen 、DeepSeek等):

- 本地/云端皆可自部署

- 支持微调,可深度贴合垂直领域

- 无 per-token 费用,但需自建推理基础设施

- 专有模型(GPT-4、Claude 3.5、Gemini 等):

- “开箱即用”,API 调用门槛低

- 综合能力通常领先

- 按 token 计费,成本不确定,且内容需出站

一般而言:做通用任务且对敏感数据要求不高时,专有模型是快速起步选项;需要严格内容控制或深度行业定制时,开源模型更具战略价值。

维度二:LLM vs SLM(大模型 vs 小模型)

| 维度 | 大模型 LLM | 小模型 SLM |

|---|---|---|

| 参数规模 | 30B–T 级 | 通常 <30B |

| 通用能力 | 强 | 相对有限 |

| 推理能力 | 强 | 视微调方向而定 |

| 资源需求 | 高端 GPU | 笔记本/边缘也可 |

| 成本与延迟 | 高 | 低很多 |

| 适用场景 | 多任务、复杂推理 | 单一任务、实时、高并发 |

在论文场景中,可以在云端部署一个较大的专用 LLM 处理复杂分析,同时用若干 SLM 执行结构化抽取、格式转换等简单子任务。

维度三:通用 vs 专业化模型

- 代码生成专用:CodeLlama, StarCoder 等

- 强推理模型:o1、DeepSeek-R1 等

- 多语言/中文增强:Qwen、ChatGLM 等

- 工具调用增强:支撑高可靠 Function Calling 的系列模型

五、第三层:数据——让模型“知道你知道的”

模型再强,内部知识也是静态的。要让系统掌握最新论文、企业内部文档和实时数据,就必须设计好数据层。

5.1 数据层的三大组件

组件一:外部数据源

常见数据源包括

- 论文库(PubMed、arXiv)

- 企业知识库与内部文档

- 业务数据库与日志

- 用户上传的 PDF、Word、CSV 等

关键问题不在于“信息多不多”,而是“能否高质量地检索和利用”。

组件二:数据处理管道

原始文档进入体系后,通常要经历:

- 文本/结构化信息提取(从 PDF、Word、HTML 等)

- 分块(Chunking),控制每块长度与语义完整性

- 向量化(Embedding),将文本映射到高维向量空间

- 构建索引并写入向量数据库

利用语义向量,有效解决同义词与表达差异问题。

组件三:向量数据库与 RAG

RAG(Retrieval-Augmented Generation)已经成为让 LLM 使用外部知识的事实标准流程:

- 将用户疑问向量化

- 在向量库中检索出若干相关文档片段

- 将问题 + 检索结果拼接进 Prompt

- 由 LLM 基于这些“证据”生成回答

常见向量数据库包括 Pinecone、Weaviate、Milvus、FAISS 等,选型时需权衡规模、性能、托管/自建与成本。

六、第四层:编排——把一次“对话”变成一条“流程线”

当任务从“帮我总结这篇论文”升级为“对 50 篇论文做趋势分析并提出研究假设”时,单次模型调用已远远不够。编排层负责把复杂需求拆解为可执行的多步流程。

6.1 编排层的三项核心能力

能力一:任务规划(Planning)

面对类似“总结 2025 年 mRNA 疫苗最新进展,并结合本团队 2024 年工作做对比”这样的请求,环境需要自动规划:

- 检索 2025 年相关论文

- 抽取每篇论文的核心发现

- 以主题维度聚类(新靶点、递送载体、临床阶段等)

- 检索团队 2024 年内部研究

- 生成对比分析与趋势总结

通过这一规划步骤本身就能够由 LLM 在“规划模式”下完成。

能力二:器具调用(Tool / Function Calling)

LLM 本身不适合做:数据库查询、大规模数值计算、制图等操作,需要调用外部工具:

- 文献 API(如 PubMed)

- 内部实验数据库

- Python 执行环境用于统计与可视化

- 检索系统与知识图谱

MCP(Model Context Protocol)提供了统一的工具接口规范,使得模型可以以标准方式发现和调用各种软件,并在多次调用间共享上下文。

能力三:反馈循环与自我审查

为了降低“一本正经地胡说”的风险,可以在编排层引入 Reviewer Agent,对生成内容进行二次审查:

- 检查结论是否有引用支撑

- 否与原文一致就是验证数值/实验结果

- 对不确定部分发起二次检索与补充

“生成 → 审查 → 补充 → 再生成”的闭环,行显著提升系统可靠性,尤其适用于高风险领域如医疗和金融。

6.2 常见编排框架

- LangChain:成熟、生态丰富,适合构建复杂 Agent 工作流

- LlamaIndex:专注 RAG,擅长文档索引和检索

- Haystack:偏企业级 NLP 管道,擅长搜索集成

- AutoGen:多 Agent 协作框架

在本文场景中,一个典型选择是:LangChain 负责多步流程 + MCP 负责统一工具调用协议。

七、第五层:应用——决定“这不是 Demo,而是生产工具”

再好的模型与编排,倘若没有合适的交互界面与工作流集成,很容易停留在 Demo 阶段。应用层决定了系统的日常存在方式。

7.1 界面形态:不止是一个输入框

对于药物研发场景,实用的应用层通常具备:

- 文件入口:支撑一键上传 PDF/Word 文献

- 多模态输出:用表格、图表、标注高亮、结构化要点呈现结果

- 引用体系:每条结论均有可点击的文献出处

- 可编辑与版本管理:科学家可以对 AI 草稿进行修订与追踪

多模态交互还可以包括:上传实验截图、结构式图像,由模型辅助解释或结构化抽取。

7.2 与现有工具的集成

一个真正“用起来”的架构,必须嵌入既有工作流,而不是让用户跳出主战场:

- 和文献管理工具(Zotero、Mendeley)集成,自动同步论文库

- 和协作应用(Slack、Teams)集成,在讨论中直接调用分析能力

- 和知识管理工具(Notion、Obsidian)集成,一键保存分析结果

- 对外暴露 REST API,使团队的其他内部系统可以编程调用

对药物团队而言,最好是:在原来的文献管理或内部门户中,无痛地多出一个“AI 助理”按钮即可。

八、五层协同:一次完整请求在系统中的旅程

将上面五层串联起来,回到前面的案例:科学家上传一篇 2025 年的论文,并提问“这篇工作的核心创新是什么,与大家 2024 年的研究有什么联系?”

一个典型的执行链条如下:

- 应用层:接收 PDF 和困难,触发“论文对比分析”流程

- 编排层:规划步骤,依次调用“PDF 解析”“团队研究检索”“对比分析”等子任务

- 数据层:

- 抽取并向量化新论文内容

- 在向量库中检索团队 2024 年研究

- 模型层:

- 调用生物医学专用 LLM,生成初版分析与对比

- 编排层(审查子流程):

- 否存在无引用结论或明显冲突就是Reviewer Agent 检查

- 如有问题,追加检索与修订

- 应用层:以报告形式呈现结果,包含:核心创新要点、对比表格、关键段落高亮与引用链接

- 基础设施层:在后台保证整个流水线以可接受的时延和成本搞定推理

任何一层出问题,都会直观反映为用户体验的下降,如响应变慢、错误增多、结果不可验证等。

九、成本与性能:三种典型技巧栈组合的取舍

在实际落地时,科技决策往往体现在“钱与体验”的权衡上。下面以三种典型方案为例做粗略对比:

9.1 三种常见方案

| 方案 | 基础设施 | 模型 | 数据层 | 预估月度主要成本特征 |

|---|---|---|---|---|

| A:云端 + 专有模型 | 云上 GPU/Serverless | GPT-4 等 | 托管向量库 | 前期快、API 成本高 |

| B:本地 + 开源大模型 | 自建 GPU 集群 | Llama 等 | 自建向量库 | 一次性高投入,长期均摊 |

| C:云端 + 开源大模型 | 云上 GPU 自部署 | Llama 等 | 自建向量库 | 综合成本较优 |

以中小团队构建内部 AI 助理为例,方案 C(云端自部署开源模型)往往是“性价比 + 可控性”的平衡点。

十、结语:用全栈视角设计 AI 系统

如果只盯着某一个“最强模型”,AI 系统很容易陷入“看起来很厉害,但实际用不起来”的陷阱。

真正可用、可靠、可扩展的 AI 环境,必须从 GPU 到应用层进行整体设计,在五个层次上做出清晰的工程与产品决策。

对于开发者和技术负责人而言,更重要的不是“追哪一个最新模型”,而是建立一种全栈思维:

- 明确场景与约束

- 分解到五层技能栈

- 在每一层做出透明的权衡与选型

- 让整条链路可监控、可优化、可演化

只有当五层真正协同工作时,AI 才能从实验室的 Demo,变成科研和业务中的核心基础设施。

浙公网安备 33010602011771号

浙公网安备 33010602011771号