详细介绍:工程化路径:当我们信任并拥抱 AI,超级潜力才真正被点燃

目录

(四)管理者的心理障碍:害怕 AI 替代自己,而不是激活团队

(六)最终结论:组织吃不到 AI 红利,是因为它们没真正“把任务交给 AI”

(一)使用可审计、可回溯的 Agent 架构:让信任有“底”和“边界”

(二)让 AI 逐步获得权限,而不是“一步到位”:信任是一种“渐进式授权”

(三)人类从“执行者”转向“监护者”:角色变化是信任的真正标志

(四)用数据让 AI 持续自我增强:信任不是终点,而是飞轮的起点

思考分享,感谢您的阅读!本文通过阅读里德·霍夫曼相关观念和表诉且核心针对“当我们信任与拥抱AI时,就真的启动了AI的超级潜力”这些内容进行一些思考。

一、为什么“信任”是 AI 超级潜力的启动器?

里德·霍夫曼提出的关键点不是“AI 很强”,而是:

AI 的潜力并不是由模型规模或算力直接决定的,而是由社会、组织和开发者愿不愿意真正使用 AI 来改变工作方式决定的。

一个非常工程化、系统化的判断。就是这并非哲学观点,而

在算法、模型、工具链都越来越成熟的背景下,限制 AI 的瓶颈正在从科技约束 → 组织与心智约束 转移:

技术层面已经具备可用性:模型越来越稳、越来越便宜、越来越符合开发者预期。

链路工具逐渐成熟:从 LangChain 到 OpenAI API,再到企业级 Agent 框架。

系统集成能力比过去任何阶段都更容易落地。

但真正决定“AI 是否能创造巨大价值”的,是人和组织是否愿意把关键节点交给 AI。

换句话说,AI 潜力的触发条件不是“能不能做”,而是“敢不敢让它做”。

而这背后有深刻的技巧逻辑。

“信任阈值”后的指数跃迁就是二、AI 的潜能不是线性累加,而

:就是大部分组织在 AI 落地上遇到的最大难题

AI 应用强度过弱,导致能力未形成闭环。

当你只把 AI 当成一个增强工具(辅助写代码、写方案、总结文档),你得到的是静态收益;

但当你把 AI 赋予代理权(自主执行任务、调用工具、持续优化),系统就会发生质变。

这背后是智能系统设计中的一个核心规律:从“工具”到“代理”,AI 的能级被彻底改变

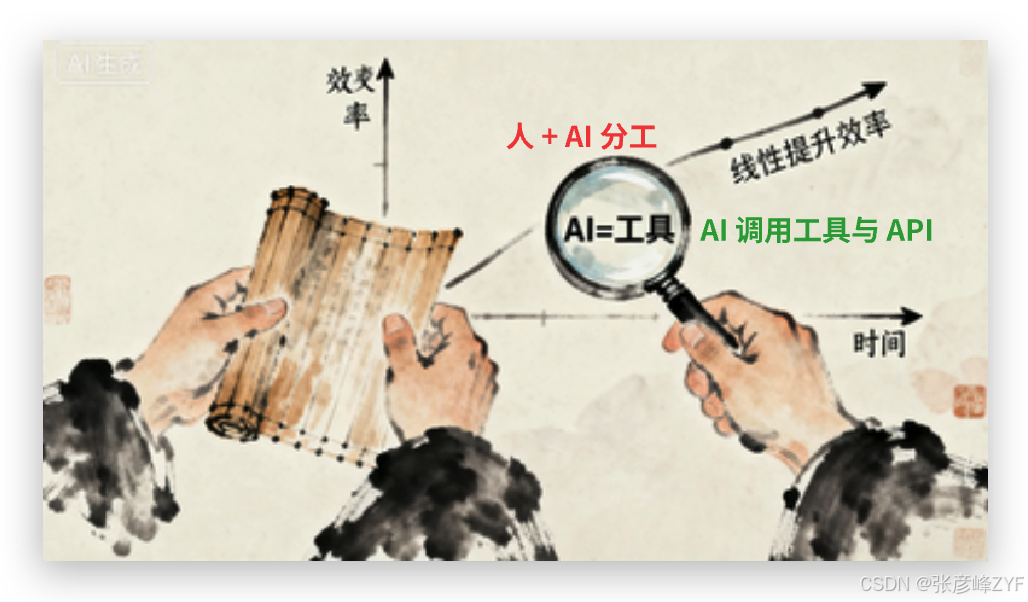

| AI 阶段 | 系统结构 | 能力模式 | 潜力上限 |

|---|---|---|---|

| 第一阶段:设备型 AI | AI = 工具 | 用户驱动 | 线性提升效率 |

| 第二阶段:协作者型 AI | 人 + AI 分工 | 协作驱动 | 加速知识生产 |

| 第三阶段:自治代理型 AI | AI 调用程序与 API | 自主驱动 | 指数级价值创造 |

里德·霍夫曼说的“拥抱”其实指的是:

把 AI 从一个“可控工具”提升为“可信代理”。

当开发者让 AI 有能力:

自主调用 API

自主写脚本

自主规划多步骤任务

自主优化策略

系统就从 human-in-the-loop 变成 AI-in-the-loop,“潜力边界”因此被彻底重写。

阈值条件。就是这就是为什么“信任”

三、手艺角度拆解:为什么信任 AI 会解锁超级潜力?

这是一个系统工程问题,而不是一句口号。

下面从技术底层解释为何“拥抱 AI”会带来指数级提升。

(一)AI 能让系统从“局部最优”跳到“全局最优”

:就是传统环境由人制定规则,难免受限于人的经验、注意力与误差。AI 的优势

跨域知识整合能力极强

能挖掘非人类直觉的最优解

可根据数据动态更新策略

能执行多步骤逻辑链路规划

当组织愿意让 AI 参与策略制定、流程自动化、业务执行时,系统会从局部优化 → 全局优化。

例:

物流调度系统由 AI 规划路径,而不是人写规则

推荐系统由 AI 设计策略,而不是人调参

编排系统让 AI 自动决定何时调用哪个服务

效果不是“效率提升 20%”,而是出现新的能力(人类之前没有的能力)。

(二)信任使得 AI 能真正进入“连续执行”模式

大多数组织的 AI 使用方式是“离散调用”:

用户问一句

模型答一句

但一旦系统把流程权交给 AI,它进入“连续执行”:

自己规划步骤

自己调用函数

自己修正错误

自己结束任务

连续执行是一切“智能体(Agent)”力量的核心。

如果组织不愿意让 AI 执行任务(不信任),那它永远无法进入这个模式。

(三)当 AI 被赋予代理权,系统整合能力急剧放大

AI 代理是一个新的软件层,它的能力不是独立的,而是继承整个软件生态:

AI 拥有你给它的所有器具的能力

如果你让 AI 代理:

读写数据库

运行 Git

调用业务服务

执行 shell 命令

访问企业 API

编排数据流任务

那它并不是“一个智能体”,而是变成了组织的“软体外骨骼”。

这才是里德·霍夫曼口中的“超级潜力”。

四、为什么很多组织看得到 AI,却吃不到 AI 的红利?

即便 2025 年的 AI 已经强大到令人震惊,我们依旧看到一个巨大而讽刺的现实:

会喊“AI 时代来了”的组织很多,但真正让 AI 驱动生产力跃迁的组织极少。

一个看似抽象,却实际最残酷的东西:就是究其原因,不是缺技术、缺预算、缺场景,这些都不是核心瓶颈。真正的瓶颈

它们卡在了“信任门槛”上。

该“门槛”是一个深层次系统性问题,它不是情绪、不是观念,而是组织结构、流程、责任机制与工艺理解之间的多维度冲突。

因为组织仍在用“工具范式”理解它就是(一)AI 不被信任,

绝大多数企业把 AI 当作:

PPT 生成器

文案助手

编程提示器

内容洞察工具

这是一种“工具式使用方式”。困难是:工具式运用方式永远只能产生器具级收益。

它无法:

自动化流程

重新定义业务

取代低价值岗位

改造决策结构

重写用户体验

迭代产品模型

也就是说,它无法产生系统性价值。

但信任 AI 的本质是什么?

不是让 AI 更聪明,而是让整个组织从“应用范式”跨越到“代理范式(Agent Paradigm)”。

设备是用来“辅助”的,代理是用来“执行”的。

当组织不敢让 AI 执行,就永远无法进入“潜力飞轮”。

这就是为什么很多企业投资了 AI,但收益几乎为零。

(二)组织结构本身和“AI 协作模式”天然冲突

AI 真正能带来价值的地方,是流程闭环和职责边界。但企业结构是几十年延伸下来的金字塔型:

一层层审批

一层层拆解

一步步人工执行

一步步反馈返工

:就是而 AI 协作模式的核心

自动化

去中间层

快速反馈

自我优化

自主执行

结果是:

现有流程阻塞 AI,AI 也无法改变流程。

组织并不是不想信任 AI,而是它们被自己的流程和层级“禁锢”了。

AI 的效率是 10 倍的,组织的流程却只允许 1 倍的速度。

这就像让一台超级跑车在自行车道上跑——根本跑不起来。

(三)组织的风险机制天然不允许“AI 权限延展”

要让 AI 有价值,就必须给它权限,例如:

调用内部 API

执行 SQL

操作流水线

修改系统配置

执行业务动作

分配预算

进行策略决策

处理用户请求

但绝大多数组织的安全机制、合规要求、人为的责任链条是:

权限越低越安全,权限越高越危险。

AI 要发挥价值,是要:

让它做更大、更深、更难、更有风险的事情。

这两者天然冲突。所以组织的本能反应是:“AI 当然可以用,但不能让它影响关键链路。”

而恰恰是那些“关键链路”,才是 AI 真正能释放价值的地方。

于是组织陷入一个恶性循环:

不敢给权限 → AI 只能做浅层任务

AI 只能做浅层 → 证明不了价值

证明不了价值 → 更不敢给权限

最终大家都会得出一个误判:

“AI 好像没有想象中那么厉害。”

不是 AI 不够强,是组织不给它发挥实力的空间。

(四)管理者的心理障碍:害怕 AI 替代自己,而不是激活团队

:就是很多管理者口头说“我们要拥抱 AI”,但潜意识担心的

AI 是否会让团队不再依赖我?

AI 是否会降低管理的存在感?

AI 是否会暴露团队真实的低效率?

AI 是否会让我失去对流程的控制?

说白了,许多管理者要的不是真效率,而是“可控的效率”。

最不听话的程序,它会:就是AI

跨层级执行

自动优化策略

提出你没想到的改进

挑战人类的既定工作方式

它不尊重层级,只尊重目标。它不维护权力,只优化路径。

这对管理者来说是巨大的心理压力。

所以许多行业发生了怪象:

越是技术先进的部门,反而越害怕让 AI 真正自主执行任务。

因为 AI 不会问:“领导同意了吗?” 它只关心目标是否可以优化。

(五)组织对“AI 错误”零容忍,对“人类错误”却极其宽容

这是信任 AI 的最大障碍。

AI 一旦写错一段代码、一旦给错一条建议、一旦调错一个参数,组织会议马上炸裂:

“AI 不靠谱!”

“AI 不可控!”

“风险太大!”

但你回头看看一个组织的人类团队:

产品经理每周犯错

运营每个月出纰漏

工程师每年事故

数据分析经常判断偏差

但组织对人的错误有天然容忍:

“下次注意。”

“没事,大家都会错。”

“当成经验。”

对 AI 的错误,却要求:零。不可能的。AI 要替代任务,它的错误率只需要一个条件:就是而这

不比人类更差即可。

但假如组织要求 AI 达到“完美”,那它永远不会被采用,永远无法积累经验,永远无法变好。

于是再次进入死循环:

不信任 → 不敢用

不敢用 → 不会变好

不会变好 → 更不信任

组织性“AI 不成熟”其实都是自我制造的幻觉。

(六)最终结论:组织吃不到 AI 红利,是因为它们没真正“把任务交给 AI”

技术不是主角。

模型也不是主角。

主角。就是工具链不

组织结构才是 AI 时代真正的阻力与变量。不改变组织的协作方式,AI 永远不可能改变你的业务结构。不用信仰,也不用盲目崇拜,只是把 AI 当作一个真正的“能力体(Capability Entity)”,然后给予职责、权限、流程、容错、舞台。

五、大家应该如何“信任并拥抱 AI”?(工程化路径)

情绪层面的“我相信它”,而是就是真正的信任并不工程化、架构化、可审计、可控的“系统性信任”。

冒险式的勇气。就是它是一种结构设计,而不

下面四条,是目前真正让组织开始吃到 AI 红利的核心路径。

(一)使用可审计、可回溯的 Agent 架构:让信任有“底”和“边界”

组织之所以不敢信任 AI,是因为觉得它不可控、不可预测。但事实是:

AI 不可预测,但可以被约束、被监控、被回放。

这就是可审计 Agent 架构的意义。

一个真正可用的 Agent 系统必须具备:

链路全记录(Action Trace):每个思考步骤、工具调用、参数输入,都能被完整回放。

可解释意图(Intent Report):AI 为什么这么做,你能看到“推理路径”。

自动化约束(Guardrails):例如速率限制、权限限制、策略限制。

这使得团队可以放心地让 AI 执行任务,因为:

任何一步都可追溯,任何偏差都能定位,任何风险都有边界。

信任从来不是“放手”,而是“把手放在正确的位置”。

(二)让 AI 逐步获得权限,而不是“一步到位”:信任是一种“渐进式授权”

AI 要创造价值,必须拥有权限。但权限不能一次性给到最大,否则组织会本能抗拒。

因此要求建立分级权限体系:

- Level 1:只读。AI 可以看数据、看文档、看日志,但不能写。

- Level 2:工具调用。它能够使用计算工具、API、模型链路,但不能修改真实环境。

- Level 3:受限写操控。比如创建草稿、生成 PR、写入 sandbox 环境。

- Level 4:自主执行任务。完全接管从规划到执行的链路,但仍在可审计框架下。

这是一种非常工程化的信任方式:

利用“最小风险实践”不断累积可信度,让 AI 自己用表现赢得权限。

AI 的能力不是凭空获得的,是在权限扩展中逐步展现的。

(三)人类从“执行者”转向“监护者”:角色变化是信任的真正标志

在 AI 时代,人类最核心的不是“做事”,而是:

设目标(Goal Setting)

定规则(Constraints)

做审计(Review)

控边界(Boundaries)

这是一个从“微观执行”向“宏观治理”的迁移。

以前人类的角色是:

“亲自做所有事情。”

现在的角色变成:

“确保 AI 做的是正确的事情。”

也就是说——你不需要信任 AI 的每一步,你只需要信任它的目标和边界不会偏离。

AI 做执行,人类做方向;

AI 做路径,人类做规范。

组织只要理解了这一点,就能真正让 AI 从“辅助型工具”升级为“自主型代理”。

(四)用数据让 AI 持续自我增强:信任不是终点,而是飞轮的起点

AI 和传统软件的最大区别就是:

它不是固定逻辑,而是一个可持续自我增强的平台。

你给它的数据越多、任务越多、执行越多,它就越熟练、越稳定、越准确。

这形成一个典型的“信任飞轮”:

给 AI 小任务

AI 执行得不错

你给它更多权限

AI 得到更多反馈

能力快速提升

信任再进一步

权限进一步扩大

系统进入指数级循环

这就是里德·霍夫曼所说的:

越信任 AI,它的潜力越能被点燃;

越拥抱 AI,它的能力越能自我放大。

AI 的能力的上限,

不是模型的规模,

不是算力的强弱,

你给它的“舞台大小”。就是而

“智能本身”就是六、结语:超级潜力来自“协作结构”,而不

里德·霍夫曼的真正意思不是“我们要崇拜 AI”,而是:

AI 的价值来自人与 AI 构成的协作系统,而这个环境的启动条件是“信任 + 拥抱”。

:就是技术角度的最终结论

AI 不是 CPU,而是“协作结构的放大器”

AI 的潜力是被启用方式激活的

组织给它的权限就是AI 的上限不是模型规模,而

信任是权限的前提

权限是智能的放大器

放大器越大,“超级潜力”就越充分显现

AI 的时代不是由 GPU 推动的,而是由“组织架构和心智架构”推动的。

当你愿意把重要任务交给 AI,那一刻开始,你真正进入了新的时代。

相关文章和讨论链接参考

《当大家信任与拥抱 AI 时,就真的启动了 AI 的超级潜力》 — 财新读书解读

财新 Mini+ 发布了霍夫曼自己撰文的一段,对“超级能动性(super-agency)”的解读。强调大量用户采用突破性技术会产生质变级的协作价值。

mini.caixin.com《The Guardian》访谈 — “Start using AI deeply. It is a huge intelligence amplifier.”

霍夫曼在采访中把 AI 视为大幅放大人类智能和行动力 (“agency”) 的工具。他还呼吁对 AI 的迭代部署,并以务实乐观的立场看待监管。

卫报《The Washington Post》节目记录 — “Superagency with Reid Hoffman”

录音文字稿(transcript)里,霍夫曼谈到 “agentic revolution”(能动性革命),强调 AI 带来的是一种增强人类行动能力的新范式。

The Washington Post《AI 赋能》(中文版)图书简介 /豆瓣

豆瓣对这本书做了介绍,可以用于确认书名、作者、核心主张等。

豆瓣读书霍夫曼本人观点汇总 — “面对 AI 前景,他将自己归入繁荣论者”

多篇中文媒体采访 /报导里都提到霍夫曼对 AI 的乐观态度,他主张“明智地冒险”,通过渐进部署技术。

科学网+1

浙公网安备 33010602011771号

浙公网安备 33010602011771号