循环神经网络(RNN)全面解析 - 详解

目录

1. RNN基本概念

1.1 什么是循环神经网络

循环神经网络(Recurrent Neural Network, RNN) 是一类专门用于处理序列数据的神经网络。与传统的前馈神经网络不同,RNN具有"记忆"能力,能够捕获序列中的时间依赖关系。

1.2 为什么需要RNN

在现实世界中,很多数据都具有序列特性:

时间序列:股票价格、天气数据、传感器读数

自然语言:句子、段落、文章

音频信号:语音、音乐

视频数据:连续的画面帧

2. RNN核心思想

2.1 循环连接机制

RNN的核心创新在于引入了循环连接,使得网络能够保持对之前信息的记忆。这种机制让RNN能够处理任意长度的序列。

2.2 参数共享

RNN在时间步之间共享相同的权重参数,这使得:

模型能够泛化到不同长度的序列

大大减少了需要学习的参数数量

捕获序列中的时间模式

3. RNN原理详解

3.1 RNN基本结构

输入序列: [x₀, x₁, x₂, ..., x_t]

隐藏状态: [h₀, h₁, h₂, ..., h_t]

输出序列: [y₀, y₁, y₂, ..., y_t]3.2 数学公式

RNN在每个时间步的计算可以表示为:

隐藏状态更新:

h_t = tanh(W_hh * h_{t-1} + W_xh * x_t + b_h)输出计算:

y_t = W_hy * h_t + b_y其中:

h_t:当前时间步的隐藏状态h_{t-1}:前一个时间步的隐藏状态x_t:当前时间步的输入W_*:权重矩阵b_*:偏置项

3.3 RRN变体对比

模型类型 | 结构特点 | 优点 | 缺点 | 适用场景 |

简单RNN | 最基本的循环结构 | 计算简单,参数少 | 梯度消失/爆炸问题 | 短序列任务 |

LSTM | 引入门控机制 | 解决长依赖问题 | 计算复杂,参数多 | 长序列,重要信息间隔远 |

GRU | 简化版LSTM | 计算效率高 | 极端长序列可能不如LSTM | 中等长度序列,资源受限 |

双向RNN | 同时考虑前后文 | 信息更全面 | 不能实时处理 | 需要完整序列的任务 |

3.4 RNN门控机制详解

LSTM的三个门:

遗忘门:决定从细胞状态中丢弃什么信息

输入门:决定哪些新信息存储在细胞状态中

输出门:决定输出什么信息

GRU的两个门:

重置门:决定如何将新输入与之前的记忆结合

更新门:决定保留多少之前的记忆

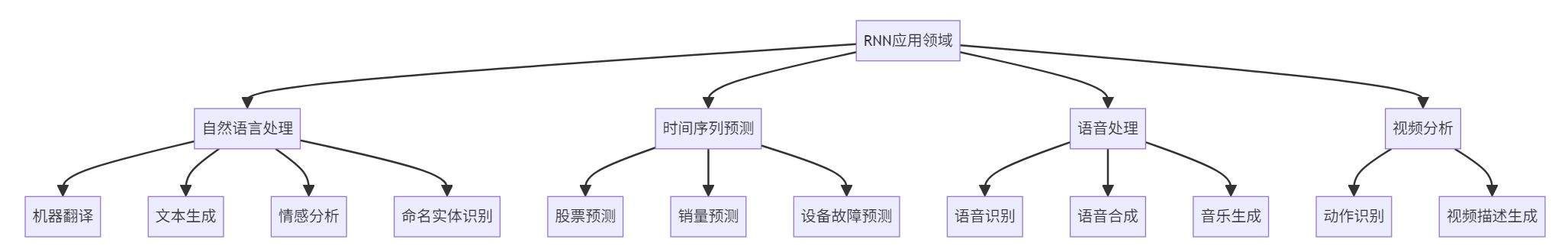

4. RNN应用场景

4.1 主要应用领域

4.2 输入输出模式对比

模式类型 | 输入输出关系 | 典型应用 | 示例 |

一对一 | 单个输入 → 单个输出 | 图像分类 | 图片 → 类别标签 |

一对多 | 单个输入 → 序列输出 | 图像描述 | 图片 → 文字描述 |

多对一 | 序列输入 → 单个输出 | 情感分析 | 句子 → 情感极性 |

多对多(同步) | 序列输入 → 同步序列输出 | 词性标注 | 单词序列 → 词性序列 |

多对多(异步) | 序列输入 → 异步序列输出 | 机器翻译 | 源语言句子 → 目标语言句子 |

5. TensorFlow代码实现

5.1 环境准备和数据处理

import ten

浙公网安备 33010602011771号

浙公网安备 33010602011771号