【ComfyUI】Wan2.2 Smooth Mix 首尾帧图像电影质感视频生成 - 教程

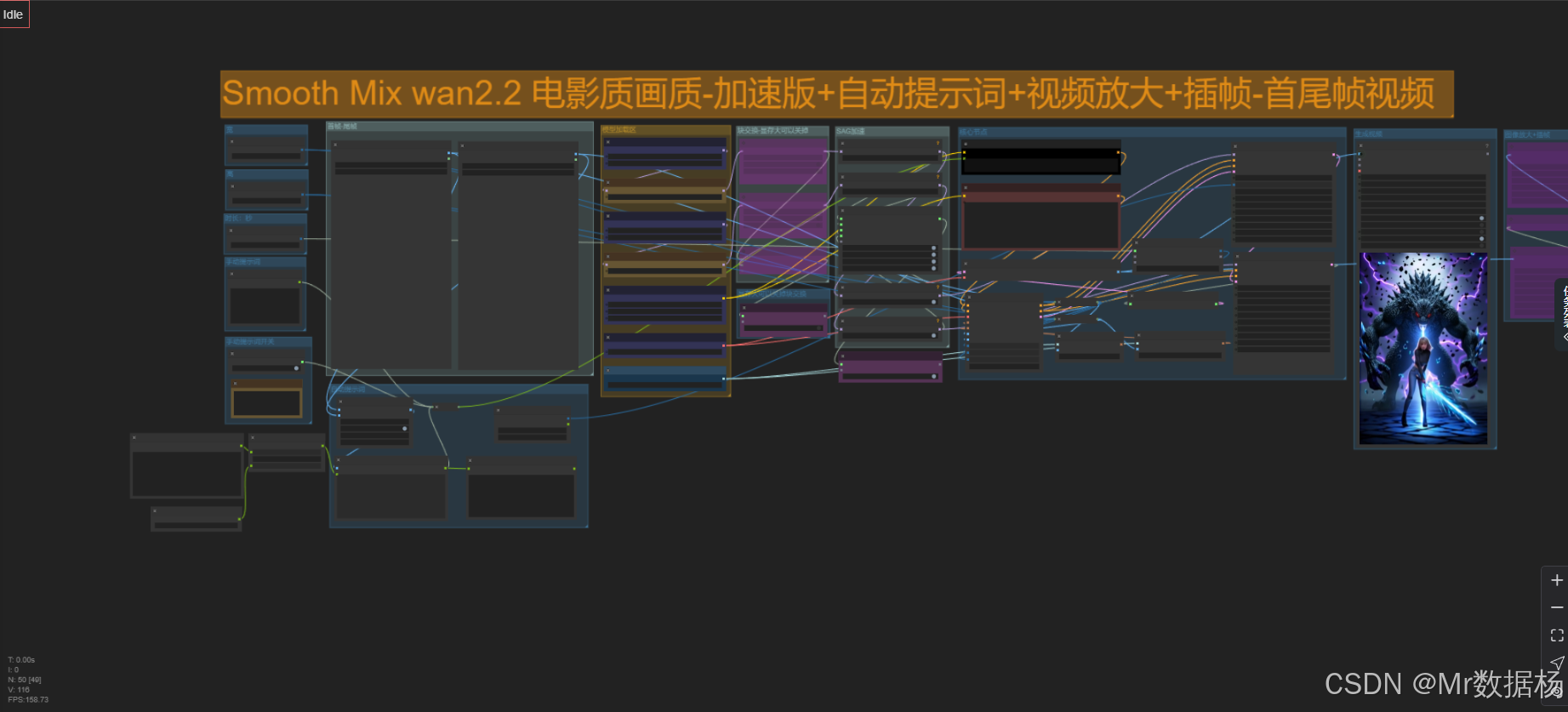

今天给大家演示一个高质量、自动化的ComfyUI 视频生成工作流,其亮点在于经过两张图像(视频首帧与尾帧)自动生成画面提示词,并融合大模型搭建影视级的细腻镜头过渡。该流程还集成了视频放大、插帧、文本提示控制、双模型混合、自动构图等关键模块,实现从图像到动态影像的全链路生成效果。工作流极大简化了视频创作门槛,适用于角色变身、场景切换、动作进化等高需求表达场景。

工作流介绍

本工作流名为「Smooth Mix wan2.2 电影质画质-加速版」,通过组合多个核心模型、特效节点与推理链路,实现从静态图像输入到电影质感视频输出的全过程。其核心流程包括模型混合(BlockSwap)、提示词智能切换、首尾帧理解与过渡、图像插帧生成中间画面、再通过视频输出模块合成为一段完整视频。

此工作流使用了多个关键模型和 Node 节点,包括基于 wan2.2 的高动态 UNet 模型、自动提示生成节点、图像上下采样处理器、视觉语义理解模型、文本嵌入器、插帧算法与视频输出模块等。多个 Fast Bypasser 和 Mute/Repeater 节点提升了执行效率与灵活性,使复杂模型结构下的工作流依旧保持高性能。

核心模型

本工作流采用双 UNet 模型进行高低质图像路径的推理,通过 wanBlockSwap 节点实现模型混合,并加载相应的 VAE、CLIP、Vision 模型来支持不同层级的感知与推理。尤其使用 smoothMixWan22I2V14B 系列模型,使画面风格更加自然、细节丰富。

| 模型名称 | 说明 |

|---|---|

smoothMixWan22I2V14B_i2vHigh.safetensors | 高质感 UNet 模型,负责处理高动态画面推理,适用于首帧特写等关键细节场景 |

smoothMixWan22I2V14B_i2vLow.safetensors | 相对简化版本 UNet 模型,用于快速生成视频尾帧或插帧内容 |

wan_2.1_vae.safetensors | 专用 VAE 模型,用于将潜空间内容转化为高保真图像 |

umt5_xxl_fp8_e4m3fn_scaled.safetensors | 高性能文本编码器 CLIP 模型,支撑多语言复杂提示理解 |

clip_vision_h.safetensors | 用于视觉语义提取的 CLIP Vision 模型,为首尾图像语义过渡提供支撑 |

Node节点

本流程大量使用模块化节点搭建出一套动态响应、可复用、易于扩展的视频合成系统。其中特别通过 wanBlockSwap 进行模型融合,PathchSageAttentionKJ 与 ModelPatchTorchSettings 调整内部注意力与精度推理策略。RH_Captioner 节点根据首尾帧生成符合视频语义的描述词,结合 KSamplerAdvanced 完成正负提示词采样,最终借助 WanFirstLastFrameToVideo 节点将所有视觉特征映射到完整视频输出。

| 节点名称 | 说明 |

|---|---|

wanBlockSwap | 实现模型 Block 结构融合,用于低/高质模型切换与融合 |

ModelSamplingSD3 | 控制采样风格变化,用于同一模型下不同风格采样策略 |

PathchSageAttentionKJ | 精调注意力机制,提升画面细节稳定性 |

ModelPatchTorchSettings | 控制是否启用 FP16 加速计算,用于降低显存负担 |

RH_Captioner | 核心大模型节点,负责分析首尾图生成中间画面提示词 |

WanFirstLastFrameToVideo | 将起始图像通过推理转化为连贯视频,支持 VAE 与 Vision 模型输入 |

RIFE VFI | 视频插帧节点,补足首尾之间帧数,提升动态流畅性 |

CR Upscale Image | 最终图像放大节点,确保输出视频满足高分辨率需求 |

工作流程

整个工作流围绕“从首尾帧生成视频”的目标进行分阶段处理。首先加载起始图像并进行图像拼接,交由 RH_Captioner 进行语义分析与提示词生成,再通过多路径的 UNet 模型分别进行风格建模与采样推理。中间使用 KSamplerAdvanced 进行步进采样,并使用 RIFE VFI 插帧生成完整动态过程。最后通过图像上采样与视频合成模块完成视频输出。

此流程划分为四大阶段:图像输入与语义分析、模型加载与提示词处理、推理采样与插帧生成、视频构建与输出。其中,语义构造与模型融合是保证视频画面连贯性与丰富性的关键环节。

| 流程序号 | 流程阶段 | 工作描述 | 使用节点 |

|---|---|---|---|

| 1 | 图像输入 | 加载首帧与尾帧图像,并通过 ImageStitch 拼接 | LoadImage, ImageStitch |

| 2 | 自动提示词生成 | 拼接图输入给 RH_Captioner 生成视频语义提示 | RH_Captioner, easy ifElse |

| 3 | 模型加载 | 加载双 UNet 模型进行 BlockSwap 组合 | UNETLoader, wanBlockSwap, ModelSamplingSD3 |

| 4 | 模型精调 | 添加注意力机制与精度设定以优化 UNet 推理 | PathchSageAttentionKJ, ModelPatchTorchSettings |

| 5 | 文本编码 | 加载 CLIP 与 Vision 模型进行文本与视觉语义嵌入 | CLIPLoader, CLIPTextEncode, CLIPVisionEncode |

| 6 | 初始视频生成 | 使用 WanFirstLastFrameToVideo 合成 latent 视频流 | WanFirstLastFrameToVideo |

| 7 | 二次采样生成 | 对 latent 图像应用两组 KSamplerAdvanced 进行细化 | KSamplerAdvanced(x2) |

| 8 | 插帧补全 | 使用 RIFE VFI 插帧扩展中间过程 | RIFE VFI |

| 9 | 图像放大 | 利用 Upscale 模块将插帧结果放大输出 | CR Upscale Image |

| 10 | 视频输出 | 将最终插帧结果转为视频并输出 | VHS_VideoCombine |

大模型应用

视频提示词生成核心:RH_Captioner

在本工作流中,RH_Captioner 是最关键的大模型节点,负责根据首尾帧拼接图自动生成完整的视频描述提示词(Prompt)。这个节点通过自然语言处理与图像理解,将静态视觉内容转化为具备时序与逻辑的动态镜头描述,是实现视频中“变化”核心逻辑的关键节点。其提示词严格遵循视频镜头语言规范,确保生成内容具备可视化表现力,适合直接用于正向提示输入。

| 节点名称 | Prompt信息 | 说明 |

|---|---|---|

| RH_Captioner | 你是一个视频提示词生成助手。用户将上传一张左右拼接图像:左边为视频首帧画面,右边为尾帧画面。你的任务是根据图像内容,合理脑补中间变化过程,生成一段不超过100字的视频画面提示词。 当前的视频主题是:科幻战斗,根据故事的内省搞定下面的关键词描述。 输出内容要求: 请生成一段连贯、具体、可执行的单段文字描述,整合以下三要素,且必须严格按照以下顺序出现: — 1. 运镜方式(Motion Language) 必须使用专业影视术语描述镜头运动,包括但不限于:推轨镜头(Dolly In)、拉远镜头(Zoom Out)、慢摇镜头(Slow Pan)、环绕镜头(Orbit Shot)、长镜头(Long Take)、变焦推进(Zoom Push) — 2. 主体变化(Subject Transformation) 描述图像主体从首帧到尾帧的变化过程,禁止模糊语言、禁止直接跳变,必须脑补中间步骤。 — 3. 背景/场景变化(Environment Evolution) 环境或背景必须与主体变化呼应,具体描述,不模糊化。 额外要求: 整体输出为一段完整句子,不拆句,不分段;总字数不得超过100字;不输出抽象语句;描述具有视频表现力。 现在开始:请根据用户上传的左右合成图像,严格按以上格式与逻辑生成视频提示词。 | 生成就是本节点的设计目标具象、有逻辑、具备时间推移感的视频描述语句,为后续模型采样提供明确的动态引导。它把图像对输入转化为高精度语言提示,是首尾图过渡推理的语言基石。 |

使用方法

本工作流使用了标准的 ComfyUI 输入输出机制,但在字段设置上聚焦于开始节点的图像上传、提示词选择机制与结束节点的视频输出定义。支持“自动提示”与“手动输入”两种模式自由切换。

开始节点

图像输入采用 LoadImage,结合提示词生成判断(布尔值开关)与分支控制节点来决定是否启用大模型自动生成描述。

| 字段名 | 含义 | 数据类型 |

|---|---|---|

| upload | 上传首帧/尾帧图像 | IMAGEUPLOAD |

| value(auto_prompt) | 是否启用自动提示词生成 | BOOLEAN |

| prompt(text) | 手动提示词输入内容 | STRING |

| stitched_image | 合成首尾帧拼接图像 | IMAGE |

结束节点

视频生成通过 WanFirstLastFrameToVideo、RIFE VFI、CR Upscale Image 组合完成,最后经 VHS_VideoCombine 导出。最终输出为视频格式。

| 字段名 | 含义 | 数据类型 |

|---|---|---|

| latent | 基于首尾帧生成的中间图像潜空间 | LATENT |

| frames | 所有插帧图像帧序列 | IMAGE(序列) |

| upscale_output | 经图像放大后的最终帧序列 | IMAGE |

| 视频合成输出 | 渲染为完整视频 | VIDEO |

应用场景

该工作流特别适合用于应该体现主体转化、风格演变与镜头动态变化的场景创作,尤其是二次元动画角色转变、游戏角色进化、影视剧镜头特效预演等应用中。用户只需准备两张图,即可经过提示词自动生成与插帧合成,快速构建具有专业视觉表现的视频序列。

不仅创作者能够快速出片,提升效率;影视制作团队亦可用来进行镜头前后状态的原型模拟。同时它也为 AI 视频内容创作者、动画制作者与剧本展示团队提供了极具扩展性的创作程序。

| 应用场景 | 使用目标 | 典型用户 | 展示内容 | 实现效果 |

|---|---|---|---|---|

| 二次元角色变身 | 展示角色从普通形态到机甲/魔法变身过程 | 动画创作者、Cos视频制作者 | 起始与结束形象,过渡过程自动构建 | 实现流畅角色造型演变动画 |

| 概念视频原型制作 | 预演剧本中镜头运动与环境演变 | 影视导演、预告片剪辑师 | 剧情片段关键帧图像 | 实现镜头语言与视觉叙事的结合 |

| 游戏角色动态演示 | 展示技能释放、状态变化等效果 | 游戏策划、宣传设计师 | 角色初始与释放状态图 | 自动生成技能过渡过程动画 |

| AI内容创作 | 利用AI自动构建视觉故事片段 | AI视频博主、独立制作人 | 任意图片对 | 快速获得高质量创意视频内容 |

开发与应用

更多 AIGC 与 ComfyUI工作流 相关研究学习内容请查阅:

更多内容桌面应用开发和学习文档请查阅:

AIGC软件平台Tauri+Django环境开发,支撑局域网使用

AIGC工具平台Tauri+Django常见错误与解决办法

AIGC软件平台Tauri+Django内容生产介绍和使用

AIGC工具平台Tauri+Django开源ComfyUI方案介绍和使用

AIGC工具平台Tauri+Django开源git项目介绍和采用

浙公网安备 33010602011771号

浙公网安备 33010602011771号