【论文阅读】SEDNet:Learning the Distribution of Errors in Stereo Matching for Joint Disparity and Uncertainty Estimation(CVPR2023)

title: Learning the Distribution of Errors in Stereo Matching for Joint Disparity and Uncertainty Estimation date: 2023-04-18 tags:

|

作者 |

Liyan Chen Weihan Wang Philippos Mordohai |

|

单位 |

Stevens Institute of Technology |

|

代码 |

https://github.com/lly00412/SEDNet.git |

|

期刊/会议 |

CVPR |

|

关键词 |

2023 |

0.摘要

We present a new loss function for joint disparity and uncertainty estimation in deep stereo matching. Our work is motivated by the need for precise uncertainty estimates and the observation that multi-task learning often leads to improved performance in all tasks. We show that this can be achieved by requiring the distribution of uncertainty to match the distribution of disparity errors via a KL divergence term in the network's loss function. A differentiable soft-histogramming technique is used to approximate the distributions so that they can be used in the loss. We experimentally assess the effectiveness of our approach and observe significant improvements in both disparity and uncertainty prediction on large datasets. Our code is available at https://github.com/lly00412/SEDNet.git.

- 问题:

我们的工作是出于对精确的不确定性估计的需要,以及观察到多任务学习通常会提高所有任务的表现。

- 工作内容:

提出了一种用于深度立体匹配中联结视差和不确定度估计的损失函数。我们表明,这可以通过要求不确定性的分布通过网络损失函数中的KL散度项匹配视差误差的分布来实现。采用可软直方图技术(soft-histogramming technique)对分布进行近似,使其可用于损失的计算。

- 效果:

我们通过实验评估了该方法的有效性,并观察到在大数据集上的差异和不确定性预测方面的显著改进。

1. Introduction

我们区分置信度和不确定性:前者指的是正确的概率或可能性,而后者与估计的预期误差的大小有关。

置信度可用于拒绝被怀疑是不正确的估计,或将它们从最可靠到最不可靠进行排序。我们认为不确定性更有价值,因为它也可以用于融合多个观测,例如在卡尔曼滤波框架中。

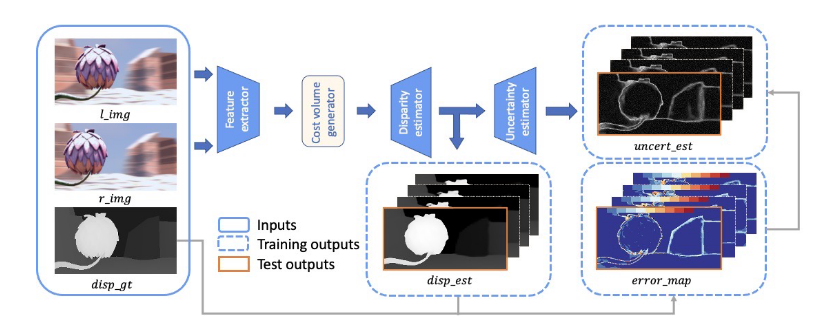

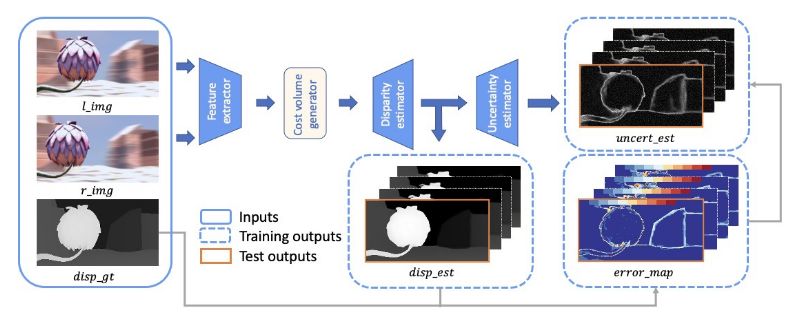

在本文中,我们提出了一种通过深度网络实现这一概念的方法,该网络从一对校正后的图像中联合估计视差及其不确定性。我们将该网络命名为SEDNet,即立体声误差分布网络。SEDNet包括一个新的、轻量级的不确定性估计子网络,它可以预测任意的匹配的不确定性,提出了一种新的损失,以匹配不确定度分布与视差误差的分布。为了产生这一新损失的输入,我们通过软直方图技术(soft-histogramming technique),以可微的方式从视差误差和不确定值的样本中逼近分布

我们提出了广泛的实验验证SEDNet的性能在视差估计和不确定性预测的大数据集与地面真相。SEDNet优于具有相似甚至相同架构的基线,但没有提出的损失函数。我们的主要贡献是:

- 一个新的不确定性估计子网络,从视差子网络生成的中间多分辨率视差图中提取信息;

- 可微分软直方图技术(soft-histogramming technique),用于近似视差误差和估计不确定性的分布;

- 基于KL散度的损失应用于上述技术获得的直方图。

2. Related Work

我们区分了置信度和不确定性:置信度是用BCE损失训练的二元变量,而不确定性是用L1或L2损失训练的连续变量。

在立体匹配中,CNN已被用于估计置信度。置信度CNN(CCNN)[31]、基于块的置信度预测(PBCP)[33]、早期融合网络(EFN)和晚期融合网络(LFN)[4]和多模CNN(MMC)[5]只使用小块的视差图。相反,全局置信度网络(ConfNet)和局部-全局置信度网络(LGC)[35]引入了类似U-Net的体系结构,并将图像和视差图作为输入。作为基线,我们使用局部自适应融合网络(LAF)[18],它基于三模式输入预测置信度图:成本和视差图以及彩色图像。

3. Method

我们工作的目标是共同估计视差及其不确定性。这种联合公式的一个重要好处是,当添加不确定性子网络时,多任务网络学习预测比独立视差估计器更准确的视差。

- 图像尺寸H×W的立体图像对X={XL,XR}

- 地面真实视差d

- 网络fˆ的预测θd可以表示为ˆd=fθ(XL,XR)

- 使用L1损失来计算预测的误差

我们建议最小化预测不确定性分布与实际视差误差之间的散度D。

在接下来的小节中,我们介绍了任意不确定性估计(第3.1节),提出的KL散度损失(第3.2节),我们的网络架构(第3.3节)和组合损失函数(第3.4节)

3.1. Aleatoric Uncertainty Estimation (任意不确定性估计)

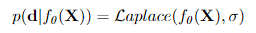

为了预测不确定性并减少误差的影响,Kendall和Gal[14]在假设预测模型服从高斯分布的情况下,最小化预测模型的像素级负对数似然。Ilg等人[13]的后续工作表明,根据L1或L2损失是否用于视差估计,预测分布可以建模为拉普拉斯或高斯。由于我们使用前者,我们可以将预测模型写成:

其中,均值由模型输出给出,σ为观测噪声标量。

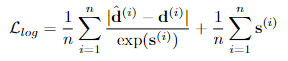

为了模拟任意不确定性,Kendall和Gal[14]引入了像素特定的噪声参数σ(i)。我们遵循Ilg等人[13]的方法,他们对拉普拉斯模型也做了同样的事情,并获得以下像素级损失函数:

其中:d(i)和d(i)是像素i的预测和实际真相视差,s(i)是观测噪声标量σ(i)的对数,n等于像素的总数。式(2)可以看作是一个鲁棒损失函数,其中像素的剩余损失因其不确定性而衰减,而第二项则作为正则子。我们按照作者的建议,训练网络预测观测噪声标量s的对数,以保证数值稳定性

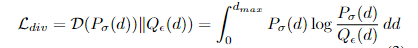

3.2 Matching the Distribution of Errors

Kullback-Leibler (KL)散度[22]是测量c分布与σ分布差异的自然选择。由于KL散度是不对称的,我们选择的分布c作为参考。因此,我们的网络还应该最小化以下目标函数:

其中d表示视差范围。由于网络回归视差,KL散度的连续表述是合适的。

直接最小化式(3)需要两个分布的封闭形式表达式,这对我们来说是不可用的。它们可以被建模为拉普拉斯分布,但最大似然估计量是不可微的。此外,在分布的尾部,模型与数据的拟合可能不精确。因此,我们选择直方图形式的非参数表示。

直方图也不是一个可微的操作,导致我们用软直方图作为可微的替代方案。

3.3. SEDNet

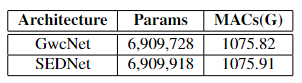

我们的网络架构,命名为SEDNet,包括一个视差估计子网络,一个不确定性估计子网络,如图2所示。在所有实验中,我们采用GwcNet[11]作为视差估计子网,在其他部分中,我们设计了一种与接入GwcNe框架的新型不确定性估计子网。值得注意的是,不确定性子网络非常小。

GwcNet子网络使用类似resnet的特征提取器从图像中提取特征,生成成本量,并使用softargmax操作符[16]将差异分配给像素。视差预测器的输出模块生成K个不同分辨率的视差图。

提出了一种新的结合立体匹配网络的不确定性估计器。不确定性估计子网络学习预测每个像素处观测噪声标量的对数,即误差。提出的子网络以多分辨率视差预测为输入,计算成对差分向量(PDV),并将其传递给像素级MLP来回归不确定性图。具体地说,视差估计器输出K个不同分辨率的视差图d = {d1,…, dK},首先上采样到全分辨率,然后进行两两差分,形成PVD,其中包括(K2)元素。不确定性映射的输出集还包含K个分辨率来匹配视差映射。我们在所有实验中都使用K = 4。

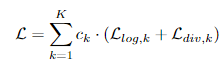

3.4. Loss Function

损失函数结合了两部分:

(1)对数似然损失来优化误差和不确定性,

(2)KL散度损失来匹配不确定性与误差的分布。

全损考虑所有视差和不确定性映射上采样到最高分辨率:

其中ck为第k个分辨率级别的系数,Llog,k和Ldiv,k由Eq.(2)和Eq.(6)对相应分辨率级别的预测计算。

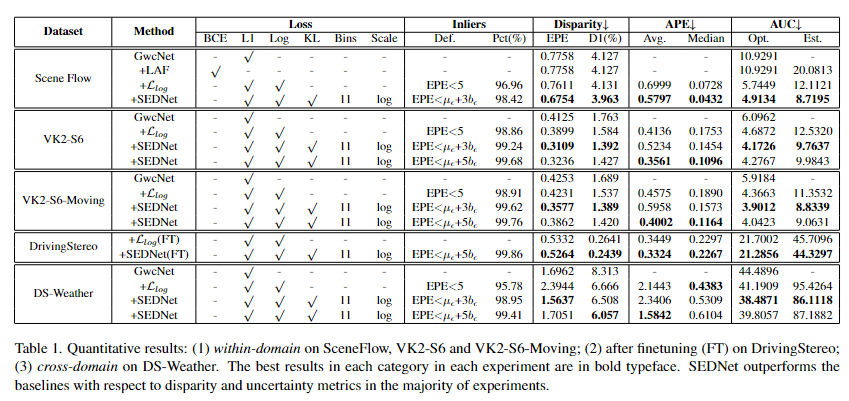

4. Experiments

两个NVIDIA RTX A6000 gpu,每个gpu都有48 GB的RAM。

对SceneFlow数据集实验

在具有24gb内存的Nvidia TITAN RTX GPU上。我们在256 × 128块半分辨率图像上从头开始训练所有模型,以限制内存消耗。我们将初始学习率设置为0.001,并在第10 epoch之后每2个epoch将其缩小2。

6. Conclusion

提出了一种基于立体图像对的关节视差和不确定度估计的新方法。关键思想是基于差差分布和不确定性估计之间的KL散度的唯一损失函数。这是通过我们在这里也介绍的可微分直方图方案实现的。为了实现我们的方法,我们扩展了GwcNet架构,包括一个只有190个参数的不确定性估计子网络。我们在多个大型数据集上的实验表明,我们的方法,命名为SEDNet,在差异和不确定性预测方面都是有效的。我们的方法的成功归因于新的损失函数。SEDNet在视差估计方面轻松超过GwcNet,尽管它们在本质上具有相同的容量和几乎相同的架构,直到微小的不确定性估计子网络。我们乐观地认为,我们的方法将在其他像素级回归任务中取得类似的成功,我们计划在未来的研究中解决这些问题。

------------

参考: 1.

浙公网安备 33010602011771号

浙公网安备 33010602011771号