《机器学习》第一次作业——第一至三章学习记录和心得

第一章基本概念

1.1什么是模式识别

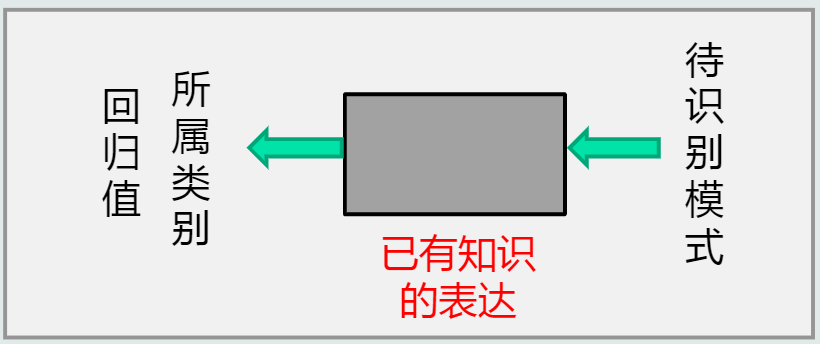

根据任务,模式识别可以划分为“分类”和“回归”两种形式。

模式识别:根据已有知识的表达,针对待识别模式,判别决策其所属类别或者预测其对应的回归值。(本质上是一种推理过程)

1.2模式识别数学表达

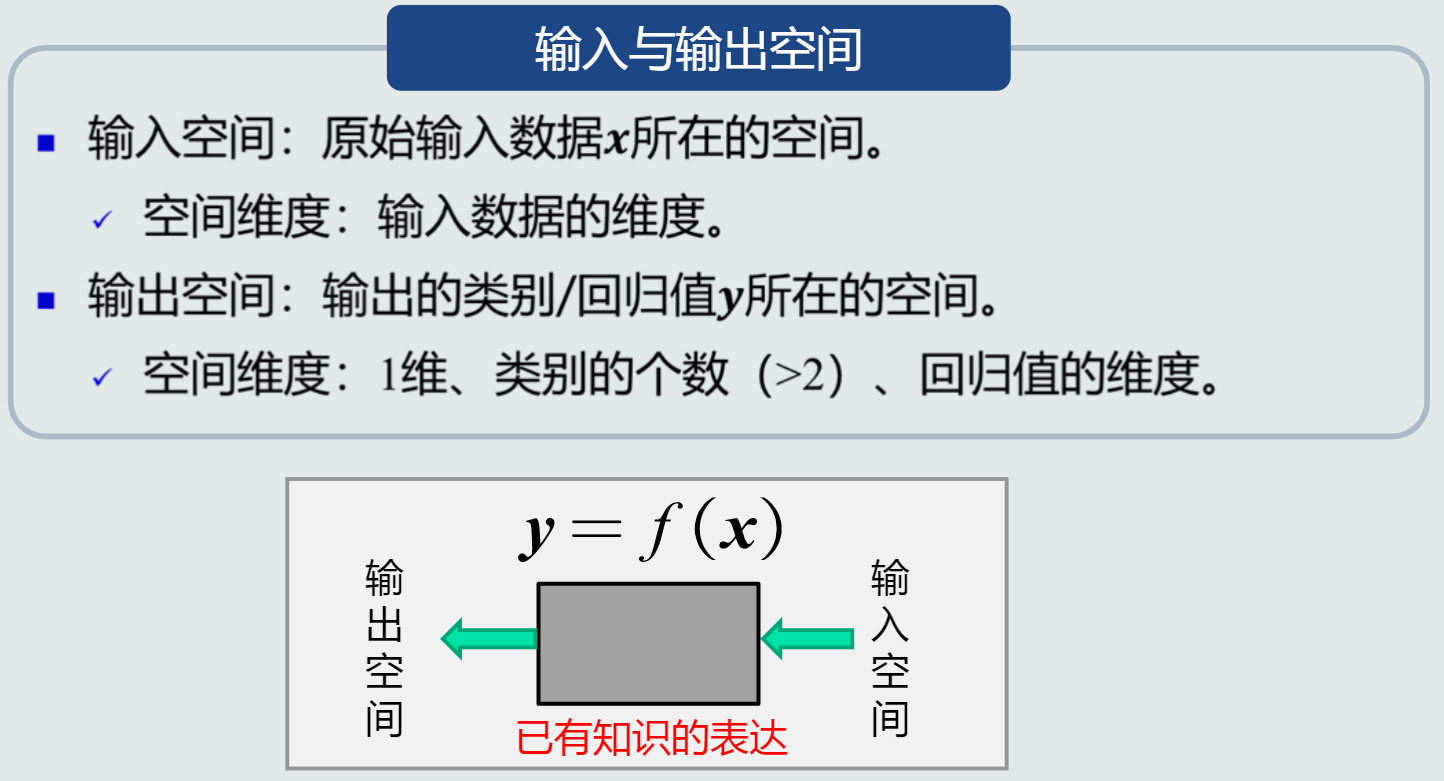

1.数学解释:看成一种函数映射f(x),将待识别模式x从输入空间映射到输出空间,f(x)是关于已有知识的表达。

- 输入与输出空间

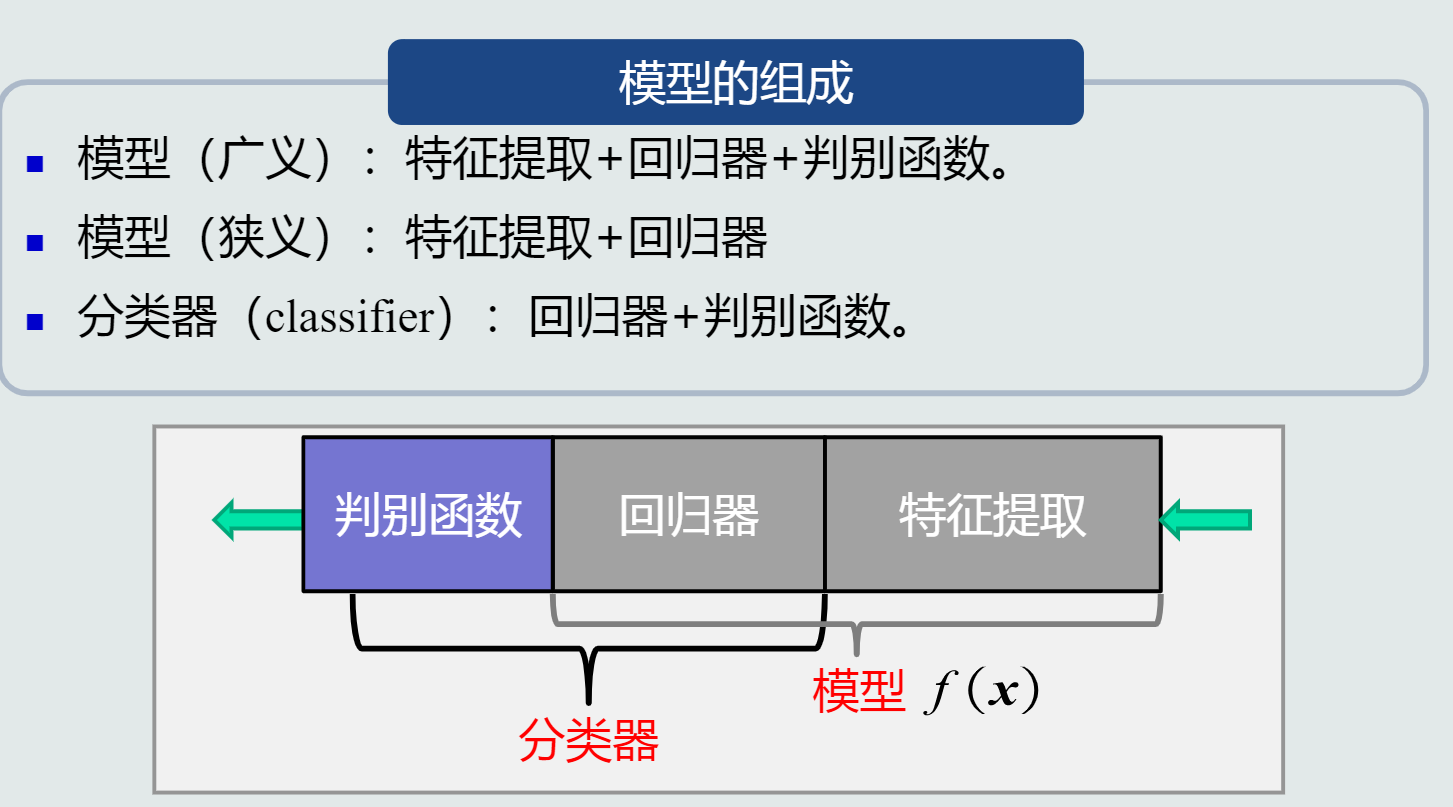

2.模型:关于已有知识的一种表达方式,即函数f(x)。用于回归与分类。 - 回归

- 分类

判别函数:使用一些特定的非线性函数实现,记作函数g。 - 判别器:

- 二类分类:sign函数(判断回归值>0还是<0);

- 多类分类:max函数用来进行多类分类(取最大的回归值所在维度对应的类别)。

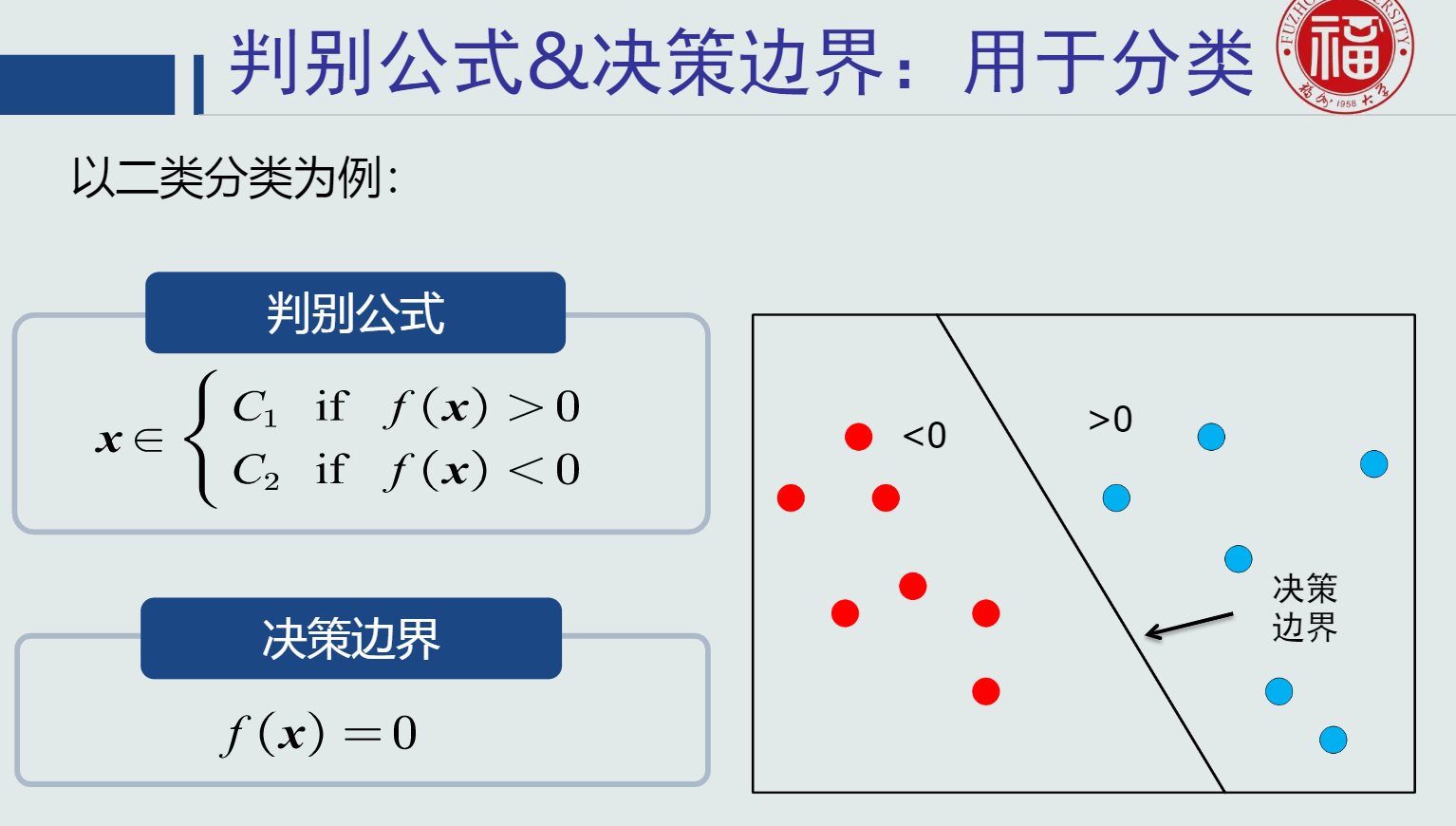

- 判别公式&决策边界:用于分类

3.特征&特征空间 - 特征:可以用于区分不同类别模式的、可测量的量。(输入数据也可以看作原始特征表达)

- 特征的特性:

- 特征具有辨别能力,提升不同类别之间的识别性能。(基于统计学规律,而非个例)

- 鲁棒性:针对不同的观测条件,仍能够有效表达类别之间的差异性。

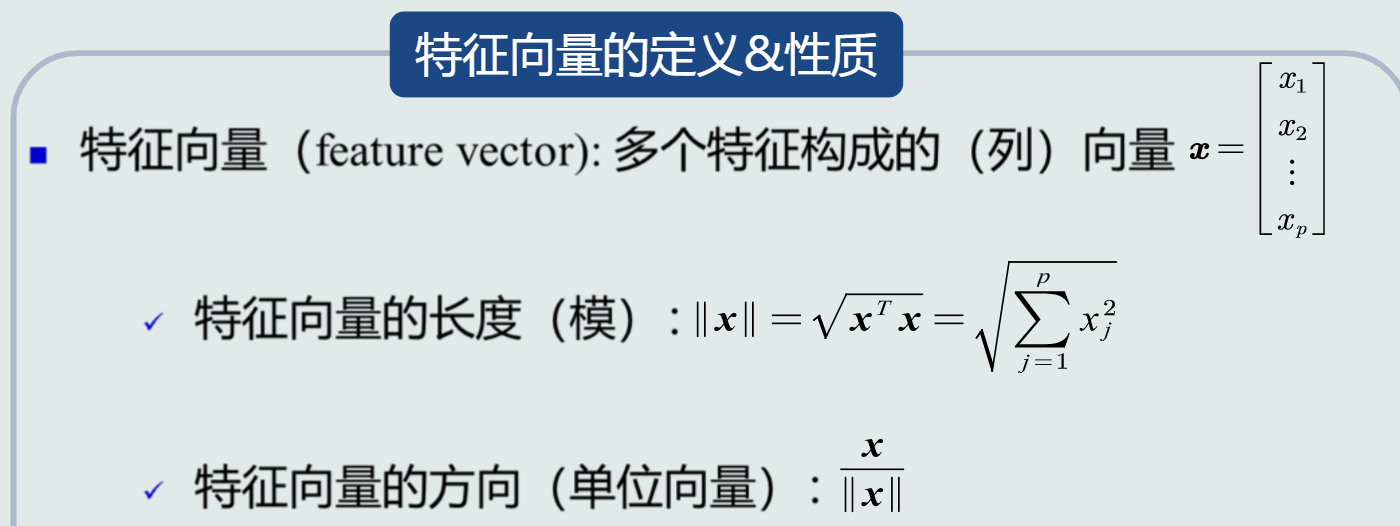

- 特征向量

- 特征空间

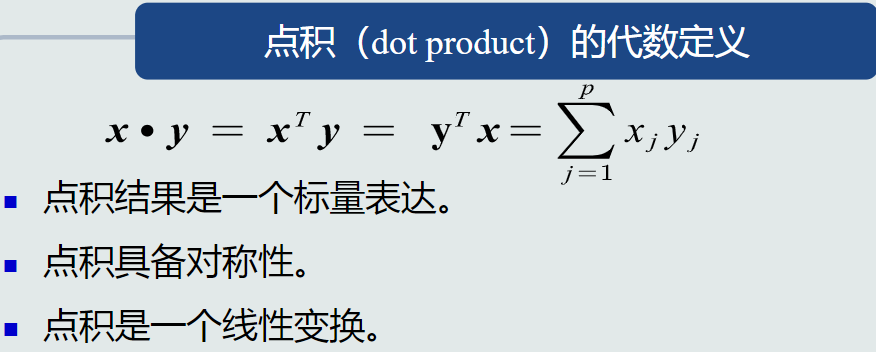

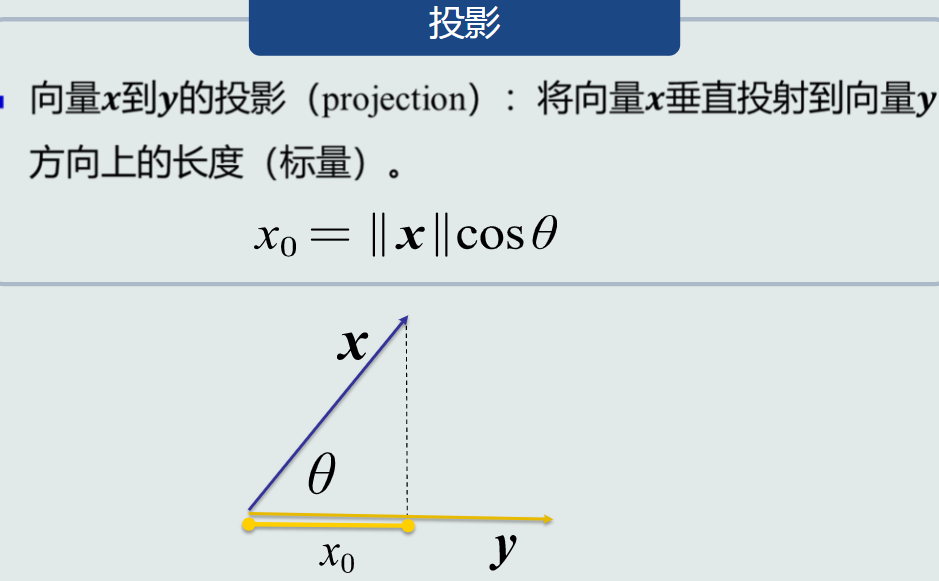

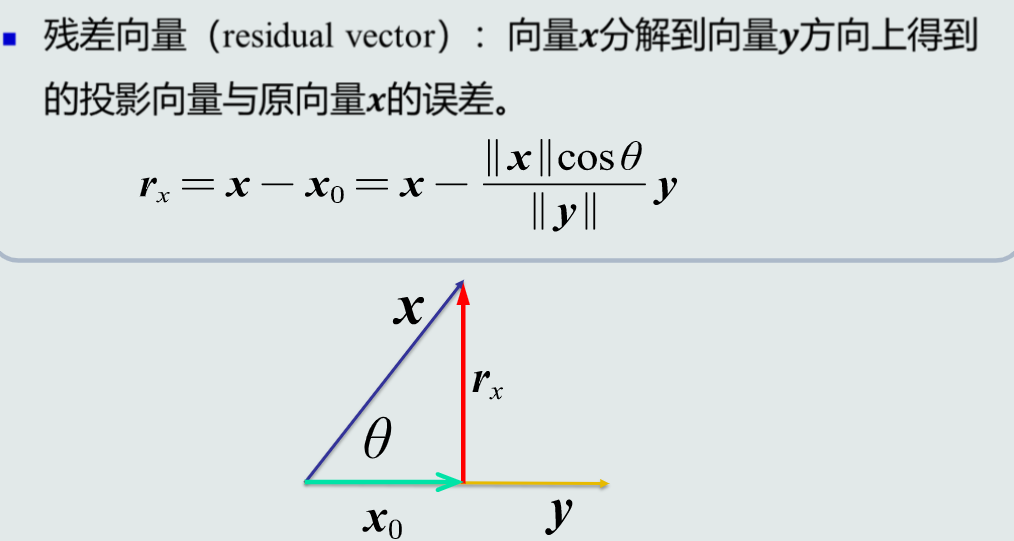

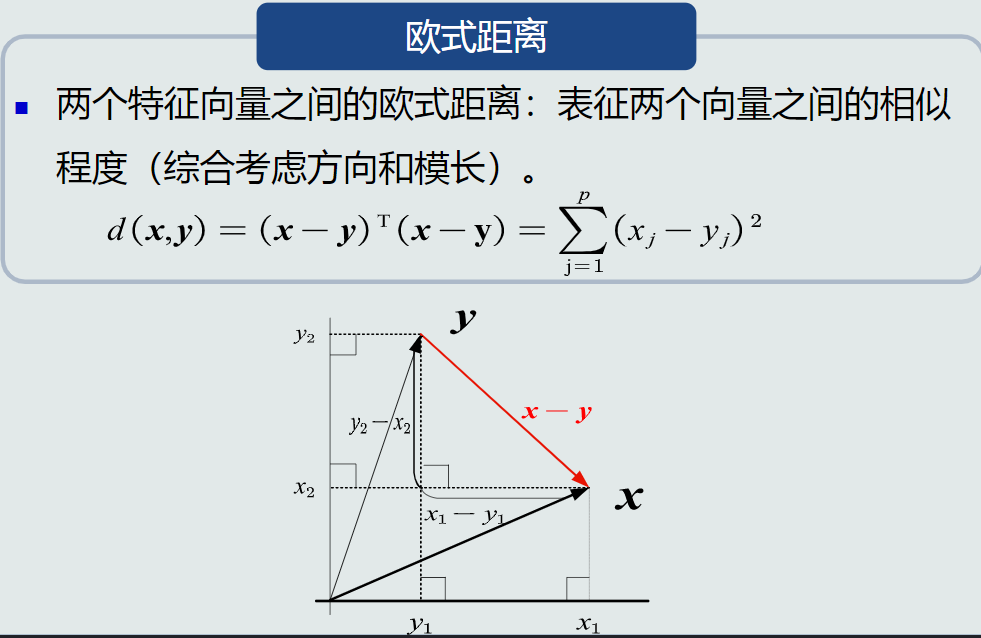

1.3特征向量的相关性

- 特征向量点积

- 特征向量投影

- 残差向量

- 特征向量的欧式距离

1.4机器学习基本概念

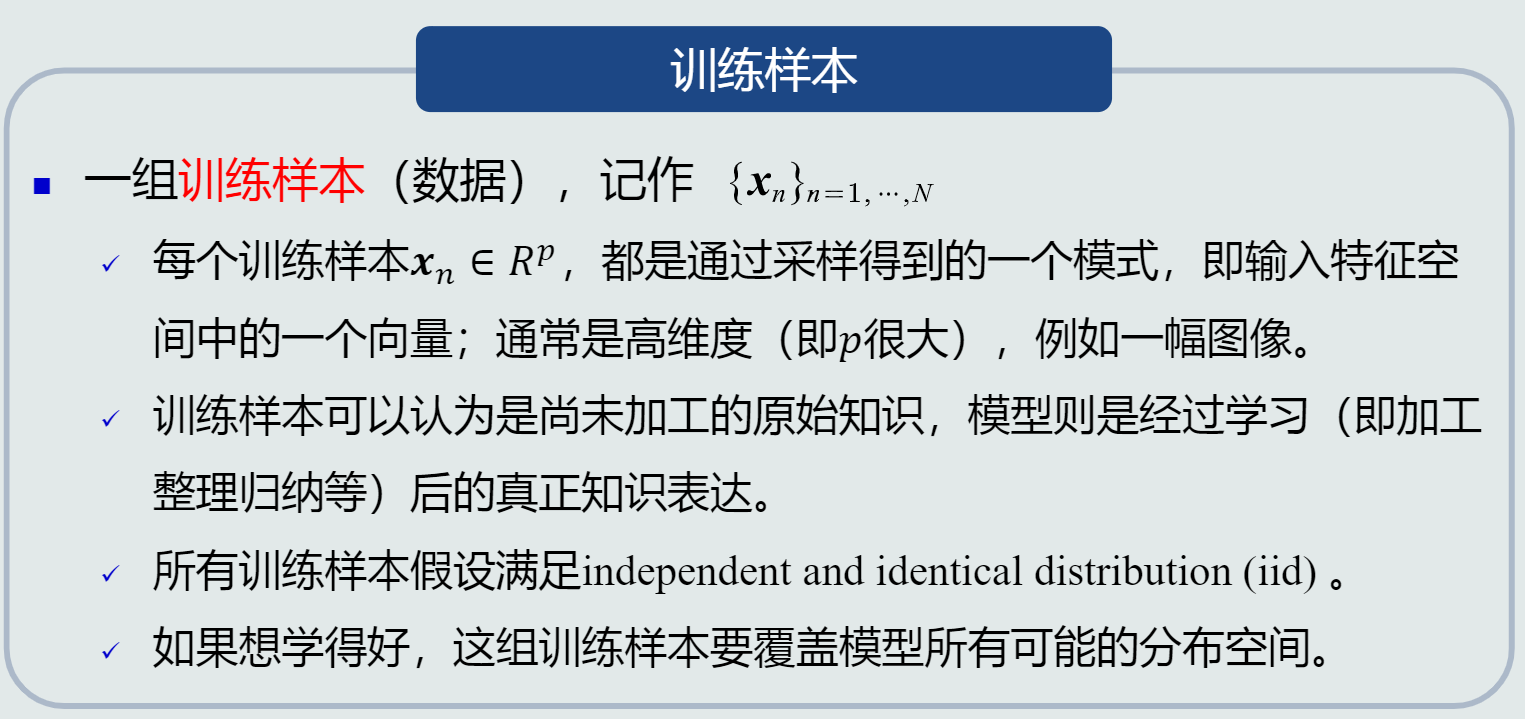

1.模型使用机器学习技术来得到,如何进行机器学习?

- 使用训练样本

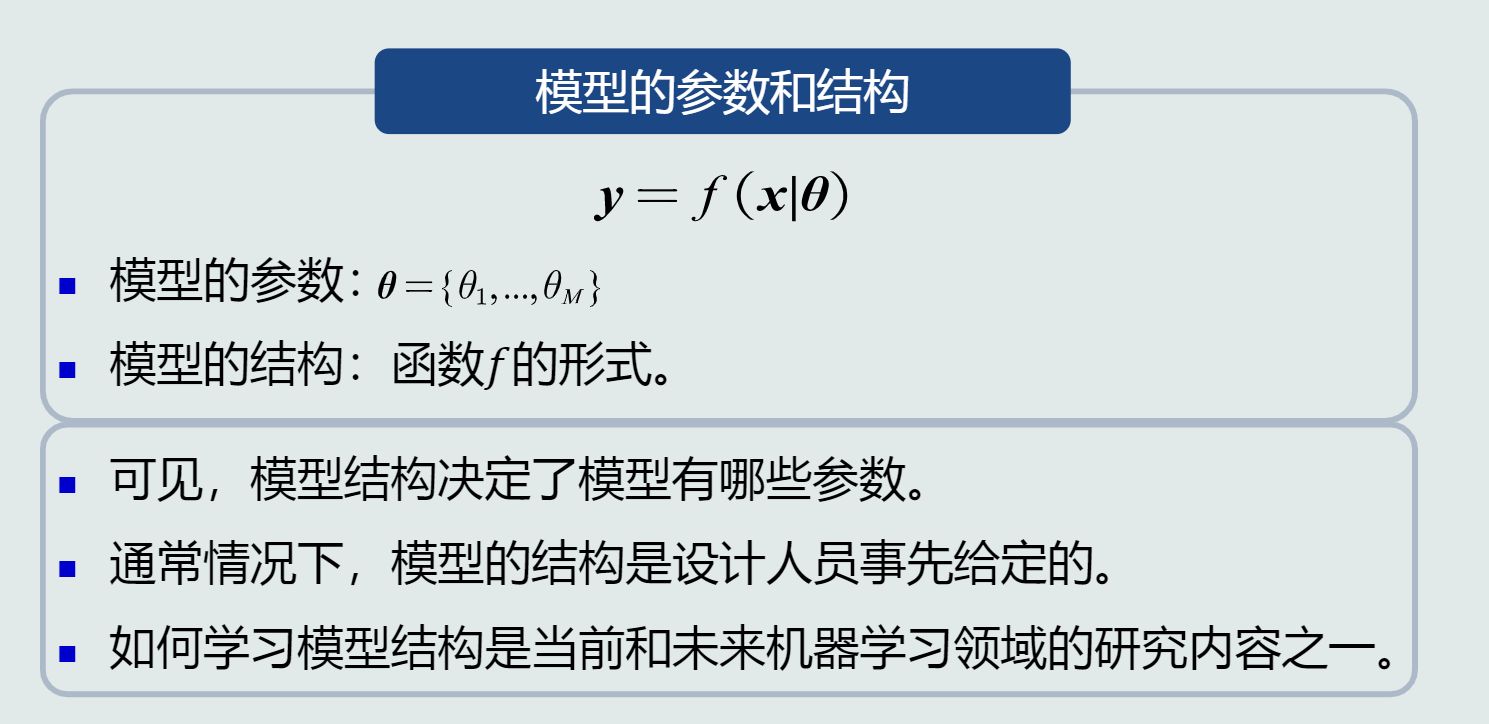

- 学习模型的参数和结构

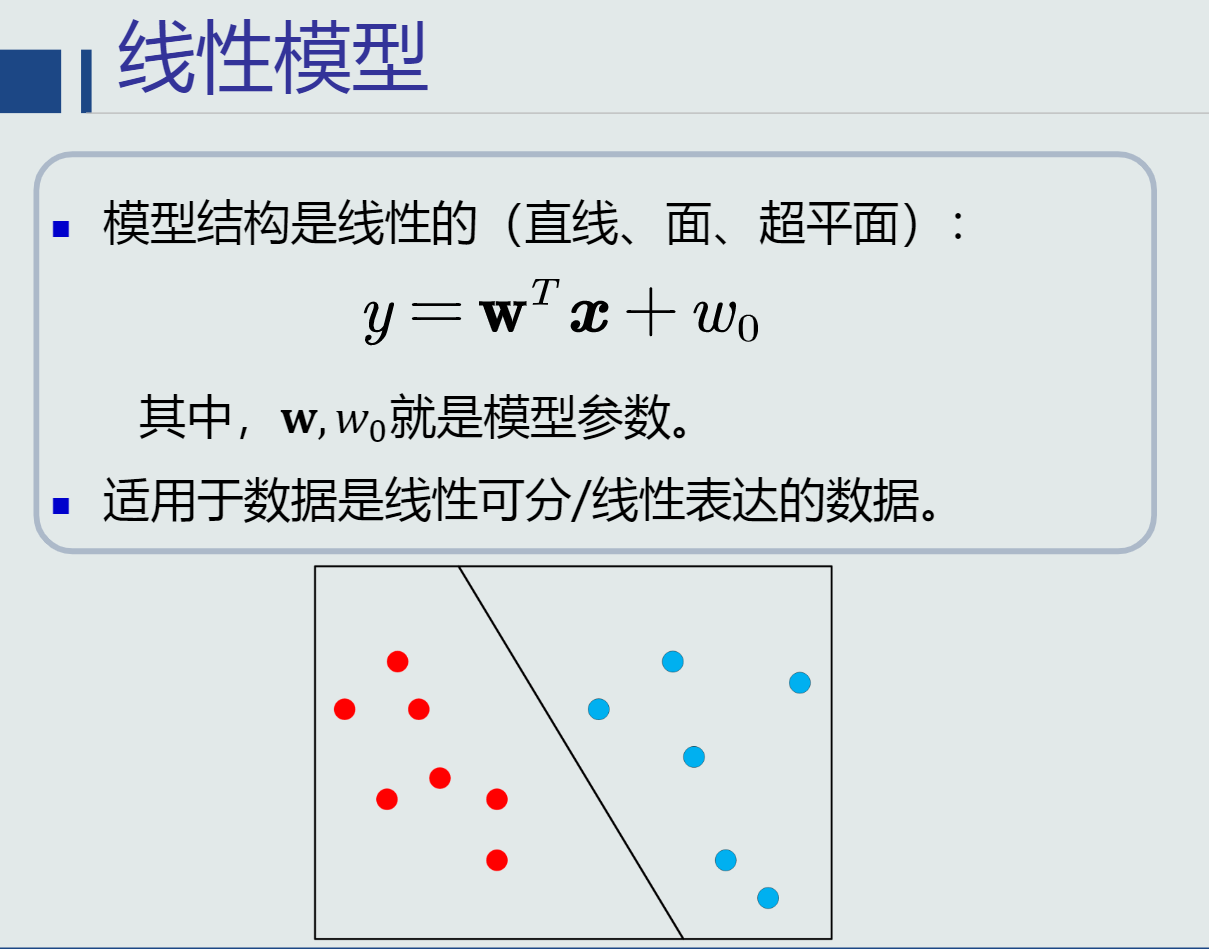

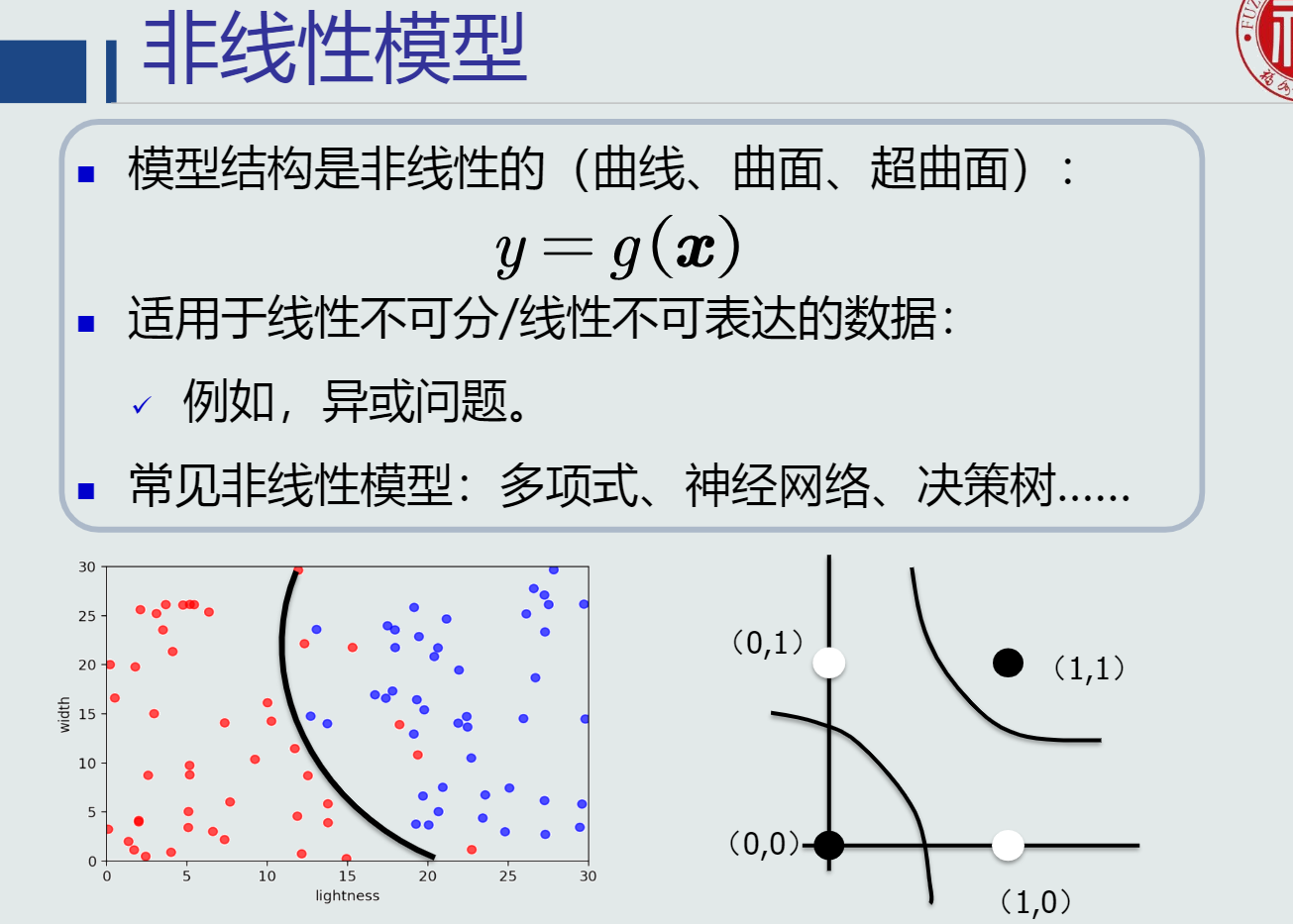

- 模型有线性模型和非线性模型

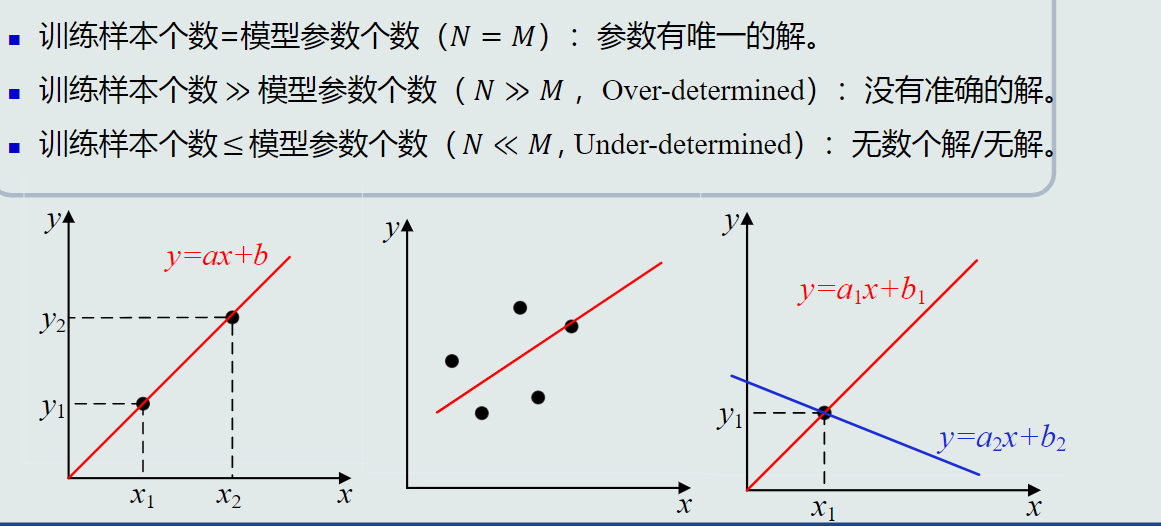

- 样本量vs模型参数量

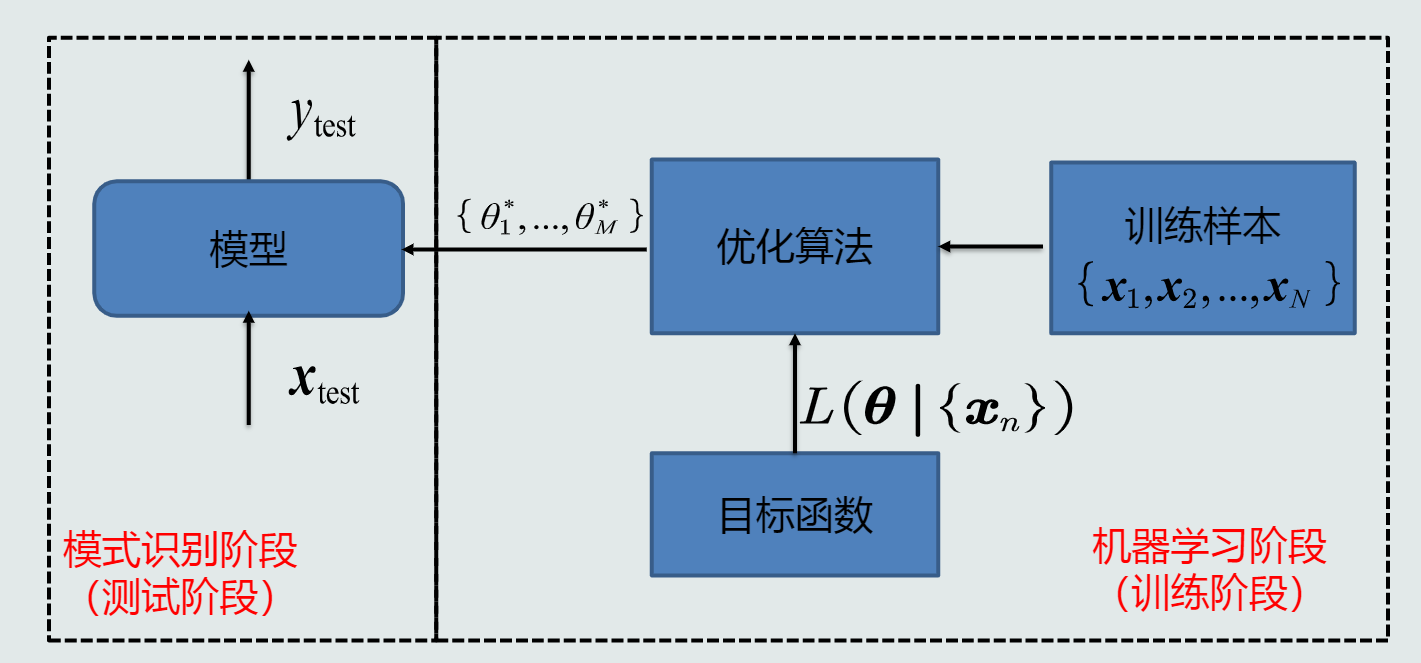

- 利用训练样本,定义目标函数,使用优化算法最终得到模型参数的最优解。

2.机器学习的方式:监督式学习、无监督式学习、半监督式学习、强化学习。

1.5模式识别的泛化能力:学习算法对新模式的决策能力

- 训练集:集合中的每个样本称作训练样本。

- 测试集:集合中的测试样本。

- 训练集训练模型,测试集评估模型。

- 训练误差:模型在训练集上的误差。

- 测试(泛化)误差:模型在测试集上的误差。它反映了模型的泛化能力。

- 泛化能力:训练得到的模型不仅要对训练样本具有决策能力,也要对新的(训练过程中未看见)的模式具有决策能力。

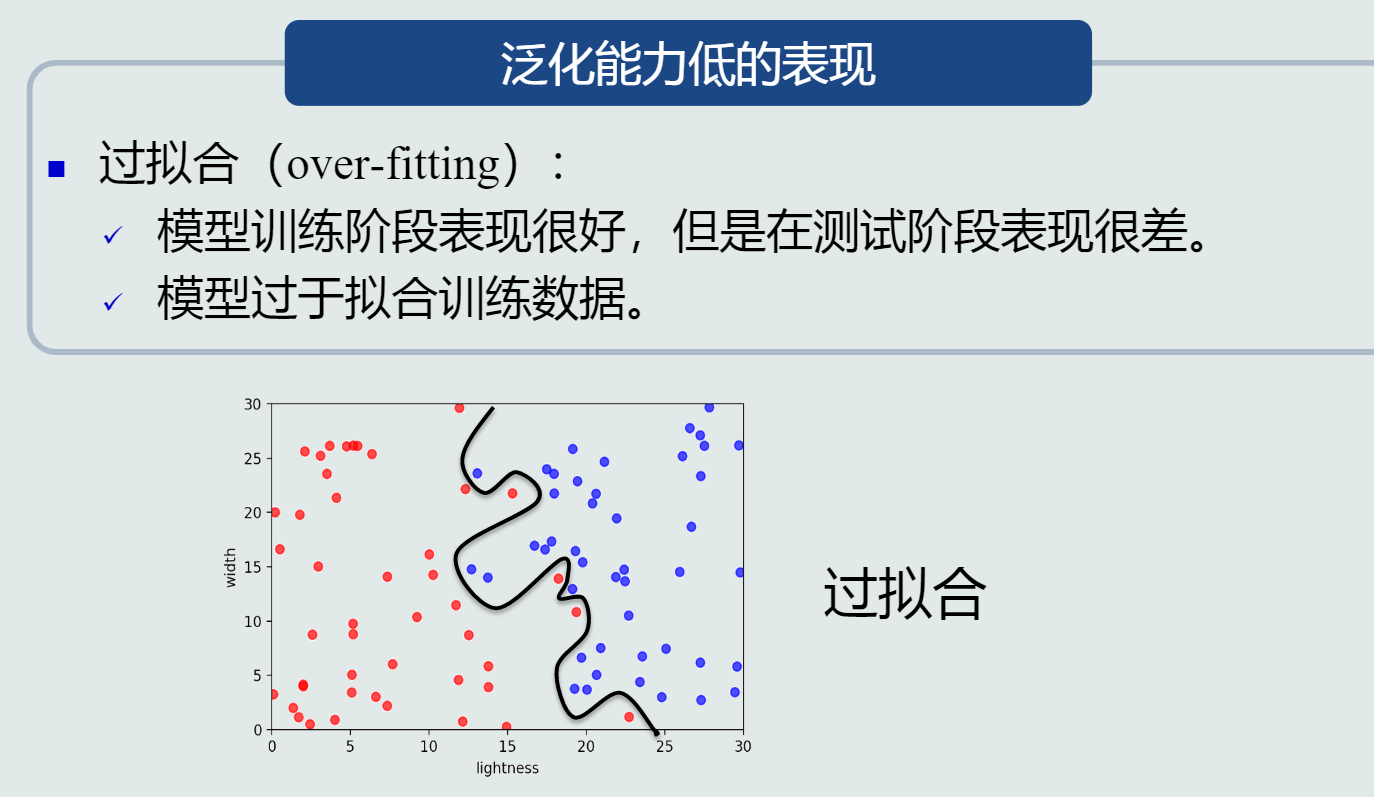

- 泛化能力低:过拟合。

- 提高方法:(1)选择复杂度适合的模型(2)正则化(在目标函数中加入正则项实现)

1.6评估方法与性能指标

1.评估方法:留出法、K折交叉法、留一验证法

性能指标:准确度、精度、召唤率、F-Score、F1-Score、PR曲线、ROC曲线、AUC曲线

第二章基本概念

2.1MED分类器--最小欧式距离分类器 (类的原型是均值,衡量的距离为欧式距离)

1.基于距离分类

- 基于距离的决策:把测试样本到每个类之间的距离作为决策模型,将测试样本判定为与其最近的类。

- 判别公式

- 类的原型:

- 将均值作为类的原型

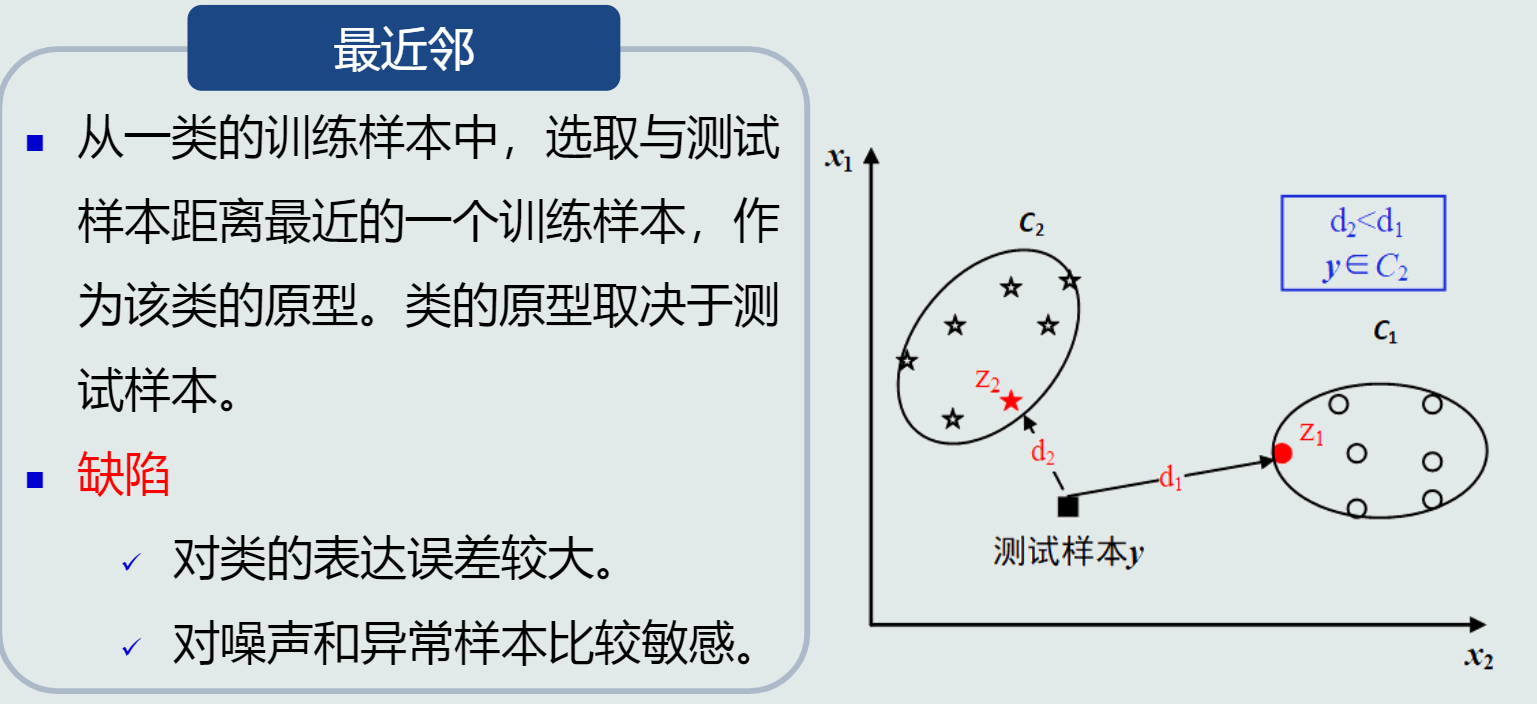

- 选取最近邻作为类的原型

- 将均值作为类的原型

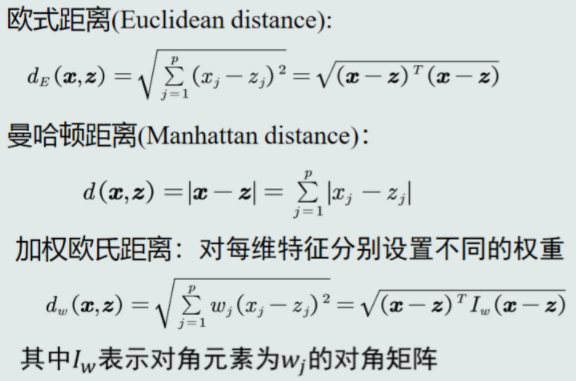

- 距离的种类:欧式距离,曼哈顿距离,加权欧式距离。

2.最小欧氏距离(MED)分类器

存在的问题:没有考虑特征变化的不同及特征之间的相关性(即若协方差方阵对角线元素不相等则每维特征的变化不同,若非对角线元素不为0则特征之间存在相关性)

2.2特征白化

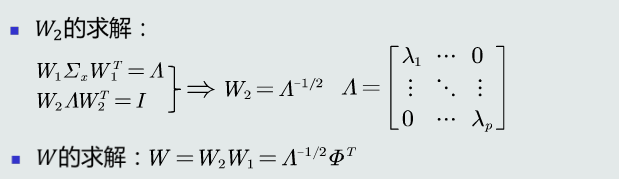

1.特征白化的目的: 将原始特征映射到一个新的特征空间,使得在新空间中特征的协方差矩阵为单位矩阵,从而去除特征变化的不同及特征之间的相关性。

2.步骤:

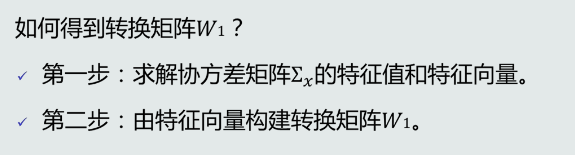

- 解耦:通过W1实现协方差矩阵对角化,去除特征之间的相关性。

- 白化:通过W2对上一步变换后的特征再进行尺度变换,实现所有特征具有相同方差。

W1起到旋转的作用

W转换后的欧式距离发生改变,变成马氏距离。

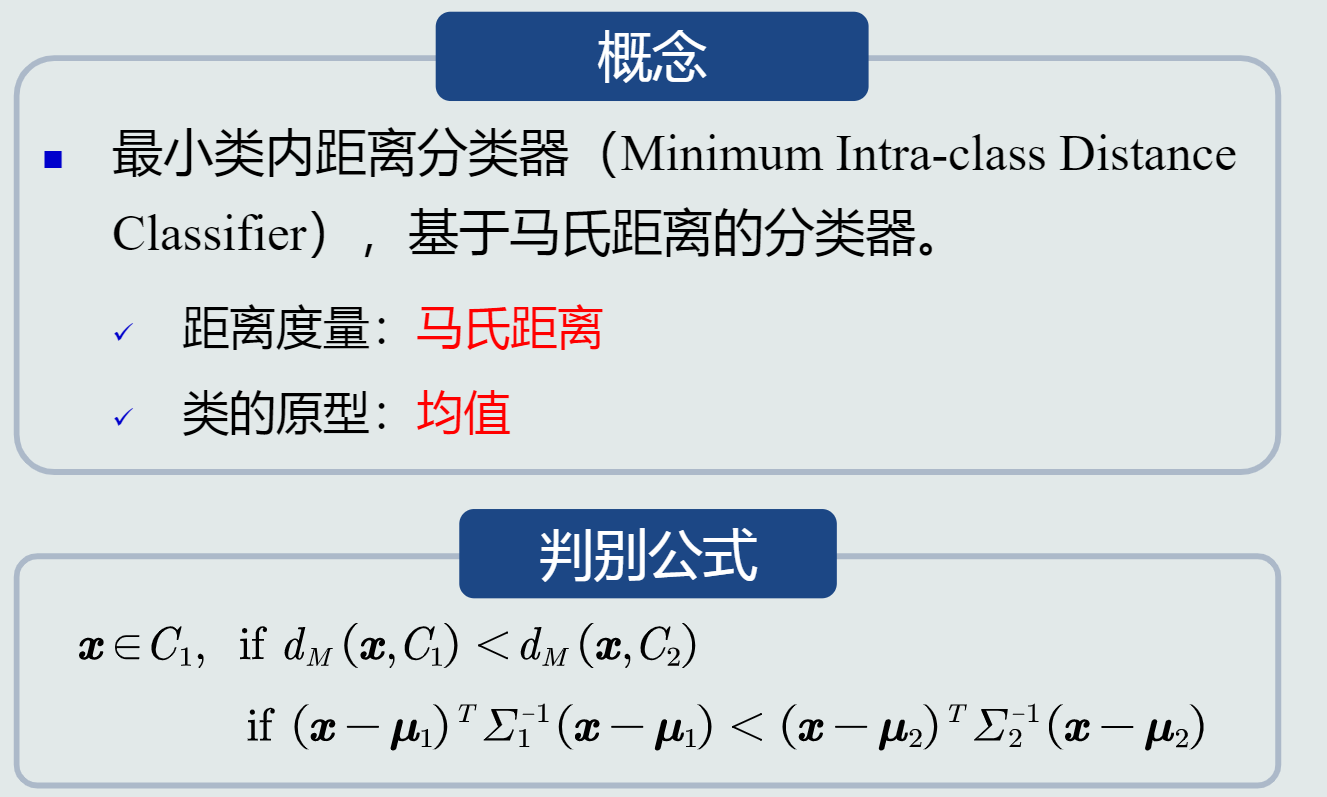

2.3MICD分类器——最小类内部距离分类器 (类的原型是均值,衡量的距离为马氏距离)

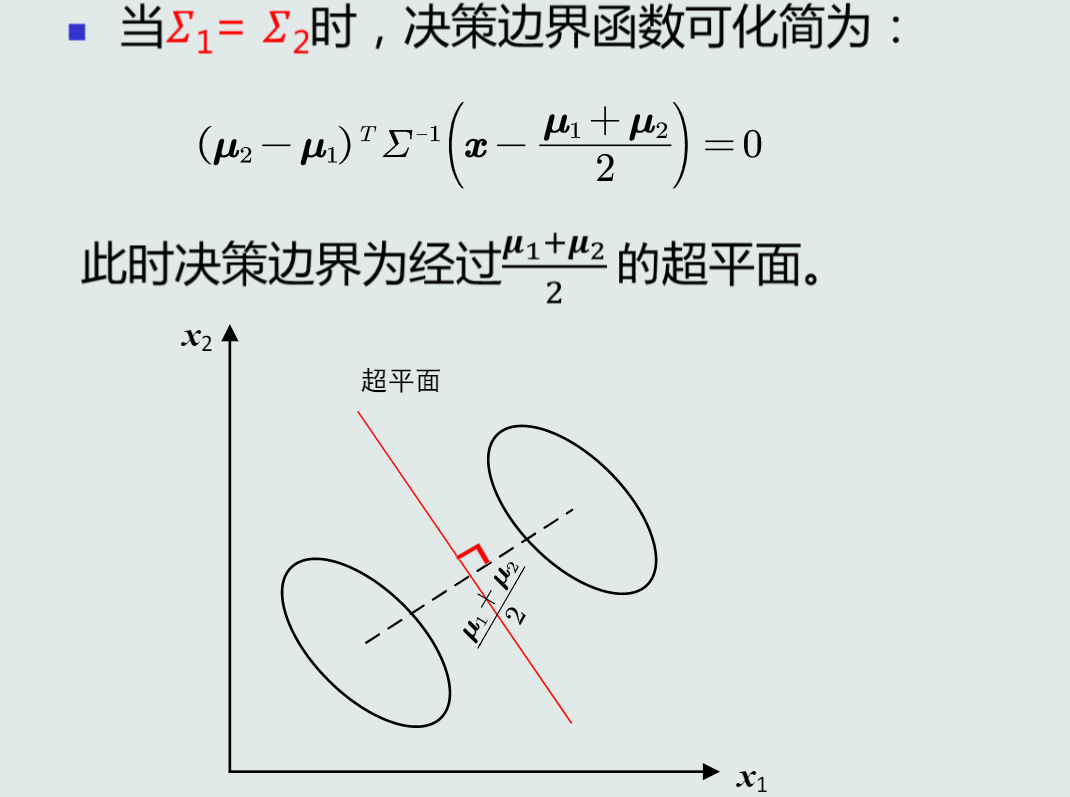

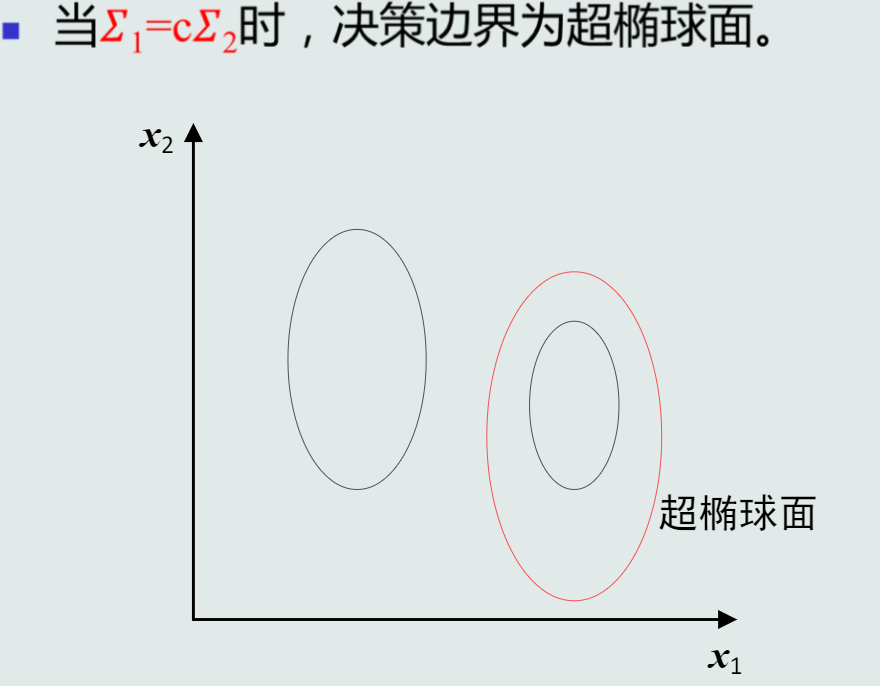

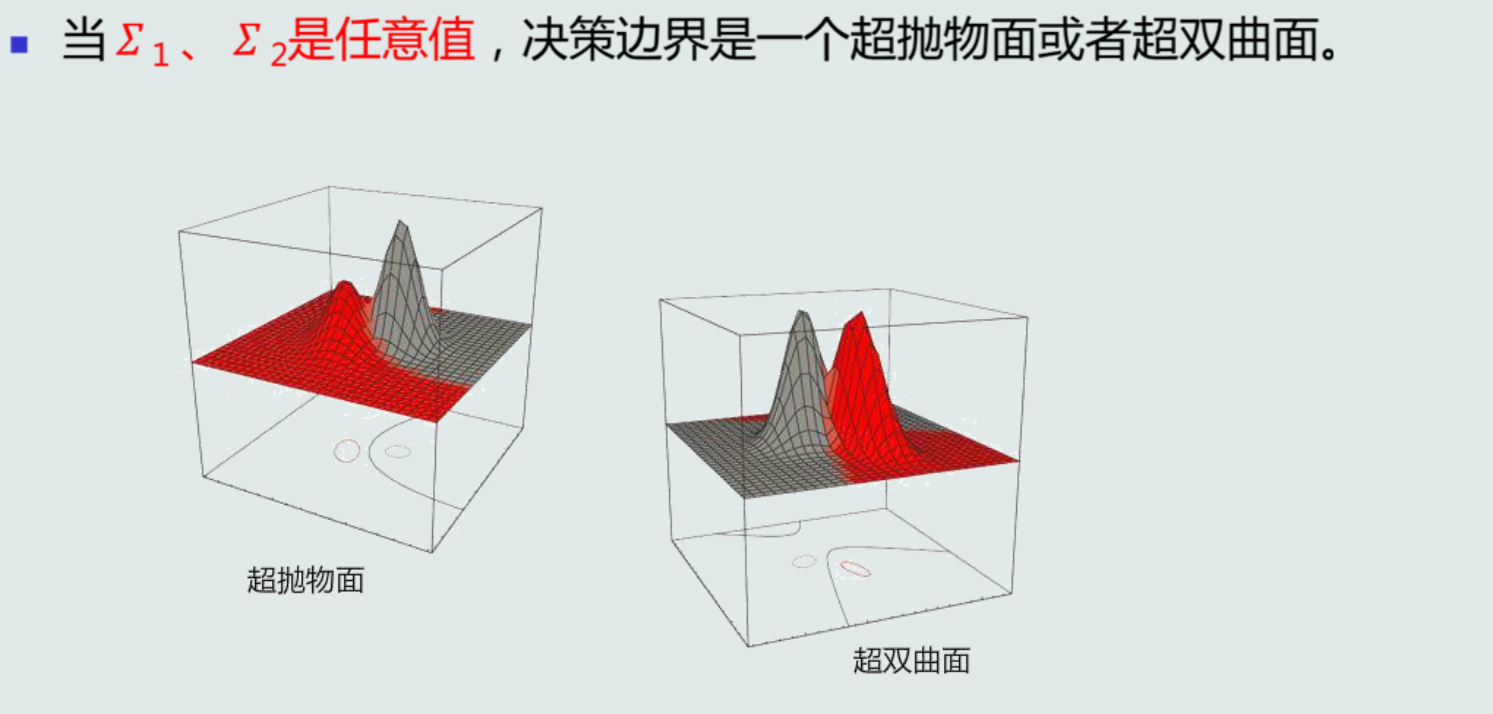

- MICD的决策边界

2.4.补充

- 马氏距离使非奇异线性变换不变的

- 马氏距离具有平移不变性、旋转不变性、尺度缩放不变性、不受量纲影响的特性

- 欧式距离具有平移不变性、旋转不变性

- 基于距离的决策仅考虑了每个类各自观测到的训练样本的分布情况,没有考虑类的分布等先验知

第三章基本概念

3.1贝叶斯决策与MAP分类器

- 后验概率P(Ci|x):(输入模式x、类别输出C):用于分类决策,表达给定模式x属于类Ci的可能性。

1.怎么得到后验概率? - 贝叶斯规则

- 基于贝叶斯规则、在已知先验概率和观测概率的情况下

- 基于贝叶斯规则、在已知先验概率和观测概率的情况下

- MAP分类器

- 最大后验概率分类器:将测试样本决策分类给后验概率最大的那个类。

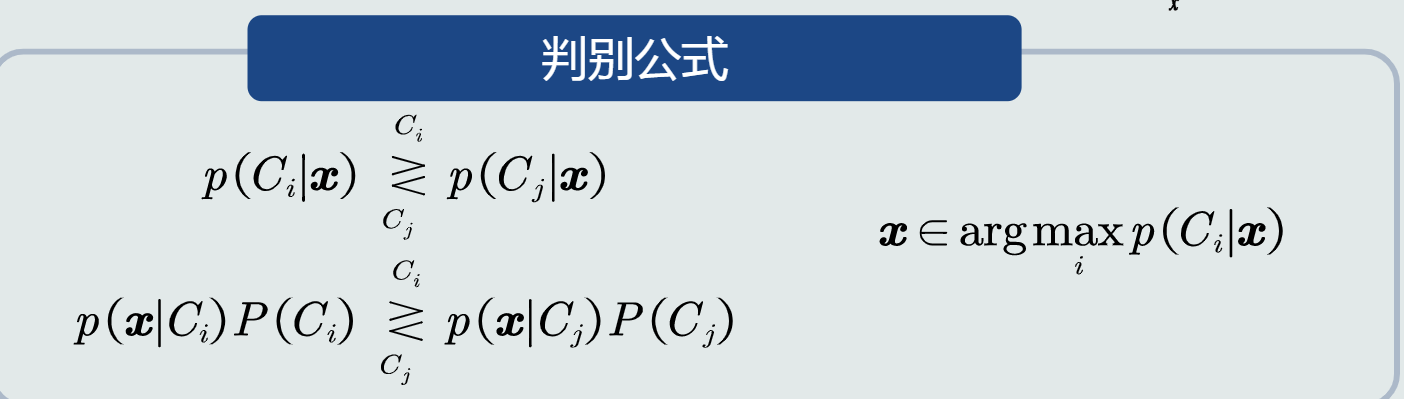

- 判别公式:

- 决策边界

- 对于二类分类:p(x|C1)p(C1)−p(x|C2)p(C2)=0

- 单维空间:通常有两条决策边界;

- 高维空间:复杂的非线性边界

- 决策误差(概率误差=未选择的类对应所对应的后验概率)

MAP分类器决策目标即为最小化概率误差,即分类误差最小化

(给定所有测试样本,MAP分类器选择后验概率最大的类,等于最小化平均概率误差,即最小化决策误差)

3.2 MAP分类器:高斯观测概率

1.表达先验和观测概率的方式

1)常数表达:例如P(Ci)=0.2

2)参数化解析表达:高斯分布...

3)非参数化表达:直方图、核密度、蒙特卡洛...

- 观测概率:单维高斯分布

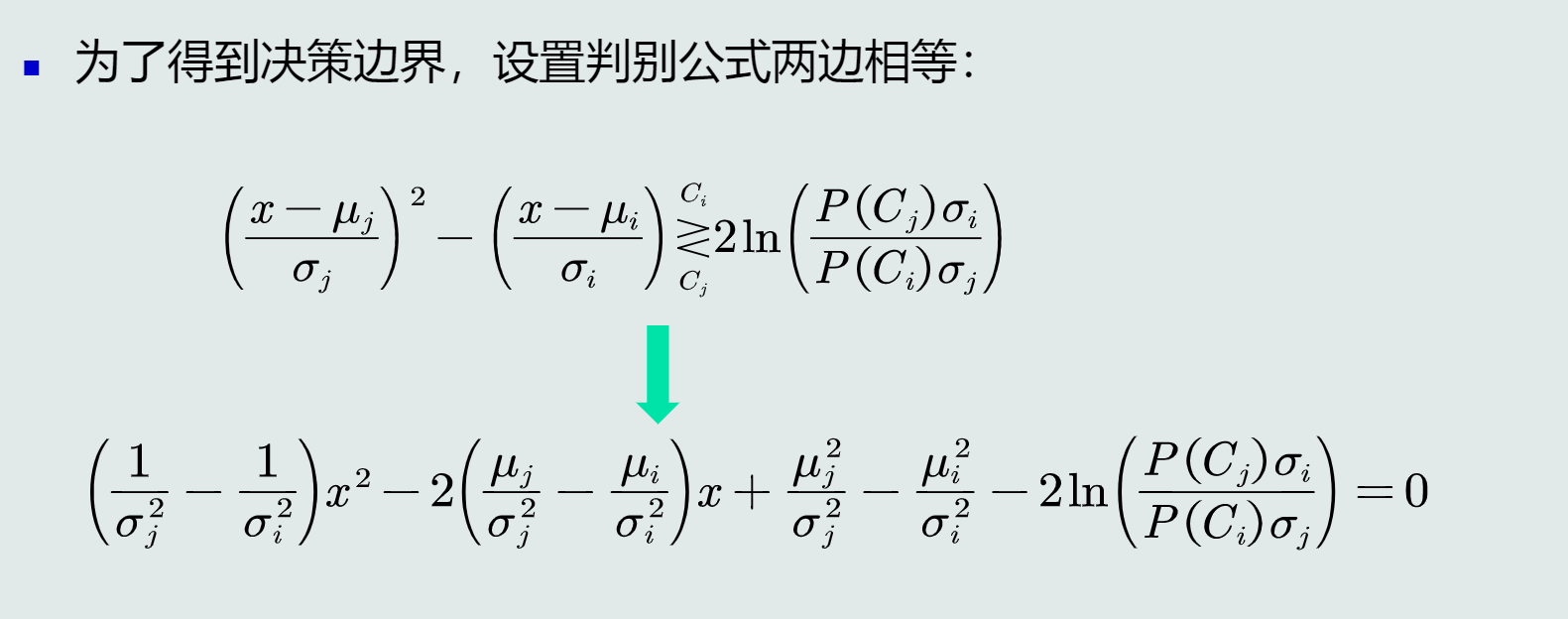

- 决策边界

-

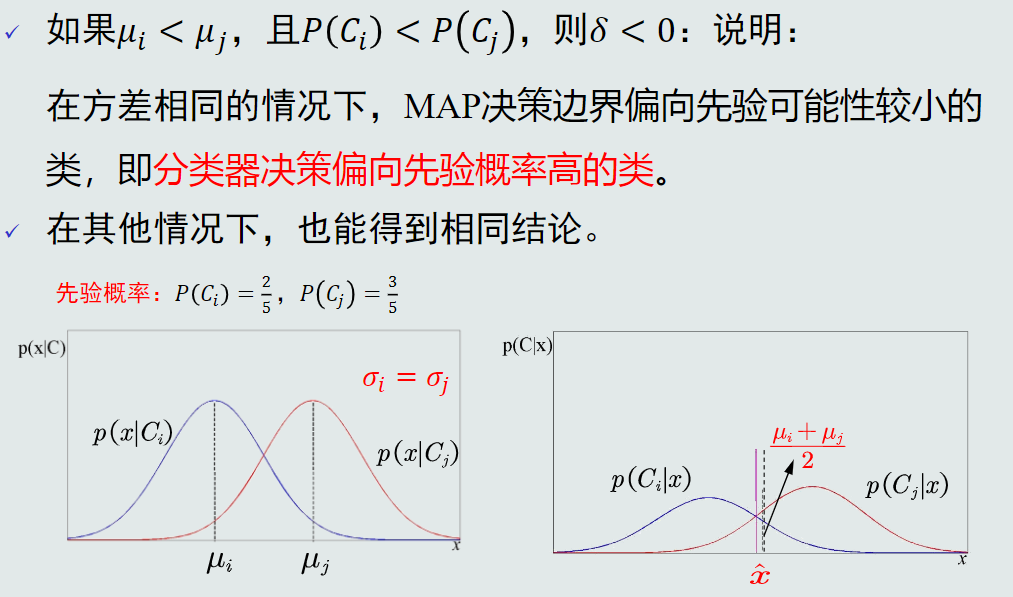

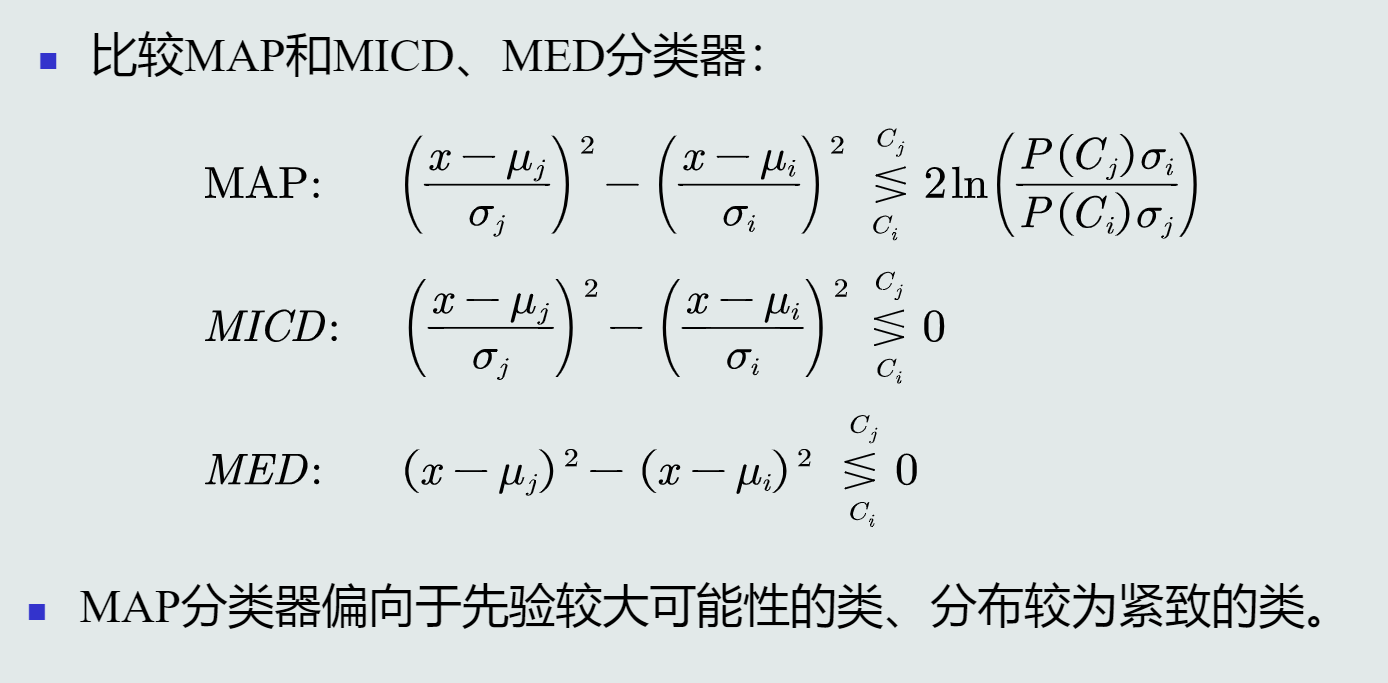

当𝜎𝑖 = 𝜎𝑗 = σ 时,决策边界是线性的,只有一条;

-

如果𝜇𝑖 < 𝜇𝑗,且𝑃(𝐶𝑖) < 𝑃(𝐶𝑗) ,则𝛿 < 0;

-

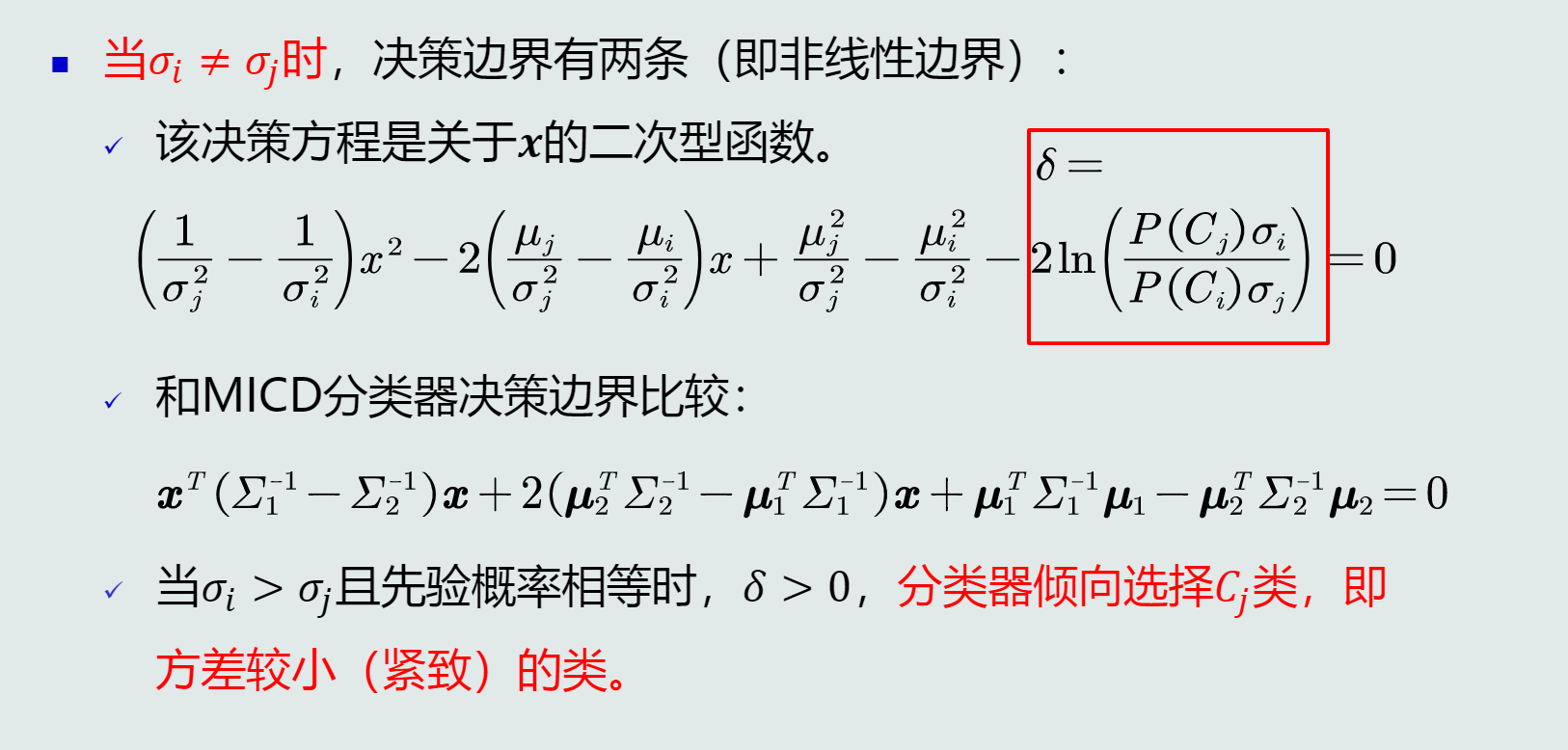

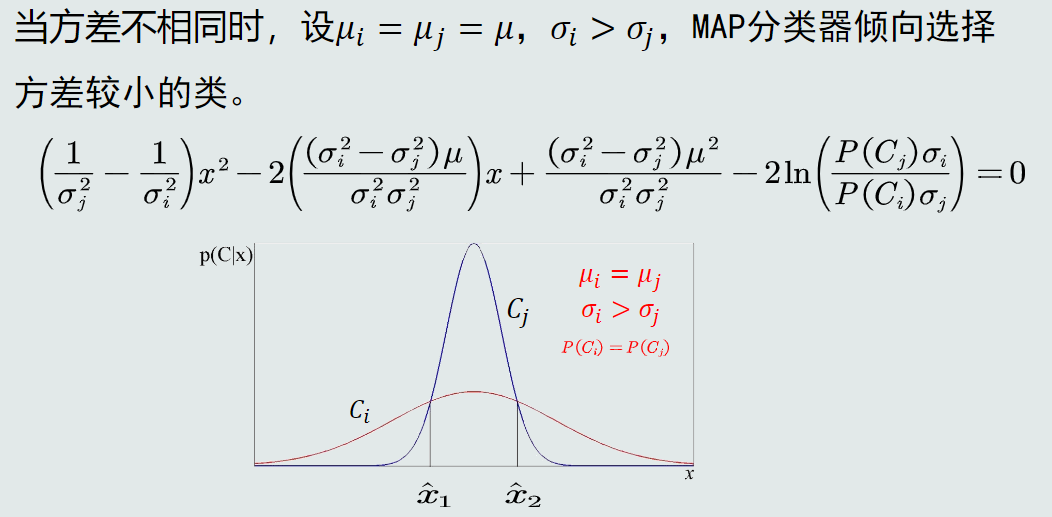

当𝜎𝑖 ≠ 𝜎𝑗时,决策边界有两条(非线性边界),该决策方程是关于𝒙的二次型函数

-

MAP分类器可以解决MICD分类器存在的问题

-

分类器比较

-

3.3 决策风险与贝叶斯分类器

贝叶斯决策不能排除出现错误判断的情况,由此会带来决策风险;不同的错误决策会产生程度完全不一样的风险。

1.损失(loss):表征当前决策动作相对于其他候选类别的风险程度。

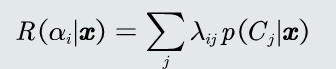

2.决策风险的评估:给定一个测试样本x,分类器决策其属于Ci类的动作αi对应的决策风险可以定义为相对于所有候选类别的期望损失。记为R(αi|x)。(决策动作αi|Cj、测试样本的真值Cj) )

3.贝叶斯分类器:在MAP分类器基础上,加入决策风险因素,得到贝叶斯分类器。贝叶斯分类器选择决策风险最小的类,即最小化期望损失。

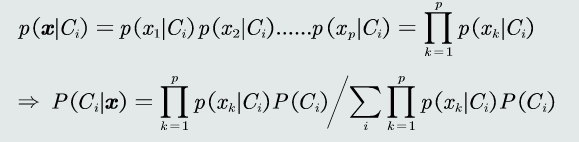

4.朴素贝叶斯分类器:当特征是多维的,假设特征之间是相互独立的,从而得到以下公式:

(特征维度太高,通过即假设特征之间符合独立同分布以达到简化计算的目的)

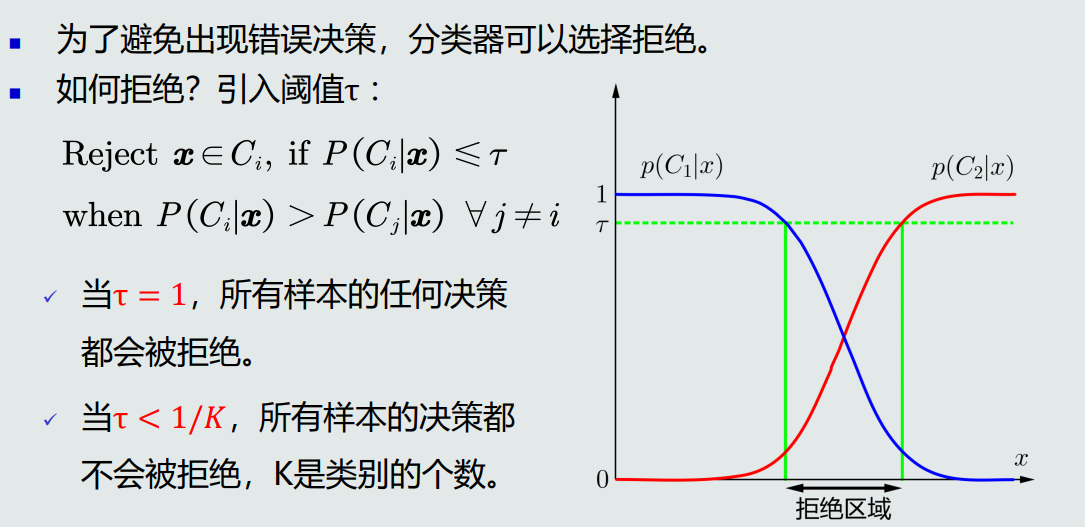

5.拒绝选项:当测试数据在决策边界时,即使选择后验概率高的,该概率的值仍然可能很小。为了避免错误决策,引入阈值,当概率低于阈值时不决策。

3.4最大似然估计

1.根据概率分布的表达形式,监督式学习方法有以下两种:

- 参数化方法:给定概率分布的解析表达,学习这些解析表达函数中的参数。该类方法也称为参数估计

- 非参数化方法:概率密度函数形式未知,基于概率密度估计技术,估计非参数化的概率密度表达。

2.参数估计方法

- 最大似然估计

- 贝叶斯估计

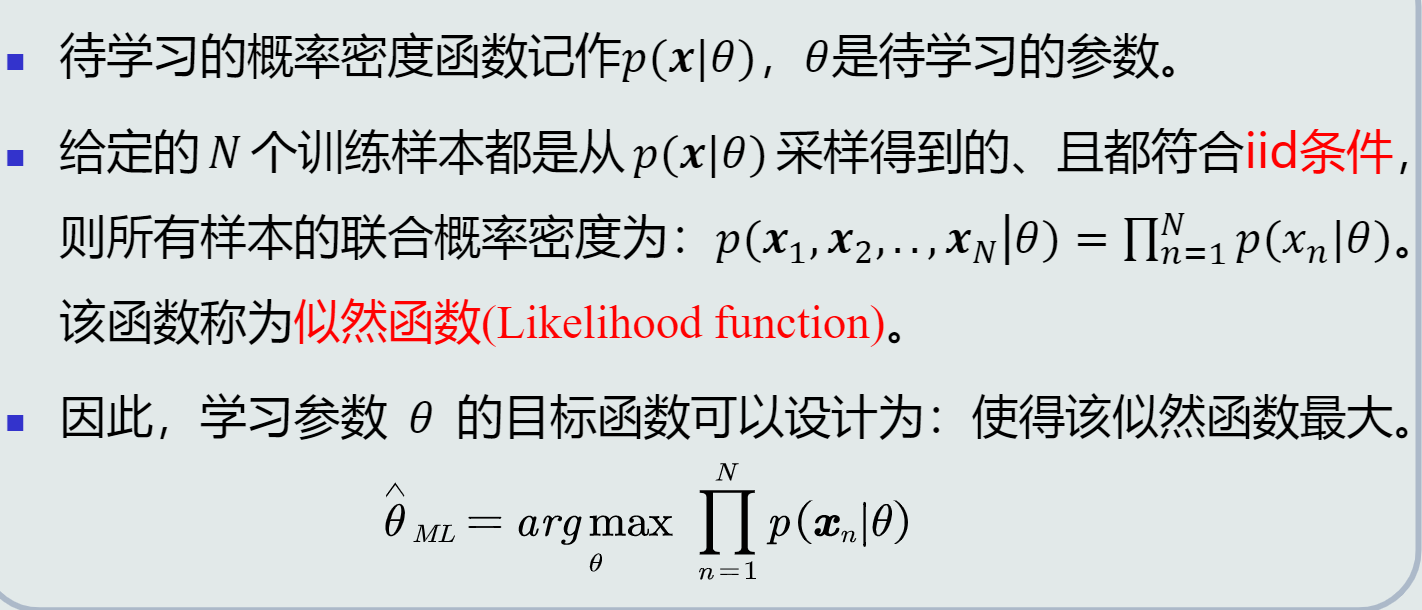

3.最大似然估计

- 定义

- 先验概率估计: 给定所有类的𝑁个训练样本,假设随机抽取其中一个样本属于𝐶1类的概率为𝑃,则选取到𝑁1个属于𝐶1类样本的概率为先验概率的似然函数(即目标函数)

- 求解的步骤:

- 根据要求的概率分布写出似然函数;

- 对似然函数取对数;

- 对参数求偏导;

- 解似然方程(取函数导数为0的点)。

结论:

(1)先验概率的最大似然估计就是该类训练样本出现的频率。

(2)高斯分布均值的最大似然估计等于样本的均值(无偏估计);高斯分布协方差的最大似然估计等于所有训练模式的协方差(有偏估计)。

(3)估计偏差是一个较小的数。当N足够大时,最大似然估计可以看做是一个较好的估计。

3.5最大似然估计的估计偏差

1.无偏估计

- 定义:如果一个参数的估计量的数学期望是该参数的真值,则该估计量称作无偏估计

- 含义:只要训练样本个数足够多,该估计值就是参数的真实值

- 判断是否为无偏估计

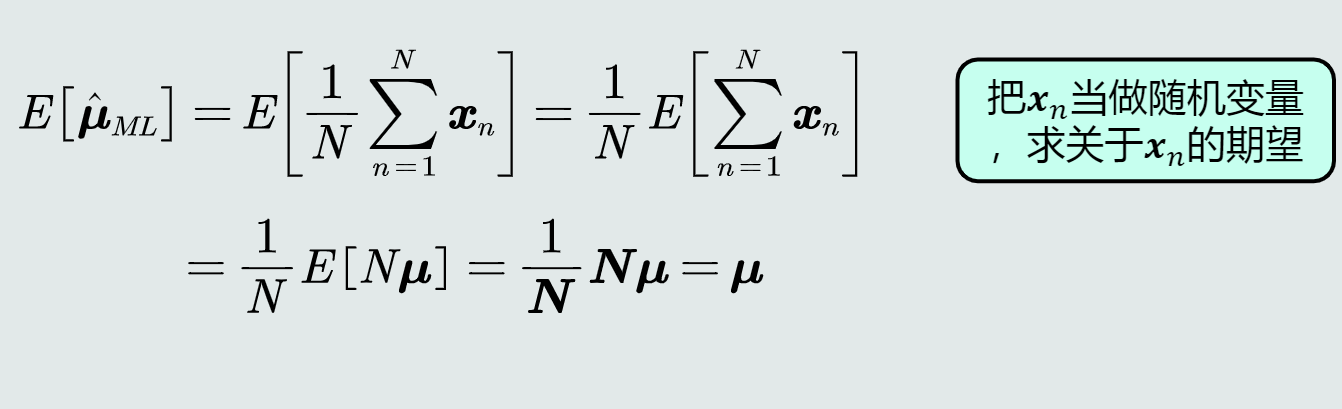

- 高斯分布均值的最大似然估计

- 均值的最大似然估计是无偏估计

2.高斯分布均值的最大似然估计是无偏的,协方差的最大似然估计不是无偏的。实际计算中通过将训练样本的协方差乘以N/(N-1)来修正协方差的估计值。

- 高斯分布均值的最大似然估计

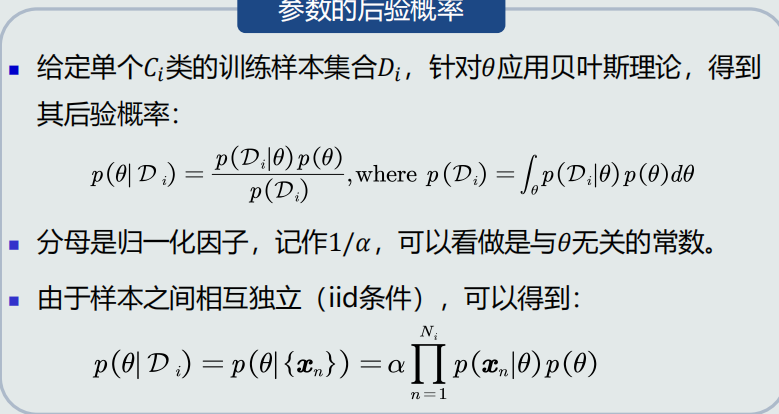

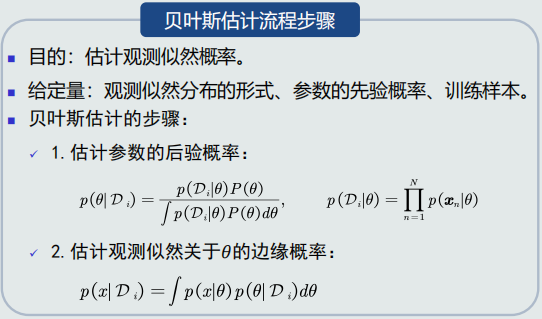

3.6&3.7贝叶斯估计

1.贝叶斯估计:给定参数分布的先验概率以及训练样本,估计参数分布的后验概率。

2.贝叶斯估计具有不断学习的能力,随着训练样本的不断增加,可以串行的不断修正参数的估计值,从而达到该参数的期望真值。

3.贝叶斯估计的目的:估计观测似然概率,给定量为观测似然分布的形式、参数的先验概率、训练样本。

4.

1)贝叶斯估计与最大似然估计的对比:贝叶斯估计把参数看作参数空间的一个概率分布,依照训练样本来估计参数的后验概率,从而得到观测似然关于参数的边缘概率,随着样本个数逐渐增大,贝叶斯估计越来越能代表真实的观测似然分布。最大似然估计的参数是确定值,不需要估算参数的边缘概率。

2)贝叶斯估计等是假设概率分布为高斯分布,但如果分布未知,就需要使用无参数估计技术来实现概率密度估计。

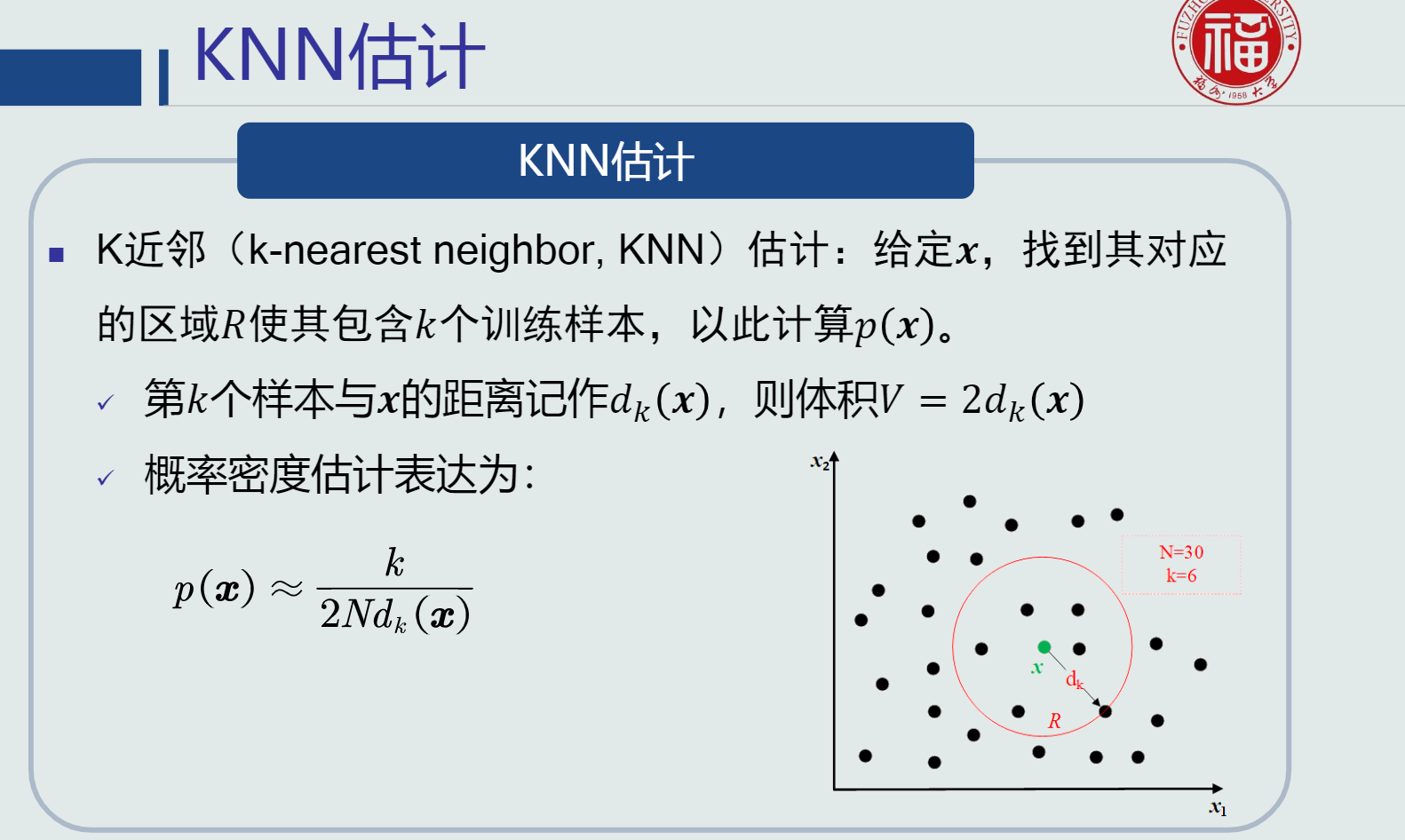

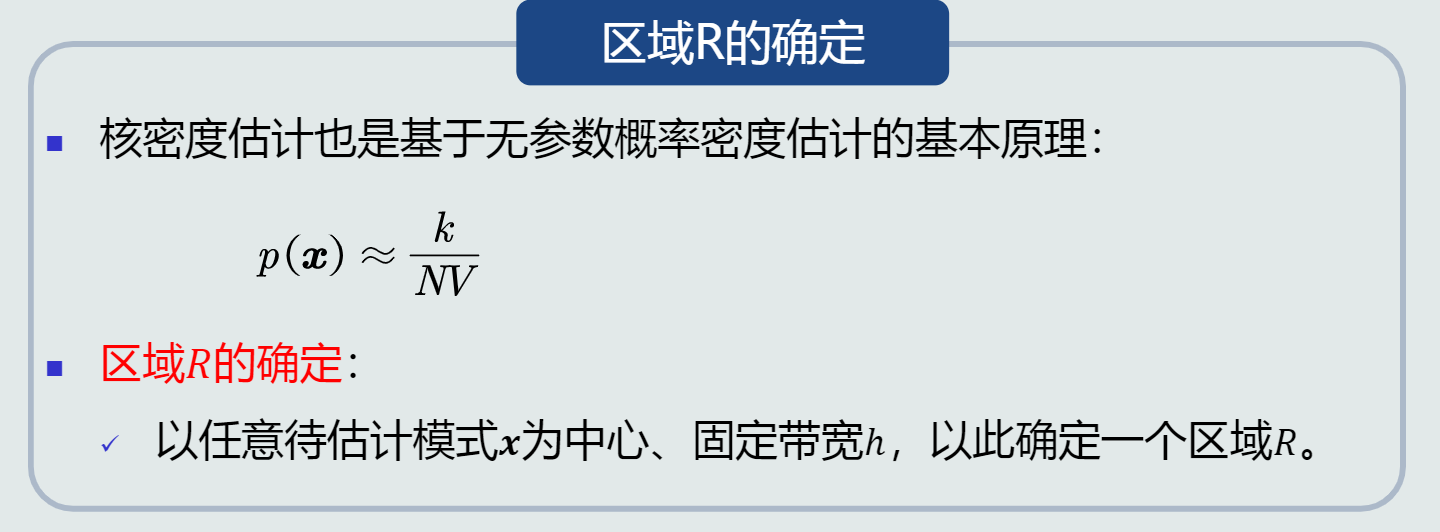

3)常用的无参数估计技术:KNN估计、直方图估计、核密度估计,基于p(x)=k/(NV)估计概率密度。

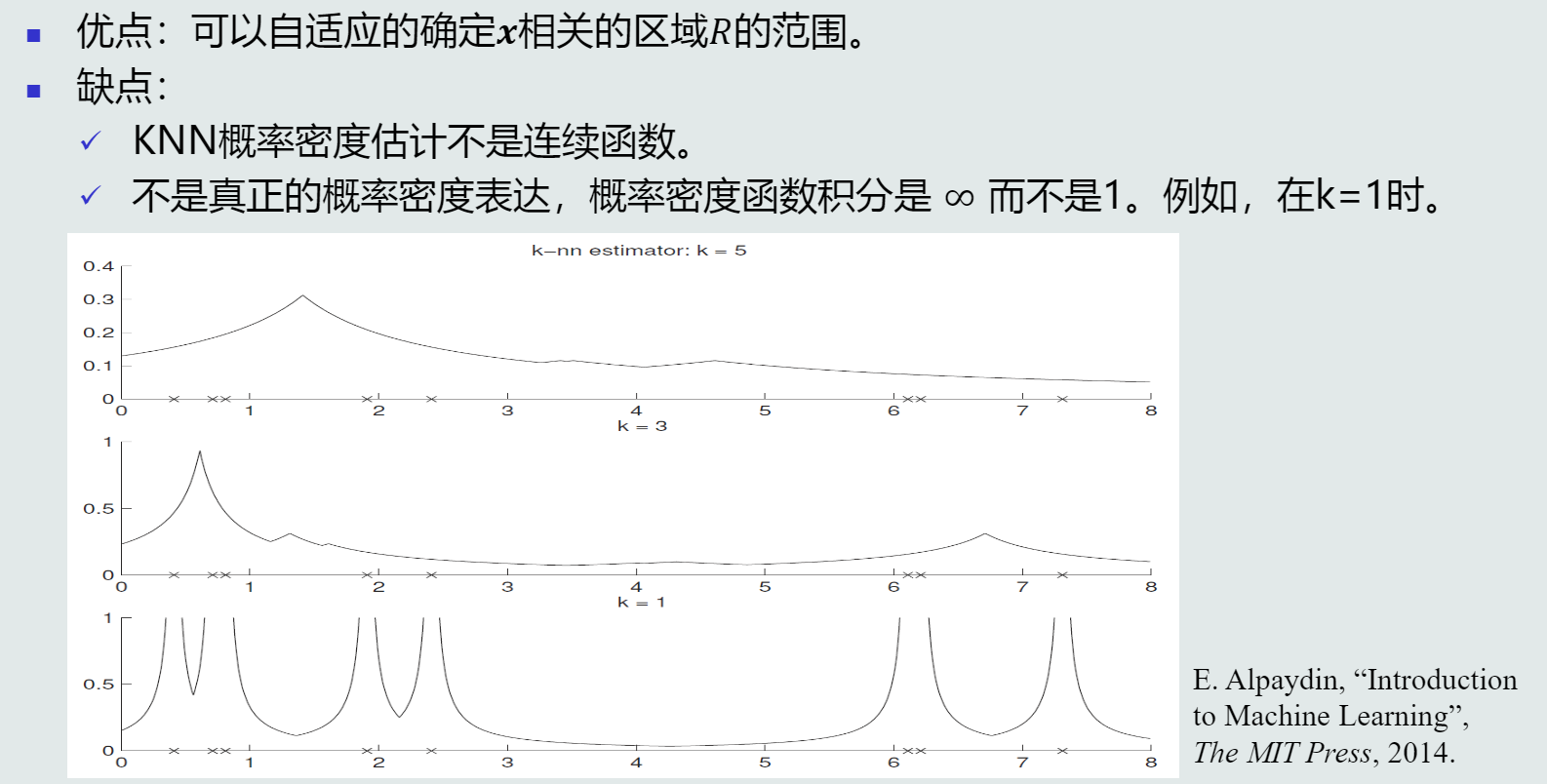

3.8KNN估计

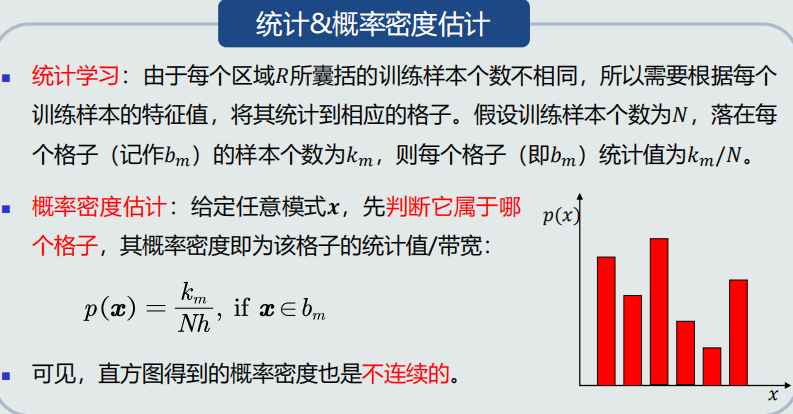

3.9直方图与核密度估计

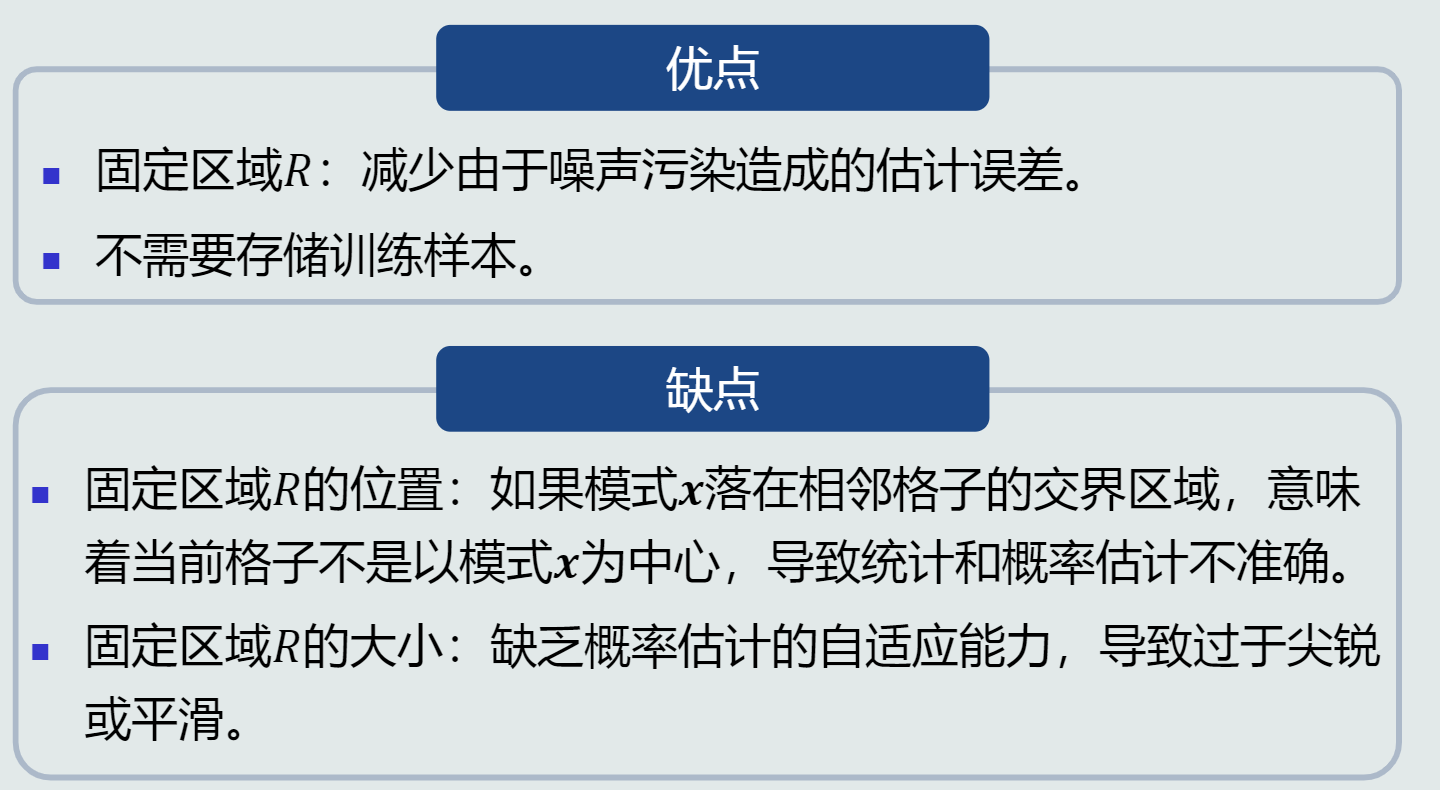

1.直方图估计

-

原理

-

优缺点

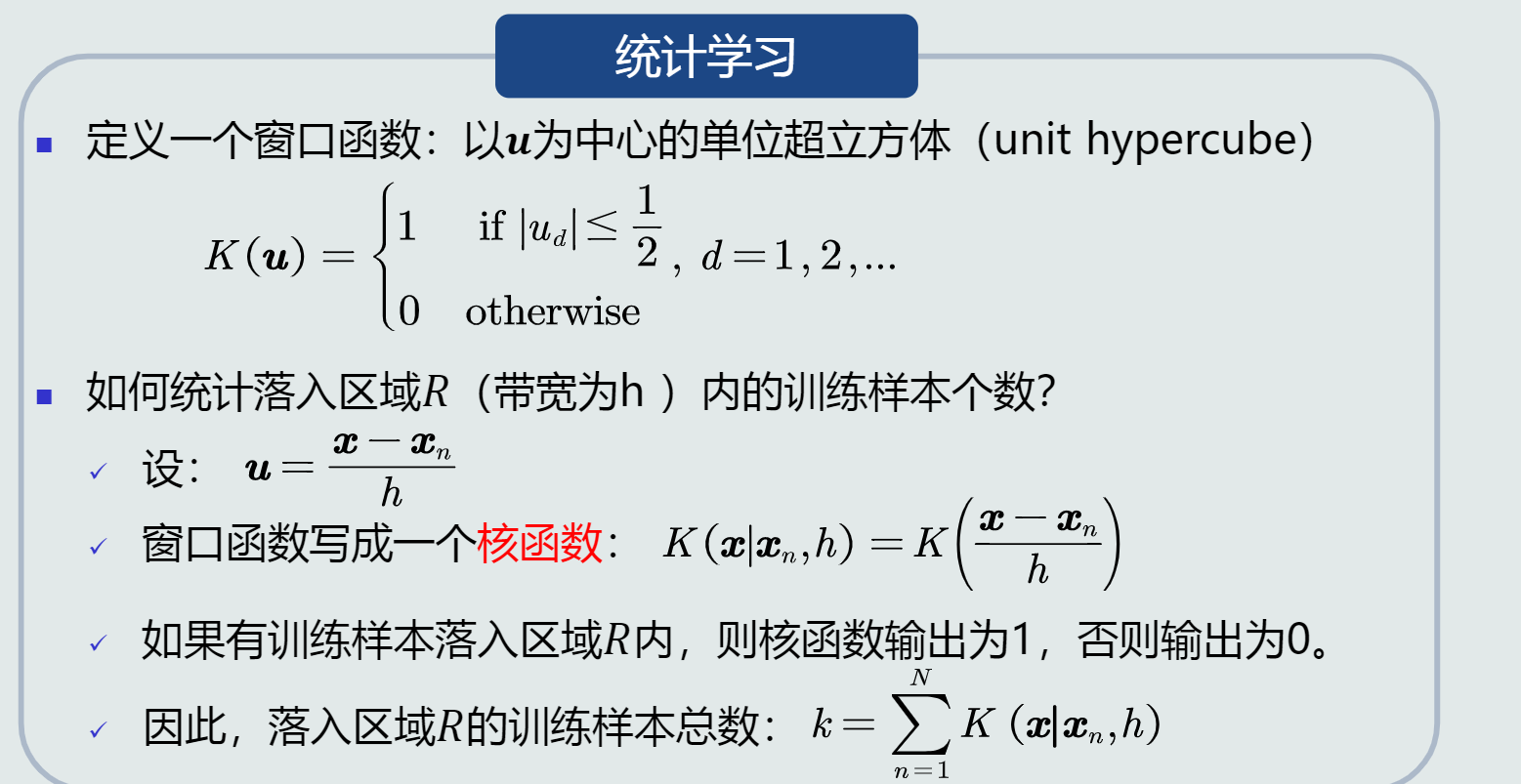

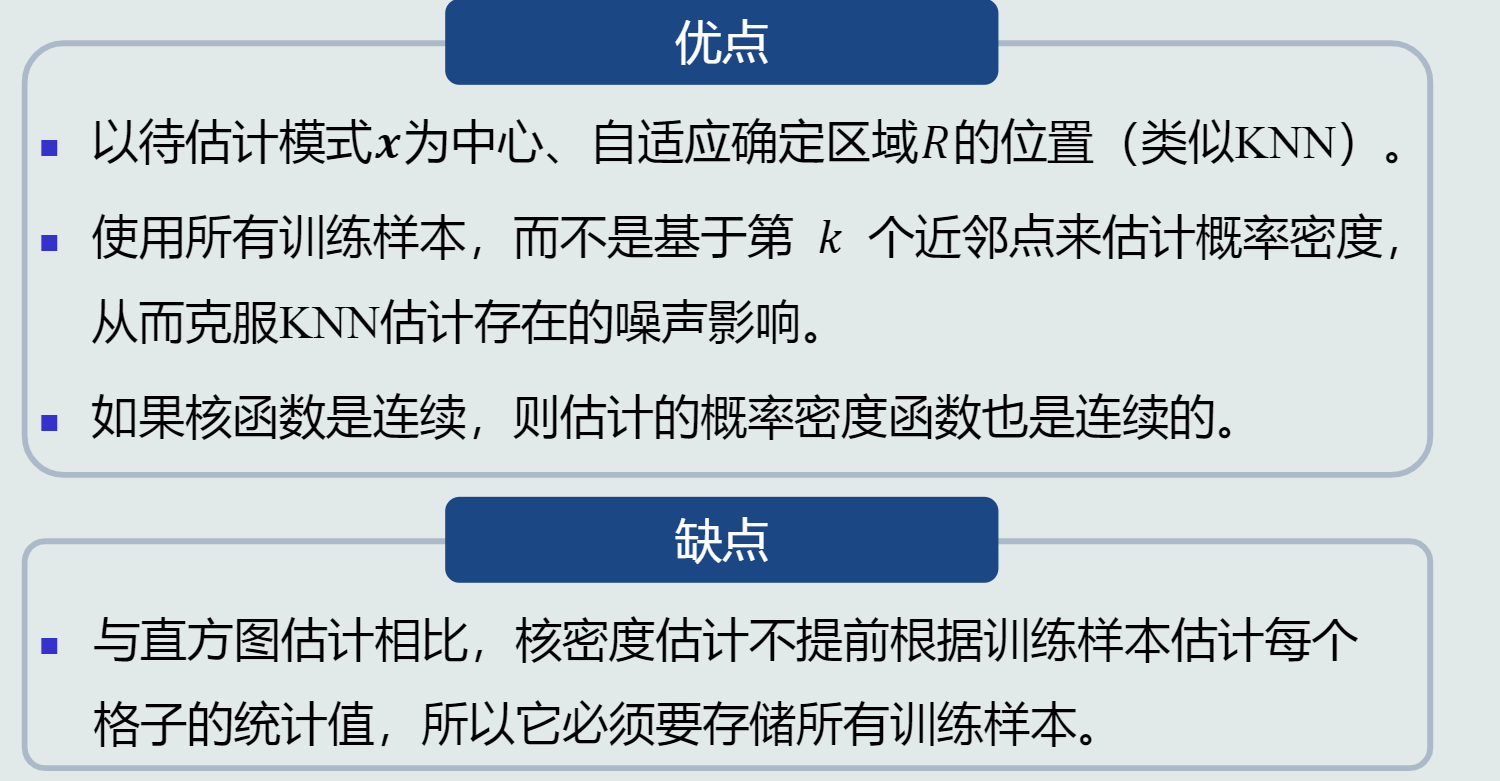

2.核密度估计 -

原理

-

优缺点

浙公网安备 33010602011771号

浙公网安备 33010602011771号