Pytorch中的梯度知识总结

https://blog.csdn.net/qq_45724216/article/details/127645900

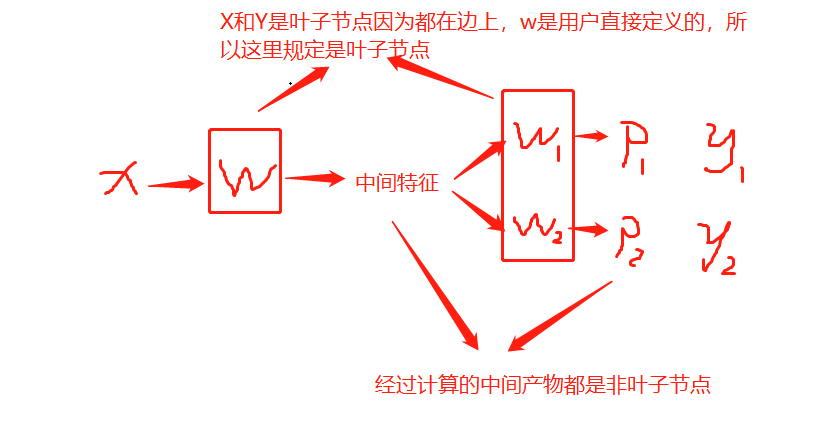

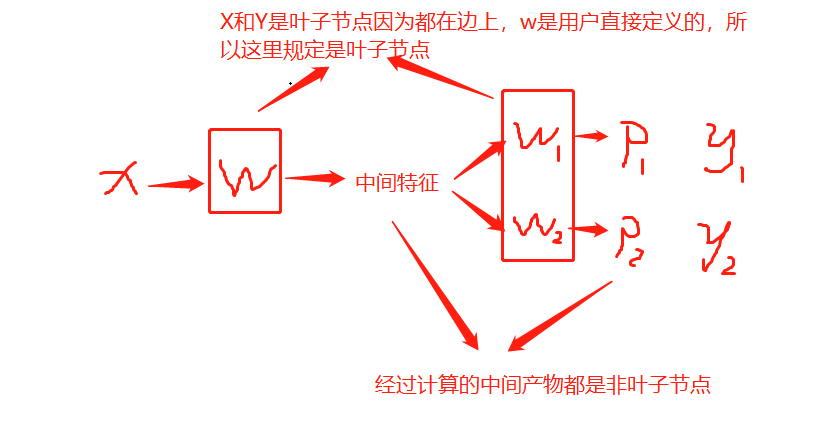

凡是requrie_grad=True的,loss.backward() 的时候都会计算grad,但是大部分人用不到中间产物(如果非要保存的话用retain_grad()),所以只保存了W的grad

https://blog.csdn.net/qq_45724216/article/details/127645900

凡是requrie_grad=True的,loss.backward() 的时候都会计算grad,但是大部分人用不到中间产物(如果非要保存的话用retain_grad()),所以只保存了W的grad