1. 详解Transformer (Attention Is All You Need)

2. The Illustrated Transformer

3.The Illustrated Transformer【译】

4.Transformer 模型详解

5.从中文Transformer到BERT的模型精讲,以及基于BERT情感分类实战

6 图解Transformer——重要理解Attention

7 对模型中embedding的理解

8 各种attention机制

9 各种Attention机制2

10 seq2seq+attention

11 图解seq2seq+attention模型

Tips

tip1

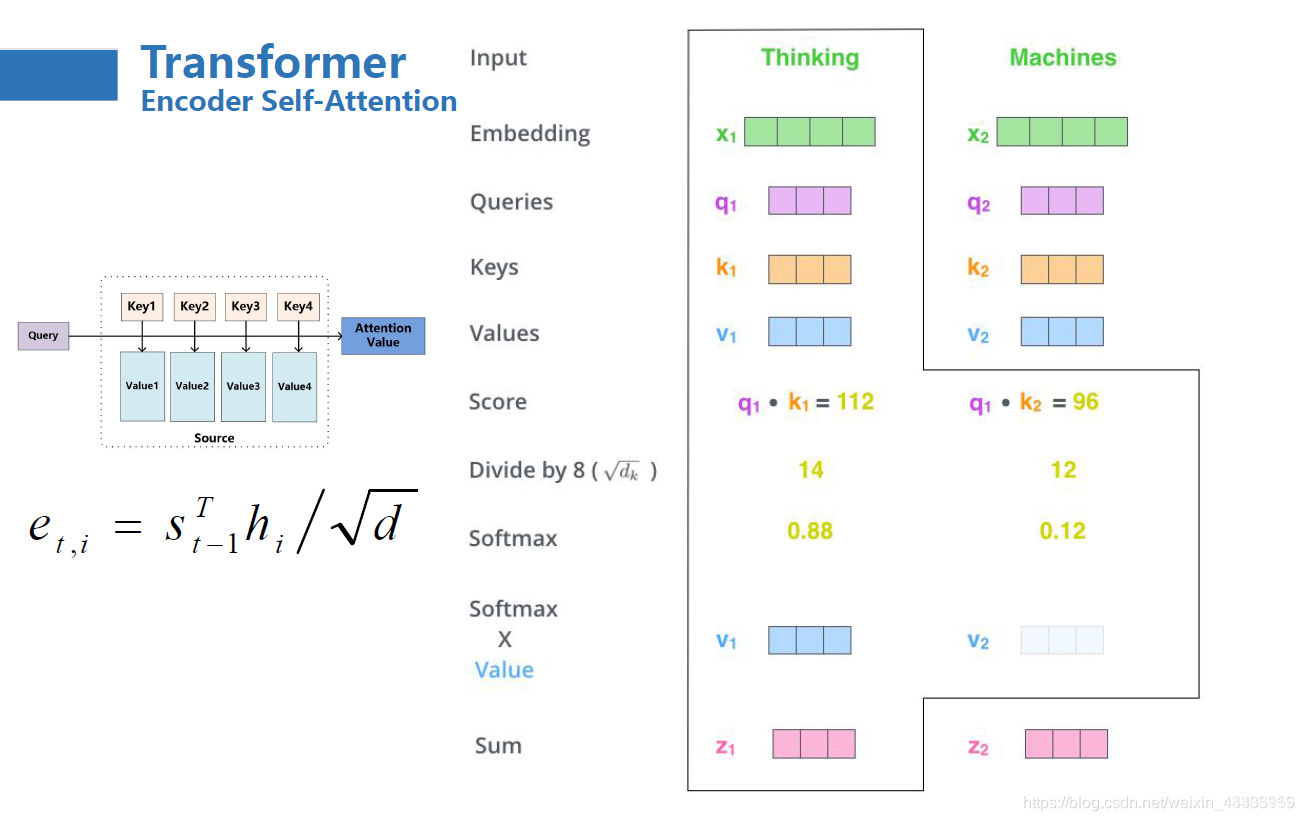

Transformer 中encode层中self-attention的计算

这里的dk是Attention的输出维度大小,一般默认为64,所以加个根号便是8了。

浙公网安备 33010602011771号

浙公网安备 33010602011771号