Dify + Ollama + DeepSeek 知识库部署

通过ollama安装deepseek-r1

我没有GPU服务器,安装7b版本小模型试试。

参考: https://github.com/ollama/ollama

安装ollama

# ollama默认端口11434

curl -fsSL https://ollama.com/install.sh | sh

ollama pull deepseek-r1:7b

# 查看本地模型

ollama list

ollama run deepseek-r1

修改ollama服务监听地址

-

vim /etc/systemd/system/ollama.service, 在[Service]部分添加以下内容:Environment="OLLAMA_HOST=0.0.0.0" -

重新加载配置并重启服务

systemctl daemon-reload systemctl restart ollama

修改ollama模型存储路径

参考: https://github.com/ollama/ollama/blob/main/docs/faq.md

-

停止服务

systemctl stop ollama -

vim /etc/systemd/system/ollama.service, 在[Service]部分添加以下内容:Environment="OLLAMA_MODELS=/apps/ollama" -

迁移数据

chown -R ollama:ollama /apps/ollama/ cp -a /usr/share/ollama/.ollama/models/* /apps/ollama/ -

重新加载配置并重启服务

systemctl daemon-reload systemctl restart ollama

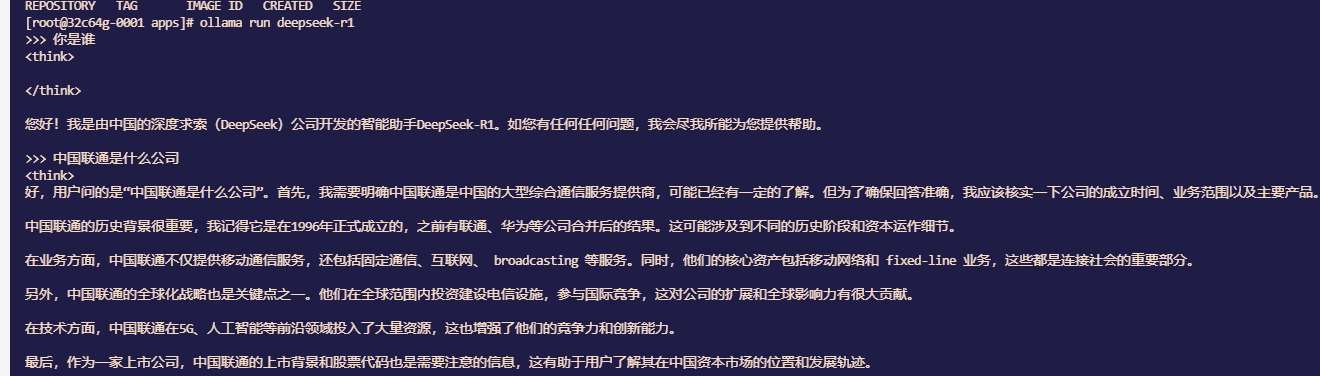

效果展示

Dify部署

参考: https://docs.dify.ai/zh-hans/getting-started/install-self-hosted/docker-compose

yum install -y git

git clone https://github.com/langgenius/dify.git

cd dify/docker

cp .env.example .env

docker-compose up -d

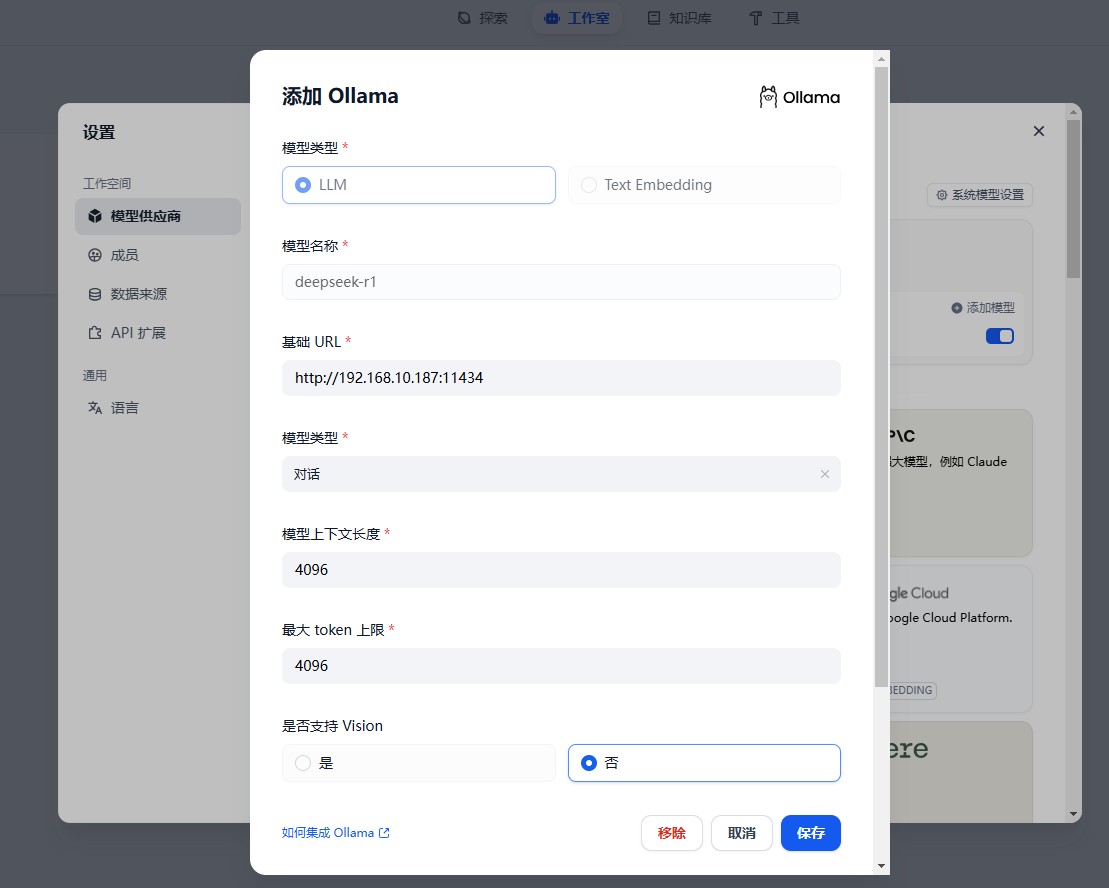

配置本地模型

设置 -> 模型供应商 -> 选择Ollama -> 添加自己的本地模型

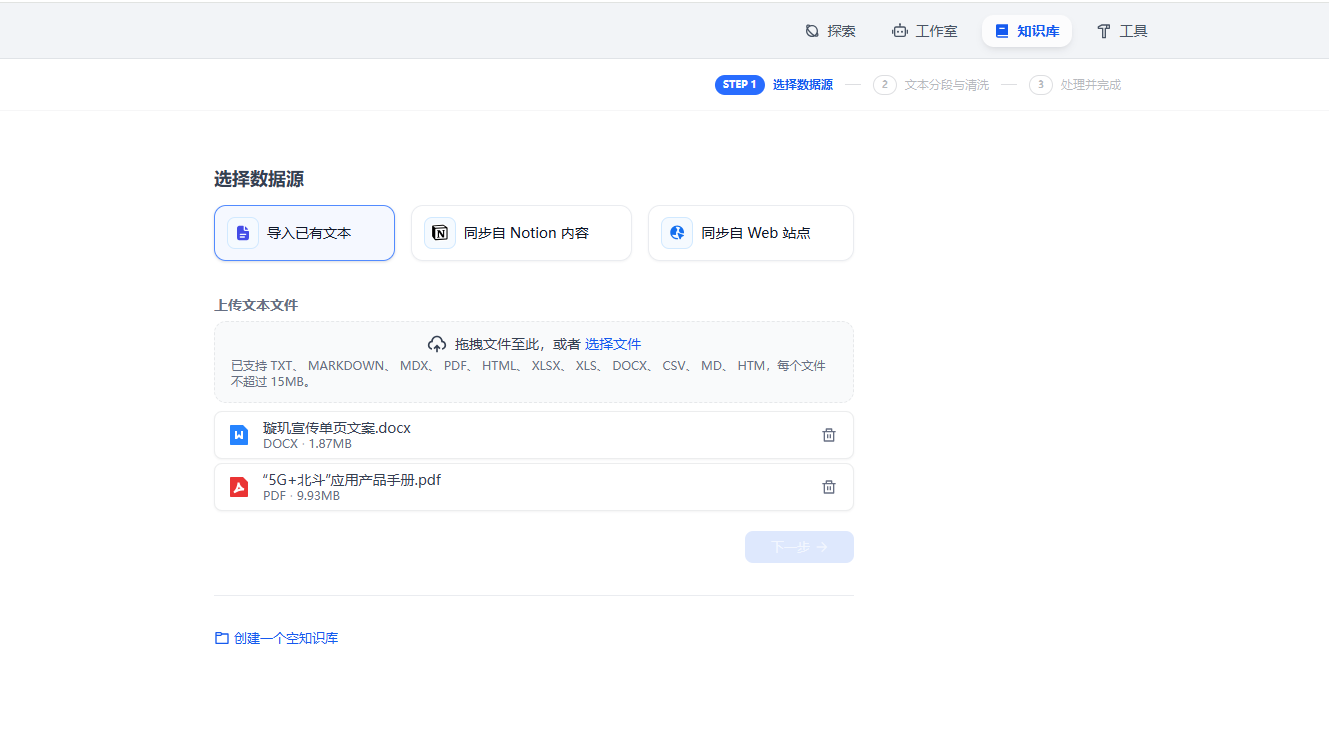

创建知识库

创建知识库,并上传材料即可:

创建应用

经测试,Dify 0.15.3版本下,

聊天助手可以成功引用知识库中的内容,智能体未能调试成功,原因暂时没有找到。

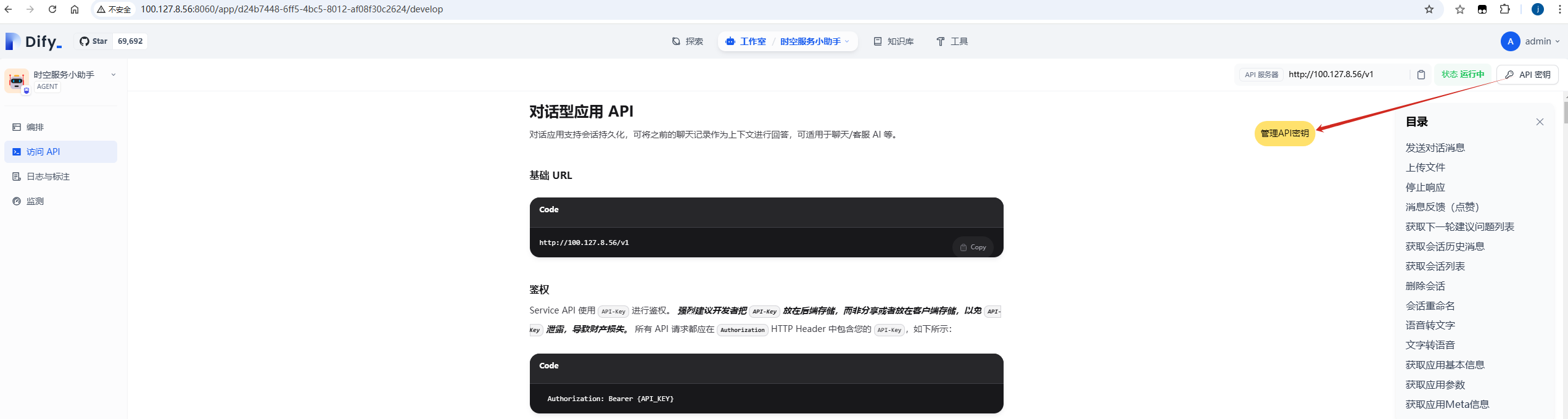

API调用

点击智能体左侧菜单中的访问API,即可管理API密钥,并查阅API文档。

浙公网安备 33010602011771号

浙公网安备 33010602011771号