大模型-Param.data.copy_详细解读-70

param.data.copy_ 这个用法在 PyTorch 中的含义和功能。

首先,直接回答你的问题:是的,param.data (作为一个张量) 是有 copy_ 这个方法的。

接下来,我们详细解释它实现了什么功能。

copy_ 的功能

在 PyTorch 中,以 _ (下划线) 结尾的函数通常表示这是一个 "in-place" (就地) 操作。这意味着它会直接修改调用它的那个张量(Tensor)自身,而不是返回一个新的、修改后的张量。

copy_ 方法的功能是 将另一个张量(src)的数据复制到当前的张量(self)中。

其方法签名为:self.copy_(src, non_blocking=False)

核心功能:

数据复制:它会把 src 张量中的所有元素,逐一复制到 self 张量中相对应的位置。

就地操作:操作完成后,self 张量的内容会被 src 张量的内容覆盖。这个过程不会创建新的张量对象,只是修改了 self 的数据。

形状和类型要求:为了让复制能够成功,self 和 src 两个张量通常需要有相同的形状(size)和数据类型(dtype)。如果形状不匹配,PyTorch 会抛出错误。

在 PyTorch 的神经网络模块(torch.nn)中,param 通常是一个 torch.nn.parameter.Parameter 类的实例。这个类是 torch.Tensor 的一个特殊子类。

当你定义一个神经网络层时,比如 nn.Linear,它的权重(weight)和偏置(bias)就是 Parameter 对象。

import torch

import torch.nn as nn

# 创建一个线性层

linear_layer = nn.Linear(10, 5)

# linear_layer.weight 就是一个 Parameter 对象

param = linear_layer.weight

print(type(param))

# <class 'torch.nn.parameter.Parameter'>

Parameter 对象和普通 Tensor 的主要区别是,它会被自动注册为模块的参数,并出现在 model.parameters() 的迭代器中。这意味着在模型训练时,优化器(如 SGD, Adam)会自动找到它并更新其梯度。

param.data 是什么?

访问 .data 属性会直接获取到该 Parameter 对象内部存储数据的那个底层 Tensor。这样做有一个重要的特点:它会绕过 PyTorch 的自动求导(Autograd)追踪系统。

对 param 直接进行操作(如 param = new_tensor)会被 Autograd 记录。

对 param.data 进行操作则不会被记录。

param.data.copy_ 的作用和使用场景

结合以上几点,param.data.copy_(src) 的完整含义是:

在不被自动求导机制追踪的情况下,将 src 张量的数据,就地复制到 param 这个模型参数的底层数据张量中。

这在模型训练和推理中非常有用,尤其是在需要手动修改模型权重而又不希望这个操作被当做训练过程的一部分时。

常见使用场景:

加载预训练权重:在加载一个预训练好的模型权重到你自己的模型中时,你希望精确地将权重数值复制过去,而不是进行一次可微分的操作。

# 假设 state_dict 是从文件中加载的预训练权重字典

# my_model 是你定义的模型实例

with torch.no_grad(): # 通常会用 torch.no_grad() 上下文来确保不计算梯度

for name, param in my_model.named_parameters():

if name in state_dict:

param.data.copy_(state_dict[name])

模型参数的聚合(如联邦学习):在联邦学习(Federated Learning)中,服务器需要将多个客户端(workers)上传的模型参数进行平均,然后将平均后的参数更新回全局模型。这个更新过程就是数值的直接替换。

# 伪代码

global_model_params = global_model.parameters()

client_model_params = client_model.parameters()

with torch.no_grad():

for global_param, client_param in zip(global_model_params, client_model_params):

# 比如将客户端参数直接复制给全局模型

global_param.data.copy_(client_param.data)

模型参数的重置:如果你想将一个模型的某一层权重重置为某个初始值,可以使用 copy_。

with torch.no_grad():

# 将某一层权重重置为 0

my_model.layer1.weight.data.copy_(torch.zeros_like(my_model.layer1.weight.data))

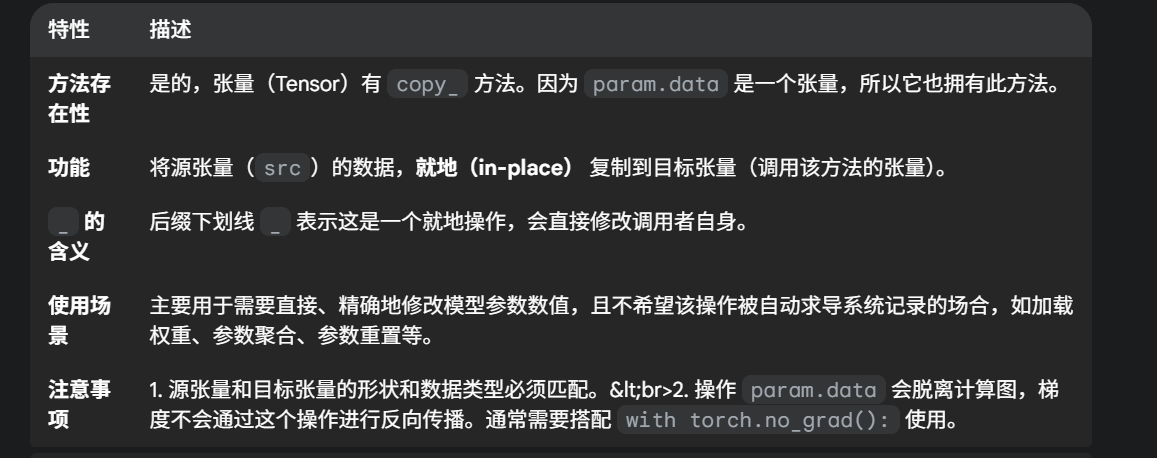

特性 描述

方法存在性 张量(Tensor)有 copy_ 方法。因为 param.data 是一个张量,所以它也拥有此方法。

功能 将源张量(src)的数据,就地(in-place) 复制到目标张量(调用该方法的张量)。

_ 的含义 后缀下划线 _ 表示这是一个就地操作,会直接修改调用者自身。

使用场景 主要用于需要直接、精确地修改模型参数数值,且不希望该操作被自动求导系统记录的场合,如加载权重、参数聚合、参数重置等。

注意事项 1. 源张量和目标张量的形状和数据类型必须匹配。<br>2. 操作 param.data 会脱离计算图,梯度不会通过这个操作进行反向传播。通常需要搭配 with torch.no_grad(): 使用。

浙公网安备 33010602011771号

浙公网安备 33010602011771号