AI大模型初识及Ollama安装使用

AI大模型基础

概念

大模型,通常值的是“大语言模型”,它是一个通过在海量文本数据上训练、能够理解并生成人类语言的超大型人工智能程序。

分类

- 自然语言处理模型:让机器理解、生成和处理人类语言。核心任务包括文本分类、翻译、问答、情感分析等。

- 计算机视觉(CV)模型:视觉大模型(Large Visual Models)核心是通过大规模数据和复杂模型架构,实现对图像和视频的深度理解和生成。能够处理复杂的视觉任务,如图像分类、目标检测、语义分割、图像生成等。

- 语音模型:语音模型是将声音信号转换为数字信号的模型,主要用于处理语音相关的任务,如语音识别(ASR)、语音合成(TTS)、声音事件监测(警报、机器故障)、语音增强、说话人识别、语音翻译等。

- 多模态模型:多模态模型是一种能够同时处理多种数据模态(如文本、图像、音频、视频等)的人工智能模型。

模型关系图:

| 模型 | 说明 |

|---|---|

| 自然语言处理(NLP) | 文本理解/生成 |

| 计算机视觉(CV) | 图像理解/生成 |

| 语音模型(ASR/TTS) | 语音<->文本转换 |

| 多模态模型(CLIP/Qwen-VL) | 融合所有能力,实现“看图说话+语音交互”。 |

Ollama

什么是Ollama?

Ollama是一款旨在简化大型语言模型本地部署和运行过程的开源软件。

Ollama提供了一个轻量级、易于扩展的框架,让开发者能够在本地机器上轻松构建和管理LLMs(大型语音模型)。无需关注复杂的底层实现细节。

Ollama特点

- 一站式管理:Ollama将模型权重、配置和数据捆绑到一个包中,定义成Modelfile,从而优化了设置和配置细节。用户无需关注底层实现细节,即可快速部署和运行复杂的大预言模型。

- 热加载模型文件:支持热加载模型文件,无需重新启动即可切换不同的模型,提高灵活性,增强了用户体验。

- 丰富的模型库:提供多种预构建的模型,如DeepSeek、通义千问等,方便用户快速在本地运行大型语言模型。

- 多平台支持:支持多种操作系统,如Mac、Windows和Linux,确保了广泛的可用性和灵活性。

- 无复杂依赖:优化推理代码,减少不必要的依赖,可以在各种硬件上高效运行。

- 资源占用减少:Ollama的代码简洁明了,运行时占用资源少,使其能够在本地高效运行,不需要大量的计算资源。

Ollama下载与安装

下载

- 访问ollama官网打开浏览器,访问Ollama的官方网站:https://lollama.ail。在官网首页,你可以找到"Download"按钮,点击后会跳转到下载页面。

- 选择Windows版本在下载页面,找到适用于Windows系统的安装包。Ollama通常提供.exe格式的安装程序,直接点击下载即可。

安装

- 第一步:找到执行程序>OllamaSetup.exe

- 第二步:右键管理员身份运行(按照默认路径自动安装)

默认安装路径:C:\Users\xxx\AppData\Local\Programs\Ollama

若要修改安装路径,按以下步骤操作:

- 以管理员身份打开命令提示符(Win+R➡输入cmd➡右键选择“以管理员身份运行”),切换到OllamaSetup.exe所在目录,或者用下面方式直接运行cmd。

2.执行以下命令:

DIR是你想要安装的文件目录

OllamaSteup.exe /DIR="D:\Tool\Ollama"

如果出现以下报错:

Suggestion [3,General]: 找不到命令 OllamaSetup.exe,但它确实存在于当前位置。默认情况下,Windows PowerShell 不会从当前位置加载命令。如果信任此命令,请改为键入“.\OllamaSetup.exe”。有关详细信息,请参阅 "get-help about_Command_Precedence"。

可以尝试以下命令:

& "安装包路径\OllamaSetup.exe" /DIR="D:\Tool\Ollama"

- 第三步:点击install进行安装

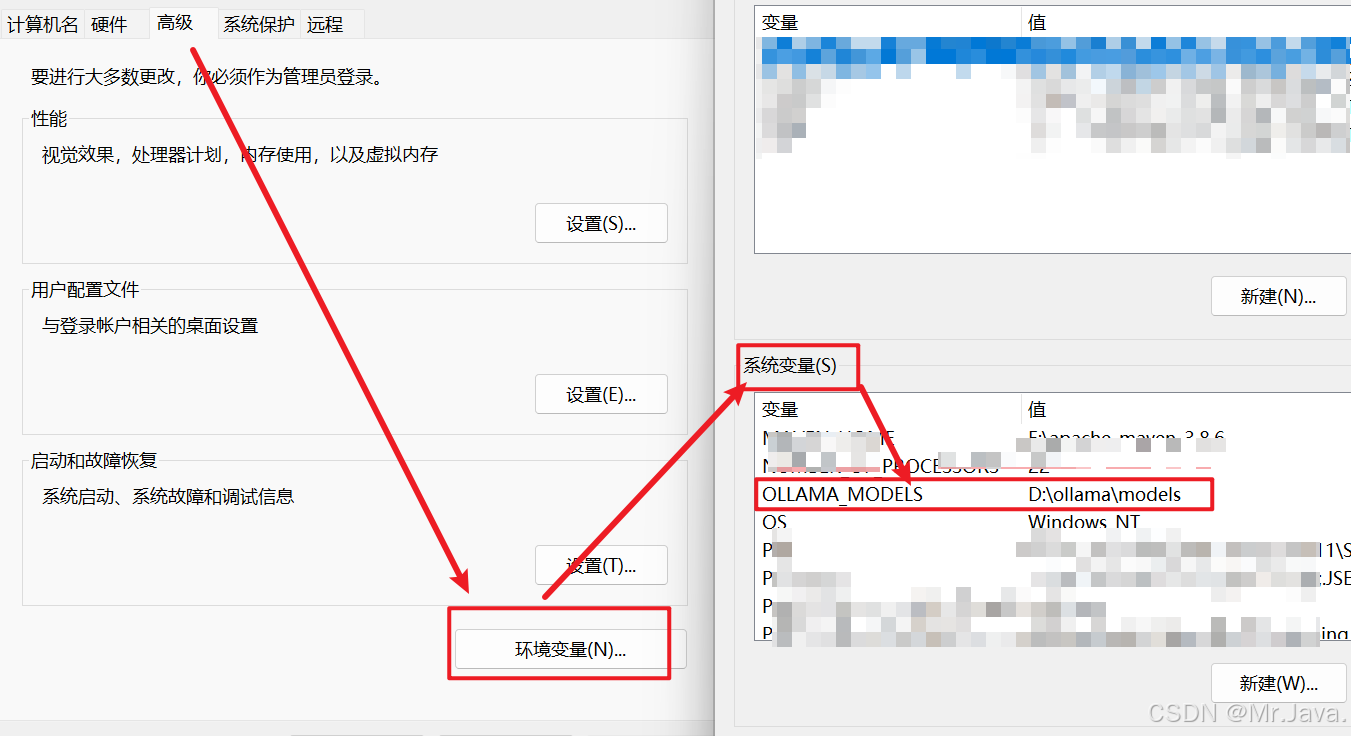

- 第四步:修改环境变量更改模型安装位置

模型默认的安装位置:C:lUsersl%username%l.ollamalmodels

修改环境变量,在“新建系统变量”窗口中,输入变量名OLLAMA_MODELS,变量值为你希望的模型存储路径(例如D:\ollama\models

- 第五步:验证,cmd命令行中,输入ollama -v 显示ollama版本号。

Ollama客户端命令

run 运行模型

ollama run MODEL[:Version][PROMPT][flags]

MODEL:模型名称

[:Version]:模型版本

[PROMPT]:参数是用户输入的提示词,只对话一次

[flags]:指定运行时的参数

| Flags参数列表 | |

|---|---|

| --format string | 指定运行的模型输出格式(比如.json) |

| --insecure | 使用非安全模式,比如在下载模型时会忽略https的安全证书 |

| --keepalive string | 指定模型在内存中的存货时间 |

| --nowordwrap | 关闭单词自动换行功能 |

| --verbose | 开启统计日志信息 |

示例:

ollama run qwen2:0.5b

show查看模型信息

# 语法

ollama show MODEL

# MODEL:模型名称

#示例:

ollama show qwen2:0.5b

返回参数项:

pull下载模型

ollama pull MODEL[:Version]

\# 示例:

ollama pull qwen2

等同于

ollama pull qwen2:latest

\#latest是指最新版本

list/ls查看本地下载模型列表

ollama list 或 ollama ls

返回参数:

| 参数 | 说明 |

|---|---|

| NAME | 名称 |

| ID | 大模型唯一ID |

| SIZE | 大模型大小 |

| MODIFIED | 本地存活时间 |

rm删除本地大模型

ollama rm qwen2:0.5b

Ollama对话指令

| 指令类型 | 指令 | 说明 |

|---|---|---|

| 基本指令 | /? | 查看支持的指令 |

| /bye | 退出对话模型 | |

| /show | 显示模型信息 | |

| /? shortcuts | 查看快捷键 | |

| """ | 多行输入指令 | |

| 对话调整指令 | /set | 设置对话参数 |

| /clear | 清理上下文 | |

| 模型调整指令 | /load | 动态切换模型 |

| /save | 存储模型 |

/show延申指令:

| /show info | 查看模型的基本信息 |

|---|---|

| /show license | 查看模型的许可信息 |

| /show modelfile | 查看模型的制作源文件Modelfile |

| /show parameters | 查看模型的内置参数信息 |

| /show system | 查看模型的内置System信息 |

| /show template | 查看模型的提示词模板 |

/? shortcuts延申指令:

| Ctrl + a | 移动到行头 |

|---|---|

| Ctrl + e | 移动到行尾 |

| Ctrl + b | 移动到单词左边 |

| Ctrl + f | 移动到单词右边 |

| Ctrl + k | 删除游标后面的内容 |

| Ctrl + u | 删除游标前面的内容 |

| Ctrl + w | 删除游标前面的单词 |

| Ctrl + l | 清屏 |

| Ctrl + c | 停止推理输出 |

| Ctrl + d | 退出对话(只有在没有输入时才生效) |

/set 延申指令:

| /set parameter | 设置对话参数 |

|---|---|

| /set system |

设置系统角色 |

| /set template |

设置推理模板 |

| /set history | 开启对话历史 |

| /set nohistory | 关闭对话历史 |

| /set wordwrap | 开启自动换行 |

| /set nowordwrap | 关闭自动换行 |

| /set format json | 输出JSON格式 |

| /set noformat | 关闭格式输出 |

| /set verbose | 开启对话统计日志 |

| /set quiet | 关闭对话统计日志 |

本文来自博客园,作者:不思量一口干,转载请注明原文链接:https://www.cnblogs.com/bsl-zjw/articles/19497032

浙公网安备 33010602011771号

浙公网安备 33010602011771号