MOE中 switch transformer

非常好的问题!

Switch Transformer 是谷歌在 2021 年提出的一种改进版 Transformer,主要是为了 在保持训练效率的同时,大幅增加模型容量。

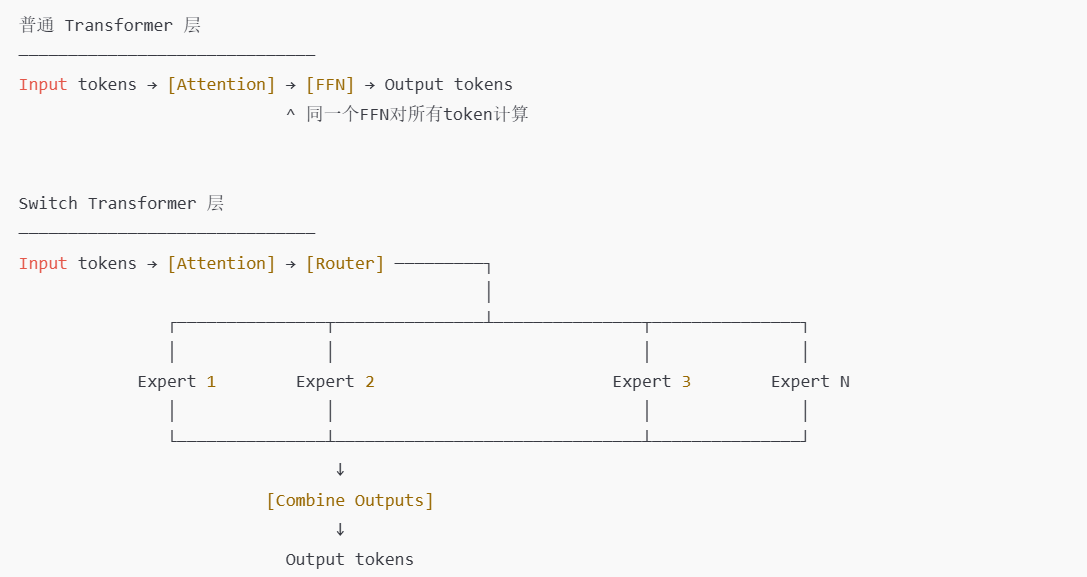

它和普通 Transformer(例如 BERT、GPT 等使用的标准架构)在核心机制上非常相似,但在 前馈网络(Feed-Forward Network, FFN)部分 做了关键性的创新。

下面详细说明两者的主要区别:

🎯 1. 核心思想:密集 vs 稀疏激活

| 模型类型 | 激活方式 | 含义 |

|---|---|---|

| 普通Transformer | 密集(Dense) | 每一层的所有神经元对每个输入token都激活、都参与计算。 |

| Switch Transformer | 稀疏(Sparse) | 每个token只通过一小部分(通常是1个)「专家」子网络计算,从而大幅减少计算量。 |

换句话说,Switch Transformer 并不是扩大整个网络的计算负担,而是通过「只激活部分子网络」来让模型容量变大但计算量受控。

⚙️ 2. 前馈层(FFN)的结构不同

在普通 Transformer 的每个 Transformer block 里,FFN 结构一般是这样的:

在 Switch Transformer 中,这个 FFN 模块被替换成一个 Mixture-of-Experts (MoE) 结构:

- 模型中有多个「专家」(expert),每个专家其实就是一个 FFN。

- 一个轻量「路由器(Router)」负责决定每个输入 token 该送到哪个专家。

- 通常每个 token 只会被送到 一个专家(这就是 “switch” 的由来——每次只选择一个)。

数学上可以描述为:

其中:

- xixi 是第 ii 个 token 的输入,

- EkEk 表示第 kk 个专家(一个独立的 FFN),

- r(i)r(i) 是路由器选择的专家索引。

🧮 3. 模型容量与计算成本

| 指标 | 普通Transformer | Switch Transformer |

|---|---|---|

| 模型容量 | 受限于计算量 | 可扩展到数十亿甚至上千亿参数(通过增专家) |

| 每次计算量 | 与模型大小成正比 | 与专家数量几乎无关(只激活少数专家) |

| 硬件效率 | 较高(无稀疏通信) | 稀疏通信需要优化(跨设备路由) |

举例:Switch Transformer 达到了 1.6 万亿参数(1.6T),但每次训练时仅使用约 1/64 的参数,这让大模型变得可训练。

🧩 4. 训练挑战与解决方案

主要难点 在于「负载均衡」:

- 如果路由器总是选中几个固定专家,则部分专家会被过度使用、其他几乎不用。

- 解决方法是加入一个 load balancing loss,鼓励路由器把token分配得均匀一些。

🚀 5. 性能与应用效果

- 在相同计算预算下,Switch Transformer 能达到和更大 dense 模型相近甚至更好的效果。

- 特别适合超大规模语言模型(例如 PaLM、Gemini 系列内部都受其思想影响)。

- 缺点是在分布式系统中实现较复杂,需要支持专家间通信和高效的动态路由。

✅ 总结对比

| 方面 | 普通 Transformer | Switch Transformer |

|---|---|---|

| FFN结构 | 单一FFN | 多专家FFN(MoE) |

| 参数共享 | 全部共享 | 专家部分独立 |

| 激活方式 | Dense | Sparse(每token选几个专家) |

| 模型容量 | 受限 | 可极大扩展 |

| 计算成本 | 高(随容量线性增加) | 稀疏(成本近似不变) |

| 实现复杂度 | 简单 | 较复杂(需路由、负载均衡) |

是否希望我帮你画一个简单图,对比一下普通 Transformer 的 FFN 和 Switch Transformer 的 MoE 结构?

(一个示意图会更直观展示区别。)

非常好的追问,这其实切中了 Switch Transformer 的一个核心疑惑——

如果不同 token 被送到不同专家处理,会不会「风格不一致」或者「语义断裂」?

我们可以这样理解它的运作机制,来看看为什么一般不会产生这种问题👇

🧠 一、专家是“内层功能模块”,不是生成独立句子

每个 token 被送到的“专家”其实只是执行 前馈网络(Feed Forward Network, FFN) 计算的子模块,它并不独立生成内容,也不会自己决定语义。

换句话说:

- 词的含义、句子的连贯性 是由 自注意力层(Self-Attention Layer) 保持的;

- 而专家层只是在 token 局部的、非交互部分(FFN层)做特征变换,用不同的参数提升表达能力。

所以,即使 token A 去了专家1,token B 去了专家2,它们的上下文依然通过注意力层互相感知——不会“各说各话”。

🧩 二、专家输出的维度是严格对齐的

所有专家的输入输出维度完全相同(比如都从 dmodeldmodel → dffdff → dmodeldmodel 的映射),

因此不管 token 被送到哪个专家,输出 shape 和规范一致,后续层照常计算。

这就保证了:

- 不存在“输出错位”或“拼接对不齐”的问题;

- 只是数值经过了不同参数的非线性变换,但其结构完全兼容。

⚙️ 三、训练时的联合优化保证一致性

所有专家与路由器一起 端到端训练。

训练目标(比如语言建模loss)会逼迫它们在整体上产生一致的语义输出。

模型会自动学会:

- 哪类 token 适合哪个专家(例如数字 vs 名词 vs 稀有词);

- 各专家间参数差异如何协同工作,让最终输出更稳定。

同时还有一个 负载均衡损失(load balancing loss),防止路由器总偏向某几个专家,从而让所有专家都学到稳健的变换。

🧪 四、在生成时的连贯性

生成时模型仍是按 token 顺序解码:

- 当前 token 输入模型;

- 经过自注意力和路由器;

- 路由器选择一个专家做FFN;

- 汇总结果并预测下一个 token。

整个过程依然是 单流递归生成,并没有在逻辑上分叉为多个专家子句。

所以不会出现“专家A生成半句,专家B接上另一半句”的情况。

🧭 可以理解成这样类比:

- 普通 Transformer:每个词都经过同一个加工厂。

- Switch Transformer:每个词被路由到专门的车间加工(某些车间可能更擅长处理数字、专有名词或罕见语法);

但所有车间生产的部件都会重新组装到同一个流水线上,整体语义还是一致的。

✅ 总结

| 担忧 | 事实 |

|---|---|

| 不同专家输出会不会风格不同? | 不会明显不同,因为 attention 层统一上下文、专家训练时参数联合优化 |

| token 输出会不会不对齐? | 不会,所有专家输出维度相同,结果拼接后继续流入同一结构 |

| 模型语义会不会乱? | 不会,稀疏激活发生在局部子层,不影响全局语义一致性 |

浙公网安备 33010602011771号

浙公网安备 33010602011771号