智能体安全——LLM-KG Framework for Robot Intention Prediction 文章要点总结

LLM-KG Framework for Robot Intention Prediction

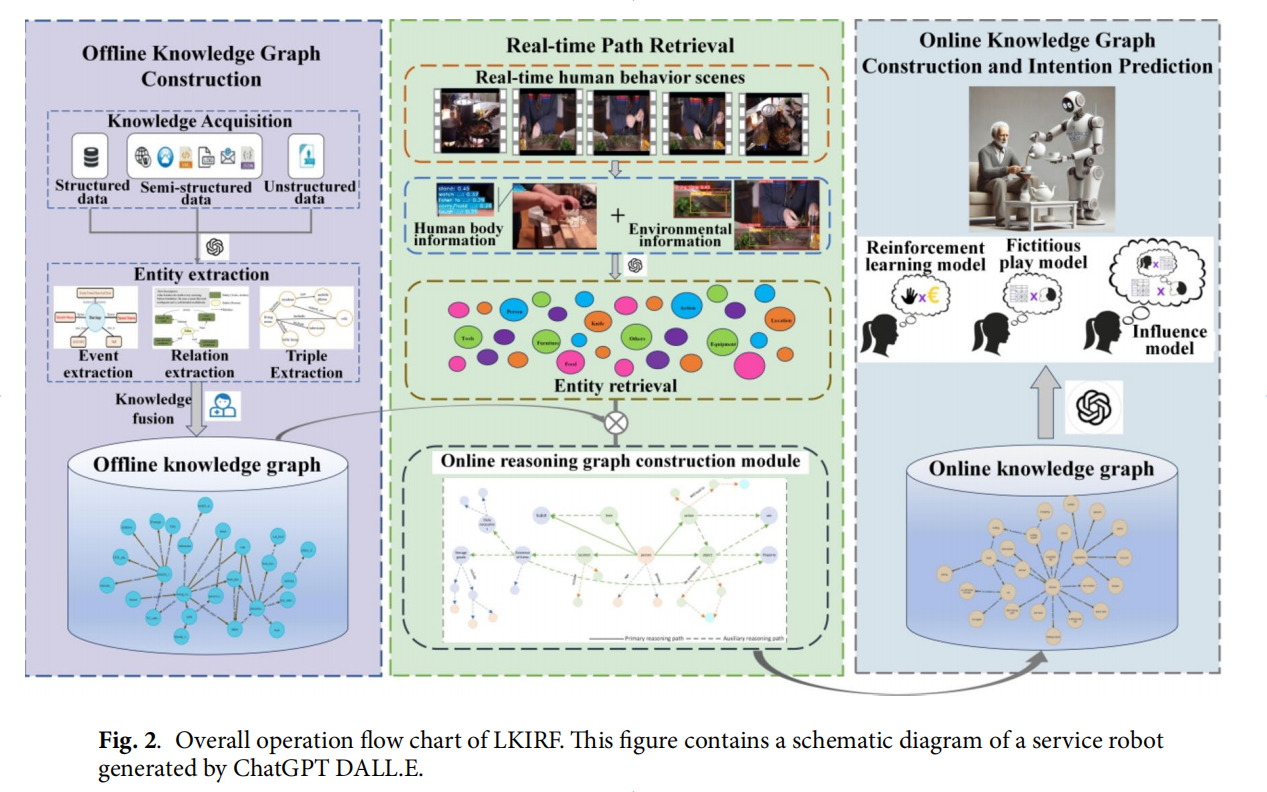

这份文本介绍了一种新颖的框架(LKIRF),旨在提升服务机器人在复杂环境中识别人类意图的准确性和可解释性。该框架通过结合大型语言模型(LLM)和知识图谱(KG)来解决传统方法在处理上下文和深层语义理解方面的不足。研究人员构建了离线知识图谱以理解人类行为和环境数据,并通过实时交互构建在线推理图,再利用LLM进行解释和意图推断。实验结果表明,与传统方法相比,LKIRF不仅提高了预测精度,还显著增强了推理过程的透明度,为服务机器人更好地理解和响应人类需求提供了基础。

人类意图识别框架 LKIRF:结合大型语言模型与知识图谱的创新方法

本研究提出了一种融合**大型语言模型(LLM)与 知识图谱(KG)**的人类意图识别框架——LKIRF (Large Language Model and Knowledge Graph-based Intent Recognition Framework),旨在提升服务机器人在复杂非结构化环境中对人类意图的识别能力、推理透明度和可解释性。

一、核心要点 (Key Points)

1. 核心目标与挑战

- 目标 :服务机器人需准确识别并预测人类意图,以实现高效交互。

- 挑战 :

- 人类意图具有高度复杂性和多样性;

- 意图受场景、任务和上下文影响;

- 传统方法在非结构化环境下表现不佳,仅关注词汇层面理解,忽视实体间深层语义与潜在关系;

- 缺乏对个体差异和环境动态变化的建模能力。

2. LKIRF 框架概述

LKIRF 结合 LLM 的语义理解能力和 KG 的结构化知识表示能力,形成多维推理机制,具体流程如下:

(1)离线知识图谱构建

- 基于人类行为数据与物理环境信息,构建静态知识图谱;

- 支持对人类行为模式的深度建模。

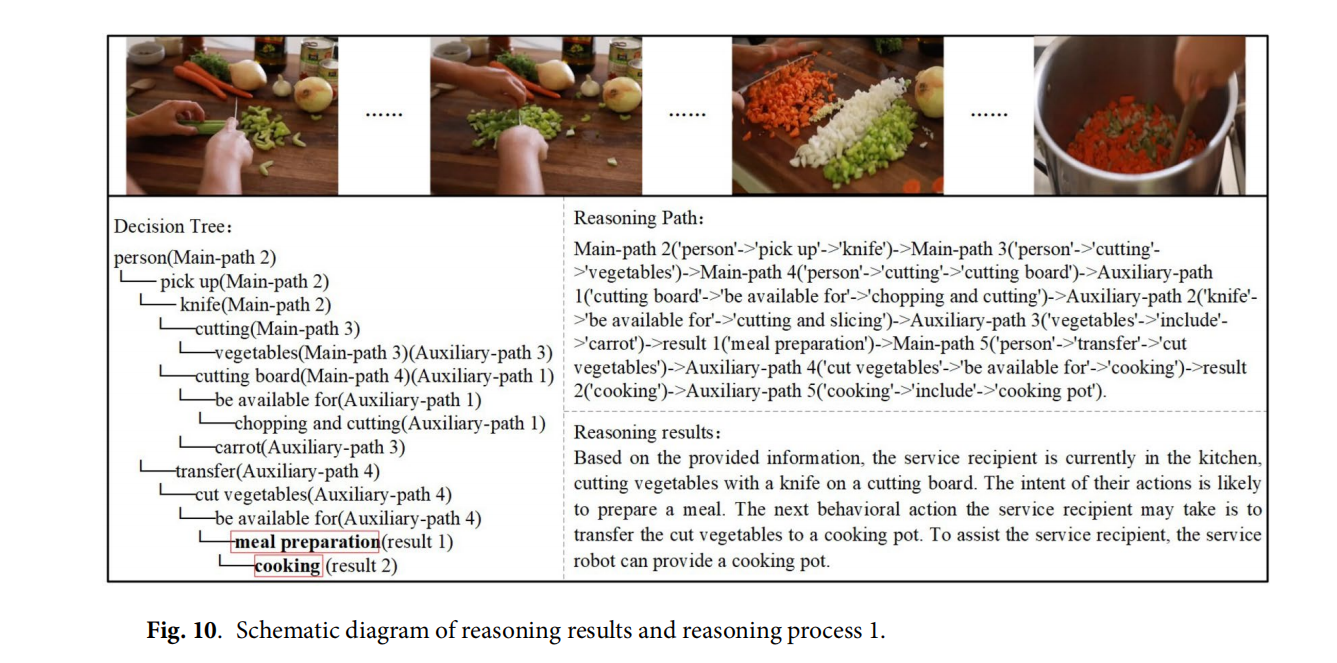

(2)实时推理图构建

- 利用当前环境信息从离线KG中提取相关子图;

- 结合LLM生成自然语言描述,构建在线推理图。

(3)意图推断

- 综合历史知识与实时信息,进行意图识别与预测。

3. 双向增强与可解释性

- 双向增强 :LLM 为 KG 提供语义扩展,KG 为 LLM 提供结构化支撑;

- 可解释性强 :推理路径可视化,便于用户理解和信任系统决策过程。

4. 优势互补

- 两者结合可实现:

- 更精准捕捉文本细微差异;

- 揭示复杂情境下的多维度关联;

- 提升在不可预见场景中的鲁棒性与泛化能力。

二、关键算法 (Key Algorithms)

LKIRF 框架由多个关键模块构成,涵盖知识构建、推理路径获取、意图识别等阶段。各阶段使用的主要算法如下:

1. 大型语言模型(LLM)

- GPT-3.5

- 功能 :实体/关系抽取、推理路径生成、意图解释

- 处理流程 :

- 第一阶段 :设计提示词模板,输入 GPT-3.5,生成初步实体、关系、事件类型;

- 第二阶段 :基于第一阶段结果,采用多提示学习策略,细化提取具体内容;

- 推理与解释 :

- 将子图集转化为自然语言描述;

- 构建在线推理图并生成决策树、推理路径摘要;

- 参数设置 :Temperature = 0.7,平衡生成文本的多样性和一致性,最大化 F1-score。

2. 知识图谱(KG)

- 离线KG构建

- 步骤:数据收集 → 预处理 → 本体构建 → 信息提取 → 知识融合 → 知识处理;

- 在线KG构建

- 实时整合主推理路径与辅助推理路径;

- 克服静态KG的时效性与上下文依赖问题。

3. 环境感知与姿态识别

- SlowFast 模型 :端到端时空动作检测,获取人体姿态与动作信息;

- YOLOv8 :目标检测与识别,提取环境实体信息。

4. 推理路径获取

- 主推理路径搜索 :

- 在实体集中探索连接路径,深度可达 k 步;

- 构建主推理子图集;

- 辅助推理路径搜索 :

- 对每个实体进行一步扩展;

- 结合语义相关性验证,丰富推理子图集合。

5. 基线模型(Baseline Models)

用于实验对比的关键模型包括:

三、实验结果与性能评估

在 WHYACT 数据集上的实验表明:

- LKIRF 相比纯 LLM 或其他基线模型,在意图识别任务中显著提升了性能;

- F1-score 达到峰值 ,验证了 LLM 与 KG 融合的有效性;

- 模型具备更强的泛化能力、可解释性和鲁棒性,适用于复杂或不可预见的交互场景。

四、总结

LKIRF 框架通过融合 LLM 的语义理解与 KG 的结构化知识,实现了对人类意图的高精度识别与可解释性推理。该方法不仅提升了服务机器人在复杂环境中的智能交互能力,也为未来人机协同系统的开发提供了新的思路和技术路径。

浙公网安备 33010602011771号

浙公网安备 33010602011771号