智能体安全—— intent detection in the age of llms 文章要点总结

Intent Detection in the Age of LLMs

该研究探讨了在任务导向对话系统 (TODS) 中使用大型语言模型(LLMs)进行意图检测的有效性。作者们比较了LLMs与传统的句子转换器模型(SetFit)在预测质量和延迟方面的表现,发现LLMs虽然准确度更高,但延迟也更高。为克服这一挑战,他们提出了一个混合系统,该系统根据SetFit模型的不确定性来决定是否将查询路由到LLM,从而在性能和成本之间取得平衡。此外,研究还深入分析了LLMs的域外(OOS)检测能力,并提出了一种两步法来提升其OOS检测的准确性。

意图检测中的LLM应用:关键点与算法

关键点 (Key Points)

-

意图检测的重要性与传统挑战

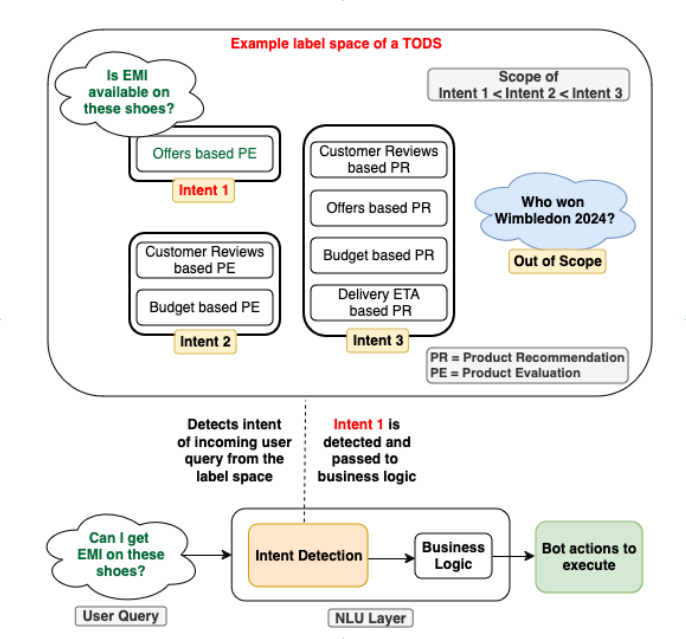

- 核心作用: 意图检测是任务型对话系统 (TODS) 的关键,用于识别用户话语的适当操作。预计到2026年,TODS自动化将节省数十亿美元的劳动力成本。

- 传统方法局限:

- 依赖计算效率高的监督式句子转换器编码模型。

- 需要大量训练数据。

- 难以处理超出范围 (Out-of-Scope, OOS) 的查询。OOS查询数量无限,且通常缺乏训练数据。

- 需处理不平衡的训练数据和少样本意图。

- 新应用: 在检索增强生成 (RAG) 中,意图检测也用于识别正确的知识源、API和工具。

-

LLM在意图检测中的潜力

- 大型语言模型 (LLMs),如ChatGPT、Claude、Mistral和Llama,凭借其固有的世界知识和少样本学习能力,为解决传统挑战提供了新机遇,并在多项NLP任务中表现出色。

-

LLM与传统方法的性能/延迟权衡

- 研究对比: 评估了7种SOTA LLM(来自Claude和Mistral家族)与经过微调的SetFit模型的性能和延迟。

- 性能:

- F1分数: Claude v2/v3和Mistral Large表现相似,其中Claude v3 Haiku在延迟方面更优。

- 速度: SetFit模型比最佳LLM(Claude v3 Haiku)快约56倍,但其预测性能低约8%。

- OOS检测弱点: LLM普遍存在OOS检测能力较弱的问题,所有模型在数据集上的OOS召回率都很低。

-

OOS检测能力分析的洞察

- 影响因素: LLM的OOS检测能力受意图标签的范围(类设计)和标签空间大小的显著影响。

- 发现:

- 更细粒度的标签和更小的标签空间有利于LLM的OOS检测。

- LLM的域内准确性相对不受意图范围变化的影响,但会随着标签空间大小的增加而下降。

- OOS检测的AUC-ROC下降比域内准确性下降更严重。

-

混合系统和新型OOS检测方法的效果

- 混合系统: 结合SetFit和LLM,可以在保持LLM原生精度2%以内的情况下,将延迟降低约50%。

- 两步OOS检测法: 利用LLM的内部表示,在不微调LLM的情况下,将Mistral-7B模型的OOS检测准确性和F1分数提高了超过5%。

算法与方法 (Algorithms & Methodologies)

本研究提出了多种利用LLM进行意图检测的方法,并与传统模型进行了对比:

-

传统基线:对比微调句子转换器 (SetFit)

- 方法:

- 对比微调: 在训练数据上,以对比、孪生的方式对句子转换器模型进行微调。

- 分类头训练: 使用第一步微调过的编码器为训练数据生成编码,并用这些编码训练一个文本分类头。

- 负面数据增强 (Negative Data Augmentation):

- 目的: 帮助SetFit学习更好的决策边界,避免捕捉虚假模式。

- 方式: 通过修改句子中的关键词来创建被视为OOS的负样本,修改方式包括:

- a) 删除关键词

- b) 将关键词替换为随机字符串

- 方法:

-

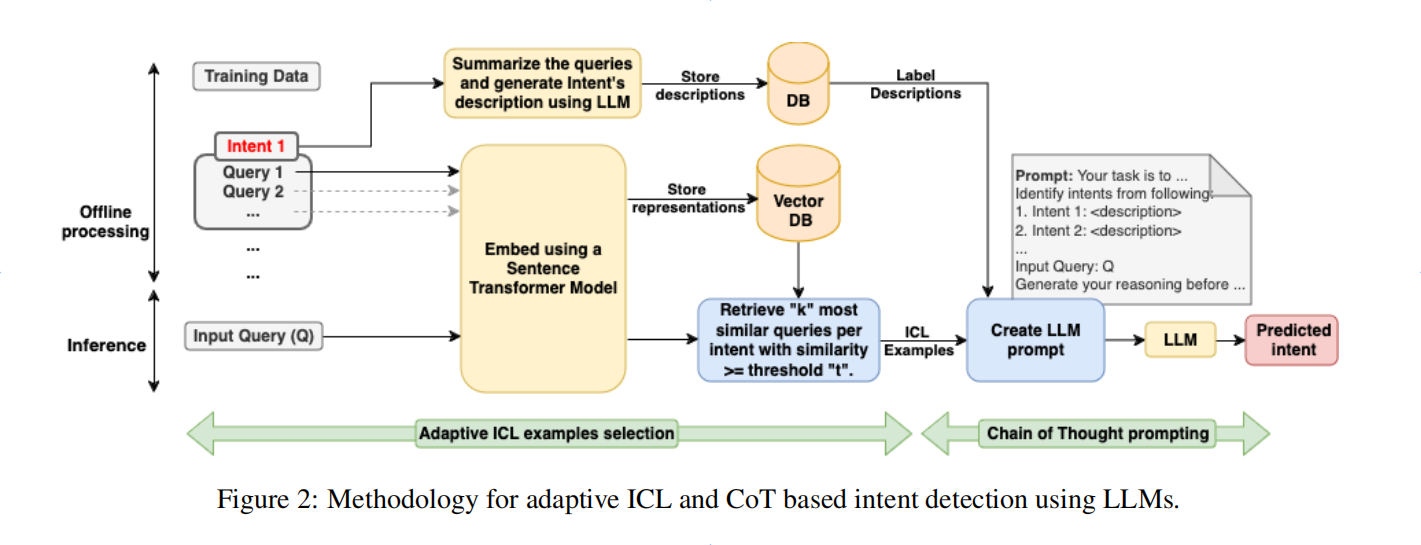

LLM意图检测方法:自适应上下文学习 (ICL) + 思维链 (CoT) 提示

![]()

- 离线处理:

- 使用句子转换器模型(如BGE)为所有训练样本生成嵌入向量并存入数据库。

- 使用LLM为每个意图生成描述并存储。

- 推理过程:

- 嵌入用户查询。

- 从数据库中检索Top-k个最相似的查询作为ICL示例。

- 结合检索到的ICL示例、意图描述和静态任务指令,构建最终的LLM提示。

- 离线处理:

-

混合意图检测系统:基于不确定性的查询路由

- 目的: 平衡LLM的高昂计算成本与高性能。

- 策略: 仅当SetFit模型对其预测不确定时,才将查询路由到LLM。

- 不确定性估计:

- 通过Monte Carlo (MC) dropout从SetFit模型中采样M个预测。

- 使用预测结果的方差作为不确定性的度量。

- 如果M个样本中的预测标签种类多于1个或少于M/2个,则认为预测是不确定的。

-

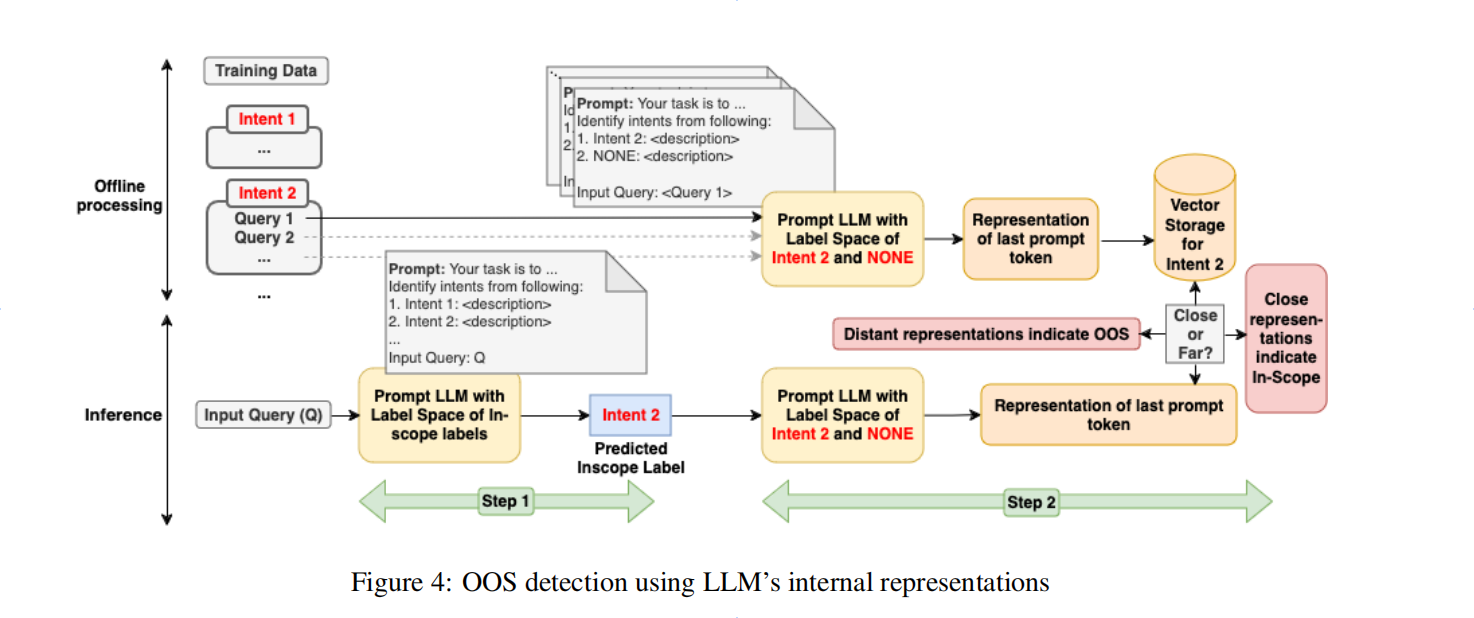

利用LLM内部表示的OOS检测两步法

![]()

- 动机: 在避免昂贵的LLM微调的前提下,解决其在OOS检测上的不足。

- 离线处理: 获取LLM解码器层最后一个提示token的表示,为训练数据中的每个句子生成表示并存储。

- 推理过程:

- 步骤一 (域内预测): 首先,提示LLM仅在域内标签中进行预测,完全不考虑OOS标签,以减小标签空间。

- 步骤二 (相似度比较):

- 基于步骤一的预测结果,使用LLM的解码器层为传入查询生成表示。

- 将该查询表示与步骤一预测的意图类别下的所有训练实例表示进行余弦相似度比较。

- 取所有相似度分数的平均值作为最终判断依据。

- 优势: 仅需一次前向传播即可完成编码,计算开销远低于自回归生成,因此延迟低。此方法适用于未经微调的基础LLM,实用性更强。

浙公网安备 33010602011771号

浙公网安备 33010602011771号