Adaptive Learning Rate(自适应学习率)

Adaptive Learning Rate(自适应学习率)

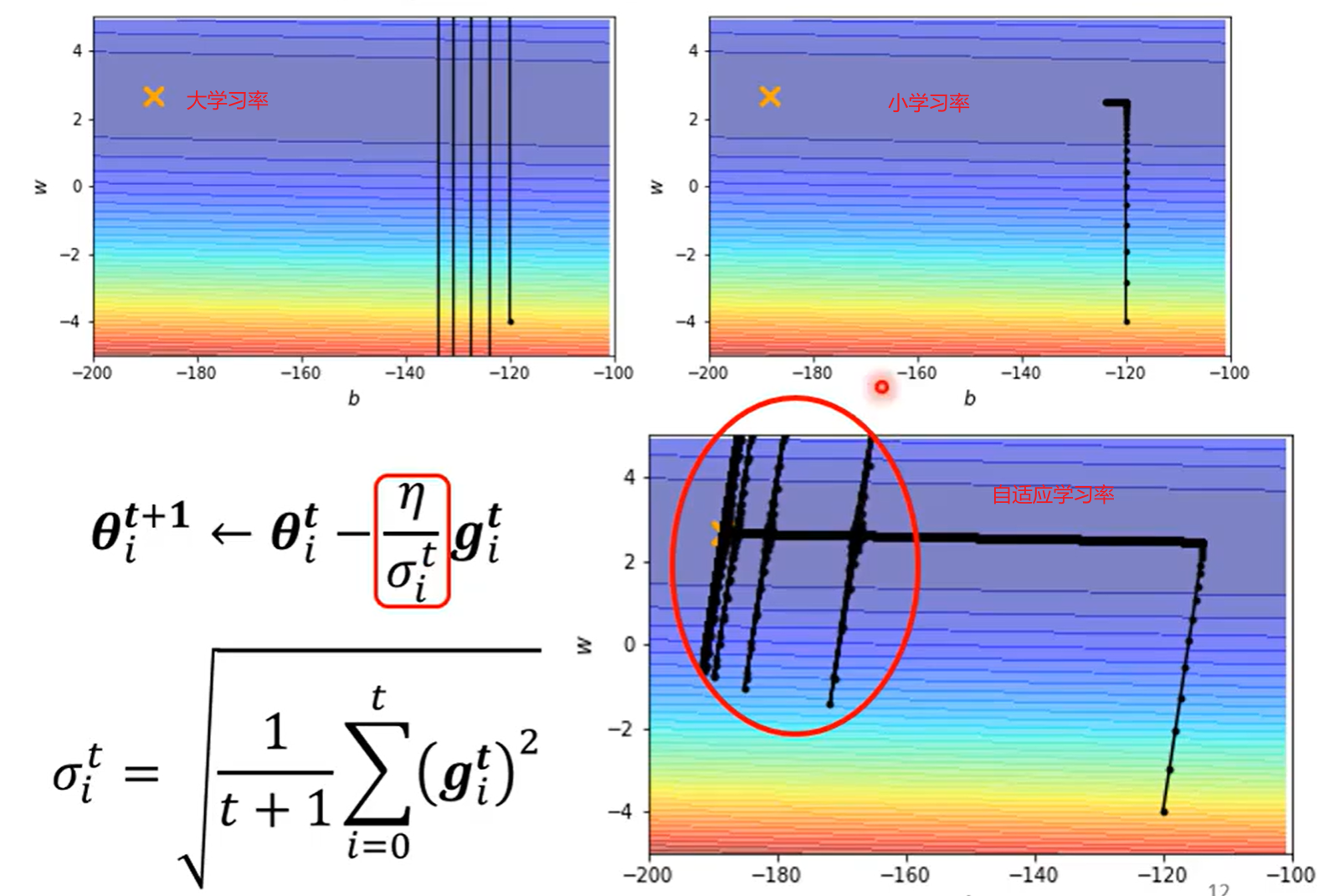

Adaptive Learning Rate(自适应学习率) 是指在模型训练过程中,学习率会根据参数更新的反馈自动调整,而不是使用一个固定值。其核心思想是:

👉 不同参数或不同训练阶段,最优的学习率应该不同。

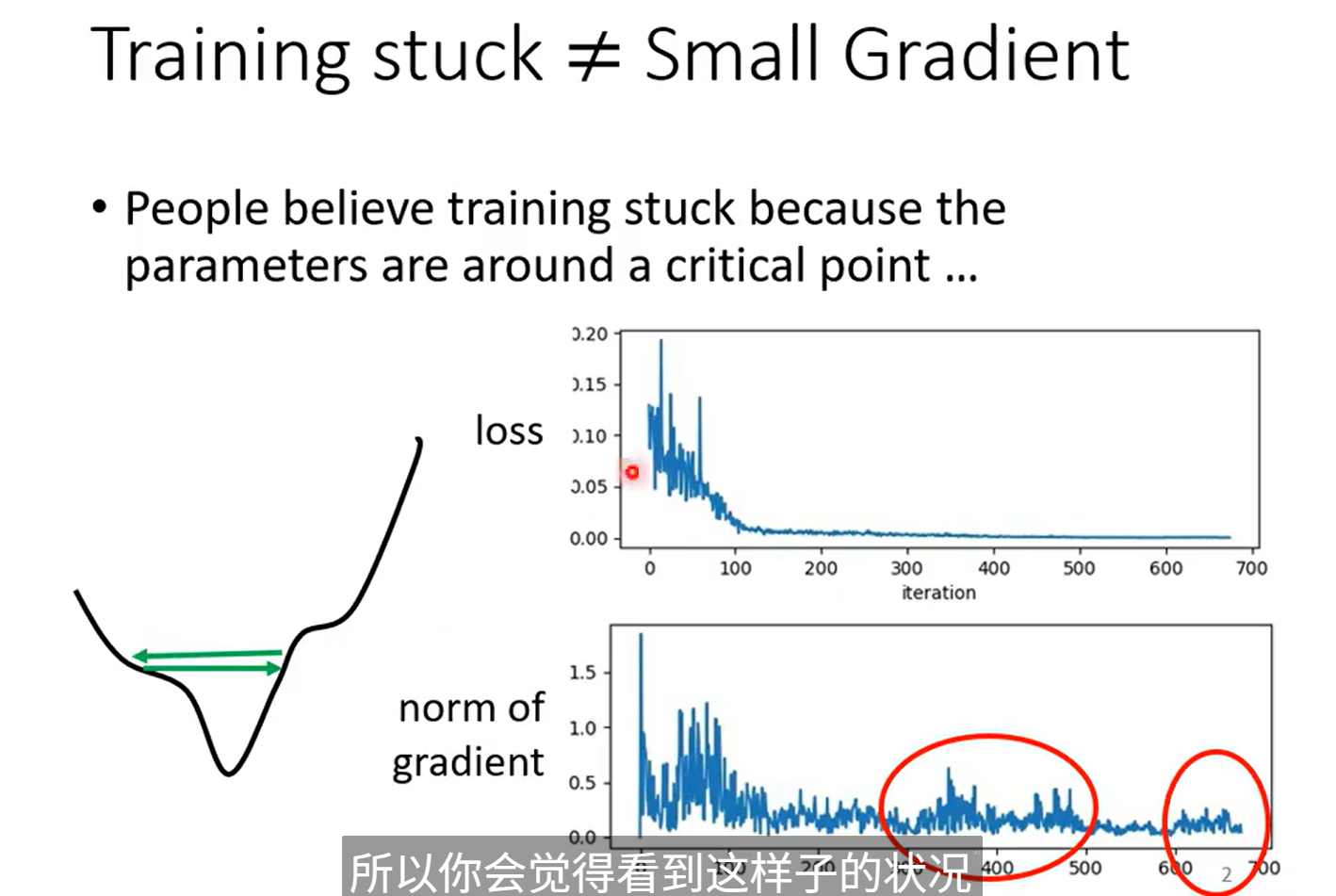

当 Loss 不在下降,Gradient 不一定是 0

而是梯度太大,在最低的 Loss 中徘徊

不同的参数需要不同的学习速率

different parameters needs different learning rate

在深度学习中,模型的各层参数承担的角色不同,它们的梯度分布、敏感度、训练目标往往不一样。

如果所有参数都用同一个学习率,会导致:

- 有的参数更新太快,导致训练不稳定;

- 有的参数更新太慢,导致收敛变慢甚至停滞。

因此,针对不同参数设定不同学习率,可以让模型收敛更平稳、更快。

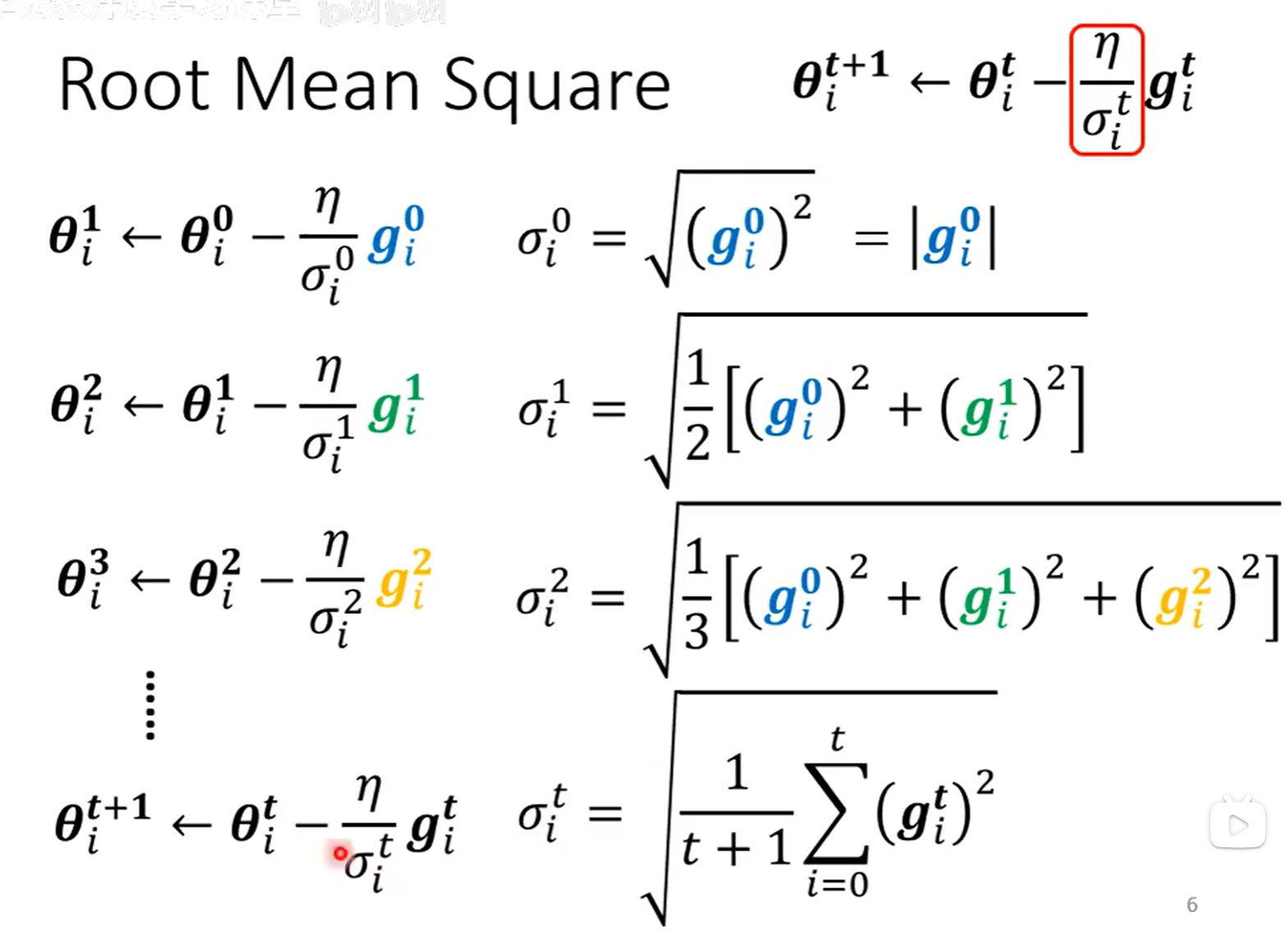

Root Mean Square

i 是第 i 个参数,上角标是第几次更新

平方和相加取平均在开根号

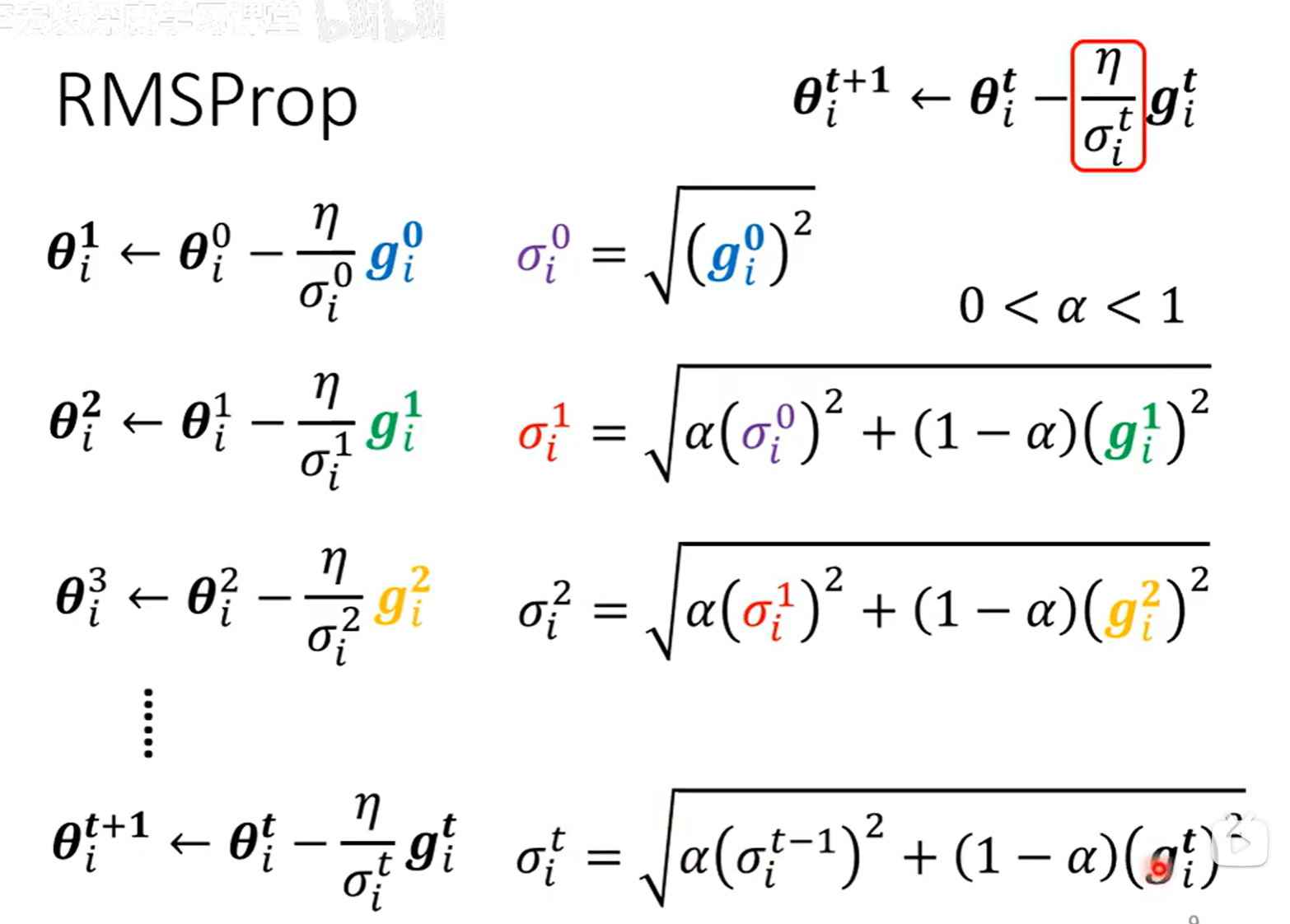

RMSProp

加上一个参数控制权重

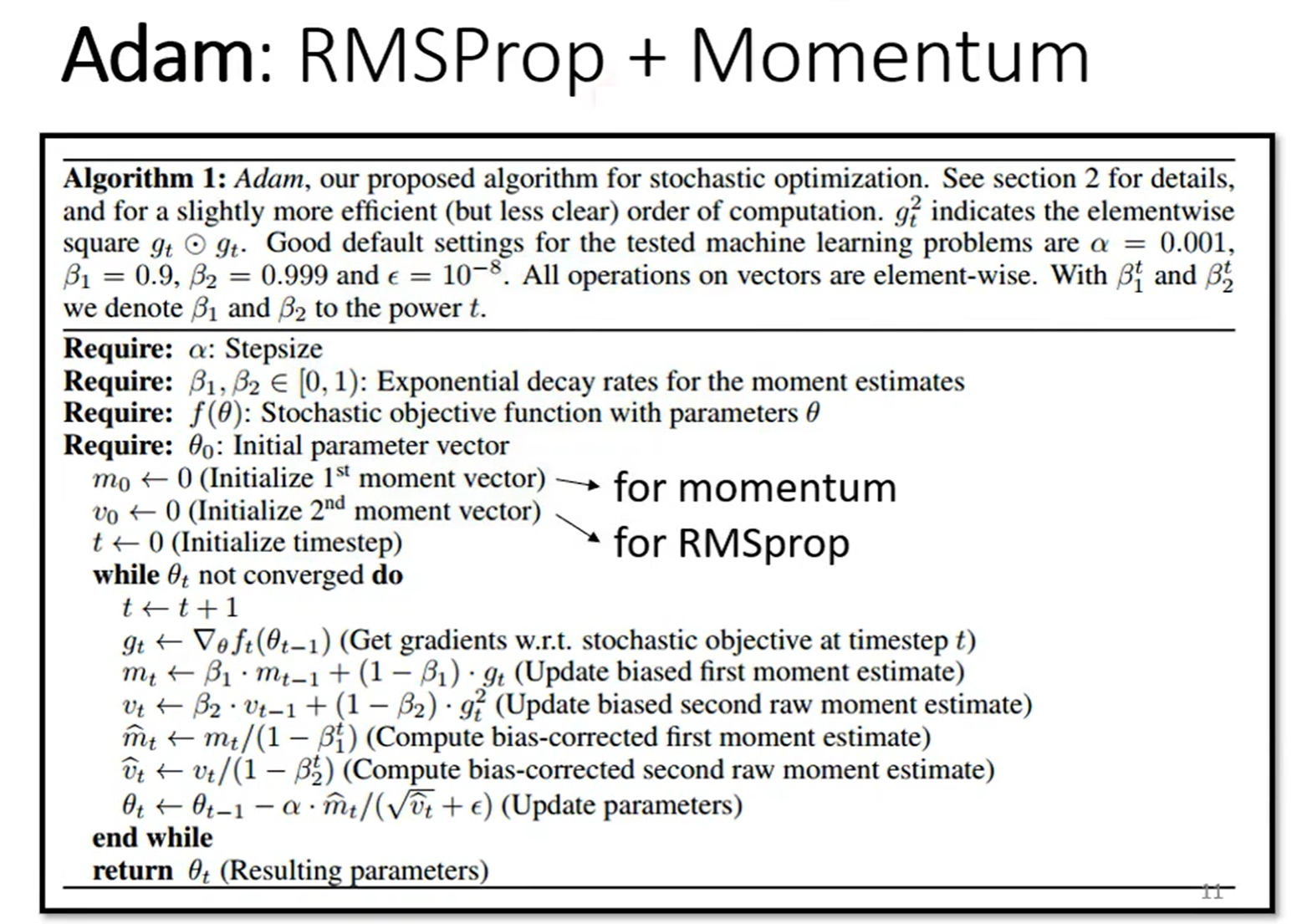

目前常用的

横向累计了很多,当累计到一定程度的时候,就暴走了产生纵向的

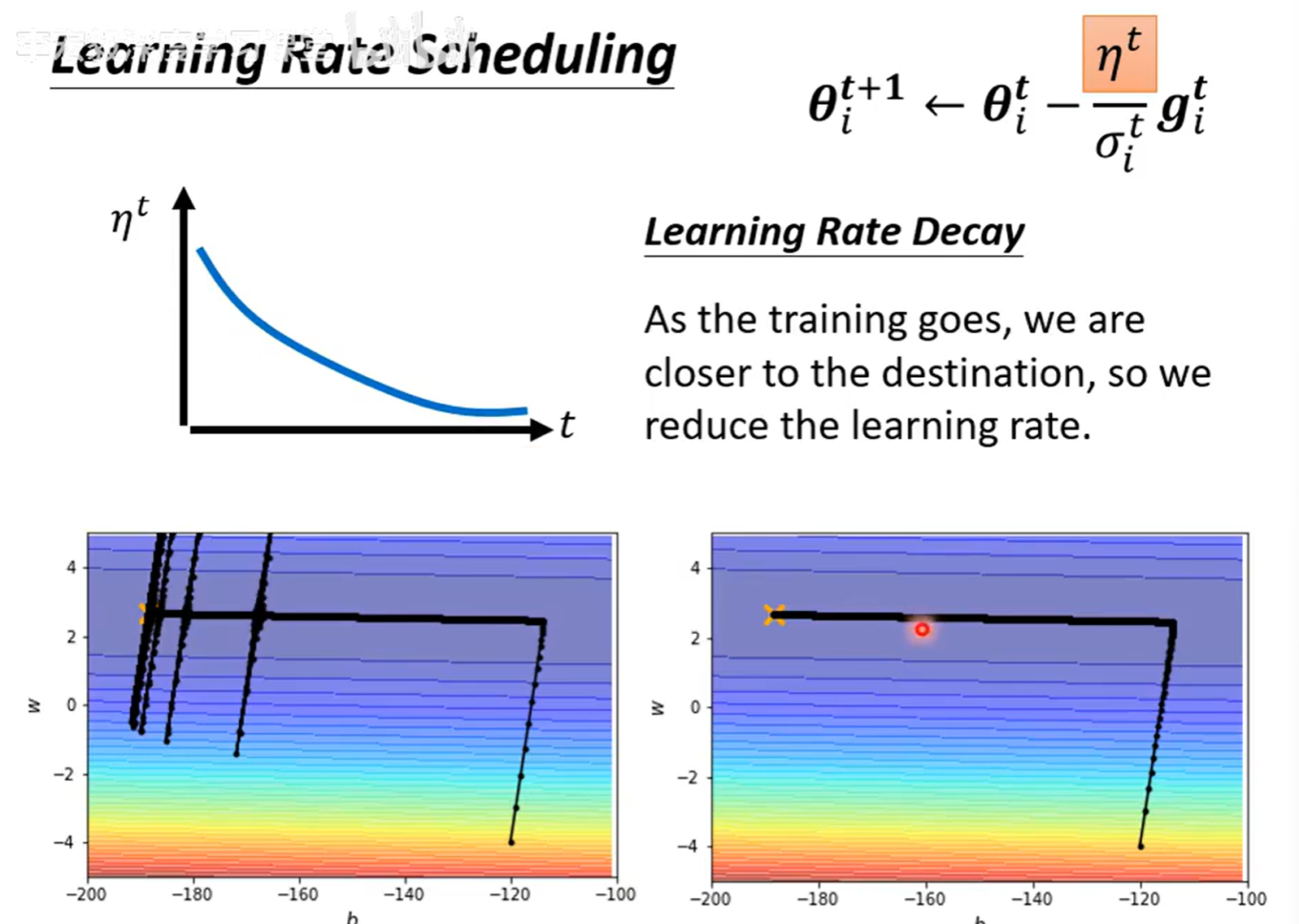

解决上面的办法:加入 \(n^t\),随着时间 \(n^t\) 逐渐变小,学习率变小

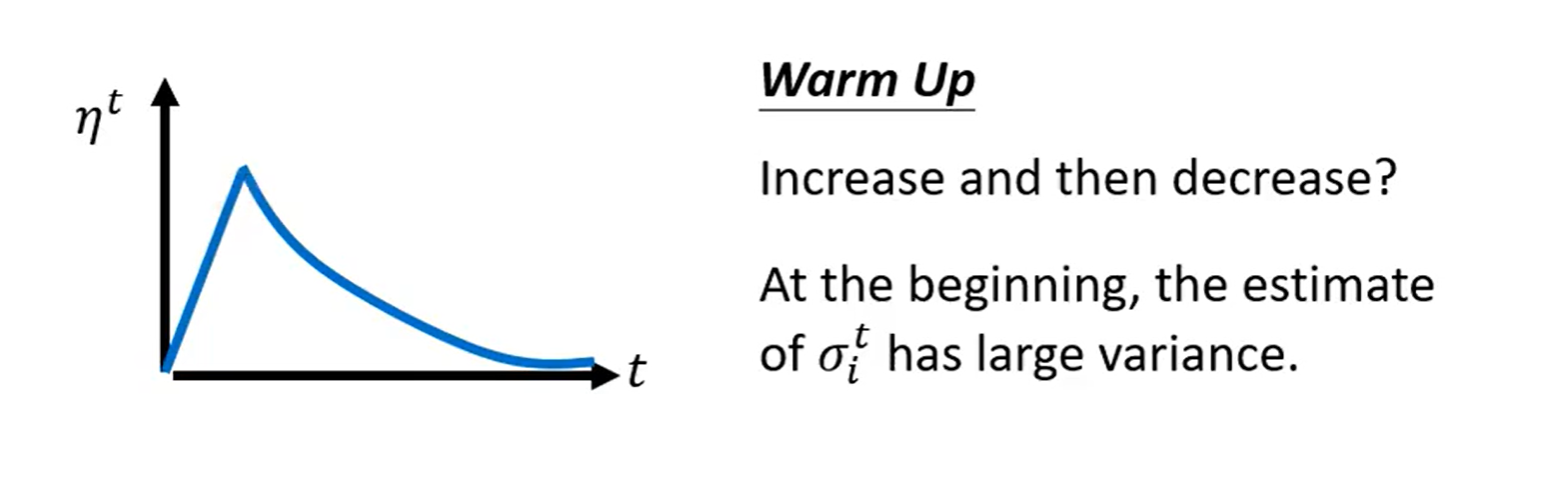

Warm Up

黑科技(目前没有权威解释):先增加,再减小

其中一个解释:先开始很小探索周围,逐渐扩大,然后再慢慢变小收到 Loss 低点

浙公网安备 33010602011771号

浙公网安备 33010602011771号