Multi-armed Bandits

区分强化学习与其他类型学习的最重要特征是它使用训练信息来评估所采取的行动而不是通过给予正确的行动进行指导。

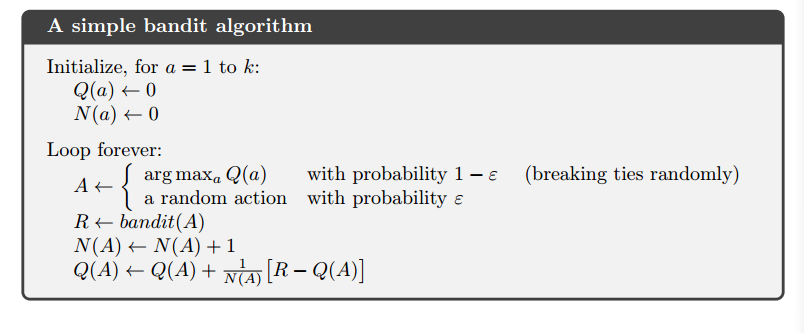

2.4 Incremental Implementaion

\(Q_n=\frac{R_1+R_2+...+R_{n-1} } {n-1}\)

\(Q_{n+1}=\frac{R_1+R_2+...+R_{n} } {n}\)=\(\frac{1}{n}\sum_{i=1}^n R_i=Q_n+\frac{1}{n}[R_n-Q_n ]\)

2.5 Tracking a Nonstationary Problem

我们会经常遇到非常不稳定的强化学习问题。在这种情况下,给与最近的奖励比给长期过去的奖励更重要。最常用的方法之一是使用常量步长参数,如

\(Q_{n+1}=Q_n+a[R_n-Q_n]\)

\(\sum_{n=1}^\infty a_n(a)=\infty\) and

\(\sum_{n=1}^\infty a_n^2(a)<\infty\)

其中\(a_n(a)\)是步长参数。

第一个条件来保证步骤足够大以最终克服任何初始条件或随机波动。第二个条件保证最终步骤变得足够小以确保收敛。

显然,\(a_n(a)=\frac{1}{n}\)满足该这两个条件,而\(a_n(a)=a\)不满足第二个条件,表明估计值从未完全收敛,但是响应与最近收到的奖励而继续变化,实际上这在非平稳环境中是我们想要的,

2.7 Upper-Confidence-Bound Action Selection

ε-主动行动选择迫使不贪婪的行动被审判,但不分青红皂白,不偏袒那些几乎贪婪或特别不确定的行为。最好根据它们实际上最优的潜力来选择非贪婪行动,同时考虑到它们的估计与最大值的接近程度以及这些估计中的不确定性。用公式表达为:

$A_t = argmax_a \([\)Q_t(a)+c\sqrt{\frac{Int}{N_t(a)}}$]

上置信界(UCB)行动选择的概念是,平方根项是对a值估计的不确定性或方差的度量。

虽然UCB表现良好,但相比$ \varepsilon $,其很难扩展到其他情况,一方面是处理非平稳问题,另一方面是处理大的状态空间。

浙公网安备 33010602011771号

浙公网安备 33010602011771号