03Linux与Hadoop操作实验

(一)熟悉常用的Linux操作

请按要求上机实践如下linux基本命令。

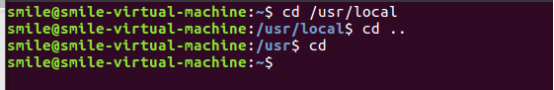

cd命令:切换目录

(1)切换到目录 /usr/local

(2)去到目前的上层目录

(3)回到自己的主文件夹

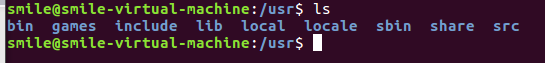

ls命令:查看文件与目录

(4)查看目录/usr下所有的文件

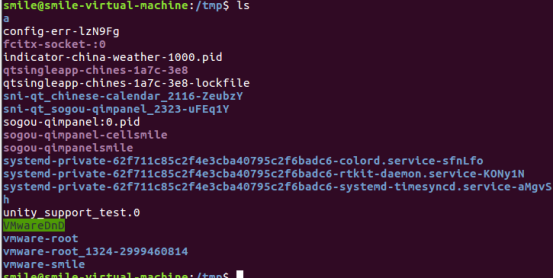

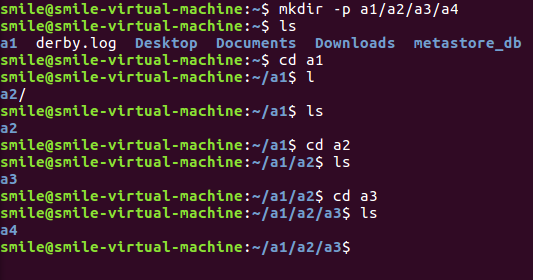

mkdir命令:新建新目录

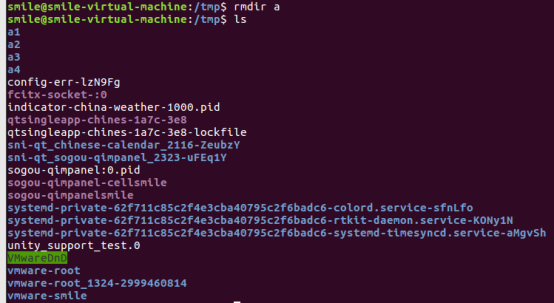

(5)进入/tmp目录,创建一个名为a的目录,并查看有多少目录存在

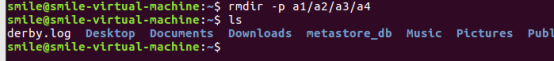

(6)创建目录a1/a2/a3/a4

rmdir命令:删除空的目录

(7)将上例创建的目录a(/tmp下面)删除

(8)删除目录a1/a2/a3/a4,查看有多少目录存在

cp命令:复制文件或目录

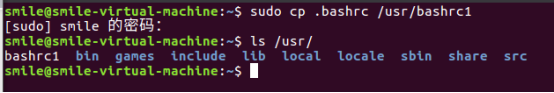

(9)将主文件夹下的.bashrc复制到/usr下,命名为bashrc1

(10)在/tmp下新建目录test,再复制这个目录内容到/usr

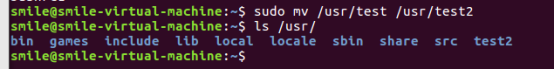

mv命令:移动文件与目录,或更名

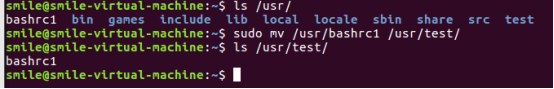

(11)将上例文件bashrc1移动到目录/usr/test

(12)将上例test目录重命名为test2

rm命令:移除文件或目录

(13)将上例复制的bashrc1文件删除

(14)将上例的test2目录删除

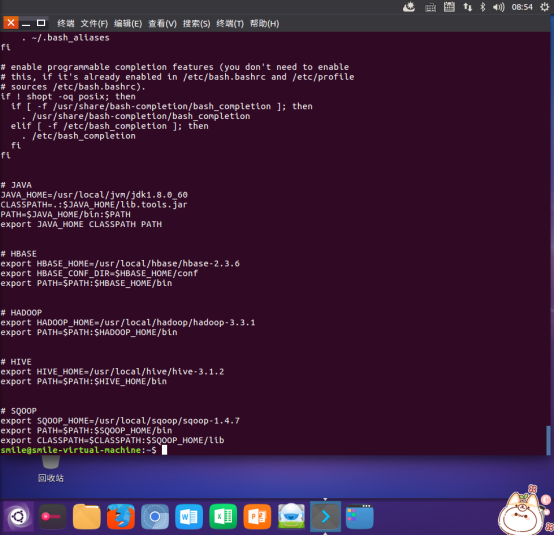

cat命令:查看文件内容

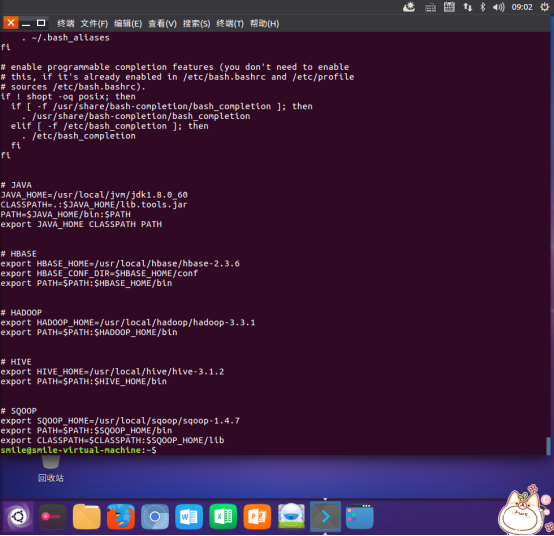

(15)查看主文件夹下的.bashrc文件内容

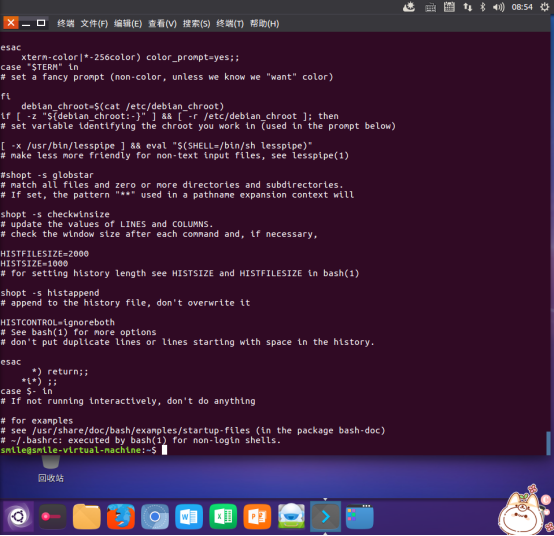

tac命令:反向列示

(16)反向查看主文件夹下.bashrc文件内容

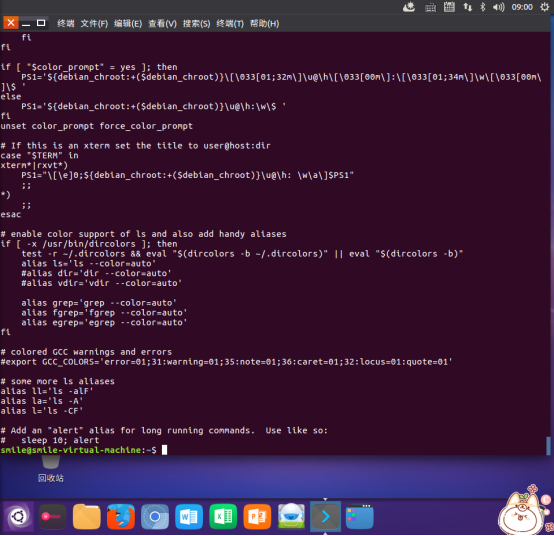

more命令:一页一页翻动查看

(17)翻页查看主文件夹下.bashrc文件内容

head命令:取出前面几行

(18)查看主文件夹下.bashrc文件内容前20行

(19)查看主文件夹下.bashrc文件内容,后面50行不显示,只显示前面几行

tail命令:取出后面几行

(20)查看主文件夹下.bashrc文件内容最后20行

(21)查看主文件夹下.bashrc文件内容,只列出50行以后的数据

chown命令:修改文件所有者权限

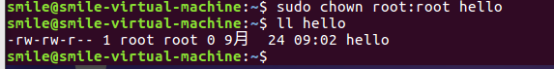

(22)将hello文件所有者改为root帐号,并查看属性

Vim/gedit/文本编辑器:新建文件

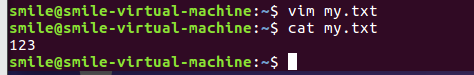

(23)在主文件夹下创建文本文件my.txt,输入文本保存退出。

tar命令:压缩命令

(24)将my.txt打包成test.tar.gz

(25)解压缩到~/tmp目录

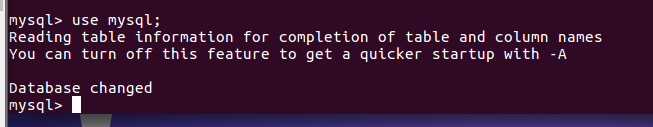

(二)熟悉使用MySQL shell操作

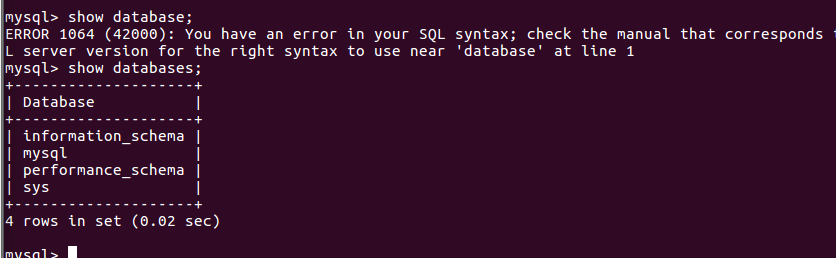

(26)显示库:show databases;

(27)进入到库:use 库名;

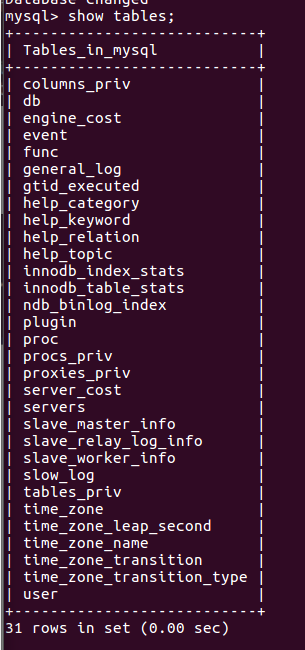

(28)展示库里表格:show tables;

(29)显示某一个表格属性:desc 表格名;

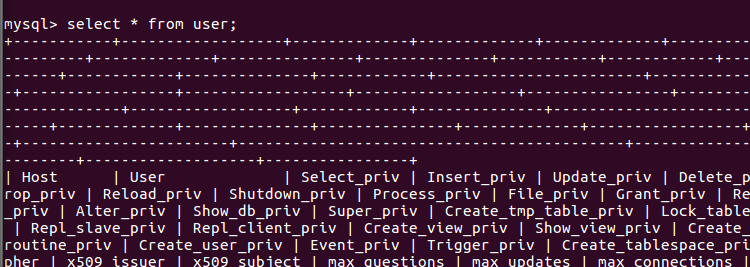

(30)显示某一个表格内的具体内容:select *form 表格名;、

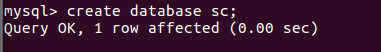

(31)创建一个数据库:create databases sc;

(32)在sc中创建一个表格:create table if not exists student( );

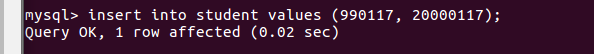

(33)向表格student中插入具体内容:insert into 表格名(名)values(value);

插入记录包含自己的学号

(33)显示表的内容。

(三) Hadoop历史

1.Hadoop的起源

2003-2004年,Google公布了部分GFS和MapReduce思想的细节,受此启发的Doug Cutting等人用2年的业余时间实现了DFS和MapReduce机制,使Nutch性能飙升。然后Yahoo招安Doug Gutting及其项目。

2005年,Hadoop作为Lucene的子项目Nutch的一部分正式引入Apache基金会。

2006年2月被分离出来,成为一套完整独立的软件,起名为Hadoop

Hadoop名字不是一个缩写,而是一个生造出来的词。是Hadoop之父Doug Cutting儿子毛绒玩具象命名的。

Hadoop的成长过程

Lucene–>Nutch—>Hadoop

总结起来,Hadoop起源于Google的三大论文

GFS:Google的分布式文件系统Google File System

MapReduce:Google的MapReduce开源分布式并行计算框架

BigTable:一个大型的分布式数据库

演变关系

GFS—->HDFS

Google MapReduce—->Hadoop MapReduce

BigTable—->HBase

2.Hadoop发展历程

目前,Hadoop已经正式成为Apache顶级开源项目,俨然已经成为大数据处理技术的核心地位。下面我们回顾一下近10年来Hadoop的主要发展历程。

· 2008年1月,Hadoop成为Apache顶级项目。

· 2008年6月,Hadoop的第一个SQL框架——Hive成为了Hadoop的子项目。

· 2009年7月 ,MapReduce 和 Hadoop Distributed File System (HDFS) 成为Hadoop项目的独立子项目。

· 2009年7月 ,Avro 和 Chukwa 成为Hadoop新的子项目。

· 2010年5月 ,Avro脱离Hadoop项目,成为Apache顶级项目。

· 2010年5月 ,HBase脱离Hadoop项目,成为Apache顶级项目。

· 2010年9月,Hive脱离Hadoop,成为Apache顶级项目。

· 2010年9月,Pig脱离Hadoop,成为Apache顶级项目。

· 2010年-2011年,扩大的Hadoop社区忙于建立大量的新组件(Crunch,Sqoop,Flume,Oozie等)来扩展Hadoop的使用场景和可用性。

· 2011年1月,ZooKeeper 脱离Hadoop,成为Apache顶级项目。

· 2011年12月,Hadoop1.0.0版本发布,标志着Hadoop已经初具生产规模。

· 2012年5月,Hadoop 2.0.0-alpha版本发布,这是Hadoop-2.x系列中第一个(alpha)版本。与之前的Hadoop-1.x系列相比,Hadoop-2.x版本中加入了YARN,YARN成为了Hadoop的子项目。

· 2012年10月,Impala加入Hadoop生态圈。

· 2013年10月,Hadoop2.0.0版本发布,标志着Hadoop正式进入MapReduce v2.0时代。

· 2014年2月,Spark开始代替MapReduce成为Hadoop的默认执行引擎,并成为Apache顶级项目。

· 2017年12月,继Hadoop3.0.0的四个Alpha版本和一个Beta版本后,第一个可用的Hadoop 3.0.0版本发布。

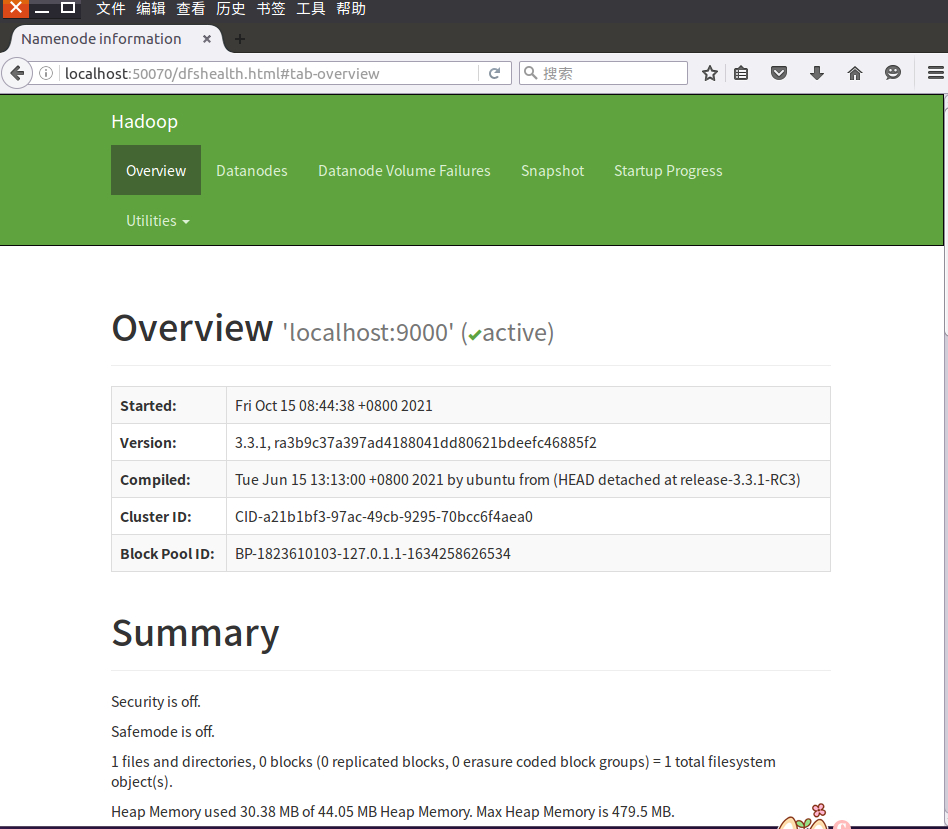

(四) Hadoop操作

1.对比Windous,Linux,Hadoop文件系统

Windows:

Linux:

Hadoop:

web:

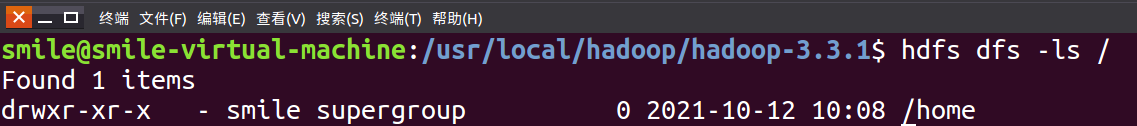

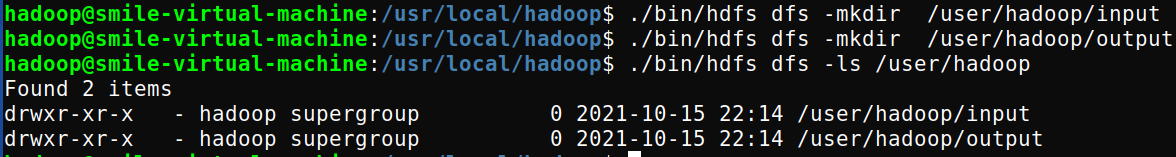

查看与创建hadoop用户目录

在用户目录下创建与查看input目录

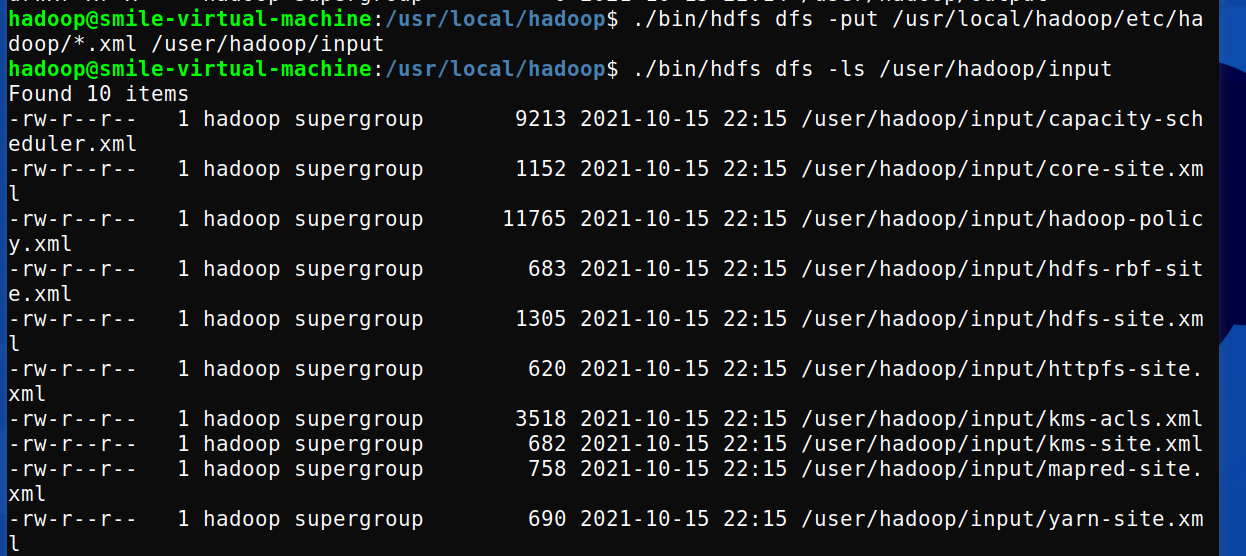

将hadoop的配置文件上传到hdfs上的input目录下

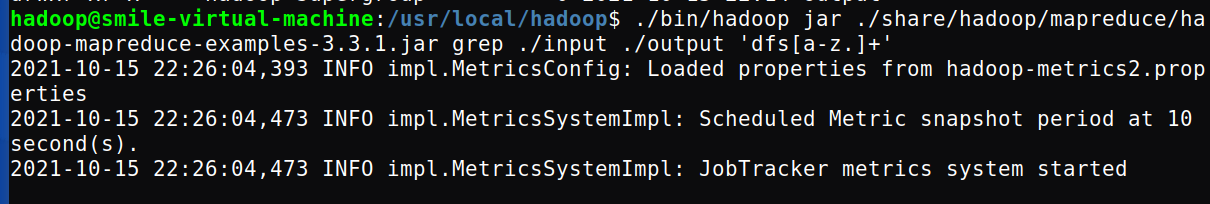

运行MapReduce示例作业,输出结果放在output目录下

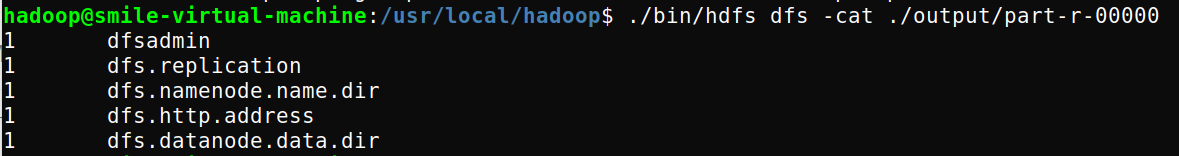

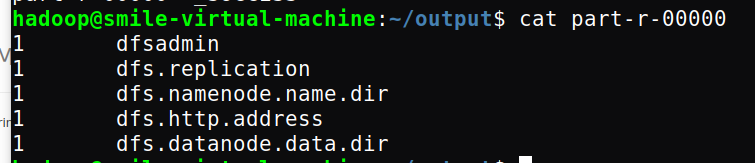

查看输出结果

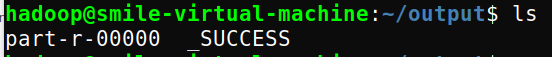

将输出结果文件下载到本地

查看下载的本地文件

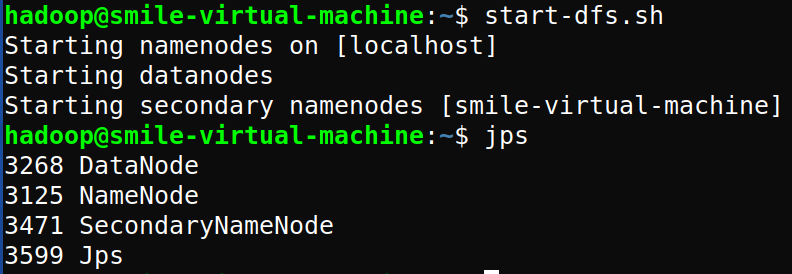

设置Hadoop环境变量,在本地用户主目录下启动hdfs,查看hdfs用户主目录,停止hdfs。

浙公网安备 33010602011771号

浙公网安备 33010602011771号