这是个人记录的视频编码方向初步了解的知识

编码框架

帧内预测:

对于一幅图像,相邻的两个的亮度和色度值之间经常是比较接近的,也就是颜色是逐渐变化的,不会一下子突变成完全不一样的颜色。而进行视频编码,目的就是利用这个相关性,来进行压缩。帧内预测是利用视频空间域的相关性,使用同一帧图像内邻近已编码像素预测当前的像素,以达到有效去除视频时域冗余的目的。

存储一个像素的亮度值可能需要8个bit,但是如果相邻的两个像素变化不大,我存储一个像素的原始值,以及第二个像素相对第一个像素的变化值,那么第二个值我可能用2个bit就够了,这就节约了很多的空间。而节约存储消耗的bit数,也就是节约码率

帧间预测:

是利用视频时间域的相关性,使用邻近已编码图像像素预测当前图像的像素,以达到有效去除视频时域冗余的目的。目前主要采用基于块的运动补偿技术,原理是为当前图像的每个像素块在之前已编码图像中寻找一个最佳匹配块,即运动估计。用于预测的图像称为参考图像,参考块到当前像素块的位移称为运动矢量(MV),当前块与参考块的差值称为预测残差。

变换量化:

1、什么是变换编码:绝大部分的图形都含有较多的平坦区域内容或者称为内容变化缓慢的区域,变换可以使得图像能量在空间域的分散分布转换为变换域中相对集中的分布。变换的结果为一组变换系数,变换后进行编码的对象也是得到的这样一组变换系数,由于人对图像的高频信息不敏感,因此在对变换系数进行量化的时候,就可以丢弃这些高频分量,达到减小传输码流,压缩视频的效果。但这些高频信息的丢弃并不会对重构的图像产生很大的影响(注意在对变换系数进行量化的时候会用到一个量化表,量化表的作用是进一步减小码流)。

2、什么是量化:量化就是幅值连续的信号取值通过量化表映射成有限个离散幅值的过程,基本的原理就是信号幅度取值多对一的一种映射过程。在上面学习的变换过程之后,得到的是一组变换系数,而变化变换系数的取值范围很大,通过量化过程,可以减小信号的取值范围,从而获得更好的压缩效果。同样值得一提的是,在视频或者图像压缩中造成失真的根本原因是由于量化的存在,但只要这种失真对于传输内容的正确理解影响不大,就可以忽略。

去方块滤波:

大的量化步长会造成相对较大的量化误差,这就可能将原来相邻块“接壤”处间灰度的连续化变成了“台阶”变化,主观上就有”伪边缘”的方块效应。去方块效应的方法就是在保持图像总能量不变的条件下,把这些台阶状的阶跃灰度变化重新复原成台阶很小或者近似连续的灰度变化,同时还必须尽量减少对真实图像边缘的损伤。

样点自适应补偿:

在图像中值剧烈变化的边界区,经过编码-解码重建之后通常会出现波纹状的失真现象,这种失真称作振铃效应。振铃效应产生的根本原因在于边界区高频分量在编码过程中丢失。为了减少高频分量的损失,同时不降低编码的效率,HEVC引入了SAO技术,从像素域入手对振铃区域进行补偿。SAO首先利用将样点分类,然后根据类别对样点值加上一个偏移值。样点的类别下标以及偏移值会被编码到码流中。

熵编码:

信源熵是编码这个信源平均所需要的最小位数。

素材,编码,封装格式

编码

-

H.264/AVC/MPEG-4 Part 10:H.264又称为MPEG-4第10部分,到2014年,它已经成为高精度视频录制、压缩和发布的最常用格式之一。H.264/AVC**项目的目的是为了创建一个更佳的视频压缩标准,在更低的比特率的情况下依然能够提供良好视频质量的标准。

-

H.265/HEVC/MPEG-H Part 2:H.265围绕着现有的视频编码标准H.264,保留原来的某些技术,同时对一些相关的技术加以改进。新技术使用先进的技术用以改善码流、编码质量、延时和算法复杂度之间的关系,达到最优化设置。具体的研究内容包括:提高压缩效率、提高鲁棒性和错误恢复能力、减少实时的时延、减少信道获取时间和随机接入时延、降低复杂度等。H.264由于算法优化,可以低于1Mbps的速度实现标清数字图像传送;H.265则可以实现利用1~2Mbps的传输速度传送720P(分辨率1280*720)普通高清音视频传送。HEVC在同等视频质量下的压缩率比AVC提高25~50%。

-

AV1:支持H.266/VVC的软件则预计会在2020 年秋季推出,所以无论软解还是硬解都仍需要等待一段时间。暂时的「代替品」就是AOMedia Video 1(简称AV1)编码,提供到比H.265/HEVC 高30%效能

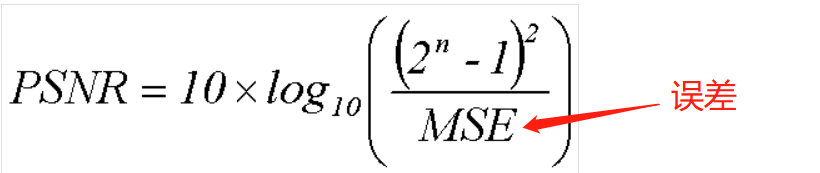

为了衡量经过处理后的影像品质,我们通常会参考PSNR值来衡量某个处理程序能否令人满意。它是原图像与被处理图像之间的相对于(2^n-1)^2的对数值(信号最大值的平方,n是每个采样值的比特数),它的单位是dB。

MSE是原图像(语音)与处理图像(语音)之间均方误差。误差越小,PSNR越大,效果越好

-

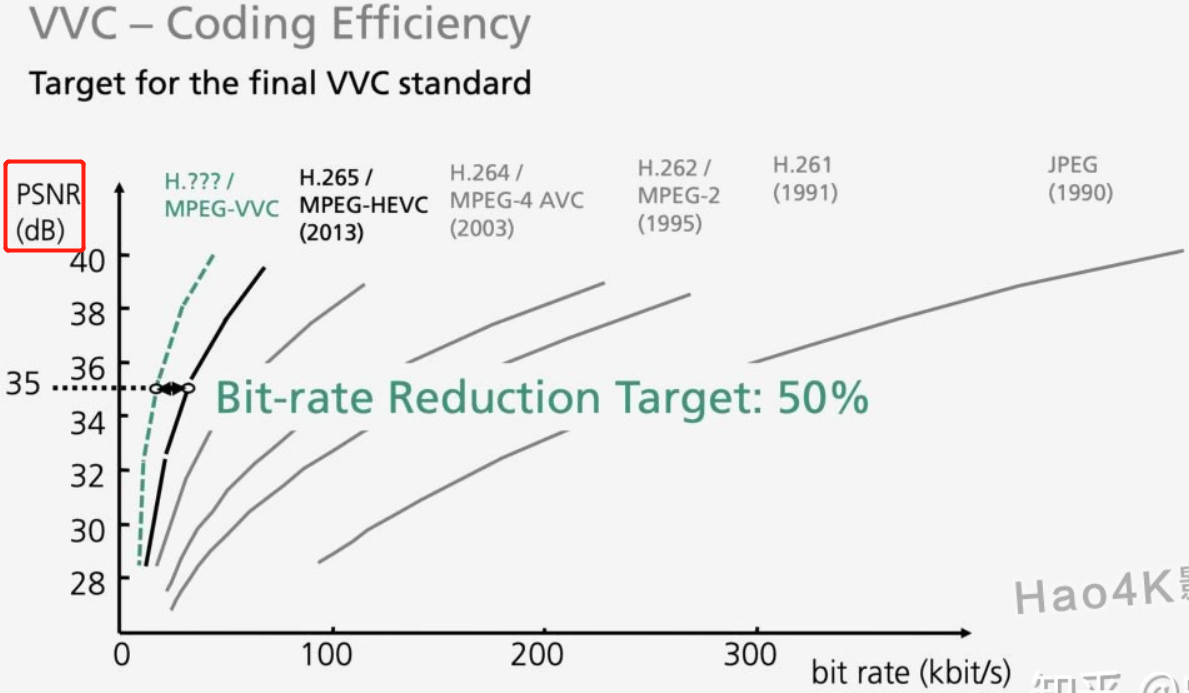

H.266/VVC 比H.265节省30%至50%容量

-

AVS3:AVS ,即 Audio Video coding Standard ,音视频编码标准,由我国的数字音视频编解码技术标准,工作组负责开发制定。工作组制定的 AVS1 、 AVS2两代编码,已分别于 2006 年和 2016 年被颁布为国家标准。目前 AVS 标准广泛应用于我国的广播电视领域,正在进军互联网视频领域和监控领域。相较于 AVS2,AVS3 在保留部分编码工具的同时,针对不同模块引入了一些新的编码工具,并采用了更灵活的块划分结构、更精细的预测模式、更具适应性的变换核,实现了相较于 AVS2约 30% 的码率节省,显著提升了编码效率。

封装格式

-

Matroska是一种多媒体封装格式,这个封装格式可把多种不同编码的视频及16条或以上不同格式的音频和语言不同的字幕封装到一个Matroska Media档内。它也是其中一种开放源代码的多媒体封装格式。很多人把Matroska当作为mkv,其实mkv只是Matroska媒体系列的其中一种文件格式。

-

MP4全称MPEG-4 Part 14,是一种使用MPEG-4的多媒体电脑文件格式,扩展名为.mp4,以存储数字音频及数字视频为主。MP4至今仍是各大影音分享网站所使用主流,即使他们是在网站上多加一层Flash的影音播放接口。因为MP4可以在每分钟约4MB的压缩缩率下提供接近DVD质量的影音效果。MP4优点是压缩质量优、转换容易,目前智能手机的录像,大多都是MP4格式。

-

AVI是英语Audio Video Interleave(“音频视频交织”或译为“音频视频交错”)的首字母缩写,由微软在1992年11月推出的一种多媒体文件格式,用于对抗苹果Quicktime的技术。现在所说的AVI多是指一种封装格式。尽管AVI已经属于老旧的技术,但是由于Windows的通用性,和简单易懂的开发API,仍被广泛使用。 AVI将视频和音频封装在一个文件里,其顺序是:若干视频帧之后接着若干音频帧,再然后是视频帧、音频帧,故名为“音频视频交织”,意即音频和视频按帧交错排列,以此达到音频同步于视频播放的效果。

-

MKV:多功能餐盘,把不同的音轨字幕都封装到一起,可以选择观看

![image-20220317143906574]()

浙公网安备 33010602011771号

浙公网安备 33010602011771号