梯度的前反向传播

梯度的前反向传播

参考

给出此节参考:

A

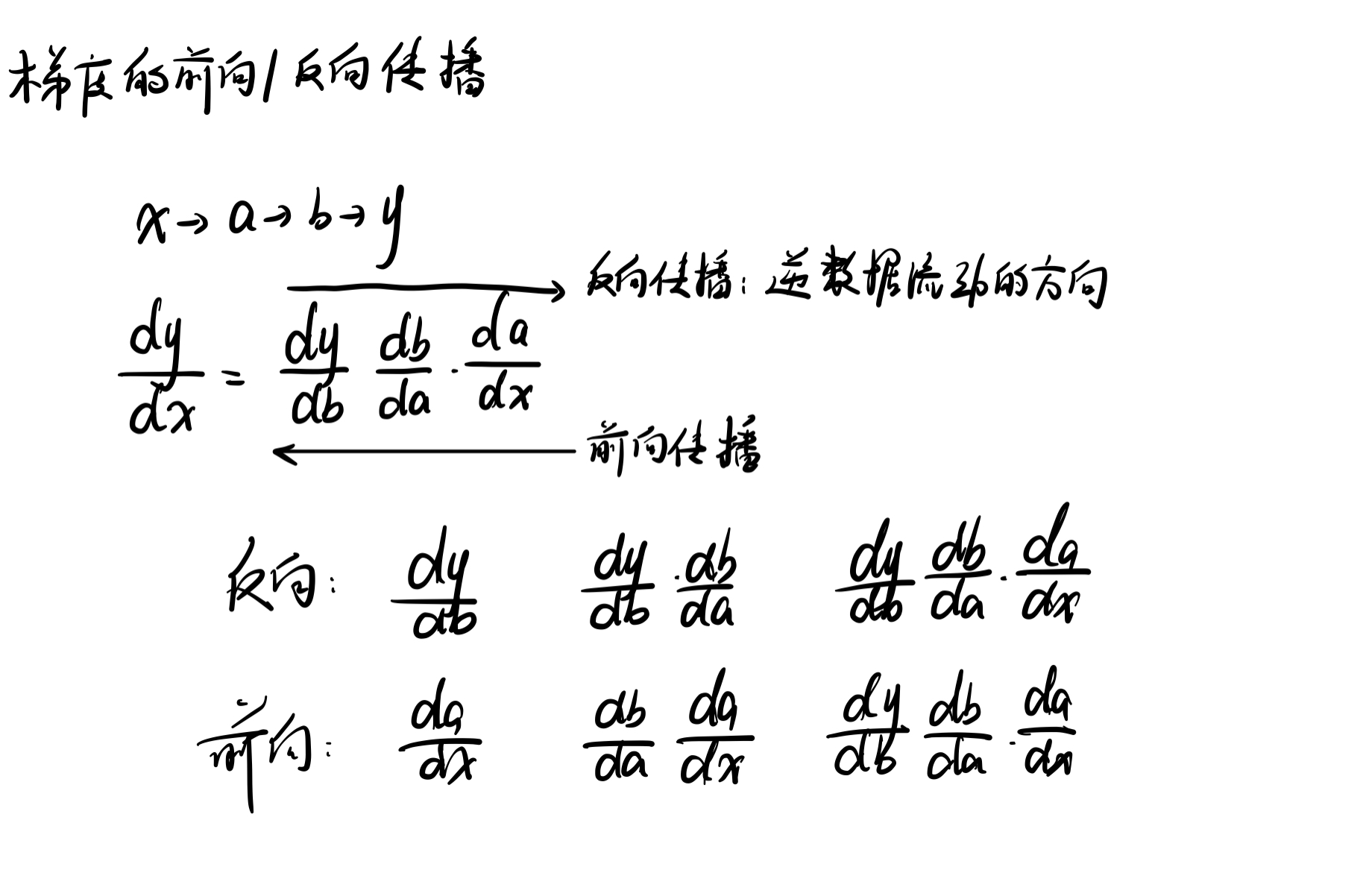

梯度计算有两种方向,一个是梯度的前向传播,一个是梯度的反向传播;

A.1

一般来说在DL中使用反向传播更加好,我自己认为主要有两个原因,可能角度比较局限,请批判吸收

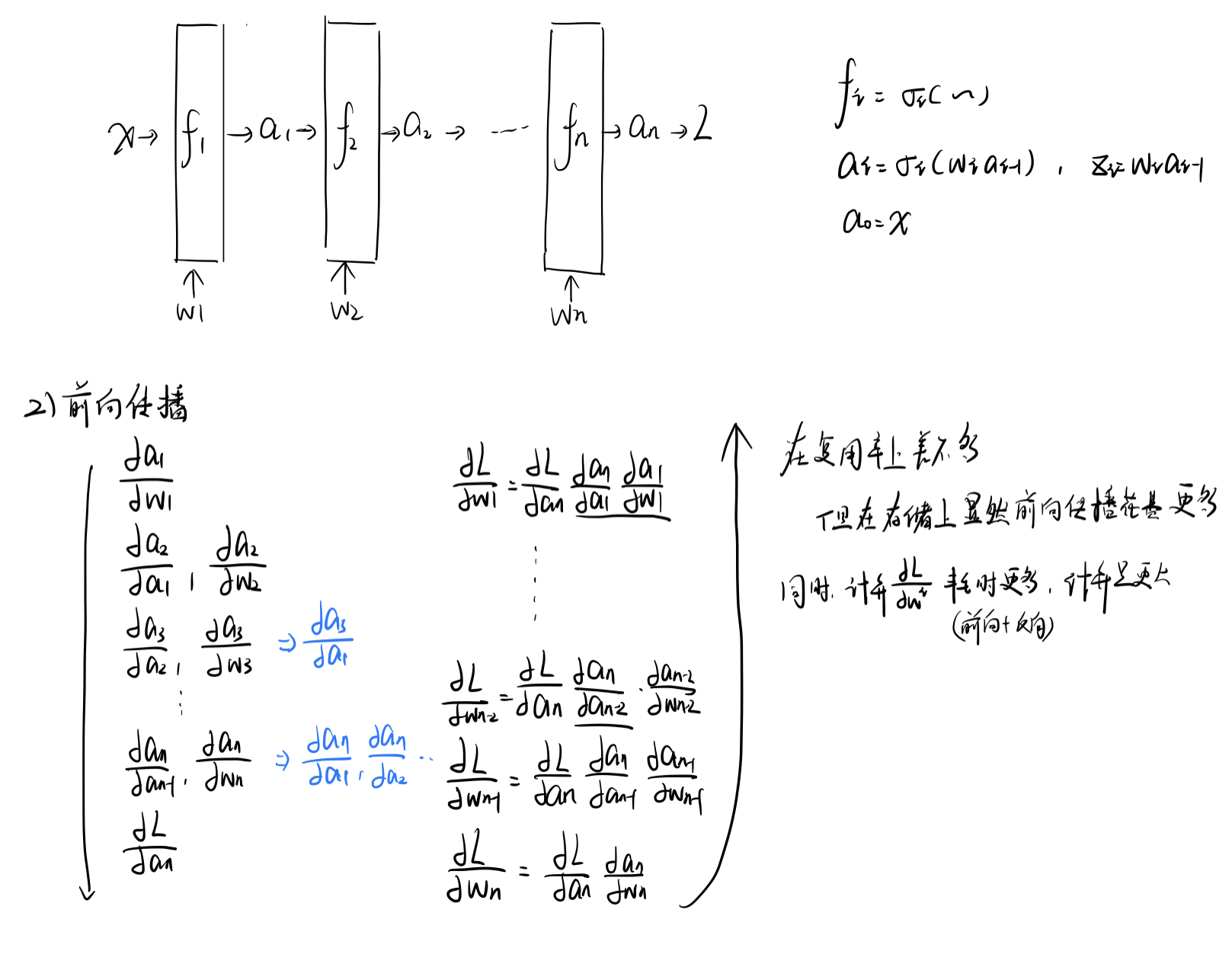

- 计算量减少(这点不一定),复用率可能没有前向传播高

- 不是没有中间存储,而是中间存储相对于前向传播更少一点

- 更加适合神经网络的层次结构,从后向前每层对参数的求导均可以用于该层的梯度下降

B

下面我们举一个简单神经网络的例子来分别看看梯度前反向传播区别

B.1

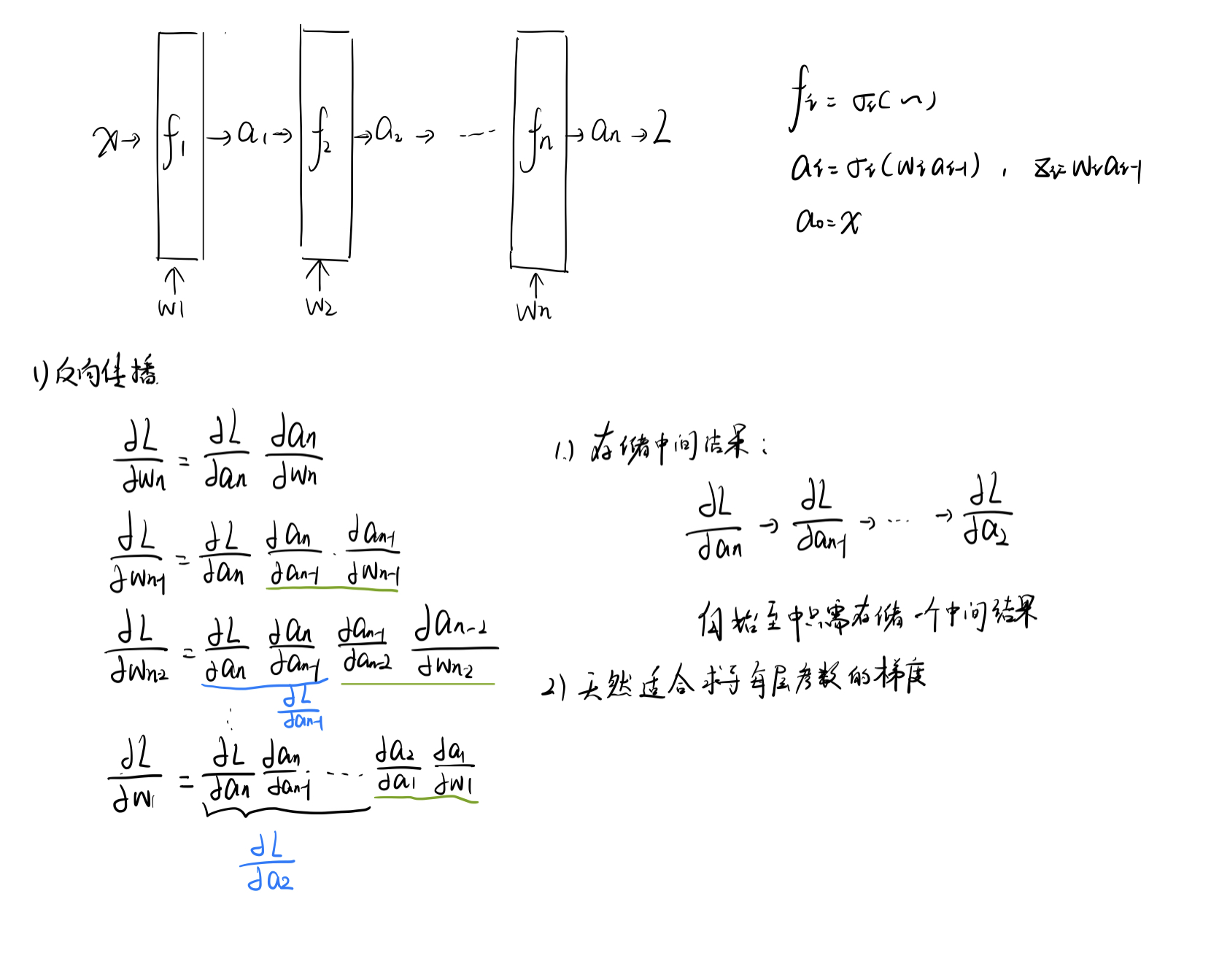

反向传播时神经网络每层的梯度计算

B.2

前向传播时神经网络每层的梯度计算

此时我们可以清楚地看见两种传播的区别

C

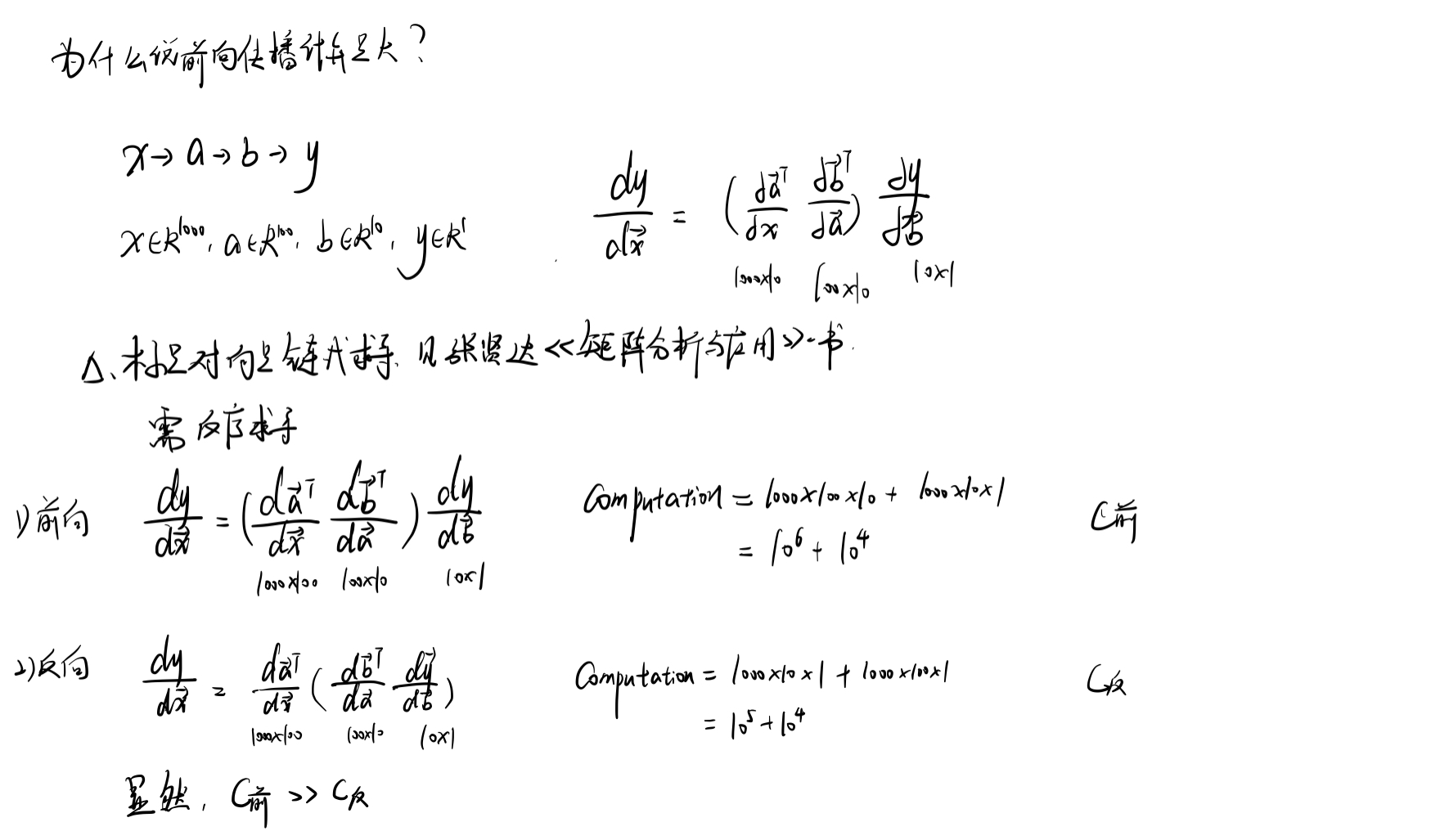

最后说明一下前反向传播的计算量区别

注:这是一个比较粗浅的计算,实际情况可能并非如此,但是可以这么理解。

浙公网安备 33010602011771号

浙公网安备 33010602011771号