深度学习中的凸函数

深度学习中的凸函数

1.26修改一下

先解释凸函数,这里的凸函数指下凸,即凹函数

深度学习中的凸函数的意思是在参数空间上的凸函数,而不是x或者y的凸函数,下面解释

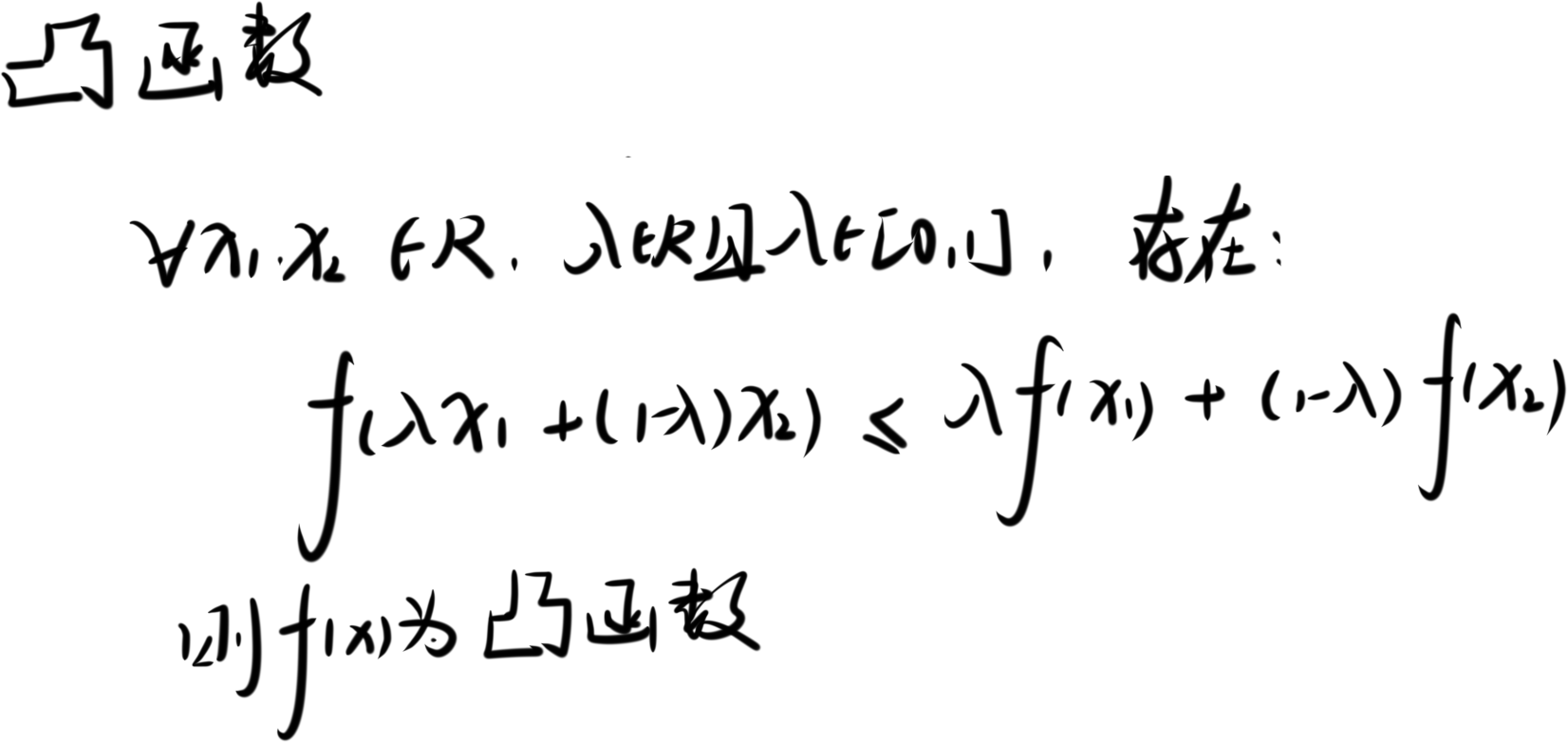

概念

先说明一下上凸函数的性质,下凸同理可得,不再赘述。

初中学过,简单先过一遍

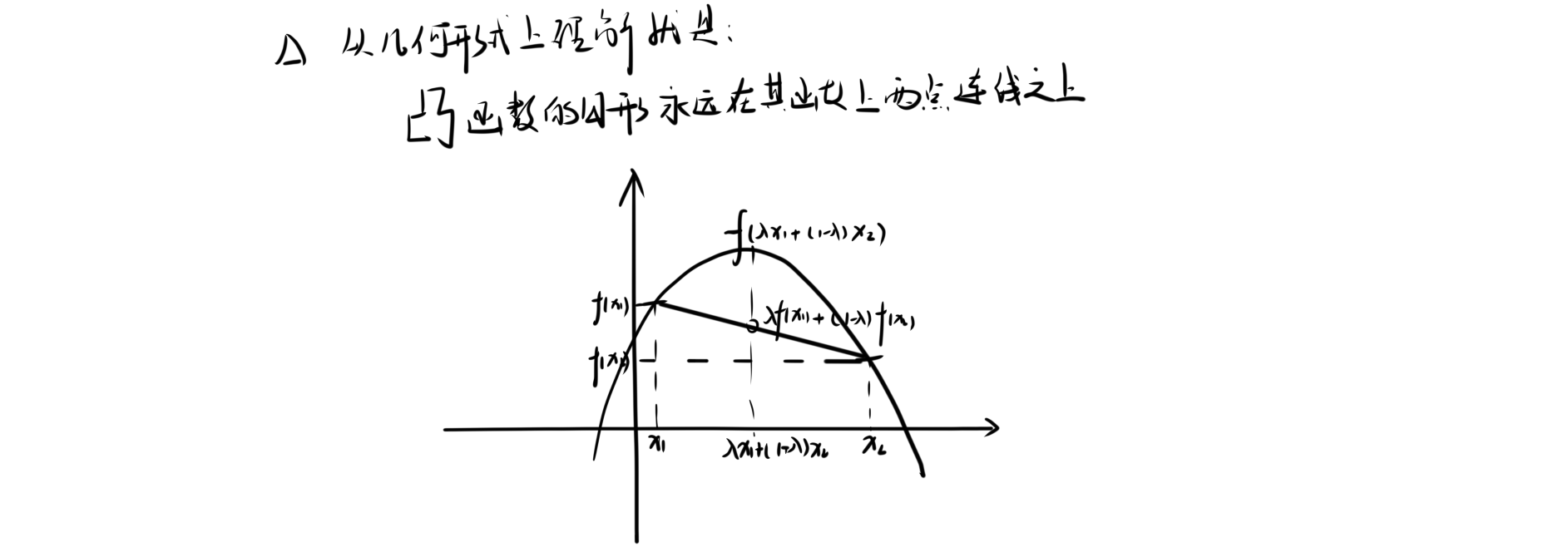

几何理解

二乘法

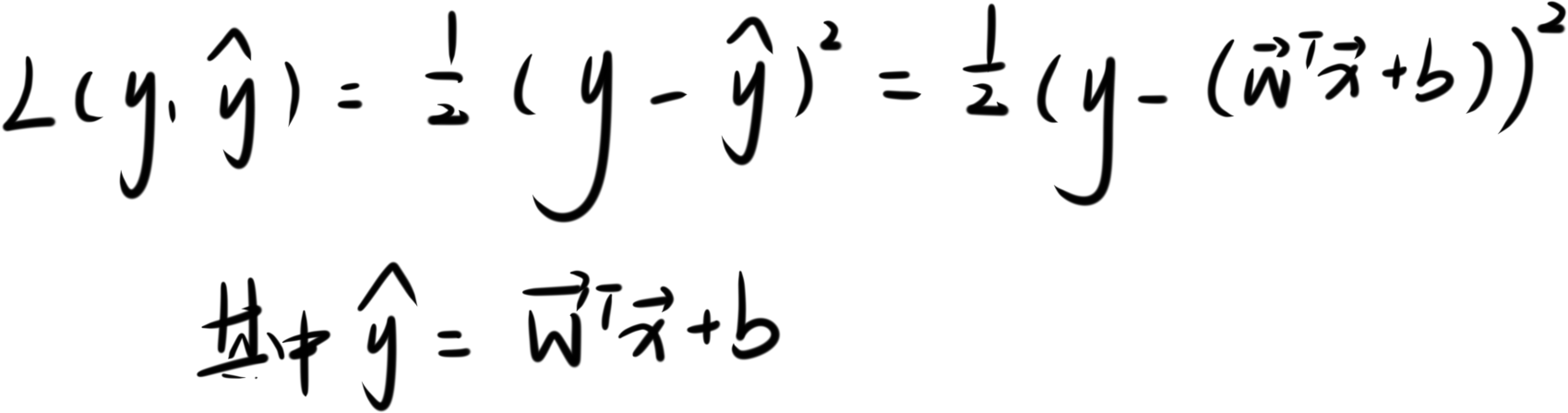

二乘法损失函数是一个经常采用的凸函数,使用它求得\(\mathbf{w}\)和\(b\)来最小化损失函数

公式如下:

凸针对的是参数空间\((\mathbf{w}^T,b)\),而不是\((\hat{y})\)。下面做简单证明

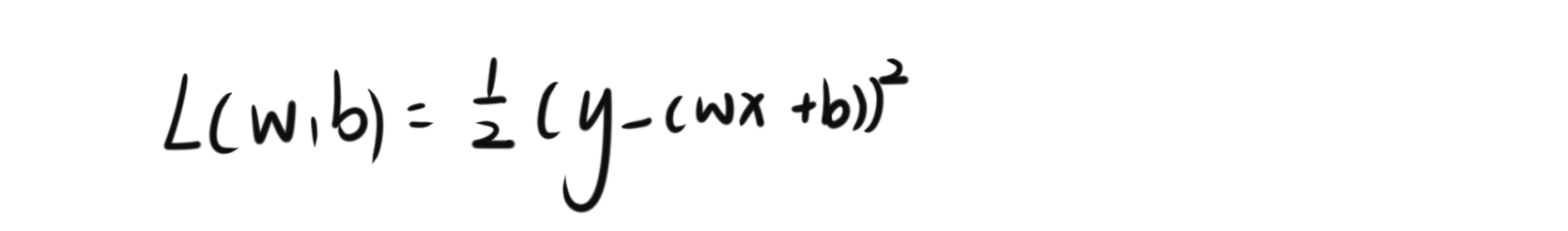

首先简化参数\(\mathbf{w}和b\)为一维,有

二乘法优化的目标是参数\((\mathbf{w}^T,b),st:L(y,\hat{y};w,b)=L(w,b)min\),则有:

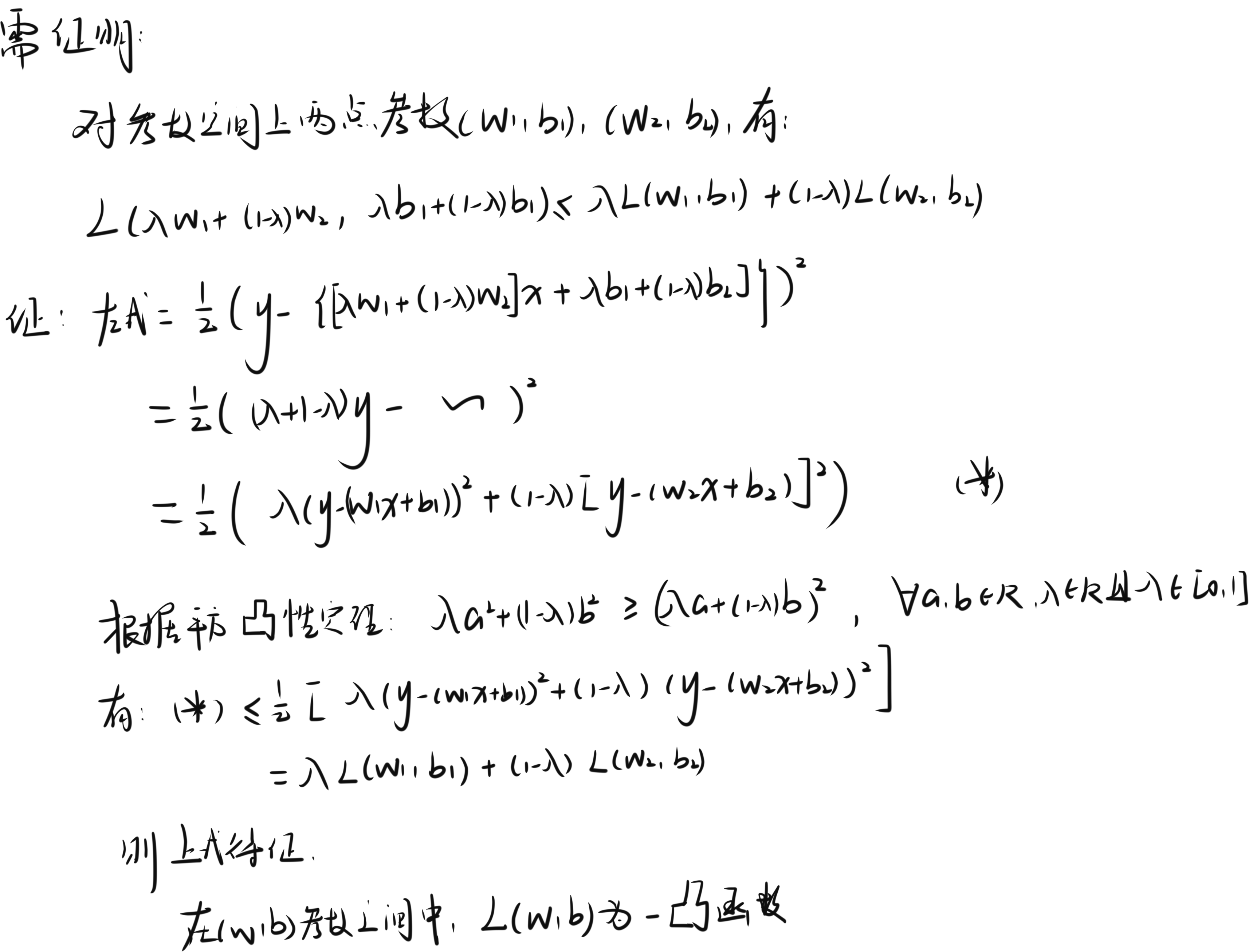

证明如下

这里的证明其实是证明了一个下凸性质

一个疑问

自然有一个疑问,凸函数开口向下不是逼近最大值吗

A:

这里的凸函数是下凸

很简单,因为取负就是凹函数,容易得到最小值

在最优化问题中,最大化和最小化问题常常是等价的

补充知识

B.1

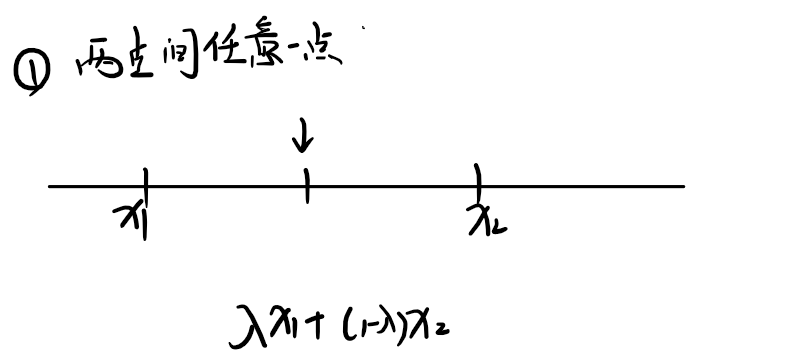

- 两点之间点的表达式

B.1.1

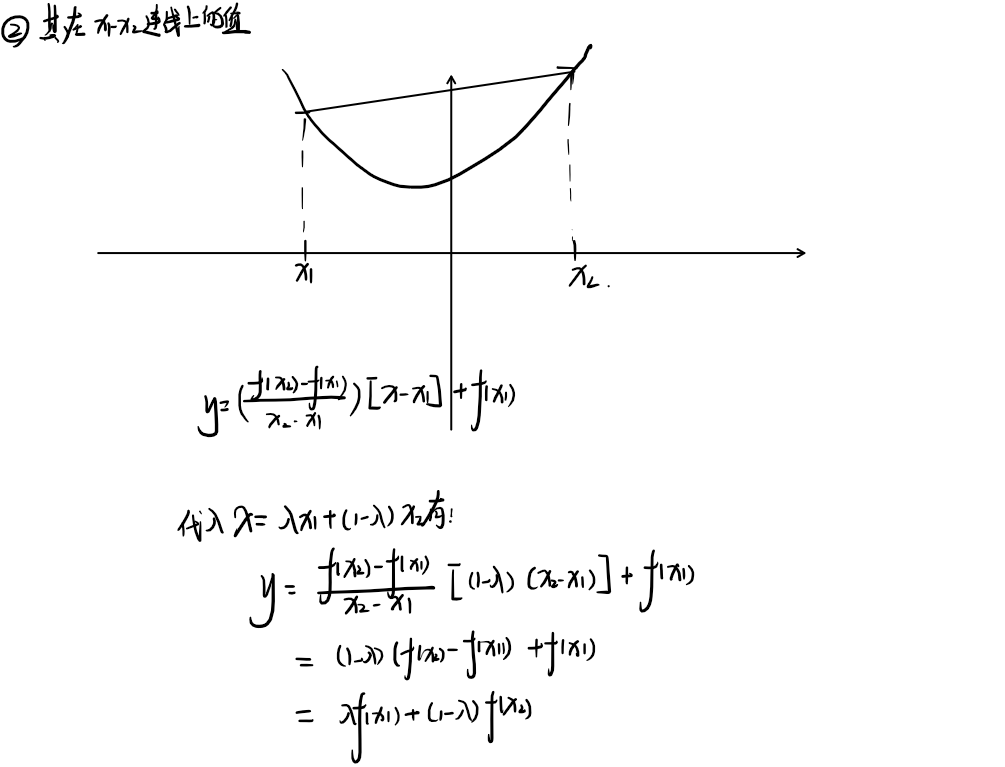

- 两点之间点的两点连线函数值

B.2

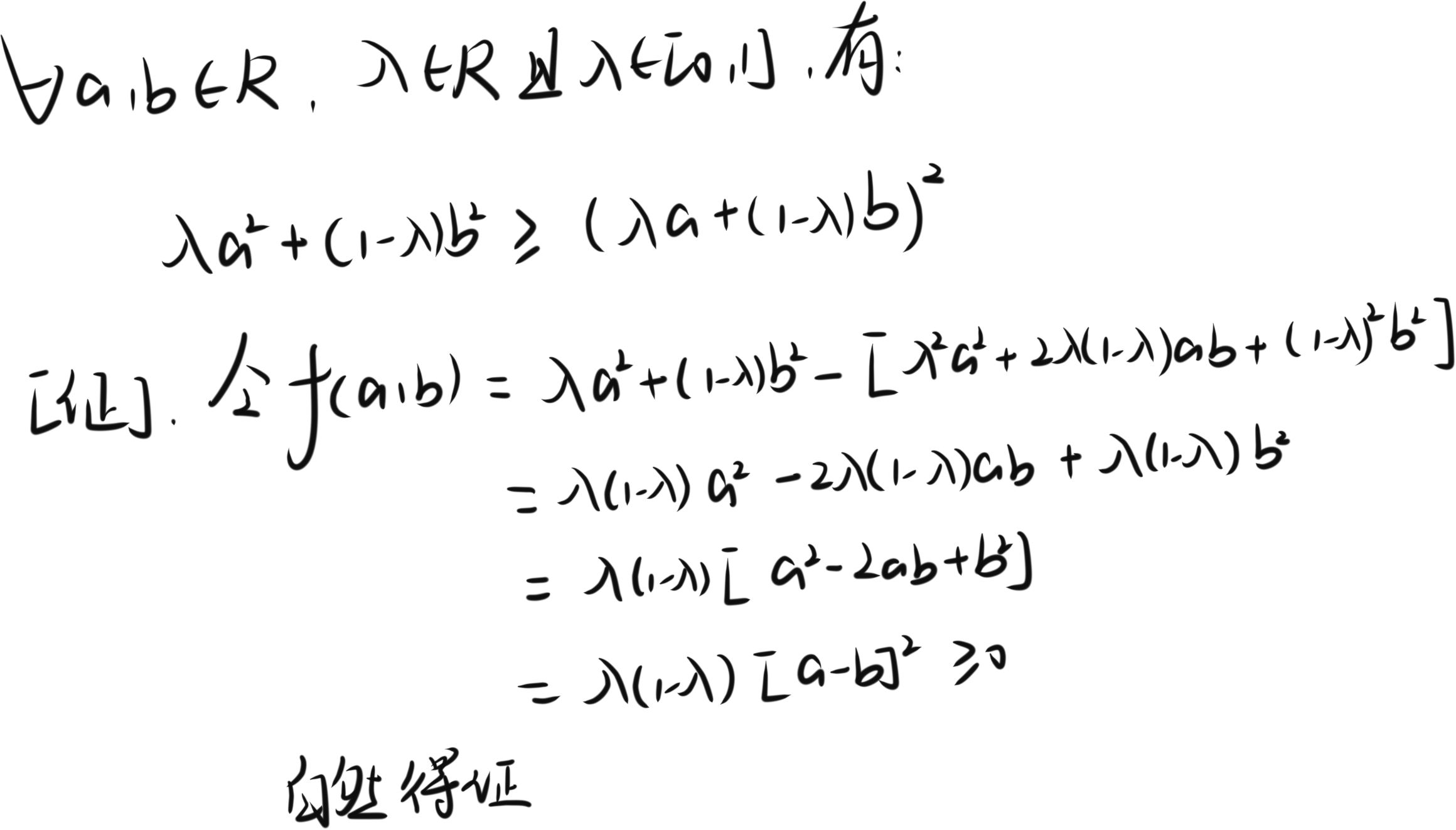

平方凸性定理

浙公网安备 33010602011771号

浙公网安备 33010602011771号